一种基于强化学习算法的多机器人协作方法

本发明涉及协作控制领域,尤其涉及一种基于强化学习算法的多机器人协作方法。

背景技术:

1、多智能体的协作控制被广泛应用,其中比较经典的案例就是机器人仿真足球比赛,机器人仿真足球研究现状:目前主要使用手工决策方法对球队的策略进行优化,手工决策是指通过观看比赛录像发现球队的漏洞,并修改对应的底层模块代码来调整球队策略。但手工决策方法的实施需要在特定的比赛环境,对随时变化的球场情形适应性差,由于比赛环境的多变性和复杂性,在每个阶段使用手工决策的攻防策略并不现实,球员agent必须要有对比赛环境的学习和适应能力。

技术实现思路

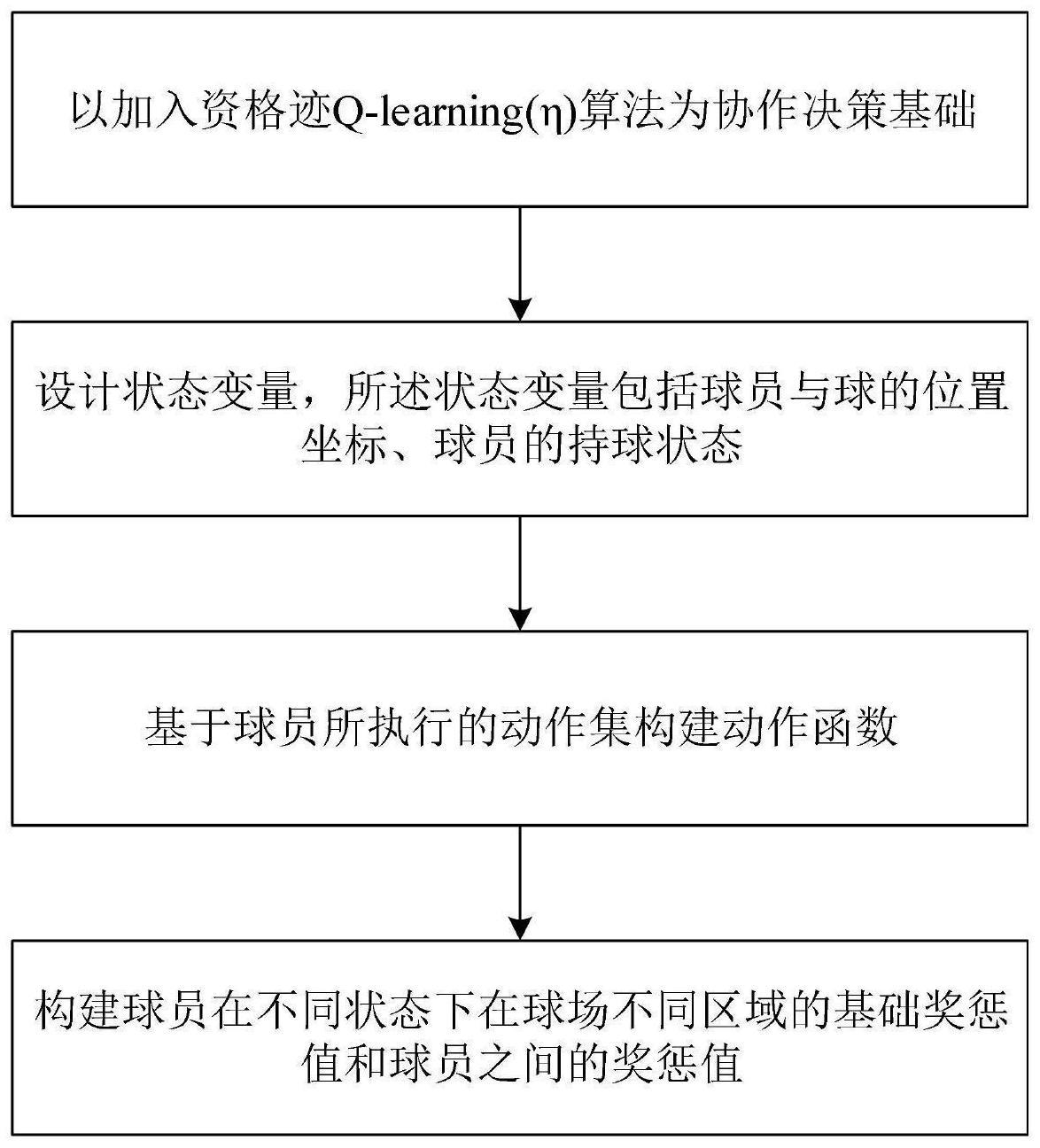

1、有鉴于此,为了解决现有机器人协作方法中无法在多变的球场场景中实时调整策略,进而导致球员agent之间攻防协作效率低的问题,本发明提出一种基于强化学习算法的多机器人协作方法,所述方法包括以下步骤:

2、以加入资格迹q-learning(η)算法为协作决策基础;

3、设计状态变量,所述状态变量包括球员与球的位置坐标、球员的持球状态;

4、基于球员所执行的动作集构建动作函数;

5、构建球员在不同状态下在球场不同区域的基础奖惩值和球员之间的奖惩值。

6、在一些实施例中,所述基于球员所执行的动作集构建动作函数这一步骤,其具体包括:

7、将球员分类为进攻球员、防守球员和守门员;

8、根据球员与球的位置坐标、球员的持球状态,确定策略;

9、根据策略,控制不同类型的球员执行动作。

10、其中,基于球员所执行的动作集设计核心进攻球员与普通防守球员以及守门员的动作函数。

11、在一些实施例中,进攻球员的动作函数具体如下:

12、当进攻球员持球,作为持球者,选择执行动作,包括传球、带球和射门;

13、k2球员向球的位置移动;

14、除持球者和k2球员的其余进攻球员,维持预设阵型位置。

15、在一些实施例中,防守球员的动作函数具体如下:

16、当对方球员持球,k4球员选择执行动作,包括铲球、转身寻找球和移动至阵型指定位置;

17、当没人持球且对方球员的位置与球的位置较近,选定己方防守球员执行截球动作,其余防守球员维持状态。

18、在一些实施例中,门员的动作函数具体如下:

19、当球与守门员的距离在第一预设区间,执行扑球动作;

20、若扑球动作执行后,捕获球成功,执行发球动作;

21、若扑球动作执行后,捕获球失败,重新执行扑球动作。

22、在一些实施例中,持球的判定规则为球员的位置坐标与球的位置坐标小于预设值。

23、在一些实施例中,所述状态包括进攻状态和防守状态,根据不同状态将球场划分为多个区域并分别设置基本奖惩值。

24、在一些实施例中,进攻状态下的奖惩值设计如下:

25、

26、在一些实施例中,防守状态下的奖惩值设计如下:

27、

28、基于上述方案,本发明提供了一种基于强化学习算法的多机器人协作方法,将基于资格迹(et)的q-learning(η)算法应用在足球仿真比赛的球员的攻防协作中,通过设计球员在进攻状态和防守状态下的状态变量,并设计进攻球员、普通防守球员和守门员的动作函数。同时根据球和球门的位置对不同区域的奖惩值进行更新设计,使其在比赛中增大搜索范围,增强球员间的协作配合。

技术特征:

1.一种基于强化学习算法的多机器人协作方法,其特征在于,包括以下步骤:

2.根据权利要求1所述一种基于强化学习算法的多机器人协作方法,其特征在于,所述基于球员所执行的动作集构建动作函数这一步骤,其具体包括:

3.根据权利要求2所述一种基于强化学习算法的多机器人协作方法,其特征在于,进攻球员的动作函数具体如下:

4.根据权利要求2所述一种基于强化学习算法的多机器人协作方法,其特征在于,防守球员的动作函数具体如下:

5.根据权利要求2所述一种基于强化学习算法的多机器人协作方法,其特征在于,守门员的动作函数具体如下:

6.根据权利要求3-5任一项所述的一种基于强化学习算法的多机器人协作方法,其特征在于,持球的判定规则为球员的位置坐标与球的位置坐标小于预设值。

7.根据权利要求1所述一种基于强化学习算法的多机器人协作方法,其特征在于,所述状态包括进攻状态和防守状态,根据不同状态将球场划分为多个区域并分别设置基本奖惩值。

8.根据权利要求7所述一种基于强化学习算法的多机器人协作方法,其特征在于,进攻状态下的奖惩值设计如下:

9.根据权利要求7所述一种基于强化学习算法的多机器人协作方法,其特征在于,防守状态下的奖惩值设计如下:

技术总结

本发明公开了一种基于强化学习算法的多机器人协作方法,该方法包括:以加入资格迹Q‑learning(η)算法为协作决策基础;设计状态变量,所述状态变量包括球员与球的位置坐标、球员的持球状态;基于球员所执行的动作集构建动作函数;构建球员在不同状态下在球场不同区域的基础奖惩值和球员之间的奖惩值。通过使用本发明,能够在多变的球场场景中实时调整策略,进而解决球员之间攻防协作效率低的问题。本发明可广泛应用于协作控制领域。

技术研发人员:王萍,金枝,韩瑜,钱军,刘万泉

受保护的技术使用者:中山大学

技术研发日:

技术公布日:2024/1/15

- 还没有人留言评论。精彩留言会获得点赞!