一种路侧感知系统的雷达与视觉目标匹配融合方法与流程

本发明属于智能交通,具体为一种路侧感知系统的雷达与视觉目标匹配融合方法。

背景技术:

1、路侧感知就是利用摄像机、毫米波雷达、激光雷达等传感器,并结合路侧边缘计算,其最终目的是实现对该路段的交通参与者、路况等的瞬时智能感知。目前,在融合体系的数据源部分,常用到的传感器有摄像头、毫米波雷达和激光雷达。摄像头能够检测交通参与者类型(比如行人、车辆、骑行者)等信息,但是其受天气、光照强度的影响较大;毫米波雷达能够准确地检测目标的位置、速度等信息并且不会受天气状态的干扰,但是其容易漏检静止的目标,而且检测的目标噪点较多;激光雷达能够准确检测出静止和运动目标的位置、速度以及目标物的尺寸等信息,但是其环境敏感度高,易受大雪、灰尘影响。通过将多种传感器的数据融合能够结合不同传感器的优点,起到扬长避短的效果。

2、雷达和视觉的融合策略可以分为三类:数据层融合,特征层融合,以及决策层融合。数据层融合的核心思想是由一种传感器数据生成目标物体的候选区域(术语称作proposal),然后在另外一种传感器数据上进行验证。这也就相当于融合了一种传感器的决策(proposal)和另外一种传感器的数据。与数据层融合相比,特征层的融合更加底层一些,也更有利于神经网络也学习不同传感器之间的互补性,但是算法设计的复杂程度也相对较高。一般的做法是将点云数据映射到图像坐标系下,形成一个类似于相机图像的“点云图像”。点云图像和相机图像处于相同的坐标系下,因此可以很容易的通过神经网络进行融合。决策层的融合其实就是分别处理雷达和图像数据,将两种数据中得到的检测结果进行融合。在这个过程中,将来自不同传感器的结果进行匹配是非常关键的步骤。传统的方法一般直接通过物体检测的输出(比如类别,位置,大小等)来计算相似度,并进行匹配。

3、智能网联汽车经过近年来的大力发展,目前已经可以实现特定场景和低速状态下的无人驾驶。对于实现全场景高速无人驾驶,目前还没有一个完善的解决方案。为了弥补单车智能的感知不足,提高智能车的感知范围,以及提升交通管控的感知手段,业内专家提出了车路协同的概念。

4、车路协同,即智能车通过无线通信的方式,与路侧人、车、路、网互联通信,提升自车的感知范围和感知手段。通常,在车路协同的路侧端,一般会架设路侧感知系统。系统由多种感知传感器组成,如图像传感器、毫米波雷达传感器、激光雷达传感器等,通过多传感器融合感知的方式,获取道路上目标的位置、速度、航向角、类型等目标特征数据。目前,将不同传感器感知到的目标进行匹配融合存在精度不高,稳定性差的问题。

技术实现思路

1、本发明的目的在于提供一种路侧感知系统的雷达与视觉目标匹配融合方法,以解决背景技术中提出的现有技术中,存在数据层融合和特征层融合算法设计复杂度高、效率较低以及现有的决策层融合是基于全局匹配融合,精度和稳定性较差的问题。

2、为解决上述技术问题,本发明所采用的技术方案是:

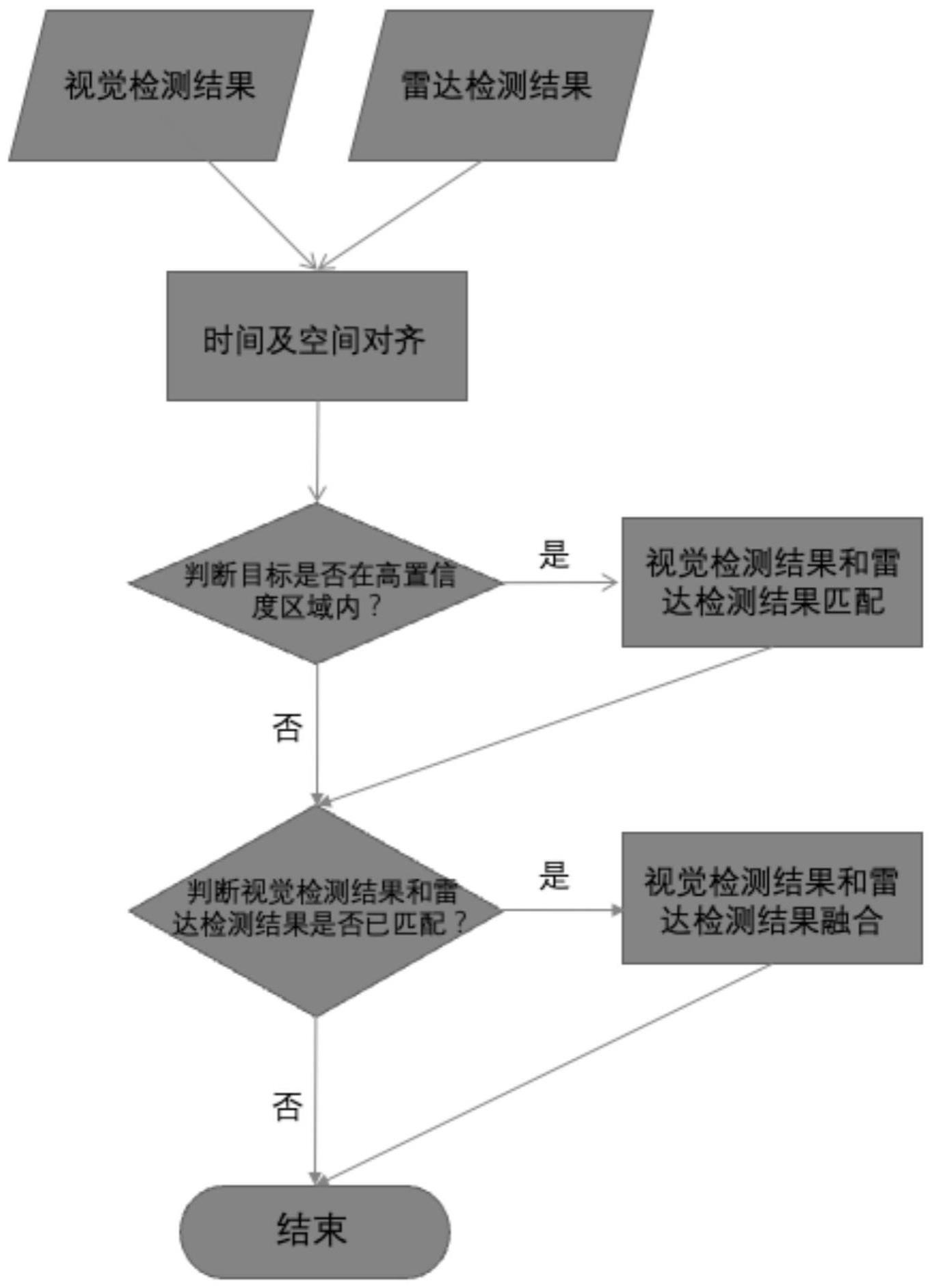

3、一种路侧感知系统的雷达与视觉目标匹配融合方法,包括以下步骤:

4、步骤s1,将视觉检测结果和雷达检测结果进行时间以及空间对齐,使得不同传感器的检测结果时间同步;

5、步骤s2,判断目标是否在高置信度区域内,如果是,则视觉检测结果和雷达检测结果进行匹配,如果不是,则继续下一步判断;

6、步骤s3,判断视觉检测结果和雷达检测结果是否已匹配,如果是,则视觉检测结果和雷达检测结果融合;如果不是,则直接结束。

7、根据上述技术方案,步骤s2中,视觉检测用于检测目标的检测框位置,分别代表检测框左上角的像素坐标和右下角的像素坐标;

8、雷达检测用于得到目标的经纬度坐标[lon,lat],通过坐标系转换矩阵transformmatrix变换为像素坐标转换公式如下:

9、

10、其中,坐标系转换矩阵transformmatrix通过对雷达和相机进行联合标定得出;具体地,采集若干组像素-经纬度匹配对,然后通过几何变换拟合得出坐标系转换矩阵。

11、根据上述技术方案,几何变换拟合得出坐标系转换矩阵具体为:

12、对于任意一个采集的经纬度坐标[lon,lat],使用一个2*2矩阵来变换到另一个向量空间,即像素坐标通过采集像素-经纬度匹配对,计算出两个坐标系的转换矩阵,如下式所示:

13、

14、将矩阵形式写成表达式形式,如下式所示:

15、

16、

17、其中,a,b,c,d是transformmatrix需要求得的4个矩阵值,4组像素-经纬度匹配对即可求出所有的值。采用更多的像素-经纬度匹配对可以与真实的转换矩阵更加接近。这样就可以求得坐标系转换矩阵。

18、根据上述技术方案,根据步骤s2中检测得到的像素坐标,计算视觉检测框的中心像素坐标:

19、

20、

21、式中,lx为检测框左上角x坐标,rx为检测框右下角x坐标,ly为检测框左上角y坐标,ry为检测框右下角y坐标;

22、然后计算视觉检测框中心像素坐标与雷达像素坐标的欧式距离l,如下式所示:

23、

24、式中,mx为检测框中心x坐标,my为检测框中心y坐标,ox为雷达检测像素x坐标,oy为雷达检测像素y坐标。

25、根据上述技术方案,将当前时间的所有视觉检测结果和雷达检测结果分别计算距离,得到距离矩阵m,如下式所示:

26、

27、其中,表示第i个视觉检测结果与第j个雷达检测结果的欧式距离l。

28、根据上述技术方案,将其最邻近的雷达检测结果进行匹配,即第i个视觉检测结果与第j个雷达检测结果匹配当以下条件满足:

29、

30、当视觉检测结果和雷达检测结果匹配上后,将两者信息进行融合。

31、与现有技术相比,本发明具有以下有益效果:

32、本发明通过将不同传感器的共同感知区域划分为高置信度区域和低置信度区域,然后在高置信度区域进行不同传感器的检测结果匹配并在匹配结束(离开高置信度区域)后一直保持关联,从而达到高精度,高稳定性的雷视融合效果。

33、本发明中的方法,与现有技术中的数据层融合和特征层融合算法相比,具有复杂度低,效率更高的优点。并且,本发明中的方法,是基于高置信度区域进行匹配融合,精度和稳定性更好。

技术特征:

1.一种路侧感知系统的雷达与视觉目标匹配融合方法,其特征在于:包括以下步骤:

2.根据权利要求1所述的一种路侧感知系统的雷达与视觉目标匹配融合方法,其特征在于:步骤s2中,视觉检测用于检测目标的检测框位置,分别代表检测框左上角的像素坐标和右下角的像素坐标;

3.根据权利要求2所述的一种路侧感知系统的雷达与视觉目标匹配融合方法,其特征在于:几何变换拟合得出坐标系转换矩阵具体为:

4.根据权利要求2所述的一种路侧感知系统的雷达与视觉目标匹配融合方法,其特征在于:根据步骤s2中检测得到的像素坐标,计算视觉检测框的中心像素坐标:

5.根据权利要求4所述的一种路侧感知系统的雷达与视觉目标匹配融合方法,其特征在于:将当前时间的所有视觉检测结果和雷达检测结果分别计算距离,得到距离矩阵m,如下式所示:

6.根据权利要求1所述的一种路侧感知系统的雷达与视觉目标匹配融合方法,其特征在于:将其最邻近的雷达检测结果进行匹配,即第i个视觉检测结果与第j个雷达检测结果匹配当以下条件满足:

技术总结

本发明公开了一种路侧感知系统的雷达与视觉目标匹配融合方法,包括以下步骤:步骤S1,将视觉检测结果和雷达检测结果进行时间以及空间对齐,步骤S2,判断目标是否在高置信度区域内;步骤S3,判断视觉检测结果和雷达检测结果是否已匹配。本发明通过将不同传感器的共同感知区域划分为高置信度区域和低置信度区域,然后在高置信度区域进行不同传感器的检测结果匹配并在匹配结束(离开高置信度区域)后一直保持关联,从而达到高精度,高稳定性的雷视融合效果。本发明中的方法,与现有技术中的数据层融合和特征层融合算法相比,具有复杂度低,效率更高的优点。并且,本发明中的方法,是基于高置信度区域进行匹配融合,精度和稳定性更好。

技术研发人员:肖育豪,刘维维,封钦柱,司宇

受保护的技术使用者:四川天府新区北理工创新装备研究院

技术研发日:

技术公布日:2024/1/15

- 还没有人留言评论。精彩留言会获得点赞!