一种基于深度学习和双目视觉的无人机自主避障方法与流程

1.本发明涉及无人机自主避障领域,具体为一种基于深度学习和双目视觉的无人机自主避障方法.

背景技术:

2.无人机的避障性能是决定其应用性能的核心因素之一。应用单一传感器的避障方法存在鲁棒性差、有效性低、可靠性差、环境适应性弱等问题。目前,一般使用基于多传感器信息融合的避障和定位方法,能够保证侦测无人机在不同环境条件下最大程度地感知周围信息。但超声波雷达、毫米波雷达、激光测距仪等难以完成周围环境的详细描述,进行避障具有一定局限性。采用视觉模块通过相机标定,立体匹配,三维重建和路径规划等多个步骤虽然可以实现自主避障,但步骤较为繁琐。

3.因此本发明考虑将发展迅速的计算机视觉技术应用于无人机自主避障过程,利用双目相机和轻量级的卷积神经网络实现端到端的预测过程,在实现较高精确度的条件下大大简化了自主避障的过程。

技术实现要素:

4.本发明的目的在于提供一种基于深度学习和双目视觉的无人机自主避障方法,以解决上述背景技术中提出的问题。

5.为实现上述目的,本发明提供如下技术方案:一种基于深度学习和双目视觉的无人机自主避障方法,包括以下步骤:

6.s1:在多个真实场景下如墙壁、树木、行人等场景下进行手动操作避障;

7.s2:对左右相机的图像进行处理,以及在避障时无人机瞬时的俯仰角θ、滚转角和油门量m的进行数据采集;

8.s3:在卷积神经网络经过训练后搭载到无人机上,最终实现端到端的无人机自主避障过程。

9.优选的,在所述s3步骤中卷积神经网络设计为输入为224

×

224

×

3的图像,经过归一化以及以卷积网络之后,输出为预测的俯仰角θ、滚转角和油门量m三个数据。

10.优选的,所述输出的俯仰角θ、滚转角和油门量m以及左右两个摄像头得到的图像的输出值为平均值,若双目相机的某个相机被遮挡后导致数据错误,或若某一个期望姿态角或油门量为异常值,则直接舍弃,只使用另一摄像头获得的期望值作为无人机的输入值。

11.优选的,在所述s2步骤中的图像处理中,无需对图像中的障碍物进行任何的标注,主要是对图像进行归一化处理和数据增强,归一化的主要公式为其中x

i

为图像像素点值,min(x)、max(x)分别为图像像素的最大与最小值;

12.所述数据增强为通过对原始图片的变换来提高模型的鲁棒性与泛华能力,因此,通过水平翻转、随机裁剪、平移、加噪的方式进行数据增强,其中水平翻转时,植保无人机的滚转角也进行相应的翻转以保持数据的对应。

13.与现有技术相比,本发明的有益效果是:本发明将计算机视觉技术应用于无人机避障领域,并通过双目相机和轻量级的卷积神经网络实现端到端的预测过程,以达到在保证精确度的前期下简化现有无人机的自主避障过程的目的。

附图说明

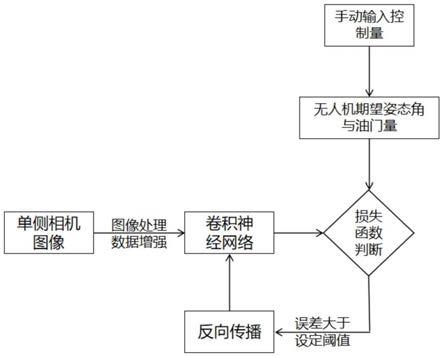

14.图1为本发明中图像输入至卷积神经网络的流程图;

15.图2为本发明中卷积神经网络的设计图;

16.图3为本发明中实现正向预测的流程图。

具体实施方式

17.下面将结合本发明实施例中的附图,对本发明实施例中的技术方案进行清楚、完整地描述,显然,所描述的实施例仅仅是本发明一部分实施例,而不是全部的实施例。基于本发明中的实施例,本领域普通技术人员在没有做出创造性劳动前提下所获得的所有其他实施例,都属于本发明保护的范围。

18.实施例1:

19.如图1

‑

3;本发明提供一种基于深度学习和双目视觉的无人机自主避障方法,包括以下步骤:

20.s1:在多个真实场景下如墙壁、树木、行人等场景下进行手动操作避障;

21.s2:对左右相机的图像进行处理,以及在避障时无人机瞬时的俯仰角θ、滚转角和油门量m的进行数据采集;

22.s3:在卷积神经网络经过训练后搭载到无人机上,最终实现端到端的无人机自主避障过程。

23.进一步的,在所述s3步骤中卷积神经网络设计为输入为224

×

224

×

3的图像,经过归一化以及以卷积网络之后,输出为预测的俯仰角θ、滚转角和油门量m三个数据。

24.进一步的,所述输出的俯仰角θ、滚转角和油门量m以及左右两个摄像头得到的图像的输出值为平均值,若双目相机的某个相机被遮挡后导致数据错误,或若某一个期望姿态角或油门量为异常值,则直接舍弃,只使用另一摄像头获得的期望值作为无人机的输入值。

25.进一步的,在所述s2步骤中的图像处理中,无需对图像中的障碍物进行任何的标注,主要是对图像进行归一化处理和数据增强,归一化的主要公式为其中x

i

为图像像素点值,min(x)、max(x)分别为图像像素的最大与最小值;

26.所述数据增强为通过对原始图片的变换来提高模型的鲁棒性与泛华能力,因此,通过水平翻转、随机裁剪、平移、加噪的方式进行数据增强,其中水平翻转时,植保无人机的滚转角也进行相应的翻转以保持数据的对应。

27.本发明的目的就是利用深度学习技术简化信息的处理和决策过程。无人机在手动

飞行过程中遇到障碍物时,飞手通过操控遥控器给出无人机期望的俯仰角θ、滚转角和油门量m。因此,可以利用多重神经网络来模拟飞手避障时的操作,输入给无人机,实现自主避障。如图1所示,以单侧相机的图像作为输入,经过图像处理和增强之后,传入到卷积神经网络之中;

28.而卷积神经网络的设计如附图2所示,包括卷积层和全连接层。

29.激活函数的选取:elu激活函数兼具sigmoid激活函数和relu激活函数的优点,能缓解梯度消失,且具有软饱和性,鲁棒性强,受输入中噪声的影响小,且收敛速度更快,因此选用elu为激活函数。

30.损失函数设计:训练过程中,卷积神经网络的输出(θ,m)与实际的手动避障数值进行对比,用均方差函数(mse)来衡量损失,均方误差损失函数公式为:

[0031][0032]

因此卷积神经网络的损失函数为:

[0033][0034]

其中俯仰角θ、滚转角为弧度制,为减小不同单位的影响,在进行计算时与油门量m一起映射到(

‑

1,1)区间中。设定均方误差阈值,当均方误差求得的损失值大于其阈值时,进行网络权重的调整,直至满足要求。

[0035]

得到训练好的网络权重后,加载到无人机上实现左右图像的正向预测,如附图3所示,左右摄像头图像经过卷积神经网络之后得到预测值,得到的预测值经过数据筛选及融合之后传给无人机飞控,调整电机的转速,实现无人机自主避障过程。

[0036]

尽管已经示出和描述了本发明的实施例,对于本领域的普通技术人员而言,可以理解在不脱离本发明的原理和精神的情况下可以对这些实施例进行多种变化、修改、替换和变型,本发明的范围由所附权利要求及其等同物限定。

技术特征:

1.一种基于深度学习和双目视觉的无人机自主避障方法,其特征在于,包括以下步骤:s1:在多个真实场景下如墙壁、树木、行人等场景下进行手动操作避障;s2:对左右相机的图像进行处理,以及在避障时无人机瞬时的俯仰角θ、滚转角和油门量m的进行数据采集;s3:在卷积神经网络经过训练后搭载到无人机上,最终实现端到端的无人机自主避障过程。2.根据权利要求1所述的一种基于深度学习和双目视觉的无人机自主避障方法,其特征在于:在所述s3步骤中卷积神经网络设计为输入为224

×

224

×

3的图像,经过归一化以及以卷积网络之后,输出为预测的俯仰角θ、滚转角和油门量m三个数据。3.根据权利要求2所述的一种基于深度学习和双目视觉的无人机自主避障方法,其特征在于:所述输出的俯仰角θ、滚转角和油门量m以及左右两个摄像头得到的图像的输出值为平均值,若双目相机的某个相机被遮挡后导致数据错误,或若某一个期望姿态角或油门量为异常值,则直接舍弃,只使用另一摄像头获得的期望值作为无人机的输入值。4.根据权利要求1所述的一种基于深度学习和双目视觉的无人机自主避障方法,其特征在于:在所述s2步骤中的图像处理中,无需对图像中的障碍物进行任何的标注,主要是对图像进行归一化处理和数据增强,归一化的主要公式为其中x

i

为图像像素点值,min(x)、max(x)分别为图像像素的最大与最小值;所述数据增强为通过对原始图片的变换来提高模型的鲁棒性与泛华能力,因此,通过水平翻转、随机裁剪、平移、加噪的方式进行数据增强,其中水平翻转时,植保无人机的滚转角也进行相应的翻转以保持数据的对应。

技术总结

本发明属于无人机自主避障领域,具体公开了一种基于深度学习和双目视觉的无人机自主避障方法,包括以下步骤:S1:在多个真实场景下如墙壁、树木、行人等场景下进行手动操作避障:S2:对左右相机的图像进行处理,以及在避障时无人机瞬时的俯仰角θ、滚转角和油门量m的进行数据采集:S3:在卷积神经网络经过训练后搭载到无人机上,最终实现端到端的无人机自主避障过程;本发明将计算机视觉技术应用于无人机避障领域,并通过双目相机和轻量级的卷积神经网络实现端到端的预测过程,以达到在保证精确度的前期下简化现有无人机的自主避障过程的目的。的目的。的目的。

技术研发人员:何斌 李刚 耿书城 沈润杰 陆萍 王志鹏

受保护的技术使用者:苏州同港无人机研究院有限公司

技术研发日:2021.08.03

技术公布日:2021/12/21

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1