一种基于神经网络的Modelica机理模型隐私计算方法及系统与流程

本发明涉及软件工程,尤其是涉及一种基于神经网络的modelica机理模型隐私计算方法及系统。

背景技术:

1、modelica机理模型中,由于时代的局限性,建模中有大量的经验公式,比如核能二回路相关的建模,这些经验公式常常是一个公司付出大量的资源,通过大量测试总结出来的,是一个公司宝贵的财富。

2、在建模的过程中,需要将这些公式写入模型,这就使得这些公式存在泄露风险,尤其是在互联网时代,在mohub建模仿真云平台中,需要为c端用户提供建模服务,该过程中,经验公式都存在泄露风险。

3、本专利基于神经网络技术,针对用户需要仿真的工况,提出一种对经验公式的拟合方式,作为此种工况下的经验公式的替代,既能应对千变万化的用户需求,又能保护机理模型的核心隐私。

技术实现思路

1、针对上述问题,本发明提供了一种基于神经网络的modelica机理模型隐私计算方法及系统,实现对图片中的具有空间信息的文字进行分类及检测,进而不需要人工对检测到的文字进行筛选,降低筛选成本。

2、为实现上述目的,本发明提供了一种基于神经网络的modelica机理模型隐私计算方法,包括:

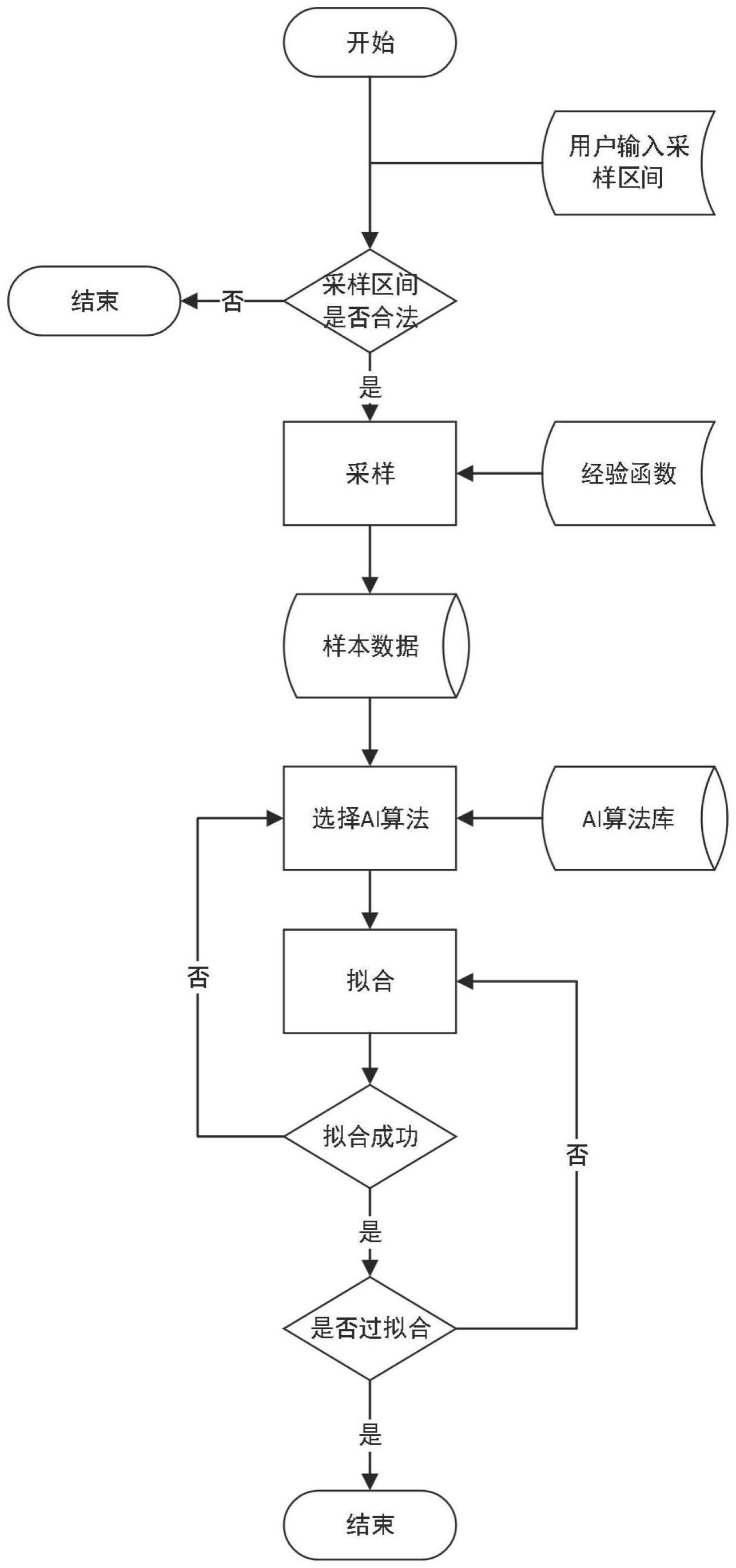

3、判断用户输入的采样区间是否合法,若合法,则针对所述采样区间进行间隔采样,得到各采样值;

4、将各采样值输入经验公式得到总样本,对所述总样本做抽稀处理,抽出部分作为训练样本,剩余部分作为过拟合样本;

5、基于所述训练样本对神经网络进行拟合训练,得到训练后的神经网络;

6、基于所述过拟合样本对训练后的神经网络再次进行拟合训练,得到过拟合的神经网络模型;

7、修改modelica机理模型编译器,将所述经验公式替换为过拟合的神经网络模型,并根据过拟合的神经网络为用户计算并输出仿真结果。

8、作为本发明的进一步改进,所述判断用户输入的采样区间是否合法,包括:

9、预设合法采样区间,若用户输入的采样区间小于或等于所述合法采样区间,则合法;

10、反之,则不合法,直接结束计算。

11、作为本发明的进一步改进,针对所述采样区间进行间隔采样时,采用等间隔采样。

12、作为本发明的进一步改进,对所述总样本做抽稀处理时,抽出1/3的点作为训练样本,将剩余2/3的点作为过拟合样本。

13、作为本发明的进一步改进,所述基于所述训练样本对神经网络进行拟合训练,得到训练后的神经网络;包括:

14、预设ai算法库,在所述ai算法库选择一个神经网络作为拟合算法;

15、基于所述训练样本对所述拟合算法进行拟合训练;

16、若该拟合算法不收敛,则选择下一神经网络作为拟合算法重复进行拟合训练,直至拟合算法收敛,得到训练后的神经网络。

17、本发明还提供了一种基于神经网络的modelica机理模型隐私计算系统,包括:合法性判断模块、样本准备模块、拟合训练模块、过拟合训练模块和公式替换模块;

18、所述合法性判断模块,用于:

19、判断用户输入的采样区间是否合法,若合法,则针对所述采样区间进行间隔采样,得到各采样值;

20、所述样本准备模块,用于:

21、将各采样值输入经验公式得到总样本,对所述总样本做抽稀处理,抽出部分作为训练样本,剩余部分作为过拟合样本;

22、所述拟合训练模块,用于:

23、基于所述训练样本对神经网络进行拟合训练,得到训练后的神经网络;

24、所述过拟合训练模块,用于:

25、基于所述过拟合样本对训练后的神经网络再次进行拟合训练,得到过拟合的神经网络模型;

26、所述公式替换模块,用于:

27、修改modelica机理模型编译器,将所述经验公式替换为过拟合的神经网络模型,并根据过拟合的神经网络为用户计算并输出仿真结果。

28、作为本发明的进一步改进,所述判断用户输入的采样区间是否合法,包括:

29、预设合法采样区间,若用户输入的采样区间小于或等于所述合法采样区间,则合法;

30、反之,则不合法,直接结束计算。

31、作为本发明的进一步改进,针对所述采样区间进行间隔采样时,采用等间隔采样。

32、作为本发明的进一步改进,对所述总样本做抽稀处理时,抽出1/3的点作为训练样本,将剩余2/3的点作为过拟合样本。

33、作为本发明的进一步改进,所述基于所述训练样本对神经网络进行拟合训练,得到训练后的神经网络;包括:

34、预设ai算法库,在所述ai算法库选择一个神经网络作为拟合算法;

35、基于所述训练样本对所述拟合算法进行拟合训练;

36、若该拟合算法不收敛,则选择下一神经网络作为拟合算法重复进行拟合训练,直至拟合算法收敛,得到训练后的神经网络。

37、与现有技术相比,本发明的有益效果为:

38、本发明对于用户特定工况下输入的采样区间,基于神经网络的黑盒特性及过拟合缺点,对经验公式进行采样并进行拟合,得到过拟合的神经网络模型,通过过拟合的神经网络模型为用户计算仿真结果,既能满足用户的仿真需求,又能避免经验公式的泄露,保护了modelica机理模型的隐私。

39、本发明预设ai算法库,能够针对用户输入的不同工况实时完成神经网络模型的训练、针对用户输入区间的仿真计算,保证用户的正常使用的同时,实现modelica机理模型的隐私保护。

40、本发明通过对用户输入的采样区间的合法性判断,放置拟合出的神经网络模型和原本的经验公式过于接近,避免了经验公式的泄露。

技术特征:

1.一种基于神经网络的modelica机理模型隐私计算方法,其特征在于,包括:

2.根据权利要求1所述的modelica机理模型隐私计算方法,其特征在于:所述判断用户输入的采样区间是否合法,包括:

3.根据权利要求1所述的modelica机理模型隐私计算方法,其特征在于:针对所述采样区间进行间隔采样时,采用等间隔采样。

4.根据权利要求1所述的modelica机理模型隐私计算方法,其特征在于:对所述总样本做抽稀处理时,抽出1/3的点作为训练样本,将剩余2/3的点作为过拟合样本。

5.根据权利要求1所述的modelica机理模型隐私计算方法,其特征在于:所述基于所述训练样本对神经网络进行拟合训练,得到训练后的神经网络;包括:

6.一种基于神经网络的modelica机理模型隐私计算系统,其特征在于,包括:合法性判断模块、样本准备模块、拟合训练模块、过拟合训练模块和公式替换模块;

7.根据权利要求6所述的modelica机理模型隐私计算系统,其特征在于:所述判断用户输入的采样区间是否合法,包括:

8.根据权利要求6所述的modelica机理模型隐私计算系统,其特征在于:针对所述采样区间进行间隔采样时,采用等间隔采样。

9.根据权利要求6所述的modelica机理模型隐私计算系统,其特征在于:对所述总样本做抽稀处理时,抽出1/3的点作为训练样本,将剩余2/3的点作为过拟合样本。

10.根据权利要求6所述的modelica机理模型隐私计算系统,其特征在于:所述基于所述训练样本对神经网络进行拟合训练,得到训练后的神经网络;包括:

技术总结

本发明提供一种基于神经网络的Modelica机理模型隐私计算方法及系统,涉及软件工程技术领域,包括:判断用户输入的采样区间是否合法,若合法,则针对采样区间进行间隔采样,得到各采样值,并输入经验公式得到总样本,对总样本做抽稀处理,得到训练样本和过拟合样本;基于训练样本对神经网络进行拟合训练,得到训练后的神经网络;基于过拟合样本对训练后的神经网络进行拟合训练,得到过拟合的神经网络模型;修改Modelica机理模型编译器,将经验公式替换为过拟合的神经网络模型,为用户计算并输出仿真结果。本发明对于用户特定工况下输入的采样区间,得到过拟合的神经网络模型,满足用户的仿真需求,避免经验公式的泄露。

技术研发人员:刘宇超

受保护的技术使用者:武汉鼎元同立科技有限公司

技术研发日:

技术公布日:2024/1/12

- 还没有人留言评论。精彩留言会获得点赞!