面向异构数据的本地差分隐私联邦学习训练方法及系统

本发明涉及数据安全,尤其涉及一种面向异构数据的本地差分隐私联邦学习训练方法及系统。

背景技术:

1、近年来,大数据技术的快速发展驱动着市场经济由传统转向数字化时代,数据的力量被越来越多的领域和产业所认同,科学家们发现通过深度学习(deep learning,dl)构建组成不同的神经网络,对多种模态数据均有强大的特征提取能力,在计算机视觉、自然语言处理、机器人等领域均有不俗表现。然而,目前主流的技术是依然是以云计算平台为中心的集中式架构,需要研究者或公司将不同应用和领域的数据统一收集进行集中训练。集中式机器学习在数据存储、管理、算力成本方面开销较大,并且会带来数据隐私和安全问题。深度学习算法的效果离不开大量的训练数据,现实生活中,由于行业竞争、数据敏感等原因,数据分散存储在不同持有方,难以整合。

2、谷歌于2017年提出了联邦学习(federated learning,fl)的概念。联邦学习为多站点数据协作提供了一种有前途的隐私保护解决方案,该解决方案通过汇总每个本地客户端的参数同时将数据保存在本地,从分散的数据集开发全局模型。但是,联邦学习在很多场景下仍有缺陷,比如目前联邦学习在面向异构数据时存在以下缺陷:(1)全局服务器和本地客户端之间存在特征漂移,模型收敛性能不理想;(2)梯度信息被证明隐私,通信过程中传递梯度仍然会造成隐私泄露。

技术实现思路

1、本发明的目的在于克服现有技术的问题,提供一种面向异构数据的本地差分隐私联邦学习训练方法及系统。

2、本发明的目的是通过以下技术方案来实现的:一种面向异构数据的本地差分隐私联邦学习训练方法,所述方法以客户端作为执行主体时,包括以下步骤:

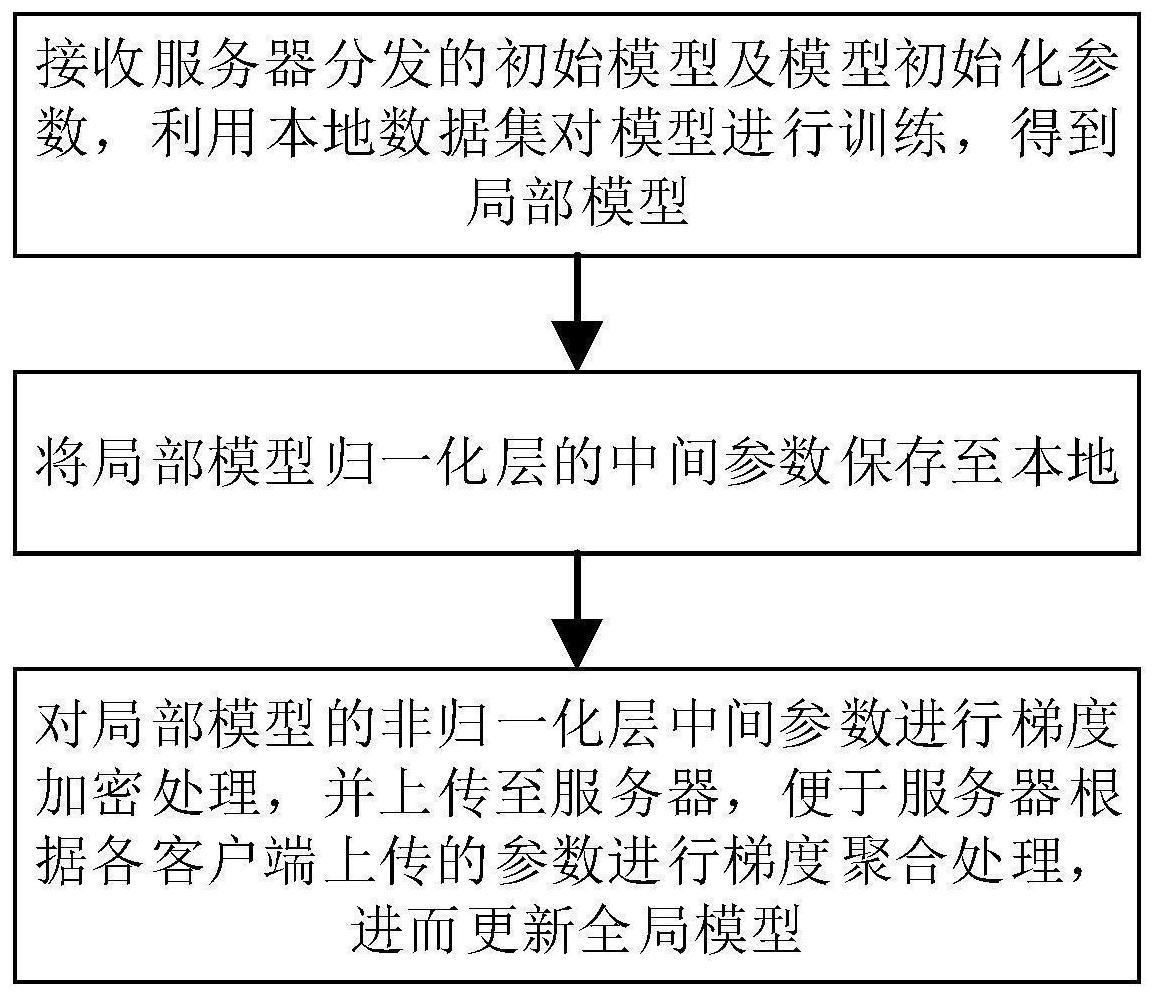

3、接收服务器分发的初始模型及模型初始化参数,利用本地数据集对模型进行训练,得到局部模型;

4、将局部模型归一化层的中间参数保存至本地;

5、对局部模型的非归一化层中间参数进行梯度加密处理,并上传至服务器,便于服务器根据各客户端上传的参数进行梯度聚合处理,进而更新全局模型。

6、在一示例中,所述接收服务器分发的初始模型及模型初始化参数前还包括:

7、向服务器发起注册请求,报头为名称、密码以及请求注册信息;服务器内预设有服务器ip、不同请求消息对应值、发送端口、接收端口、非归一化参数保存路径、隐私预算、训练批次、batch、epoch、学习率、本地数据路径;

8、收到成功码,注册成功;反之,注册失败;

9、注册成功的客户端向服务器发送模型请求报文,进而收到服务器分发的初始模型及模型初始化参数。

10、在一示例中,所述梯度加密处理为对局部模型的非归一化层添加噪声扰动。

11、需要进一步说明的是,上述以客户端作为执行主体的训练方法各示例对应的技术特征可以相互组合或替换构成新的技术方案。

12、本发明一种面向异构数据的本地差分隐私联邦学习训练方法,以服务器作为执行主体时,包括以下步骤:

13、向对应客户端分发初始模型及模型初始化参数;

14、接收客户端上传的局部模型的非归一化层中间参数,所述非归一化层中间参数为经过梯度加密处理的参数;

15、根据各客户端上传的参数进行梯度聚合处理,进而更新全局模型。

16、在一示例中,所述向对应客户端分发初始模型及模型初始化参数前还包括:

17、建立与模型端的连接,获取初始化模型;服务器中存储有客户端名称、密码、不同请求消息对应值、ip地址、发送端口、接收端口、模型路径、参数保存路径、初始化模型参数路径、每次传递字节数;

18、接收客户端发起的注册请求,并进行验证处理,验证通过,向客户端发送成功码,并基于客户端的模型请求报文向客户端分发初始模型及模型初始化参数。

19、在一示例中,所述根据各客户端上传的参数进行梯度聚合处理前还包括:

20、对上传的梯度值进行加权平均处理,再广播至各客户端。

21、在一示例中,所述服务器接收到最小聚合所需客户端数或达到最长等待时间后,停止接收参数,进行梯度聚合处理,更新全局模型。

22、在一示例中,所述服务器还用于执行日志记录及参数保存步骤,包括:

23、对参与训练的客户端进行统计,确定未参与训练的客户端名单;

24、对每轮更新的全局模型参数进行备份保存。

25、需要进一步说明的是,上述以服务器作为执行主体的训练方法各示例对应的技术特征可以相互组合或替换构成新的技术方案。

26、本发明还包括一种面向异构数据的本地差分隐私联邦学习训练系统,所述系统包括客户端,客户端依次连接有加密模块和客户端通信模块;

27、客户端用于接收服务器分发的初始模型及模型初始化参数,利用本地数据集对模型进行训练,得到局部模型,并将局部模型归一化层的中间参数保存至本地;

28、加密模块用于对局部模型的非归一化层中间参数进行梯度加密处理;

29、客户端通信模块用于将完成梯度加密处理的中间参数上传至服务器,便于服务器根据各客户端上传的参数进行梯度聚合处理,进而更新全局模型。

30、在一示例中,本发明一种面向异构数据的本地差分隐私联邦学习训练系统,所述系统包括服务器,服务器连接有模型端和服务器通信模块;

31、模型端用于提供初始模型;

32、服务器经服务器通信模块向对应客户端分发初始模型及模型初始化参数;同时服务器经服务器通信模块接收客户端上传的局部模型的非归一化层中间参数,非归一化层中间参数为经过梯度加密处理的参数;

33、服务器还用于根据各客户端上传的参数进行梯度聚合处理,进而更新全局模型。

34、需要进一步说明的是,上述系统各示例对应的技术特征可以相互组合或替换构成新的技术方案。

35、与现有技术相比,本发明有益效果是:

36、1.在一示例中,将包含均值、方差等隐私信息的归一化层的中间参数保存至本地,不上传至服务器,降低了隐私泄露风险;同时,仅对非归一化层中间参数进行梯度加密处理,能够将噪声控制在较小范围内,降低了通信代价,能够有效改善由于全局模型和局部模型特征漂移出现的异构性,大大提升了模型的收敛速度。

37、2.在一示例中,只有服务器允许的客户端才能获取初始模型,避免恶意客户端为窃取其他客户端信息或者以破坏全局模型为目的的加入,提升全局数据安全性。

技术特征:

1.一种面向异构数据的本地差分隐私联邦学习训练方法,其特征在于:所述方法以客户端作为执行主体,包括以下步骤:

2.根据权利要求1所述的面向异构数据的本地差分隐私联邦学习训练方法,其特征在于:所述接收服务器分发的初始模型及模型初始化参数前还包括:

3.根据权利要求1所述的面向异构数据的本地差分隐私联邦学习训练方法,其特征在于:所述梯度加密处理为对局部模型的非归一化层添加噪声扰动。

4.一种面向异构数据的本地差分隐私联邦学习训练方法,其特征在于:所述方法以服务器作为执行主体,包括以下步骤:

5.根据权利要求4所述的面向异构数据的本地差分隐私联邦学习训练方法,其特征在于:所述向对应客户端分发初始模型及模型初始化参数前还包括:

6.根据权利要求4所述的面向异构数据的本地差分隐私联邦学习训练方法,其特征在于:所述根据各客户端上传的参数进行梯度聚合处理前还包括:

7.根据权利要求4所述的面向异构数据的本地差分隐私联邦学习训练方法,其特征在于:所述服务器接收到最小聚合所需客户端数或达到最长等待时间后,停止接收参数,进行梯度聚合处理,更新全局模型。

8.根据权利要求4所述的面向异构数据的本地差分隐私联邦学习训练方法,其特征在于:所述服务器还用于执行日志记录及参数保存步骤,包括:

9.一种面向异构数据的本地差分隐私联邦学习训练系统,其特征在于:所述系统包括客户端,客户端依次连接有加密模块和客户端通信模块;

10.一种面向异构数据的本地差分隐私联邦学习训练系统,其特征在于:所述系统包括服务器,服务器连接有模型端和服务器通信模块;

技术总结

本发明公开了一种面向异构数据的本地差分隐私联邦学习训练方法及系统,属于数据安全技术领域,包括以下步骤:接收服务器分发的初始模型及其初始化参数,对模型进行训练,得到局部模型;将局部模型归一化层的中间参数保存至本地;对局部模型的非归一化层中间参数进行梯度加密处理,并上传至服务器,便于服务器进行梯度聚合处理,进而更新全局模型。本发明将包含均值、方差等隐私信息的归一化层的中间参数保存至本地,不上传至服务器,降低了隐私泄露风险;同时,仅对非归一化层中间参数进行梯度加密处理,能够将噪声控制在较小范围内,降低了通信代价,能够有效改善由于全局模型和局部模型特征漂移出现的异构性,大大提升了模型的收敛速度。

技术研发人员:匡平,许媛媛

受保护的技术使用者:电子科技大学

技术研发日:

技术公布日:2024/1/13

- 还没有人留言评论。精彩留言会获得点赞!