一种基于多目相机的室外视觉定位深度模型训练方法与流程

本发明涉及智能机器人,特别涉及一种基于多目相机的室外视觉定位深度模型训练方法。

背景技术:

1、目前在实施机器人定位时,一般情况下在室外主要的定位方法包括gps定位、基站定位和激光雷达定位等,而gps定位只能用于空旷场地,在隧道或遮挡较多的环境下无法搜寻gps信号,而基站和激光雷达定位成本较高;基于双目相机的视觉定位由于基线等限制,感知范围较小,所以大多数用于室内场景,而如何利用多目相机实现室外视觉定位,是本发明所要解决的主要问题。

技术实现思路

1、本发明的目的在于提供一种基于多目相机的室外视觉定位深度模型训练方法,以解决上述背景技术中提出的问题。

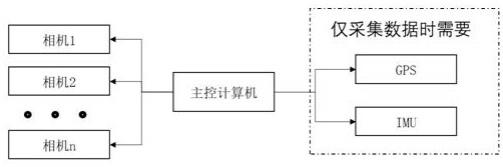

2、为实现上述目的,本发明一种基于多目相机的室外视觉定位深度模型训练方法,主要包括离线数据采集以及在线实时定位两部分;

3、进行离线数据采集时,在机器人四周的任意位置安装多个相机,并且安装imu、gps或基站装置,在需要定位的环境中进行数据采集;

4、在线实时定位时,利用机器人周围的多个相机采集图片,之后将图片输入至深度卷积网络中提取图片关键点,并与离线数据库中的关键点描述符进行匹配,通过所有相机的位姿信息解算出机器人的坐标和位姿信息。

5、进一步地,相机在拍摄每张图片时,会记录下当前的时间戳,保存当前imu和gps数据,在将数据离线采集结束后,将所有图片放入深度卷积网络中提取关键点信息和特征描述符向量,深度卷积网络分为骨干网络、关键点生成网络和特征描述符生成网络,其中骨干网络采用常见的resnet网络,用于提取图片特征信息,关键点生成网络能够提取图片中包含纹理特征的关键点,特征描述符生成网络能为每个关键点生成对应的特征描述符向量。

6、进一步地,关键点生成网络首先会在imagenet公开数据集上进行训练,使网络能够提取到鲁棒的关键点信息,之后将采集到的图像输入至深度卷积网络提取特征点信息,并使用resnet骨干网络提取到高维图像特征。

7、进一步地,图像特征张量大小维度为64,长宽只有相机图像的八分之一,即图像特征中的每个像素对应相机图像中8*8的像素块,在特征点提取分支中,使用3*3卷积对图像进一步特征提取并进行降维,之后使用softmax函数计算每个像素点的鲁棒性得分,之后进行阈值筛选(一般设为0.8),超过阈值的像素点为筛选后的特征点。

8、进一步地,在特征描述符向量分支中,会使用多层3*3卷积对图像特征做进一步提取,获得图像的高维度特征,特征点分支中的每一个像素点都对应着特征描述符向量中大小为1*256的向量,表示该像素点的抽象纹理特征信息。

9、进一步地,提取到特征点后,采用传统的暴力匹配的方法对不同图像之间的特征点进行匹配,通过不同图像中的相同特征点,能够估算出当前相机的位姿以及相对于特征点的距离,并能够对不同相机、以及不同时间拍摄的照片进行关键点拼接,关键点匹配地图。

10、进一步地,匹配后根据当前gps获得的机器人坐标信息,以及相机当前的位姿,能够得到相机之间以及相对于船体的相对位姿关系,并结合imu信息,获得当前机器人的位姿信息,将离线处理得到的多相机相对位置信息、构建的关键点匹配地图、以及gps和imu数据进行数据融合存储,得到全局离线语义信息地图。

11、进一步地,在实时定位阶段,相机拍摄照片后深度卷积网络获得关键点和特征描述符,之后将得到的关键点和特征描述符与全局离线语义信息地图中的关键点匹配地图进行匹配,采用交叉注意力网络对实时获取的关键点与全局离线语义信息地图中的融合数据进行匹配。

12、进一步地,交叉注意力网络的计算公式为:

13、

14、

15、其中,和分别为实时拍摄图像的特征和全局离线语义信息数据库的图像特征,上标(k)为当前的迭代次数,和为网络需要学习的权重矩阵,和为对应的偏置学习参数,输出为经过训练得到特征三元组(query,key,value),迭代多次提取两张图像间的抽象比对特征,计算最终特征三元组输出;

16、通过最终特征三元组,使用softmax函数计算匹配描述符矩阵z,匹配描述符矩阵中的每个元素对应每个特征点的匹配概率值,通过阈值筛选得到最终的输出匹配结果。

17、本发明的技术效果和优点:不受双目相机基线限制,不受传感器安装位置限制,在实时定位过程中不需要gps、imu的辅助只需要相机即可,另外,不受机器人型号、结构、形态限制,只需保证机器人的动作不影响各传感器间的刚性变换即可。

技术特征:

1.一种基于多目相机的室外视觉定位深度模型训练方法,其特征在于,主要包括离线数据采集以及在线实时定位两部分;

2.根据权利要求1所述的一种基于多目相机的室外视觉定位深度模型训练方法,其特征在于,所述相机在拍摄每张图片时,会记录下当前的时间戳,保存当前imu和gps数据,在将数据离线采集结束后,将所有图片放入深度卷积网络中提取关键点信息和特征描述符向量,深度卷积网络分为骨干网络、关键点生成网络和特征描述符生成网络,其中骨干网络采用常见的resnet网络,用于提取图片特征信息,关键点生成网络能够提取图片中包含纹理特征的关键点,特征描述符生成网络能为每个关键点生成对应的特征描述符向量。

3.根据权利要求2所述的一种基于多目相机的室外视觉定位深度模型训练方法,其特征在于,所述关键点生成网络首先会在imagenet公开数据集上进行训练,使网络能够提取到鲁棒的关键点信息,之后将采集到的图像输入至深度卷积网络提取特征点信息,并使用resnet骨干网络提取到高维图像特征。

4.根据权利要求3所述的一种基于多目相机的室外视觉定位深度模型训练方法,其特征在于,所述高维图像特征张量大小维度为64,长宽只有相机图像的八分之一,即图像特征中的每个像素对应相机图像中8*8的像素块,在特征点提取分支中,使用3*3卷积对图像进一步特征提取并进行降维,之后使用softmax函数计算每个像素点的鲁棒性得分,之后进行阈值筛选(一般设为0.8),超过阈值的像素点为筛选后的特征点。

5.根据权利要求4所述的一种基于多目相机的室外视觉定位深度模型训练方法,其特征在于,所述在特征描述符向量分支中,会使用多层3*3卷积对图像特征做进一步提取,获得图像的高维度特征,特征点分支中的每一个像素点都对应着特征描述符向量中大小为1*256的向量,表示该像素点的抽象纹理特征信息。

6.根据权利要求5所述的一种基于多目相机的室外视觉定位深度模型训练方法,其特征在于,所述提取到特征点后,采用传统的暴力匹配的方法对不同图像之间的特征点进行匹配,通过不同图像中的相同特征点,能够估算出当前相机的位姿以及相对于特征点的距离,并能够对不同相机、以及不同时间拍摄的照片进行关键点拼接,关键点匹配地图。

7.根据权利要求6所述的一种基于多目相机的室外视觉定位深度模型训练方法,其特征在于,所述图像匹配后根据当前gps获得的机器人坐标信息,以及相机当前的位姿,能够得到相机之间以及相对于船体的相对位姿关系,并结合imu信息,获得当前机器人的位姿信息,将离线处理得到的多相机相对位置信息、构建的关键点匹配地图、以及gps和imu数据进行数据融合存储,得到全局离线语义信息地图。

8.根据权利要求1所述的一种基于多目相机的室外视觉定位深度模型训练方法,其特征在于,所述在实时定位阶段,相机拍摄照片后深度卷积网络获得关键点和特征描述符,之后将得到的关键点和特征描述符与全局离线语义信息地图中的关键点匹配地图进行匹配,采用交叉注意力网络对实时获取的关键点与全局离线语义信息地图中的融合数据进行匹配。

9.根据权利要求8所述的一种基于多目相机的室外视觉定位深度模型训练方法,其特征在于,所述交叉注意力网络的计算公式为:

技术总结

本发明公开了一种基于多目相机的室外视觉定位深度模型训练方法,主要包括离线数据采集以及在线实时定位两部分;进行离线数据采集时,在机器人四周的任意位置安装多个相机,并且安装IMU、GPS或基站装置,在需要定位的环境中进行数据采集;在线实时定位时,利用机器人周围的多个相机采集图片,之后将图片输入至深度卷积网络中提取图片关键点,并与离线数据库中的关键点描述符进行匹配,通过所有相机的位姿信息解算出机器人的坐标和位姿信息。其有益效果:不受双目相机基线限制,不受传感器安装位置限制,在实时定位过程中不需要GPS、IMU的辅助只需要相机即可,只需保证机器人的动作不影响各传感器间的刚性变换即可。

技术研发人员:王佶骏,谷容辉,张继

受保护的技术使用者:江苏博人文化科技有限公司

技术研发日:

技术公布日:2024/1/13

- 还没有人留言评论。精彩留言会获得点赞!