本发明属于机器视觉领域,具体涉及一种针对微观离散噪声场景的深度估计方法。

背景技术:

1、现有的微纳米级三维重建方法主要分为三大类:激光共聚焦三维重建、白光干涉三维重建与基于光学图像的三维重建方法,激光共聚焦三维重建旨在通过激光器发射激光束对待测微观场景进行逐点,逐行和逐面进行扫描成像,处于场景焦平面的激光点将反射回探测针孔成像,最后汇集成微观场景的三维结构,但受限于激光发射器的成本昂贵与硬件集成化程度高等因素使其缺乏多场景适用性。白光干涉三维重建主要利用白光的低干涉性,由于干涉只发生在零光程差附近,干涉条纹对比度会随着光程差的增大而下降,通过算法找出微观场景表面每一点的零光程差位置,可得到各点的相对高度,进而获得微观场景的三维形貌结构。由于其精度可达纳米级,因此其扫描效率低下,除此之外,白光干涉三维重建无法获得场景的纹理信息。综上所述,激光共聚焦三维重建与白光干涉三维重建等微纳米级三维重建系统通常需要昂贵的硬件支撑,导致其使用成本可达几十万甚至上百万,这使其无法进行广泛应用。而基于光学图像的三维重建旨在通过二维图像的线索探寻场景不同的聚焦面,通过聚合不同聚焦面得到微观场景的相对深度信息,进而重构微观场景的三维结构,以面扫描方式代替前两类方法的点扫描的方式,可大幅提升微观场景的重建速度,并且光学成像可获得微观场景丰富的纹理信息。但现有的光学图像三维重建在针对具有高反射特性微观场景重建过程中容易出现较多的反射噪声点,进而导致重建精度下降。我们认为该问题的原因在于重建过程中缺乏对噪声信息的有效滤除导致。因此如何有效区别正常信息与噪声信息是实现微观离散噪声场景高精度三维重建的关键。

2、综上可知,本发明方法从统计学意义下数据的稳定性角度提出了具有噪声鲁棒性的微观场景深度估计方法,实现带有离散噪声的微观场景高精度的三维重建。

技术实现思路

1、为克服上述技术中存在的问题,本发明的目的是提供一种针对微观离散噪声场景的深度估计方法。

2、本发明所采取的技术方案是:一种针对微观离散噪声场景的深度估计方法,包括以下步骤:

3、步骤1,通过微米级步进电机采集微观离散噪声场景的多景深图像序列in,1≤n≤n,其中n为图像序列下标,n为图像序列总数;

4、步骤2,将步骤1得到的图像序列in,1≤n≤n与c个方向拉普拉斯算子cdmlc,1≤c≤c根据式(1)进行卷积操作得到c组图像序列的聚焦体积结果

5、

6、其中c为方向拉普拉斯算子下标,c为算子总数,为卷积运算符,方向拉普拉斯算子cdmlc,1≤c≤c的表达式如式(2)所示,

7、

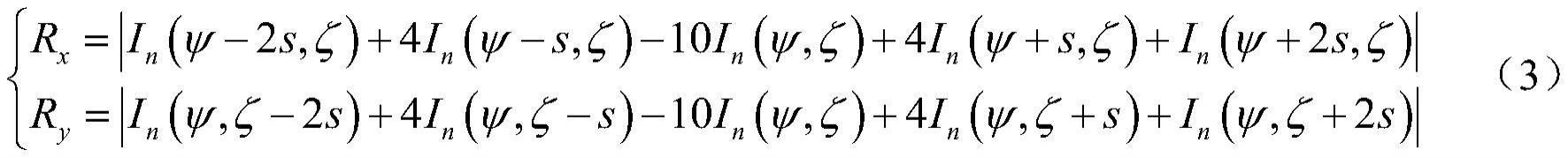

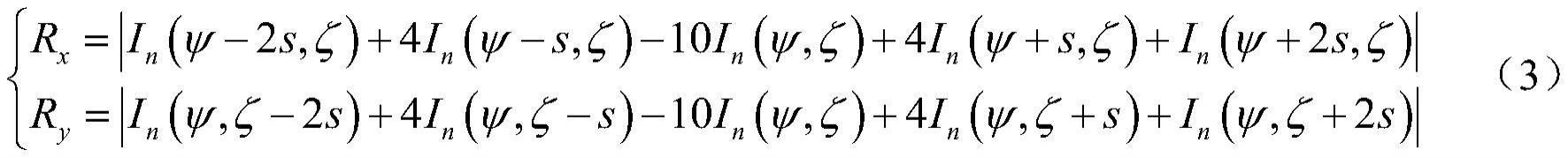

8、其中sin(·)与cos(·)分别为正弦与余弦函数,θ为角度参数,rx与ry分别为水平拉普拉斯算子与垂直拉普拉斯算子,其表达式如式(3)所示,

9、

10、其中像素坐标(ψ,ζ)为像素(x,y)的邻域坐标,s为步长,in(ψ,ζ)为第n幅图像in中(ψ,ζ)位置的灰度值;

11、步骤3,将步骤2得到的c组图像序列的聚焦体积结果按照式(4)计算得到c幅初始深度图dc,1≤c≤c,

12、

13、其中表示求解聚焦体积结果下标n的函数;

14、步骤4,对于步骤3得到的c幅初始深度图dc,1≤c≤c中每一幅深度图dk,1≤k≤c按照式(5)的数据稳定性约束条件进行选择,将满足条件的深度图组合为r幅深度图di,1≤i≤r,

15、

16、其中s2表示c幅初始深度图dc,1≤c≤c的方差,dj,1≤j≤c为c幅初始深度图中第j幅深度图,di,1≤i≤r为r幅选择后初始深度图中第i幅深度图;

17、步骤5,将步骤4得到的r幅初始深度图di,1≤i≤r按照式(6)得到融合后的深度图df;

18、

19、其中di,1≤i≤r为r幅选择后初始深度图中第i幅深度图;

20、步骤6,将步骤5得到的融合后的深度图df联合步骤1中的图像序列in,1≤n≤n按照式(7)得到对应的融合图像f,

21、

22、其中d2f(·)为深度图映射为灰度图函数;

23、步骤7,将步骤5得到的融合后的深度图df与步骤6得到的融合图像f按照式(8)得到微观离散噪声场景最终的深度图像d,

24、d=jointwmf(df,f) (8)

25、其中jointwmf(·)表示加权中值滤波函数。

26、与现有技术相比,本发明具有以下优点:

27、(1)本发明提出的深度估计方法从统计学数据稳定性视角下筛选出多种深度图中异常数据,进而实现微观场景中离散噪声的有效滤除,可获得微观场景更加准确的深度估计;

28、(2)本发明提出的深度估计方法具有较高的运算效率与广泛的场景适用性,特别适用于诸如包含较多高反表面的复杂微观场景,能够有效减少反射造成的噪声深度点。

技术特征:1.一种针对微观离散噪声场景的深度估计方法,其特征包括以下步骤:

技术总结本发明涉及一种针对微观离散噪声场景的深度估计方法。包括:步骤1,微米级步进电机采集微观离散噪声场景的多景深图像序列;步骤2,采用多方向拉普拉斯算子与图像序列进行卷积操作得到多个聚焦体积结果;步骤3,通过聚焦体积结果最大值所在位置得到多个初始深度图;步骤4,从统计学数据稳定性视角提出的约束条件对初始深度图进行筛选;步骤5,对筛选后的深度图进行融合;步骤6,联合图像序列与融合后的深度图得到融合图像;步骤7,融合后的深度图与融合图像通过加权中值滤波得到微观场景最终的深度图。本发明提出的方法可对微观离散噪声场景的深度信息进行准确估计。

技术研发人员:闫涛,刘凤娴

受保护的技术使用者:山西大学

技术研发日:技术公布日:2024/1/13