多智能体协作的3D对象检测方法与流程

本发明涉及人工智能,特别涉及一种多智能体协作的3d对象检测方法。

背景技术:

1、感知是指智能体(例如智能车辆、智能机器人、智能家居设备等)对周围环境感知和理解的能力。通过使用传感器和信息处理设备来使系统能够获取并处理环境中的各种信息,可以识别出场景中的物体、动作等信息,从而实现智能化的应用。传统的感知系统中,由一个单独智能体负责感知任务,然而在遮挡或者远距离场景中,这种基于单一智能体的3d对象检测方法存在其固有的局限性。因此,现有技术中提出,通过智能体之间进行通信和信息共享,搭建多智能体的感知网络。通过将多个智能体的感知信息进行整合和分析,提高系统的感知效率、可靠性和鲁棒性,可以适应更为的复杂环境。

2、现有技术在数据集和协同方法提出了很多改进,然而,通信带宽仍然是限制多智能体协同感知的一个重要瓶颈。通信带宽受限以及通信网络可能存在的波动,成为了限制多智能体之间协作的一大瓶颈。充分的信息交互能够最大化地提高群体智能的感知能力,然而通信带宽低的问题极大地限制了多智能体之间信息的传递,网络的波动同样对群体协作带来了不稳定性,在自动驾驶领域甚至带来了安全风险。

技术实现思路

1、本发明的目的在于提供一种多智能体协作的3d对象检测方法,以解决现有的多智能体协同感知受到通信带宽限制的问题。

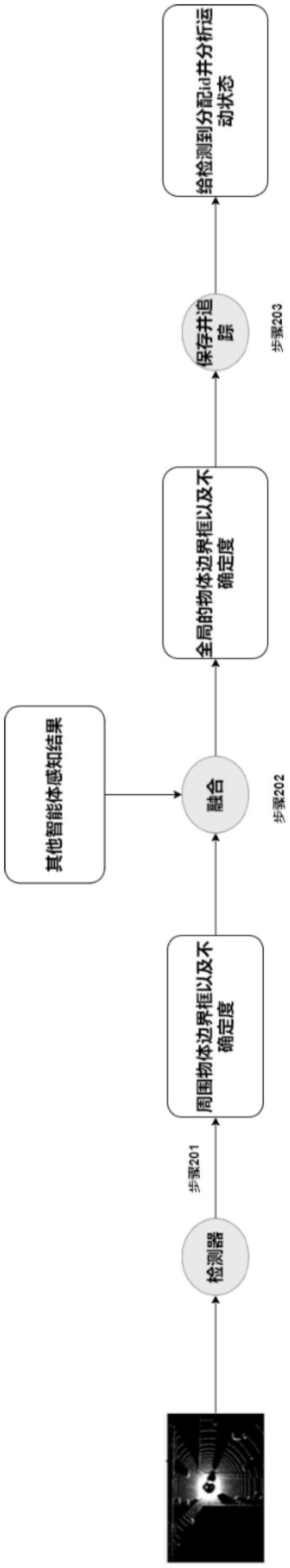

2、为解决上述技术问题,本发明提供一种多智能体协作的3d对象检测方法,包括:

3、在第一智能体上设置感知模块、预测模块和融合模块,在第二智能体上设置感知模块;

4、由第一智能体和第二智能体的感知模块基于传感器信息对周围物体的信息进行感知,分别得到第一感知信息和第二感知信息,其中第二感知信息作为第一智能体的交互信息;

5、由第一智能体的预测模块基于周围物体的历史信息对周围物体的当前状态进行预测,得到预测结果;以及

6、由第一智能体的融合模块与第二智能体进行信息交互,以使得第一感知信息与所述交互信息进行融合,以及使得第一感知信息与预测结果进行融合。

7、可选的,在所述的多智能体协作的3d对象检测方法中,还包括:

8、在初始化阶段中:

9、由多个智能体分别独立对3d对象进行检测,得到检测结果;

10、在每个智能体中,根据检测结果生成智能体周围物体的边界框;

11、在每个智能体中,智能体与该智能体交互范围内的其他智能体进行交互以融合多个智能体的检测结果,得到融合后的检测结果;以及

12、在每个智能体中,智能体存储融合后的检测结果;

13、在系统运行阶段中:

14、智能体基于周围物体的历史感知信息对周围物体的当前信息进行预测,得到预测结果,并计算预测的不确定性;

15、判断预测的不确定性是否大于置信阈值,若是则重新与周围智能体进行感知信息的融合,对物体信息进行修正;

16、否则将该智能体独立检测的检测结果与预测结果进行融合。

17、可选的,在所述的多智能体协作的3d对象检测方法中,在初始化阶段中还包括:

18、所述感知模块基于传感器信息感知周围物体的信息,所述周围物体的信息包括物体的边界框以及边界框的方差;

19、bi,t=fdetection(oi,t)={b1,b2,…,bn}

20、其中oi,t表示第i个智能体在t时刻传感器观测信息,并作为检测器的观测输入;fdetection表示智能体的检测模块所执行的动作;bj表示对周围3d对象感知到的边界框;bi,t表示第i个智能体在t时刻对周围3d对象感知到的边界框的集合;

21、其中,对于3d对象感知到的边界框:

22、

23、其中,(x,y,z)表示所述边界框的3d中心位置,l为边界框长度,w为边界框的宽度,h为边界框的高度,θ为边界框的偏航角,为边界框的中心位置方差,以及为边界框的偏航角方差。

24、可选的,在所述的多智能体协作的3d对象检测方法中,在初始化阶段中还包括:

25、协作系统初始化时,智能体自身与其他智能体连续n帧(n≥1)进行交互,交互信息mi,t定义为:

26、mj,t=(posej,t,bj,t)

27、其中mj,t为智能体j与智能体j在t时刻进行交互的信息;posei,t为智能体j在t时刻的位姿;bj,t表示智能体j在t时刻对周围对象感知到的边界框的集合。

28、可选的,在所述的多智能体协作的3d对象检测方法中,在初始化阶段中还包括:

29、基于智能体自身的感知信息与其他智能体的交互信息进行融合,从而生成协作的物体边界框ri,t;

30、mj→i=ftransform(mj,t,ξ′j→i),

31、ri,t=fusion(bi,t,mj→i,t,mj+1→i,t…)

32、其中ri,t表示基于智能体自身感知信息与智能体交互信息进行融合得到的检测结果;fusion为将智能体自身感知信息与智能体交互信息进行融合的方法;bi,t为智能体i在t时刻基于自身传感器信息的感知信息;mj,t为与智能体j在t时刻的交互信息。

33、可选的,在所述的多智能体协作的3d对象检测方法中,在初始化阶段中还包括:

34、循环上述步骤多次,直至预测模块能够对物体未来位置进行预测。

35、可选的,在所述的多智能体协作的3d对象检测方法中,在系统运行阶段中还包括:

36、智能体基于存储的历史信息对周围物体当前位置信息进行预测;

37、b′t=predection(rt-1,rt-2,…)={b′1,b′2,…,b′n}

38、其中,b′t为智能体基于历史数据对周围物体当前位置的预测,predection为基于物体历史信息对其当前位置进行预测的方法;rt-dt为智能体在t-dt时刻对周围物体融合感知的结果;

39、

40、其中,(x,y,z)表示所述边界框的3d中心位置,l为边界框长度,w为边界框的宽度,h为边界框的高度,θ为边界框的偏航角,为边界框的中心位置方差,以及为边界框的偏航角方差。

41、可选的,在所述的多智能体协作的3d对象检测方法中,在系统运行阶段中还包括:

42、如果基于历史信息的预测结果不确定度小于置信阈值,则智能体将基于历史信息的预测结果与基于当前帧感知信息进行融合,生成周围物体的边界框;否则,重新请求与周围的智能体进行信息交互,对智能体周围物体的信息进行修正;

43、基于卡尔曼滤波器预测过程对不确定度进行定义:

44、

45、其中,p为预测估计的协方差矩阵,pi,j表示第i个变量同第j个向量的协方差,其对角线元素分别为对应向量的方差,使用分别表征对应量的不确定度。pt-1|t-1为上一时刻的状态协方差矩阵,pt|t-1为基于上一时刻状态对当前时刻协方差矩阵的预测。ft为t时刻的变量的状态转移矩阵。qt为对应的过程噪声,表征运动学模型的不确定度。

46、可选的,在所述的多智能体协作的3d对象检测方法中,在系统运行阶段中还包括:

47、智能体将基于历史信息的预测结果与基于当前帧感知结果进行融合,生成周围物体的边界框包括:

48、ri,t=fusion(bi,t,b′i,t)

49、其中ri,t表示基于智能体自身感知结果与预测结果进行融合的结果;fusion为将智能体自身感知结果与对物体位置的预测进行融合的方法;bi,t为智能体i在t时刻基于自身传感器信息的感知结果;b′t为智能体基于历史数据对周围物体当前位置的预测。

50、本发明还提供一种智能体,实施如上任一项所述的多智能体协作的3d对象检测方法。

51、本发明的发明人通过研究发现,针对通信带宽受限的问题,现有技术采用神经网络方法来寻找需要交互的信息。该方法的核心思想是在周围智能体的感知中查找对于该智能体自身最为重要的部分,并将其作为补充信息传递。然而,现有方法仅考虑在每帧信息中进行信息交互,并未考虑通信波动(通信带宽的变化可能会导致信息传输的延迟或数据丢失)等不确定因素。

52、在本发明提供的多智能体协作的3d对象检测方法中,通过融合模块在关键时刻进行信息交互,以使得智能体自身的感知信息与其他智能体的交互信息进行融合,以及使得智能体自身的感知信息与预测结果进行融合,避免了现有方法仅考虑在每帧信息中进行信息交互,并未考虑通信波动等不确定因素的缺陷,通过考虑到通信波动等不确定因素,解决了通信带宽的变化可能会导致信息传输的延迟或数据丢失的问题。

- 还没有人留言评论。精彩留言会获得点赞!