基于跳出局部极小的改进卷积神经网络训练的方法

本发明属于人工智能领域,深度学习方向,发明了一种基于跳出局部极小的改进卷积神经网络训练的方法,应用在图像分类领域。

背景技术:

1、近年来人工智能的飞速进步离不开深度学习的快速发展,离不开人们对深度神经网络的不断研究。深度神经网络通常被用来在图像等领域上实现分类任务。深度神经网络通过不断训练已知标签的训练样本,从而对网络的参数值(包括权重和偏置)进行不断调整,最终实现对图像的精准分类。所以如何优化深度神经网络的参数值,提高对图像的分类正确率是深度学习领域目前研究的重要问题。本专利发明可应用在图像分类领域,旨在提高图像分类的正确率。

2、优化神经网络参数值至达到最优体现在使其训练损失达到全局最小,这样才能够保证该神经网络具有最好的预测能力和泛化能力,能够更好的完成诸如分类等任务。但是存在训练损失值大于全局最小的局部极小,在训练过程中很有可能会陷入局部极小,这会使我们无法得到最优化的神经网络。

3、利用常用的sgd和adam等优化算法对神经网络进行训练时,经常会陷入局部极小。了解当前优化得到的参数模型附近的损失景观图可以判断其是否为局部极小,将有助于解决这个难题。在此基础上,如何设计出有效地跳出局部极小的方法,使得能够继续优化神经网络,得到损失值更小、分类更精准的神经网络是我们应该深入思考的问题。

4、本发明旨在使用深度学习知识和相关数学知识,设计出基于跳出局部极小的改进卷积神经网络训练的方法,并通过编程实践佐证理论证明。本发明有助于避免训练过程中陷入局部极小,可以得到损失值更加小的卷积神经网络,能够对图像更加精准地分类。因此,本发明对于深度学习卷积神经网络方面的研究工作有着一定的理论和实际意义。

技术实现思路

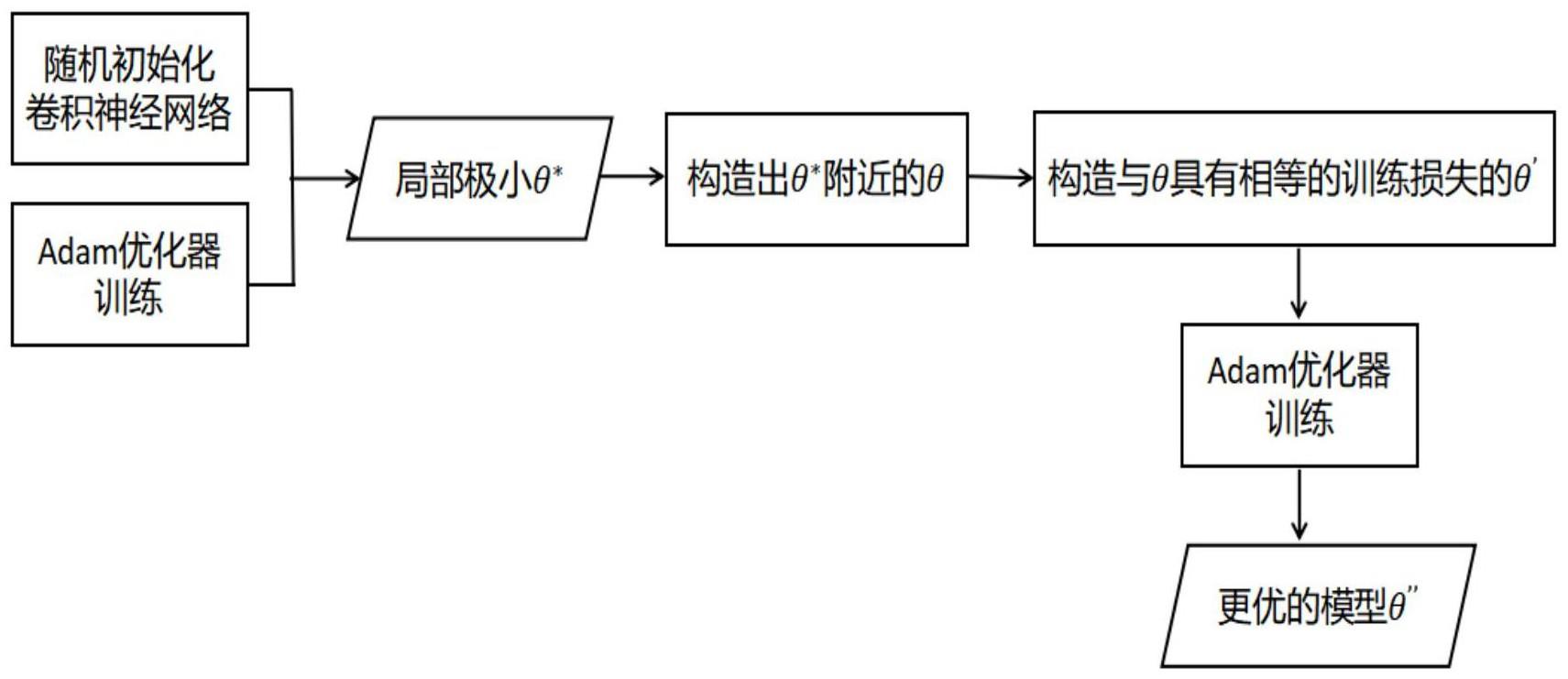

1、本发明要解决的问题是:设计出基于跳出局部极小的改进卷积神经网络训练的方法。本发明针对此问题,首先使用深度学习中广泛使用的adam优化器对随机初始化的卷积神经网络进行训练,当训练损失收敛时(训练损失不再下降),此时得到的卷积神经网络是参数空间中的一个局部极小值点,将这个卷积神经网络记作θ*。其次在参数空间中构造出θ*附近的一个点,也就是构造出一个与卷积神经网络θ*具有同样结构但是参数值发生了改变的另一个卷积神经网络,记作θ。再在参数空间中构造出与θ具有相等的训练损失的另一个点,也就是构造出一个与卷积神经网络θ具有同样结构但是参数值发生了改变并且训练损失值不发生改变的另一个卷积神经网络,记作θ′。进一步优化卷积神经网络θ′,可以使训练损失降至比卷积神经网络θ*的训练损失更低的程度,得到比θ*分类效果更好的卷积神经网络,记作θ″,代表成功跳出局部极小值点θ*。

2、本发明专利总体分为四大部分:

3、(1)使用深度学习中广泛使用的adam优化器对随机初始化的卷积神经网络进行训练,当训练损失收敛时(训练损失不再下降),此时得到的卷积神经网络是参数空间中的一个局部极小值点,将这个卷积神经网络记作θ*。

4、(2)在参数空间中构造出θ*附近的一个点,也就是构造出一个与卷积神经网络θ*具有同样结构但是参数值发生了改变的另一个卷积神经网络,记作θ。

5、(3)再在参数空间中构造出与θ具有相等的训练损失的另一个点,也就是构造出一个与卷积神经网络θ具有同样结构但是参数值发生了改变并且训练损失值不发生改变的另一个卷积神经网络,记作θ′。

6、(4)进一步优化卷积神经网络θ′,可以使训练损失降至比卷积神经网络θ*的训练损失更低的程度,得到比θ*分类效果更好的卷积神经网络,记作θ″,代表成功跳出了局部极小值点θ*。

7、本发明提出的方法具体技术方案如下:

8、1、使用深度学习中广泛使用的adam优化器对随机初始化的卷积神经网络进行训练,当训练损失收敛时(训练损失不再下降),此时得到的卷积神经网络是参数空间中的一个局部极小值点,记作θ*。

9、2、对优化得到的卷积神经网络θ*的最后两个卷积层和全连接层的部分参数进行特定改变,得到参数空间中θ*附近的一个点,也就是与卷积神经网络θ*具有同样结构但是参数值发生了改变的另一个卷积神经网络,记作θ。

10、3、在参数空间上构造出与卷积神经网络θ具有相等的训练损失的另一个点,也就是构造出一个与卷积神经网络θ具有同样结构但是参数值发生了改变并且训练损失值不发生改变的另一个卷积神经网络,记作θ′。

11、4、对卷积神经网络θ′继续进行优化,可以使训练损失降至比卷积神经网络θ*的训练损失更低的程度,得到比θ*分类效果更好的卷积神经网络,记作θ″,代表成功跳出了局部极小值点θ*。

12、本发明设计出了基于跳出局部极小的改进卷积神经网络训练的方法,有助于改进sgd和adam等优化算法导致训练过程中陷入局部极小的情况,可以得到损失更小、图片分类正确率更高的卷积神经网络。利用本专利发明的方法将会避免在优化卷积神经网络的过程中陷入局部极小,导致优化失败。

技术特征:

1.基于跳出局部极小的改进卷积神经网络训练的方法,其特征在于,包含以下几个步骤:

2.根据权利要求1所述的基于跳出局部极小的改进卷积神经网络训练的方法,其特征在于,所述步骤1具体包括:

3.根据权利要求1所述的基于跳出局部极小的改进卷积神经网络训练的方法,其特征在于,所述步骤2具体包括:

4.根据权利要求1所述的基于跳出局部极小的改进卷积神经网络训练的方法,其特征在于,所述步骤3具体包括:

5.根据权利要求1所述的基于跳出局部极小的改进卷积神经网络训练的方法,其特征在于,所述步骤4具体包括:

技术总结

本发明涉及一种基于跳出局部极小的改进卷积神经网络训练的方法,用于实现最优化卷积神经网络的目标。主要包括优化得到非平凡局部极小值点θ<supgt;*</supgt;、构造出参数空间中θ<supgt;*</supgt;附近的一个点θ、再构造出与θ具有相等的训练损失的另一个点θ′、进一步优化θ′使训练损失降至比θ<supgt;*</supgt;的训练损失更低的程度,实现跳出局部极小,得到分类效果更好的卷积神经网络。将本发明提出的方法在CIFAR 10数据集上进行实验验证,实验结果显示本发明所提出的方法是有效的,可以在优化卷积神经网络的过程中跳出局部极小,提高在CIFAR 10数据集上的分类正确率。

技术研发人员:刘波,傅可艺,袁彤彤,徐鹏

受保护的技术使用者:北京工业大学

技术研发日:

技术公布日:2024/1/14

- 还没有人留言评论。精彩留言会获得点赞!