基于自适应半异步联邦学习的模型训练系统、方法及设备

本发明属于联邦学习,涉及一种模型训练系统、方法及设备,具体涉及一种基于自适应半异步联邦学习的模型训练系统、方法及设备。

背景技术:

1、随着物联网(iot)的普及和大数据的不断发展,人们不再关注数据量的问题,转而开始关心数据的隐私和安全问题,许多国家和地区都开始颁布法律来保护用户的数据隐私,联邦学习是2016年google提出的一个机器学习框架,能有效帮助多个机构在满足用户隐私保护、数据安全和政府法规的要求下,进行数据使用和机器学习建模,它作为分布式机器学习中的一种隐私保护范式,可以有效解决数据孤岛问题,其中边缘客户端协作训练全局共享模型,而不会将其本地数据泄露给服务器。

2、目前有两种基本的联邦学习计算通信框架,一种是同步联邦学习。在同步联邦学习中,服务器每一轮都需要等到所有参与设备完成其模型参数的上传后,再进行模型聚合。由于设备资源的差异和设备上训练数据的差异,速度较快的设备再每轮训练中必须等待速度较慢的设备,这极大的较低了联邦学习的训练效率。另一种是异步联邦学习。在异步联邦学习中,服务器每一轮只等待部分参与设备上传其模型参数,再参与全局聚合任务,加快了模型聚合的速度。虽然异步联邦学习一定程度上平滑了设备性能差异对联邦学习效率的影响,但是对于未选中的终端设备来说,这种异步联邦学习抑制了这些设备可能加速模型收敛的潜力,同时也存在设备训练进度浪费问题。此外,这种异步联邦学习使得服务器在收集到少量本地模型后立即进行全局聚合,但训练过程想要覆盖所有的数据样本,就需要更多的训练轮次,可能会出现过拟合现象,使模型向局部最优解方向发展,降低模型在全局数据样本上的预测能力。

技术实现思路

1、为了解决上述技术问题,本发明是针对上述问题提供了一种基于自适应半异步联邦学习的模型训练系统、方法及设备,本发明充分考虑了终端设备性能的差异性,并充分发挥所有终端设备对模型收敛的潜在贡献,使服务器能够加速全局模型的训练。

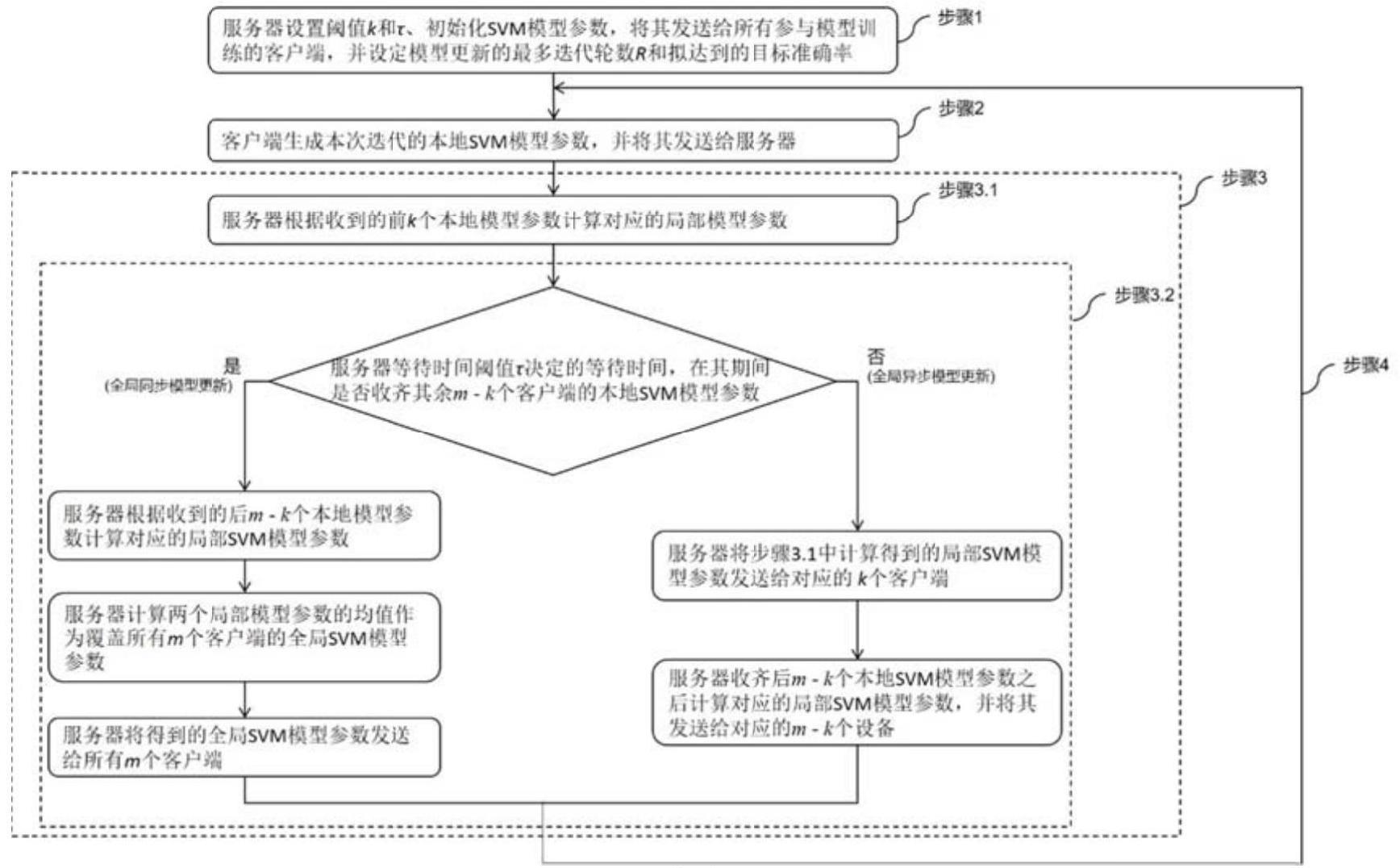

2、本发明的方法所采用的技术方案是:一种基于自适应半异步联邦学习的模型训练方法,采用基于自适应半异步联邦学习的模型训练系统;所述系统包括m个性能存在差异性的客户端和一个服务器;

3、所述方法根据每一轮客户端实际完成情况,将客户端自适应地分为两个部分:快速客户端和慢速客户端;最先提交本地模型参数发送给服务器的k个客户端记为本轮的快速客户端,剩余m-k个客户端记为本轮的慢速客户端;

4、服务器先聚合k个快速客户端的本地模型参数得到一个局部模型,并等待一预设时间τ后判断:

5、若在预设时间τ内m-k个慢速客户端的本地模型参数全部发送给服务器,则对所有客户端的本地模型参数进行一次全局模型的聚合,并把全局模型参数发送给所有客户端,进行下一轮迭代训练;

6、若在预设时间τ内m-k个慢速客户端的本地模型参数未全部发送给服务器,则服务器首先把之前聚合得到的局部模型参数发送给k个快速客户端;然后待收齐m-k个慢速客户端的本地模型参数后再聚合得到m-k个慢速客户端的局部模型,并将此局部模型参数发送给m-k个慢速客户端,进行下一轮迭代训练;

7、当全局模型收敛至预定的准确率或者模型训练轮数达到预设的阈值时,整个模型训练过程结束。

8、作为优选,若全局模型参数更新频率大于预设值a,则缩小时间阈值τ;若全局模型参数更新频率小于预设值b,则增大时间阈值τ。

9、作为优选,根据每一轮客户端实际完成情况,将客户端自适应地分为快速客户端和慢速客户端;每轮迭代中服务器自适应地进行全局异步模型更新和全局同步模型更新;

10、其中,自适应体现在快速客户端和慢速客户端不是系统指定的,也不是固定不变的,而是根据客户端具体的执行效率和其网络环境动态决定的;不同的客户端计算并提交本地模型训练参数给服务器的快慢取决于客户端拥有的计算资源多少和所处网络环境的好坏;

11、自适应还体现在每轮服务器进行的是全局同步模型更新还是全局异步模型更新不是系统指定的,而是根据客户端的实际运行情况动态决定的;如果在某轮模型迭代训练中所有客户端本地模型参数的实际上传时间均在阈值区间内,那么系统将进行全局同步模型更新,否则进行全局异步模型更新。

12、本发明的设备所采用的技术方案是:一种基于自适应半异步联邦学习的模型训练设备,包括:

13、一个或多个处理器;

14、存储装置,用于存储一个或多个程序,当所述一个或多个程序被所述一个或多个处理器执行时,使得所述一个或多个处理器实现所述的基于自适应半异步联邦学习的模型训练方法。

15、本发明还提供了一种存储介质,存储有程序;所述程序被处理器执行时,实现所述的基于自适应半异步联邦学习的模型训练方法。

16、本发明的有益效果为:本发明所有愿意参与联邦学习的终端设备作为客户端都能随时加入训练过程,服务器在收到满足预定数量的客户端训练结果时进行聚合,同时通过预设的时间阈值来判断是否进行全局同步聚合,还是对客户端训练结果进行全局异步聚合。整个训练过程中,参与模型训练的快速客户端不会受到慢速客户端的影响,同时让模型训练覆盖了所有客户端的数据集,充分发挥了慢速客户端对全局模型收敛的潜在贡献。在实际应用中,作为客户端的终端设备普遍存在速度差异问题,因此,本发明更具实际应用价值。

技术特征:

1.一种基于自适应半异步联邦学习的模型训练方法,采用基于自适应半异步联邦学习的模型训练系统;所述系统包括m个性能存在差异性的客户端和一个服务器;

2.根据权利要求1所述的基于自适应半异步联邦学习的模型训练方法,其特征在于:若全局模型参数更新频率大于预设值a,则缩小时间阈值τ;若全局模型参数更新频率小于预设值b,则增大时间阈值τ。

3.根据权利要求1所述的基于自适应半异步联邦学习的模型训练方法,其特征在于:根据每一轮客户端实际完成情况,将客户端自适应地分为快速客户端和慢速客户端;每轮迭代中服务器自适应地进行全局异步模型更新和全局同步模型更新;

4.一种基于自适应半异步联邦学习的模型训练设备,其特征在于,包括:

5.一种存储介质,存储有程序;其特征在于,所述程序被处理器执行时,实现权利要求1至3中任一项所述的基于自适应半异步联邦学习的模型训练方法。

技术总结

本发明公开了一种基于自适应半异步联邦学习的模型训练系统、方法及设备,系统包括客户端、服务器,客户端和服务器通过多轮交互实现模型的迭代更新以完成全局模型训练。在整个过程中客户端数据始终保存在客户端本地,同时客户端可以随时加入或退出本系统的模型训练。由于客户端的性能差异,不同客户端完成一次本地训练的用时不同,为了提高全局模型训练的效率,服务器在收到一定数量的本地模型参数后即刻开始进行局部模型参数的更新,并在等待一定时间后根据其余客户端本地模型的达到情况,自适应地决定是进行一次全局同步模型更新还是一次全局异步模型更新。本发明可灵活应用于分布式机器学习、分布式深度学习的应用场景中,具有很高的实用性。

技术研发人员:沈华,李磊,张明武

受保护的技术使用者:湖北工业大学

技术研发日:

技术公布日:2024/1/16

- 还没有人留言评论。精彩留言会获得点赞!