基于混合Transformer超分辨率网络的图像超分辨率方法

本发明涉及单图像超分辨率,尤其是一种基于混合transformer超分辨率网络的图像超分辨率方法。

背景技术:

1、在大数据时代,高分辨率图像在各个领域的广泛应用日益显著。在社交媒体领域中,高分辨率图像有助于提升用户的视觉体验;在医疗领域中,高分辨率图像可协助专业人士做出更准确的诊断与判断;在安全领域中,高分辨率图像有助于维护社会治安与监控。然而,由于设备成本、自然环境等多种因素的限制,采集到的图像通常具有低分辨率、质量不佳以及模糊的特点。因此,单图像超分辨率(single image super-resolution,sisr)技术对各个领域都具有重要的研究价值和实际应用意义。

2、sisr是一种用于从低分辨率(low-resolution,lr)图像生成高分辨率(high-resolution,hr)图像的技术。近年来,卷积神经网络(convolutional neural network,cnn)由于其拟合复杂映射的强大能力成为了研究的热点。基于卷积神经网络cnn的超分辨率sr方法因其从图像中提取高频细节的强大能力而广受欢迎,然而,使用基于cnn的方法建立全局依赖关系是困难的。作为替代方案,基于transformer的方法利用强大的自我注意机制sa对输入数据的全局依赖性进行建模,并显示出令人印象深刻的性能。

3、最近,几项研究发现,transformer缺乏在局部区域内信息聚合的局部机制。局部信息与图像的纹理和细节高度相关,对sisr至关重要。同时,随着越来越多的sr网络需要加载到移动或嵌入式设备上,轻量级sr(lsr)方法已逐渐成为研究热点。许多基于transformer的轻量级网络,例如esrt,elan-light,swinir,这些方法通过修改sa计算来降低复杂性,或者对多个sa使用非固定计算窗口或共享注意力机制,然而,修改后的网络仍然非常复杂,sa仍然是lsr应用的昂贵模块。

技术实现思路

1、为了解决现有基于transformer的轻量级技术如何在减少复杂性的同时增强关键的局部特征提取并实现高效的全局依赖性的问题,本发明的目的在于提供一种增强网络的局部信息的提取能力,并且提高网络全局建模的效率,以此得到更加优秀的超分辨率图像的基于混合transformer超分辨率网络的图像超分辨率方法。

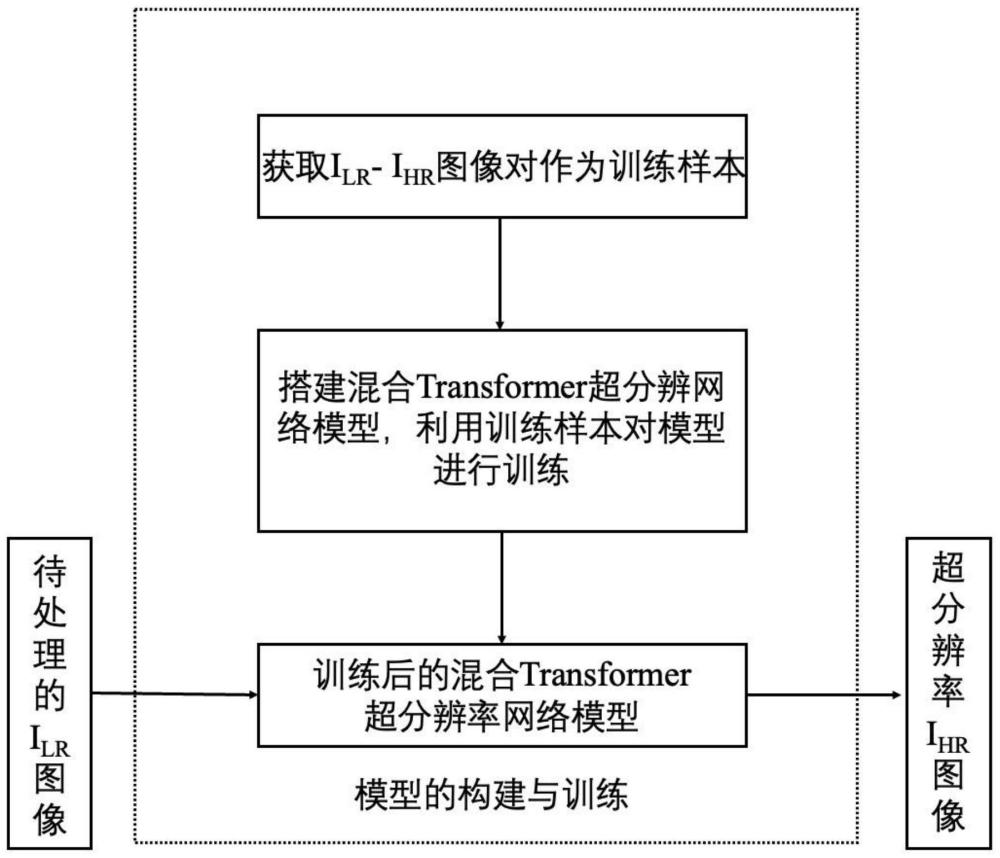

2、为实现上述目的,本发明采用了以下技术方案:一种基于混合transformer超分辨率网络的图像超分辨率方法,该方法包括下列顺序的步骤:

3、(1)首先获取图像对作为训练样本,图像对由图像ilr和图像ihr组成;

4、(2)搭建混合transformer超分辨率网络模型;

5、(3)利用训练样本对混合transformer超分辨率网络模型进行训练,得到训练后的混合transformer超分辨率网络模型;

6、(4)将待处理图像作为lr图像导入到训练后的混合transformer超分辨率网络模型中,混合transformer超分辨率网络模型输出的结果即为hr图像。

7、所述步骤(1)具体包括以下步骤:

8、(1a)获取高分辨率图像hr;

9、(1b)对高分辨率图像hr进行剪裁,得到剪裁后的图像ihr;

10、(1c)对剪裁后的图像ihr进行下采样得到图像ilr:

11、ilr=imresize(crop(ihr,s),method='bicubic')

12、其中,imresize()代表imresize函数,crop(ihr,s)代表将图像ihr的高度h和宽度w调整为下采样倍数s的整数倍,method代表下采样所使用的插值函数,'bicuic'为双三次插值函数;

13、(1d)将图像ilr和图像ihr组成图像对,并转换为张量形式的图像对;

14、(1e)将张量形式的图像对进行封装得到训练样本。

15、所述步骤(2)具体是指:所述混合transformer超分辨率网络模型包括浅层特征提取单元、深层特征提取单元和高分辨率重建单元,混合transformer超分辨率网络模型的表达式如下:

16、isr=hrec(hdf(hsf(iin)))

17、其中,iin为超分辨率网络模型的输入,isr为混合transformer超分辨率网络模型输出的超分辨率结果,hsf、hdf与hrec分别代表浅层特征提取单元、深层特征提取单元和高分辨率重建单元的函数。

18、所述步骤(3)具体包括以下步骤:

19、(3a)将图像ilr输入混合transformer超分辨率网络模型中得到超分辨率结果isr;

20、(3b)根据超分辨率结果isr、图像ihr以及下列损失函数计算公式计算损失loss:

21、

22、其中,n为每一批次的总样本数;

23、(3c)若loss的值未达到设定的阈值,通过反向传播算法,使混合transformer超分辨率网络模型参数沿loss损失函数梯度最小化方向进行更新,来优化混合transformer超分辨率网络模型的各个权重值,直到达到设定的阈值为止。

24、所述浅层特征提取单元包括第一卷积层,其表达式如下:

25、fshallow=c1(ilr)

26、其中,fshallow代表浅层特征提取单元从其输入中提取的浅层特征,c1代表第一卷积层的函数。

27、所述深层特征提取单元包括6个混合的transformer模块,其表达式如下:

28、

29、其中,fdf代表深层特征提取单元从其输入中提取的深层特征,hmtb代表混合的transformer模块的函数;fshallow代表浅层特征提取单元从其输入中提取的浅层特征;n取值为6;

30、所述混合的transformer模块由全局transformer层和局部transformer层组成,其表达式如下:

31、fmtb=hltl(hgtl(fin))

32、其中,fin,fmtb分别代表混合的transformer模块的输入和输出,hltl,hgtl分别代表局部transformer层、全局transformer层的函数;

33、所述局部transformer层由像素混合器、批量归一化和第一多层感知机组成,其表达式如下:

34、fout1=hmlp1(hbn(hpm(fin1))+fin1)+hbn(hpm(fin1))+fin1

35、其中,fout1和fin1分别代表局部transformer层的输出和输入,hpm、hbn和hmlp1分别为像素混合器、批量归一化和第一多层感知机的函数;

36、所述全局transformer层由条纹自注意力、第二多层感知机组成,其表达式如下:

37、fout2=hmlp2(hswsa(fin2)+fin2)+(hswsa(fin2))+fin2

38、其中,fout2和fin2分别代表全局transformer层的输出和输入,hswsa和hmlp2分别为条纹自注意力、第二多层感知机的函数。

39、所述高分辨率重建单元包括1个第二卷积层和1个亚像素卷积层,其表达式如下:

40、isr=p(c2(fdf))

41、其中,p和c2分别代表亚像素卷积层、第二卷积层的函数,fdf代表深层特征提取单元从其输入中提取的深层特征。

42、由上述技术方案可知,本发明的有益效果为:第一,本发明通过构建混合transformer超分辨率网络模型,在参数和性能做出合适权衡;第二,每个混合的transformer模块包含全局transformer层和局部transformer层,全局transformer层可以方便的提取图像的全局结构特征,同时局部transformer层增强了网络的局部信息的提取能力,并且提高网络全局建模的效率,得到更加优秀的超分辨率图像,通过对图像中的全局结构信息局部纹理信息作有针对性的处理,实现了在多种超分辨率任务下的优异表现。

- 还没有人留言评论。精彩留言会获得点赞!