大模型在线推理与训练一体化方法及系统与流程

本公开涉及数据处理,尤其涉及一种大模型在线推理与训练一体化方法及系统。

背景技术:

1、目前,大模型即大语言模型的落地使用,在获取基座模型之后可以分为三个阶段,包括监督微调模型训练、符合人类偏好的强化模型训练和推理部署。具体的如附图1-3所示,先将一个基座模型通过监督微调成具备对话能力的微调模型后,再对一定量指令模型的不同回复,进行人工打分标注,训练得到奖励模型,并基于奖励模型进行符合人类偏好的强化训练,对目标微调模型施加文本分布约束。还需要说明的是,现有的大模型部署推理服务过程中,根据用户的输入指令文本进行多轮对话。其中,上述三个阶段基本相互独立,使得每次模型迭代都需要人工启动流程,检测步骤中间结果,存在迭代人工工作量大的问题,且具有一定延时性,无法充分实时的利用用户输入数据。

2、因此,提供一种能够整合上述三个阶段的方法,减少模型迭代时的人工参与,并实时利用用户输入数据,是目前亟待解决的问题。

技术实现思路

1、为了解决上述问题,本申请提出一种大模型在线推理与训练一体化方法及系统,以解决上述问题。

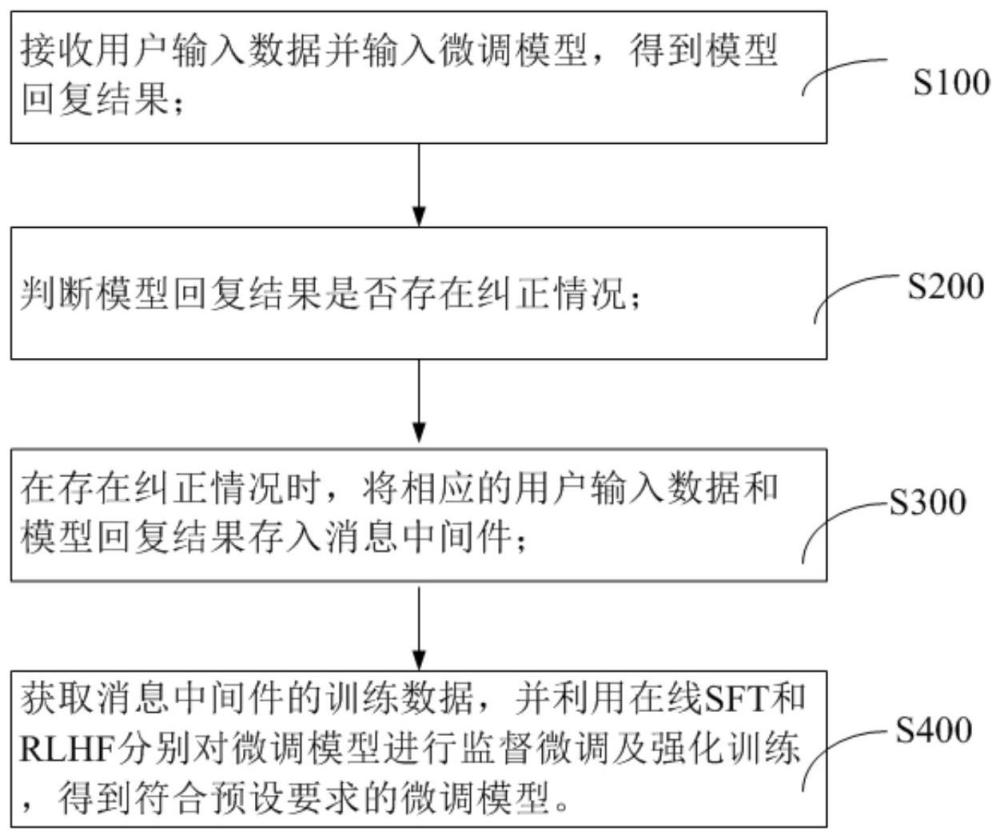

2、本申请一方面,提出一种大模型在线推理与训练一体化方法,包括如下步骤:

3、接收用户输入数据并输入微调模型,得到模型回复结果;

4、判断所述模型回复结果是否存在纠正情况;

5、在存在所述纠正情况时,将相应的所述用户输入数据和所述模型回复结果存入消息中间件;

6、获取所述消息中间件的训练数据,并利用在线sft和rlhf分别对所述微调模型进行监督微调及强化训练,得到符合预设要求的所述微调模型。

7、作为本申请的一可选实施方案,可选地,所述接收用户输入数据并输入微调模型,得到模型回复结果,包括:

8、接受用户输入指令和文本;

9、将所述用户输入指令和文本输入所述微调模型进行多轮对话,得到相应的模型回复结果;

10、其中,所述微调模型能够部署对话任务。

11、作为本申请的一可选实施方案,可选地,在利用在线sft对所述微调模型进行监督微调时,所述在线sft的训练数据包括sft数据和预先标注的监督训练数据;

12、其中,所述sft数据基于所述用户输入指令文本和所述模型回复结果中对应的纠正语义组合得到。

13、作为本申请的一可选实施方案,可选地,在利用rlhf对所述微调模型进行强化训练时,包括:

14、获取奖励模型训练数据;

15、基于所述奖励模型训练数据对奖励模型进行训练,更新所述奖励模型;

16、利用所述奖励模型对所述模型回复结果打分,强化训练所述微调模型。

17、作为本申请的一可选实施方案,可选地,所述奖励模型训练数据基于所述用户输入数据,以及所述模型回复结果中的chosen回复和rejected回复组建得到。

18、作为本申请的一可选实施方案,可选地,在获取奖励模型训练数据后,还包括:

19、对所述微调模型进行文本分布约束,提高所述奖励模型的打分结果。

20、作为本申请的一可选实施方案,可选地,还包括:

21、利用旁路模型更新所述微调模型的参数。

22、本申请一方面,提供一种系统,用于实现上述任一项所述的大模型在线推理与训练一体化方法,包括:

23、数据获取模块,被配置为接收用户输入数据并输入微调模型,得到模型回复结果;

24、数据判断模块,被配置为判断所述模型回复结果是否存在纠正情况;

25、数据存储模块,在存在所述纠正情况时,将相应的所述用户输入数据和所述模型回复结果存入消息中间件;

26、模型训练模块,获取所述消息中间件的训练数据,并利用在线sft和rlhf分别对所述微调模型进行监督微调及强化训练,得到符合预设要求的所述微调模型。

27、本申请一方面,提供一种电子设备,包括:

28、处理器;

29、用于存储处理器可执行指令的存储器;

30、其中,所述处理器被配置为执行所述可执行指令时实现上述任一项所述的大模型在线推理与训练一体化方法。

31、本申请一方面,提供一种非易失性计算机可读存储介质,其上存储有计算机程序指令,其特征在于,所述计算机程序指令被处理器执行时实现上述任意一项所述的大模型在线推理与训练一体化方法。

32、本发明的技术效果:

33、本申请通过将用户输入数据和微调模型的回复结果存入消息中间件,借此充分利用前向推理阶段的过程向量和用户结果反馈,实现重复利用的目的,从而有效的解决每次模型迭代都需要人工启动流程的问题。具体的,包括接收用户输入数据并输入微调模型,得到模型回复结果;判断模型回复结果是否存在纠正情况;在存在纠正情况时,将相应的用户输入数据和模型回复结果存入消息中间件;获取消息中间件的训练数据,并利用在线sft和rlhf分别对微调模型进行监督微调及强化训练,得到符合预设要求的微调模型。也即,本申请根据中间件保存的在线监督训练数据和在线符合人类偏好强化模型训练数据,相应利用在线sft和rlhf对微调模型进行监督微调和强化训练,进一步的优化微调模型,使其更加符合人类偏好。

34、根据下面参考附图对示例性实施例的详细说明,本公开的其它特征及方面将变得清楚。

技术特征:

1.一种大模型在线推理与训练一体化方法,其特征在于,包括如下步骤:

2.根据权利要求1所述的大模型在线推理与训练一体化方法,其特征在于,所述接收用户输入数据并输入微调模型,得到模型回复结果,包括:

3.根据权利要求1所述的大模型在线推理与训练一体化方法,其特征在于,在利用在线sft对所述微调模型进行监督微调时,所述在线sft的训练数据包括sft数据和预先标注的监督训练数据;

4.根据权利要求1所述的大模型在线推理与训练一体化方法,其特征在于,在利用rlhf对所述微调模型进行强化训练时,包括:

5.根据权利要求4所述的大模型在线推理与训练一体化方法,其特征在于,所述奖励模型训练数据基于所述用户输入数据,以及所述模型回复结果中的chosen回复和rejected回复组建得到。

6.根据权利要求4所述的大模型在线推理与训练一体化方法,其特征在于,在获取奖励模型训练数据后,还包括:

7.根据权利要求1所述的大模型在线推理与训练一体化方法,其特征在于,还包括:

8.一种系统,用于实现上述权利要求1-7中任一项所述的大模型在线推理与训练一体化方法,其特征在于,包括:

9.一种电子设备,其特征在于,包括:

10.一种非易失性计算机可读存储介质,其上存储有计算机程序指令,其特征在于,所述计算机程序指令被处理器执行时实现权利要求1至7中任意一项所述的大模型在线推理与训练一体化方法。

技术总结

本申请涉及一种大模型在线推理与训练一体化方法及装置,该方法包括接收用户输入数据并输入微调模型,得到模型回复结果;判断模型回复结果是否存在纠正情况;在存在纠正情况时,将相应的用户输入数据和模型回复结果存入消息中间件;获取消息中间件的训练数据,并利用在线SFT和RLHF分别对微调模型进行监督微调及强化训练,得到符合预设要求的微调模型。本申请通过将用户输入数据和微调模型的回复结果存入消息中间件,借此充分利用推理过程中的前向过程向量和用户反馈,从而实现重复利用的目的,有效的解决每次模型迭代都需要人工启动流程的问题。

技术研发人员:吴东

受保护的技术使用者:吴东

技术研发日:

技术公布日:2024/3/11

- 还没有人留言评论。精彩留言会获得点赞!