基于改进YOLOv7-tiny模型的多尺度运动目标检测方法

本发明属于目标检测技术,特别涉及一种基于改进yolov7-tiny模型的多尺度运动目标检测方法。

背景技术:

1、随着经济水平的提升,道路上的行人、车辆数量持续增长,监控系统不止需要监测危险人物,同时也要对危险车辆的识别监测。为了保障管控区域安全、加强对入侵目标的检测,基地对监控系统的性能要求越来越高,监控距离的要求也在提高,从近处检测延伸到远距离警戒。监控系统的水平提高对基地安全的保障有质的提升。

2、近年来对远距离小目标检测技术的研究虽然有许多突破,但是识别速度和精度都不够高,且会影响正常目标检测的精度,性能指标之间达不到平衡。202211628492公开了《一种基于改进的yolo多尺度检测的车辆目标识别方法》,通过添加eca注意力模块和一个小目标检测层以解决现有的车辆目标检测方法在相对复杂场景中所表现出的精度低问题,但模型的参数量变大、对目标特征提取不彻底,模型性能提升不显著。因此开发出同时适用监控场景、能够同时对远距离小目标与近距离大目标正常检测的算法对重要区域的管控尤为重要。

技术实现思路

1、为解决远距离入侵目标成像像素少,纹理信息不足以及在目标持续接近过程中的大尺度变换导致的模型误检、漏检问题,本发明提出一种基于改进yolov7-tiny的多尺度运动目标检测方法,该方法使用新的obm模块提高网络的特征提取能力,能够融合不同层次的特征,加强同级别、相邻层之间的融合,ac-bifpn将进行自适应加权融合后的多层次特征传给注意力机制,以提升模型对多尺度目标的感知能力,使得模型对监控图像中不同尺寸的目标性能更加优越,并通过改进损失函数优化锚框,得到更精确的预选框。改进的yolov7-tiny模型对各层次的特征进行深度挖掘、融合,提高模型对多尺度目标的感知能力,减少模型预测偏差,实现检测精度与检测效率的平衡。

2、实现本发明的技术解决方案为:

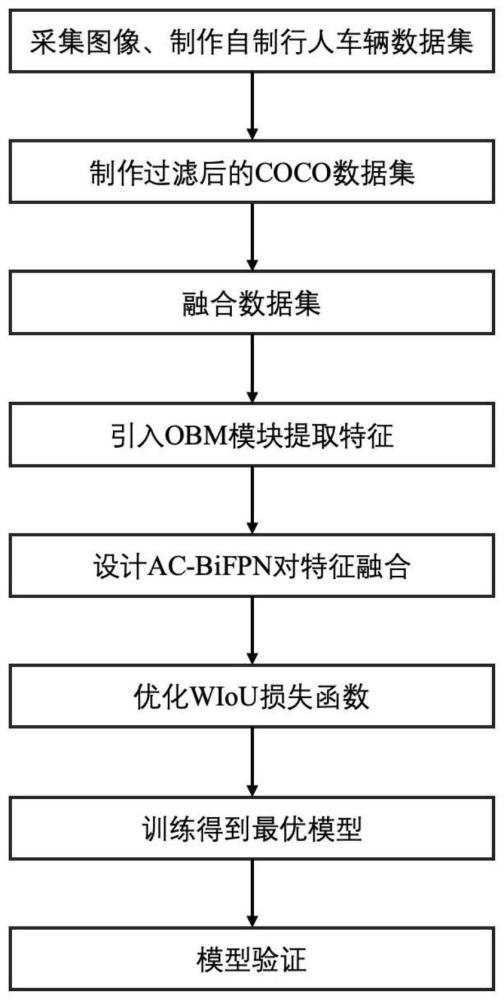

3、一种基于改进yolov7-tiny模型的多尺度运动目标检测方法,步骤如下:

4、步骤s1、以监控视角拍摄行人车辆视频,对视频进行抽帧率处理获得图像数据集,并标注图像,格式设置为yolo,得到自制行人车辆数据集,转入步骤s2。

5、步骤s2、对coco数据集进行类别过滤,保留只有行人和车辆类别的图片及标签数据,并将标签格式转换为yolo,得到过滤后的coco数据集,转入步骤s3。

6、步骤s3、将自制行人车辆数据集与过滤后的coco数据集融合,得到融合数据集;所述融合数据集共有七类目标,类别名称分别为person、car、truck、train、motorcycle、bicycle、bus,将融合数据集按照8:1:1的比例划分为训练集、验证集和测试集,转入步骤s4。

7、步骤s4、设计改进后的yolov7-tiny模型,转入步骤s5。

8、步骤s5、将训练集送入改进后的yolov7-tiny模型进行训练,得到训练后的yolov7-tiny模型,转入步骤s6。

9、步骤s6、采用wiou梯度增益分配策略,将优化后模型的预测结果和融合数据集中的真实标签计算交叉熵损失,通过反向传播与参数更新得到优化后的yolov7-tiny模型,转入步骤s7。

10、步骤s7、将融合数据集的验证集输入优化后的yolov7-tiny模型,得到较优的模型结果与优化后的yolov7-tiny模型精度,实现目标检测。

11、本发明与现有技术相比,其显著优点在于:

12、(1)本发明提升模型精度的同时,多维注意力机制是以并行的方式沿着核空间的所有四个维度学习卷积核的四种类型的注意力,这样不像其他多内核的动态卷积会增加巨大的参数量,影响模型效率,对cbl模块的激活函数进行了优化,mish的曲线更加光滑且增加了下界,具有更好的学习适应能力,模型会得到更高的准确率和泛化能力。

13、(2)ac-bifpn在几乎不增加计算成本的同时融合更多特征,有效减少了各个尺度目标的漏检,提高对模型目标的检测能力;

14、(3)本发明调整了yolov7-tiny模型的损失函数,使用wiou损失函数对预测框与真实框之间的区域加权,减少模型预测偏差。

15、(4)本发明提出基于yolov7-tiny改进的远距离目标检测方法,改进后的yolov7-tiny模型精度更高、误检漏检的情况得到极大改善,且检测速度没有收到影响,效果优于原网络模型和其他经典模型,达到了精度与速度的平衡。

技术特征:

1.一种基于改进yolov7-tiny模型的多尺度运动目标检测方法,其特征在于,步骤如下:

2.根据权利要求1所述的基于改进yolov7-tiny模型的多尺度运动目标检测方法,其特征在于,步骤s4中,设计改进后的yolov7-tiny模型,包括输入层、骨干网络层和头部层。

3.根据权利要求2所述的基于改进yolov7-tiny模型的多尺度运动目标检测方法,其特征在于,步骤s5中,将训练集送入改进后的yolov7-tiny模型进行训练,得到训练后的yolov7-tiny模型,具体如下:

4.根据权利要求3所述的基于改进yolov7-tiny模型的多尺度运动目标检测方法,其特征在于,骨干网络层利用改进的obm模块实现特征提取,并利用多维注意力机制提高网络的特征提取能力,具体如下:

5.根据权利要求4所述的基于改进yolov7-tiny模型的多尺度运动目标检测方法,其特征在于:头部层将骨干网络层传来的特征进行融合,包括elan、cbl以及sppcspc;sppcspc利用卷积和三个maxpool操作,获取到四种不同的感受野,以适应不同分辨率的图像,用来区分不同像素占比的目标。

6.根据权利要求5所述的基于改进yolov7-tiny模型的多尺度运动目标检测方法,其特征在于:在头部层首次利用acmix-bifpn以聚合不同分辨率的特征;

7.根据权利要求6所述的基于改进yolov7-tiny模型的多尺度运动目标检测方法,其特征在于:步骤s6中,采用wiou梯度增益分配策略,将优化后模型的预测结果和融合数据集中的真实标签计算交叉熵损失,通过反向传播与参数更新得到优化后的yolov7-tiny模型,具体如下:

技术总结

本发明公开了一种基于改进YOLOv7‑tiny模型的多尺度运动目标检测方法,首次提出了一个新的ODM模块,得到了新的特征提取网络,利用多维注意力机制和曲线平滑非单调的激活函数提高特征提取能力,另外设计了一种基于注意力机制的双向特征融合策略,通过信息双向流动和注意力感知,有效融合模型不同层次特征,增强模型对多尺度物体特征的感知与捕捉能力,并使用WIoU损失函数以平衡高低质量样本,减少模型预测偏差、提高泛化能力。

技术研发人员:蔡云飞,董玉玟

受保护的技术使用者:南京理工大学

技术研发日:

技术公布日:2024/4/17

- 还没有人留言评论。精彩留言会获得点赞!