本发明涉及语言视觉大模型设计、知识图谱搭建与任务智能规划研究领域,具体涉及一种基于语言视觉大模型与知识图谱的任务序列智能规划方案,包括语言视觉大模型的设计、知识图谱的搭建以及在此基础上的任务序列智能规划等。

背景技术:

1、近年,语言大模型迅速发展,如chatgpt和gpt4等,其具备语言、知识、简单推理能力,能够很好地近似人的智能行为。许多研究者已经开始将大模型应用于机器人操作中。如何能够将语言、视觉大模型对场景、任务的理解能力与复杂操作任务的规划结合起来是当前研究的热点与难点问题。

2、在现有的处理方法中,传统的思路是利用自然语言理解中句法分析获取关键信息,并通过视觉识别获取相关物体的位姿信息,将此信息整理为pddl规划器的域文件与问题文件来规划动作序列,较难自主实现整个过程,且感知模型能力有限,满足日常生活复杂环境中物品与物品间状态识别需求较难。近期利用大模型的思路,一种是端到端的思路,语言、视觉感知信息以及机器人操作示教信息作为transformer网络的训练输入,模型输出直接为机械手臂末端的目标位姿,这种方法较依赖于示教的信息,针对复杂的操作任务其规划灵活性有待验证。另一种思路是利用chatgpt语言大模型推理获取实现任务的动作序列,然后结合强化学习等进一步规划针对机器人可行的动作序列,如saycan模型。该思路虽将强化学习的“行”的能力和大语言模型的“言”的能力结合在一起,但是适用于人类自然语言的未必适用于机器人本体语言。而本发明着眼于任务规划的自主性、智能性与灵活性,利用语言、视觉大模型在任务与场景理解方面的优势,获取场景物体之间的初始关系,预测语言任务中物体间的目标关系。利用场景关系的感知与预测,与存储了机器人操作相关信息的知识图谱相结合,智能获取适用于机器人操作规划的动作序列,避免了人类语言与机器人本体语言之间的不一致问题。具体实现通过查询知识图谱,自动生成pddl(planningdomain definition language)规划器的输入,输出能够完成任务的动作基元序列。

3、本发明的特点是能够根据语言视觉感知,灵活、自主地从知识库中提取相关信息,生成pddl规划器的输入文件,用于规划动作基元序列,方法简洁、有效、实用性强。

技术实现思路

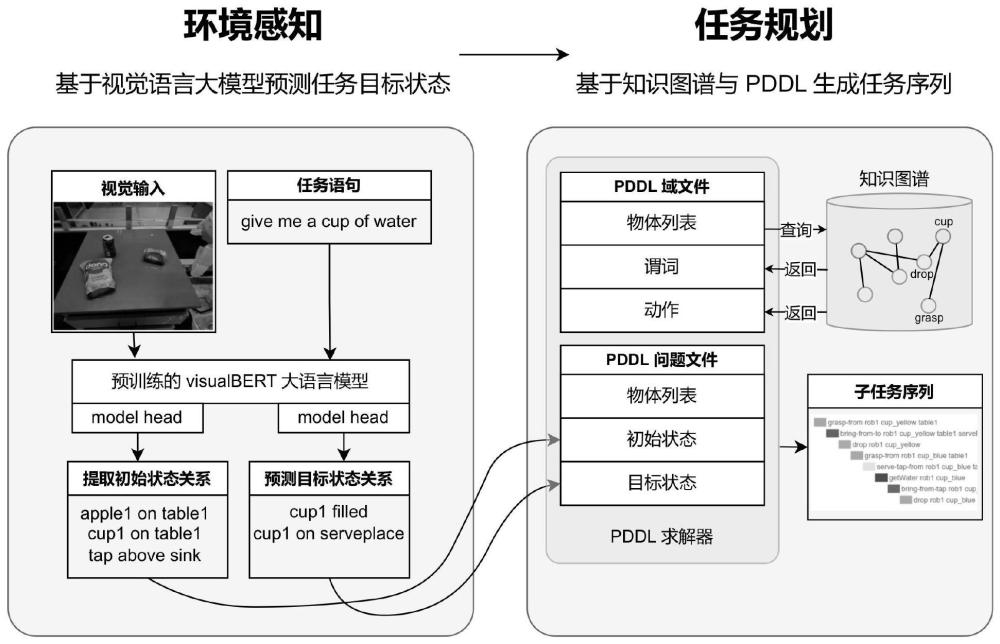

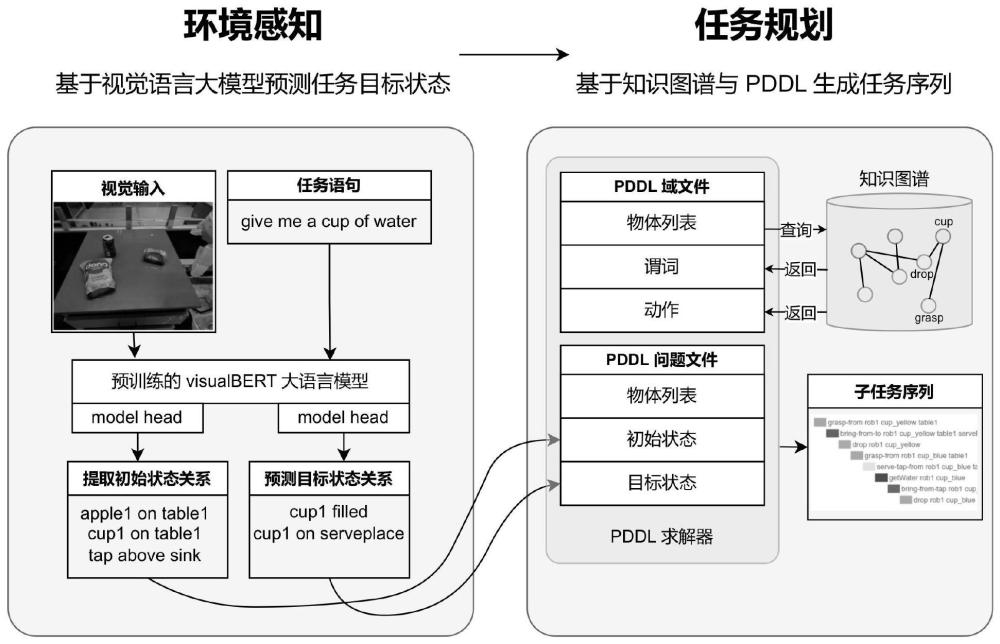

1、针对机器人将日常生活中复杂、多样的任务指令灵活转换为动作序列的问题,本发明提供一种基于语言视觉大模型与知识图谱的任务序列智能规划方法。该方法主要包括3部分内容:层次化知识图谱构建、基于语言视觉大模型的场景关系感知与预测模型训练以及pddl自主动作序列规划。从层次化知识图谱构建的知识图谱中查询并提取相关的物体与动作属性,用于自动生成pddl规划器的域文件,同时基于语言视觉大模型的场景关系感知与预测模型训练,并输出相关物体的初始与目标状态,自动生成pddl规划器的问题文件;所述域文件与问题文件驱动pddl自主动作序列规划动作基元序列。

2、本发明中层次化知识图谱构建的知识图谱,主要包括物体层、动作层。其中物体层包含物体的外观属性、可操作方式以及物体与物体之间的关系描述。动作层包括多个动作基元以及技能的属性存储。

3、在基于语言视觉大模型的场景关系感知与预测模型训练中,首先获取场景图片与任务指令的文本描述,将其输入在coco数据集上预训练的visualbert大模型中,通过注意力机制提取上下文特征,并获取场景图片中的场景物体与任务语句之间的潜在特征联系,经语言视觉大模型的场景关系感知与预测模型训练,最终实现场景中物体之间初始关系的提取(采取三元组的形式描述)与任务目标状态三元组的预测。

4、在实际应用中,输入当前语言任务指令与场景图片至基于语言视觉大模型的场景关系感知与预测模型中,输出场景物体初始关系三元组与目标状态三元组。根据输出信息,从知识图谱的库中查询并提取出相关物体属性、物体与物体之间关系属性以及相关动作属性,并利用其自动生成pddl规划器的域文件与问题文件。最终经由pddl规划器在线求解,获取完成任务所需的动作基元序列。

5、本发明的主要创新点在于(1)基于语言视觉大模型的场景关系感知与预测,利用大模型学习场景图片物体与任务语句之间的潜在特征联系,实现以三元组的形式描述任务中相关物体的初始与目标状态;(2)根据任务需求,从知识图谱中灵活提取相关物体与操作动作、技能属性信息,利用此信息,自动生成pddl规划器的域文件与问题文件,自主完成动作规划。以往研究中,pddl规划器的域文件通常由程序员离线情况下预先编写完成,内容量大且不灵活,较难适用于日常、家居生活中复杂、多样且多变的任务指令;而问题文件需要根据每次的任务指令要求以物体目标状态的形式编写,也给pddl规划器的自主灵活应用带来了困难。本发明中,机器人根据任务需求,能够灵活从知识库中调用相关知识,自主完成规划,适用于日常家居生活等任务多变场景的动作序列规划。

6、由此,本发明的优点可以归纳为,灵活、自主及智能:

7、基于语言视觉大模型的场景关系感知预测模型与知识图谱相结合,可以实现对复杂日常生活中不同任务的感知与知识联想,这是实现自主、灵活、智能任务规划的关键所在。本发明可以应用于机器人智能规划领域,只需要输入人的语言任务指令与感知当前场景的视觉图片,机器人就可以根据内置的知识图谱进行相关信息联想与智能规划,获取可行的操作层动作基元序列。

技术特征:1.基于语言视觉大模型与知识图谱的任务序列智能规划方法,其特征在于,该方法包括:层次化知识图谱构建、基于语言视觉大模型的场景关系感知与预测模型训练以及pddl自主动作序列规划;从层次化知识图谱构建的知识图谱中查询并提取相关的物体与动作属性,用于自动生成pddl规划器的域文件,同时基于语言视觉大模型的场景关系感知与预测模型训练,并输出相关物体的初始与目标状态,自动生成pddl规划器的问题文件;所述域文件与问题文件驱动pddl自主动作序列规划动作基元序列。

2.根据权利要求1所述的基于语言视觉大模型与知识图谱的任务序列智能规划方法,其特征在于,层次化知识图谱构建的知识图谱,包括物体层、动作层;其中物体层包含物体的外观属性、可操作方式以及物体与物体之间的关系描述;动作层包括多个动作基元以及技能的属性存储。

3.根据权利要求1所述的基于语言视觉大模型与知识图谱的任务序列智能规划方法,其特征在于,在基于语言视觉大模型的场景关系感知与预测模型训练中,首先获取场景图片与任务指令的文本描述,将其输入在coco数据集上预训练的visualbert大模型中,通过注意力机制提取上下文特征,并获取场景图片中的场景物体与任务语句之间的潜在特征联系,经语言视觉大模型的场景关系感知与预测模型训练,最终实现场景中物体之间初始关系的提取采取三元组的形式描述与任务目标状态三元组的预测。

4.根据权利要求1所述的基于语言视觉大模型与知识图谱的任务序列智能规划方法,其特征在于,在实际应用中,输入当前语言任务指令与场景图片至基于语言视觉大模型的场景关系感知与预测模型中,输出场景物体初始关系三元组与目标状态三元组;根据输出信息,从知识图谱的库中查询并提取出相关物体属性、物体与物体之间关系属性以及相关动作属性,并利用其自动生成pddl规划器的域文件与问题文件;最终经由pddl规划器在线求解,获取完成任务所需的动作基元序列。

5.根据权利要求1所述的基于语言视觉大模型与知识图谱的任务序列智能规划方法,其特征在于,从知识图谱中查询并提取相关的物体与动作属性,用于自动生成pddl规划器的域文件,同时根据语言视觉感知模型输出的相关物体的初始与目标状态,自动生成pddl规划器的问题文件,该两文件可驱动pddl规划动作基元序列。

6.根据权利要求1所述的基于语言视觉大模型与知识图谱的任务序列智能规划方法,其特征在于,基于语言视觉大模型的场景关系感知预测模型构建过程中,首先需要对场景图片和任务文本描述进行预处理,将其转换为模型能理解的数据格式;对于场景图片,通过卷积神经网络提取关键视觉特征并进行标签化;任务文本描述通过自然语言处理技术进行分词和语义标注。

7.根据权利要求1所述的基于语言视觉大模型与知识图谱的任务序列智能规划方法,其特征在于,对于任务文本,将其分割成词汇单元;原始文本是一个字符串t,被分割成一系列词汇单元t1,t2,…,tn;将每个词汇单元ti转换成对应的词汇索引idx(ti);表示为:

8.根据权利要求1所述的基于语言视觉大模型与知识图谱的任务序列智能规划方法,其特征在于,知识图谱中存储机器人完成日常操作劳务所需的知识,包括场景中物体与常用的操作动作;物体层包含日常生活中物品、物体的属性、物体与物体之间的位置关系;动作层存储多样化日常操作的动作及其属性;动作与物体的操作关系通过节点互相连接,表示物体的可操作方式。

9.根据权利要求1所述的基于语言视觉大模型与知识图谱的任务序列智能规划方法,其特征在于,根据场景中出现的相关物体列表,在知识图谱中检索与物体节点相关联的动作节点,提取动作节点中存储的动作执行前提条件与动作执行后效果的属性;并检索物体与物体节点相连的位置关系信息组合生成pddl规划器的域文件即谓词与动作;利用语言视觉感知模型中获取的初始状态与目标状态自主生成pddl规划器问题文件。

10.根据权利要求1所述的基于语言视觉大模型与知识图谱的任务序列智能规划方法,其特征在于,基于特定任务与场景自动生成pddl求解文件之后,pddl智能规划算法通过域文件和问题文件构建复杂规划问题的搜索空间,包括所有可能的状态以及有动作引起状态转移的路径;规划器使用启发式搜索算法探索搜索空间,估计当前状态到达目标状态的成本,求解得出最优动作基元序列,完成任务规划;

技术总结本发明公开了基于语言视觉大模型与知识图谱的任务序列智能规划方法,包括层次化知识图谱构建、基于语言视觉大模型的场景关系感知与预测模型训练以及PDDL自主动作序列规划。从层次化知识图谱构建的知识图谱中查询并提取相关的物体与动作属性,用于自动生成PDDL规划器的域文件,同时基于语言视觉大模型的场景关系感知与预测模型训练,并输出相关物体的初始与目标状态,自动生成PDDL规划器的问题文件;所述域文件与问题文件驱动PDDL自主动作序列规划动作基元序列。本发明可以应用于机器人智能规划领域,只需要输入人的语言任务指令与感知当前场景的视觉图片,机器人就可以根据内置的知识图谱进行相关信息联想与智能规划,获取可行的操作层动作基元序列。

技术研发人员:刘春芳,高亦彤,付涵宇,郭云帆,庞瑞田,鱼天鸿

受保护的技术使用者:北京工业大学

技术研发日:技术公布日:2024/4/17