一种面向大规模分布式训练的深度学习模型优化方法与流程

本发明涉及深度学习,特别涉及一种面向大规模分布式训练的深度学习模型优化方法。

背景技术:

1、随着大数据时代的来临,深度学习在许多领域取得了显著成果。然而,随着深度学习模型的不断发展和应用,模型规模和数据量呈爆发式增长趋势。深度学习模型的训练面临着计算资源不足、训练速度慢、模型精度低等问题。

2、传统大规模分布式训练技术通过将计算任务分配到多个计算节点上并行处理,可以在一定程度上解决这些问题,但仍存在一些问题,如通信开销大、收敛速度慢、模型精度不高等。如何提高大规模分布式训练的效率、降低资源消耗并保证模型精度,仍然是亟需解决的问题。

技术实现思路

1、基于此,本申请实施例提供了一种面向大规模分布式训练的深度学习模型优化方法,在保持模型精度的同时,能够显著提高现有深度学习模型的大规模分布式训练的速度并降低计算资源的开销。

2、第一方面,提供了一种面向大规模分布式训练的深度学习模型优化方法,该方法包括:

3、s1,输入训练样本数据,计算当前分布式训练系统中各计算节点的资源差异值,根据差异值大小自动选择数据划分模式;其中,所述数据划分模式至少包括基于样本数量的数据划分和基于样本特征维度的数据划分;

4、s2,对于确定的深度学习模型,根据选择的数据划分模式将模型结构将划分为多个专家模型,然后在各计算节点上部署对应的专家模型,并结合精度控制和转换模块动态调整各训练阶段的浮点数精度;

5、s3,对各计算节点的深度学习模型参数进行参数计算,并将各参数按照从大到小的顺序进行降序排序,根据梯度优先原则,依次从大到小更新对应的模型参数。

6、可选地,s1中输入训练样本数据,计算当前分布式训练系统中各计算节点的资源差异值,根据差异值大小自动选择数据划分模式,具体包括:

7、当前分布式训练系统中各计算节点空闲资源相同时,选择基于样本数量的数据划分策略;

8、当前分布式训练系统中各计算节点空闲资源差异超过设定阈值时,选择基于样本特征维度的数据并行划分策略。

9、可选地,当基于样本数量的数据划分时,具体包括:

10、执行全局乱序重置,将所有输入样本数据打乱顺序;

11、根据计算节点的数量n,将样本数据平均划分为n份,每份包含m/n个样本;

12、各计算节点执行无放回地随机采样,确保每个节点分配到大致相等数量的样本。

13、可选地,当基于样本特征维度的数据并行划分时,具体包括:

14、分析数据集的特征维度d,根据特征维度将样本数据进行拆分;其中,按特征维度分配不同的样本子集给各计算节点,或者每个节点处理所有样本的不同特征子集;

15、将拆分后的样本数据分配到对应的计算节点上。

16、可选地,s2,对于确定的深度学习模型,根据选择的数据划分模式将模型结构将划分为多个专家模型,然后在各计算节点上部署对应的专家模型,并结合精度控制和转换模块动态调整各训练阶段的浮点数精度,具体包括:

17、根据选择的数据划分模式,将确定的深度学习模型结构进行拆分为多个专家模型;

18、根据分布式训练系统的架构,将拆分后的专家模型部署到各个计算节点上;在训练过程中动态调整各阶段的浮点数精度,将深度学习模型的计算过程划分为多个阶段,每个阶段可能包括前向传播、反向传播、参数更新;具体根据每个阶段的计算需求和数据特点,确定合适的精度模式;

19、在训练过程中,每个计算节点上的专家模型会生成各自的输出;根据模型的结构和训练目标,组合输出以形成最终分类结果。

20、可选地,s3,对各计算节点的深度学习模型参数进行参数计算,并将各参数按照从大到小的顺序进行降序排序,根据梯度优先原则,依次从大到小更新对应的模型参数,具体包括:

21、在每个计算节点上,利用输入的训练数据和对应的标签,通过反向传播算法计算深度学习模型的参数梯度;收集所有计算节点上计算得到的梯度数据,并将这些梯度值按照从大到小的顺序进行降序排序;根据梯度优先原则,首先更新具有较大梯度的参数,依次按照梯度大小顺序更新其他参数;

22、在参数更新过程中,通过分布式通信机制确保各计算节点之间的数据同步,经过设定次数的迭代后,检查模型的收敛情况,如果满足收敛条件,则停止训练;否则,继续重复训练进行下一轮的训练和参数更新。

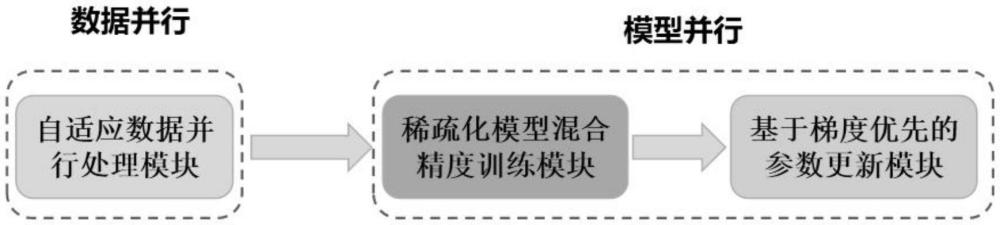

23、第二方面,提供了一种面向大规模分布式训练的深度学习模型优化装置,该装置包括:

24、自适应数据并行处理模块,用于输入训练样本数据,计算当前分布式训练系统中各计算节点的资源差异值,根据差异值大小自动选择数据划分模式;其中,所述数据划分模式至少包括基于样本数量的数据划分和基于样本特征维度的数据划分;

25、稀疏化模型混合精度训练模块,对于确定的深度学习模型,根据选择的数据划分模式将模型结构将划分为多个专家模型,然后在各计算节点上部署对应的专家模型,并结合精度控制和转换模块动态调整各训练阶段的浮点数精度;

26、基于梯度优先的参数更新模块,用于对各计算节点的深度学习模型参数进行参数计算,并将各参数按照从大到小的顺序进行降序排序,根据梯度优先原则,依次从大到小更新对应的模型参数。

27、第三方面,提供了一种电子设备,包括存储器和处理器,存储器存储有计算机程序,处理器执行计算机程序时实现上述第一方面任一所述的面向大规模分布式训练的深度学习模型优化方法。

28、第四方面,提供了一种计算机可读存储介质,其上存储有计算机程序,计算机程序被处理器执行时实现上述第一方面任一所述的面向大规模分布式训练的深度学习模型优化方法。

29、第五方面,提供了一种计算机程序产品,包括计算机程序/指令,计算机程序/指令被处理器执行时实现上述第一方面任一所述的面向大规模分布式训练的深度学习模型优化方法。

30、本申请实施例提供的技术方案包括自适应数据并行处理模块、稀疏化模型混合精度训练模块及基于梯度优先的参数更新模块三部分组成。其中,自适应数据并行处理模块用于切分输入模型的训练数据从而实现数据并行。稀疏化模型混合精度训练模块通过混合专家模型对模型结构进行优化完成模型结构稀疏化和并行化,并结合混合精度训练进一步加速深度神经网络的训练速度并降低内存使用。基于梯度优先的参数更新模块将梯度通讯和反向传播计算混合并行,有力的提升了模型训练中计算和网络通信的效率。该技术有效降低了大规模分布式训练对计算资源和存储空间的需求,可以广泛应用于大规模分布式训练的深度学习模型优化领域,如图像识别、自然语言处理等。

技术特征:

1.一种面向大规模分布式训练的深度学习模型优化方法,其特征在于,所述方法包括:

2.根据权利要求1所述的深度学习模型优化方法,其特征在于,s1中输入训练样本数据,计算当前分布式训练系统中各计算节点的资源差异值,根据差异值大小自动选择数据划分模式,具体包括:

3.根据权利要求2所述的深度学习模型优化方法,其特征在于,当基于样本数量的数据划分时,具体包括:

4.根据权利要求2所述的深度学习模型优化方法,其特征在于,当基于样本特征维度的数据并行划分时,具体包括:

5.根据权利要求1所述的深度学习模型优化方法,其特征在于,s2,对于确定的深度学习模型,根据选择的数据划分模式将模型结构将划分为多个专家模型,然后在各计算节点上部署对应的专家模型,并结合精度控制和转换模块动态调整各训练阶段的浮点数精度,具体包括:

6.根据权利要求1所述的深度学习模型优化方法,其特征在于,s3,对各计算节点的深度学习模型参数进行参数计算,并将各参数按照从大到小的顺序进行降序排序,根据梯度优先原则,依次从大到小更新对应的模型参数,具体包括:

7.一种面向大规模分布式训练的深度学习模型优化装置,其特征在于,所述装置包括:

8.一种电子设备,其特征在于,包括存储器和处理器,所述存储器存储有计算机程序,所述计算机程序被所述处理器执行时实现如权利要求1至6任一所述方法的步骤。

9.一种计算机可读存储介质,其特征在于,其上存储有计算机程序,所述计算机程序被处理器执行时实现如权利要求1至6任一所述方法的步骤。

10.一种计算机程序产品,包括计算机程序/指令,其特征在于,该计算机程序/指令被处理器执行时实现权利要求1至6中任一项所述方法的步骤。

技术总结

本申请公开了一种面向大规模分布式训练的深度学习模型优化方法。本方法首先输入训练样本数据,计算当前分布式训练系统中各计算节点的资源差异值,根据差异值大小选择数据划分模式;然后将模型结构将划分为多个专家模型,然后在各计算节点上部署对应的专家模型,并结合精度控制和转换模块动态调整各训练阶段的浮点数精度;最后对各计算节点的深度学习模型参数进行参数计算,并将各参数按照从大到小的顺序进行降序排序,根据梯度优先原则,依次从大到小更新对应的模型参数。本申请将梯度通讯和反向传播计算混合并行,提升了模型训练中计算和网络通信的效率,有效降低了大规模分布式训练对计算资源和存储空间的需求。

技术研发人员:赵朝阳,王金桥,陶满礼,吴劲

受保护的技术使用者:中科视语(北京)科技有限公司

技术研发日:

技术公布日:2024/8/26

- 还没有人留言评论。精彩留言会获得点赞!