一种自适应纹理混合特征再校准网络的光场新视点重建方法

本发明涉及光场成像,具体为一种自适应纹理混合特征再校准网络的光场新视点重建方法。

背景技术:

1、随着人们对三维信息需求的持续增长,光场成像因其卓越的信息捕获能力正逐渐走入大众的视野。在当前的科技环境下,光场超分辨率重建技术在众多领域中展现出广泛的应用潜力,包括但不限于医疗影像、虚拟现实、增强现实以及高精度测量等。然而光场数据的高维性和庞大规模使得传统的超分辨率重建方法在计算和存储方面面临巨大挑战,光场设备成本高采集稠密多视图较为困难,因此从稀疏光场视图重建密集的视图十分必要。此外,这些传统方法往往未能充分利用光场数据的结构性和连续性,导致重建结果的质量受到显著限制。

2、深度学习技术在图像处理领域取得了显著的进步,包括在光场超分辨率重建中也展现出了巨大的潜力。然而现有的基于深度学习的光场超分辨率重建方法,通过稠密光场获取扭曲稀疏视图,特别是在存在微小视差的区域时存在视差估计误差的情况,以及插值误差可能导致生成的光场丢失物体细节。在大基线场景的光场重建中,面临的挑战在于输入视图之间的重叠较少,需要处理大量遮挡区域。在光场成像中,由于物体相互遮挡一些像素只在某些输入视图中可见,而在其他视图中被遮挡导致深度估计不准确。

3、我们提出了一种自适应纹理混合特征再校准网络的光场新视点重建方法。该方法旨在增强特征表达能力,保存高频纹理信息进一步探索视图内和视图间的对应相关性,解决局部区域的差异模糊状态,我们的方法能够在保证重建质量的同时恢复遮挡伪影区域,从稀疏光场视图重建良好的密集光场新视点图像。

技术实现思路

1、(一)解决的技术问题

2、针对现有技术的不足,本发明提供了一种自适应纹理混合特征再校准网络的光场新视点重建方法,过往方法的光场重建在处理较小视差情况下,基于显式的深度网络方法可能无法可靠的提取视差信息,而基于隐式深度网络无法在视差较大的区域精准匹配视图,这些区域会出现混叠效应以及遮挡会导致深度突变,在重建的合成视角中产生空洞,本发明设计重建方法解决以上问题。

3、(二)技术方案

4、本发明为了实现上述目的具体采用以下技术方案:

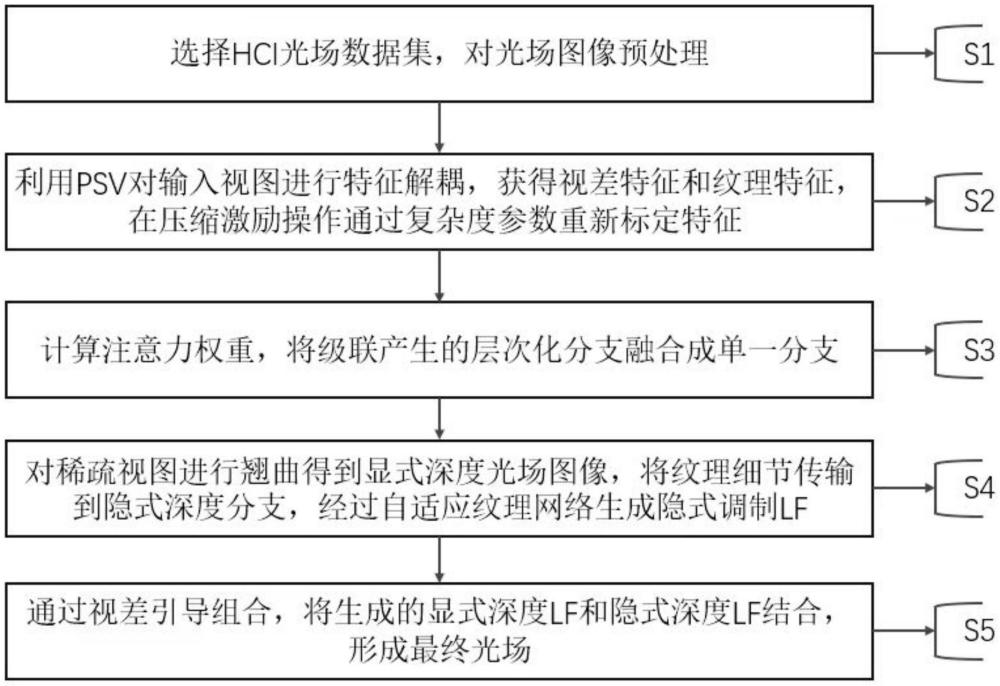

5、一种自适应纹理混合特征再校准网络的光场新视点重建方法,包括以下步骤:

6、s1.选择hci光场数据集,对光场图像预处理;

7、s2.利用psv对输入视图进行特征解耦,获得视差特征和纹理特征,在压缩激励操作通过复杂度参数重新标定特征;

8、s3.计算注意力权重,将级联产生的层次化分支融合成单一分支;

9、s4.对稀疏视图进行翘曲得到显式深度光场图像,将纹理细节传输到隐式深度分支,经过自适应纹理网络生成隐式调制lf;

10、s5.通过视差引导组合,将生成的显式深度lf和隐式深度lf结合,形成最终光场;

11、进一步地,所述s1中,遍历文件列表,读取每个文件夹中的子图像,将它们转换为灰度图像并存储在四维数组中。生成完整的9x9光场图像样本,并随机排列。

12、进一步地,所述s2中,在特征解耦中,基于输入稀疏光场视图构建psv,提取psv的特征,在每个视差水平上进行编码,通过对每个视差级别的线索进行积分得到视差特征,将视差和纹理特征分别与psv特征解耦,将视差特征传输到特征融合网络,在压缩激励操作通过复杂度参数重新标定特征,提取基于复杂度的注意力特征。

13、进一步地,所述s3中,四重旋转卷积网络由四个分支组成,用于将校准后的特征传递给每个分支。第一个分支通过逆时针旋转90度,实现了高度维度和通道维度之间的交互,并使用z池化层简化张量形状。第二个分支通过逆时针旋转90度,与w轴进行交互。第三个分支通过池化减少通道数,然后执行通道之间的交互。第四个分支通过全局平均池化和1d卷积执行通道之间的交互,生成三维的注意力权重。

14、进一步地,所述s4中,沿着视差级别整合提取纹理信息,将纹理特征输入到隐式深度分支中,生成隐式光场图像。将带有纹理特征的lf按照通道维度进行拆分,得到多个具有与lf相同空间大小但通道大小缩减的子特征图,公式:

15、[f0,f1,f2,f3]=split(lfe)

16、

17、在输入特征上应用自适应最大池化以生成多尺度特征,这有助于提高重建性能。同时,将特征图沿着空间和通道维度进行整合,将这些多尺度特征连接起来,并通过1×1卷积来聚合局部和全局关系。其表示如下:

18、

19、其中concat表示沿通道维度的连接操作,通过非线性归一化来估计注意力图。

20、进一步地,所述s5中,组合过程使用掩模将每个显式深度lf与隐式深度lf组合在一起,融合多个增强的lf,得到最终的光场图像。融合过程由四个3d残差块组成,形成一个融合残差。将这个残差与第一个增强的lf相加,得到最终加强的新视点光场图像,输入视图也被利用来进一步增强最终结果。

21、(三)有益效果

22、与现有技术相比,本发明提供了一种自适应纹理混合特征再校准网络的光场新视点重建方法,具备以下有益效果:

23、本发明,实现了从具有大基线的少量几个输入视图中重建高角分辨率光场。通过设计自适应纹理混合特征再校准网络的光场混合算法方法,重建场景几何视图合成以增强特征表示,并进一步探索视图内和视图间的相关性,重建深度估计匹配错误造成的相关性遮挡,恢复局部区域的差异模糊状态。这种方法不仅能够有效地提取和利用通道间的关系信息,从而提高网络的表示能力,而且还能够兼顾网络的计算和存储需求。

技术特征:

1.一种自适应纹理混合特征再校准网络的光场新视点重建方法,其特征在于;该方法包括以下步骤:

2.根据权利要求1所述的一种自适应纹理混合特征再校准网络的光场新视点重建方法,其特征在于:所述s1中,对图像进行预处理时遍历每个文件名,读取对应的图像数据,将每个图像切分成9x9个小块,旋转和翻转进行数据增强作为输入。将所有生成的小块按顺序存储在lfi数组中。随机打乱lfi数组中的小块顺序。将lfi数组转置为[w,h,aw,ah,n]的形状(宽度、高度、小块宽度、小块高度、样本数量)。

3.根据权利要求1所述的一种自适应纹理混合特征再校准网络的光场新视点重建方法,其特征在于:所述s2中,首先利用线索在视差特征每个视差水平上进行编码积分,计算所有位置之间的相关性来捕捉长距离依赖使视差特征再校准。

4.根据权利要求1所述的一种自适应纹理混合特征再校准网络的光场新视点重建方法,其特征在于:所述s3中,通过旋转操作对齐特征通道、角度权重,利用1d卷积来实现通道之间的交互,从而结合空间维度和通道维度的信息,生成三维的注意力权重,捕捉交叉维度的相互作用。

5.根据权利要求1所述的一种自适应纹理混合特征再校准网络的光场新视点重建方法,其特征在于:所述s4中,通过应用特征金字塔生成用于空间自适应特征调制的注意力图,将特征图沿着空间和通道维度进行整合,将多尺度特征连接起来恢复密集区域纹理细节,独立计算多尺度特征表示,动态聚合特征进行空间调制。

6.根据权利要求1所述的一种自适应纹理混合特征再校准网络的光场新视点重建方法,其特征在于:所述s5中,将四个3d残差块形成一个融合残差,将其与第一个增强的lf相加,增强得到最终的光场结果。

7.根据权利要求1所述的一种自适应纹理混合特征再校准网络的光场新视点重建方法,其特征在于:所述s5中,其中利用epi梯度损失对进行监督,以增强epi中的线性结构:

技术总结

本发明属于光场成像技术领域,尤其为一种自适应纹理混合特征再校准网络的光场新视点重建方法,该方法包括以下步骤:S1.选择HCI光场数据集,对光场图像预处理;S2.利用PSV对输入视图进行特征解耦,获得视差特征和纹理特征,在压缩激励操作通过复杂度参数重新标定特征;S3.计算注意力权重,将级联产生的层次化分支融合成单一分支;S4.对稀疏视图进行翘曲得到显式深度光场图像,将纹理细节传输到隐式深度分支,经过自适应纹理网络生成隐式调制光场;S5.通过视差引导组合,将生成的显式深度LF和隐式深度LF结合,形成最终光场。本发明,实现了对一组大视差基线的视图光场图像新视点的重建,通过设计新的改进光场混合方法,恢复局部区域的遮挡模糊部分,提高了光场重建质量。

技术研发人员:朴燕,曹祥伦

受保护的技术使用者:长春理工大学

技术研发日:

技术公布日:2024/10/31

- 还没有人留言评论。精彩留言会获得点赞!