多语言大模型优化训练方法、电子设备、存储介质和程序产品

本申请涉及人工智能,尤其涉及一种多语言大模型优化训练方法、电子设备、存储介质和程序产品。

背景技术:

1、在目前的多语言大语言模型(例如,bloom、llama等)中,当尝试在模型中加入一门新的语言时,常常会遇到“灾难性遗忘”问题,即模型会在学习新语言的同时,遗忘已有语言的知识。这是因为模型在重新训练时会更新整个网络的权重,导致先前学到的知识被覆盖。因此,亟需一种能够解决多语言大语言模型中“灾难性遗忘”问题技术方案。

技术实现思路

1、本申请实施例提供一种多语言大模型优化训练方法、电子设备、存储介质和程序产品,用于至少解决上述技术问题之一。

2、第一方面,本申请实施例提供一种多语言大模型优化训练方法,包括:

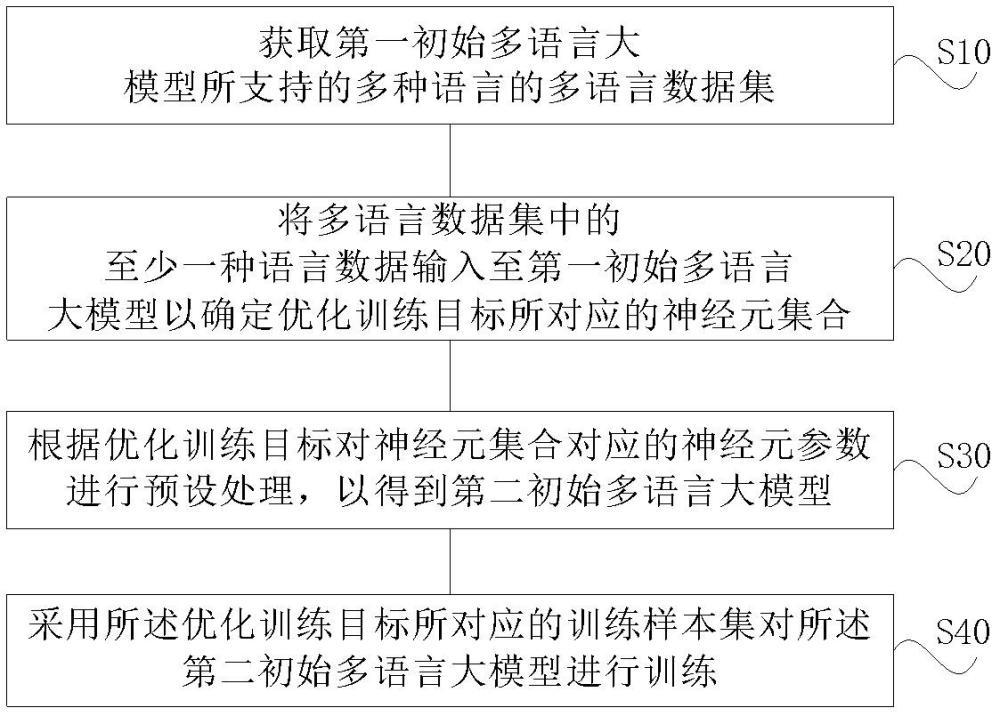

3、获取第一初始多语言大模型所支持的多种语言的多语言数据集;

4、将所述多语言数据集中的至少一种语言数据输入至所述第一初始多语言大模型以确定优化训练目标所对应的神经元集合;

5、根据所述优化训练目标对所述神经元集合对应的神经元参数进行预设处理,以得到第二初始多语言大模型;

6、采用所述优化训练目标所对应的训练样本集对所述第二初始多语言大模型进行训练。

7、在一些实施例中,优化训练目标包括为多语言大模型增加新语种处理能力;所述优化训练目标所对应的神经元集合包括所述第一初始多语言大模型所支持的多种语言所对应的关键神经元集合。

8、在一些实施例中,根据所述优化训练目标对所述神经元集合对应的神经元参数进行预设处理,以得到第二初始多语言大模型,包括:

9、冻结所述第一初始多语言大模型所支持的多种语言所对应的关键神经元集合的相应上下游权重参数,以得到第二初始多语言大模型。

10、在一些实施例中,优化训练目标包括增强多语言大模型对已支持旧语种的处理能力;所述优化训练目标所对应的神经元集合包括所述第一初始多语言大模型所支持的旧语种所对应的关键神经元集合。

11、在一些实施例中,根据所述优化训练目标对所述神经元集合对应的神经元参数进行预设处理,以得到第二初始多语言大模型,包括:

12、冻结所述第一初始多语言大模型所支持的旧语种所对应的关键神经元集合的相应上下游权重参数,以得到第二初始多语言大模型。

13、在一些实施例中,根据所述优化训练目标对所述神经元集合对应的神经元参数进行预设处理,以得到第二初始多语言大模型,包括:

14、冻结所述第一初始多语言大模型所支持的旧语种之外的语种所对应的关键神经元集合的相应上下游权重参数,以得到第二初始多语言大模型。

15、在一些实施例中,优化训练目标包括遗忘多语言大模型对已支持旧语种的处理能力;所述优化训练目标所对应的神经元集合包括所述第一初始多语言大模型中需要遗忘的旧语种所对应的关键神经元集合。

16、在一些实施例中,根据所述优化训练目标对所述神经元集合对应的神经元参数进行预设处理,以得到第二初始多语言大模型,包括:

17、置零所述第一初始多语言大模型中需要遗忘的旧语种所对应的关键神经元集合的相应上下游权重参数,以得到第二初始多语言大模型。

18、第二方面,本申请实施例提供一种计算机设备,包括存储器、处理器及存储在存储器上的计算机程序,其特征在于,所述处理器执行所述计算机程序以实现本申请任一实施例所述的多语言大模型优化训练方法的步骤。

19、第三方面,本申请实施例提供一种计算机可读存储介质,其上存储有计算机程序/指令,其特征在于,该计算机程序/指令被处理器执行时实现本申请任一实施例所述的多语言大模型优化训练方法的步骤。

20、第四方面,本申请实施例提供一种计算机程序产品,包括计算机程序/指令,其特征在于,该计算机程序/指令被处理器执行时实现本申请任一实施例所述的多语言大模型优化训练方法的步骤。

21、本申请在对多语言大模型优化训练时,先确定了优化训练目标所对应的第一初始多语言大模型中神经元集合,然后再根据优化训练目标对第一初始多语言大模型中对应的神经元参数进行预设处理,最后才采用训练样本集对多语言大模型进行训练。通过预处理的步骤,使得采用训练样本集对多语言大模型进行训练时避免或者降低了对预处理所对应神经元参数产生影响,从而解决了现有技术中存在的“灾难性遗忘”的问题。

技术特征:

1.一种多语言大模型优化训练方法,包括:

2.根据权利要求1所述的方法,其特征在于,所述优化训练目标包括为多语言大模型增加新语种处理能力;所述优化训练目标所对应的神经元集合包括所述第一初始多语言大模型所支持的多种语言所对应的关键神经元集合。

3.根据权利要求2所述的方法,其特征在于,

4.根据权利要求1所述的方法,其特征在于,所述优化训练目标包括增强多语言大模型对已支持旧语种的处理能力;所述优化训练目标所对应的神经元集合包括所述第一初始多语言大模型所支持的旧语种所对应的关键神经元集合。

5.根据权利要求4所述的方法,其特征在于,

6.根据权利要求1所述的方法,其特征在于,所述优化训练目标包括遗忘多语言大模型对已支持旧语种的处理能力;所述优化训练目标所对应的神经元集合包括所述第一初始多语言大模型中需要遗忘的旧语种所对应的关键神经元集合。

7.根据权利要求6所述的方法,其特征在于,

8.一种计算机设备,包括存储器、处理器及存储在存储器上的计算机程序,其特征在于,所述处理器执行所述计算机程序以实现权利要求1-7中任一项所述方法的步骤。

9.一种计算机可读存储介质,其上存储有计算机程序/指令,其特征在于,该计算机程序/指令被处理器执行时实现权利要求1-7中任一项所述方法的步骤。

10.一种计算机程序产品,包括计算机程序/指令,其特征在于,该计算机程序/指令被处理器执行时实现权利要求1-7中任一项所述方法的步骤。

技术总结

本申请公开一种多语言大模型优化训练方法、电子设备、存储介质和程序产品,该方法包括:获取第一初始多语言大模型所支持的多种语言的多语言数据集;将多语言数据集中的至少一种语言数据输入至第一初始多语言大模型以确定优化训练目标所对应的神经元集合;根据优化训练目标对所述神经元集合对应的神经元参数进行预设处理,以得到第二初始多语言大模型;采用优化训练目标所对应的训练样本集对第二初始多语言大模型进行训练。本申请结合优化训练目标所对应神经元集合对多语言大模型优化训练,解决了现有技术中存在的灾难性遗忘的问题,提升了模型的训练效率。

技术研发人员:陈露,俞凯,曾泓川,韩森宇

受保护的技术使用者:上海交通大学

技术研发日:

技术公布日:2024/12/19

- 还没有人留言评论。精彩留言会获得点赞!