基于多策略强化学习的交通信号灯控制方法

本发明属于交通控制系统,具体涉及一种基于多策略强化学习的交通信号灯控制方法。

背景技术:

1、随着经济技术的发展和人们生活水平的提高,交通拥堵问题越来越严重。因此,解决交通拥堵问题,就显得意义重大。

2、目前,缓解交通拥堵问题,主要有两种解决方案,一是通过新建道路和改善基础设施来缓解交通问题;二是通过人工智能方案对交通信号灯进行控制,来缓解交通问题。

3、目前,研究人员已经提出了大量的基于人工智能技术的交通信号灯控制方案,来优化交通信号控制策略。基于模型预测控制(mpc)的交通信号灯控制方案,通过实时监测道路交通流量,将数据输入预测模型,并依据预测结果调整信号灯周期和相位;该方案虽然能够在一定程度上提升交通效率,但是由于城市道路交通的动态性和偶然性,该类方案依旧存在精确性和可靠性较差的缺陷。另外,也有方案根据实时交通信息来控制信号灯,如基于深度强化学习动态控制交通信号灯的方法;该类方案通过智能体与环境互动,并借助深度神经网络进行训练,从而逐步学习优化的控制策略;但是,该类方案的学习过程速度较慢,并无法满足实时控制需求。

技术实现思路

1、本发明的目的在于提供一种可靠性高、实时性好且精确性好的基于多策略强化学习的交通信号灯控制方法。

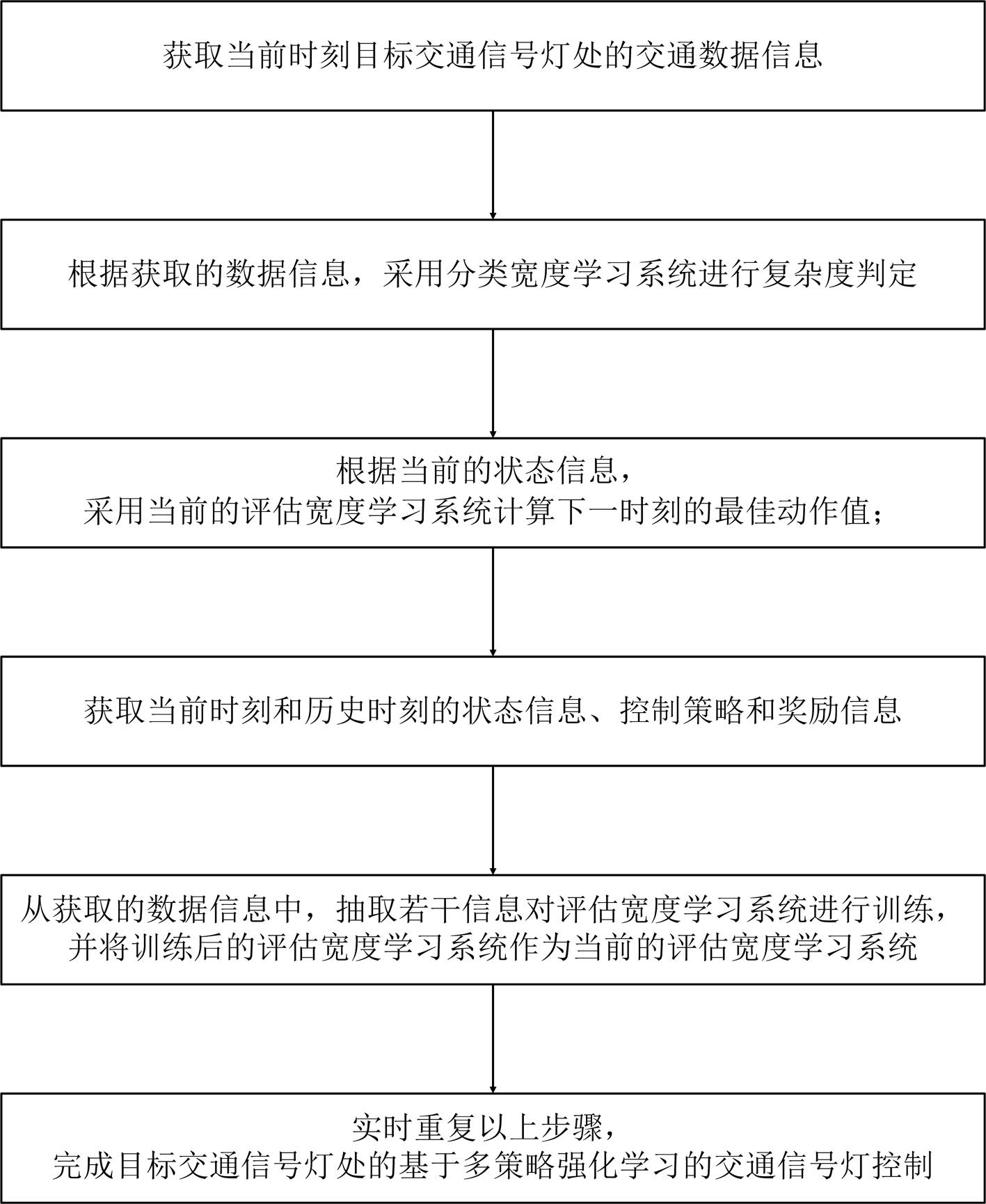

2、本发明提供的这种基于多策略强化学习的交通信号灯控制方法,包括如下步骤:

3、s1. 获取当前时刻目标交通信号灯处的交通数据信息;

4、s2. 根据步骤s1获取的数据信息,采用分类宽度学习系统进行复杂度判定:

5、若判定为简单系统,则根据获取的数据信息计算下一时刻的交通信号灯的控制策略,当前时刻的交通信号灯控制过程结束,并跳转到步骤s4;

6、若判定为复杂系统,则继续进行后续步骤;

7、s3. 根据当前的状态信息,采用当前的评估宽度学习系统计算下一时刻的最佳动作值;当前时刻的交通信号灯控制过程结束,并跳转到步骤s4;

8、s4. 获取当前时刻和历史时刻的状态信息、控制策略和奖励信息;

9、s5. 从步骤s4获取的数据信息中,抽取若干信息对评估宽度学习系统进行训练,并将训练后的评估宽度学习系统作为当前的评估宽度学习系统;

10、s6. 实时重复步骤s1~s5,完成目标交通信号灯处的基于多策略强化学习的交通信号灯控制。

11、所述的步骤s2,具体包括如下步骤:

12、根据步骤s1获取的数据信息,采用分类宽度学习系统进行复杂度判定:

13、若判定为简单系统,则根据获取的数据信息,采用韦氏算法计算下一时刻的交通信号灯的控制策略;当前时刻的交通信号灯控制过程结束,并跳转到步骤s4;

14、若判定为复杂系统,则继续进行后续步骤。

15、所述的步骤s3,具体包括如下步骤:

16、根据当前的状态信息,采用当前的评估宽度学习系统,基于当前时刻的状态,计算得到下一时刻的最佳动作值,该最佳动作值对应于交通信号灯的控制策略;

17、计算完成后,当前时刻的交通信号灯控制过程结束,并跳转到步骤s4。

18、所述的步骤s3,具体包括如下内容:

19、根据当前的状态信息,采用当前的评估宽度学习系统,基于当前时刻的状态信息,采用如下算式计算得到下一时刻的最佳动作值:式中为动作对应的最大值;为状态下对应的动作的q值;为当前状态;为评估宽度学习系统中的网络参数;最佳动作值对应于交通信号灯的控制策略。

20、所述的步骤s4,具体包括如下步骤:

21、在每个时刻下,获取上一个时刻的状态信息、动作信息、奖励信息和当前时刻的状态信息,并存储到缓冲区中;

22、当存储缓冲区存满后,用最新存储的状态信息替换最早存储的状态信息。

23、所述的奖励信息,具体为采用如下步骤计算得到:

24、采用如下算式计算得到奖励信息:式中和为权重值,且;为车辆平均等待时间变量,且,为t时刻道路上等待车辆的总数,为对应车辆的等待时间且,为交通灯在一个相位中的持续时间,为车辆当前速度,为规定的车辆最小速度;为车辆最长等待时间与最短等待时间变量,且,为最短或者最长等待那辆车的等待时间。

25、所述的步骤s5,具体包括如下步骤:

26、每一轮训练前,从存储缓冲区中,采用均匀采样的方式,抽取一批大小为设定值p的数据,并放入训练池;每一轮训练时,从训练池中获取训练数据,进行训练;每一轮训练后,将当前轮次训练后的评估宽度学习系统作为当前的评估宽度学习系统;

27、首先,针对评估宽度学习系统进行训练:

28、在当前轮次的训练数据中,将训练池中作为系统的输入 x,将目标值作为系统的输出 y;为上一时刻环境中的状态信息数据,为上一时刻环境中的动作信息数据,作为训练时目标值信息数据;

29、采用如下算式将输入 x映射到特征空间:式中为第i组特征节点;为随机产生的具有设定维数的随机权值矩阵;为随机产生的偏置项;为第一非线性映射函数;

30、采用如下算式将特征节点映射得到增强节点:式中为第j组增强节点;为第n组映射特征;为随机产生的随机产生的随机权值矩阵;为随机产生的偏置项;为第二非线性映射函数; n为特征节点的组数;

31、将特征节点和增强节点进行连接并导入到系统的输出层,得到系统的输出 y:式中为第m组增强界节点; m为增强节点的组数;为系统中网络的连接权重;

32、若评估宽度学习系统的训练未达到设定的要求,则进行增量学习;所述的增量学习包括增加特征节点和增加增强节点;

33、经过设定次数的训练后,将评估宽度学习系统的权重值复制给目标宽度学习系统,完成目标宽度学习系统的更新。

34、所述的目标值,具体采用如下算式计算得到:式中为当前时刻的奖励信息;为为折扣因子;为动作对应的q值;为目标宽度学习系统的参数。

35、所述的系统中网络的连接权重,具体为采用如下步骤计算得到:

36、评估宽度学习系统的节点为表示;

37、采用如下算式计算得到系统中网络的连接权重:式中为的转置;为正则化参数; i为单位矩阵; y为系统的输出。

38、所述的增量学习,具体包括如下步骤:

39、增加增强节点的方式实现增量学习:

40、新增加的增强节点表示为;

41、则新的评估宽度学习系统的节点表示为;

42、根据分块矩阵的伪逆理论,计算得到,其中为的伪逆矩阵,c为计算值且,为矩阵b的转置且

43、;

44、则新的新的评估宽度学习系统的网络的连接权重为;

45、增加特征节点的方式实现增量学习:

46、新增加的特征节点表示为;

47、相应增加的增强节点随机生成如下:为随机产生的具有适当维数的随机权值矩阵;为随机产生的偏置项,则新的评估宽度学习系统的节点表示为;

48、基于的伪逆对进行增量学习;

49、根据分块矩阵的伪逆理论,计算得到,其中为的伪逆矩阵,c为计算值且,为矩阵b的转置且;

50、则新的评估宽度学习系统的网络的连接权重为。

51、本发明提供的这种基于多策略强化学习的交通信号灯控制方法,结合宽度学习系统,提出了一种新的交通信号灯控制方法,不仅能够实现城市路口交通信号灯的控制,而且可靠性更高、实时性更好且精确性更好。

- 还没有人留言评论。精彩留言会获得点赞!