一种基于眼睛注视和面部微动作的智能手机控制方法与流程

本发明属于智能手机控制领域,具体涉及一种基于眼睛注视和面部微动作的智能手机控制方法。

背景技术:

1、随着智能手机的高速发展,智能手机凭借其功能性强,便携性高,适应性广等优点逐步成为了现代人生活中的必需品。有研究显示,平均每人每天与手机互动的次数高达150次以上。目前市面上的智能手机使用的是电容式触控屏,这种触控操作需要操作者在屏幕上进行点按触摸才能完成交互应用。部分手机除触控操作外,借助前置摄像头以及传感器通过手势识别,实现在特定应用下的上下翻页功能,比如华为mate系列可以进行隔空手势识别,通过识别手掌的上下或左右挥动实现短视频的滑动或电子书的翻页。但不管哪种情况,目前智能手机交互应用都需要手的参与,存在双手执行任务过程中不便对手机进行操作(如接听电话、app的进入或退出)的问题。

2、cn110191234b公开了一种基于注视点分析的智能终端解锁方法。通过特征标记法获得人脸的68个特征点矩阵,人眼图片,人脸面积以及头部姿态角,使用卷积神经网络模型预测出人眼观察屏幕的位置,通过时间来判断用户意图以及解锁功能实现,但是没有很好地解决人眼视线在手机边界这种极端特殊情况,很有可能造成误判以及资源浪费。

3、cn108171152a公开了一种深度学习人眼视线估计方法、设备、系统及可读存储介质,通过接收多个终端拍摄的人体头部图像建立数据库,采用深度学习方式建立人眼估计模型。但是图像获得是通过多个终端的拍摄,因此在相同时间下获得的图像张数有限,从而导致面部数据可能不充分,同时也需要用到多个终端设备,缺乏简洁性;其次,为了多角度拍摄,需要用户频繁旋转终端屏幕,增加了操作的繁琐性。

技术实现思路

1、针对现有技术问题,本发明提出了一个基于眼睛注视和面部微动作的智能手机控制方法,通过实时解码操作者眼神注视位置,并配合面部微动作实现对智能手机的操作控制。

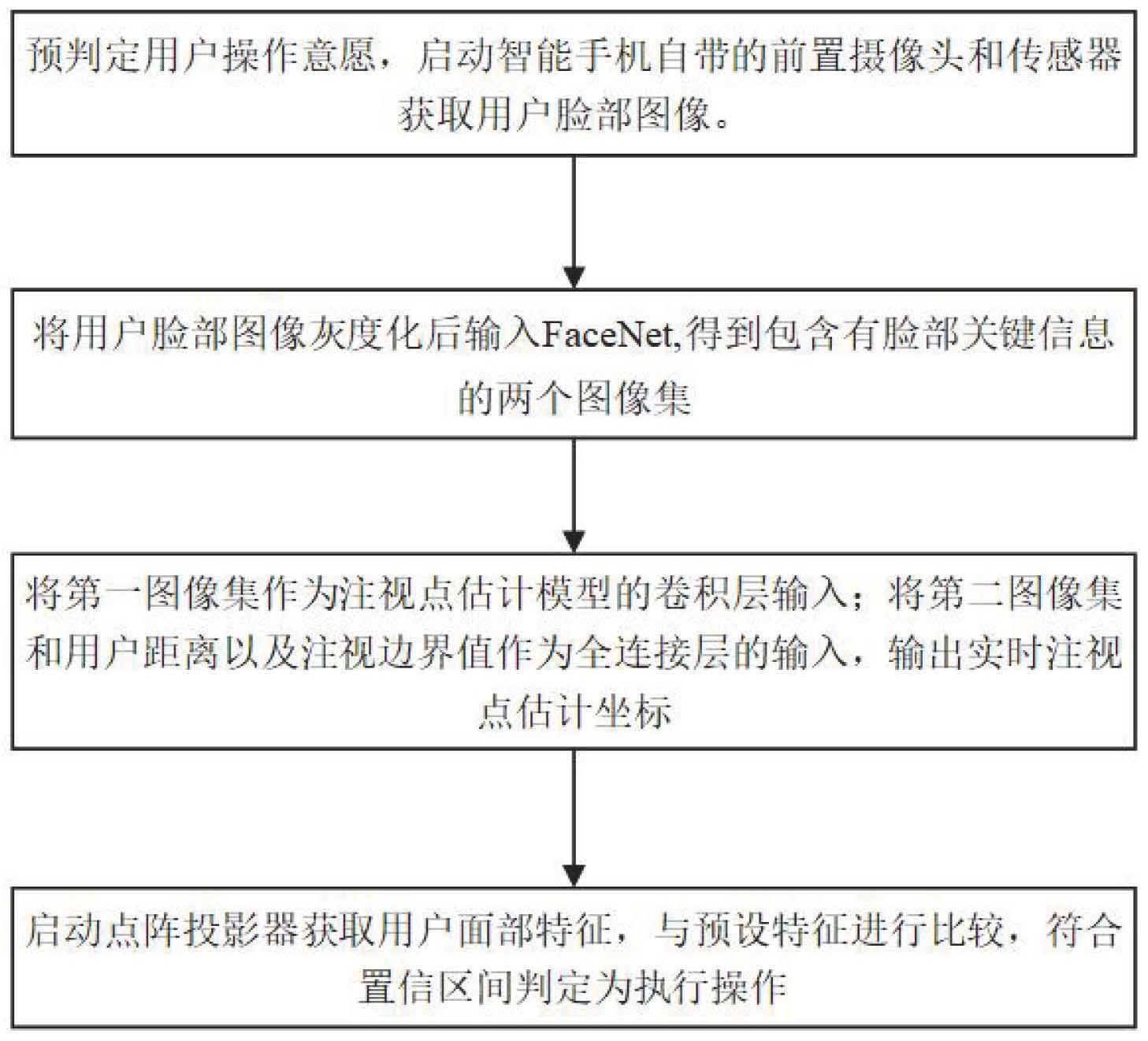

2、为达到以上目的,本发明采取以下技术方案:一种基于眼睛注视和面部微动作的智能手机控制方法,包括以下步骤:s1、预判定用户操作意愿,启动智能手机的前置摄像头和红外摄像头获取用户脸部图像;s2、对用户脸部图像进行灰度化后输入facenet,输出实时第一图像集和第二图像集,所述第一图像集是对各图像分割出面部三角区,获得眼球中心到面部中心的距离、眼球中心到内眼角的距离以及眼球中心到面部中心和内眼角的夹角,所述眼球包括左眼球和右眼球;所述第二图像集是各图像的脸部面积、头部角度、眼角位置的数值;s3、将第一图像集作为预先训练的注视点估计模型的卷积层的输入,以第二图像集和通过深度传感器获取的实时用户距离值以及注视边界值作为预先训练的注视点估计模型的全连接层的输入,输出实时注视点估计坐标;s4、对注视点估计坐标进行判定,判定非注视手机应用程序,智能手机进入待机状态;判定注视手机应用程序为交互对象,启动点阵投影器(4)获取用户面部特征,同时与预先设置的面部特征通过判别指标进行比对,当特征匹配并落在置信区间内时则判定执行操作。

3、进一步地,所述s1中预判定方法包括:启动智能手机的深度传感器(2)测量用户距离值,当用户距离值超过阈值则判定为非操作意愿,智能手机进入待机状态;若用户距离值不超过阈值则判定为操作意愿。

4、进一步地,所述s3中注视点估计模型的预先训练方法包括以下步骤:s11、启动前置摄像头(1),深度传感器(2)以及红外摄像头(3)拍摄用户在注视手机可交互区域不同校准点时的脸部图像并记录用户脸部到手机屏幕的用户距离值;s22、将脸部图像灰度化后作为facenet的输入,不同校准点的第一图像集和第二图像集作为输出;s33、将不同校准点下的第一图像集作为卷积神经网络的卷积层的输入,将不同校准点下的第二图像集和用户距离值以及注视边界值作为卷积神经网络的全连接层的输入,将不同校准点的二维像素坐标作为模型的解,反复迭代获得注视点估计模型。

5、进一步地,所述注视点估计模型的预先训练方法还包括:在智能手机中预设若干个校准点,每一个校准点对应注视点估计坐标由用户手动确认完成。

6、进一步地,所述用户距离值的阈值为20~50cm。

7、进一步地,所述注视边界值为智能手机可交互区域边界值向四周分别扩大一个允许误差值,所述允许误差值为一个注视点图像的直径。

8、进一步地,所述s4中注视点估计坐标的判定方法包括:计算注视点图像与应用程序图标的重合区域大于注视点图像一半以上时,判定应用程序为交互对象。

9、进一步地,s5中所述面部特征为“撅嘴”对应点按功能、“抿嘴”对应返回/退出操作和非操作,所述判别指标为点阵偏移量和畸变值。

10、与现有技术相比,本发明的有益效果:

11、(1)通过面部三角区关键信息输出手机可交互区域的注视点,可确保眼神注视跟踪的实时性;利用用户距离值、注视点边界值判定用户操作意愿,对用户操作意愿具有较高的判定准确性;判定注视点是否在手机应用程序上,通过比较注视点图像与手机应用程序图标的重合区域,判定是否作为交互对象,不会造成误判以及资源浪费,也更具人性化;

12、(2)仅需手机自带的前置摄像头和传感器,无需外接设备,成本低,本发明可以有效解决在双手执行任务过程中不便对手机进行操作的问题;

13、(3)针对注视点在可交互区域边界可能产生的误差,对注视点边界值进行限定,同时降低了对注视点误差范围的要求,注视点边界值作为定值,可以减少输出注视点估计坐标的计算量,完成实时性操作。

技术特征:

1.一种基于眼睛注视和面部微动作的智能手机控制方法,其特征在于,包括以下步骤:

2.根据权利要求1所述的基于眼睛注视和面部微动作的智能手机控制方法,其特征在于,所述s1中预判定方法包括:启动智能手机的深度传感器(2)测量用户距离值,当用户距离值超过阈值则判定为非操作意愿,智能手机进入待机状态;若用户距离值不超过阈值则判定为操作意愿。

3.根据权利要求1所述的基于眼睛注视和面部微动作的智能手机控制方法,其特征在于,所述s3中注视点估计模型的预先训练方法包括以下步骤:

4.根据权利要求3所述的基于眼睛注视和面部微动作的智能手机控制方法,其特征在于,所述注视点估计模型的预先训练方法还包括:在智能手机中预设若干个校准点,每一个校准点对应注视点估计坐标由用户手动确认完成。

5.根据权利要求3所述的基于眼睛注视和面部微动作的智能手机控制方法,其特征在于,所述用户距离值的阈值为20~50cm。

6.根据权利要求3所述的基于眼睛注视和面部微动作的智能手机控制方法,其特征在于,所述注视边界值为智能手机可交互区域边界值向四周分别扩大一个允许误差值,所述允许误差值为一个注视点图像的直径。

7.根据权利要求1所述的基于眼睛注视和面部微动作的智能手机控制方法,其特征在于,所述s4中注视点估计坐标的判定方法包括:计算注视点图像与应用程序图标的重合区域大于注视点图像一半以上时,判定应用程序为交互对象。

8.根据权利要求1所述的基于眼睛注视和面部微动作的智能手机控制方法,其特征在于,s5中所述面部特征为“撅嘴”对应点按功能、“抿嘴”对应返回/退出操作和非操作,所述判别指标为点阵偏移量和畸变值。

技术总结

本发明提供了一种基于眼睛注视和面部微动作的智能手机控制方法,属于智能手机控制领域。本发明的技术方案是预设多个校准点通过卷积神经网络预先训练注视点估计模型,利用FaceNet处理用户面部图像,输出第一图像集和第二图像集,第一图像集包括面部三角区关键数值作为注视点估计模型的卷积层输入,以第二图像集、用户距离、注视点边界值作为注视点估计模型的全连接层输入,输出注视点估计坐标,显示注视点图像,再利用点阵投影器获取用户面部特征,与预设特征比较,符合置信区间判定执行操作。本发明方法具有对眼神注视跟踪的实时性,实现更具人性化的眼神操控,同时,仅需手机自带的前置摄像头和传感器,无需外接设备,成本低。

技术研发人员:沈晓燕,张佳凯,徐博洋,杨永杰

受保护的技术使用者:南通先进通信技术研究院有限公司

技术研发日:

技术公布日:2024/1/15

- 还没有人留言评论。精彩留言会获得点赞!