一种高效虚拟场景内容光场获取与生成方法与流程

本发明涉及光场显示,尤其涉及一种高效虚拟场景内容光场获取与生成方法。

背景技术:

1、随着计算机和显示技术的飞速发展,高保真虚拟场景内容光场生成技术已经成为备受瞩目的前沿技术,该技术利用先进的算法和计算机图形技术,可以完整地捕捉现实世界中的光场数据,并实时传输到其他地方进行渲染和展示,实现场景和光照的真实再现,为用户带来身临其境的视觉体验。

2、虚拟场景内容光场生成技术的发展已经取得了一定的进展。然而,在当前市场和公开的文献中,实时传输和渲染仍然基于模型,面临着传输成本高和无法实时处理的问题,这些技术面临的挑战主要包括以下几个方面:

3、数据传输和处理的实时性方面,虚拟场景内容光场生成技术需要大量的数据传输和处理,尤其是对于高保真度的场景。在实时传输和渲染过程中,需要解决数据传输的时延和处理速度的问题,以确保光场的实时性和流畅性。

4、传输带宽的限制方面,虚拟场景内容光场生成技术产生的数据量庞大,需要高带宽的网络传输才能实现实时传输和渲染。然而,当前的网络基础设施可能无法满足高带宽要求,这限制了技术的应用范围和用户体验。

5、另外,设备的复杂性也使其无法普及到更广泛的领域和用户群体。

6、可见,高保真虚拟场景内容光场生成技术需要处理大量的光场数据并进行实时渲染,数据处理的实时性和算法优化是关键问题,需要一种高效的数据处理和渲染算法,以减少计算复杂度、提高算法效率、节省带宽和优化图像质量。

技术实现思路

1、本发明的目的在于提供一种高效虚拟场景内容光场获取与生成方法,解决现有数据处理算法不足导致的实时性和保真性低的技术问题。

2、为实现上述目的,本发明的一种高效虚拟场景内容光场获取与生成方法的具体技术方案如下:

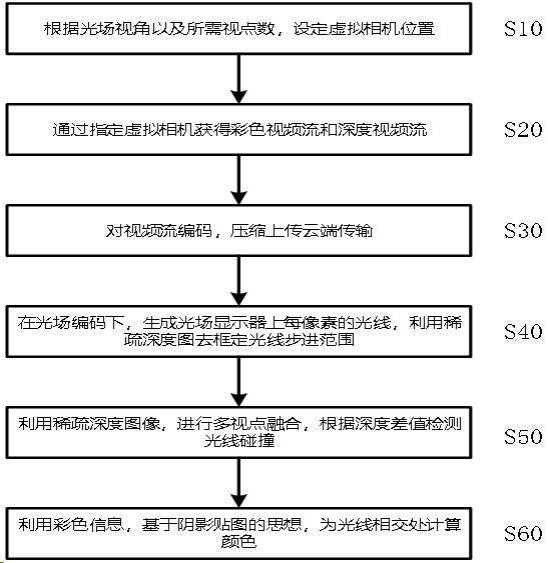

3、一种高效虚拟场景内容光场获取与生成方法,包括如下步骤:

4、步骤s10,根据光场视角以及所需视点数,设定虚拟相机位置,虚拟相机用于提供远程渲染算法所需要的彩色信息和深度信息,以及提供光场编码所需的视点位置信息;

5、步骤s20,通过指定虚拟相机获取彩色视频流和深度视频流;

6、步骤s30,通过光场编码模块对视频流编码,压缩上传云端传输;

7、步骤s40,在光场编码下,生成光场显示器上每个像素的光线,利用稀疏深度图去框定光线步进范围;

8、步骤s50,利用稀疏深度图像,通过多视点融合模块进行多视点融合,根据深度差值检测光线碰撞;

9、步骤s60,利用彩色信息,基于阴影贴图的思想,通过光场渲染模块为光线相交处计算颜色。

10、通过在预定位置的虚拟相机,实时获取虚拟场景的彩色视频流和深度视频流,并从云端实现远端到本地端传输,获取单帧对应的彩色图与深度图,经过光场编码后进行具有高保真和实时性的远程渲染,能够极大地降低传输成本,解决了以往通过模型传输代价高、无法实时的问题,并同时保证了光场下的渲染精度,满足了高保真和实时的虚拟内容远程光场传输与生成。

11、进一步地,包括如下虚拟相机设置方法:

12、设置三台提供彩色信息与深度信息的虚拟相机,分别均匀地设定在距离虚拟场景内容观看距离的左、中、右位置,并以视频流的方式实时传输;

13、还设置有提供视点位置信息的虚拟相机,均匀地设定在视点错切平面上,并提供固定的相机位置参数。

14、进一步地,光场编码模块包括:

15、光线生成模块,使用光场编码算法获取对应视点编号,之后利用视点位置信息,生成光场显示器上每像素的光线;

16、光场光线范围模块,利用稀疏深度图像去框定光线投射的步进范围。

17、进一步地,光场光线范围模块将稀疏视点下的深度图信息,以像素为单位形成体素,投射到生成视点的观察空间,以低分辨率的方式光栅化这些体素,使得这些体素分布在生成视点低分辨率的平面上,并通过最大最小值滤波,保留每个像素上体素在观察空间内深度最大与深度最小的体素,并以此得到的最大最小深度值,作为对应像素上光线步进的范围,之后根据步进范围以及光场编码后求得的对应视点位置信息以及像素坐标进而投射光线。

18、进一步地,多视点融合模块包括用于光线碰撞检测的碰撞检测模块和减少表面噪声的融合模块。

19、进一步地,碰撞检测模块根据三个稀疏视点下的深度图,动态获得光线与虚拟场景的截断深度差值并进行融合,用于计算光线的步进,检测光场中光线与虚拟场景中的物体是否碰撞。

20、进一步地,融合模块将稀疏视点下的深度图做方差预处理,实时计算时,将对应深度的方差提取,对于高方差区域,降低对应视点深度图得到的深度差值权重,计算出各个视点深度图得到深度差值并计算权重进行融合。

21、进一步地,光场渲染模块将光线交点处作为体素单位,投射到彩色图视点的观察空间中,基于阴影贴图的思想,比较视点观察空间中深度的大小,定义体素的深度值为a,虚拟场景的深度值为b,若|a-b|<0.05cm,则确定视点的彩色图可参与光线交点处颜色的计算。

22、本发明提供的一种高效虚拟场景内容光场获取与生成方法具有以下优点:

23、本发明实施例提供的一种高效虚拟场景内容光场获取与生成方法,通过特定位置下的虚拟相机实时获取虚拟场景的彩色视频流和深度视频流,并从云端传输到本地设备,获取单帧对应的彩色图与深度图,经过光场编码后进行具有高保真和实时性的远程渲染,相较于现有的技术方法,该方法能够极大地降低传输成本,解决了以往通过模型传输代价高、无法实时的问题,并同时保证了光场下的渲染精度,满足了高保真和实时的虚拟内容远程光场传输与生成。

技术特征:

1.一种高效虚拟场景内容光场获取与生成方法,包括如下步骤:

2.根据权利要求1所述的一种高效虚拟场景内容光场获取与生成方法,其特征在于,包括如下虚拟相机设置方法:

3.根据权利要求2所述的一种高效虚拟场景内容光场获取与生成方法,其特征在于,所述光场编码模块包括:

4.根据权利要求3所述的一种高效虚拟场景内容光场获取与生成方法,其特征在于,光场光线范围模块将稀疏视点下的深度图信息,以像素为单位形成体素,投射到生成视点的观察空间,以低分辨率的方式光栅化这些体素,使得这些体素分布在生成视点低分辨率的平面上,并通过最大最小值滤波,保留每个像素上体素在观察空间内深度最大与深度最小的体素,并以此得到的最大最小深度值,作为对应像素上光线步进的范围,之后根据步进范围以及光场编码后求得的对应视点位置信息以及像素坐标进而投射光线。

5.根据权利要求1所述的一种高效虚拟场景内容光场获取与生成方法,其特征在于,所述多视点融合模块包括用于光线碰撞检测的碰撞检测模块和减少表面噪声的融合模块。

6.根据权利要求5所述的一种高效虚拟场景内容光场获取与生成方法,其特征在于,所述碰撞检测模块根据三个稀疏视点下的深度图,动态获得光线与虚拟场景的截断深度差值并进行融合,用于计算光线的步进,检测光场中光线与虚拟场景中的物体是否碰撞。

7.根据权利要求6所述的一种高效虚拟场景内容光场获取与生成方法,其特征在于,所述融合模块将稀疏视点下的深度图做方差预处理,实时计算时,将对应深度的方差提取,对于高方差区域,降低对应视点深度图得到的深度差值权重,计算出各个视点深度图得到深度差值并计算权重进行融合。

8.根据权利要求1至7任一项所述的一种高效虚拟场景内容光场获取与生成方法,其特征在于,所述光场渲染模块将光线交点处作为体素单位,投射到彩色图视点的观察空间中,基于阴影贴图的思想,比较视点观察空间中深度的大小,定义体素的深度值为a,虚拟场景的深度值为b,若|a-b|<0.05cm,则确定该视点的彩色图可参与光线交点处颜色的计算。

技术总结

本发明涉及光场显示技术领域,为了解决现有数据处理算法不足导致的实时性和保真性低的技术问题,本发明公开了一种高效虚拟场景内容光场获取与生成方法,根据光场视角以及所需视点数,设定虚拟相机位置,通过指定虚拟相机获取彩色视频流和深度视频流,通过光场编码模块对视频流编码,压缩上传云端传输;通过在预定位置的虚拟相机,实时获取虚拟场景的彩色视频流和深度视频流,并从云端实现远端到本地端传输,获取单帧对应的彩色图与深度图,经过光场编码后进行具有高保真和实时性的远程渲染,能够极大地降低传输成本,解决了通过模型传输代价高、无法实时的问题,同时保证了光场下的渲染精度,满足了高保真和实时的传输和生成需求。

技术研发人员:邢树军,于迅博,李运韬,高鑫,黄辉

受保护的技术使用者:深圳臻像科技有限公司

技术研发日:

技术公布日:2024/1/14

- 还没有人留言评论。精彩留言会获得点赞!