基于姿态引导重识别特征的并行人体姿态检测跟踪方法

1.本发明涉及的是一种计算机视觉和模式识别领域的技术,具体是一种基于姿态引导重识别特征的并行人体姿态检测跟踪方法。

背景技术:

2.人体姿态检测跟踪的目标是检测视频每一帧的人体关节点姿态并在时序上构造匹配关系。人体姿态检测跟踪是计算机视觉领域中的重要分支任务,能够促进视频场景中的行为理解和预测,对人体视频动作分析具有重要作用。现有人体姿态检测跟踪技术一般是将检测和跟踪拆解成两个较为独立的步骤。这样做的缺点是忽视两者之间的内在联系,同时也造成推理时间复杂度的增加,不利于算法的实际部署和应用。

技术实现要素:

3.本发明针对现有技术在人体姿态和位置大幅度突变时,无法准确完成跟踪关联的不足、推理阶段过于复杂以及训练时耗时且复杂的缺陷,提出一种基于姿态引导重识别特征的并行人体姿态检测跟踪方法,能够同时输出姿态检测结果和人体重识别特征,其中人体重识别特征又可以利用人体姿态进行引导增强,利用包括重识别特征、人体检测框和姿态等多种语义信息进行跟踪匹配。

4.本发明是通过以下技术方案实现的:

5.本发明涉及一种基于姿态引导重识别特征的并行人体姿态检测跟踪方法,包括以下步骤:

6.步骤a,利用目标检测模型或从已经标注的数据集中得到单独的人体区域框图片,并将图片统一成相同尺寸。

7.所述的目标检测模型采用但不限于:yolo-v3。

8.所述的数据集中的人体区域框图片带有人体姿态标注、人体实例编号标注。

9.步骤b,利用深度学习网络构建的resnet网络,从步骤a得到的人体区域框图片中提取包含丰富语义信息的多通道的特征图。

10.所述的resnet网络为:多个残差块串联而成,每个残差块是由卷积层、归一化层和激活层组成,并且残差块内部有一个输入直接指向输出的跳跃连接。

11.步骤c,在步骤b的骨干网络后并联构建人体姿态检测分支网络和人体重识别分支网络,分别

①

通过人体姿态检测分支网络将特征图转换为人体姿态检测热力图,姿态检测热力图的对应真实值是以关节点位置为中心的二维高斯分布、

②

通过人体重识别分支网络将特征图转换为人体重识别特征特征向量;再根据人体姿态检测分支得到的姿态检测热力图对重识别特征进行加权引导融合。

12.所述的人体姿态检测分支网络包括:两个顺序串联的卷积神经网络和一组cnn输出层,其中:每个卷积神经网络包括:二维卷积层、批归一化层、relu激活层和像素重排(pixel shuffle)层,在两个卷积神经网络后通过一组cnn输出层得到通道数为关节点数量

的姿态检测热力图。

13.所述的人体重识别分支网络包括:卷积层、激活层和反卷积层,其中:卷积层-激活层-反卷积层顺序连接构成一组网络模块,两个网络模块串联后再接入一个输出的cnn层。

14.所述的加权引导融合是指:人体姿态检测热力图经过一组输入输出维度固定的卷积网络,得到通道数和初始人体重识别特征相同的姿态特征图,然后通过sigmoid层将姿态特征图转换为对应维度的权重分布,得到的权重分布对初始的重识别特征图进行加权融合,即按位相乘,这一过程特征图维度不变。然后经过池化操作降维得到一组特征向量以实现隐式变换,得到的特征向量经过一组可训练的全连接层,输出人体实例的分类结果。

15.所述的全连接层的输入神经元数量和特征向量维度相同,输出神经元数取决于步骤a得到的数据集中人体实例编号的数量;通过多分类损失函数可以训练人体重识别分支网络,在推理阶段,则不需要多分类网络这一步骤。

16.步骤d,将训练图片和对应的人体姿态标注以及人体实例编号标注输入到步骤b得到的骨干网络中,经前向传播得到输出结果,按照对应规则计算相应的损失函数,然后利用反向传播算法进行梯度回传,进而更新该骨干网络以及两个分支网络的参数。

17.步骤e,在线阶段,将待检测的视频序列依次输入到目标检测模型得到不同人体的检测框;将检测框尺寸统一化之后输入到步骤d更新后的骨干网络中得到人体姿态检测结果和增强后的人体重识别特征向量,将同一张图片的不同人体检测结果映射回到原图片,构建跟踪匹配池并依次进行人体重识别特征匹配、人体检测框匹配和人体姿态匹配。

18.所述的人体重识别特征匹配是指:相同的人体应该具有相近的特征向量,可以计算前后帧不同人体归一化后的重识别特征之间的余弦相似度,当相似度满足设定的阈值,则将两者进行匹配。

19.所述的人体检测框匹配是指:对于人体重识别特征匹配未成功的检测框,计算检测框位置和前面若干帧检测框位置的交并比,当交并比满足设定的阈值,则将两者进行匹配。

20.所述的人体姿态匹配是指:对于人体检测框匹配未成功的人体实例,计算前后帧的姿态距离用来衡量不同人体之间姿态的差异,当姿态距离满足阈值,则将两者进行匹配;仍未匹配的检测框,则作为新的跟踪体加入跟踪池,等待后续帧的匹配。

21.所述的姿态距离其中:α,β是权重系数,ci和cj是人体姿态的置信度,σ1和σ2是对应的控制常量,ki和kj表示关节点位置。

22.本发明涉及一种实现上述方法的系统,包括:目标检测单元、并行的人体姿态检测和重识别特征单元、重识别特征加强单元以及多语义信息在线跟踪匹配单元,其中:目标检测单元根据目标视频帧序列,进行人体区域的检测和裁剪,得到尺寸统一的人体区域图像集合;并行的人体姿态检测和重识别特征单元根据裁剪得到的人体区域图像,进行富语义特征提取,并通过两个分支分别得到人体姿态检测热力图和初始人体重识别特征图;重识别特征加强单元根据检测得到的人体姿态热力图,对初始的人体重识别特征图进行加权融合处理,并经过池化降维得到特征向量;多语义信息在线跟踪匹配单元根据加强后的人体重识别特征、人体检测框位置和人体姿态检测结果,利用特征的余弦相似度、检测框交并比

和人体姿态距离差异进行帧间匹配,得到多人的姿态。技术效果

23.本发明并行地进行人体姿态检测和人体重识别特征提取,相比现有的常规基于人体特征的姿态跟踪做法是先用一个独立的模型检测人体姿态,再提取人体特征;本发明通过人体姿态分支和人体重识别特征分支共享骨干网络,减少了训练的复杂度,支持端到端训练。

24.本发明通过人体姿态引导加强重识别特征,人体姿态热力图经过卷积层映射并归一化后得到的权重分布,和初始的人体重识别特征按位相乘,并通过最大池化得到特征向量,这种特征向量可以更聚焦在目标人体周围。

25.本发明通过多语义信息的跟踪匹配策略,分多个阶段依次利用人体重识别特征、人体检测框和人体姿态进行帧间人体匹配,且提出了全新的人体姿态距离计算公式。

附图说明

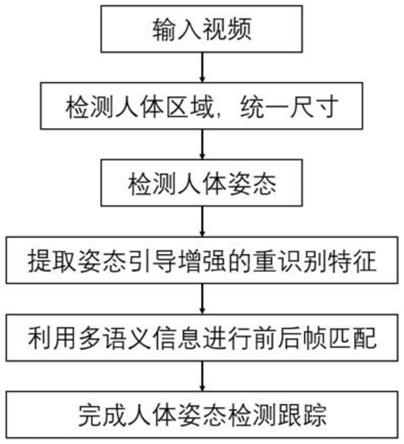

26.图1为本发明流程图;

27.图2为本发明系统示意图;

28.图3为本发明效果示意图。

具体实施方式

29.如图1所示,为本实施例涉及一种基于姿态引导重识别特征的并行人体姿态检测跟踪方法,在人体姿态检测跟踪任务中,添加并行的重识别分支进行端到端训练,并利用姿态检测结果引导增强重识别特征;利用重识别特征、人体检测框和人体姿态等多种语义信息进行人体姿态匹配,该方法具体包括:

30.步骤1,利用经过coco预训练的yolo网络得到人体检测区域,并统一尺寸;

31.步骤2,统一尺寸后的图像数据输入到骨干网络resnet中,网络的输入尺寸是256x192,输出一组语义信息丰富的特征,特征尺寸是512x64x48;

32.步骤3,在步骤b的骨干网络后并联构建人体姿态检测分支网络和人体重识别分支网络,分别

①

通过人体姿态检测分支网络将特征图转换为人体姿态检测热力图,姿态检测热力图的对应真实值是以关节点位置为中心的二维高斯分布、

②

通过人体重识别分支网络将特征图转换为人体重识别特征特征向量;再根据人体姿态检测分支得到的姿态检测热力图对重识别特征进行加权引导融合。

33.所述的特征热力图的通道数是关节点数量,空间大小一般是输入图像的1/4,即64x48;

34.所述的特征向量经过1层可训练的全连接层输出n类的分类概率,其中n取决于数据集中人体实例编号数目,可以选择一个较大值如9999。

35.步骤4,步骤3输出的人体姿态热力图和真实的关节点高斯分布进行比对并计算姿态损失函数,步骤3输出的分类概率和真实类别比对计算多分类损失函数,两个损失函数以自适应的权重系数,即使用多任务中的不确定性损失函数加权法进行计算,得到最终损失函数。

36.所述的人体姿态检测损失函数为其中:k表示人体关键点数量,s表示每个节点对应热力图的网格数量,y代表真实标签,f(x)是网络的预测值

37.所述的重识别特征的多分类网络中的多分类损失函数为所述的重识别特征的多分类网络中的多分类损失函数为其中:x表示多分类网络的输出,cls表示样本的真实标签类别,m表示类别总数

38.为使两种不同任务的损失函数在联合训练时有着合理的数量级,采用不确定性损失函数加权法进行统一,具体为:其中:

39.步骤5,使用训练集posetrack训练网络,具体包括:

40.步骤5-1,将待训练人体区域图片和对应的姿态、实例编号标注输入整体网络,按照对应规则计算相应的损失函数,利用反向传播算法将梯度进行回传,进而更新神经网络参数,采用adam优化策略。其中损失函数是人体姿态损失函数和多分类函数的不确定性加权和。

41.步骤5-2,训练过程中,将初始学习率设置为1e-4,训练迭代100和140次后,学习率按照十分之一的比率进行缩小,一共训练170个epoch;网络输入分辨率是256*192,批数量是32。

42.步骤6,在推理阶段,将待检测的视频序列依次输入到目标检测网络yolo中,得到不同人体的检测框;将检测框尺寸统一化成256*192之后输入到整体网络中得到人体姿态检测结果和增强后的人体重识别特征向量。

43.步骤7,将同一张图片的不同人体检测结果映射回到原图片,构建跟踪匹配池,利用多种语义信息进行前后帧人体的匹配,这些语义信息分别是人体重识别特征、人体检测框和人体姿态,具体包括:

44.步骤7-1,人体重识别特征匹配,相同的人体应该具有相近的特征向量,可以计算前后帧不同人体归一化后的重识别特征之间的余弦相似度,当相似度满足超过阈值0.7,则将两者进行匹配;

45.步骤7-2,人体检测框匹配,对于步骤g1中没有匹配到的检测框,计算检测框位置和前面若干帧检测框位置的交并比,当交并比超过阈值0.5,则将两者进行匹配;

46.步骤7-3,人体姿态匹配,对于步骤g2中没有匹配到的人体实例,计算前后帧的姿态距离,这里的姿态距离用来衡量不同人体之间姿态的差异,当姿态距离小于0.6,则将两者进行匹配;仍未匹配的检测框,则作为新的跟踪体加入跟踪池,等待后续帧的匹配。

47.经过具体实际实验,在带有pytorch框架的linux平台上,以多进程模式运行上述方法,可得到对应的实验数据如下表所示,在现阶段人体姿态检测跟踪最大的数据集posetrack上面,实验表明本方法无论是姿态检测的准确度(map)还是跟踪的精确度(mota)以及方法的运行速度(fps)均是业界领先水平。

48.与现有方法技术相比,本方法在常见的姿态跟踪数据集(posetrack)上各项指标均达到领先程度,姿态检测准确率达到76.9%,跟踪精确度达到65.7%,同时方法推理速度达到10.4fps。

49.上述具体实施可由本领域技术人员在不背离本发明原理和宗旨的前提下以不同的方式对其进行局部调整,本发明的保护范围以权利要求书为准且不由上述具体实施所限,在其范围内的各个实现方案均受本发明之约束。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1