一种融合偏色校正的图像去沙尘暴方法

1.本发明属于图像处理技术领域,具体涉及一种融合偏色校正的图像去沙尘暴方法。

背景技术:

2.沙尘暴天气对户外监测设备的车牌检测、自动驾驶的客观识别技术等监测系统的能力产生 了负面影响。由于光线在沙尘中传播时的散射和吸收,在沙尘暴天气中拍摄的图像往往会呈现 出颜色偏移和低对比度。沙尘暴图像输入将给其他计算机视觉任务带来困难。因此,图像去沙 尘暴作为高级计算机视觉任务的一个预处理步骤,已成为计算机视觉领域的一个重要研究课题。

3.现有的图像恢复方法可分为传统的颜色偏色校正方法和基于深度学习的方法。传统的颜色 偏色校正方法通常是先将沙尘暴图像转换到cielab颜色空间,cielab颜色空间包括两个色 度分量和一个亮度分量;然后,在cielab颜色空间中对两个色度分量进行偏色校正,对亮度 分量进行细节增强,得到相应的干净图像。然而,传统的图像去沙尘暴方法只注重图像色彩对 比度调整,没有考虑沙尘对图像的影响与图像场景深度之间的关系。因此,传统方法的修复效 果往往存在色彩饱和度低、残留沙尘较多的问题。

4.近年来,深度学习技术在图像复原方面取得了有效的应用。基于深度学习的方法通常设计 卷积神经网络来学习图像特征,并在大规模图像数据集上训练网络以生成恢复后图像。由于大 多数现有监督学习神经网络都是在合成图像数据集上进行训练,因此基于深度学习的方法很容 易在合成数据集上产生显著的效果,但在真实图像数据集上的效果欠佳。此外,由于缺乏用于 网络训练的沙尘暴图像数据集,大多数现有的图像去沙尘暴研究仍停留在传统的方法上。

5.与有雾图像类似,沙尘暴对图像的影响也取决于图像场景的深度。在合成沙尘暴图像时, 应考虑沙尘暴图像和干净图像之间的图像场景深度关系以及沙尘暴图像颜色等因素。因此,本 发明根据沙尘暴图像的具体特征来描述沙尘暴图像的形成过程:

6.i(x)=j(x)d(x)p(x)+c(1-d(x)p(x))

7.其中i和j分别表示含沙图像和干净图像。符号c表示沙尘暴颜色图,即全局遮掩光。符 号p表示通过预训练单目图像场景深度评估方法获得的图像场景深度图。d表示沙尘暴图像场景 深度和干净图像场景深度之间的关系。

技术实现要素:

8.本发明的目的在于为了更加有效去除图像沙尘暴,提供一种融合偏色校正的图像去沙尘暴 方法,该方法比当前最先进的图像复原方法具有更好的图像去沙尘暴效果。

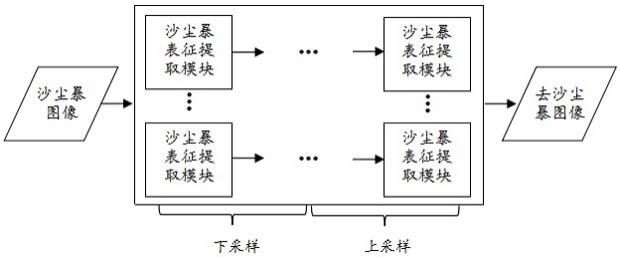

9.为实现上述目的,本发明的技术方案是:一种融合偏色校正的图像去沙尘暴方法,构建图 像去沙尘暴网络,即通过连接多个具有相同结构的沙尘感知表征提取dustare模块,先对输入 沙尘暴图像多次下采样操作,提取图像特征并融合;然后,对所提取的图像特

征进行多次上采 样操作,还原到原始图像空间,以获得最后的去沙尘暴图像。

10.在本发明一实施例中,所述图像去沙尘暴网络的高度和宽度分别为3和6,用分别表 示图像去沙尘暴网络网络第r行中第i个dustare模块的输入和输出,那么在下采样操作过程, 第2行和第3行中的第i+1个dustare模块的输入可以表示为

[0011][0012][0013]

类似地,在上采样操作过程,第2行和第1行中的第i+1个dustare模块的输入可以表示为,

[0014][0015][0016]

其中,

↓

及

↑

分别表示下采样操作和上采样操作。

[0017]

在本发明一实施例中,所述dustare模块包括两个分支,其中第一分支用于估计全局遮掩 光即散射在视线中的环境光和局部空间信息,第二分支用于生成一张沙尘暴感知图像,并且融 合该沙尘暴感知图像、全局遮掩光和局部空间信息,以得到dustare模块的输出。

[0018]

在本发明一实施例中,所述第一分支使用1

×1×

2矩阵对输入特征进行编码并生成全局遮 掩光表征(βv,γv)和使用h

×w×

2矩阵生成局部空间信息表征(βs,γs);所述第二分支首先 根据公式(1)和(2)用输入x规范化两组表征,分别记为v和s,并通过实例规范化层和sigmoid 层来生成沙尘暴感知图a;然后,融合a、v和s,得到dustare模块的输出y;其中,对于dustare 模块的输入x,v、s和输出y表示为:

[0019][0020][0021][0022]

其中,μ及σ分别表示x的平均值和标准偏差。

[0023]

在本发明一实施例中,该方法还引入偏色校正策略,即使用颜色偏色策略检测和校正训练 数据集的标签图像,使得最终去沙尘暴图像颜色更加自然,具体即:

[0024]

此处认为偏色因子k≥1.5时,标签图像本身更可能存在偏色;因此,在cielab颜色空 间中校正这些图像的a*、b*分量,即最终训练标签图像的表达式为,

[0025][0026]

其中表示原始标签图像,cor表示颜色偏色校正操作。

[0027]

在本发明一实施例中,考虑到沙尘暴图像与干净图像在cielab颜色空间的色度差异,该 方法还设计一项新的损失函数从而更好地指导网络训练,具体地,所述方法的总损失函数 定义为:

[0028]

[0029]

其中λ

ab

、λ

l1

以及λ

per

分别设置为0.3、1.2和0.4;

[0030]

第一项源于对沙尘暴图像和干净图像的观察,由于沙尘暴图像具有严重的颜色偏差,在 cielab颜色空间中沙尘暴图像的平均a*,b*色度值通常大于干净图像的平均a*,b*色度值, 因此第一个损失项为,

[0031][0032]

其中n是图像像素的总数,在去沙尘暴结果y的cielab颜色空间中,ya和yb分别表示a* 和b*颜色分量,在经过颜色偏色校正后对应清晰图像即标签图像的cielab颜色空间中,及分别表示a*和b*颜色分量;

[0033]

第二项是平滑l1损失,记为可防止潜在梯度爆炸,其定义如下:

[0034][0035][0036]

最后一项,感知损失用于激励在backbone网络中具有相似的图像特征,其定义为,

[0037][0038]

其中,h、w和c分别表示网络第i层中特征图的高度、权重和通道,φi(y)和分别表 示y和的第i层中的输出特征映射,y及分别表示去沙尘暴结果和相应的干净图像。

[0039]

相较于现有技术,本发明具有以下有益效果:

[0040]

本发明将深度学习技术引入图像去沙尘暴领域,提出了一种融合颜色校正的图像去沙尘暴 方法(sidnet)。本发明算法通过连接多个具有相同结构的沙尘感知表征提取模块,先对输入沙 尘暴图像进行多次下采样操作以提取和融合图像特征;再对特征图进行多次上采用操作,还原 到图像空间,从而得到图像去沙尘暴结果。具体创新点如下:(1)针对沙尘暴图像颜色偏差问 题,在网络模型训练时对标签图像采用了传统颜色偏色检测与校正策略,从而图像去沙尘暴结 果颜色更加自然;(2)基于沙尘暴图像a*和b*颜色分量的色度值均远大于无沙尘暴图像的发现, 设计了新的损失函数项来更好地指导网络模型训练;(3)提出了沙尘暴图像生成模型,合成了 一个包含室内外带标签的沙尘暴图像数据集,用于网络模型的训练。

附图说明

[0041]

图1为本发明方法流程图。

[0042]

图2为本发明方法(sidnet)的网络结构。

[0043]

图3为沙尘暴表征提取(dustare)模块。

[0044]

图4为一组相似场景下的沙尘暴图像和干净图像的a*,b*分量比较;(a)真实沙尘暴图像, (b)其在cielab颜色空间中的a*分量,(c)在cielab中的b*分量,(d)其对应的等效圆,(e) 真实干净图像,(f)其对应的a*分量,(g)对应的b*分量,(h)对应的等效圆。

[0045]

图5为室外合成图像上各种算法的去沙尘暴结果;(a)沙尘暴图像,(b)lpnet算法[1],(c) rgnet算法[2],(d)aodnet算法[3],(e)ffanet算法[4],(f)wang等人的算法[5],(g)hardgan 算法[6],(h)ffnet算法[7],(i)sidnet算法,(j)标签图像。。

[0046]

图6为室内合成图像上各种算法的去沙尘暴结果;(a)沙尘暴图像,(b)lpnet算法[1],(c) rgnet算法[2],(d)aodnet算法[3],(e)ffanet算法[4],(f)wang等人的算法[5],(g)hardgan 算法[6],(h)ffnet算法[7],(i)sidnet算法,(j)标签图像。

[0047]

图7为不同方法在真实沙尘暴图像上的去沙尘暴结果图像。

[0048]

图8为去沙尘暴样本图像的边缘提取结果。

[0049]

图9为一组相似场景下,不同算法去沙尘暴结果的关键点匹配数量。

具体实施方式

[0050]

下面结合附图,对本发明的技术方案进行具体说明。

[0051]

如图1所示,本发明一种融合偏色校正的图像去沙尘暴方法,构建图像去沙尘暴网络,即 通过连接多个具有相同结构的沙尘感知表征提取dustare模块,先对输入沙尘暴图像多次下采 样操作,提取图像特征并融合;然后,对所提取的图像特征进行多次上采样操作,还原到原始 图像空间,以获得最后的去沙尘暴图像。

[0052]

以下为本发明具体实现过程。

[0053]

1、本发明算法的网络结构

[0054]

如图2所示,本发明提出的图像去沙尘暴网络结构,首先连接多个具有相同结构的沙尘暴 感知表征提取(dustare)模块,对输入的沙尘暴图像进行多次下采样操作,提取图像特征并融 合;然后,对所提取的图像特征进行多次上采样操作,以生成去沙尘暴结果。网络的高度和宽 度分别为3和6。具体地,用分别表示网络第r行中第i个dustare模块的输入和输出,那 么在下采样操作过程,第2行和第3行中的第i+1个dustare模块的输入可以表示为,

[0055][0056][0057]

类似地,在上采样操作过程,第2行和第1行中的第i+1个dustare模块的输入可以表示为,

[0058][0059][0060]

其中,

↓

及

↑

分别表示下采样操作和上采样操作。

[0061]

2、沙尘暴表征提取模块

[0062]

为了在保留图像细节的同时去除图像中的沙尘暴,对全局遮掩光和局部空间信息的估计尤 为重要。受现有去雾网络的启发,本发明使用沙尘暴表征提取模块来提取它们的

表征。沙尘暴 感知表征提取(dustare)模块结构如图3所示,其主要包含两个分支。第一个分支使用1

×1×

2 矩阵对输入特征进行编码并生成全局遮掩光表征(记为βv,γv),和h

×w×

2矩阵生成局部空 间信息表征(记为βs,γs)。第二个分支首先根据公式(1)和(2)用输入x规范化两组表征(分 别记为v和s),并通过实例规范化层和sigmoid层来生成沙尘暴感知图(a);然后,融合a,v 和s,得到dustare模块的输出y。其中,对于dustare模块的输入x,v、s和输出y表示为:

[0063][0064][0065][0066]

其中,μ及σ分别表示x的平均值和标准偏差。

[0067]

3、偏色校正

[0068]

大多数现有的基于深度学习的图像恢复方法都存在一个共同的问题,即它们在合成数据集 上取得了显著的效果,而在真实图像上表现出的效果往往较差。其中的一个主要原因是最终的 图像恢复结果过度依赖于训练数据集,甚至由于训练数据集本身的偏色,导致最终真实图像的 去沙尘暴结果颜色不自然。为了解决这一问题,本发明算法sidnet使用颜色偏色策略检测和校 正训练数据集的标签图像,以提高真实沙尘暴图像的去沙尘暴效果。具体而言,本发明认为当 偏色因子k≥1.5时,该标签图像本身更可能存在偏色。因此,在cielab颜色空间中校正这 些图像的a*、b*分量,即最终训练标签图像的表达式为,

[0069][0070]

其中表示原始标签图像,cor表示颜色偏色校正操作。

[0071]

4、损失函数

[0072]

本发明算法sidnet的总损失函数定义为:

[0073][0074]

其中λ

ab

、λ

l1

以及λ

per

分别设置为0.3、1.2和0.4;

[0075]

第一项源于对沙尘暴图像和干净图像的观察,由于沙尘暴图像具有严重的颜色偏差,在 cielab颜色空间中沙尘暴图像的平均a*,b*色度值通常大于干净图像的平均a*,b*色度值。 图4展示了两个类似的真实室外场景下的沙尘暴图像和干净图像作为样本,以验证这一观察结 果。图4(a)-(d)分别显示了真实沙尘暴图像、其在cielab颜色空间中的a*色度分量、cielab 中的b*色度分量及对应的等效圆。类似地,图4(e)-(h)分别显示了干净图像,及其对应的a*色 度分量、b*色度分量和对应的等效圆。从图4可以观察到,沙尘暴图像的a*和b*分量比干净图 像的a*和b*分量模糊且更亮,这表明沙尘暴图像的平均a*和b*色度值大于干净图像的平均a* 和b*色度值。这与图4(d)和(h)中给出的数据一致。为了进一步验证这一观察结果,本发明共计 算了50幅真实沙尘暴和干净图像的a*和b*平均色度值。实验数据表明,50幅真实沙尘暴图像 的平均a*、b*色度值分别为13.53和35.69。50张干净图像的平均a*、b*色度值分别为0.28和 2.99。根据这些数据,可以得出结论,沙尘暴图像在cielab颜色空间中通常具有较大的平均 a*,b*色度值。因此,可以推断图像去沙尘暴

结果的a*,b*色度平均值越小,表明图像去沙尘 暴效果越好。基于上述观察,本发明设计了第一个损失项为,

[0076][0077]

其中n是图像像素的总数,在去沙尘暴结果y的cielab颜色空间中,ya和yb分别表示a* 和b*颜色分量,在经过颜色偏色校正后对应清晰图像即标签图像的cielab颜色空间中,及分别表示a*和b*颜色分量;

[0078]

第二项是平滑l1损失,记为可防止潜在梯度爆炸,其定义如下:

[0079][0080][0081]

最后一项,感知损失用于激励在backbone网络中具有相似的图像特征,如本文中预 训练的vgg19,其定义为,

[0082][0083]

其中,h、w和c分别表示网络第i层中特征图的高度、权重和通道,φi(y)和分别表 示y和的第i层中的输出特征映射,y及分别表示去沙尘暴结果和相应的干净图像。

[0084]

本发明方法(sidnet)与现有的7种图像复原方法进行了比较,即lpnet[1]、rgnet[2]、 aod net[3]、ffanet[4]、wang等人的算法[5]、hardgan[6]、ffnet[7]。所有算法均在合成沙 尘暴数据集上进行训练实验,同时在合成数据集和真实沙尘暴图像上进行去沙尘暴效果测试。 定量比较实验采用psnr(峰值信噪比)和ssim(结构相似性)评估合成沙尘暴图像的去沙尘 暴效果;使用基于空间光谱熵的质量(sseq)来评估真实沙尘暴图像的去沙尘暴效果。在本发 明中,为了使相关性与峰值信噪比(psnr)和ssim度量保持一致,本文对sseq值进行了反 转,即在所有指标值越高表明去沙尘暴效果越好。

[0085]

(1)室外合成图像去沙尘暴结果的定量评价

[0086]

为了对不同算法进行定量比较,表1列出了各个算法在室外合成图像上的去沙尘暴结果的 平均psnr、ssim和sseq值。从表1中的定量评价结果表明:在室外合成图像上,本发明方 法的psnr和ssim测度值均明显高于其他图像复原算法,这意味着其去沙尘暴算法效果明显 好于其他对比算法。

[0087]

表1室外合成图像沙尘暴结果的平均psnr和ssim测度值

[0088]

[0089]

(2)室外合成图像去沙尘暴结果的定性评价

[0090]

室外合成图像和去沙尘暴结果的定性评价如图5所示。从图5可以观察到,本发明方法获 得的室外图像去沙尘暴结果最接近标签图像情况(即干净无沙尘暴图像)。与其他参考方法相比, hardgan[6]和ffnet[7]具有更好的去沙尘暴效果。对于某些场景,aodnet[3]无法清除沙尘暴。 lpnet[1]、rgnet[2]和ffanet[4]会导致不同程度的颜色失真。wang等人的算法[5]校正了沙尘 暴图像的颜色,但是,他们的去沙尘暴结果仍然展现出较低的颜色饱和度。

[0091]

(3)室内合成图像去沙尘暴结果的定量评价

[0092]

为了适应现实中多种情况下的图像去沙尘暴,本发明方法还在室内合成图像数据集上进行 实验,该数据集具有色彩丰富、多细节的特点。如表2所示,室内合成图像的去沙尘暴结果的 定量评价表明:本发明方法的去沙尘暴结果上获得了最高的平均psnr(32.82)和ssim(0.9432) 值,表明其去沙尘暴效果优于其他参考方法。

[0093]

表2室内合成图像去沙尘暴结果的平均psnr和ssim测度值

[0094][0095]

(4)室内合成图像去沙尘暴结果的定性评价

[0096]

对于室内合成图像去沙尘暴结果的定性评价,如图6所示。本发明方法(sidnet)获得的 去沙尘暴结果与标签图像更为相似,表明图像去沙尘暴效果最佳。hardgan和ffnet可有效去 除大部分沙尘暴,但其颜色恢复存在一定偏差。wang等人获得的去沙尘暴结果颜色饱和度较低。 lpnet、rgnet和ffanet则会导致不同的颜色失真。aodnet能够去除少量的沙尘暴,但是有 些去沙尘暴结果颜色饱和度较低,如最后一张图像。

[0097]

(5)真实图像去沙尘暴结果的定量评价

[0098]

表3展示了8张具有代表性的真实图像去沙尘暴结果的定量评价。表3中的定量结果表明: 本发明算法sidnet在大多数真实沙尘暴图像(除了第一张图像,第五张和第八张图像)上均获 得最高的sseq值,并在第一张图像上获得次优的sseq值。此外,本发明算法具有最高平均 sseq值(69.66),表现出最好的去沙尘暴效果。

[0099]

表3不同方法在8张真实沙尘暴图像获得的去沙尘暴结果的sseq值及平均sseq值。

[0100][0101]

(6)真实图像去沙尘暴结果的定性评价

[0102]

图7展示了8张具有代表性的真实沙尘暴图像的去沙尘暴结果。从图7可以看出,lpnet[1] 和aodnet[3]能去除少量沙尘暴,但它们的去沙尘暴的效果颜色偏暗。rgnet[2]和ffanet[4] 的去沙尘暴结果带有严重的颜色失真。wang等人的算法[5]的去沙尘暴结果颜色饱和度低。hardgan[6]和ffnet[7]的去沙尘暴效果更好,但是在其去沙尘暴结果仍有沙尘暴残留,如第3、 4张和最后一张图像。相比而言,本发明方法在较好的图像去沙尘暴效果和高色彩饱和度之间能 够很好的平衡。

[0103]

(7)鲁棒性测试

[0104]

为了验证图像去沙尘暴对其他视觉任务的意义,本发明进行了两个潜在的应用,即图像边 缘提取和局部关键点匹配。

[0105]

(a)图像边缘提取

[0106]

由于沙尘暴图像的偏色和低对比度,使得沙尘暴图像的边缘提取困难。为了验证sidnet 对图像边缘提取效果的重要性,本节分析了不同方法对去沙尘暴图像边缘提取的效果。如图8 所示,与其他同类方法相比,sidnet去沙尘暴效果中的边缘细节明显增加。这验证了sidnet 可以通过恢复更多细节,从而显著提高图像边缘提取效果。

[0107]

(b)局部关键点匹配

[0108]

局部关键点匹配的目的是寻找两个相似场景之间的对应关系。为了验证sidnet在局部关键 点匹配方面的重要性,本发明使用sift(尺度不变的特征转换)算法对一组相似的真实强沙尘 暴图像(同拍摄自某广场),采用不同方法获得的相应去沙尘暴图像对进行关键点匹配。匹配结 果如图9所示,在去沙尘暴图像中,关键点匹配数量明显增加。这验证了本发明方法sidnet 还可以恢复沙尘暴图像的局部特征。

[0109]

参考文献:

[0110]

[1]fu x,liang b,huang y,ding x,paisley j.lightweight pyramid networks for image deraining.ieee transactions on neural networks and learning systems 2020;31(6):1794-1807.

[0111]

[2]fan z,wu h,fu x,huang y,ding x.residual-guide network for single image deraining. 26thacm international conference on multimedia 2018:1751

–

1759.

[0112]

[3]li b,peng x,wang z,xu j,feng d.aod-net:all-in-one dehazing network.ieee international conference on computervision 2017:4770

–

4778.

[0113]

[4]qin x,wang z,bai y,xie x,jia h.ffa-net:feature fusion attention network for single image dehazing.aaai conference onartificial intelligence 2020;34(7):11908-11915.

[0114]

[5]wang j,pang y,he y,liu c.enhancement for dust-sand storm images.international conference on springer-verlagnewyork,inc 2016:842

–

849.

[0115]

[6]deng q,huang z,tsai cc,lin cw.hardgan:a haze-aware representation distillation gan for single image dehazing.european conference on computervision 2020:722

–

738.

[0116]

[7]huang j,li z,wang c,et al.ffnet:a simple image dedusting network with featurefusion.concurrency and computation:practice and experience

(ccpe),2021:e6462.。

[0117]

以上是本发明的较佳实施例,凡依本发明技术方案所作的改变,所产生的功能作用未超出 本发明技术方案的范围时,均属于本发明的保护范围。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1