基于上下文信息感知机理的夜间和伪装目标检测方法

1.本发明属于计算机视觉和图像处理技术领域,涉及目标检测,特别涉及一种基于上下文信息感知机理的夜间和伪装目标检测方法。

背景技术:

2.目标检测是一项重要的计算机视觉任务,其被广泛应用于各类重要的工业、民用以及军用系统之中。目标检测旨在对图像或视频中的目标进行定位并分类,得到目标准确的位置和其所属的类别。经过几十年的发展,目标检测问题在不同的方案下得到了长足发展。近年来,随着深度学习的兴起,也有大量将神经网络运用到目标检测的方法,例如以faster r-cnn、yolo为代表的基于锚点框的方法和以centernet为代表的无锚点框方法,相比传统方法,它们大都获得更加精确可靠的结果。

3.而夜间目标检测与伪装目标检测比通常的目标检测更具挑战性,因为在这些场景中目标与背景更难被区分。然而,对于大部分目标检测方法,它们都是面向通用场景而提出的方法,没有考虑到部分特殊的更具挑战性的环境。shijie hao和haifeng guo提出使用夜间图像增强方法来帮助神经网络获得更稳定、更具分辨力的特征,从而提高夜间目标检测的查全率和查准率。参考文献:haifeng guo,tong lu,and yirui wu.dynamic low-light image enhancement for object detection via end-to-end training.in icpr,pages 5611

–

5618.ieee,2021.3,7,shijie hao,zhonghao wang,and fuming sun.ledet:a single-shot real-time object detector based on low-light image enhancement.the computer journal,2021.2,7,但shijie hao和haifeng guo等人的方法只能在夜间场景下工作,而且高度依赖图像增强方法导致网络计算效率低下,难以在实际场景中应用。

技术实现要素:

4.本发明的目的在于克服现有技术的不足,提供一种能有效地执行夜间目标检测和伪装目标检测的方法,为后续各类夜间和伪装目标场景下的计算机应用提供场景中感兴趣目标的精确位置与类别的基于上下文信息感知机理的夜间和伪装目标检测方法。

5.本发明的目的是通过以下技术方案来实现的:基于上下文信息感知机理的夜间和伪装目标检测方法,包括以下步骤:

6.s1、使用神经网络对输入图像进行特征提取,获得输入图像的特征图y;输入n个初始提议框,然后使用感兴趣区域特征提取器得到感兴趣区域特征图r;

7.s2、建模图像的全局与局部上下文信息:对得到的特征图y使用全局上下文编码模块处理得到全局上下文特征g;使用上下文特征融合模块处理r与g得到融合上下文特征c;通过动态特征交互模块将融合上下文特征c与感兴趣区域特征r融合,然后进行边框回归与分类预测;

8.s3、建模图像的全局语义上下文,对得到的特征图y进行卷积与上采样,输出语义

分割图s;

9.s4、使用网络上的公开数据集exdark、cod10k提供的图像与标注信息来训练根据s1-s3步骤构建出来的人工神经网络直到收敛,然后输入待检测图像得到最终检测结果。

10.进一步地,所述步骤s1具体实现方法为:

11.y=b(x)

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(1)

12.r=roialign(y,p)

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(2)

13.其中,b代表神经网络架构,b可以使用任意的卷积神经网络来实现,只要该网络具有足够的表现力来提取输入图像的特征即可;x表示输入图像;roialign()代表利用提议框对特征图y进行对齐操作;p代表输入的n个长度为4的初始提议框向量,其中每个向量中的元素取值范围为[0,1]的所有实数。

[0014]

进一步地,所述步骤s2具体实现方法为:

[0015]

re=conv(r,f(c,w1,b1),0)

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(3)

[0016][0017]

reg=f(d,w3,b3)

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(5)

[0018]

cls=f(d,w4,b4)

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(6)

[0019]

其中,f(x,w,b)代表分别以x为输入,w,b为参数的线性加权求和;conv(x,w,b)代表卷积函数;ffn()代表前馈神经网络;符号表示逐元素相加操作;σ(x)代表修正线性单元激活函数,其公式为:reg和cls分别代表输出的边框回归与类别预测值;wm、bm代表神经网络的固有可学习参数,m=1,

…

,4;

[0020]

图像的全局与局部上下文特征向量c由下面的公式计算得到:

[0021][0022]

c=attention(gl,gl,gl)

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(6)

[0023]

其中,gl代表融合后同时携带全局和局部特征的特征向量;g和l分别代表图像的全局特征向量和图像的局部特征向量;attention(gl,gl,gl)函数表示自注意力函数;

[0024]

全局特征向量g由下面的公式计算得到:

[0025]

g=δ(f(δ(f(e,w3,b3)),w4,4))

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(7)

[0026]

δ(x)代表泄露修正线性单元激活函数,其公式为:其中a的取值范围为(0,+∞);wi,bi代表神经网络的固有可学习参数;图像的全局特征e由下面的公式计算得到:

[0027]

e=δ(avg(conv(y,w5,b5)))

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(8)

[0028]

avg(x)代表全局平均池化函数;δ(x)代表泄露修正线性单元激活函数,其公式为:

[0029]

w5,b5代表神经网络的固有可学习参数;

[0030]

局部特征向量l由下面的公式计算得到:

[0031]

l=σ(f(r,w6,b6))

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(9)

[0032]

σ(x)代表修正线性单元激活函数,其公式为:w6,b6代表神经网络的固有可学习参数。

[0033]

进一步地,所述步骤s3具体实现方法为:

[0034]

s=softmax(decoder(concat(y,aspp(y))))

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(10)

[0035]

decoder(x)=up(conv(up(conv(x,w7,b7)),w8,b8))

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(11)

[0036]

softmax(x)代表柔性最大值传输函数;decoder(x)代表解码器,其由多个相同的上采样层和卷积层组成;concat(a,b)代表将a与b根据通道维度进行串联的连接操作;up(x)代表双线性插值上采样函数;conv(x,w,b)代表以w,b为可学习参数的卷积函数;aspp为空洞金字塔池化操作。

[0037]

进一步地,所述步骤s4具体实现方法为:

[0038]

l

t

=λd*ld+λs*lsꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(12)

[0039]

l

t

代表神经网络的训练损失函数;ld和ls分别代表目标检测损失函数和语义分割损失函数;λd和λs分别代表目标检测损失函数和语义分割损失函数的系数;

[0040]

目标检测损失函数ld由下面的公式计算得到

[0041]

ld=λ

cls

*l

cls

+λ

reg

*l

reg

+λ

giou

*l

giou

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(13)

[0042]

l

cls

代表焦点损失函数;l

reg

代表最小绝对值误差损失函数;l

giou

代表广义交并比损失函数;λ

cls

、λ

reg

和λ

giou

分别代表各损失函数的系数;

[0043]

语义分割损失函数ls由下面的公式计算得到:

[0044]

ls=-(s

*

logs+(1-s

*

)*log(1-s)

ꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(14)

[0045]s*

代表监督信号,由数据集提供。

[0046]

本发明的有益效果是:本发明能够提供一种能有效地执行夜间目标检测和伪装目标检测的方法,为后续各类夜间和伪装目标场景下的计算机应用提供场景中感兴趣目标的精确位置与类别。

附图说明

[0047]

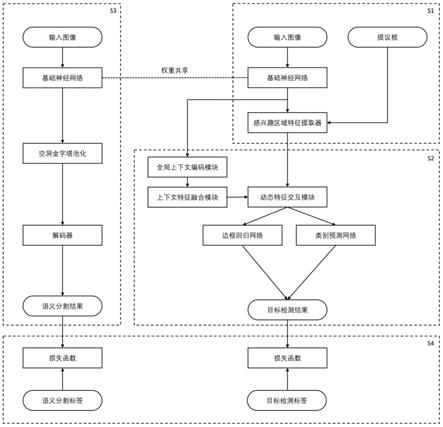

图1为本发明的基于上下文信息感知机理的夜间和伪装目标检测方法的流程图;

[0048]

图2为本实施例采用的夜间图像、伪装图像以及对应的标签信息;

[0049]

图3、4为本实施例经过步骤s1处理后得到的夜间图像与伪装图像的特征图;

[0050]

图5、6为本实施例经过步骤s3处理后得到的夜间图像与伪装图像语义分割图;

[0051]

图7为本实施例的最终目标检测检测结果。

具体实施方式

[0052]

下面结合附图进一步说明本发明的技术方案。

[0053]

如图1所示,本发明的一种基于上下文信息感知机理的夜间和伪装目标检测方法,包括以下步骤:

[0054]

s1、使用神经网络对输入图像进行特征提取,获得输入图像的特征图y;输入n个初始提议框,然后使用感兴趣区域特征提取器得到感兴趣区域特征图r;具体实现方法为:

[0055]

y=b(x)

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(1)

[0056]

r=roialign(y,p)

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(2)

[0057]

其中,b代表神经网络架构,b可以使用任意的卷积神经网络来实现,只要该网络具有足够的表现力来提取输入图像的特征即可;x表示输入图像;roialign()代表利用提议

框对特征图y进行对齐操作;p代表输入的n个长度为4的初始提议框向量,其中每个向量中的元素取值范围为[0,1]的所有实数。

[0058]

本实施例采用图像大小为640*640的夜间图像和伪装图像,如图2所示,图像分别来源于exdark和cod10k图像数据集,图像分别命名为“2015_00477”和“cod10k-cam-1-aquatic-8-frogfish-299”,(a)、(b)分别为夜间图像和伪装图像。在本实施例中的参数设置如下epochs=144,n=100,b=resnet-50。本实施例输入形状为(3,640,640)的图像,经过基础神经网络进行特征提取y=b(x)得到形状为(256,20,20)、(256,40,40)、(256,80,80)、(256,160,160)的特征图,其中256对应特征图通道,后面两个数字分别对应特征图的宽高。对应特征图的宽高。然后使用感兴趣区域提取操作r=roialign(y,p)得到形状为(n,256,7,7)的感兴趣区域特征,其中n代表感兴趣区域的个数,256代表感兴趣区域特征图通道,后面两个数字分别对应感兴趣区域特征图的宽高。分别以exdark夜间目标检测数据集和cod10k图像数据集中的一张图像作为输入为例,经过处理后得到如图3、4所示的特征图。

[0059]

s2、模拟生物视觉系统的全局上下文感知机制,建模图像的全局与局部上下文信息:对得到的特征图y使用全局上下文编码模块处理得到全局上下文特征g;使用上下文特征融合模块处理r与g得到融合上下文特征c;通过动态特征交互模块将融合上下文特征c与感兴趣区域特征r融合生成融合特征d,然后进行边框回归与分类预测;具体实现方法为:

[0060]

re=conv(r,f(c,w1,b1),0)

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(3)

[0061][0062]

reg=f(d,w3,b3)

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(5)

[0063]

cls=f(d,w4,b4)

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(6)

[0064]

其中,f(x,w,b)代表分别以x为输入,w,b为参数的线性加权求和,其公式为:f(x,w,b)=x*w+b;conv(x,w,b)代表卷积函数,其公式为:卷积函数,其公式为:其中w,b为卷积的固有可学习参数;ffn代表前馈神经网络,其公式为:ffn(x)=σ(w2(σ(w1x+b1)))+b2,w1,w2,b1,b2为网络固有可学习参数;符号表示逐元素相加操作;σ(x)代表修正线性单元激活函数,其公式为:reg和cls分别代表输出的边框回归与类别预测值;wm,bm代表神经网络的固有可学习参数,m=1,

…

,4。

[0065]

图像的全局与局部上下文特征向量c由下面的公式计算得到:

[0066][0067]

c=attention(gl,gl,gl)

ꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(6)

[0068]

其中,gl代表融合后同时携带全局和局部特征的特征向量;g和l分别代表图像的全局特征向量和图像的局部特征向量;attention(gl,gl,gl)函数表示自注意力函数,其公式为:其中gl

t

为gl的转置,d

gl

为gl对应的维度;全局特征向量g由下面的公式计算得到:

[0069]

g=δ(f(δ(f(e,w3,b3)),w4,4))

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(7)

[0070]

δ(x)代表泄露修正线性单元激活函数,其公式为:其中a的取值范围为(0,+∞);wi,bi代表神经网络的固有可学习参数;图像的全局特征e具体由下面的

公式计算得到:

[0071]

e=δ(avg(conv(y,w5,b5)))

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(8)

[0072]

avg(x)代表全局平均池化函数,其公式为:其中x(i,j)代表x特征图的第i行j列的值,h与w分别代表特征图的高度与宽度;δ(x)代表泄露修正线性单元激活函数,其公式为:公式中的w5,b5代表神经网络的固有可学习参数;本实施例对特征图y(256,20,20)、(256,40,40)、(256,80,80)、(256,160,160)进行填补卷积后得到形状相同的特征图,再进行全局平均池子化得到4个形状为(256,1,1)的特征向量,将这些向量展开并连接后得到形状为(1024)的全局特征e。将e输入到公式(7)中进行两次加权求和操作后得到形状为(n,256)的全局特征向量,其中n在本示例中为100。

[0073]

局部特征向量l由下面的公式计算得到:

[0074]

l=σ(f(r,w6,b6))

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(9)

[0075]

σ(x)代表修正线性单元激活函数,其公式为:w6,b6代表神经网络的固有可学习参数。

[0076]

将感兴趣区域特征图r进行加权求和得到形状为(n,256)的局部特征向量,其中n在本示例中为100。

[0077]

s3、建模图像的全局语义上下文,对得到的特征图y进行卷积与上采样,输出语义分割图s;具体实现方法为:

[0078]

s=softmax(decoder(concat(y,aspp(y))))

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(10)

[0079]

decoder(x)=up(conv(up(conv(x,w7,b7)),w8,b8))

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(11)

[0080]

softmax(x)代表柔性最大值传输函数;decoder(x)代表解码器,其由多个相同的上采样层和卷积层组成;concat(a,b)代表将a与b根据通道维度进行串联的连接操作;up(x)代表双线性插值上采样函数;conv(x,w,b)代表以w,b为可学习参数的卷积函数;aspp为空洞金字塔池化操作,其公式为aspp(x)=dconv(concat(conv(x,1)+conv(x,6)+conv(x,12)+dconv(x,18))),其中dconv(x,dilation)代表以x为输入,dilation为步长的空洞卷积。其示例如下:将公式(2)中得到的特征图y分别进行卷积后再上采样n次得到形状为(num_classes,,640,640)的语义图,其中num_classes为类别数。然后计算此语义图与标签的损失值,然后执行反向传播算法更新网络的权重;图5、6展示了图像经过s3步骤处理后得到的语义分割图,图5和图6中,上图为原图,下图为语义分割图。从途中可以看出,经过s3步骤对图像进行处理之后,该神经网络能够有效地提取图像中待检测物体的位置信息与类别信息。这些信息将会对目标检测分支提供有用的信息,并促进网络得到更精确的目标检测结果。

[0081]

s4、使用网络上的公开数据集exdark、cod10k提供的图像与标注信息(目标检测标注、语义分割标注)来训练根据s1-s3步骤构建出来的人工神经网络直到收敛,然后输入待检测图像得到最终检测结果;具体实现方法为:

[0082]

l

t

=λd*ld+λs*lsꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(12)

[0083]

l

t

代表神经网络的训练损失函数;ld和ls分别代表目标检测损失函数和语义分割损失函数;λd和λs分别代表目标检测损失函数和语义分割损失函数的系数;本网络总共需要

在训练集之上训练epochs次;

[0084]

目标检测损失函数ld由下面的公式计算得到

[0085]

ld=λ

cls

*l

cls

+λ

reg

*l

reg

+λ

giou

*l

giou

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(13)

[0086]

l

cls

代表焦点损失函数;l

reg

代表最小绝对值误差损失函数;l

giou

代表广义交并比损失函数;λ

cls

、λ

reg

和λ

giou

分别代表各损失函数的系数;

[0087]

焦点损失函数l

cls

由下面的公式计算得到:

[0088]

l

cls

=-α(1-p

*

)

γ

log(1-p)+(-α)(p

*

)

γ

log(p)

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(14)

[0089]

α代表平衡因子;p与p

*

分别代表预测的类别与真实的类别;γ代表聚焦因子;

[0090]

最小绝对值误差损失函数l

reg

由下面的公式计算得到:

[0091]

l

reg

=|r-r

*

|

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(15)

[0092]

r与r

*

分别代表预测的边框与真实的边框的坐标;

[0093]

广义交并比损失函数l

giou

由下面的公式计算得到:

[0094][0095]

a与b分别代表目标框与实际预测框,c代表a与b最小的外凸对象,iou代表目标框与实际预测框的交并比;

[0096]

语义分割损失函数ls由下面的公式计算得到:

[0097]

ls=-(s

*

logs+(1-s

*

)*log(1-s)

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(17)

[0098]s*

代表监督信号,由数据集提供。特别地,该监督信号在夜间目标检测任务中由微软coco数据集中的语义分割标签提供,在伪装目标检测任务中由数据集本身的语义分割标签提供。其示例如下:使用公式(11)~(16)计算由公式(5)、(6)和(10)得到的目标检测框与语义图与数据集提供的标签损失值,然后使用反向传播算法来更新整个神经网络的权重,从而不断地从某一数据集中学习并重复epochs次,得到越来越好的检测结果。当训练阶段完成后,可以直接输入图像执行目标检测任务。

[0099]

经过步骤s1~s3的计算后由步骤s4进行训练后,将图像输入训练好的检测网络,得到最终的检测结果如图7(a)和(b)所示。

[0100]

本领域的普通技术人员将会意识到,这里所述的实施例是为了帮助读者理解本发明的原理,应被理解为本发明的保护范围并不局限于这样的特别陈述和实施例。本领域的普通技术人员可以根据本发明公开的这些技术启示做出各种不脱离本发明实质的其它各种具体变形和组合,这些变形和组合仍然在本发明的保护范围内。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1