一种唇语识别方法和系统

1.本发明属于计算机视觉、自然语言处理和智能穿戴设备领域,更具体地,涉及一种唇语识别方法和系统。

背景技术:

2.目前,听障人士的辅助设备主要如下:

3.(1)助听器:助听器是一个小型扩音器,把原本听不到的声音加以扩大,再利用听障者的残余听力,使声音能送到大脑听觉中枢,从而感受到声音。助听器主要由麦克风、放大器、受话器、电池、各种音量音调控制旋钮等元件组成。但由于助听器是用来提高听力的一种设备,如果使用者彻底丧失听力,则该产品无效,对使用群体存在限制;其次,扩大有效的声音的同时,噪音也会扩大,使用者会听到很多杂音噪音,无法在全场景下保证使用效果。

4.(2)人工耳蜗:人工耳蜗是一种电子装置,由体外言语处理器将声音转换为一定编码形式的电信号,通过植入体内的电极系统,直接兴奋听神经来恢复或重建聋人的听觉功能。人工耳蜗的仪器需要定期的保养和清理,且使用寿命有限,需要通过手术的方式进行安装,风险高且花销庞大。而且植入人工耳蜗会引起一系列的并发症,比如皮下血肿,急性中耳炎等,给患者带来更多的痛苦。

5.(3)电子手套:电子手套可以将聋哑人打出的手语或者手势,翻译成普通人可以看懂、听懂的语言和文字。但由于电子手套对于使用群体有一定要求,如必须熟练掌握手语等;而且成本过高,给使用者带来了一定的经济压力。除此之外,在日常使用过程中,还会出现误读误报的可能,降低了用户的使用体验。

6.唇读,也称为视觉语言识别,是一种从不包含音频的视频中识别其中人物说话内容的一种技术,其所涉及的技术主要包括计算机视觉和自然语言处理这两大方向。唇读技术的应用场景广泛,不会受到声音信号信噪比高低的影响,在语音识别中能辅助嘈杂环境下的识别效果,在健康医疗领域中能有效辅助患有听力障碍人士的交流。但唇读同时也是一种十分具有挑战的任务,目前的主流模型识别准确率仍然较低。因此,如何提高唇读技术的识别准确率,以及对特定场景下的唇读技术的优化具有十分重要的理论和实用价值。

7.传统的人脸检测方法主要使用基于adaboost的人脸检测算法,该算法主要基于积分图、级联检测器和adaboost分类器,能够快速检测出正面人脸,且速度非常快。其核心思想为自动从多个弱分类器空间中挑选出若干个分类器组合成为一个强分类器。但该算法缺点也较为明显,对噪声敏感,鲁棒性不够强,在复杂背景下容易误检且错误率较高。

8.在人脸检测后,需要对检测到的区域进行特征提取。传统特征提取与识别方法通常包含三类算法:基于表观的,基于形状的以及二者结合的。基于表观的代表性方法为hog特征检测和全局图像线性变换等,其特点为特征提取速度快且不需要复杂的人工建模,但这类方法对于环境和姿态变换十分敏感,对唇部区域的提取精度要求非常高,且泛化性较差。基于形状的特征提取代表性方法包括轮廓描述、afs和形状模型等,其特点为具有良好

的可解释性,且能有效去除冗余信息,泛化性较好,但同时这类方法需要大量的人工标注,且会损失部分有用信息,对姿势变换十分敏感。除此以外,基于以上两种结合的方法,例如形状表观模型等方法,通常具有较强的特征表达能力,且泛化性较强。但相对的,这类方法需要大量的人工标注以及复杂的运算。

9.在得到人脸区域的特征后,我们需要对特征进行分类或者解码,以得到预测的单词或句子。通常来说,我们可以使用svm、map等模型进行模型分类,使用hmm或gmm等模型进行特征序列解码,但这两类方法通常效率和准确率都较低,且泛化性能较差,难以实际应用。

10.由此可见,现有技术存在效率低、准确率低、泛化性能较差、难以实际应用的技术问题。

技术实现要素:

11.针对现有技术的以上缺陷或改进需求,本发明提供了一种唇语识别方法和系统,由此解决现有技术存在效率低、准确率低、泛化性能较差、难以实际应用的技术问题。

12.为实现上述目的,按照本发明的一个方面,提供了一种唇语识别方法,包括:

13.提取连续帧人脸图像的唇部区域输入唇语识别模型进行唇语识别,得到各帧人脸图像对应的字符,组成语言文本;

14.所述唇语识别模型包括前端特征提取网络和后端分类网络,通过如下方式训练得到:

15.获取视频帧中人脸图像及其真实唇部语言,提取人脸图像的唇部区域,组成roi序列,将roi序列以及差分后roi序列分别输入前端特征提取网络的两个分支,输出拼接差分特征的唇部区域特征,将拼接差分特征的唇部区域特征输入后端分类网络,输出预测字符,以预测字符与真实唇部语言之间的误差最小为目标训练至收敛,得到唇语识别模型。

16.进一步地,所述唇部区域的提取方式包括:

17.从人脸图像中提取3d人脸关键点,对于检测不到人脸或者关键点检测错误的某帧人脸图像,获取该帧人脸图像前后最近的一个检测到人脸且正确检测到人脸关键点的帧,计算前后两帧之间,每个3d人脸关键点的差值,从靠前的一帧对应的3d人脸关键点开始进行线性插值,得到该帧人脸图像的3d人脸关键点,从3d人脸关键点中提取以唇部为中心形成的唇部区域。

18.进一步地,所述唇部区域的提取还包括:

19.选择人脸图像为正脸时提取的3d人脸关键点的均值作为参考脸,计算人脸图像中多个3d人脸关键点到参考脸中多个关键点之间的仿射矩阵,通过仿射矩阵校正人脸图像的3d人脸关键点,从校正后的3d人脸关键点中提取以唇部为中心形成的唇部区域。

20.进一步地,所述唇部区域的提取还包括:

21.将静态人脸图像输入关键点检测模型,生成多个旋转后的人脸图像以及3d人脸关键点,以生成的3d人脸关键点与静态人脸图像的实际3d人脸关键点之间的误差最小为目标训练至收敛,得到训练好的关键点检测模型,利用训练好的关键点检测模型从人脸图像中提取3d人脸关键点。

22.进一步地,所述训练之前对roi序列进行如下预处理:

23.对roi序列进行随机裁剪和随机水平翻转后,得到预处理roi序列,在预处理roi序列的张量形状的第一个维度上打乱其顺序,并且随机取一个范围在[1/5,4/5]之间的随机数,该随机数代表要在预处理roi序列上竖直裁切,所得到的数据占预处理roi序列的比例,1减去该随机数代表打乱后的预处理roi序列竖直裁切所得到的数据占打乱后的预处理roi序列的比例,将两次裁切后的数据合并后作为增强roi序列,将增强roi序列作为训练数据。

[0024]

进一步地,所述前端特征提取网络的训练包括:

[0025]

将roi序列以及差分后roi序列分别输入前端特征提取网络的两个分支,输出拼接差分特征的唇部区域特征,将拼接差分特征的唇部区域特征输入临时后端网络中,得到roi序列的预测字符文本,将roi序列的预测字符文本与roi序列的真实文本之间的误差作为损失函数,反向传播损失函数更新前端特征提取网络的权重,训练至收敛,得到训练好的前端特征提取网络。

[0026]

进一步地,所述后端分类网络的训练包括:

[0027]

在前端特征提取网络训练完成后,冻结前端特征提取网络的权重,将前端特征提取网络输出的所有拼接差分特征的唇部区域特征填充至同一长度后输入后端分类网络,训练时,先从一个字符开始,逐步增加字符数量至最大,每次训练将前一次训练时分类正确的数据作为当前训练的输入,以预测字符与真实唇部语言之间的误差最小为目标训练至收敛,得到训练好的后端分类网络。

[0028]

按照本发明的另一方面,提供了一种唇语识别系统,包括:

[0029]

预处理模块,用于获取视频帧中人脸图像及其真实唇部语言,提取人脸图像的唇部区域,组成roi序列;

[0030]

训练模块,用于将roi序列以及差分后roi序列分别输入前端特征提取网络的两个分支,输出拼接差分特征的唇部区域特征,将拼接差分特征的唇部区域特征输入后端分类网络,输出预测字符,以预测字符与真实唇部语言之间的误差最小为目标训练至收敛,得到唇语识别模型;

[0031]

识别模块,用于提取连续帧人脸图像的唇部区域输入唇语识别模型进行唇语识别,得到各帧人脸图像对应的字符,组成语言文本。

[0032]

按照本发明的另一方面,提供了一种唇语识别系统,其特征在于,包括:主机、对外摄像头和显示器;

[0033]

所述对外摄像头在使用时置于使用者额前或者置于使用者佩戴的眼镜上,用于采集他人的人脸图像;

[0034]

所述主机在使用时置于使用者耳后,用于提取人脸图像的唇部区域图像输入唇语识别模型进行唇语识别,得到他人字符传递至显示器;

[0035]

所述显示器,用于展示他人字符。

[0036]

按照本发明的另一方面,提供了一种唇语识别系统,包括:主机、扬声器、对内摄像头;

[0037]

所述对内摄像头在使用时置于使用者唇前,用于采集使用者的唇部区域图像;

[0038]

所述主机在使用时置于使用者耳后,用于将使用者的唇部区域图像输入唇语识别模型进行唇语识别,得到使用者字符传递至扬声器;

[0039]

所述扬声器在使用时置于使用者衣领,用于播放使用者字符对应的语音。

[0040]

按照本发明的另一方面,提供了一种唇语识别系统,包括:主机、扬声器、对内摄像头、对外摄像头和显示器;

[0041]

所述对内摄像头在使用时置于使用者唇前,用于采集使用者的唇部区域图像;

[0042]

所述对外摄像头在使用时置于使用者额前或者置于使用者佩戴的眼镜上,用于采集他人的人脸图像;

[0043]

所述主机在使用时置于使用者耳后,用于将使用者的唇部区域图像输入唇语识别模型进行唇语识别,得到使用者字符传递至扬声器,提取他人人脸图像的唇部区域图像输入唇语识别模型进行唇语识别,得到他人字符传递至显示器;

[0044]

所述扬声器在使用时置于使用者衣领,用于播放使用者字符对应的语音;

[0045]

所述显示器,用于展示他人字符,还用于展示使用者字符。

[0046]

总体而言,通过本发明所构思的以上技术方案与现有技术相比,能够取得下列有益效果:

[0047]

(1)本发明在训练时,将roi序列以及差分后roi序列分别输入前端特征提取网络的两个分支。通过观察roi序列,发现其前后存在明显的连贯性,即除了唇部运动区域外其他区域在序列前后的位置几乎是不变的,这使得可通过对输入进行差分的方法,直接得到唇部的运动部分,从而让模型获得唇部区域微小的运动特征。由于差分操作会损失较多的信息,因此,本发明在训练时,将roi序列以及差分后roi序列分别输入前端特征提取网络的两个分支,保留原来的输入部分,用一个新的分支对差分后的数据进行特征提取,并且最后对两者进行相加操作,融合两者的信息,从而在提取到每一帧特征的同时,增强模型对运动特征的捕捉能力。使得本发明可以在非限制性环境中仍然准确识别唇语。同时本发明先训练后识别的方式,模型识别准确率高,识别效率高,泛化性能较好。

[0048]

(2)主流唇读技术所使用的dlib属于2d人脸关键点检测模型,一方面检测出来的人脸关键点精度较低,往往会出现大量的错误,另一方面缺少人脸3d结构上的约束,只能够利用图像中可见的人脸部分,而无法感知到被遮挡的人脸部分,因此在侧脸、有遮挡的场景下人脸关键点中存在大量的错误。3d人脸关键点检测能够充分利用人脸的3d结构约束,感知到图像中人脸被遮挡的部分。使得模型对遮挡场景具有非常强的鲁棒性,从而提供更精确的3d人脸关键点。从更精确的人脸关键点能得到更准确的对齐roi,一方面,更准确的roi能够去除掉更多与唇读任务无关的信息,进一步提高模型的识别准确率,另一方面,更加对齐的roi能够突出视频中的微小运动,允许通过简单的差分操作提取出视频中唇部的微小运动。

[0049]

(3)为了更好的提取到微唇语中的微小运动特征,采用了3d人脸关键点检测模型来完成人脸关键点检测。提取3d人脸关键点时会存在一定数量的错误以及漏检,因此需要通过一些规则来对检测结果进行判断和修正。对于检测不到人脸或者关键点检测错误的视频帧,采用插值的方法填充这些视频帧的人脸关键点。在获取到人脸关键点后,需要对感兴趣区域roi进行提取和矫正,得到中心位于唇部区域的roi序列。

[0050]

(4)在主流唇读技术所使用的数据增强方法中,cutout和mixup属于其中较强的两种方法,但他们都存在一定的问题。前者会造成信息损失,而后者会改变数据分布,这些问题会对模式识别产生较大的影响。本发明对roi序列进行数据增强处理,是对视频数据进行处理,唇部往往分布在数据的1/5到4/5的位置区域,因此,本技术在[1/5,4/5]之间的随机

数进行竖直分割,将裁切后的数据合并从而得到适用于唇读任务的数据,同时增强后更多的数据往往会带来更高的模型准确率。

[0051]

(5)后端分类网络训练时,由于每个视频的长度都不一样,需要进行填充。从一个字符开始,将输入的字符数逐渐提升到最大,而不是一次性全部输入训练,防止过拟合,以及起到正则化的效果。将前一步正确的结果作为输入,防止错误结果累积过长导致模型训练失败。

[0052]

(6)本发明提供了具备读取功能的唇语识别系统、具备发声功能的唇语识别系统,以及同时具备读取和发声功能的唇语识别系统。这三种系统均克服现有产品成本高昂、使用场景局限等缺陷,使听障人士能够借助硬件发声音,与普通人群进行便捷的沟通和交流。且组成的硬件价格低廉;而且不会因为噪声干扰,影响使用者的佩戴体验,可以适用于多种场景。

附图说明

[0053]

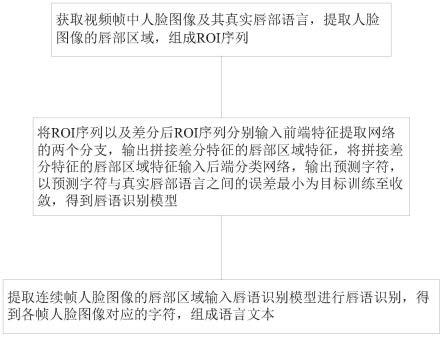

图1是本发明实施例提供的一种唇语识别方法的流程图;

[0054]

图2是本发明实施例提供的感兴趣区域提取示意图;

[0055]

图3是本发明实施例提供的唇语识别模型的训练示意图;

[0056]

图4是本发明实施例提供的一种唇语识别系统结构图。

具体实施方式

[0057]

为了使本发明的目的、技术方案及优点更加清楚明白,以下结合附图及实施例,对本发明进行进一步详细说明。应当理解,此处所描述的具体实施例仅仅用以解释本发明,并不用于限定本发明。此外,下面所描述的本发明各个实施方式中所涉及到的技术特征只要彼此之间未构成冲突就可以相互组合。

[0058]

如图1所示,一种唇语识别方法,包括:

[0059]

提取连续帧人脸图像的唇部区域输入唇语识别模型进行唇语识别,得到各帧人脸图像对应的字符,组成语言文本;

[0060]

所述唇语识别模型包括前端特征提取网络和后端分类网络,通过如下方式训练得到:

[0061]

获取视频帧中人脸图像及其真实唇部语言,提取人脸图像的唇部区域,组成roi序列,将roi序列以及差分后roi序列分别输入前端特征提取网络的两个分支,输出拼接差分特征的唇部区域特征,将拼接差分特征的唇部区域特征输入后端分类网络,输出预测字符,以预测字符与真实唇部语言之间的误差最小为目标训练至收敛,得到唇语识别模型。

[0062]

如图2所示,提取唇部区域的方法包括:

[0063]

本发明采用目前最前沿的关键点(landmark)检测模型,3ddfa_v2来进行3d人脸关键点提取。3ddfa_v2通过从一张静态人脸图像中,生成多个旋转后的人脸图像以及3d人脸关键点的方法,稳定拓展了之前3d人脸关键点数据集中的角度,允许模型学习到严重遮挡情况下的人脸3d关键点。本发明实施例中使用以mobilenet_v2为backbone版本的3ddfa_v2来提取3d人脸关键点,但其中依然会存在一定数量的错误以及漏检,因此需要通过一些规则来对模型的预测结果进行判断和修正。若检测不到人脸,那么第一步返回的结果为空;若

关键点检测错误,一般通过该帧全部人脸关键点的最大最小坐标计算最大面积,然后将该面积和该帧人脸框的面积做比较,若有某一帧面积差异过大,则认为这一帧的人脸关键点检测结果是有问题的。对于检测不到人脸,或者关键点检测错误的视频帧,我们默认采用插值的方法填充这些视频帧的人脸关键点,即对于该无法检测到人脸的视频帧,分别找到它前后最近的一个检测到有人脸并且正确检测到人脸关键点的帧,计算两个帧的关键点之间,每一个关键点的差值,从靠前的一个正确关键点开始进行线性插值,具体公式为:

[0064]

delta=e-s

ꢀꢀꢀ

(1)

[0065]

其中,每一个关键点的差值作为delta,靠前的一个成功帧关键点为s,索引为is,靠后的一个为e,索引为ie。那么从s后面第i帧的关键点为:

[0066][0067]

感兴趣区域roi的提取和矫正

[0068]

在获取到人脸关键点后,需要对感兴趣区域roi进行提取和矫正。选择一些正脸视频的关键点的均值作为参考脸,并对人脸部分进行矫正,具体步骤为:

[0069]

1)选取参考脸和每一帧中人脸的5个关键点(左右眼睛的最左和最右,以及鼻尖),计算它们之间的一个仿射矩阵;

[0070]

2)得到视频帧关键点到参考脸关键点这一方向的仿射矩阵,将这一仿射矩阵应用到整个视频帧上,得到校正后的视频帧和关键点;

[0071]

3)根据校正后的唇部20个关键点,计算它们的中心,以这个中心作为roi的中心,切取一个96x96大小的patch作为roi。

[0072]

为了更好的提取到微唇语中的微小运动特征,本发明采用了3d人脸关键点检测模型来完成人脸关键点检测。主流唇读技术所使用的dlib属于2d人脸关键点检测模型,一方面检测出来的人脸关键点精度较低,往往会出现大量的错误,另一方面缺少人脸3d结构上的约束,只能够利用图像中可见的人脸部分,而无法感知到被遮挡的人脸部分,因此在侧脸、有遮挡的场景下人脸关键点中存在大量的错误。3d人脸关键点检测通过拟合3dmm模型,能够充分利用人脸的3d结构约束,感知到图像中人脸被遮挡的部分,使得模型对遮挡场景具有非常强的鲁棒性,从而提供更精确的3d人脸关键点。从更精确的人脸关键点能得到更准确的对齐roi,一方面,更准确的roi能够去除掉更多与唇读任务无关的信息,进一步提高模型的识别准确率,另一方面,更加对齐的roi能够突出视频中的微小运动,允许通过简单的差分操作提取出视频中唇部的微小运动。

[0073]

如图3所示,唇语识别模型的训练包括:

[0074]

前端网络训练:在经过上述预处理过程后,得到中心位于唇部区域的roi序列。在模型训练过程中,对该序列进行数据增强,然后输入前端特征提取网络中提取序列特征,使用临时后端对序列特征进行分类,利用分类任务来完成对前端网络的训练。

[0075]

在数据增强过程中,使用随机裁剪,随机水平翻转和videomix。具体而言,在一批数据经过随机裁剪和随机水平翻转后,假设其张量形状为(batchsize,channel,framenumer,height,width),在batchsize维度上打乱其顺序,并且随机取一个范围在[1/5,4/5]之间的随机数,该数字代表要从打乱前的数据上,竖直裁切视频,所得到的数据占原数据的比例,1减去该数字代表打乱后的视频竖直裁切所得到的数据占打乱后数据的比例,

两个裁切的视频大小应该正好互补构成原数据大小,将两者合并后的数据作为增强后的数据输出作为数据增强后的训练数据,并输入前端网络。

[0076]

对于前端特征提取网络,添加运动差分模块来增强对运动特征的提取效果。具体的,将前端改造为一个双流网络,其中一支的输入为原始roi视频,另外一支输入为差分后的roi视频,两者结构上完全一致。具体结构为:一层3d卷积,将roi降采样,一层resnet18的第一层,来初步提取特征。之后将两个resnet18第一层的输出相加,用差分特征来补充原始视频的特征,强调视频中运动的部分,提高微唇语的效果。后续的模型为resnet18的2、3、4层,输入为原始和差分特征相加后的合并特征。

[0077]

采用dc-tcn网络作为临时后端,resnet18输出的特征输入到一个dctcn的网络中,学习特征时序上的关系,得到该特征序列的一个预测字符文本,从而训练前端的特征提取网络。

[0078]

差分操作,即前一帧和后一帧的相同位置的像素相减,若原视频有n帧,那么差分之后的视频一共具有n-1帧。由于差分操作会损失较多的信息,因此,本发明保留原来的输入部分,用一个新的子模块对差分后的数据进行特征提取,并且最后对两者进行相加操作,融合两者的信息,从而在提取到每一帧特征的同时,增强模型对运动特征的捕捉能力。具体来说,运动差分模块复用了原特征提取前端的部分模块,但并不共享权重,通过这种方法将特征提取前端改造为双流输入,同时提取两种信息,并通过将提取到的特征相加的方法,加强原视频提取到的特征以及对唇部运动区域的特征捕捉能力。

[0079]

后端网络训练:前端网络训练完成后,冻结前端网络权重,从视频中提取特征。后端网络使用transformer-seq2seq架构,输入为前端提取到的特征,输出为预测的文本。transformer由编码器和解码器组成,两者均由若干层相同layer堆叠而成。其中,编码器的encoderlayer由multi-head self-attention、feedforward和layernorm组成,用于把图像序列映射成为隐藏层,即提取该图像序列的数学表示。解码器的decoderlayer和encoderlayer的结构基本相同,把隐藏层再映射为自然语言序列。由于每个视频的长度都不同,需要先将每个batch内的序列pad到同一个长度,并且将mask输入transformer去掩盖pad。在训练时,采用课程学习设置,从一个单词(字符)开始,将输入的单词数逐渐提升到最大,而不是一次性全部输入训练,防止过拟合,起到正则化的效果。同时还会采用teacher forcing策略,将前一步正确的结果作为输入,防止错误结果累积过长导致模型训练失败。模型解码部分用greedy decode或者beam search decode,前者速度快,但效果较差,后者稍微慢一些但效果会更好,beam search采用束搜索方法,每次选取top k个单词(字符)解码,最后,计算使得全局似然最大的结果作为输出。

[0080]

深度学习是一种数据驱动的方法,通常情况下更多的数据往往会带来更高的模型准确率,因此在深度学习中,会大量使用数据增强来扩充训练集,从而获得更高的模型准确率。在主流唇读技术所使用的数据增强方法中,cutout和mixup属于其中较强的两种方法,但他们都存在一定的问题。前者会造成信息损失,而后者会改变数据分布,这些问题会对模式识别产生较大的影响。

[0081]

因此,本技术提出一种拓展的cutmix数据增强方法来进一步扩充数据以及提高模型识别准确率,称之为videomix。原版的cutmix方法就是将一部分区域裁切掉但不填充0像素,而是随机填充训练集中的其他数据的区域像素值,并且标签按一定的比例分配。本发明

提出的videomix与原版的cutmix相比有两处不同:第一,cutmix是一种应用在图像上的数据增强手段,本发明通过对每一帧采取相同处理的方法,将cutmix拓展并应用到视频数据上;第二,对于图像分类任务而言,原版的cutmix方法组合了两个图像不同区域的特征,能起到较强的数据增强效果,但对于唇读,如果cutmix随机裁切的区域不包含唇部,会使模型错误关注与唇读不相关的区域,造成准确率下降。因此本发明进一步修改cutmix的裁切方法,将原版中随机裁切改为竖直分割图像。结合上一步中提取到的对齐的感兴趣区域roi,本发明可以注意到唇部往往分布在数据的1/5到4/5的位置区域,因此,本发明随机在这一区域中将图像竖直分割并按照cutmix的方法组合称为新的数据,从而得到适用于唇读任务的videomix方法。

[0082]

通过3d人脸关键点得到对齐的感兴趣区域roi,通过观察后不难发现其前后存在明显的连贯性,即除了唇部运动区域外其他区域在序列前后的位置几乎是不变的,这使得可通过对输入进行差分的方法,直接得到唇部的运动部分,从而让模型获得唇部区域微小的运动特征。由于差分操作会损失较多的信息,因此,本发明保留原来的输入部分,用一个新的子模块对差分后的数据进行特征提取,并且最后对两者进行相加操作,融合两者的信息,从而在提取到每一帧特征的同时,增强模型对运动特征的捕捉能力。

[0083]

本发明基于计算机视觉与自然语言处理等技术,通过对使用者的唇部形态进行识别,将其转化为相应的文本及语音。此外,本发明通过置于使用者唇前的对内摄像头采集使用者唇部动态,置于使用者额前的对外摄像头采集他人的唇部动态,并使用计算机视觉技术,从摄像头捕捉的视频中检测人脸,并消除背景,提取roi区域。之后,通过关键点矫正人脸,并使用唇部的关键点,形成相应的数据流。最后,通过悬挂于使用者耳后的主机与云端服务通信,将数据流输入到唇语识别模型中,解析唇语数据,得到相应的文本和语音,并通过固定于使用者衣领的小型扬声器播放语音,通过显示器将唇语对应的文本反馈给使用的听障人士。

[0084]

实施例1

[0085]

一种同时具备读取和发声功能的唇语识别系统,包括:主机、扬声器、对内摄像头、对外摄像头、显示器。

[0086]

所述对内摄像头在使用时置于使用者唇前,用于采集使用者的唇部区域图像;

[0087]

所述对外摄像头在使用时置于使用者额前或者置于使用者佩戴的眼镜上,用于采集他人的人脸图像;

[0088]

所述主机在使用时置于使用者耳后,用于将使用者的唇部区域图像输入至云端服务器的唇语识别模型中进行唇语识别,得到使用者字符传递至扬声器,提取他人人脸图像的唇部区域图像输入云端服务器的唇语识别模型进行唇语识别,得到他人字符传递至显示器;

[0089]

所述扬声器在使用时置于使用者衣领,用于播放使用者字符对应的语音;

[0090]

所述显示器,用于展示他人字符,还用于展示使用者字符。

[0091]

显示器上不仅可以显示他人话语,还可以显示使用者自己的话语。由于唇读模型的识别误差或使用者的口型不标准,均有可能造成最终识别结果的错误,通过显示器的反馈,使用者可以知道信息是否得以准确的表达。

[0092]

实施例2

[0093]

一种具备读取功能的唇语识别系统,其特征在于,包括:主机、对外摄像头和显示器;

[0094]

所述对外摄像头在使用时置于使用者额前或者置于使用者佩戴的眼镜上,用于采集他人的人脸图像;

[0095]

所述主机在使用时置于使用者耳后,用于提取人脸图像的唇部区域图像输入云端服务器中的唇语识别模型进行唇语识别,得到他人字符传递至显示器;

[0096]

所述显示器,用于展示他人字符。

[0097]

实施例3

[0098]

一种具备发声功能的唇语识别系统,包括:主机、扬声器、对内摄像头;

[0099]

所述对内摄像头在使用时置于使用者唇前,用于采集使用者的唇部区域图像;

[0100]

所述主机在使用时置于使用者耳后,用于将使用者的唇部区域图像输入云端服务器的唇语识别模型进行唇语识别,得到使用者字符传递至扬声器;

[0101]

所述扬声器在使用时置于使用者衣领,用于播放使用者字符对应的语音。

[0102]

实施例4

[0103]

一种同时具备读取和发声功能的唇语识别系统,包括:主机1、扬声器2、对内摄像头3、led4、显示器5、对外摄像头6。

[0104]

主机1悬挂于使用者的耳后,主要用于初步处理采集数据以及与云端进行通信。显示器5位于使用者的额前,通过数据线与主机相连,用于显示唇语解析后的文本;此外,显示器5还安装有对外摄像头6,用于采集他人的唇部动态。对内摄像头3悬挂于使用者的唇前,并有补光led 4打光,用于采集使用者的唇部动态。扬声器2固定于使用者的衣领上,通过蓝牙与主机相连,用于播放唇语解析后的语音。

[0105]

本发明中主机还需要对唇部区域图像进行关键点校正后再输入云端服务器中,本发明中主机包括:

[0106]

中央处理器:用来指控制程序中指令的执行顺序、控制部件按指令的要求进行动作、对各种操作实施时间上的定时和对数据进行算术运算和逻辑运算,包括但不限于控制器、寄存器、程序计数器、算术逻辑单元。

[0107]

存储器:用来保存信息,如数据,指令和运算结果。存储器主要包括存储程序区和存储数据区,其中,存储程序区需要存储操作系统、以及采集视频、上传视频等应用程序;存储数据区可存储视频数据、音频数据、文本数据等等。存储器可以是内部存储器或外部存储器,内部存储器如只读存储器和随机存储器,外部存储器如软盘、硬盘、光盘、u盘、移动硬盘。

[0108]

网络模块:用于汇集唇语数据,并通过各种网络接口方式上传到云端。除了基于wifi和宽带网络外,gprs/3g/4g/5g以及通用的nb-iot等移动线路也可采用。尤其是在户外和移动场景下,可以采取轻量级协议,如mqtt,coap,xmpp等。包括但不限于esp8266等模块。

[0109]

蓝牙模块:用于传输音频到扬声器或手机听筒,可以通过串口(spi、iic)和mcu控制设备进行数据传输。可以选择以下模块作为蓝牙模块:音频类soc,如csr8610,cs8635;或语音与数据复合的soc,可以同时传输语音,音频,数据,比如csr8670,8675等。

[0110]

电源模块:用于为中央处理器、存储器、专用集成电路、数字信号处理器及其他数字或模拟负载提供供电,可以是直接贴装在印刷电路板上的电源供应器,应由以下部分组

成:可充电镍镉电池及多个稳压电路,将充电电池电压转换成各个模块所需要的电压;输入整流滤波器,包含整流桥和输入滤波电容;单片开关电源,包括功率开关管、控制器及mosfet。

[0111]

摄像头模块:用于对采集唇语数据进行处理。由传感器、软板、图像处理芯片组成,其中物体通过镜头聚集的光,通过cmos或ccd集成电路,把光信号转换成电信号,再经过内部图像处理器转换成数字图像信号输出到数字信号处理器加工处理,转换成标准的grb、yuv等格式图像信号。

[0112]

屏显模块:用于将数据传输到显示器,并显示相应数据。

[0113]

按键模块:用于控制主机的工作状态。

[0114]

本发明在硬件方面,克服现有产品成本高昂、使用场景局限等缺陷,使听障人士能够借助硬件发声音,与普通人群进行便捷的沟通和交流。本发明是一种可穿戴式设备,由摄像头、扬声器和头戴式显示器等硬件组成,价格低廉;而且不会因为噪声干扰,影响使用者的佩戴体验,可以适用于多种场景,如超市、车站、医院、学校。

[0115]

本领域的技术人员容易理解,以上所述仅为本发明的较佳实施例而已,并不用以限制本发明,凡在本发明的精神和原则之内所作的任何修改、等同替换和改进等,均应包含在本发明的保护范围之内。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1