用于检测人的运动过程和/或生命体征参数的系统的制作方法

用于检测人的运动过程和/或生命体征参数的系统

1.已知专利申请的交叉引用

2.本专利申请要求以下德国专利申请的优先权:递交于2019年8月30日的de 102019123304.6;递交于2020年1月30日的de 102020102315.4以及递交于2020年5月12日的de 102020112853.3。上述德国专利申请的全部内容在此通过引用完全纳入本专利申请中。

技术领域

3.本发明涉及一种用于自动地执行老年病学测试的服务机器人。

4.本发明的背景

5.医疗健康体系一直饱受专业人员严重匮乏的困扰。这种人员匮乏导致用来治疗患者的时间越来越少。缺乏时间不仅导致患者和医务人员的不满,还导致疾病无法充分得到治疗,这不仅为患者带来痛苦,还减少了国民经济创造的价值。因为这些因素的原因,记录患者状况的必要性越来越高,从而从医学角度必要时也能够对可能归因为治疗不充分而造成的损害索赔请求进行辩护。这种记录义务在某些情况下可能有自我强化的作用。

6.在本文献中所述的服务机器人解决的问题在于,通过使用多个传感器由该服务机器人来自主地执行目前由医务人员进行的老年病学测试。这种服务机器人另外还能够准确记录完成的练习,由此使服务机器人的健康装置能够履行与此相关的记录义务和其他合规义务,而不必再为此还单独安排人手。另一项效果是使用服务机器人能够使测试的评估标准化,因为目前对患者的评估都依赖医务人员的经验,而该评估结果又因个人经验的原因而与其他医务人员不同。因此医务人员对同一练习进行的评估可能会得出不同的结果,而使用服务机器人则能够获取统一的评估结果。

7.除服务机器人比如能够获取barthel指标、执行所谓的“定时起身和行走”测试和/或有不同的特征的简易心理测试的老年病学领域以外,服务机器人在另一方面被如此配置,使得服务机器人能够替代性和补充性地解决诊所中的其他任务。这些例如包括光谱仪检查,其能够分析人皮下或皮上的不同的物质。这些分析比如能够用于测定精神错乱探测评分。

8.在一个方面,服务机器人还被配置为执行精神错乱识别和/或精神错乱监控。这种背景下,服务机器人在一个方面能够根据对声学信号序列的识别来测定患者可能存在的注意力障碍。在一个替代的和/或补充的方面,服务机器人能够基于图像识别来评估认知能力,和/或通过运动机能的实施情况来表明认知能力,比如通过计算患者对服务机器人的主要视觉上的请求做出反应的手指的计数来表明认知能力。作为替代方案和/或补充方案,服务机器人能够确定患者的疼痛状态。这能够通过识别情绪、检测上肢运动和/或接人工呼吸和/或未接人工呼吸的患者的疼痛发声来实现。在一个方面,服务机器人能够测定患者的血压、其呼吸频率,并且除了初步诊断和/或治疗目的之外,将这些信息用于操控自身的硬件和软件组件。

9.除此以外,服务机器人可以被配置为比如在检测数据的范围内探测操纵尝试。服

务机器人还能够检查用户是否在精神和/或身体方面受到可能影响待执行测试质量或其结果的不利影响。此外,在一个方面,服务机器人能够按环境影响因素来调整其信号处理质量,并且还调整信号输出。在此,这包括对输入和输出、用户对话等进行调整。

10.此外,使用服务机器人还显著减轻了医务人员的负担,因为他们不得不做些有时候耗时且单调但却对患者健康没有直接影响的工作,从而妨碍了这些人员实施直接改善患者健康的措施。

现有技术

11.本领域普通技术人员通晓健康或老年病领域不同种类的服务机器人。因此cn108422427描述了一种康复机器人,它能够送药片给患者服用。类似的是,cn206833244中描述的服务机器人能够在医院中分发材料。在医院领域,中国专利申请cn107518989和cn101862245涉及一种能够运送患者的服务机器人,其与轮椅类似。cn205950753描述了一种机器人,它通过传感机构识别患者,在医院中为患者提供导航。在cn203338133中描述了一种用来为护理人员提供支持的机器人,它能够在医院中陪同患者处理日常事务。相反,cn203527474涉及一种通过其机器人手臂为老人提供支持的机器人。

12.cn108073104涉及一种护理机器人,它能够护理受到传染的患者,手段包括为这些患者送药或者给药,为患者按摩,喂食,与患者沟通等。在此,护理机器人之所以能降低医务人员的感染危险是因为其减少了医务人员与患者接触的次数。cn107598943中描述了一种用于陪伴老人的机器人。这种机器人拥有几项监控功能,但其基本功能是地板清洁。

13.cn106671105涉及一种照顾老人的移动式服务机器人。这种服务机器人通过传感机构监控诸如体温之类的人体参数,还能够监控表情。该服务机器人还能够识别人是否跌倒并且能够通过网络相应地报警帮助。

14.类似的现有技术还包括cn104889994和cn204772554,其中医疗领域的服务机器人能够识别心跳频率,为患者提供氧气并且还包括语音识别和用于娱乐目的多媒体模块。cn105082149所描述的产品也能够检测血氧。cn105078445涉及一种记录尤其是老人心电图、测量血液中氧含量的服务机器人。类似地,cn105078450具备脑电图测量功能。

15.某些健康机器人专用于对患者进行练习或者测试。在cn108053889中相对简要地描述了一种基于已保存信息对患者进行练习的系统。cn108039193描述了一种在机器人中用于自动生成健康报告的系统。cn107544266中描述了借助机器人检测运动/适应性练习,记录和保存数据以对其进行分析并将该数据传输至外部系统。同时,该机器人能够通过不同传感器来监控药品的服用情况。

16.cn106709254描述了一种用于患者医学诊断的机器人,其同样以诊断为基础制定治疗方案。为此,机器人分析语音和图像信息,将其与存储器中保存的信息进行比对。为此,将使用一种神经网络。

17.cn106407715中描述了一种服务机器人,其使用语音处理和图像识别来执行患者的病史检查。除通过语音输入和输出装置询问以外,还能够在病史检查时通过触控板参考由机器人摄像头拍摄的舌头照片。

18.cn105078449描述了一种配备平板电脑和通信装置的服务机器人,通过它能够进行认知功能训练或者认知心理测试,以发现患者是否患有阿尔茨海默症。为此,平板电脑将

记录患者与儿童之间按照特定过程进行的电话交谈,从谈话记录中判断患者是否患有阿尔茨海默症。

19.服务机器人在一个方面根据纸的折叠来分析手势。在现有技术中,本质上是识别手势本身。然而,挑战尤其在于识别和跟踪手指。比如us10268277以及us9372546或us9189068就描述了一种通用的手势识别系统。在us9690984中比如示出了借助机器学习算法以摄像头为基础通过骨架模型来识别手。这些方案基本上涉及空手。相反,us9423879涉及识别和跟踪手中的物体,并提出使用热传感器将双手和手指(通过排出的热)与其他物体(趋于更冷)区分开来。

20.在现有技术中,只发现了两份文献涉及识别纸或用户手中类似于纸的物体。因此us9117274描述了怎样使用深度摄像头来识别用户拿在手里的一张纸,而在下一步骤中,图像被投影到代表一个平整表面的这张纸上,用户能够与该图像互动。通过将其拐角与保存在存储器中并在空间上在空间内旋转的四边形进行比较,来识别纸。与此相反,us10242527描述了怎样通过自动识别手势监控(游艺场中的)游艺桌,这包括与纸具有一定类似程度的游艺币或扑克牌。但未描述怎样进行识别,而是只描述了出于什么目的而进行这类分析。此外,扑克牌的牌角做成圆形,而纸的拐角通常未做成圆形。

21.根据对人认知状态的分析,同样描述了在现有技术中对控制机器人有影响的多种方案。例如,us20170011258示出了怎样以人的情绪状态为基础操纵机器人,其中基本上通过人的面部表情分析这种状态,同样通过梯度直方图分析检测面部表情。通常情况下,能够通过以聚类评估为基础的分类方法,但也能够通过神经网络,来确定人的情绪状态。比如us2019012599总地描述了怎样使用多层卷积神经网络以所拍摄面部视频为基础来生成权重,所述多层卷积神经网络具有至少一个卷积层和至少一个隐藏层,其最后一层描述人的情绪,该多层卷积神经网络测定至少一层的输入变量的权重,计算至少一个feed-forward-process(前馈过程)中的权重,并在反向传播的范围内进行更新。

22.在现有技术中,在检测人的精神状态方面存在不同的检查成果。比如us9619613使用一种通过震动工作的特殊仪器来分析人的精神状态。比如us9659150使用加速度传感器执行定时起身和行走测试。在us9307940中触发刺激,以通过输出定义长度的刺激序列并记录患者的反应,来测试其精神能力。us8475171比如利用虚拟现实技术为患者示出不同的图像并且通过患者对这些图像的识别来例如诊断阿尔茨海默症。us10111593比如使用运动分析识别精神错乱。相反,cn103956171尝试以患者的说话为基础得出简易心理测试评分的结论。

23.服务机器人被如此配置,从而通过其传感装置,比如通过摄像头,能够检测其他医学参数,其中包括以非接触方式测量血压。通过以摄像头为基础的分析来测定血压的这一最新技术通常正处于研究阶段。zaunseder等人(2018年)描述了血液流动彩色分析方法的大致情况。rouast等人(2018年)的评论文章也对此有所涉及。比如karylyak等人(2013年)或wang等人(2014年)具体从事以能够用信号数据为基础测定血压的分析算法检查,而mcduff等人(2014年)致力于检查测定心脏收缩和心脏舒张压力时间点,而bai等人(2018年)则检查新信号滤波器的有效性。例如parati等人(1995年)找到了根据检测到的测量值测定血压的常规方案。liu等人(2018年)致力于彩色分析的具体实现手段,同样比较面部的各个子区域,verkruysse等人(2008年)也提出了类似的方法,而lee等人(2019年)描述了以

面部运动为基础的具体实现手段。相反,unakafov(2018年)比较了以能够自由支配数据项为基础的不同方法。比如pasquadibisceglie等人(2018年)的方案已经进入实际应用阶段,它将彩色分析方法集成到一面镜子中。相反,luo等人(2019年)为了记录彩色数据使用了一台智能手机。wei等人(2018年)通过记录彩色数据的方案已经进入到具体落实阶段,它已具备临床检查的特征。ghijssen等人(2018年)的方案则相反。他们通过激光器发射光穿过手指,在相反侧用传感器进行探测,其中出射的光具有斑点图案,由此一方面能够探测周期性脉管血液流动,另一方面如之前的方案所述,能够探测血管的周期性脉管膨胀。

24.参考文献来源:

25.zaunseder等人,通过成像光度计分析心血管——回顾。生物医学工程生物技术2018;63(5):617

–

634,doi:0.1515/bmt-2017-01。

26.kurylyak等人,根据ppg信号估计血压,2013年ieee国际仪器和测量技术会议(i2mtc)。doi:10.1109/i2mtc.2013.6555424。

27.mcduff等人,使用数码相机远程探测光电收缩压和舒张压的峰值。ieee生物医学工程交易,61卷,编号12,2014年12月12日,doi:10.1109/tbme.2014.2340991。

28.bai等人,使用摄像头进行实时稳健的非接触式心率监控,ieeeaccessvolume6,2018。doi:10.1109/access.2018.2837086。

29.pasquadibisceglie等人,个人保健系统的心血管参数的非接触式分析。2018aeit国际年会。doi:10.23919/aeit.2018.8577458。

30.wang等人,使用脉冲过境时间和心率的无袖带血压分析。2014年12届国际信号处理会议(icsp)。doi:10.1109/icosp.2014.7014980。

31.luo等人,使用经皮光学成像技术的基于智能手机的血压测量。循环心血管成像。2019;12:e008857。doi:10.1161/circimaging.119.008857。

32.wei等人,透皮光学成像通过心率差异性分析揭示基础压力:一种能够与心电图相媲美的新方法。心理学前沿9:98。doi:10.3389/fpsyg.2018.00098。

33.parati等人,血压和心率差异性的频谱分析在分析心血管调控方面的作用。高血压。1995;25:1276-1286。doi:10.1161/01.hyp.25.6.1276。

34.rouast等人,使用低成本的rgb面部视频进行远程心率测量:技术文献回顾。前沿电脑科学,2018,12(5):858-872。doi:10.1007/s11704-016-6243-6。

35.lee等人,使用无监督聚类对球形心电图头运动的基于视觉的心率测量。传感器2019,19,3263。doi:10.3390/s19153263。

36.liu等人,经皮光学成像显示面部心血管活动的不同时空模态。科学报告,(2018)8:10588。doi:10.1038/s41598-018-28804-0。

37.unakafov。使用成像光学体积描记术的脉搏率分析:通用框架和公开数据项的方法比较。生物医学物理工程快讯4(2018)045001。doi:10.1088/2057-1976/aabd09。

38.verkruysse等人,利用环境光进行远程胸透成像。2008年12月22日/16卷,编号26/光学快讯21434。doi:10.1364/oe.16.021434。

39.ghijssen等人,生物医学光学快讯,9卷,8期,3937-3952页(2018)。doi:10.1364/boe.9.003937。

40.yamada等人2001(doi:10.1109/6979.911083)

41.roser和mossmann(doi:10.1109/ivs.2008.4621205)

42.us20150363651a1

43.mcgunnicle2010(doi:10.1364/josaa.27.001137)

44.espy等人(2010)(doi:10.1016/j.gaitpost.2010.06.013)

45.senden等人(doi:10.1016/j.gaitpost.2012.03.015)

46.vanschooten等人(2015)(doi:10.1093/gerona/glu225)

47.kasser等人(2011)(doi:10.1016/j.apmr.2011.06.004)

48.此外,服务机器人能够部分以接触皮肤的方式,部分以非接触方式,测定皮肤上或皮肤内的物质。在此,主要采用光谱仪方案。光谱仪或类似于光谱仪的方案比如参见us6172743、us6008889、us6088605、us5372135、us20190216322、us2017146455、us5533509、us5460177、us6069689、us6240306、us5222495、以及us8552359。

附图说明

49.各图示出了:

50.图1示出了服务机器人的示意结构;

51.图2示出了服务机器人的轮子的俯视图;

52.图3示出了服务机器人的管理系统;

53.图4示出了通过2d激光雷达识别座椅;

54.图5示出了通过2d激光雷达识别座椅上的人;

55.图6示出了让一个人运动以便自主坐下的方法;

56.图7示出了将人导航至满足特定标准的座椅;

57.图8示出了尤其通过激光雷达来识别门;

58.图9示出了识别对象前面的固定标记;

59.图10示出了从起身和行走测试所得的运动数据的打标签;

60.图11示出了识别重复的语音序列;

61.图12示出了检测和分析纸的折叠;

62.图13示出了由服务机器人分析写下的句子;

63.图14示出了识别由第三人对服务机器人进行的可能的操纵;

64.图15示出了由第三人进行操纵或协助;

65.图16示出了在考虑到用户障碍的情况下校准服务机器人;

66.图17示出了服务机器人向患者方向移动;

67.图18示出了通过门;

68.图19示出了由服务机器人测定手术患者的老年痴呆风险和术后监控的测试;

69.图20示出了由服务机器人为治疗建议准备数据;

70.图21a)示出了测定患者身上的测量区域;

71.图21b)示出了测量和分析光谱检查;

72.图22示出了输出和分析患者对音序的反应;

73.图23示出了出于诊断目的分析患者的图像识别;

74.图24示出了确保服务机器人显示器的充分的可见性;

75.图25示出了通过查看所显示的数字进行手势识别;

76.图26示出了显示两根手指和探测患者反应;

77.图27示出了由服务机器人来分析情绪;

78.图28示出了分析患者上肢的活动;

79.图29示出了检测患者的咳嗽;

80.图30示出了测定血压;

81.图31示出了自学习识别表面上的湿度;

82.图32示出了在探测表面上的湿度时的导航;

83.图33示出了分析跌倒事件;

84.图34示出了在练习/测试时监控生命体征参数;

85.图35示出了在跌倒风险方面分析人的步态进程;

86.图36示出了移动性测试的进程;

87.图37示出了测定坐姿平衡性;

88.图38示出了测定起身;

89.图39示出了测定起身尝试;

90.图40示出了测定站立平衡性;

91.图41示出了测定站立平衡性和脚之间的距离;

92.图42示出了测定站立平衡/冲击;

93.图43示出了行走开始分类;

94.图44示出了测定步伐位置;

95.图45示出了测定步高;

96.图46示出了测定步态对称性;

97.图47示出了测定步伐连续性;

98.图48示出了测定行程偏差;

99.图49示出了测定躯干稳定性;

100.图50示出了测定跨距;

101.图51示出了旋转测定;

102.图52示出了测定自主坐下;

103.图53示出了骨架模型分析时的信噪比的改善;

104.图54示出了在探测传感器运动时调整图像截取部分;

105.图55示出了导航以在侧面检测人;

106.图56示出了测定训练计划配置;

107.图57示出了架构视图;

108.图58示出了以音频信号为基础的操纵识别;

109.图59示出了与座椅上起身/自主坐下相结合的评分测定系统;

110.图60示出了用于同步人和服务机器人之间的运动的系统;

111.图61示出了用于检测和分析折叠练习的系统;

112.图62示出了用于识别操纵的系统;

113.图63示出了光谱仪系统;

114.图64示出了注意力分析系统;

115.图65示出了用于认知分析的系统;

116.图66示出了用于确定疼痛状态的系统;

117.图67示出了用于血压测定的系统;

118.图68示出了用于测量物质的系统;

119.图69示出了用于湿度评估的系统;

120.图70示出了用于跌倒探测的系统;

121.图71示出了用于检测生命体征参数的系统;

122.图72示出了用于测定跌倒风险评分的系统;

123.图73示出了用于测定人的平衡性的系统;

124.图74示出了用于测定脚位置的系统;

125.图75示出了用于分类旋转运动的系统;

126.图76示出了用于步态分类的系统;

127.图77示出了用于改变传感器的光学信号的系统;

128.图78示出了用于调整图像截取部分的系统;

129.图79用于实现侧面拍摄的系统;

130.图80示出了用于大量关节点的迭代分类器创建系统;

131.图81示出了分析表面上的湿度的进程;

132.图82示出了探测地面上的湿度时的路径规划;

133.图83示出了用于测定脚位置的方法;

134.图84示出了用于测定旋转运动的方法;以及

135.图85示出用于检测人沿一条线的运动过程的方法。

具体实施方式

136.用户这一术语是指使用服务机器人17的人,这个人这种情况下主要由服务机器人17通过所述的装置基本上以传感器的方式予以分析。在此,所述用户可以指上年纪的人,利用服务机器人17对所述上年纪的人进行老年病学测试,但比如在此辅助老年人的亲属或第三人也会与服务机器人17交互,或者为所述上年纪的人进行测试。

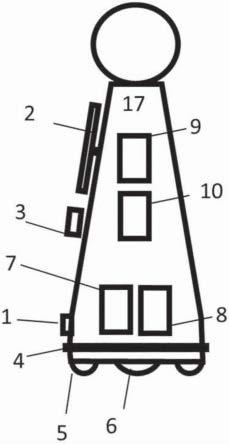

137.图1示出了移动式服务机器人17。服务机器人17具有用来扫描服务机器人17的周围环境的激光扫描仪(激光雷达)1。作为替代方案和/或补充方案,其他传感器在此同样是可行的,比如摄像头(2d和/或3d)185、超声波和/或雷达传感器194。

138.服务机器人17具有至少一个显示器2,其在一个方面是指触控板。在图1示出的方面,服务机器人17具有两个触控板。所述触控板还具有比如麦克风193和扬声器192,它们能够允许与服务机器人17进行声音通信。服务机器人17还具有至少一个用于非接触式三维检测患者的运动数据的传感器3。在非限制性的示例中,传感器是microsoft kinect仪器。作为替代方案,也可以使用orbecc astra 3d摄像头。这类3d摄像头具有一套用于识别深度的立体摄像头系统,它们能够分析患者的骨架模型并且通常也具有rgb摄像头来识别颜色。在一个替代的方面,能够采用传统的单色摄像头。在此,在3d摄像头中能够使用的技术是飞行时间传感器(tof)或者speckle传感器。

139.在离地比如5cm的距离中在服务机器人17外罩周围有压敏推杆4,它至少在服务机器人17可能的行驶方向所在的区域内。处理单元9与压敏推杆4连接并识别服务机器人17与某个物体的碰撞。发生碰撞时,立即停止驱动单元7。

140.服务机器人17在一个方面具有两个驱动轮6,它们相互定心并且平行布置(参见图2)。其周围比如在一条环形轨道上有两个或三个另外的支撑轮5。支撑轮5的这种布置能够通过反向操控驱动轮6将服务机器人17旋转就位。两个或三个支撑轮5的轴线对此如此支撑,从而确保所述轴线能够绕着垂直轴线360度旋转。在使用两个支撑轮5时,驱动轮的距离大于图2所示的距离,由此能够防止服务机器人17过于轻易倾翻。

141.服务机器人17另外还具有电源8,其用于为驱动单元和处理单元9、传感装置(激光扫描仪1、传感器3和推杆4)以及输入和输出单元2供电。电源8是一块电池或蓄电池。当然也能够考虑替代的能量源,诸如燃料电池,其中包括直接甲醇燃料电池或固体氧化物燃料电池。

142.处理单元9具有至少一个存储器10和至少一个接口188(诸如wlan)以用于交换数据。在此,在一个可选的方面包括(未在图中示出)用于读出移动存储器(比如发射应答器/rfid标记)的装置。在另一个方面移动存储器也是可写入的。在一个方面,该接口或另一个接口188(诸如wlan)允许与网络进行无线通信。服务机器人17具有本文后面部分中所描述的用来执行存储器10中所保存的分析的规则。作为替代方案和/或补充方案,这些规则也能够保存在云18的存储器中,服务机器人17通过至少一个接口188(诸如wlan)访问云。在其他位置不必对此详细提及,但在本公开文本中将此内容包含在内。

143.传感器3识别人及其操作,并以人的运动为基础创建骨架模型。在此,传感器3在一个方面也能够识别行走辅助装置/下臂支架(uags)。此外,服务机器人17可选地具有一个或多个麦克风193,它们能够独立于触控板实施,以便记录人的语言并且在处理单元中对其进行分析。

144.图57示出了架构视图,但其隐藏了本文后面部分中所描述的应用。在软件层面上有具备服务机器人17的基本功能的不同模块。在导航模块101中比如包含不同模块。在此,包括2d或3d周围环境检测模块102,它以不同传感器数据为基础分析比如周围环境信息。路径规划模块103允许服务机器人17测定它所经过的自身路径。运动规划器104使用比如路径规划模块103的路径规划结果,并且在考虑或优化不同的成本函数的情况下计算出最佳的用于服务机器人的路段。除了路径规划的数据以外,来自避让障碍物、优选行驶方向等的数据,诸如受监控人的预期的运动方向这些数据也能够作为成本函数来起作用。运动动力学的各方面在此也扮演着重要角色,比如在转弯时速度自适应。自定位模块105使服务机器人17能够确定在地图上其自身的位置,比如通过测距数据,将2d/3d周围环境检测装置检测到的周围环境参数与地图模块107的地图中保存的周围环境参数等等进行比较。绘图模块106允许服务机器人17能够绘制其周围环境的地图。创建的地图比如将保存在地图模块107中,但它也可能包含其他不同于仅仅自身创建的地图。充电模块108用于自动充电。另外能够提供包含房间数据109的数据库,它比如包含应在哪个空间由人进行分析的信息等等。运动分析模块120比如包含运动过程提取模块121和运动过程评估模块122。它们分别包含用于进行运动分析的规则,将在本文后面部分对其进行详细描述。人识别模块110比如包含人身份识别模块111,它比如包含根据检测到的传感器数据确定它是人还是其他物体的规则。用于

虚拟人跟踪的视觉上的人跟踪模块112基本上以作为输入变量的摄像头数据为基础,基于激光的人跟踪模块113相应地使用激光雷达1。人身份识别模块114比如在跟踪过程中断时能够将之后被检测的人按照是否属于之前跟踪的人进行分类。座椅识别模块115允许比如探测座椅。服务机器人17此外具有人-服务机器人互动模块130,其包括图形用户界面131、语音合成单元133和语音分析模块132。另外还有应用模块125,它可能包含大量应用,比如对人进行练习和测试的应用,下面将详细描述这些内容。

145.在硬件层面180上有里程计单元181、用于与rfid发射应答器通信的接口、摄像头185、操作元件186、接口188,比如wlan、电源充电控制系统190、马达控制系统191、扬声器192、至少一个麦克风193、雷达和/或超声波传感器194、探测器195(将在其他位置对其详细进行描述),以及光谱仪196和例如投影装置920。已经对激光雷达1、显示器2和驱动装置7作过描述。

146.图3示出服务机器人17通过接口188与云18连接。治疗医生能够通过终端13使用计算机161访问设于云18中的患者管理模块160,该计算机又与存储器162连接。

147.医务人员能够在患者管理模块160中保存患者数据,或者在一个方面通过接口188(诸如wlan)从其它系统导入这些患者数据。其他系统基本上包括通常在医院或诊所使用的医院管理系统(his)和/或患者数据管理系统。患者数据除包含姓名和患者房间号(如果可用的话)以外,还包括有关常规健康状态的信息。计算机161在患者管理模块160中为每个人生成一个id,它与患者数据一起保存在存储器162中。医务人员能够定义有待执行的测试。管理系统通过云18与调控机构150连接,该调控机构由处理器151和存储器152组成。调控机构150提供用于执行和分析练习的规则,它们与服务机器人17的规则一致并且例如在调控机构中集中维护,并且之后分发给多台服务机器人178。

148.在调控机构150中保存有对象和运动的分类,但也保存有两者的组合,以便在测试层面上分析观察结果。例如,以骨架模型为基础保存有双腿、上肢、手臂、双手等的位置。此外,能够识别应在测试的范围内分析的对象。调控机构150最初能够以模板为基础由本领域普通技术人员创建,即规定各个肢体的边界值。对于边界值,也能够使用模糊算法。替代地,也能够通过医务人员将例如又基于人的图像而被转换成骨架模型的各张图像或图像序列打标签并且然后借助机器学习算法(包括神经网络)来规定映射边界值的分类。

149.在一个方面也存在具有导航计算机171和导航存储器172的基于云的导航模块170。

150.服务机器人17能够与云18中的云应用相关联。治疗医生能够为应执行测试的人分配移动式存储器单元,诸如标签。标签包含患者id和/或分配给人或其自身id的另一个标签id。使用该标签或序列号和/或id,能够在服务机器人17上识别人身份。也能够通过其他方式识别身份,比如通过在屏幕引导菜单中输入登记数据,但也能够通过生物统计学特征,诸如面部扫描或者移动设备上的软件识别,软件已包含输入或者读入到服务机器人17中的代码。服务机器人17现在通过接口188(诸如wlan)从云18相应地下载由医务人员保存的测试,但不包括其个人相关数据——通过人id进行指配。在完成测试之后,服务机器人17将测试数据加密之后加载到患者管理模块160中——通过人id进行指派。患者管理模块160中才对数据进行解密(见下文)。医务人员之后能够分析数据,如通过下面的相应示例详细说明的那样。

151.在另一方面,医务人员能够将用于执行测试或其子组件的请求传输到存储介质上(比如rfid标签形式的发射应答器),人通过获取它以便在服务机器人17上识别身份,为此该服务机器人具有rfid接口183。在此,将从存储介质向服务机器人17传输数据,包括患者管理模块160规定的人id。在完成测试之后,服务机器人17将数据重新传输至存储介质,由此医务人员在读取存储介质时能够向患者管理模块160中传输数据。在一个补充的和/或替代的方面,也能够通过无线或有线接口188(诸如wlan)向患者管理模块160加密传输数据。

152.也能够通过存储介质(或发射应答器)组合上述方案或数据交换。

153.服务机器人具有由摄像头185、激光雷达1和雷达和/或超声波传感器194组成的传感装置,它不仅用于导航用途,还能够用于人检测和跟踪,因此这些传感器与相应的软件模块搭配,在硬件方面构成了人检测和跟踪单元4605,其中也能够使用其他传感装置,比如与惯性传感器5620搭配,该传感器位于需要待检测和/或跟踪的人身上。在人检测和人跟踪方面,首先能够使用人识别模块110,由此根据传感器数据能够识别出人,也能够有不同的子模块。这比如包括人身份识别模块111,它能够识别人的身份。在此,比如保存这个人的表征性特征。通过人身份识别模块114能够重新识别出人,比如在人跟踪中断之后,这能够借助视觉上的人跟踪模块112(比如分析摄像头185的数据)或基于激光的人跟踪模块113(比如分析激光雷达1的数据)实现。能够通过模态比较在人身份识别模块114中重新识别出人,其中比如由保存的人特征得出模态。运动分析模块120允许分析不同运动。首先在运动过程提取模块121中预处理检测到的运动,即提取在运动过程评估模块122中分类和评估的运动特征,例如以便识别特殊的运动。在检测和分析人的运动方面,在此能够在骨架创建模块5635中创建骨架模型,该骨架模型测定人关节处的关节点以及关节点之间的方向矢量。例如在基于骨架模型的特征提取模块5460中以关节点为基础进行特征提取。在本文中列举了多个特殊特征提取模块以及多个特征分类模块,比如能够将它们放到所述的特征提取模块上。在一个方面,这包括同样使用骨架创建模块5635的数据的行走特征提取模块5605,行走特征分类模块5610和步态进程分类模块5615。

154.在所使用的术语方面需要澄清:在一个方面例如提到的手关节点,其代表能够使用一只手的位置,例如当涉及到分析一个人对物体的抓握时,视分析结果而定,也能够包括指关节点,只要能够在检测距离内分析手指。下面提到的是人和用户。在此,能够相对宽泛地理解人,而用户通常是指在服务机器人17上识别出身份的人。但这些术语在许多位置上能够作为同义词使用,区别在识别操纵时尤为重要。

155.在阈值比较方面,该文档有时是指超过阈值,这在之后导致对一种情况的特定评估。此外,能够使用不同计算方法,它们能够部分导致相反地解释分析结果。一个示例是比较用于重新识别人的两个模态。如果为此计算例如相似系数,比如关联度,则高于某阈值的高关联度表示两个人是同一人。但如果各个值之间存在差异,则高差异值表示相反,即高度不相似性。但将这类替代的计算视为关联度初次计算的同义词。

156.使用机器学习方法比如使得确定例如用于运动过程的明确阈值变得多余,这有利于模态分析。换言之,代替来自骨架模型的关节点的专用距离的阈值比较,而是进行同时分析多个关节点的模态比较。如果在下面谈到阈值比较,尤其是在运动过程方面,则在使用机器学习算法时也能够找到一种模态比较方式。作为这类模态比较的基础,比如能够在时间进程内检测例如运动过程的身体姿势正确还是错误,并进行连续分析。以提取到的特征、诸

如关节点为基础,能够创建分类器,之后将该分类器与其他检测到的、规定为正确或错误的身体姿势和由此推导出的关节点的走势进行比较。

157.获取barthel指标

158.服务机器人17能够执行的测试之一是获取barthel指标或者执行barthel测试。通过该barthel测试,以行为观察为基础,对基本自主能力或者护理需求(比如进食和饮水、个人卫生、灵活性和座椅/小便控制)进行估计。为此,服务机器人17被如此配置,从而通过通信装置能够向用户提出有关这些主题领域的问题。用户可能是指待评估的人。作为替代方案和/或补充方案,其他人或者亲属同样能够通过通信装置提出有关这些主题的问题。在此,通过服务机器人17的显示器2的菜单引导或者通过语音界面提出问题。作为安装在服务机器人17内的显示器2和/或麦克风193的替代方案或补充方案,也能够使用单独的、通过接口188(诸如wlan)与服务机器人17连接的显示器2,诸如平板电脑,人能够将其拿在手里,或者放到桌子上,由此能够方便答复和完成练习。通过问题对话在有待对其进行评估的人和例如亲属之间进行区分。作为替代方案和/或补充方案,也能够按照不同的方案区分,比如在有关识别操纵的章节中将对其详细说明。

159.识别坐着应进行定时起身和行走测试的患者的座椅

160.通过服务机器人17执行的测试之一是所谓的“定时起身和行走”测试。在该测试中,待评估的人坐在扶椅中,起身,然后行走三米,以便返回再重新坐下。检测在此用掉的时间,以表格为基础将所述时间转换为评分。

161.服务机器人17使用激光扫描仪1扫描服务机器人17所在的空间,计算与墙的距离,并且在测绘的范围内通过绘图模块106创建一张虚拟地图,该虚拟地图反映了空间的轮廓,但同样在xy面中记录位于激光扫描仪1与墙之间的物体。创建的地图保存在地图模块107中。只要激光扫描仪1不再具备360

°

视线,则服务机器人17则会如此实施行进运动,从而使服务机器人17能够接近360

°

地扫描其周围环境。服务机器人17比如从空间的不同位置实施这一扫描,以识别比如隔开立放的障碍物。如果服务机器人17扫描过一次空间并创建了虚拟地图,则服务机器人17能够通过重新扫描一部分空间重新识别出空间。其他扫描越精确,就能够扫描越多的空间。在此,服务机器人17比如记录其经过的路程并且在此测量距离,由此服务机器人17能够确定其在空间内的位置。与此相补充,也能够通过分析轮子的旋转运动,与其周长相结合,来测量出经过的距离。如果使用摄像头185取代激光扫描仪来创建地图,则能够更方便地确定位置,因为不仅在xy面中能够识别出表征性的尺寸,在z面中也能够识别出表征性的尺寸,由此能够在空间内相较于仅在二维图中进行识别更快速地识别出空间内的独特的尺寸。

162.通过绘图模块106绘制空间地图时也能够使用一个以上的传感器,比如激光雷达1与传感器3的组合使用,其中传感器3为rgb摄像头,它比如能够检测空间中的着色,并且为激光雷达1所记录的xy面中的每个点分配一个色值。对此,服务机器人17的处理单元如此执行图像处理,从而首先为xy面中的每个点分配z轴线坐标,它用激光雷达的倾斜度及其相对于地面的高度表示。rgb摄像头又具有与激光雷达的已知相对位置,以及已知对准角度和已知拍摄角度,由此能够知道例如水平直线在图中有哪一距离,它们距离2m,离地50cm。通过这些参数能够为激光雷达1所测定的每个空间坐标分配rgb图片中的一个像素,由此也确定像素的色值。

163.通过激光雷达1能够确定预计座椅在空间中的位置。图4中描述了识别方法。座椅通常有最多四条腿,其中单腿椅为办公转椅,由于它能够绕着z轴线旋转,因此这种办公转椅不太适合可能有残疾并且年龄较大的人。更为可能的是两腿或四腿椅,其中两腿椅通常是指所谓的悬臂椅。椅腿的突出之处在于,椅腿隔开地立放在xy面中,由此激光雷达1能够在步骤405中识别隔开立放的对象。另外在z轴线恒定时,椅腿在xy面中还具有均匀的横截面积(步骤410)。在此,对象的直径(即潜在的椅腿)处于0.8cm至15cm,或者1cm至4cm之间,并且这在步骤415中确定。可能作为椅腿撑开的对象之间的在xy面中的距离典型地约为40cm,步骤420。四腿椅的椅腿主要以矩形的形式布置(步骤425)。这意味着,相同直径的两个对象指示出存在有两个椅腿的悬臂椅(步骤430)。如果座椅的前后腿彼此间具有相同的横截面积,则它可能属于四腿椅(步骤435)。

164.服务机器人17现在能够以这一特点(两个或四个隔开立放的对象,它们有大致对称的横截面,距离约为40cm,并且大致成矩形布置)为基础为这些对象分配“座椅”属性,并在通过激光雷达1和/或一个或多个另外的传感器创建的虚拟地图中在步骤440中确定座椅的这种位置,在这些位置很可能有一个或多个座椅。此外,在步骤445中为识别出的每个座椅分配一个空间朝向。座椅通常大致与墙平行,通常距墙有一定的距离,该距离在2cm至20cm之间,其中这一距离参照座椅背面。因此,为与墙平行的两条椅腿之间通常距墙40-70cm的线分配“座椅正面”属性,步骤450,正交的两个区域在步骤455中被标识为座椅的“背面”。作为补充方案和/或替代方案,也能够将四腿椅中的距靠近的墙进一步远离的那个面识别为正面。

165.还能够使用2d或3d摄像头185取代激光雷达1来识别座椅。在这种情况下,处理单元通过接口188(诸如wlan)和api向云18中的网络服务发送图像,该网络服务设置用于对图像进行分类,或者处理单元采用保存在服务机器人17的存储器10上的图像分类算法,这一算法能够将在2d或3d摄像头185中创建的图像识别为座椅,其中也包括带有扶手的座椅。有大量算法能够进行这类分类和创建模型,之后能够在云18的网络服务中或者能够在服务机器人17的存储器10中在服务机器人17的2d或3d摄像头185上使用它们,其中这些算法也包括神经网络,比如卷积神经网络。

166.服务机器人17能够独立于座椅识别方式保存座椅位置,比如保存在自身的存储器10中,该存储器与服务机器人17的导航模块101集成在一起,步骤465。此外,服务机器人17检测空间470中的座椅数量,并按照顺时针顺序对座椅数量进行计数。作为对此的替代方案,也能够有其他顺序。座椅按照这一顺序获取一个编号,该编号被作为对象id保存,步骤475。

167.服务机器人17以所述的处理方法为基础,能够绘制空间地图,包括所存在的座椅,即确定座椅在空间中的位置,包括其朝向。但在执行定时起身和行走测试时,需要有一个人坐在座椅之一上,其必要时也能够具有处于座椅附近的行走辅助装置。对于将服务机器人17如此配置,从而服务机器人17使用激光雷达1识别人身份时的情况,采用以下方法:通过图5中的前述方法在步骤505中识别座椅在空间内的位置和朝向。为了识别腿和可能的行走辅助装置,并区分xy方向上横截面中设计的对象,服务机器人17在步骤510绕着座椅所在的位置导航约至少20

°

,比如至少45

°

,理想情况下至少90

°

,步骤510,其中激光雷达1和/或一个或多个另外的传感器向座椅方向定向(步骤515)。在此,服务机器人17保持超过50cm的距

离,比如超过80cm,步骤520。由此,便能够提高预测精度,以识别到服务机器人17的椅腿,并允许得出有人坐在座椅上的结论。

168.如果有人坐在座椅上,则在座椅附近可选地布置有两个另外的对象,步骤525,它们大致成圆形,步骤530,这些对象的直径稍小于4cm,比如小于3cm,步骤535。它们相互之间和/或与椅腿之间很可能有如下距离,这一距离明显不同于椅腿之间存在的约40cm的距离,步骤540。此外,这些距离很可能位于椅腿侧面,步骤545。考虑这些信息情况下,服务机器人17中的处理单元9能够将识别出的对象识别为行走辅助装置,步骤550。如果多数未探测到这些特征,则不会识别为行走辅助装置,步骤585。为此,比如能够使用naivebayes估计法。由于并非每个应完成测试的人都必须有行走辅助装置,因此步骤525-550是可选的和/或不是必需的,以便通过激光雷达1识别座椅上的人的身份。从空间上来看,座椅前腿周围可能有坐在座椅上的人的腿。

169.能够将一条或两条腿放在前椅腿的前方、之间或者前椅腿后方。由此,便形成一个略呈漏斗形的区域,它从座椅中心略呈辐射状向前延伸,直至达到超出两条椅腿连接线最多约50cm,步骤555。对由激光雷达1检测到的数据进行如下分析,从而确保在这一区域内识别到两个(步骤560)大致呈圆形至椭圆形的对象(步骤565),其直径为6-30cm,比如7-20cm,步骤570。双腿也能够放在前椅腿之间或者甚至椅腿后方。两条前椅腿之间的线上的对象越密集,对象的形状就越呈圆形形状,步骤575。如果在最大程度上满足了这些标准,保存在服务机器人17中的调控机构150会以激光雷达数据为基础识别坐在座椅上的人,步骤580。替代地,没有识别出座椅上的人,步骤590。

170.作为激光雷达1的替代方案,通过常规图像分类也能够识别人和行走辅助装置,如例如在前面已经稍微解释的那样。在此,服务机器人17同样会改善预测精度,其方法是服务机器人17从多个位置测定座椅的朝向,由此2d或3d摄像头185能够拍摄座椅,如上一节所述。也能够使用在现有技术中有充分描述的方法(sdk、比如kinectsdk、astra orbbecsdk、openpose、tensorflow的posenet等)取代常规图像分类,以便通过2d或3d摄像头185基于识别骨架来识别人员。

171.服务机器人17根据图6还能够识别空间内人的身份,步骤605,为此能够采用不同的替代性和/或补充性方案:为此,一方面能够使用激光雷达1从不同角度识别两个直径至少5cm,比如至少7cm的横截面,它们并非精确圆形并且其静态距离至少为3cm,或者至少为5cm。作为补充方案或者替代方案,能够基于图像分类通过2d或3d摄像头185识别人的身份,其中比如能够使用前一节提到的sdk。如果在时间进程内在空间中的位置发生改变,则在一个方面有很高的可能性将其分类为人。服务机器人17另外还使用来自现有技术的算法,它们通过传感器(比如摄像头185)的sdk和/或第三方提供商的软件,能够创建人的骨架模型,并在一定时间内进行跟踪,步骤610,比如借助视觉上的人跟踪模块112和/或基于激光的人跟踪模块113进行跟踪。如果识别出一个未坐在座椅上的人,步骤615,则服务机器人17会请求该人坐到座椅上,这比如能够以声学和/或光学的方式进行,步骤620。在此,服务机器人17会跟踪这个人向座椅方向上的运动,步骤625。如果服务机器人17未检测到朝座椅方向的运动,步骤630,服务机器人17会改变其位置,步骤635。这一措施的背景是服务机器人17可能挡住了人的去路,或者必要时传感装置未正确检测到人。如果错误检测到存在一个人,则中断这一过程,替代地则继续(在图6中未示出)。服务机器人17在步骤640中重新请求这个

人坐下。在此,服务机器人17重新跟踪运动,步骤645,比如借助视觉上的人跟踪模块112和/或基于激光的人跟踪模块113来重新跟踪运动。如果服务机器人17在步骤650中没有发现朝座椅方向的运动,则服务机器人17会重新请求这个人坐下,但请求的程度更高,比如通过发出增加的语音输出音量、替代的语音输出、视觉信号等,步骤655。再根据朝座椅方向的运动来跟踪人,步骤660。如果之后假设未发现朝座椅方向的人的运动,步骤665,则服务机器人17通过接口188(诸如wlan)向计算机发送一条信息,计算机通过显示器2与医务人员互动,并且请求医务人员向服务机器人17移动,并且为该服务机器人17提供支持,步骤670。在一个替代的和/或补充的方面,服务机器人17能够检测人探测的程度,即服务机器人17使用内部规则来测定检测质量,比如与检测阈值的偏差,以此为基础来测定服务机器人17向人发出的请求次数。

172.由于在空间内有超过一个可能有人坐的座椅,而且并非每个座椅前面都有足够的空间能够经过必要的3m距离,因此服务机器人17具有一套校正机制。这套校正机制规定,服务机器人17从识别到的座椅量(步骤705)中识别出在其前方朝向座椅正面的垂直方向中有无障碍的自由面,其长度至少为3.5m,比如至少为4m,步骤710。如果在座椅前面有用于执行测试所需的相应的自由面,则将这一特征作为属性保存在服务机器人17的存储器10中,步骤715。在将用户导航至座椅时使用这些信息,或者通过这些信息确保座椅上有人坐着,该座椅适合通过座椅前面的充足空间执行测试。作为对此的补充方案和/或替代方案,也能够通过地面标记识别座椅,例如在下面的某些章节中识别这些地面标记。

173.为此,服务机器人17在请求(站着的)人坐下时,能够在步骤720中向站着的人指示出恰当的座椅。服务机器人17也能够请求该人重新起身,然后坐到另一个座椅上,步骤725。在一个方面,在步骤730中详细识别该座椅。为此,服务机器人17使用对象id和定位座椅的顺序。此外,在服务机器人17的存储器10内存在例如有人坐在6号座椅中,但4和7号座椅符合条件来执行测试的信息,因为在它们前面有足够的空间。服务机器人17能够在发送给人的请求中实现,聚合人自己能够坐到服务机器人17左侧的座椅或两个位置上的,或者服务机器人17右侧的一个位置上的信息。在这种情况下,服务机器人17能够基于在被人和服务机器人17占据的空间中的朝向来如此校正这类信息,从而确保输出的信息与人的朝向或视角有关。在所述的示例中,它们是人右侧的两个位置或者左侧的一个位置。与此类似,服务机器人17也能够使用站立的人的坐标以及恰当的座椅的坐标,以便指引站立的人坐到该座椅上,或者以“请您坐到您斜左侧的座椅上”的方式进行指引,必要时指定距离。在一个补充的和/或替代的方面,在此也能够包含座椅的颜色信息,之前比如能够通过rgb摄像头获取它们。

174.如果座椅是空的并且服务机器人17未在空间内识别到人,但服务机器人17收到了使用座椅对人进行测试的指令,则服务机器人17比如会以距座椅超过一米的距离进行定位。在一个方面,服务机器人17具有经由其导航模块101的信息,其指示患者从哪个方向接近。这些信息一方面已经能够明确保存在系统中。

175.在一个附加或者替代的方面,服务机器人17能够识别门或通道。在门关着的情况下,墙内有至少1cm的错位,它与墙面垂直地朝向,步骤805,而在垂直方向上错位的距离超过77cm,比如超过97cm,但小于120cm,步骤810。作为对此的补充方案或者替代方案,它属于距离数cm的双错位,其中内部距离达到提到的约77cm,最好约为97cm。在这些信息的协助

下,尤其能够通过激光雷达1识别出关着的门。在门开着的情况下,服务机器人17通过激光雷达1识别到在xy方向上在约77-97cm的长度(步骤815)和与边缘成1-178

°

的角度(步骤820)、在时间进程内有能够变角度(步骤825)下接近边缘之一的平面,和/或在识别到的开口后方有至少90cm的距离在地图中没有xy面的其它限制,步骤830,该地图由服务机器人17比如通过激光雷达1来绘制。

176.在2d或3d摄像头185的情况下,一方面又能够采用基于表征性门特征曲线学习的算法。另一方面也能够如此处理来自z方向的信息并且必要时与来自xy方向的数据组合,如果在xy面中被识别为可能的门或通道的区域有1.95-2.25m的高度限制,则这些信息有助于以更大的机率识别出通道。作为对此的补充方案和/或替代方案,也能够包含涉及门把手的对象信息。

177.针对座椅未被占用的情况,服务机器人17通过其导航模块101基于门或通道的所测定的位置以及座椅的位置、例如通过测定欧几里何距离来创建座椅和门或不被障碍物挡住的通道之间的直接路径。服务机器人17定位在该路径以外,比如在空间上如此朝向,从而其传感器能够告知座椅和/或门/通道。

178.如果服务机器人17识别出进入空间的人,则服务机器人17将如上所述请求他坐到座椅上。

179.如果现在座椅上有人,服务机器人17将通过输出单元,比如扬声器192,作为替代方案和/或补充方案,也能够通过显示器2,请求人起身,直行三米,然后再重新返回到座椅上。

180.服务机器人17能够通过2d或3d摄像头185识别地面上的距离标记,为此使用常用的模态识别方法。服务机器人17第一步骤中先使用识别到的座椅的位置信息。为了确保它是距离标记并且例如不是正常的地板图案,服务机器人17首先通过其导航模块101测定空间中与座椅的正面大致垂直相距3m的位置。随后,将扫描大致位于该位置的地面区域,以识别这种标记。将扫描其他地面区域,以识别图案是唯一的还是重复的。如果它是唯一的,或者是保存在服务机器人17的存储器10中的(如果适用的话),则将该图案作为3m点标记使用。

181.固定地面标记的一个缺点是在空间中进行清洁工作时,坐在座椅上的人等能够不同程度地移动座椅。因此在一个补充的和/或替代的方面,服务机器人17配备有投影装置920,用于以3m的距离从座椅正面向垂直方向投影标记。再通过比如导航模块101来测定座椅和3m点的xy坐标,其中事先通过根据座椅位置由服务机器人17更新该导航模块101。为此,能够使用光源,比如激光器或led,它们又能够通过透镜或具有类似功能的工具进行聚焦。该投影装置920能够向地面上投影一个面,投影成条柱,必要时含信号请求人应向那里移动的字符。投影装置920在一个方面(参见俯视图9a)至b))独立于服务机器人17可移动地布置,由此服务机器人17比如能够通过自身的旋转运动在正面始终向人910方向定位(如线940所示),而投影的标记915始终位于与座椅正面905垂直的相同位置上。在此,投影装置920的光源本身在一个方面可移动地布置,在另一方面反射镜,比如微形反射镜或微型结构的元件,确保对于光的这种控制,从而该光比如在服务机器人17运动、例如旋转运动时保持在相同位置上。由此,时间点a)和b)之间的角度在人910向标记915方向移动时变化,这包括线条925和935以及930和935之间的角度。在一个替代的和/或补充的方面,服务机器人17同

样能够平行于人的行进方向移动。

182.在另一方面(图9c)至d)),光源能够投影到地面的一个面上,从服务机器人17的角度看,其宽度超过3m。由此,该投影装置920便覆盖了人应从座椅开始走过的路段。在此,投影装置920的中心轴线从摄像头185的中心轴线开始参照服务机器人17的z旋转轴线,旋转10

°

至60

°

的角度,比如20-50

°

的角度,即朝向从服务机器人17开始人应移向的方向进行旋转。如果例如在座椅上有人,该座椅位于服务机器人17左侧,而3m点位于服务机器人17右侧,则投影标记(比如条柱)在3m点位置,从服务机器人17看去,其在投影面的右边缘。将服务机器人17向固定的3m点方向旋转之后,投影标记将移向投影面的左边缘。在此,比如能够采用投影装置920,它位于传统的(lcd)数据和视频投影机内,在其中在软件方面如此操控矩阵,确保投影面的不同区域有不同程度地被照亮。如果坐着人的座椅在服务机器人17右侧和3m点左侧,则相应地按照镜面相反方式进行朝向。图9c)中,人915坐在座椅905上。投影装置920能够照亮由虚线矩形构成的面。3m点标记915在右侧区域内。通过旋转服务机器人17,投影面顺时针与服务机器人17一起移动,在此将3m标记保持在固定的xy坐标上,这意味着,3m标记向投影面的左侧区域移动(图9d))。在此,所述的图示假定了固定投影方向920。在一个替代的和/或补充的方面,投影装置920可移动地布置(未详细示出效果)。

183.作为对此的替代方案,服务机器人17不旋转并且通过激光雷达1和/或2d或3d摄像头185检测超过人必须经过的完整路段(参见图9e),其中传感器检测到的最小区域至少为虚线。在另一方面,2d或3d摄像头185采用可调整布置方式,而投影装置920或光源采用刚性布置方式或者同样采用可调整布置方式(未单独示出)。

184.服务机器人17中的处理器以服务机器人17的导航模块101的坐标、投影装置920的倾斜度及其高度为基础计算投影面,由此能够事先测定座椅的、3m点的和服务机器人17的位置,以便投影到完成练习的人看来在最大程度上不失真的条柱,它与座椅正面大致平行。根据实施方案而定,标记的形状也能够不同。

185.如在现有技术中所充分描述的那样,借助视觉上的人跟踪模块112和/或基于激光的人跟踪模块113能够跟踪人。为此,服务机器人17同样检测上肢的姿势,以识别人何时开始站起。从这一时间点开始,同样检测这个人完成这项测试所需的时间。当人返回到座椅之后旋转再重新坐回到座椅时,计时结束。通过算法将旋转运动识别为模态,由此通过人的关节点能够生成骨架模型,手臂在旋转运动中能够与平面大致平行,这个平面与有待经过的路段一致。在一个方面,在时间进程中分析手臂的关节点,并且测定对称存在的关节点与连接起始位置和换向位置的直线超过160

°

的角度变化。

186.在一个替代的和/或补充的方面中,服务机器人17被如此配置,从而服务机器人17在走完一个路段时测定患者在此所经过的距离。由于起始位置和换向位置相距3m,走过的路段的在座椅到达起始位置时开始和结束的长度为6m,它同时也是结束位置,换向位置距离座椅3m。在此,服务机器人17不必检测地面上的标记。能够通过不同方式测定走过的路段距离,其中也包括累加步长。这可以基于踝关节或踝关节的距离,通过2d或3d摄像头185与在此使用的分析框架组合识别这些踝关节或踝关节,在三维空间内分配其点,通过服务机器人17例如以矢量的方式测定其距离。作为替代方案和/或补充方案,通过累加患者经过的坐标点之间的欧氏几何距离能够确定患者走过的路段,也能够根据患者和服务机器人17所在的周围环境地图来测定坐标点,其中能够根据参考位置来测定患者的坐标。在此,包括与

识别出的空间界限的距离或者服务机器人17的位置,能够通过自定位(自定位模块105)确定所述位置。

187.在比如借助视觉上的人跟踪模块112和/或基于激光的人跟踪模块113跟踪患者期间,服务机器人17计算走过的距离,根据与患者必须走过的总距离设置这一走过的距离。服务机器人17能够通过输出装置,比如显示器2和/或语音合成单元133向患者反馈他还必须走多远,还需要走多少步,患者什么时候能够旋转等。

188.服务机器人17以检测到的时间为基础,基于调控机构150的保存在存储器10中的参考数据来传输评分。服务机器人17能够通过接口188(诸如wlan)向云18中的患者管理模块160传输评分和/或检测到的时间。

189.如图10所示,在一个方面,服务机器人17能够利用其传感器3在步骤1005中检测运动,将这些运动在步骤1010记录为视频,在步骤1015进行保存,并且在步骤1030通过接口188(诸如wlan)向云18中的云存储器进行传输,该云存储器位于调控机构150内。以加密方式进行数据传输。事先将待评估的面部特征打上马赛克,由此人能够保持匿名,步骤1025。在调控机构150内为打标签目的而提供了视频材料,以便借助自学算法继续改进调控机构150的参考数据。为此目的,能够通过终端1030访问所保存的数据,由此医务人员能够鉴定拍摄的视频并对其打标签,步骤1035。在此,打标签是指手动对人的身体姿势进行分类,比如人坐到座椅中,人站直,人向前或向后移动,人旋转等。针对这些由视频序列得出的事件,能够为时间点分配标签。在此,例如对运动的起点或端点做时间上的标记,并且同时将运动、诸如描述肢体部位例如在时间进程中的朝向的身体姿态之类的运动进行归类/分类。随后,将例如以这种方式打标签的数据保存到数据库中,库存数据同样保存在该数据库中,步骤1040。随后,调控机构150能够通过算法、诸如神经网络来自主改进分类规则。改进基本上以两种方式实现:a)检测之前尚未描述的情况,因为它们偶尔出现,以及b)提高事件数量。由此,这两种方式在所执行的分类的范围内能够进行更精确的权重估计,步骤1045。在此,对由患者身体姿势得出的矢量空间、其运动等进行相应的分配,由此能够更方便地估计待评估的人的姿势。在此,包括从座椅上起身、走路、旋转以及重新自己坐下。为了更好的分类,新权重保存1050在调控机构150中并且通过接口188(诸如wlan)以升级方式向服务机器人17传输。

190.图59对用于检测和分析起身和自己坐到座椅上的运动的系统总结如下:该系统包括处理单元9、存储器10和至少一个用于非接触地检测人的运动的传感器,其中系统的存储器10中有座椅探测模块4540、输出装置(比如扬声器192)和/或用于传输指令的显示器2、用于测定用于所走过路段4510的持续时间的持续时间-路段模块和/或用于测定被检测的人在路段上的速度的速度-路段模块4515以及用于评估人在路段上的速度和/或用于走过路段所花时间的持续时间-路段评估模块4520。此外,该系统还可具有用于执行听力测试的听力测试单元4525、视力测试单元4530和/或精神能力测试单元4535。该系统可用是服务机器人17。在一个方面,该系统具有投影装置(920),例如以便投影显示旋转点的标记和/或起点。在一个方面,该系统具有人识别模块110、人身份识别模块111、跟踪模块(112、113)、运动分析模块120、骨架创建模块5635和/或基于骨架模型的特征提取模块5640。

191.简易心理测试

192.简易心理测试:会话练习

193.此外,如此配置服务机器人17,从而服务机器人17能够执行简易心理测试。简易心理测试的目标是识别认知限制,比如老年痴呆。在测试的范围内,通过服务机器人17的通信装置(语音输入和输出,显示器2)向患者提出问题,患者能够通过服务机器17的通信装置回答这些问题(比如以语音输入、以屏幕上有候选择的答案、以徒手输入,比如日期、居住地等形式)。针对这种执行,一方面能够使用服务机器人17的显示器2,另一方面也能够使用单独的、通过接口188(诸如wlan)与服务机器人17连接的显示器2,诸如平板电脑,人能够将其拿在手里,或者放到桌子上,由此能够方便回答和完成练习。

194.所述服务机器人17被配置为使得服务机器人17能够与人通信,如在图11中所述的方法所揭示的那样。为此,在一个方面,服务机器人17能够如此在空间内对准,使服务机器人17的显示器2与轴线大致平行,该轴线延伸穿过用户的双肩、髋和/或膝并且延伸经过骨架模型,借助2d或3d摄像头185及其sdk识别到该轴线。由此,服务机器人17与用户对准,步骤1105。与用户交互的范围内,通过扬声器192播放保存在存储器10中的至少一个语音序列,并且能够通过显示器2和/或语音输出请求用户复述播放的语音序列,步骤1110。在作出所述请求后,服务机器人17通过麦克风193记录用户的声音信号,步骤1115,并且确切而言比如与所输出的复述的语音序列那样长地进行记录,步骤1120。与下面的步骤一样,这通过语音分析模块132实现。服务机器人17分析时间范围内信号的幅度,步骤1125。如果幅度下降至零或接近零(比如小于幅度最大值的90%)超过1秒,比如超过2秒,则结束记录,步骤1130。继续进行采样,其中通过幅度接近零超过1秒并且长度至少为用户应复述的和保存在服务机器人17内的语音序列的70%的相位来定义采样宽度,步骤1135。以这种方式能够确保检测并单独分析用户的多次语音尝试。服务机器人17在时域内或者频域内比较样本,并且在考虑到在音频技术领域常用的方法、尤其是交叉关联性的情况下,来计算相似性值,步骤1140。如果在此例如相似性值低于阈值,步骤1145,则在一个替代性或补充的方面,服务机器人17能够重新请求用户复述语音序列(连接1145=》1110)。如果相似性值超过特定的阈值,则服务机器人17会修改服务机器人17的存储器10内的数据库中的与用户有关的值,步骤1150。保存由用户发出、记录的语音信号,步骤1155,并且与修改后的来自数据库中的值一起通过接口188(诸如wlan)传递给患者管理模块160,步骤1160。在一个补充的或替代的方面,只将由服务机器人17记录的语音序列及模态序列的最高的相似性值保存起来。系统此外计算复述尝试次数,并且如果尝试次数超过某一阈值,则中断记录相关的复述尝试,转至下个有待复述的语音序列。同样,还在数据库中备注用户的多次复述尝试或已失败的复述尝试。

195.简易心理测试:折叠练习

196.简易心理测试的练习包括取纸,纸的折叠和放下纸/让纸落下,如图12所示。为此目的,移动式服务机器人17具有可选的装置,该装置包含有待评估的人比如根据服务机器人17的请求在测试中能够拿取的纸。替代地,移动式服务机器人17也能够提醒待评估的人在执行测试的空间内有这类纸。为此,语音输出和/或显示器2的输出单元经过相应配置,步骤1205。

197.如此配置服务机器人17,从而能够通过呈3d摄像头,比如飞行时间摄像头(tof)的实施方案的传感器3来识别、检测和跟踪用户的双手,即在第一步骤中识别双手,步骤1210,并且在第二步骤中在这个人在折叠纸时跟踪双手,步骤1215。也能够采用以各个2d摄像头

为基础识别双手(步骤1210)、跟踪(手)运动(步骤1215)的方案来取代tof摄像头,以识别相应的姿势或经折叠的纸,步骤1220。在此,权重比如来自于一个借助常规机器学习方法,比如回归法和/或神经网络、诸如借助卷积神经网络来分类的模型。为此,事先要拍摄大量折叠运动,打标签,并且从常规算法中学习。作为替代方案和/或补充方案,也能够通过2d摄像头以架构为基础创建骨架模型,比如将openpose或posenet与tensorflow相结合来创建骨架模型。

198.在这一时间内比如借助视觉上的人跟踪模块112和/或基于激光的人跟踪模块113来检测运动。在此,在第一步骤中识别双手,步骤1210,根据整体拍摄对它们进行分段。在第二步骤中通过分段识别双手中的物体,步骤1220,比如通过能够允许模态识别的容错分段算法(比如ransac架构)。通过在现有技术中充分说明的跟踪方法检测时间进程中的运动,步骤1215。在此,开始时手中还没有纸。然后,用户拿起一张纸,将其折叠,然后再将纸移向负z轴方向,即朝地板方向移动。在最后一次纸运动时,用户的一只手或双手不必介入。比如通过纸分类来测定纸,即事先通过拍摄纸并将图像打标签创建的摄像头185的二维或三维数据。纸这个术语涵盖了纸和在练习时有相等效应和/或类似尺寸以及可能与一张纸具有相同特征的材料。

199.服务机器人17在练习开始时请求用户拿起一张纸,步骤1205。为此,利用服务机器人17的扬声器192例如进行语音输出。作为补充方案或替代方案,也能够使用显示器2上的显示或者两种方式相结合。从请求时间点开始使用比如针对纸的对象识别。服务机器人17类似地请求用户比如在中间位置折叠纸,步骤1225。在此,服务机器人17会观察折叠过程,在折叠过程结束之后,服务机器人17会请求用户放下纸或使其落下。作为补充方案或者替代方案,也能够在之前请求进行同一练习之后直接发出有关折叠和/或放下或使其落下的信息。

200.在一个方面,使用3d摄像头,比如kinect或astra orbbec。在识别手的各个元素,即手指和由此推导出的手指跟踪(步骤1230)时的挑战在于,摄像头185的视线可能被各根手指遮挡,进而无法直接进行估计。对于在手里没有物体时执行的姿势而言也是如此。在另一方面,如果用一只手或多只手进行纸的折叠,则视折叠过程类型而定,同样会遮挡一部分手指。能够根据手指运动(步骤1235)例如来由此识别折叠过程或将其分类为折叠过程,比如至少一根大拇指和同一只手的至少一根,最多多根手指在指尖高度上触碰,步骤1240,即比如检测和跟踪到例如至少两根手指。替代地,用一只手的一根或多根手指触碰另一只手的一根或多根手指,比如在指尖的区域内,步骤1245。在任何情况下,纸被至少一根手指接合,步骤1250。比如在这些手指之间有如在下一节中所述那样来识别的纸。

201.该系统和方法是对识别纸及其形状变化的替代方案和/或补充方案(步骤1252),其中该纸与至少一根手指接触,或者与其接合。在此,在一个方面,识别处于用户的一只或两只手中的一张纸的四个拐角,步骤1255。在此,在时间进程中单独跟踪每个拐角,步骤1260,并且测定拐角之间的距离,步骤1265。在此,例如通过以下方式识别成功的折叠:a)在三维空间中各两个拐角的距离降低了超过90%,比如降低了超过98%,步骤1270。作为替代方案和/或补充方案,也能够跟踪纸的两个对边之间的距离,并且如果距离小于所指定的值,则识别到折叠过程。作为对此的补充方案和/或替代方案,(b)根据其弯曲来跟踪纸的表面,步骤1275。为此,折叠模块分别测定两个拐角1277之间的中心,并监控(跟踪)纸例如在

这一区域内的弯曲,步骤1279。在这种情况下,通过以下方式识别到成功的折叠,步骤1280:即,在时间进程中这一区域内的弯曲增加,步骤1282,而拐角附近的纸边/边缘略为平行,步骤1284(尤其是经折叠的拐角),并且纸边的距离大幅下降,步骤1285,比如下降至距离小于2mm,由此通常不再需要单独检测两个大约相同大小的纸部分,因为摄像头185的深度分辨率由于纸更薄而无法检测两张叠放的纸。作为对此的补充方案和/或替代方案,(c)在时间进程中也检测纸在三维空间内的面积,其中无法探测或者只能较差地探测纸的小于2mm的深度。通过时间进程中纸的面积下降超过40%,比如约50%来确定纸的折叠。例如也能够在不明确地分析和跟踪手指的情况下来实现这一方案。作为对此的替代方案和/或补充方案,(d)检测和分析相互平行的纸边缘的两端的距离,步骤1293,并且当纸两端相互间的距离小于20mm时,识别到折叠,步骤1294。通过两种或这三种检测变型方案中的组合,能够总体提高检测精度。如果这一练习成功结束,即折好纸,并且之后向地心方向移动,步骤1295,也替代地安放在一个平面上,步骤1297,将在数据库中备注这一点,步骤1299,尤其是在保存测试结果的数据库中备注这一点。

202.总之,图61示出了用于识别折叠练习的系统,比如服务机器人17:该系统包括处理单元9、存储器10和用于非接触地检测人的运动的传感器,比如2d和/或3d摄像头185、激光雷达1、雷达和/或超声波传感器194以及其存储器10中的多个模块。这包括纸探测模块4705、用于测定纸的折叠运动的折叠运动识别模块4710、用于创建人的骨架模型的骨架创建模块5635、用于探测纸的边缘和/或拐角的距离的纸距离拐角边缘模块4720、用于探测纸的形状变化的纸形状变化模块4725、用于探测纸的弯曲的纸弯曲模块4730、用于探测纸的尺寸的纸尺寸模块4740和/或用于探测纸边缘的朝向的纸边缘朝向模块4745。此外,存储器10包括用于探测至少一只手指尖的距离的指尖距离模块4750和用于探测纸的纸探测模块4705,比如该纸探测模块由用于探测纸的纸分段模块4755和/或用于纸分类的模块4760组成。此外,该系统还有输出装置,比如扬声器192和/或显示器2以用于传输指令,并且该系统还具有通向终端13的接口188。在一个方面,该系统具有人识别模块110、人身份识别模块111、跟踪模块(112、113)、运动分析模块120、骨架创建模块5635和/或基于骨架模型的特征提取模块5640。从进程开始检测、识别和跟踪一个人的至少一只手;检测、识别和跟踪一张纸,并且共同将检测到的纸的尺寸、形状和/或运动和手元素识别为折叠过程。在一个方面,还通过容错分段算法和比如纸分类和/或基于二维或三维模态(包括形状模态和/或运动模态)进行的折叠过程的分类来识别纸。

203.简易心理测试:句子练习

204.在测试的范围内,服务机器人17还能够请求用户自发地想出一个句子,在对其分析时拼写和语法是不相关的,但句子必须包含至少一个主语和一个谓语。为此,服务机器人17通过通信装置(显示器2;扬声器192)请求待评估的人自主想出一个自发的句子,步骤1305,并且用手指将该句子写到服务机器人17的触控板上,步骤1320。这能够通过显示器输出1310或语音输出1315进行。在第二方面,服务机器人17为此提供了一只笔或类似于笔的物体,步骤1320。在第三方面,准备人能够使用的笔和纸,以便写下句子,步骤1325,并且服务机器人17通过通信装置请求人将写好的纸放在服务机器人17的摄像头185前面,步骤1330,对其进行记录,并保存到服务机器人17的存储器10中。为此,传感装置(2d、3d摄像头185)跟踪用户运动1335,比如借助视觉上的人跟踪模块112和/或基于激光的人跟踪模块

113来进行跟踪,利用纸的内部对象识别(参见前述方案)并且识别用户将纸放在服务机器人17的2d摄像头前面,步骤1340,并且服务机器人17识别该服务机器人17使用2d摄像头所拍摄(步骤1350)的纸(步骤1345)。

205.在下一个过程步骤中,对图像中包含的句子进行ocr处理,步骤1355。在此,服务机器人17的处理器使用已经创建好的相应的数据库,以便处理能够进行ocr处理的图像或文本。视具体的方面而定,能够在云中进行这类数据处理。在下一步骤中将使用自然语言解析器1360,以便确定在句子中存在主语和谓语。为此,在第一步骤中将检测到的句子分解成单个的单词(分词),步骤1365。随后,形成单词的基本形式(词干化和/或词法化),步骤1370。随后,进行pos标记(词性),通过它将单词分类为主语、谓语、宾语等,步骤1375。在此背景下,也能够使用基于神经网络的方案。为此,能够使用nltk或spacy等工具包。在步骤1380中将结果保存到存储器中,并且在下个步骤1385中进行比较在用户给出的句子中是否出现了主语和谓语。在这种情况下,在数据库中保存成功完成了练习(步骤1390)。

206.简易心理测试:五边形练习

207.另一个测试元素包括绘制两个重叠的五边形。为此,在一个方面让待评估的人能够在显示器2上进行绘图,该显示器位于服务机器人17上。在第二方面,显示器2在服务机器人17和用户所在的空间以内能够自由移动,但通过接口188(诸如wlan)与服务机器人17无线连接。在此,能够用手指或者借助适用于平板电脑的笔进行绘图。在第三方面,能够在一张纸上完成绘图,其中由服务机器人17通过通信装置请求绘图的人将画完的图画放到服务机器人17的摄像头185前面。摄像头185拍摄图片。就此而言,这些过程与图13中在1305至1350中所述的过程类似地进行,区别在于在此不涉及应写下的句子,而是涉及绘制五边形。

208.由计算机将检测到的图片与保存在数据库中的图片进行比较,其中使用调控机构150将图片的特征与分类后的图片的特征进行比较,基于概率进行指配。对于分类机制而言可以采用在现有技术中有过描述的和之前基于自动化的练习来创建的、基本上是使用神经网络方法来创建的方法。替代地,也能够使用不经练习创建的分类机制,其分类特征基于五边形的表征性的特征,以定义的规则(诸如角和线的数量)的形式来确定重叠五边形的特征。这比如考虑到经倒圆的边缘、不直的线条走向和不构成封闭五边形的线条。在这类分析的范围内,能够使用平滑方案来简化分类。如果在由服务机器人17记录到并保存在调控机构150中的比较模型或两个重叠的五边形的识别规则之间的相似性比较(比如关联度)中达到某一阈值,则在数据库中保存已成功完成了练习。

209.操纵识别

210.服务机器人17包括用来在完成练习时识别被第三人操纵的功能。为此,用来分析用户及其各项活动的传感装置能够检测在空间内是否有其他人,步骤1405。在此,将分析在测试期间是否有人(包括用户)在空间中如此定位,从而其可能对服务机器人17进行操纵,即其是否处于距服务机器人17的所谓“临界距离”内,步骤1410。操纵在一个方面也包括在服务机器人的显示器2上输入数据。在此,测定人距服务机器人17的距离,并且之后通过下面三种方式中的至少一种确定人是否足够靠近服务机器人17定位,以便能够在必要时进行输入(尤其是在显示器2上):a)假定总计的距离值,比如75cm。如果小于该值,则服务机器人17假定能够操作显示器2(步骤1415)。作为替代方案和/或补充方案,也能够探测人的手和/或手指距服务机器人17的距离,其中假定可能操纵的距离短于人本身所处的距离。b)通过

骨架模型来测定人的臂长,步骤1420,尤其是通过测定肩关节点与手关节点或者与指关节点之间的距离。如果小于该距离,则服务机器人17会假定能够操作,步骤1425。c)通过由服务机器人17测定的人的尺寸(步骤1430)得出平均臂长,步骤1435(比如将其保存在存储器10中),并且一旦小于该距离,则假定能够操作/能够操纵,步骤1425。作为这三种方案的补充方案,服务机器人17能够计算人在空间内相对于显示器2的位置的定位(步骤1440)。如果肩膀、髋关节等的对准或者由此推导出的人的正面与显示器2大致为平行或者呈小于45

°

的角度,并且这个人已在显示器2的方向上对准,比如由人的初始的运动方向、手臂的、头的、膝的、脚的姿态以及面部特征等得出这一结果,由此能够提高与显示器的交互概率。取决于服务机器人17的传感装置的朝向,这套方案也能够针对服务机器人17的其他元件而非显示器2来实现,比如关闭按钮。在这种情况下不考虑与人有关的显示器2的屏幕,而是考虑与操作元件186的对称轴线正交、朝向服务机器人17中心朝向的虚拟屏幕。在可选的第二个步骤中,传感装置分析是否由用户或第三人进行了服务机器人17的输入或操纵,步骤1450。如在现有技术中一般性而言所描述的那样,为此服务机器人17基于表征性的特征(比如基于身高、肢体尺寸、行走特点、比如其衣物表面颜色和纹理等)来跟踪其周围环境中的人,比如借助虚拟人跟踪模块112和/或基于激光的人跟踪模块113来跟踪其周围环境中的人,步骤1445。通过服务机器人17处进行的识别来区分用户和第三人,其中假定识别的人为用户。这通过在显示器2上观察输入内容,借助服务机器人17的光学传感器实现。总之,在此能够通过测定人的正面和垂直位于服务机器人17的操作元件186上的轴线之间的分别投影到水平平面中的角度来测定人相对于服务机器人17的朝向,并且将测定的角度与阈值进行比较,其中低于阈值包括探测到增加的操纵概率。在一个方面,人能够在服务机器人17上登录并检测和保存人的身份特征,例如在这之后能够检测和跟踪人,检测人的身份特征,将检测到的身份特征与登录时保存的人的身份特征进行比较以及与阈值进行比较,其中在此将比较相似性,并且阈值暗含最小相似性。在此,如果该值低于阈值,将探测到增加的操纵概率,如果超过阈值,则将探测到更低的操纵概率。最后能够将测定的操纵概率相乘,以便测定操纵评分,例如在由机器人执行分析之时或者之后将其与被检测的人和分析结果一起保存起来。取决于比较方式,也能够进行其他交互,如开头所述。

211.图62示出了用于识别操纵的系统的一个方面。该系统或服务机器人包括处理单元9、存储器10和用于非接触地检测至少一个人的运动的传感器,比如2d和/或3d摄像头185、激光雷达1、雷达和/或超声波传感器194。系统包括其存储器10包含规则的模块。这比如包括通过至少一个在该系统的周围环境中探测到的人实现的操纵尝试探测模块4770、人身份识别模块111、用于测定至少人与服务机器人17的距离的人-机器人距离测定模块4775、用于测定至少一个人的尺寸、臂长和/或朝向的尺寸-臂长朝向模块4780,和/或用于比较是否是被系统识别出身份的人比如通过操作元件186在系统上进行输入的输入登记比较模块4785。此外,该系统比如还包括输出装置,比如用于传输指令的扬声器192、显示器2,和/或通向终端13的接口188。在一个方面,该系统具有人识别模块110、跟踪模块(112、113)、运动分析模块120、骨架创建模块5635、基于骨架模型的特征提取模块5640和/或运动规划器104。

212.为了排除第三人仅按照用户的指令进行输入,通过现有的麦克风193对人之间的口头交流进行分析(在图14中),步骤1455。为此,在服务机器人17的周围环境内通过至少一

个集成的麦克风193记录语音信号,步骤1560。通过两种替代性或补充的方式比如同样在语音分析模块132中实现语音来源的识别。为此,一方面能够对唇部运动进行视觉分析,首先对这些唇部运动进行识别,步骤1565,然后进行跟踪,步骤1570,并且之后与由服务机器人17记录的语音信号进行时间同步,步骤1575。为了识别唇部的说话运动,采用了来自现有技术的图像识别和跟踪方法。由此,这使得服务机器人17能够识别登录的语音来自于谁,它们是否与应执行练习的用户一致,其中比如当服务机器人17识别到用户身份时,能够检测用户的语音。在相反情况下,可能存在操纵,步骤1580。这一方案的劣势是必要时仅仅难以检测甚至无法检测其身体姿势不朝向服务机器人17的第三人的唇部运动。回避这一问题的第二种方式包括安装在服务机器人17的不同位置上并且通过多条通道在时间进程和频率进程中记录的多只麦克风193的音调分析(步骤1480),其中服务机器人17的处理器进行运行时间分析,步骤1485,并且由信号出现的时间偏差计算这些信号来自哪个人,步骤1490。作为替代方案和/或补充方案,也能够使用麦克风193,其中在这种情况下能够通过变换服务机器人17的位置进行三角测量。为此,比如通过三角测量计算出的时间偏差,关联时间进程,确定在房间中的原点(这可以二维地或三维地进行)。然后,将该原点与通过在房间中定位通过2d或3d摄像头185或者激光雷达1测定的人的定位进行匹配,由此服务机器人17通过这种方式能够确定刚刚是哪个人讲话,步骤1495。如果涉及语音信号归属于其的第三人(而非用户),则可能存在操纵,步骤1498。之后在存储器中调整值,并且在一个方面在用户对话时生成请求或错误消息。

213.现在,其他人只能为用户提供输入协助,即不自己进行输入,而是仅讲话人、记录人等通过显示器2或麦克风193向服务机器人17中进行输入。为了检查是否能做到这一点,将对记录到的单词序列进行分析,确保能够通过之前章节中示出的至少一种方式将所述单词序列与各个人对应起来,步骤1505。图15示出了这种处理方法的基本点。作为对此的补充方案或者替代方案,能够在服务机器人17的周围环境中记录语音,步骤1510,并且根据不同的语音特征/语音特点尤其是在语音分析模块132内区分讲话人,步骤1515,这基本上包括语音序列(尤其是基频率)、不同语音强度和/或不同语音速度。该方法与图14所述的方法相结合,根据语音信号传播通过唇部跟踪或定位来使用人的语音信号,从而能够将识别到的语音信号与人对应起来,不必每次重新测定讲话人的唇部运动和/或空间位置,并且也不必在必要时与2d/3d人跟踪结果进行比较。将人与语音特点匹配之后,步骤1520,这允许记录语音并且同时根据用户进行跟踪,步骤1525。在内容上对相应予以记录并保存在服务机器人17的存储器10内的序列进行分析,即搜索“预测行为”,即检查这些文本分段或语音分段/语音模态在时间上是否依次多次出现,步骤1530并且来自于不同的人,步骤1535,这通过为模态及与人对应的语音特点,比如基频率进行打标签来实现(作为替代方案和/或补充方案,也能够使用图14中所述的方案)。文本分段、语音分段或语音模态比如指相同的单词和/或词序。在此,在评估这些序列以协助用户或者服务机器人17的操纵时,重要的是知道相关的序列由哪个人首次提到。如果由用户首次提到,步骤1565,则假定为未操纵,而是第三人的协助活动,步骤1570。如果序列首次来自第三人,则要假定为操纵,步骤1575。为此,在第一步骤中检查一语音分段是否首先由一个非用户的人来记录,然后再由用户重复这一语音分段。为此,将进行关联,尤其是在时间范围内,以便搜索相同的单词。在此,尤其会检查是否重复了超过一个依次单独出现的单词。作为对语音序列的关联分析的补充方案或替代方

案,也能够通过自然语言处理进行词汇分析,步骤1545,其中会分析比如前几段中的单词,并且比较打标签的单词的序列,以分词、词义化和部分语音标记,比如通过spacy或python中的nltk为基础比较打标签的单词。这一处理方法另外还能够检查“预测”是否并非由用户为由服务机器人17进行记录而在声音上重复,而是由用户直接向服务机器人17中进行相应输入。因为只有这些重复的语音分段/模态才有重要意义,同样在测试的范围内由服务机器人17检测并在内容上分析这些语音分段/模态,比如以针对用户的问题的表格的形式,步骤1540。为此,相应地同样通过自然语言处理(步骤1550),替代地通过所保存的语音信号来比较服务机器人17中的文本输入(“任意文本”)以及菜单引导的输入(选项),这些语音信号反映了菜单选项,步骤1555,进行分析,再将第三人语音记录与用户输入内容进行比较,步骤1560。如果在所述的这些用于操纵识别的方案中发现由第三人进行了用户的输入或记录,或者由第三人进行“预测”,则在服务机器人17的存储器10中备注已经发生了操纵,步骤1580。

214.总之,用于测定操纵概率的方法包括由非接触式的传感器在机器人的周围环境内检测和跟踪至少一个人,测定该人在机器人的周围环境内的位置,记录和分析音频信号,定位音频信号的来源,比较所测定的人位置和音频信号的来源位置,并且将位置差异与阈值进行比较,并且以位置差异与阈值的比较为基础测定机器人的操纵的概率。在此,通过至少一只麦克风和所测定的方向的三角测量,通过检测音频信号的方向的检测来定位音频信号的来源位置,比如也通过变换服务机器人17的位置或者通过第二只麦克风。定位音频信号的来源位置包括通过麦克风检测音频信号的方向,通过非接触式的传感器测定至少一个人的位置,音频信号的方向和所测定的人位置的三角测量。另外比如会分析面部,检测时间进程中的唇部运动,在时间上将检测到的音频信号(比如通过关联度分析)与检测到的唇部运动与阈值的关系进行比较,并且在超过阈值时将检测到的音频信号与被检测的人对应起来。该方法同样能够包含人在机器人上登录(以用户身份)及检测和保存人的身份特征(以用户身份),其中身份特征包括人音频信号的频率、强度和/或频谱,比如另外能够检测和跟踪人,检测人的身份特征,将检测到的身份特征与在人的登录的范围内保存在机器人上的人身份特征进行比较,以及与阈值进行比较(即具有最低相似性),登录人在操作元件(186)上的输入内容,并分类经登记的人(用户)是否在操作元件(186)上进行了输入。比如如果未登记的人在机器人的操作元件(186)上进行了输入,则能够测定到针对机器人的操纵的增加的概率。该方法另外比如还可以包括:测定检测到的音频信号或音频序列中的单词和/或词序,将测定的单词和/或词序与被检测的人对应起来,如果测定的词序的比较得出单词和/或词序差异超过阈值,即未达到最小关联度,则会测定到针对机器人的操纵的增加的概率。此外,该方法比如能够测定由人通过操作元件(186)输入的单词或词序,测定在检测到的音频信号中的单词和/或词序,将检测到的音频信号中测定的单词和/或词序与被检测的人对应起来,如果将通过操作元件(186)输入的词序与由检测到的音频信号所测定的词序进行比较时发现单词和/或词序最小相似性并且同时被检测的人身份特征与登录时检测到和保存的身份特征有最小相似性,则会测定到针对机器人的操纵的增加的概率。

215.图58示出了以音频信号为基础的用于操纵识别的系统的架构视图。这包括处理单元9、存储器10和用于非接触地检测在系统的周围环境中探测到的人的运动的传感器、至少一只麦克风193、用于测定人在空间中的位置的人位置测定模块4415、用于确定音频信号的

空间来源的音频源位置测定模块4420、用于关联两个音频信号的模块4025、用于将音频信号与人关联的音频信号人模块4430和/或语音分析模块132。此外,还有用于比较是否是被系统识别出身份的人在系统上进行输入的输入登记比较模块4785。该系统另外还有用于比较音频序列(即比如复述单词的音序)与触觉输入字母序列的音频序列输入模块4435。另外还有输出装置,比如扬声器192和/或显示器2以用于传输指令。通过接口188(比如wlan)能够与终端建立连接。用于非接触地检测人的运动的传感器是指2d和/或3d摄像头185、激光雷达1、雷达和/或超声波传感器194。该系统在一个方面具有人识别模块110、人身份识别模块111、跟踪模块(112、113)、运动分析模块120、骨架创建模块5635和/或基于骨架模型的特征提取模块5640。

216.检查用户的障碍

217.用户特别是指老人,他们除了经受可能存在应通过在本专利申请中所述处理方式来检查的认知障碍以外,也可能经受听力和视力障碍,这些障碍可能导致测试结果失真。为了改善测试结果的准确度,服务机器人17在一个方面被如此配置,从而服务机器人17在开始练习前能够给用户执行短期的听力测试,作为对此的补充方案或者替代方案,给用户执行短期的视力测试。基本上在图16中示出了在此进行的方法步骤。服务机器人17首先可选地通过屏幕输出和/或声音输出向用户请求可能出现可能的理解问题的这一问题情况,因此需要根据用户来校准服务机器人17。视力和/或听力测试属于这类校准的一种。然后,服务机器人17提示用户参与校准,步骤1605。

218.在短期的听力测试的范围内,当用户听到特定声音时,服务机器人17提示用户在显示器2的菜单中按下相应的按键。作为对此的补充方案或者替代方案,也能够为用户提供语音输入,如在现有技术中所描述的那样,比如又能够在语音分析模块132中通过自然语言处理方法对语音输入进行分析。随后,服务机器人17播放不同频率和不同音量的音序,但它们单个地基本上具有恒定的频率和音量,步骤1610,并在每次都“询问”用户是否听到了声音,这比如能够通过以下方式实现:服务机器人17向用户示出有输入选项的显示器2,通过该显示器用户能够说明他在多大程度上听到了声音,步骤1615。在一个方面,在此,声音在时间进程中音量更低和频率更高,步骤1620。但也能够考虑与此相关的不同顺序。检测用户的回答。随后,将测定一个评分,步骤1625,它说明在用户的哪个范围内能够听到声音。如果用户比如未达到听觉行为内的特定阈值,即服务机器人17通过其屏幕菜单引导或者语音菜单引导并经过相应分析的回答未达到预先定义的正面回答的边界值(比如只识别到七个声音中的三个),则能够由此测定相应的评分值。在一个方面,该评分保存在服务机器人17内的数据库中,步骤1630,比如与表征人的临床状态的用户信息一起保存。作为对此的补充方案或者替代方案,通过用户发出的比如相对于通过至少另外一个麦克风193记录到的周围环境噪声水平1635的回答音量,服务机器人17也能够确定用户是否需要较由服务机器人17输出的信号的增加的音量。在一个补充的和/或替代的方面,相应地调整服务机器人17的声音信号的输出音量,比如当通过其中所述方式中的至少一种方式确定用户听觉迟钝时,就提高音量。

219.在短期的视力测试的范围内,当用户能够识别特定字母或其他类型的符号时,服务机器人17提示用户在显示器2的菜单中按下相应的按键,步骤1650。作为对此的补充方案或者替代方案,也能够为用户提供语音输入,如在现有技术中所描述的那样,又能够通过自

然语言处理方法对语音输入进行分析。随后,服务机器人17在显示器2上播放一系列的字符或图片,步骤1655。在此,用户在步骤1660中用信号表示,用户是否已经识别到字符或者用户识别到哪些字符。在此,在一个方面,在时间进程中的符号或图片变小(步骤1665)。但也可以考虑与此相关的不同顺序。作为对此的补充和/或互补,也可以用不同的颜色图案来识别用户可能存在的色盲。检测用户的回答。以评分的形式显示测试结果,步骤1670。如果比如用户未达到特定的视力阈值,或者发现色盲,即无法识别特定数量的对象/图案(诸如七个中的三个),这影响到了评分,则在一个方面能够将其保存在服务机器人17内的数据库中,步骤1675。在一个补充的和/或替代的方面,在向服务机器人17的显示器2上输出文本元素时相应地调整字母的大小,必要时同样调整菜单设计,以便能以更大的字母显示相应的菜单项,步骤1680。此外,在一个补充的方面,也能够调整显示器2的色彩,以便在存在色盲的情况下更好地识别显示器菜单。在一个补充的和/或替代的方面,服务机器人17能够改变与用户的距离,比如如果用户存在视力障碍,则更靠近用户,步骤1695。为此,将在导航模块101中临时修改一个参数值,该参数值定义用户和服务机器人17之间的常规距离,步骤1690。最终也能够在考虑用户的视力的情况下,按照环境条件来调整服务机器人17的显示器2的对比度和/或亮度,步骤1685。

220.通过适应环境影响因素来改善信号处理质量

221.在另一方面,不仅考虑视力和听力测试,还考虑用户的缺陷,服务机器人17能够按照环境来如此调整输入和输出单元,由此便能在不同亮度和/或噪声背景条件下操作。服务机器人17在显示器附近有一个市售的亮度传感器,以便测定有多少光落到显示器2上。同时,按照环境来调整显示器2的亮度值,即尤其上在有强烈的光入射时提高显示器2的亮度,并且在亮度值低时,降低显示器2的亮度。作为补充方案或者替代方案,服务机器人17能够通过一个或多个麦克风193测定背景中的噪音。在一个方面,这可能导致在噪音水平提高时服务机器人17的声音输出音量同样更大,并且在噪音水平低时则降低音量。在一个补充或替代的方面,至少另一个麦克风193记录背景噪音并且使用noise cancellation(即噪音消除)方法(输入信号围绕记录的背景噪音的相移),以便改善声音输入信号的信号质量,由此能够更好地处理语音,以便因此避免比如数据检测误差、由服务机器人17重新提出问题或提示等。

222.此外,服务机器人17作为改进测量结果精度的措施还会询问待评估的人是否有疼痛,其中同样会询问疼痛的强烈程度。为此,通过在其他位置处已经描述的通信装置实现服务机器人17与待评估的人之间的互动。这类信息保存在用户的数据库记录中。

223.作为用于改进测量结果的精度的另一项措施,服务机器人17从患者管理模块160获取患者什么时候进入医院的信息,测试在该医院中进行,并计算出截止目前的留院持续时间,以考虑因延长留院时间造成的认知能力下降。同时,在患者管理模块160中还会检测患者是否已经被诊断为一种疾病。在示出简易心理测试结果时同样考虑这一信息并且将其保存在用户的数据库记录中。

224.服务机器人17通过接口188(诸如wlan)将保存的上述测试任务的结果传输至患者管理模块160,并且使它们可用于医务人员,其中同时也记录结果。

225.对患者的光谱测量

226.在一个方面,服务机器人17被如此配置,从而服务机器人17能够确定患者的皮肤

上是否有特定的分泌物,在一个方面,这种分泌物指示出特定的疾病,能够借此方式对其进行诊断。由此,服务机器人17比如能够测定患者在床上是否出汗,必要时也确定该患者出汗有多严重。在此,比如能够使用光谱仪196,比如近红外光谱仪,在另一方面也能够使用raman光谱仪。在图21中示出了测量分泌物的过程2100。在此,能够分别对不同身体部位进行测量。示例性地说明了对三个部位的处理方法:双手、前额以及躯干上的测量,尤其是床单。探测这些部位的汗液比如是另一测试的精神错乱探测评分的组成部分,以便证明患者存在精神错乱。

227.服务机器人17被如此配置,从而服务机器人17能够通过3d传感器,比如3d摄像头,记录床上的患者。为此,该传感器比如被定位在服务机器人17上,由此服务机器人17能够位于至少80cm的高度上,比如至少1.2m高度上,并且比如采用能够旋转和/或能够倾翻放置方式。

228.服务机器人17能够基于对象识别对床进行识别,步骤2105。为此,在一个方面,服务机器人17能够通过2d或3d传感器、比如激光雷达1来扫描空间,据此推理得知在该空间中有床。作为替代方案和/或补充方案,也能够通过保存在存储器10中的地图来测定尺寸,该地图比如包括空间的宽度和深度等房间信息。以这种方式方法分析空间尺寸,步骤2110。服务机器人17另外还能够测定所测量的对象的尺寸,步骤2115,比如与所实施的里程计单元181搭配进行三角测量(2120步骤),它能够测定服务机器人17的位置偏差。测定在空间内所测量的对象相对于房间信息的尺寸,步骤2122,为此不必求助里程计功能。基于保存在存储器10中的规则对所测定的尺寸,尤其是床的外形尺寸进行分类,由此测定该对象是否属于床,步骤2124。在一个方面,这包括床所占据的尺寸。在一个补充的和/或替代的方面,也能够基于明确地识别出床的表征性的特征对由激光雷达1和/或2d和/或3d摄像头185识别到的对象进行分类,步骤2125。在此,可以涉及床的轮子的设计方案和/或用于调节床高度的升降装置。但也能够使用通过基于机器学习和/或神经网络方法来学习典型的床特征来创建的分类规则。作为替代方案和/或补充方案,床也可配备传感装置和/或条形码,步骤2130,比如rfid或蓝牙发射器,它们能够对床进行识别。

229.在一个方面,通过将传感器定位在床上能够测定床在空间中的朝向,步骤2140,比如能够通过使用在床架上不同地反射的背向散射信号,并且通过运行时间和/或相差来测定床在空间中的朝向。条形码同样能够通过这种方式固定在服务机器人17上,该方式使得这种读取允许测定床的空间朝向。由服务机器人17读取保存在传感装置和/或条形码中的代码,并且将其与保存在服务机器人17的存储器10中并且分配给床的代码进行比较,由此服务机器人17能够确定所读取的传感器和/或条形码已经分配给一张床。作为替代方案和/或补充方案,尤其是在基于其尺寸来识别床时(步骤2124),床在空间中的朝向通过床尺寸来进行,在一个方面也能够通过比较与最近的墙的位置进行识别,步骤2135:也就是说,服务机器人17以先验信息为基础测定床的朝向,尤其是床头的朝向,其中先验信息是指床具有基本上为矩形的形状,其较短的侧边为床头或床尾。在此,将更短的边识别为床头,该床头比如更靠近空间的墙。在一个替代的方面,服务机器人17能够识别床上的人,尤其是其头和手臂,例如能够在骨架模型范围内对其进行分析。

230.随后,在可选的步骤2145中,服务机器人17测定服务机器人17在哪个位置相对更靠近患者的头。为此,服务机器人17在下一步骤中在床的一侧测定服务机器人17能够行走

多远到达床头。如果到在床的一侧上的床头处的墙的距离小于1m,则服务机器人17沿这一床侧行进。如果距离超过1m,则服务机器人17在床的另一侧测定与墙的距离,并且随后尽可能向前行走至靠近床头的墙,即在服务机器人17能够尽可能远地行进至靠近床头处的墙的一侧。在一个替代的方面,服务机器人17如前所述首先检查两侧的深度,之后向朝向床头方向的一侧行进,服务机器人17在这一侧朝向靠近床头的墙的方向行驶的距离最远。

231.作为下一步骤,服务机器人17测定头的候选区域,步骤2150。为此,定位服务机器人17如此定位,从而指示其正面朝向预测的头位置的方向。这比如能够通过将服务机器人17旋转就位实现,其中服务机器人17具有相对于床的较长一侧测量的25

°

至90

°

的旋转角度。服务机器人17通过2d或3d传感器来检测床的表面,尤其是在到床头的区域内进行检测。作为替代方案和/或补充方案,服务机器人17计算出头通常所在的候选区域,并且这一候选区域位于距床较长侧至少25cm、距床头至少10cm、到床头的距离最大为60cm的区域内。

232.作为替代方案和/或补充方案,也能够保存宽度的间隔。如果与床较长侧(通过比较床侧和/或通过预定义的长度间隔来相对测定)的距离小于定义的阈值(比如20cm),说明床沿着墙伸展,并且服务机器人17沿床的纵向侧移动,直至有充足的空间。随后,服务机器人17使用已经描述过的用于测定头的候选区域的方法,服务机器人17替代地通过摄像头185扫描整个床,通过市售的架构对其图片进行分析,该架构能够实施头识别。

233.服务机器人17以头特征为基础能够测定前额,步骤2152。在一个方面,这通过定义一个通过以下面部特征限制的区域来实现:高于在发际线的两侧连接眼睛中心点的线约4cm,这能够通过患者皮肤的彩色对比度予以识别。作为替代方案和/或补充方案,在此也能够使用头形状,其中通过使头倒圆来限制前额面。在此,比如能够使用方向梯度直方图方案,它采用比如opencv或scikit-image架构。在此,作为限制也能够使用角度,大腿的角度由头传感器的光束与位于光束射到头的表面上的位置处的垂直线形成。在识别出患者的前额之后,服务机器人17跟踪头的位置,步骤2172,比如借助视觉上的人跟踪模块112和/或基于激光的人跟踪模块113来跟踪头的位置。

234.如果服务机器人17识别患者前额或眼睛遇到问题,在一个方面,该服务机器人能够调换床侧,以确保患者的后脑不会转向它。作为替代方案和/或补充方案,服务机器人17能够通过其输出单元,比如显示器2和/或语音合成单元133请求患者移动头,步骤2154,比如看向该服务机器人。在发出这样的请求之后,重新尝试识别头或前额。

235.服务机器人17还能够使用其他分类算法来识别患者的双手。在此,一方面与识别患者头的方法相同(即大致在床较长侧的中心,与较短床边的平行深度约为30cm确定手的两个候选区域,步骤2157),作为替代方案和/或补充方案,能够使用rgb或rgb-d摄像头185的sdk中的算法,以创建患者(部分地分配的)骨架模型,其中在此尤其是识别手臂和双手,即其关节点,而关节点之间的连接能够显示为方向矢量。如果服务机器人17未识别到手臂或双手,服务机器人17能够通过其输出单元,比如显示器2和/或语音合成单元133请求患者移动双手或手臂,步骤2159,比如将它们从床单下面伸出。在发出这样的提示之后,重新尝试识别手臂或双手。与前额类似,服务机器人17还能够识别手表面,比如手背和/或手心。在此,为了改善定位,作为替代方案和/或补充方案,还能够考虑来自骨架模型的关节点,其中手部的重点区域在手关节和手指关节之间。作为替代方案和/或补充方案,能够通过图片分类识别手心,其中借助显示手心的图像来训练分类算法。

236.另一个重点身体区域是患者的上半身,通过一个候选区域事先将其定义为从头向下指向的区域,该区域在约1.5倍头高长度范围内延伸,一半头高从头下方开始,宽度约为2倍头宽。作为替代方案和/或补充方案,从患者头下方约10cm处开始,在约45cm的宽度和约50cm的高度内定义这一区域,也替代地大致定位在床中心,与床头的距离约为50cm。作为替代方案和/或补充方案,也能够通过三维形式进行分类。在此,在一个方面根据高度扫描床的宽度,并且在轴线与处于床的半部的区域的较长一侧平行的区域内,朝向床头朝向。沿着在该区域内产生的脊线选择位于头的候选区域下方的部分。通过这种方式能够测定上半身的候选区域,步骤2160。然后,扫描相对于通过服务机器人17的3d传感装置检测到的床垫的水平的突起,并且在在候选区内探测到突起的情况下,则将该区域识别为上半身,步骤2162。

237.为了使得服务机器人17能够检测到识别患者的目标区域:前额、手表面/手背和躯干的上部。能够通过传感装置,比如借助rgb-d摄像头185在空间中如此识别它们,由此能够相应地在三维坐标系中显示其表面。在此,比如也会进行跟踪,步骤2170,尤其是跟踪患者的头,步骤2172,并且在一个变型方案中,也能够跟踪手,步骤2174,并且可选地跟踪上半身,比如借助视觉上的人跟踪模块112和/或基于激光的人跟踪模块113来进行跟踪。在此,比如对由传感装置创建的图像进行分段,以通过分类来确定身体区域,使光谱仪(196)能够对准这些身体区域。相应的分类能够保存在存储器10中。服务机器人17比如在用于控制光谱仪的应用中也能够保存应在其上面进行测量的区域。

238.在测量前,服务机器人17在步骤2170中在定义的时间段内跟踪手或头的运动(也可选地跟踪上半身的运动)。如果在超过定义的阈值的持续时间内未发现运动(比如5秒),或者只发现了手/头未超过定义阈值(比如5mm)的运动,步骤2180,则测量和分析检测到的数据,步骤2185。

239.在使用光谱仪测量期间,在安全性检查2178的范围内通过rgb-d摄像头185持续地跟踪患者的头或者正在对其进行测量的手。如果发现了运动,比如头的旋转运动、超过定义阈值的低头或抬头运动,则立即中断测量。服务机器人17继续跟踪应在上面进行测量的区域,并且当头的运动小于定义的阈值时,再次开始重新的测量尝试。

240.服务机器人17另外比如还有一个用于进行物质分析的近红外光谱仪2186,它能够旋转和回转地安置并且能够与之相关地进行电子调节。服务机器人17能够通过这种安置方式来使得光谱仪196如此对准,让由光谱仪196测定的辐射的路径到达三维空间内的目标区域的坐标,并且也能够重新探测光谱仪196的经反射的辐射,步骤2187。尽管将带聚焦镜头的红外线二极管用作光源,但在一个方面能够使用红外激光器。

241.将会进行测量,即分析光谱仪196的信号,并且根据参数数据库进行分类2189,数据库中包含参考光谱,并且由此能够在质量或数量上2190测定在目标区域内或上有什么2188。作为替代方案和/或补充方案,也能够直接保存用于根据测得的光谱确定物质的分类规则,它们比如以关联度评估为基础工作。在此,在一个方面测定表征性信号,即基本上测定汗液的光谱分布,步骤2191,它们由水、钠和/或氯的单个光谱组成,并且比如出现在患者的皮肤上,比如前额或手上。根据躯干目标区域检测患者的床单有多湿,即在此根据床罩的材料来考虑用于分析信号所使用的分类。

242.通过扫描床单的不同的部分区域,借助通过参考数据库所进行的分类例如也估计

作为汗液析出的水的量。

243.数据库在另一方面具有参考光谱,通过它们能够确定其它物质的浓度,包括不同的药品2192,如海洛因、鸦片制剂(诸如吗啡)、安非他明、甲基苯丙胺、可卡因(必要时包括苯丙胺)、9-四氢大麻酚(thc),或其它物质2193,如葡萄糖、乳酸、尿酸、尿素、肌酐、皮质醇等等。

244.服务机器人17具有另一个参考数据库,它以不同的物质的组合和/或其浓度为基础允许对测定的测量值进行分类,由此能够将不同的疾病与测得的光谱相关联,步骤2194。在此,浓度阈值或测得的物质量、物质量和/或浓度彼此间的比例以及它们的组合构成了这种分类的组成部分。一个示例是尿素、尿酸和肌酐的组合,其中尿酸的浓度大于0.02mmol/l、肌酐的浓度为0.04mmol/l(在温度更低时浓度会更高)、并且尿素浓度》15mmol/l(在低温条件下)或者》100mmol/l(在高温条件下)。服务机器人17在该分类中通过位于服务机器人17内的温度计考虑环境温度、季节或室外温度,并且在后一种情况下配备有接口188(诸如wlan),由此通过云18能够测定其所在位置的室外温度,即服务机器人17为了改善分析能够检测其他数据,或者通过其它传感器2195和/或通过接口188(诸如wlan)向其他数据库2196传输。

245.测量结果保存在位于服务机器人17内的数据库中,步骤2197和/或能够通过接口188(诸如wlan)向云18中的服务器传输并保存在那里,步骤2198。随后,能够通过显示器2和/或语音输出测量结果,步骤2199,比如通过服务机器人17和/或医务人员在分析时能够访问的终端来进行输出。

246.在图63中对(比如服务机器人17的)光谱仪系统进行了总览式地示出:光谱仪系统包括处理单元9、存储器10和用于非接触地检测人的传感器(比如2d和/或3d摄像头185、激光雷达1、雷达和/或超声波传感器194)、光谱仪196和用于将光谱仪196与人的身体区域对准的光谱仪对准单元4805,它与翻转单元类似。此外,该系统还能够具有用于测量环境温度的温度计4850和/或通向终端13的接口188。在存储器10中有用于探测身体区域的身体区域探测模块4810、用于在身体区域上进行光谱测量之前和/或期间跟踪身体区域的身体区域跟踪模块4815、用于监控的光谱仪测量模块4820(包括中断和/或继续基于在上面进行测量的身体区域的运动的光谱测量)、视觉上的人跟踪模块112和/或基于激光的人跟踪模块113。系统访问参考光谱数据库4825和/或具有所保存的疾病图像和与之关联的用于比较所测得的光谱并测定所测得的物质的疾病图像数据库4830,它们位于云18和/或存储器10中。在存储器10或云18中另外还有用于测定流出的汗液的汗液模块4835、用于测定精神错乱探测评分的精神错乱探测评分测定模块4840和/或用于测定认知能力的认知能力评估模块4845。在一个方面,该系统具有人识别模块110、人身份识别模块111、跟踪模块(112、113)、和/或运动分析模块120。

247.以多项测试为基础识别精神错乱并进行监控

248.作为简易心理测试的替代方案,在临床诊断中还出现了一种目前已被医务人员所掌握的、用于精神错乱识别的测试法。精神错乱是一种至少暂时性精神错乱症。它尤其采用cam-icu这一术语,其中cam代表“困惑评估方法”,icu代表“intense care unit”,即重症监护室。由医务人员进行的评估在此包括注意力障碍,这能够通过声音和/或视觉测试进行,但也能够进行需要有运动机能反应的无序思维测试。

249.基于对声学信号序列的识别,分析患者的注意力障碍

250.服务机器人17在一个方面被如此配置(参见图22),从而服务机器人17能够通过比如脉搏频率为0.3-3hz,比如约一赫兹的扬声器192输出不同的声音信号的脉冲序列(比如音序),步骤2205。同时,服务机器人17能够检测至少一个触觉传感器4905的信号(步骤2210),并与输出的信号同步,步骤2220。此外,能够在存储器10中为每个声音信号分配一个值。输出声音信号和探测触觉传感器4905的信号之间有一定的时间上的延迟2215,即比如最大为一半脉冲长度、跟踪脉冲信号的相移。在此,将对至少一个触觉传感器4905的以可能的相移进行登录的信号进行分析,确定其是否在定义的且保存在存储器10中的声谱范围内出现,步骤2225,即比较在定义的音序之后是否出现探测到的信号。如果出现了这种情况,则存储器10中的计数器会增加一个整数值,步骤2230,或者替代地,不增加,步骤2235。随后,以这种方式对测定的计数器值进行分类,使得给测定的计数器值分配一个与计数器值对应的诊断,步骤2240。对准患者输出声音,以便例如检查其认知能力。值越大,患者的认知能力受到的不利影响越低。诊断结果保存在服务机器人17的存储器10中,步骤2245,可选地将所述诊断结果向云18内的基于云的云存储器中传输,并且可选地通过终端提供给医务人员。

251.触觉传感器4905是指一种压电、压阻、电容式或电阻式的传感器。但如kappassov等人在2015(doi:10.1016/j.robot.2015.07.015)所述,也能够使用其他类型的传感器。在一个方面,在服务机器人17的执行器4920上有触觉传感器4905,该服务机器人有至少一个关节并且能够如此定位,从而服务机器人17能够够到患者的手,即触觉传感器4905相对于手以小于比如保存在存储器中的阈值的距离进行定位。在一个方面,该传感器集成在机器人手臂中。在一个替代的或补充的方面,该传感器被安装在服务机器人17的表面上。为此,服务机器人17利用至少一个摄像头185来识别患者的身份,对其跟踪并测定其双手的位置,比如至少测定右手的位置。

252.应用示例:

253.服务机器人17在用于检测患者的注意力的测试中通过扬声器192输出相当于一个单词的字母串。每个字母间隔约一秒输出。服务机器人17请求患者在识别到特定字母时用其一只手实施按压运动。通过所述的触觉传感器4905分析这些按压运动,并对识别到特定的字母的频次进行计数。识别率越高,患者受到的不利影响越低。

254.如图64所示,注意力分析系统的组成如下:系统,比如服务机器人17,其包括处理单元9、存储器10、用于声音信号的输出单元(诸如扬声器192)、触觉传感器4905以及用于通过触觉传感器分析信号的触觉传感器分析单元4910和用于比较检测到的信号是否在定义的输出之后出现的触觉传感器输出比较模块4915。该系统同样能够包括执行器4920,比如机器人手臂以及摄像头185。触觉传感器4905比如定位在执行器4920上。在存储器10中有执行器定位单元4925,它通过执行器4925将触觉传感器4905定位在人的手附近,并通过人身份识别模块111和/或手识别模块4930以及认知能力评估模块4845来测定人的认知能力。该系统在一个方面具有人识别模块110、跟踪模块(112、113)、运动分析模块120、骨架创建模块5635和/或基于骨架模型的特征提取模块5640。

255.基于图像识别来分析患者的认知能力

256.在服务机器人17的一个替代的或补充的方面该服务机器人17被如此配置,从而能

够由患者分析和分类对图像的识别,以便由此评估患者的认知能力,尤其是其注意力。图23示例性地示出了在此所使用的流程。在此,服务机器人17通过语音合成单元133向患者指示,服务机器人17应记住多张图片,步骤2305。在语音输出之后,服务机器人17的显示器上将显示一系列图片,步骤2310,比如分别间隔三秒显示五张图片。然后,通过语音合成单元133通知患者,服务机器人17希望通过其患者头的运动来用信号表示患者是否认识所显示的图片,即服务机器人17希望在步骤2315中进行与之相关的分类。在此,将摇头评估为拒绝,将点头评估为确认。分别间隔三秒在服务机器人17的屏幕上播放十张图片(步骤2320)。在此,与前五张图片序列相比,有五张图片是重复的,但每张图片只播放一次。在一个方面,能够与显示过的图片比较,通过随机发生器确定图片的顺序和/或区分新图片,步骤2325。服务机器人17保存显示的图片序列是否已经显示过,步骤2330,并且在显示期间(或者最多等待一秒)检测患者的头运动。为此,服务机器人17至少具有一个传感器,比如rgb-d摄像头185,它能够识别和跟踪患者的头,步骤2335,其中比如借助视觉上的人跟踪模块112和/或基于激光的人跟踪模块113进行分析。这包括转头和/或点头。在此,服务机器人17能够通过分类方法检测面部的特征点,其中包括眼睛、眼眶、嘴和/或鼻子。在现有技术中已知存在这方面的解决方案(比如doi:10.1007/978-3-642-39402-7_16;10.1007/s11263-017-0988-8),它们使用方向梯度直方图。作为下一步骤对患者的头运动进行分类,以识别摇头和/或点头,步骤2340。为此,同样能够使用源自现有技术的架构。由此识别到的点头或摇头运动相应地与显示的图片进行同步,步骤2345。然后根据再次显示或首次显示给患者之后他或她是否已经正确识别出图片,来对所显示的图片序列进行编码,步骤2350。服务机器人17可选地将值的比较结果,比如与执行日期一起保存到数据库中,数据库比如同样保存显示的图片序列。在通过患者每正确识别到一次图片重复时,计数器都将累加一次,步骤2355。通过累加产生的评分是衡量患者是否经受认知障碍的标准。为此,对测定的评分进行分类,为其分配医学注释,步骤2360。评分及其医学注释保存在数据库中,步骤2365,必要时保存在云18内的云存储器中,步骤2370,并通过终端提供给医务人员以进行分析,步骤2375。

257.在一个可选的方面,服务机器人17能够在三维空间中测定患者的眼睛的位置2410以及显示器2的位置(步骤2405)。服务机器人17在一个方面使用这些数据检查眼睛与显示器2之间的视线连接是否存在障碍物。比如,在患者卧床时,防跌倒装置可能成为这样的障碍物。为此,服务机器人17首先计算视线所在的坐标,步骤2415,并且通过3d摄像头检查视线连接的坐标是否与探测到的障碍物关联,步骤2420。如果服务机器人17识别到障碍物,则重新定位显示器倾斜度,步骤2450,作为替代方案和/或补充方案,在xy面中重新定位服务机器人17,步骤2455。在一种替代的和/或补充的方面,服务机器人17被如此配置,从而服务机器人17能够在显示器2(比如显示器拐角)空间坐标的帮助下测定患者眼睛与显示器表面之间的角度(步骤2425),以便确保至少一个角度在一定间隔内,步骤2430,该间隔可能为设备所特有。通过这种方式能够确保例如显示器2的反射表面不会导致患者无法充分识别显示器2,因为显示器倾斜度会令患者识别到强烈的反射。为此,服务机器人17能够相应地调整显示器倾斜度2450和/或在空间中重新定位服务机器人17。作为替代方案和/或补充方案,还能够根据患者与显示器2之间的距离来调整显示器2上的字体大小和/或其他符号。为此,服务机器人17首先计算眼睛和显示器2之间的欧氏几何距离,将其与保存在服务机器人17的存储器10中的参考值进行比较,检查这一距离是否能够接受用于识别,且在一个补充

的方面能够包含有关患者视力的数据,以便在必要时调整参考值。由此,服务机器人17便能够调整显示器2的显示尺寸(即显示的对象和符号的尺寸)和/或服务机器人17在空间内在xz平面(即地面平面)中定位,从而确保有充足的用于识别显示器内容的距离。

258.根据服务机器人17在xz平面中的重新定位、显示器2的倾斜度和/或显示器显示的尺寸调整,该服务机器人17能够通过扫描其周围环境和可能的扩展或替代的没有障碍物的视线范围,测定显示器2的倾斜可能性和/或显示器2的显示尺寸,这可能成为它在xz平面中的位置、显示器倾斜度和/或显示尺寸,由此患者在其眼睛和显示器2之间不会发现障碍物,能够在空间上如此定位显示器2,从而确保其尽可能无反射和/或显示尺寸对于患者的视力而言是足够的。

259.在一个替代的和/或补充的方面,服务机器人17具有用于显示器倾斜度的操控装置和显示器2中的对话功能,或者被配置为语音界面。借助该对话功能,能够向患者反馈显示器显示对他来说在多大程度上充分能够识别。如果患者方面对效果不满意,服务机器人17能够改变显示器2的对准。在一个方面能够通过相对于患者进行重新定位服务机器人17来实现。这一方面能够通过旋转就位实现,另一方面也能够通过占据其他位置实现(比如通过服务机器人17覆盖地面的区域来定义)。在一个替代的和/或补充的方面,能够调整显示器2的倾斜度,其中能够水平和/或垂直对准翻转轴线。

260.在xz平面中重新定位显示器2和/或服务机器人17之后,重新执行所描述的过程,以便检查患者是否能够练好地识别到显示器2。

261.机器人对一只手的手指的数量进行计数

262.服务机器人17在一个方面被如此配置,从而通过摄像头185、比如rgb-d摄像头185能够识别手指或对其进行跟踪,以便根据显示的数字来分析由手所显示的姿势,比如借助视觉上的人跟踪模块112和/或基于激光的人跟踪模块113。图25示出了这一过程。为此,将由3d深度摄像头生成的深度图像2505被转换为3d散点图,在其中为摄像头的每个像素分配一个空间坐标,步骤2510,由此能够通过第三方提供商、诸如nuitrack的摄像头sdk或软件来识别骨架,步骤2515。在此,相应地识别关节点,包括手关节以及指关节。

263.作为下一步骤进行关节选择2520,即仅为下述有待执行的计算继续处理必要的关节点。随后,将进行角度计算2525,比如计算第三和第二指节、第二和第一指节以及第一指节和掌骨之间的角度。(在此一般第三指节被称为有手指尖端的指节)。由于大拇指通常没有第二指节,因此它在这里是指第三和第一指节、第一指针和掌骨之间的角度,以及在一个方面指掌骨和腕骨之间的角度。在此,每个指节或每根掌骨被显示为分别从观察的关节点开始的方向矢量。作为下一步骤进行特征提取2530,其中比如共同分析每根手指的所述关节点的角度。在基于所确定的规则来实现的特征分类2535的范围内,比如将伸开的食指定义为第一和第二指节以及第二和第三指节之间的180

°

的角度。在特征分类的范围内能够定义如下阈值,该阈值可能与180

°

的条件稍有偏差,并且比如对于第三和第二指节间的角度为150

°

至180

°

,并且对于第一和第二指节间的角度为120

°

至180

°

,并且对于掌骨和第一指节之间的角度为90

°

至180

°

。对于大拇指而言,第三和第一指节间的角度为120

°

至180

°

,而第一指节和掌骨之间的角度为150

°

至180

°

。在姿势分类2540的范围内,对各根手指及其关节点角度进行结合观察。由此一方面能够基于手动定义的值2545来探测借助手指显示的值2,通过伸出大拇指和食指、食指和中指,或者它们和/或其他手指中两根的组合来探测这该

值,而其它手指,尤其是在第二和第三指节之间所具有的角度小于120

°

,比如小于90

°

。如果未伸出大拇指而是伸出另外两根手指,则在此大拇指的第三和第一指节之间的角度小于120

°

,比如小于100

°

,比如最终最识别为2。掌骨之间的角度可选地小于145

°

,比如小于120

°

。

264.一方面能够通过预定义的规则,比如各个关节点的角度定义及其组合,或者也能够通过机器学习方案2550、诸如支持矢量模型来练习特征提取、特征分类和手势分类,在其中对特定角度组合相应打标签,即能够相互说明各个指节的角度的组合,由此比如示出两根手指,其相当于值2。

265.在患者认知能力测试的范围内,在一个方面首先触发服务机器人17的输出,通过语音合成单元133,借助扬声器192和/或通过文本和/或图片向服务机器人17的屏幕输出。该语音输出请求患者显示两根手指2605。在此,摄像头185识别患者的双手、其手指,并跟踪手指运动。在此,服务机器人17在手势分类的范围内对此进行分析,以便测定显示多少根手指2610。在此,在一个可选的方面,如在下面所描述的那样,考虑是否能将由患者显示的手指姿势与代码相关联2665。随后,服务机器人17保存一个值,这个值指示患者是否显示了两根手指2615,即评估所评估的手指姿势与以光和/或声音方式输出的数值的比较结果。

266.服务机器人17在一个替代的和/或补充的方面具有至少一个执行器4920,比如有至少一个关节的机器人手臂,它另外具有至少一只机器人手2620,所述至少一只机器人手具有至少两根能模仿人的手指,但至少有五根手指,其中一根从其布置上来看相当于大拇指,并且它们有与人手一样多的指节。在此,服务机器人17能够借助这些手指来显示数字,其中伸出的手指和手指姿势由指节的角度得出,之前已经根据使用摄像头185识别指节进行过分类。由此,服务机器人17也能够显示出值2,步骤2670,其方法是伸出例如机器人手上的大拇指和食指,即前三个指节之间的角度例如接近180

°

,而其他指节和指节与掌骨之间的角度小于120

°

。服务机器人17经过如此配置,使服务机器人17通过语音输出和/或显示器2能够如此同步机器人手的姿势调控,使机器人手显示出值2,同时通过显示器2和/或语音合成单元133请求患者显示与机器人手所显示出的手指一样多的手指,步骤2675。然后进行所述的手识别、手跟踪和姿势分类,以便识别患者的两根手指,步骤2610,以便在测定到患者显示了数字二时保存一个值,步骤2615。在此,在一个方面在服务机器人17通过其输出单元,比如扬声器192和/显示器2请求患者显示数值或者说通过机器人手向其显示了相应的数字之后,在比如3秒的时间窗口内分析由患者所显示的手势。

267.在该测试的范围内获取的认识允许评估患者在多大程度上受到无序思维的影响,进而给出一种依据识别和监控精神错乱的测试方法。

268.在一个可选的替代方案和/或补充方案的方面,服务机器人17被如此配置,从而能够基于文化和/或国籍差异利用手指来显示数字。作为替代方案和/或补充方案,服务机器人17在分析手势时考虑这些区别也能够方便识别所显示的数字。其结果是,比如德国的患者更可能用大拇指和食指来显示数字2,而美国人用食指和中指表示数字2。为做到这一实施方案,服务机器人17在存储器10中包含表示相同数字的不同手势的代码,步骤2650,并且它们与之相应地为各国所特有/受到文化条件限制。服务机器人17在其存储器10中保留的患者数据同样能够包含这些代码中的一种,步骤2652,它相应地指示出了患者的国家/文化背景。因此,在存储器10中保存了针对每个数字的多个姿势,尤其是手指的多种组合。作为

下一步骤比较代码,以便测定患者优选采用的姿势,步骤2655。恰好也在考虑患者可能的认知障碍的情况下,能够提高患者用其熟悉的手和/或手指姿势来显示出数字的测试可信度。由此服务机器人17能够向患者显示出手势和/或手指姿势,比如数字2,它与患者的文化/国家背景相符,步骤2660,由执行器4920的机器人手实现这一点,步骤2670。作为替代方案和/或补充方案,这些涉及患者的相应编码的文化/国家背景的信息还能够用于更好地识别由患者显示的两根手指。在考虑到这样的代码的情况下进行该手指输出和/或识别是一种可选的实施方案。

269.服务机器人17还被如此配置,从而通过执行器4920使用至少一个关节在空间上如此对准机器人手,由此在步骤2638中能够由患者识别到机器人手。为此,服务机器人17检测患者的头及其在空间中的朝向,其方式为,服务机器人17使用在现有技术中已经完备的面部姿态识别方法2625,比如在openpose架构中包括这种方法。在此,在一个方面也能够比如以opencv或scikit-image架构实现的梯度直方图方案。服务机器人17通过该架构测定头在空间中的朝向,并且为眼睛计算出一个视线范围。这尤其分别是指张角为45

°

的锥角,比如30

°

(从垂线测得)-下文中将其称为“良好的可识别性”,它与头的正面垂直对准。因此,服务机器人17具有锥角识别装置2630。在此,服务机器人17检测其在空间中的位置和执行器的位置4920,尤其是机器人手的位置,并测定该位置是否在锥角之内2632。如果该位置不在锥角之内,则服务机器人17计算执行器4920的关节需要哪些角度设置才能在锥角之内定位机器人手。在此,服务机器人17计算出空间内的三维区域,它与患者具有最小距离并且例如视患者的身体区域变化。在步骤2636中,将这类最小距离保存在服务机器人17的存储器10中。通过识别床上的患者的,比如其头和身体,则计算出机器人手允许在其中活动的“允许区域”,其中与患者头的距离较距离躯干或手臂的距离更大。在一个方面,距头的距离为50cm,与患者剩余身体部分距离30cm。服务机器人17在步骤2638中测定机器人手能够定位在服务机器人17允许区域的哪一部分,才能使机器人手在两个锥角之间。然后,服务机器人17在步骤2638中通过执行器4920如此对准机器人手,从而通过患者能够实现手的“良好的可识别性”。如果无法实现这类定位,服务机器人17会在步骤2640中请求患者通过输出单元,比如显示器2和/或语音合成单元133借助扬声器192请求患者看向该服务机器人17。然后,在步骤2642中再次检查,即执行步骤2630-2640。如果不改变所测定的锥角的对准,服务机器人17会取消测试步骤2644,并且在步骤2646中向医务人员传输信息,为此比如通过接口188(诸如wlan)向服务器和/或移动终端发送信息。作为替代方案和/或补充方案,服务机器人17能够重新向患者请求和/或等待更长时间。如果以患者能够良好识别的方式对准机器人手,则能够在步骤2670中用一只手显示出两根手指,并按前面所述继续这一过程。在基于面部姿态识别考虑“允许的区域”来对准机器人手时,这属于一个可选的方面。

270.图65中示出了用于认知分析的系统。该系统、比如服务机器人17包括处理单元9、存储器10、在存储器中通过数值输出模块4940输出数值的输出单元、人检测和跟踪单元(4605),该人检测和跟踪单元带有摄像头(185)和人识别模块(110)。输出单元是指声音发生器、诸如扬声器192,显示器2和/或执行器4920、比如机器人手臂,在一个方面带有机器人手4950。系统在存储器10中具有用于探测人手势的手势探测模块4960、用于生成机器人手的手指姿势(4950)的手指姿势生成模块4955,其中手指姿势比如代表数值。系统另外还有用于评估被检测的人的认知能力的认知能力评估模块4845。系统在一个方面与患者管理模

块160连接。系统具有在其它位置处已经有过描述的、用于测定被检测的人的认知能力的规则。该系统在一个方面具有人身份识别模块111、跟踪模块(112、113)、运动分析模块120、骨架创建模块5635和/或基于骨架模型的特征提取模块5640。

271.确定疼痛状态

272.服务机器人17在一个方面被如此配置,从而服务机器人17能够进行患者疼痛感测试,这由服务机器人17所进行的对于患者的行为观察来实现。在此,采用在医学上所创建的疼痛评估表的疼痛表现指标的处理方法。在精神错乱监控的范围内同样进行这类测试。在此,在第一步骤中将分析躺在床上的患者的面部表情。在本

技术实现要素:

的其他位置(比如图21a)处示出了一些方案,比如服务机器人17在患者卧床时识别其面部,必要时对其进行跟踪,这包括与此相关联的服务机器人17的导航。在一个方面通过传感器检测床,并且通过模态比较来分析在此生成的图像,以便评估它是否是指一张床。在一个方面,在此也能够使用这些方案。

273.疼痛状态:识别情绪

274.服务机器人17在第一部分测试中分析患者通过其面部表情表达的情绪。为此,服务机器人17在一个方面能够访问面部分类数据库,在其中保存有面部候选区域内和多个面部候选区域的分类规则,它们以面部特征为基础能够得出有关患者的情绪状态的结论,在下面对此有详细描述。这种两阶段式方法与比如在us20170011258或us2019012599中作为单阶段式方法描述的现有技术存在偏差。在这种实施方案的范围内比如能够使用方向梯度直方图方案,它在比如opencv或scikit-image架构内实施。在识别情绪时,基本上依靠检测表现患者紧张程度的、从放松到极度紧张的情绪,这些都表现在脸部变形上。

275.在该方法的范围内,首先在步骤2705中识别患者的头,比如通过openpose等架构。能够通过2d或3d摄像头185进行这类分析。在此,比如首先识别面部的候选区域2710,然后基于梯度直方图算法在至少一个候选区域中在步骤2715中进行用于分析情绪状态所需的特征提取,由此比如能够评估嘴或眉毛的运动。在步骤2720中,基于获取到的梯度直方图数据进行特征分类,这种特征分类采用现有的特征分类,通过成熟的聚类法,诸如k-means、支持向量机和/或基于通过练习神经网络、比如带有反向传播的多层卷积神经网络来获取的权重借助为面部表情打标签来产生。在下一步骤,即步骤2725中,在多个候选区上对在候选区平面上进行过的分类进行分类,这同样通过基于机器学习的成熟的聚类法、诸如通过k-means、支持向量机和/或已经提到过的卷积神经网络进行。在此,比如共同分析嘴和眉毛的运动。

276.在步骤2730中能够在不同的方面对识别算法进行滤波,即比如在步骤2735中校正服务机器人17通过接口188(诸如wlan)从数据库获取的患者年龄,前提是直接在服务机器人17上分析情绪。作为替代方案和/或补充方案,也能够通过接口188(诸如wlan)向云18传输摄像头185为识别情绪而创建的患者头图像,并在那里进行分析。在这种情况下,会将可能的年龄信息从云18中的云存储器传输至执行情绪识别的模块。另一个滤波器在一个方面,判断患者是否插着气管插管(步骤2740),它能够确保通过嘴为患者进行人工呼吸。比如在一个方面,通过使用相应的气管接人工呼吸患者的图片的训练数据来创建用于所述的情绪评估的分类算法。有关探测插管的详情参见下方,并且在一个方面也能够在本文所描述的处理方法的范围内使用。

277.在步骤2745中,在测定评分的范围内,在1-4的标度上评估情绪,为此将测定的情绪与保存在存储器10中以及分配有标度值的情绪进行比较。值“1”表示被分类为正常的面部表情,而紧张程度在标度上上升直至暗示着面部变形的最高值4。针对跨候选区域的分类存在如下一个矩阵图,该矩阵图针对不同面部表情显示出相应的评分。

278.在一个方面,在数小时或数天的流程内检测这些值,例如当患者处于放松的状态时在开始由服务机器人17进行一系列情绪测量时,这能够必要时简化对于患者的情绪状态的分析,这能够例如由医务人员比如通过终端和菜单配置保存到存储器10中,服务机器人17能够访问它们。这包括健康状况,比如患者在开始测量时没有疼痛的信息。由此能够在无疼痛和可能伴随有疼痛的状态下检测和分析面部表情和情绪,由此无疼痛状态的分类特征能够被考虑用于评估伴随有疼痛的状态并作为滤波器使用。通过对面部表情动态分类(步骤2750)提升了分类品质,因为能够基于多个时间点的面部差异观察实现分类。由此,例如也能够进行回顾分类,其中比如只将提取到的特征与表征检测时间的时间戳一起保存并重新分类。为实现这一点,将保存面部记录。总之,单个地和/或相关联地检测人、识别面部、在面部以内选择候选区域、提取候选区域的表面弯曲的特征,并对候选区域的表面弯曲进行分类,其中这种分类描述疼痛状态。

279.疼痛状态:检测上肢活动

280.测试的第二部分侧重于上肢的运动,比如上臂、下臂、手和手指。在此,服务机器人17在时间进程内跟踪服务机器人17如上所述识别到的运动,这或者通过2d摄像头和openpose等架构或者3d摄像头(必要时通过rgb-d摄像头185)实现,其中比如借助视觉上的人跟踪模块112和/或基于激光的人跟踪模块113进行分析。rgb-d摄像头185上的流程为将3d图像在步骤2805中转换为散点图,在步骤2810中为每个点分配一个空间坐标,通过摄像头架构或现有技术的其它软件工具在步骤2015中进行骨架模型识别,其中能够识别骨架的关节点。随后,在步骤2820中进行关节选择,即在此有目标地识别关节点,比如肩关节、肘关节、手关节和指关节。在步骤2825中计算这些关节点的角度,在这些关节点上例如通过方向矢量来定义角度,这些方向矢量取关节点作为原点。在步骤2830中,在特征提取的范围内,在时间进程内检测这些肢体的角度。然后,对肢体进行如此分类,从而将每个时间单位内的角度变化次数、速度,即例如角速度等作为衡量运动强度的尺度。在此,服务机器人17在步骤2835中在1至4的标度内对这些运动进行分类,并保存该值。值1相当于在跟踪时间内无运动。值2相当于手臂运动少和/或运动缓慢,3相当于手指有运动,4相当于手指运动强度大,它们例如通过每个时间单位内的手指运动数和/或其速度来定义并且它们与阈值有关。

281.疼痛状态:疼痛发声

282.测试的第三部分侧重于患者的疼痛发声,能够分两个原则上不同的流程进行,它们面向不同的场景并且表现为两种评估变型方案。第一个场景涉及接人工呼吸的患者,其中基于咳嗽来评估发声。第二个场景下,患者不接人工呼吸并且评估典型的疼痛声。在此,在图29中详细描述了这种处理方法。

283.疼痛状态:接人工呼吸患者的疼痛发声

284.第一变型方案中涉及接人工呼吸的患者。他们或者插有气管插管,这种气管插管通过在颈部中的开口来保证人工呼吸,或者插有气管插管,这种气管插管能够用嘴进行人工呼吸。借助图像识别算法,服务机器人17能够在步骤2901中识别接人工呼吸的患者。为

此,作为2d或3d图像来记录患者头和颈部区域,这些区域在第一步骤中作为候选区域使用,其中如果使用气管插管,则将颈部作为候选区域,如果使用气管插管则将嘴部作为候选区域。例如与基于梯度直方图(hog)的面部识别相结合在步骤2905中识别候选区域,并在步骤2910中识别由此推导出的候选区域,如嘴部和颈部。相应地分析两个区域。在此,以模型假设为基础,即这种插管典型地所具有的形状(步骤2915)。随后,通过可选的实时和容错分段算法2920分析由摄像头185拍摄的像素,以识别这类插管。由此,服务机器人17能够探测插管。

285.作为替代方案和/或补充方案,在步骤2902中能够进行基于数据库的识别,其中服务机器人17在步骤2925中通过接口188(诸如wlan)从基于云的数据库查询有关患者呼吸的信息以及在步骤2927中查询云18中的患者信息,和/或这些信息与其他患者数据一起保存在服务机器人17的存储器10中(步骤2929)。

286.服务机器人17针对这两种人工呼吸的情况测定患者在多大程度上正常呼吸,或者甚至咳嗽2930。能够通过不同的方式来进行测定过程。一个场景下,服务机器人17在步骤2935中在此使用来自呼吸机和/或转接器的数据,该转接器位于插管和呼吸机之间。服务机器人17在一个方面在步骤2936中通过接口188(诸如wlan)访问所使用的呼吸机,并且检测由呼吸机进行的呼吸循环的分析曲线,由压力和/或流量传感器检测这些分析曲线。在步骤2941中将记录的曲线走向与阈值进行比较,这些阈值对于不同的人工呼吸场景、比如压力或容积受控的人工呼吸而言是典型的,并且在咳嗽时在这些人工呼吸场景下出现这种阈值。作为替代方案和/或补充方案,在这些情况下比如也能够比如由医务人员打标签,以识别非典型的人工呼吸模态,比如咳嗽,这能够通过机器学习算法和/或神经网络在步骤2942中将其分类为咳嗽。作为替代方案和/或补充方案,能够分析关于时间的曲线走向(压力、容积、流量),并且识别时间进程中的异常,即通过机器学习方法和/或神经网络将在呼吸周期前后不再出现的偏差分类为咳嗽。在此,不仅能直接在步骤2942中比较周期前后的异常,还能够相应地探测多个周期的一条链,比如涉及多种咳嗽事件的咳嗽发作。在呼吸机甚至通过调整人工呼吸来支持咳嗽的情况下,通过服务机器人17也能够识别呼吸机的相应模态,作为替代识别由此推导出的人工呼吸曲线(关于时间的压力/流量),并且在步骤2944中对患者的人工呼吸进行相应分类时予以考虑。作为替代方案和/或补充方案,服务机器人17也能够从呼吸机获取正处于咳嗽支持模式或者触发咳嗽的信息,由此系统可能会探测到咳嗽事件。作为替代方案和/或补充方案,能够通过接口188(诸如wlan)访问呼吸机的分析结果,也能够在步骤2937中访问转接器,该转接器能够在插管和呼吸机之间通过压力和/或流量传感器测量输送软管中的压力和/或流量,并且通过接口188向服务机器人17例如无线地传输信号,之后创建相应的人工呼吸情况的相应的分析结果,从而能够如上所述那样对其进行分析。

287.作为替代方案和/或补充方案,能够通过至少一个位于患者身体上的传感器进行探测,步骤2950。这一方面包括比如在胸腔、颈部或面颊区域使用的惯性传感器2952(比如带有磁力计)、应变传感器2954(比如安置在患者皮肤部位上的应变测量带)、接触式麦克风193(步骤2956)(它同样安置在患者皮肤上,在一个方面位于紧邻皮肤下方的骨头上,它们能够检测咳嗽声)、例如位于鼻子上或者鼻子内的热敏电阻2958,并且它们分别通过接口188(诸如wlan)与服务机器人17无线地连接。在此,既与这些传感装置直接连接,也能够访

问由传感装置生成并保存在存储器10中的数据,比如医院信息系统。在此,能够分析咳嗽信号方面的数据,或者在服务机器人17内进行分析。

288.drugman等人,2013,“针对自动咳嗽探测的传感器相关性的客观检查,生物医学和健康信息学的ieee杂志,17卷(3),2013年5月,699-707页(doi:10.1109/jbhi.2013.2239303)已经表明,与前一章节使用的传感器相比,通过麦克风193探测咳嗽具有最好的效果,其中仅将未插管的患者纳入观察范围,虽然在这种情况下患者有气管插管或者气管插管能够用。基于此,在一个方面使用至少一个麦克风193(步骤2960),该麦克风位于患者和/或患者房间的其他位置上,并且直接(或者间接与存储器10中服务机器人17能够访问的数据文档连接(在一种变型方案中存档也已经包括在咳嗽信号方面经过分析的数据))与服务机器人17连接,比如所述至少一个麦克风193集成2962在服务机器人17中,在服务机器人17的存储器10中记录患者的周围环境中的噪音,并且之后将声音信号进行是否出现咳嗽的分类。在此,比如使用已经借助记录到的咳嗽噪音进行练习的机器学习和/或神经网络算法。

289.为了创建这样的分类,在一个方面能够训练一种系统,该系统具有至少一个用于处理音频数据的处理器和至少一个音频数据存储器,在音频数据存储器中保存有音频数据,所述音频数据在一个方面也能够作为光谱数据存在并相应地对其进行打标签。

290.在一个替代的和/或补充的方面,服务机器人17的3d传感器,比如3d摄像头,能够测定嘴部周围的运动,然而也包括胸腔和/或颈部的运动,即通过容错分段算法2976分析所述的候选区域2974。已经在其他位置描述过如何能够探测嘴部。根据胸部和腹部的探测结果比如通过肩关节点高于骨架模型的距离来测定候选区域2974,并且与该线条正交向双脚方向测定相同的距离,以识别床单下面的躯干的由胸腔和腹部组成的候选区域,所述胸腔和腹部两者在呼吸时会运动,从而能够分析它们。作为替代方案和/或补充方案,候选区域2974比如也能够通过从颏部向下延伸的两倍头高、约2.5倍头宽来测定。在这两种情况下,在此将头识别为初始步骤,并且由此用作参考2972,由此从那里能够识别候选区域。作为替代方案和/或补充方案,也能够将床的尺寸用作参考2972,以识别候选区域2974。作为替代方案和/或补充方案,也能够使用3d摄像头检测床单表面的突起情况,其中在一个方面进行梯度直方图评估,以分类为基础进行分析,通过一个系统对这种分类进行练习,该系统包含床的2d或3d图像作为输入参量,之后标识床上是否有患者,并且通过机器学习和/或神经网络领域的分类方法对它们进行分析,同时分析结果构成了尤其能够探测患者的上半身的分类。

291.在步骤2978中,在特征提取的范围内,在时间进程中分析由3d摄像头检测到的嘴部、面颊、颈部和上半身的运动。在此,根据martinez等人2017年“真实条件下由深度摄像头在睡眠期间进行的呼吸速率监控”,2017年ieee计算机视觉应用的冬季会议(wacv),2017年3月24-31日,(doi:10.1109/wacv.2017.135)进行干扰降低2980,它以运动探测为基础,这些运动被布料或床单盖住,尤其是上半身/腹部。通过测定功率密度谱消除因所检测到的床单移动各个阶段产生并且加剧其自身呼吸运动检测难度的干扰,这有助于检测胸腔的运动。在此,比如在步骤2982中例如借助快速傅里叶变换(fft)分别为时间进程中检测到的三维空间中的每个像素测定功率密度谱,之后在步骤2984中聚合所有像素的功率密度谱,并且在步骤2986中通过二次插值测定最大值,其中在步骤2988中最大值的位置说明了呼吸频

率。随后,根据频率变化监控它们,这些频率变化在步骤2990中表现为咳嗽。随后,在步骤2990中测定检测到的肢体的频率2990。比如在此,在步骤2990中考虑使用梯度直方图计算。在步骤2992中基于通过咳嗽运动和非咳嗽运动记录生成的分类进行随后的特征分类,为此能够使用标准分类法和/或神经网络,如在本文其它位置所作的描述一样。如果通过上述方案未探测到咳嗽,则将该标准评估为1分。如果探测到咳嗽,则评估为2分。

292.对这一流程的总结说明如下:检测人,识别面部和颈部,按照描述用于进行人工呼吸的装置的模态来分析面部和颈部区域,在探测到描述用于进行人工呼吸的装置的模态时保存值,其中用于进行人工呼吸的装置描述一种疼痛状态。

293.疼痛状态:无人工呼吸患者的疼痛发声

294.如果服务机器人17通过所实施的图像识别未识别到患者身上有插管,和/或在带有患者信息的数据库中未保存关于人工呼吸的信息,则执行本测试的第三部分的另一变型方案,其中服务机器人17通过麦克风193分析患者发出的噪音。使用基于打标签的噪音数据已经训练的算法通过机器学习算法和/或神经网络算法对这些噪音进行分类,由此通过噪音能够识别有不同特点的疼痛发声。如果未发现疼痛发声,则将该标准评估为值1。如果在少于3秒的持续时间内检测到频率小于每分钟三次的疼痛发声,则将该标准评估为值2。将增加的频率或更长的持续时间评估为值3,同时检测在一个方面也能够通过与患者的对话来测定的口头疼痛发声,将该标准评估为值4。

295.将这三部分测试的评分最终相加。结果保存在数据库中,所述结果在一种变型方案中能够通过接口188(诸如wlan)向云18中的服务器传输并且保存在那里。在两种变型方案中,医务人员能够访问分析结果,由此也能够详细观察测试结果(部分结果和整体结果),并通过终端在视觉上显示这些数据。在一个替代的和/或补充的方面,也能够相互独立执行各个测试部分。

296.总之,对以无人工呼吸患者的疼痛发声为基础测定疼痛状态的方法总结如下:记录声音信号,通过疼痛分类来分析声音信号,以便测定记录到的声音信号是否代表一种疼痛发声,通过疼痛程度分类来评估被分类为疼痛发声的声音信号,其中疼痛程度分类包括将标度值分配给记录到的声音信号,并且每个标度值代表一种疼痛状态。在一个方面,附加地执行以下步骤:确定声音信号的来源位置,确定测定人疼痛状态的位置,通过与阈值(即在位置值的最低相似性方面)进行比较调整所测定的位置,并且在与所测定的疼痛状态相比低于阈值时保存一个值。

297.在图66中对用于测定人的疼痛状态的系统总结如下:该系统或服务机器人17包括处理单元9、存储器10和用于非接触地检测人的传感器,比如2d和/或3d摄像头185、激光雷达1、雷达和/或超声波传感器194。视确定疼痛状态方式的配置而定,在其存储器10中可能有不同模块。在一个方面,系统具有人识别模块(110)、视觉上的人跟踪模块(112)、用于识别面部的面部识别模块5005、用于在面部中的候选区域中进行选择的面部候选区域模块5010、用于对表情的候选区域的表面弯曲进行分类的情绪分类模块5015和用于测定情绪标度值的情绪评估模块5020。比如系统具有用于识别床的床识别模块5025和/或用于探测人上肢、在时间进程中跟踪上肢并分析躯干与上臂、上臂与下臂和/或指关节与掌骨之间每个单位时间内角度变化强度、其速度和角度变化次数的上肢分析模块5035以及比如具有用于测定疼痛状态的标度值的疼痛状态计算模块5040。在一个方面,该系统包括用于记录声音

信号的麦克风193,比如用于分析声音信号来源位置的音频源位置测定模块(4420)以及用于将音频信号与人对应起来的音频信号-人模块(4430)。系统比如能够具有用于对声音信号的强度和频率进行分类并测定代表疼痛发声的标度值的疼痛发声模块(5055)。在一个方面,该系统包括用于识别用于进行人工呼吸的装置的人工呼吸装置识别模块5065,即选择人工呼吸的候选区域,通过对象识别分析人工呼吸的候选区域以及用于识别插管、比如气管插管或气管插管的对象分类装置。此外,能够通过用于分析固定在人身上的传感器(比如惯性传感器、应变传感器、接触式麦克风和/或热敏电阻)的疼痛敏感度分析模块5085检测运动、气流和/或声音,和/或在疼痛表现方面对它们进行分类。在一个方面,该系统具有人身份识别模块111、运动分析模块120、骨架创建模块5635和/或基于骨架模型的特征提取模块5640。

298.测定血压和测定其他心血管参数

299.服务机器人17还配备有一个系统,它能够检测人体的重复活动,它们与每次心跳时从心脏向主血管输出的血液相关联。在此,将检测通过主血管运动产生并且例如在体内呈波形传播的和/或因皮肤中的动脉运动产生的运动的变化。后者更能够耐抗身体部位的光照波动和/或皮肤的不同色调。作为替代方案和/或补充方案,将例如在时间进程中检测皮肤中的血量或者血液流动的变化,所述血量或者血液流动与心跳相关联。图30示出了数据检测和分析的过程。

300.在步骤3005中识别身体区域和多个部分区域。比如,身体区域包括面部,其中比如通过摄像头185进行分析。该系统使用来自现有技术的算法、比如opencv、openpose或dlib架构来检测和跟踪面部(也替代地包括其它身体区域),其中比如借助视觉上的人跟踪模块112和/或基于激光的人跟踪模块113进行分析。在此,作为部分区域至少检测前额、面颊或下巴,比如共同检测多个身体区域,之后单独和/或分开根据下面说明的步骤对其进行分析。在此,比如能够选择候选区域,即面部的、与分析有关的部分区域,为此能够使用在现有技术中已知的分段方法(诸如ransac)。能够跟踪这些部分区域,也包括跟踪在时间进程中在步骤3010中通过所述的架构来跟踪的身体区域。

301.在可选的步骤3015中,将摄像头185尽可能与应跟踪的区域平行对准。为此,能够将面部的检测角度降至最小幅度,该检测角度由垂直于检测面部的摄像头的轴线和垂直于面部的矢状平面的轴线得出。在此,系统比如测定一个面部能够在其中延伸穿过并且基本上与面部的俯视图平行并例如与矢状平面相符的平面。基于例如梯度直方图(hog),系统具有一种描述与该俯视图偏差的分类方法,进而能够检测面部在三维空间中的倾斜度。在一个方面,系统利用该处理方法评估看向系统的摄像头185的面部在多大程度上与摄像头镜头平行对准。如果出现偏差,系统在一个方面能够通过相应的机械装置,比如翻转单元5130,例如通过操控两个带有相互正交布置的翻转轴线来调整摄像头185在三维空间中的倾斜度,通过伺服电机来驱动所述翻转轴线。因此,翻转单元这一术语在本文中指至少有两根轴线的翻转单元,它一方面能够实现水平平面的倾斜位置,另一方面能够绕着垂直轴线旋转。作为替代方案和/或补充方案,如此操控服务机器人17的轮子,使服务机器人17向人的方向旋转,以便减少摄像头平面与面部平面的所测定的偏差。在一个替代的和/或补充的方面,这种偏差会触发服务机器人17的语音输出,为患者提出相应地对准其面部的指示。在此,比如保存有当在xy平面中发现偏差时请求在xy平面中进行对准的规则。例如,如此长时

间地校准面部倾斜度和操控翻转机构、确定服务机器人17的朝向和/或根据患者进行语音输出,直至摄像头平面与面部平面之间的角度达到最小。作为替代方案和/或补充方案,摄像头185相对于矢状平面和必要时也相对于横向平面的检测角度能够得到最小化,这例如也包括机器人17的行驶移动性。

302.在一个可选的方面,系统在步骤3020中被配置用于照亮身体部分,比如面部。也就是说,在通过摄像头185拍摄期间用一只照亮患者的待拍摄的身体部位的灯来照射面部(或其他身体部分)。在此,使用至少一只灯,它比如位于摄像头185附近。这盏灯在理想情况下位于摄像头185下方和/或上方,即与摄像头185垂直放置。比如所发射的光会散射,以保证尽可能均匀地照亮有待拍摄的面。视面部位置及其尺寸而定,摄像头185的侧面布置要尽可能使鼻子能够产生阴影投影,这种阴影投影碰到位于鼻子侧面并且其记录能够提供超出平均水平的信噪比的面颊,这必要时可能造成分析质量变差。

303.所使用的摄像头185为分析提供了至少一个颜色通道,其中比如包括至少一个绿色信号通道,因为在此能够由血红蛋白特别良好地吸收所发射的光。摄像头185在另一方面也能够提供橙色和/或青绿色色调的颜色通道。每个通道的色深例如为至少8位,帧频为每秒30张图片。在一个方面,摄像头185可能是一种rgb-d摄像头185,除颜色识别以外,它还能够比如基于飞行时间传感装置或speckle模式来提供深度识别,以便检测有规律的血管血液流动和有规律的血管膨胀。

304.在第一步骤3025中进行信号提取。为此,首先以被跟踪的区域的视频信号为基础选择输入信号,这或者能够是由心脏的泵送规律引起的运动和/或根据血液、尤其是血红蛋白的流动而产生的颜色变化,由此能够检测所述的有规律的血管血液流动和/或有规律的血管膨胀。

305.在第二步骤中根据原始数据在纳入已知信息情况下进行颜色通道分析,确定哪些特征由哪一颜色通道来映射,前提是这涉及到血液流动的检测。这尤其指在步骤3030中的通道权重。在此,尤其能够分析绿色颜色通道、绿色和红色颜色通道(比如为观察绿色和红色通道的差异)、绿色、蓝绿色和橙色等的组合。为了检测运动,能够作为对此的补充方案或者替代方案测定位置分辨率。也就是说,跟踪已检测的面部属性的垂直和/或水平运动,比如检测和分析面部位置及其在时间进程内的部分区域。这既包括头的运动,也包括各个面部部分。

306.随后进行的信号测定在第一个分步骤(预处理3035)比如使用至少一个滤波器。这可以包括趋势调整(比如通过缩放和/或标准化);平滑的平均值观测、高通滤波;带通滤波,必要时设计为自适应带通滤波;幅度选择滤波;kalman滤波;和/或连续小波变换。作为替代方案和/或补充方案,也能够使用最小二次幂的线性多项式近似法。

307.随后,使用信号分离法3040,以便改善信噪特性并且减少观察到的特征维度的数量。在此,比如能够使用主分量分析或独立性分析,在一个方面也能够使用机器学习方法。

308.信号处理3045包括在傅里叶变换的范围内测定脉搏率和必要时其他参量(快速或离散的傅里叶变换,尤其是为测定最大的功率谱密度)、自回归模型(比如通过burg法)、与探测最大值,比如识别波峰相关联使用带通滤波器、连续小波变换和/或机器学习模型,尤其是非监控学习。作为替代方案和/或补充方案,也能够使用离散的余弦变换。

309.在后处理3050的范围内,另外还能够使用不同的方法,以便补偿比如因头运动等

产生的错误,为此又能够使用卡尔曼滤波器、(自适应)带通滤波器、离群值检测、平滑的平均值、贝叶斯融合和/或机器学习方法。

310.截止目前进行的处理步骤已经反映了一部分医学相关参数,比如脉搏率、脉搏率差异性、脉冲波传播时间、脉冲波形等。在步骤3055中继续计算医学相关参数,比如以在现有技术中有关描述的不同的方案为基础,由此能够测定心脏收缩和心脏舒张血压,为此能够使用线性或非线性预测法。

311.所提及的机器学习方法,比如卷积神经网络等神经网络,能够识别数据中隐藏的且部分未知的特征,并在分析时予以考虑,比如在所执行的聚类分析的范围内加以考虑。在此,比如以训练数据为基础生成分类或线性和非线性预测模型的权重,之后能够在生产运行的所述流程范围内使用它们。

312.在一个方面,将测定的脉搏率、脉搏率差异性值和必要时其他值在进行完后处理之后与保存在存储器10中的值在一个步骤中进行比较,以此为基础来测定脉搏率、脉搏率差异性或其他参量,尤其包括心脏收缩血压和心脏舒张血压。

313.根据待探测的参量在预处理和后处理的范围内进行滤波。在一个方面对于脉冲幅度能够使用带通滤波器,它覆盖的频谱为0-6赫兹,比如至少0.7-4.5hz。在一个方面,也能够在这一频率范围内更小范围地进行脉冲信号采样,比如在0.1hz的窗口范围内。随后,能够通过低通滤波器进行平滑化处理。比如能够通过的宽度范围为0.7至4hz的带通滤波器来处理脉搏率、心率或脉搏频率或心脏频率。为了测定脉搏率差异,又能够使用窗口范围为0至0.4hz的带通滤波器,在一个方面,以0.02hz的间隔进行采样。能够通过比较检测到的至少两个区域的值获取脉冲波传播时间,其中能够在0.5至6hz的带宽范围内进行分析,在一个方面,以0.1hz的间隔进行采样。通过比较多个区域的值能够测定脉冲波传播时间。在约0-6hz的频谱范围内由未采样的走势产生脉搏形状,比如通过曲线下方的面积、高度和/或宽度表现其特征。通过这些值的一阶导数得出脉冲能量。

314.由此比如能够通过脉冲波传播时间和脉搏率或心率以及之前的血压值通过线性模型测定血压,并且能够将其用于线性回归模型或神经网络。例如也通过测定脉冲曲线和延伸穿过最大值的垂线之间的差能够分析测得的脉冲的形状,由此取代之前的血压值。

315.如在图67中所示,用于测定血压的系统的图示如下:用于测定人心血管参数的系统在一个方面即服务机器人17,包括处理单元9、存储器10和摄像头185(比如2d和/或3d摄像头)以及此外包括用于探测身体区域的身体区域探测模块4810、身体区域跟踪模块4815、面部识别模块5005、面部候选区域模块5010和用于检测由心血管活动所产生的运动的心血管活动模块5110。摄像头185提供了至少一个8位绿色颜色通道。该系统另外还有灯5120,以在通过摄像头185记录期间照亮面部,该灯比如位于摄像头185的上方和/或下方。系统具有能够测定心脏收缩血压和心脏舒张血压5125的血压测定模块5125和/或一个翻转单元5130,以便最大幅度缩小摄像头185相对于矢状平面的检测角度。为此,该系统具有一些规则,以便例如将垂线放在被检测的人的双眼之间,从而将头分为两半。对面部进行分段,其中在各个分段上方放置梯度直方图。如果它们具有低于某一阈值的(镜面相反的)相似性,则将面部感知为垂直监控的状态。现在,能够通过翻转单元5130来如此操控摄像头185,从而在操控期间,通过梯度直方图来比较镜面相反的两半面部,并且如此定位摄像头,从而确保低于梯度直方图的阈值。在一个方面,该系统具有人识别模块110、人身份识别模块111、

视觉上的人跟踪模块112、运动分析模块120、骨架创建模块5635、基于骨架模型的特征提取模块5640和/或运动规划器(104)。探测皮肤表面上或者下方的物质

316.在一个方面,服务机器人17同样配备有探测器195,该探测器比如位于服务机器人17的面向患者的一侧上。该探测器195在一个方面固定地集成在服务机器人17的表面内或表面上。在一个替代的和/或补充的方面,探测器195安装在执行器4920上,比如机器人手臂上,并且之后如示例性地针对将光谱仪196与患者皮肤对准所描述的那样,能够与由服务机器人17识别到的患者身体表面对准,并且在一个方面,以这种方式触碰患者的皮肤。作为替代方案和/或补充方案,服务机器人17还能够请求患者触碰探测器195,比如用手指进行触碰。在此,在一个方面,服务机器人17能够验证患者是否真的接触了探测器195。在一个方面,能够通过试测量进行验证,其中将检测到的值与保存在存储器10中的测量间隔进行比较,以便评估患者是否真的已将手指放到探测器195上。但在该方案中无法排除测量结果可能受到手指在传感器上的朝向的影响。因此在一个替代的和/或补充的方面,基于摄像头跟踪手指,其中例如借助视觉上的人跟踪模块112和/或基于激光的人跟踪模块113进行分析。已经在本文献的其他位置中描述过这类跟踪。作为替代方案和/或补充方案,能够使用基于对话的方法,其中由服务机器人17询问患者,该服务机器人17是否正确放置了手指,这能够通过显示器2和/或语音输出的方式来进行。

317.探测器195的表面由晶体构成,比如有立方体晶格结构(比如金刚石结构)、六角形晶格结构或四边形晶格结构的晶体。晶体的折射率为1-4,比如1.3-1.4,2.2-2.4或者3.4-4.1。晶体的频谱宽度的间隔为100nm

–

318.20000nm,比如间隔900nm

–

12000nm。探测器195的测量方法在此利用分析激光器5205基于物质的激光感应的激励而在晶体表面上发生的偏转,由患者皮肤上和/或内的另一个激光器5210激励这些物质。在此,通过另一个激光器5210激励过的面例如与探测器195在分析激光器5205在晶体表面上偏转的位置上接合。为进行分析会进行特征提取,其中特征包括另一个激光器5210的波长变化和由此造成的、由基于光电效应的传感器检测到的分析激光器5205的偏转。在此,能够使用在图30中示出的步骤,尤其是3025-3050,在其他位置中已对此有详细描述。随后,通过与保存在存储器10中的特征分类进行比较,将这些特征分类。在此,为例如特定波长和/或另一个激光器5210的波长变化以及基于此的分析激光器5205的偏转分配特定的物质及其浓度。随后,将保存所测定的分类并且通过显示器2输出和/或保存在患者管理模块160中。

319.在一个替代的和/或补充的实施方式中,使用基于摄像头的系统,它对准患者的皮肤表面并且能够执行测量。在此,在一个方面,系统固定安装在服务机器人17上,或者比如能够如此地三维对准,由此能够检测患者的皮肤表面,而患者不需要移动。在此,如针对探测情绪所描述的那样,服务机器人17比如探测应检测患者的皮肤表面的患者区域。

320.通过至少一个摄像头185照亮待检测的皮肤表面,为此在一个方面使用led灯,它在550-1600nm范围内,比如至少在900-1200nm范围内形成光谱,因此它属于红外波段。在此,至少一个摄像头185的传感器是基于砷化镓铟或硫化铅的传感器,在一个方面为该传感器补充有基于硅的传感器,该基于硅的传感器必要时集成在另一个摄像头185中。在一个方面,能够用激光器取代led灯。如此操控光源,从而光源的波长在时间进程内发生变化。在此,至少一个摄像头185检测通过光激励的皮肤上或皮肤内物质的发射。测量期间进行特征

提取,它测定皮肤上和皮肤内的物质发射的相和频率,在一个方面同样考虑所发射的光的频率。在此,能够进行预处理和/或后处理,其中使用不同的滤波器,比如带通滤波器和/或低通滤波器。总之,在此也能够进行在图30中示出并且在其他位置处详细描述的步骤3025至3050。随后,基于特征提取来确定物质的浓度。

321.如在图68中所示,用于物质测量的系统的图示如下:用于测量人皮肤上和/或皮肤内的物质的系统在一个方面即服务机器人17包括带有分析激光器5205和另一个激光器5210的探测器195,其中分析激光器从进入介质5215起比如偏转一个晶体表面,并且另一个激光器5210通过波长的变化来激励物质,其中经激励的物质的区域在分析激光器5205偏转的位置上与介质5215(诸如晶体)接合,另外所述系统包括用于对另一个激光器5210的波长变化进行特征提取和特征分类的激光器变化模块5225以及用于对分析激光器的偏转进行分析的激光器偏转分析模块5220。系统比如具有用于非接触地检测人的传感器,用于分析人在时间进程中运动的运动分析模块(120)和/或用于自动识别手指在介质5215上的定位并在将手指放到介质上之后执行测量的手指定位识别模块5230。用于测量人皮肤上和/或皮肤内的物质的系统在一个方面包括例如服务机器人17、带有介质5215的探测器195,这种介质具有立方体、六角形或四边形晶格结构,折射率为1-4,并且频谱宽度间隔为100nm-20000nm。系统此外包括分析激光器5205和另一个激光器5210,其中分析激光器5205从晶体表面起比如偏转,并且另一个激光器5210通过波长的变化激励物质,其中经激励的物质区域在分析激光器5210偏转的位置上与介质5215接合。另外,系统可包括用于对另一个激光器5210的波长变化进行特征提取和特征分类的激光器变化模块5225以及用于对分析激光器5205的偏转进行分析的激光器偏转分析模块5220。通过基于光电效应5250的传感器对分析激光器进行分析。该系统另外还能够包含用于将数据传输到患者管理系统160的接口。探测器195能够定位在执行器4920上,并且系统具有包含规则的模块,以便能够将探测器195定位在人的皮肤上,比如通过平衡性执行器4920和应在上面定位执行器的位置,并如此操控执行器,使执行器4920与应在上面定位执行器4920的位置之间的距离降至至少接近零。此外,该系统具有用于非接触地检测人的传感器,比如2d和/或3d摄像头185、激光雷达1、雷达和/或超声波传感器194。在一个方面,系统具有身体区域探测模块4810和用于跟踪测量区域的身体区域跟踪模块4815。在一个方面,用于测量人皮肤上和/或皮肤内的物质的系统配备有摄像头185和能够水平和/或垂直对准摄像头185的翻转单元(5130),配备身体区域探测模块(4810)和用于在时间进程内识别人身份和跟踪人的身体区域跟踪模块(4815)(在一个方面与人身份识别模块111和跟踪模块112及113相同),并且配备有至少一个能够照亮人的待检测的皮肤的光源5270,其中系统具有使由至少一个光源发射的光的波长发生变化的波长变化单元5275以及用于分析检测到的信号的波长变化的波长变化分析单元5280。至少一个光源5270可以是激光器(在一个方面与激光器5205和/或5210相同)和/或多个有不同频谱的led灯,能够对这些灯进行相应操控。所发射的光的波长能够为550nm至1600nm,比如900至1200nm。摄像头185比如能够具有一个砷化镓铟或硫化铅材质的光探测器。在一个方面,该系统具有另一个用于探测频谱为400-800nm的光的摄像头185。所述系统比如能够具有用于对检测到的数据进行特征提取和特征分类并将分类后的数据与物质分类进行比较的材料分类模块5295,即通过将分析过的特征与保存的特征进行比较,例如至少分析探测到的光。在一个方面,该系统具有人识别模块110、人身份识别模块111、跟踪模块(112、

113)、运动分析模块120、骨架创建模块5635和/或基于骨架模型的特征提取模块5640。

322.湿度识别和机器人导航

323.在服务机器人17在其中进行移动的周围环境内可能出现,服务机器人17以及由服务机器人17跟踪的人在上面移动的地面变得潮湿的情况,这比如因清洁作业或液体洒出造成。根据被服务机器人17引导进行练习的人,这种潮湿的表面可能构成威胁,伴随着增加的跌倒危险。为了降低人受伤风险,服务机器人17在一个方面有相应的传感装置,以便识别地面的湿度。在现有技术中描述了在此使用的不同的传感器技术:

324.yamada等人2001年“辨别道路状况以了解车辆驾驶环境”,ieee 智能交通系统论文集,第2卷(1),2001年3月,26-31(doi:10.1109/6979.911083)描述了一种通过入射光的极化来探测地面上的湿度的方法。在此,使用布儒斯特角(53.1

°

)作为倾角,以便在水平极化面中将反射设置为0,而垂直极化表现出较强的反射。在此,以测量所得的水平和垂直极化的强度关系为基础,确定经测量的表面上有多大程度的湿度。

325.相反,roser和mossmann,“单色图像上的天气情况分类”,2008年ieee智能车辆系统研讨会,2008年6月2-6日(doi:10.1109/ivs.2008.4621205)提出了一种方案,它没有极化滤波器并且以作为特征从图片中提取的对比度、亮度、清晰度、色调和饱和度等图片参数为基础。在此,通过在图像处理时建立的koschmieder模型考虑亮度,其中亮度尤其与光的衰减和散射有关。又能够通过局部的亮度极值的差测定对比度,其中在此相互比较被观察区域中的最亮和最暗的像素。在清晰度方面,这套方案以图像处理时建立的tenen度标准为基础。通过定义的像素组测定色调和饱和度。针对每个被检测的区域,为每个特征生成一个有10个区域的直方图,并且由此推导出一个矢量,它包含各个特征的结果。通过机器学习/人工智能方法对这些矢量进行分类,其中包括k-nn、神经网络、决策树或支持向量机。在此,首先提供在练习算法前事先加了标签的数据,其中在此所测定的分类允许对未来拍摄的地面图像进行如下评估,从而确定地面有多湿。

326.相反,申请号为2015/0363651a1的美国专利申请分析由摄像头拍摄的表面纹理,以检查其湿度,并在此比较在不同时间点拍摄的两个图像,进行特征提取。特征包括一个区域内的像素的空间接近性(即搜索重复出现的模态)、边缘检测及其空间朝向、图像之间灰度的相似性、既定的laws纹理能量量度、自相关和功率密度模型,以及纹理分段(基于区域和基于边界,即位于有不同纹理的像素之间的边缘)。

327.相反,mcgunnicle,2010“使用近红外照明来检测潮湿表面”,美国光学学会杂志a,第27卷(5),1137-1144(doi:10.1364/josaa.27.001137)使用频谱约960nm的红外线二极管,并且通过rgb(ccd)摄像头来记录由这些二极管发射的光,以便相应地分析光谱。在此,mcgunnicle描述到,潮湿的表面会发射表征性的频谱,由此能够探测表面上的潮度。

328.另一套方案是使用可见或不可见雷达波范围的光、尤其是超宽带宽雷达波,进行物质分析。能够在现有技术中所描述的那样来分析反射的信号(即分类),其中在测量表面上的湿度时能够识别到表征性的特征,由此能够探测到湿度的类型。

329.在任何情况下,传感器被如此布置在服务机器人17上,从而传感器至少能够检测服务机器人17前方或下方的表面,在一个方面也能够在侧面或向后指向。

330.在一个方面,在服务机器人17的存储器10中保存有用于测定湿度的算法,比如作为值保存在数据库中,由此允许根据频谱分析检测到的红外波段光谱,或者由服务机器人

17发射并且被表面反射的雷达波。服务机器人17在一个替代或补充的方面具有一套自学系统3100(参见图31),以便区分湿地面和干地面。这套自学系统比如尤其能够为测定表面的纹理和/或反射的光学方法提供帮助。为此,服务机器人17驶过服务机器人17通常在其上方移过的表面3110,而这些表面处于干燥的状态下。在此,服务机器人17通过至少一个集成传感器记录表面,步骤3120,进行特征提取,步骤3130,比如根据roger和mossmann的方案或者根据申请号为2015/0363651a1的美国专利申请的教导。这优选在不同日间时间进行,以便考虑不同的光线条件(日光、人工照明和/或两者的组合)。通过在一个方面通过接口188(诸如wlan)与服务机器人17连接的输入装置为所记录的测量值分配一个值,该值将记录的表面表征为干燥的(打标签3140)。在步骤3145中将该值与记录的测量值一起保存在存储器10中。在另一个步骤3150中,服务机器人17部分地重新驶过之前驶过的面,但其中之前驶过的面是潮湿的。为此,在一个方面中通过接口188(诸如wlan)与服务机器人17连接的输入装置用于为记录的测量值分配一个值,该值将记录的表面表征为潮湿的(打标签3140)。顺序是首先驶过干表面还是湿表面(或者甚至调换这一顺序)对这一方法的有效性的影响并不大。随后,通过机器学习/人工智能方法对通过传感器记录的特征进行特征分类3160,如roger和mossmann所示。结果是在步骤3170中将表面探测为潮湿的或干燥的。在步骤3180中将特征分类的结果,即表面是潮湿的或干燥的,保存在服务机器人17的存储器中。

331.当服务机器人17在将来行驶时,服务机器人17能够访问保存的分类(比如针对雷达反射、红外红光谱吸收、光反射或通过摄像头记录纹理),并且通过所保存的这些分类借助其传感器检测到的测量值来分析经检测的表面是否是潮湿的。

332.图32示出了在探测表面3200上的湿度的情况下进行服务机器人17的导航。如果在一个人的陪同下3210导航服务机器人17,比如陪同患者练习,则服务机器人17会记录服务机器人17移过的地面的表面特征,步骤3120。进行特征提取3130、特征分类3160,进而随之进行湿度探测3170。为此,在一个方面,服务机器人17视所使用传感器或实现的分析算法而定,在可选的步骤中通过例如围绕服务机器人17的垂直轴线的旋转运动3220来检测湿度的或者说干燥区域3230的宽度。在一个方面,这一实施方案能够保存在运动规划器104中。视传感器类型和实施方案而定,能够使用翻转单元5130取代服务机器人17的旋转运动,或者传感器的检测角度足够宽,从而即使不移动也能够在行驶方向上检测表面。在此,比如在与行驶方向正交的情况下测定宽度。将干(替代地,湿)区域的宽度与保存在存储器的值进行比较3240。在一个可选的方面,测定潮湿区域宽度与服务机器人17在其中移动的空间宽度的关系。如果检测到的干燥区域的宽度小于保存在存储器中的宽度,服务机器人17不会移至湿的区域,而是停止和/或如运动规划器104中保存的那样在步骤3250中转向。在一个可选的方面,通过输出单元(显示器2、扬声器192、必要时也包括投影装置920/警示灯)进行输出,这种输出指示出被识别为潮湿的表面。服务机器人17在一个可选的方面在步骤3260中通过接口188(诸如wlan)向服务器和/或终端发出一条消息。相反,如果被探测到的干燥区域宽于阈值,则服务机器人17会在步骤3270中被如在运动规划器104中保存的那样导航通过干燥区域。在此,服务机器人17与被探测为潮湿的表面保持保存在运动规划器104中保存的最小距离,步骤3280。服务机器人17在可选的方面能够通过输出单元(显示器2、扬声器192、必要时也包括投影装置920/警示灯)向陪同人员指示出潮湿的表面,步骤3290。

333.在一个方面,湿度的分类也包括潮湿度。由此,比如在本身被感知为干燥的表面上

可能有一层极薄的湿气膜,但该湿气膜对物体在表面上可能会受到的摩擦几乎没有影响。

334.总之,对检测和评估表面上的湿度的方法总结如下:检测一个表面,比如地面,对用于探测表面上的湿度的表面特征进行分类,将检测到的表面分段为潮湿区域和非潮湿区域,测定检测到的区域宽度,通过与保存的至少一个值进行比较,以便评估检测到的区域宽度。

335.一个替代的流程如在图81中所示出的那样在下面总结如下:检测表面6005,对表面进行分类以探测潮湿6010,将表面分段为潮湿区域和非潮湿区域6015,将潮湿区域保存到地图6020中,测定有最小尺寸的面6025并基于它通过输出装置6030输出,传输消息6035和/或修改存储器10中的值(步骤6040)。作为替代方案和/或补充方案,能够修改路径规划和/或运动规划6045。图82同样示出了一部分流程。服务机器人17沿着最初规划的路径6072所述的通过通道6071(参见图82a)移动,其中在地面上有多个由服务机器人检测到的潮湿的分段6070。服务机器人17在路径规划模块103中规划新路径6073,它基于湿度被计算为障碍物。服务机器人17比较比如从保存在地图模块(107)中的地图得出的、被作为障碍物保存的、测定为潮湿的面区段之间的宽度6074,并且与被检测为潮湿的面区段保持安全距离并跟随新计算出的路径(参见图81c)。如在图81d)中可见的那样,被检测为潮湿的面区段的宽度能够确保服务机器人不会围绕着它进行导航,因为被分类为潮湿的区域与通道墙之间的宽度小于服务机器人17的宽度,因此服务机器人17在其前面停止。

336.如在图69中所示出的那样,用于湿度探测的系统的描述如下:它包括用于非接触地检测表面的传感器(比如摄像头185或雷达传感器194)、用于将检测到的表面分段的分段模块5705、用于在表面上的湿度方面对各分段进行分类的湿度测定模块5305和用于评估表面的经分类的分段的尺寸的湿度评估模块5310。此外,它还能够包括地图模块107,其中包含在系统的周围环境中的障碍物以及在湿度方面经过分类的分段。在一个方面,系统包括运动规划器104和/或路径规划模块103、比如输出单元(2或192)和保存在存储器10中的用于指示出被探测为潮湿的面的输出内容。该系统能够是指服务机器人17、比如陪同人员。

337.用于探测表面上的湿度的位置的系统(比如服务机器人17,其在一个方面即陪同人员)包括用于测定的单元(比如摄像头185)、用于将检测到并分段的表面在表面上的湿度方面进行分类的湿度测定模块5305、用于评估表面上的经分类的分段的尺寸的湿度评估模块5310。在此,例如对经分类的面如此进行分析,使湿度宽度与系统的运动方向略为垂直地得到评估,并在其宽度范围内测定干燥和/或潮湿的区域。系统比如能够具有包含规则的运动规划器104,以便在测定其宽度超过保存在存储器10中值的干燥的区域时能够运动通过这一区域。运动规划器104比如能够具有用于测定与潮湿区域的最小距离的规则,比如通过将被分类为潮湿的区域录入到地图中并将自身的位置与地图进行比较。系统具有输出单元(2或192)以及保存在存储器10中的用于指示出被探测的区域为潮湿的和/或发出警告的规则。运动规划器104比如能够具有指引系统的规则,当测定的潮湿区域的宽度超过某一阈值或者测定的干燥区域的宽度低于某一阈值时,能够中断其向规定的目标行进方向的运动,这与现有技术中移动式系统向障碍物运动的规则类似。此外,系统还有用于向服务器和/或终端13发送消息的单元。

338.跌倒的人的分类方法

339.服务机器人17在一个方面具有跌倒识别功能,即服务机器人17被如此配置,从而

服务机器人17能够直接或间接探测人的跌倒。在图33中示出对于跌倒事件的分析过程3300。间接是指服务机器人17访问外部的传感装置,而直接是指通过自身的传感装置进行分析。

340.在一个方面,人配备有用于跌倒探测的传感器单元,即服务机器人17通过接口188(诸如wlan)与外部的跌倒传感器连接,该外部的跌倒传感器位于待监控的人身上3310。该传感器单元包含至少控制单元、电源、可能包含存储器、接口188(诸如wlan)和至少一个用于检测人的运动的惯性传感器3315、比如加速度传感器。在一个方面,在步骤3325中分析传感器单元中的惯性传感器的信号,在一个替代的方面在步骤3320中向服务机器人17传输信号,由此能够在服务机器人17中实现信号的分析3330。接下来,在步骤3335中对检测到的测量值进行分类,确认这个人是否跌倒。比如能够通过测量超过定义的阈值的加速度进行该分类。随后,在步骤3345中基于跌倒探测通过接口188(诸如wlan)发出通知,即比如通知警报系统和/或触发警报等(比如警报音)。如果在传感器单元内对检测到的运动进行分类,则通过传感器单元(通过接口188(诸如wlan))进行通知和/或发出警报。如果服务机器人17执行对于运动的分类,则会触发该通知和/或启动警报。

341.传感器单元在一个方面被如此设计,从而传感器单元为了探测跌倒的严重程度而探测人的运动,为此获取测量值并且直接在传感器单元内和/或通过服务机器人17在步骤3340中对测量值进行分类。这具体是指在这里将检测配备有加速度传感器的人在多大程度上继续运动。为此,能够分析传感器单元的加速度和/或朝向数据。为此,在传感器单元和/或服务机器人17的存储器中保存有如下规则,所述规则基于所测量的运动数据来触发不同的通知。比如当在探测到跌倒之后,传感器单元能够测定超过定义的阈值的运动信息,和/或对它们如此进行分类,从而让跌倒的人能够重新站起来,修改通知和/或警报,比如降低通知的优先级。相反,在出现跌倒事件之后,如果传感器单元未探测到跌倒的人的进一步的运动和/或位置变化,能够修改通知和/或警报,比如提高通知的优先级。在一个方面,只有在分析完人在跌倒之后的运动行为之后,即必要时在实际的跌倒数秒之后才会发出通知或警报,由此必要时能够减少与跌倒事件有关的通知。

342.在一个方面,服务机器人17配备有无线传感器单元,以便能够在步骤3350中测定人的跌倒事件。该传感器单元是指摄像头185或3d摄像头、雷达传感器和/或超声波传感器194,或者至少两种传感器的组合。在此,传感器单元比如用于识别人身份和/或在步骤3355中在时间进程中跟踪人,这比如借助视觉上的人跟踪模块112和/或基于激光的人跟踪模块113来实现。由此,服务机器人17能够配备kinect或astra orbbec,即rgb-d摄像头185,它借助在现有技术中所描述的方法能够(比如通过摄像头sdfk、nuitrack、openpose等)在步骤3360中创建被探测人的骨架模型,在该骨架模型中身体关节被显示为关节点和连接关节点的肢体,比如作为方向矢量。在此,在特征提取3365的范围内测定方向矢量的不同朝向,比如关节点与被探测表面的距离,被探测到的人在该表面上运动。在特征分类3370的范围内,服务机器人17分析被探测人是站立、行走、坐下还是可能跌倒。在此,在一个方面能够固定地规定特征分类的规则,在一个替代的和/或补充的方面能够由服务机器人17自行学习这些规则。在学习时会拍摄跌倒的人的照片,同样会拍摄未跌倒的人的照片,对其进行分析,其中通过打标签来确定这些照片属于哪种情况。服务机器人17以此为基础通过机器学习/人工智能方法能够进行分类,由此在之后能够将人的将来的照片分类为跌倒或未跌倒。

343.在此,比如以在步骤3367中提取以下特征为基础进行跌倒探测,其中根据跌倒分析身体部分,即进行分类:离开地面的距离和距离变化,或者由距离或距离变化推导出的关节点朝一个方向的加速度(比如在定义的最短持时间段内),其垂直方向分量大于水平方向分量,其中垂直方向分量优选朝向地心方向。比如,如果探测到的髋关节点与地面的距离小于20cm,距离变化例如大于70cm至小于20cm,或者髋关节点的加速度同样朝向地面,这会被分类为跌倒事件,其中该加速度比如会低于定义的持续时间(比如2秒)。作为替代方案和/或补充方案,也能够在空间内定向至少一个方向矢量(作为两个关节点之间的连接),或者将空间内的方向矢量的变化分类为跌倒事件。尤其是在变换朝向之后(比如从基本上垂直的方向变换至基本上水平的方向),比如将基本上为水平的脊柱和/或腿的朝向算作跌倒事件也属于此,这可选地在定义的时间段内进行。在一个替代的和/或补充的方面,能够通过3d摄像头测定人的高度。如果人的高度低于定义的高度,则将其探测为跌倒事件。作为人的高度的替代方案和/或补充方案,也能够测定人在地面上所占的面积。为此,在一个方面通过被跟踪的人在地面上的垂直投影来测定面积。

344.在出现经分类的跌倒事件之后,服务机器人17会在步骤3345中触发通知和/或警报,比如通过接口188(诸如wlan),通过扬声器192等作为声音警报发出。

345.针对服务机器人17通过雷达和/或超声波194探测人的情况,为此将主要检测人的外部尺寸,包括其高度。如果在此探测到高度下降,或者高度加速下降,则必要时与低于阈值的情况相结合将其分类为跌倒事件。作为替代方案和/或补充方案,服务机器人17也能够对人在地面上所占的面积进行分类(在示例中垂直投影)。

346.服务机器人17在一个方面在步骤3369中同样检测人的头的位置。根据地面和/或探测到的障碍物(的位置)来跟踪位置。也就是说,比如通过传感器单元(摄像头185、雷达和/或超声波传感器194)来检测所探测到的墙。作为替代方案和/或补充方案,也能够通过激光雷达1来测定墙的位置。服务机器人17将人的头的水平位置与墙和/或其他障碍物在空间中的(水平)位置进行比较。

347.在一个替代的和/或补充的方面,在此同样考虑垂直位置。由此比如摄像头185也能够分析被跟踪的头与物体(比如桌子)在三维空间中的距离。(二维、基本上水平对准的)激光雷达1例如会识别到桌腿,但不必识别人在跌倒的情况下其头可能触碰到的桌面在空间中的位置。相反,基于摄像头的分析允许对头和其它障碍物在空间中进行三维检测,并且测定其它障碍物与头之间的距离,在分类的范围内在步骤3374中对这些障碍物进行分析。如果服务机器人17探测到低于头和其他障碍物之一之间的距离值,则修改服务机器人17存储器中的值并且必要时触发单独的通知或单独的警报。

348.服务机器人17另外还会跟踪跌倒后的人,并且检测他在多大程度上重新站起或者尝试站起,即在步骤3340中进行跌倒后运动检测和分类。大程度是指比如与地面的距离、与地面相反垂直方向中的加速度、定向身体部分或肢体矢量、分析人的高度和/或(投影的)面积。在一个方面,同样分析关节点的位置变化的程度。随后,对人的移动或者甚至尝试起身程度进行分类。由此就将调整服务机器人17存储器中的值,在一个方面通过接口188(诸如wlan)/警报来修改通知的程度。实际上这是指,视跌倒程度而定能够进行不同的警报和/或通知。也能够将通过人佩戴的传感器进行跌倒分类以及在服务机器人17之内通过摄像头185、雷达和/或超声波194进行传感器数据分析进行组合。总之,跌倒事件的评估流程如下:

检测和跟踪人的运动,通过对于人的肢体和/或躯干的朝向进行特征提取和分类来探测跌倒事件,探测和分类跌倒后人的运动以及评估跌倒事件的严重程度。

349.在一个方面,服务机器人17还能够通过其传感装置在步骤3380中检测跌倒的人的生命体征参数。如在其它位置处所阐释的那样,为此例如能够使用集成的雷达传感器、比如超宽带宽雷达。在此,在一个方面能够通过雷达和/或基于摄像头的方法来探测未被衣物覆盖的人的身体部分,并在这些区域内例如通过雷达对人的脉搏进行测量。在对通知和/或警报进行分类时能够考虑这些信息,在一个方面能够随通知来传输生命体征参数、诸如脉搏。

350.在图70中详细示出了用于跌倒分类的系统。因此,用于探测人的跌倒的系统首先包括比如服务机器人17、存储器10、至少一个能够在时间进程中非接触地检测人的运动的传感器、人身份识别模块111和人跟踪模块112或113、用于从传感器数据中提取特征并将提取的特征分类为跌倒事件的跌倒探测模块5405、用于对跌倒事件的严重程度进行分类的跌倒事件评估模块5410。出于传输消息的目的,该系统另外还能够具有通向服务器和/或终端13的接口188。跌倒探测模块5405比如能够具有骨架创建模块5635,以用于创建人的骨架模型。跌倒探测模块5405能够包括用于测定来自骨架模型的关节点与地面的距离或距离变化的分类;关节点在垂直方向中的加速度;定向由连接至少两个关节点产生的方向矢量;方向矢量的朝向变化;例如通过人尺寸分析模块5655测定人的高度和/或高度变化,该人尺寸分析模块通过比如两个方向矢量的矢量差测定人的高度,这些方向矢量从一个共同原点延伸至至少一只脚和至少人的头;沿着垂直方向投影的人在地面上所占的面积,和/或人的头相对于看向地面和/或相对于看向探测到的障碍物的位置。系统另外还有用于检测人的生命体征参数的生命体征参数检测单元5415(比如摄像头185、激光雷达1、雷达和/或超声波传感器194)和用于分析被检测的人的生命体征参数的生命体征参数分析模块(5420)。该系统在一个方面具有人识别模块110、运动分析模块120和/或基于骨架模型的特征提取模块5640。

351.预防跌倒

352.服务机器人17在一个方面在执行测试和/或练习期间检测人的生命体征参数,如在图34中以步骤3400所示。为此,服务机器人17识别和跟踪人,比如借助视觉上的人跟踪模块112和/或基于激光的人跟踪模块113结合摄像头185或激光雷达1。为此,在步骤3355中进行人身份识别和人跟踪,对此能够使用人身份识别模块111。系统(可选地)位于人前方(步骤3420),并在步骤3430中(可选地)移动到这个人前面。在步骤3440中识别并跟踪需要执行练习和/或测试的人的身体区域,以便在步骤3450中通过在这一身体区域旁或上进行测量来检测生命体征参数。考虑将例如人的面部、手和胸部区域等作为身体区域。相应在本文的其他位置和/或现有技术中对探测这类身体区域的处理方法有过描述。测得的生命体征参数比如包括脉搏率、脉搏率差异性、心脏收缩和心脏舒张血压或者然而也包括人的呼吸(诸如呼吸频率)。在本文的其他位置处描述了怎样通过服务机器人17例如测定这些示例性提到的生命体征参数。但也能够使用其它方法来测定生命体征参数。使用至少一个传感器,比如摄像头185和/或雷达传感器(比如微波脉冲雷达、距离控制雷达、多普勒雷达、连续波雷达、超宽带雷达)和/或它们的组合搭配来检测生命体征参数,它们检测所提及的人的身体区域和生命体征参数,优选在时间进程内进行所述检测。

353.在一个方面,在此所使用的传感器测定人的皮肤和/或衣物上面和/或下方的运

动。在一个替代的和/或补充的方面,相对于一个人朝向服务机器人17的运动来分析这个人的皮肤表面和/或衣物的运动,即以人的运动来校正检测到的身体区域信号,步骤3460。为此,服务机器人17除为了测定生命体征参数而被分析的身体区域以外,还检测至少另一个身体区域,并测定所述至少另一个身体区域距服务机器人17的距离。在此,将为了对经分析的身体区域的生命体征参数进行分析而进行的运动检测与为了测定经检测的人身体区域的相对运动而进行的运动检测互相同步。比如能够通过激光雷达1,比如通过摄像头185,比如rgb-d摄像头185、超声波和/或雷达传感器194为了测定相对运动而检测身体区域。