一种对抗场景下的对手模型构建方法及存储介质

1.本发明涉及计算机兵棋推演模拟仿真领域,具体的,涉及在对抗场景下,基于对智能体的状态类数据和动作类数据进行对手模型构建方法及存储介质。

背景技术:

2.当前战争已进入“发现即摧毁”的“秒杀”时代,战争作为复杂系统,具有高动态性和不确定性等特点,在资源有限的前提下,多方面临利益冲突,指挥员决策面临信息量大、决策难度大的难点痛点。“知己知彼,百战不殆”,为获得最大收益,必须考虑其它智能体可能采取的行动对己方的影响,开展智能体的理性决策需求迫切。

3.传统博弈论方法在状态转换和策略动态演化方面建模能力不足,绝对理性决策难以实现;传统强化学习又受限于对抗场景巨大的状态空间,收敛性差、决策缓慢。立足“料敌从宽、预己从严”的原则,对手智能体构建的原则一是要

ꢀ“

像”,二是要“强”。

4.因此如何提出一种提高对手智能体建模的准确性,降低计算的复杂性,增强系统的适应性,成为亟需解决的技术问题。

技术实现要素:

5.本发明的目的在于提出一种对抗场景下的对手模型构建方法及存储介质,结合了变分自编码器和强化学习的优点,使得训练的对手智能体预测精准、计算简便。

6.为达此目的,本发明采用以下技术方案:一种对抗场景下的对手模型构建方法,包括如下步骤:数据采集以及预处理步骤s110:采集对手智能体的历史数据,按照时间序列提取历史数据中的高维输入观测信息,进行数据预处理后,构造出样本集,所述样本集包括t时刻的状态动作转移环境状态量样本数据;其中,表示当前t时刻状态下的状态及动作数据对,表示发生状态转移后的下一步状态;对手智能体状态模型构建及训练步骤s120:构建对手智能体状态模型,所述对手智能体状态模型包括神经网络,输入带时序信息的对手状态数据,利用所述神经网络提取出时序特征组,再在隐空间将所述时序特征组进一步提取处理,生成标准正态分布n(z),以及该标准正态分布的均值和方差,再对这些标准正态分布n(z)做概率采样,生成隐状态t时刻的状态数据并输出,利用步骤s110中的状态动作转移环境状态量样本数据对所述对手智能体状态模型进行学习训练直至收敛,输出该观测状态的抽象表示;对手智能体状态预测模型构建及训练步骤s130:

在低维隐空间中利用ddpg深度强化学习网络构建状态预测模型,输入t时刻的状态数据和对手智能体动作数据,输出t+1时刻的隐空间状态变量预测值,利用kl散度和重构前后的损失函数之和作为目标函数,根据需要设定具体阈值,如果达到训练目标,则停止训练,反之继续训练,通过不断调参使模型对目标函数的优化达到最优;状态转移模型构建及输出步骤s140:利用解码器在隐变量空间中构建状态转移模型,通过重参数,恢复对手智能体特征信息里的采样数据,将隐变量映射为可观测变量的估计值,升维重构生成新的重构样本值。

7.可选的,在步骤s110中,所述历史数据包括对手智能体状态类数据和对手智能体动作类数据,所述对手智能体状态类数据包括各智能体的位置、性能,所述位置是指物理空间的位置,所述性能是指装备的损伤程度;所述对手智能体动作类数据包括各装备智能体的行动指令数据,行动指令在交战规则集中选取,包含攻击或防守的目标和动作;所述数据预处理包括对数据进行归一化和异常值处理。

8.可选的,在步骤s120中,所述对手智能体状态模型包括卷积神经网络模块和循环神经网络模块,利用卷积神经网络模块输入带时序信息的对手状态数据,提取特征,将连续n时刻的特征处理为时序特征组,输出至循环神经网络模块;循环神经网络模块对应均值方差计算模块,生成标准正态分布n(z),以及该标准正态分布的均值和方差,再对这些标准正态分布n(z)做概率采样,生成隐状态下t时刻的状态数据并输出。

9.可选的,步骤s130具体为:在低维隐空间利用ddpg深度强化学习网络构建状态预测模型,ddpg深度强化学习网络包括:actor现实策略网络、actor估计策略网络、critic现实得分网络和critic估计得分网络,输入t时刻的状态数据和对手智能体动作数据,输出t+1时刻的状态预测值自身的隐状态,隐状态是前一时刻的隐状态和当前时刻数据的函数,即预测输出下一时刻状态值的概率密度函数,此时以概率密度函数的形式输出,概率密度函数不是一个确定值,是一个范围区间,其中,表示深度强化学习网络模型在t+1时刻的隐状态,即智能体对于自身行动所引发的环境变化的预测,利用kl散度和重构前后的损失函数之和作为目标函数,根据需要设定具体阈值,如果达到训练目标,则停止训练,反之继续训练,通过不断调参使模型对目标函数的优化达到最优。

10.可选的,在步骤s130中,所述目标函数使用的是kl散度与重构前后的均方误差之和作为评价指标。

11.可选的,在步骤s140中,

解码器为反卷积模块,将循环神经网络提取的潜在变量从预设分布中采样重构,在隐空间对下一时刻状态预测值实施反卷积,生成和原始训练样本分布相似的新样本数据,得到重构样本值并输出。

12.本发明进一步公开了一种存储介质,用于存储计算机可执行指令,其特征在于:所述计算机可执行指令在被处理器执行时执行上述的对抗场景下的对手模型构建方法。

13.本发明具有如下优点:1.神经网络结构和状态特征属性相结合方法,模仿人脑对高维数据的抽象思维和分布式的表达,较好地表现了模拟人类决策过程。面对场景任务迁移时,可灵活调整结构和特征属性的结合方式进行环境特征提取。

14.2.引入变分自编码器模型可对高维数据降维提取特征,不仅能够捕获对手策略网络数据中的高度非线性特征,还能节省开销加快数据处理速度,学习到其数据的分布,有一定的泛化能力,生成的数据具有灵活性和多样性。

15.3.将变分自编码器模型与深度强化学习相结合,在用深度强化学习训练对手模型的过程中,不断采集数据去扩充训练变分自编码器的数据集。同时,利用变分自编码器的目标函数构造附加奖励,加速智能体对陌生状态空间的探索,缩短探索用时,增加奖励次数,提高了强化学习的探索率和学习率。在训练模型的同时,实时填充经验池,支撑后期的网络训练。

附图说明

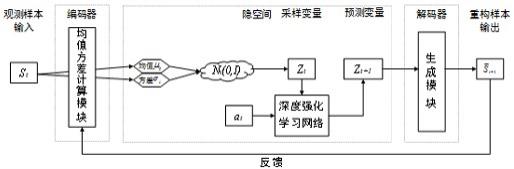

16.图1是根据本发明的对手建模的基本原理图;图2是根据本发明具体实施例的对抗场景下对手模型的网络结构图;图3是根据本发明具体实施例的对抗场景下的对手模型构建方法的流程图。

具体实施方式

17.下面结合附图和实施例对本发明作进一步的详细说明。可以理解的是,此处所描述的具体实施例仅仅用于解释本发明,而非对本发明的限定。另外还需要说明的是,为了便于描述,附图中仅示出了与本发明相关的部分而非全部结构。

18.因此本案提出一种对抗场景下基于变分自编码器和强化学习的对手模型构建方法与系统,将对手的状态特征隐式编码到强化学习推理过程中,属一种隐式对手模型构建方法。

19.对对手策略进行建模预测,简称对手建模。对手建模的过程可以看作是一个函数,输入观测到的交互历史信息与实时数据,输出下一时刻对手的动作、偏好、目标、计划等方面的预测值,整个过程原理如图1所示。

20.因此,为构建一个真实且强大的对手智能体,本发明提出一种结合变分自编码器与深度强化学习的对手模型预测方法,将整体环境模型区分为对手智能体状态表示模型和对手智能体状态转移模型:其中对手智能体状态表示模型利用编码器构造,将高维空间中的训练数据映射到低维空间,保持原始数据网络结构的低维节点的抽象压缩表示,使得较

大相似度的节点具有类似的向量表示;对手智能体状态预测模型采用解码器结合深度强化学习网络构造,在低维潜在空间生成未来状态的预测表示;利用对手智能体状态类数据和动作类数据对模型进行学习训练,当达到训练目标或者收敛后,利用变分自编码器的生成模块,在隐空间对下一时刻状态预测并输出。

21.本发明的对手模型预测方法所设计的模型设计的模型包含两部分:(1)变分自编码器既包含擅长自主态势理解的深度神经网络,能够深度模拟和表征决策,同时又能将复杂高维空间映射到便于数据处理的低维空间,具有降维功能。因此,通过使用无监督变分自编码器进行预训练,重新表征对手特征,可以初步实现对手智能体模型的“像”。

22.(2)强化学习不需要大量学习样本,就能在不确定环境下探索最佳收益。在低维空间中利用深度强化学习网络模型,学习预测未来状态表示,避免了深度神经网络在状态表示中对所训练数据过度拟合的问题。因此,通过深度强化学习预测对手模型,能训练出优化策略的智能体,实现对手智能体模型的“强”。

23.参见图3,示出了根据本发明具体实施例的对抗场景下的对手模型构建方法的流程图,包括如下步骤:数据采集以及预处理步骤s110:采集对手智能体的历史数据,按照时间序列提取历史数据中的高维输入观测信息,进行数据预处理后,构造出样本集,所述样本集包括t时刻的状态动作转移环境状态量样本数据;其中,表示当前t时刻状态下的状态及动作数据对,表示发生状态转移后的下一步状态。

24.所述历史数据包括对手智能体状态类数据和对手智能体动作类数据,所述对手智能体状态类数据包括各智能体的位置、性能,所述位置是指物理空间的位置,所述性能是指装备的损伤程度;所述对手智能体动作类数据包括各装备智能体的行动指令数据,行动指令在交战规则集中选取,包含攻击或防守的目标和动作。

25.所述数据预处理包括对数据进行归一化和异常值处理。

26.对手智能体状态模型构建及训练步骤s120:在本步骤中,利用编码器降维表达对手智能体状态,将复杂分布的样本数据投影到简单的隐变量空间,实现对高维信息数据样本的特征提取,将高维空间中的训练数据映射到低维空间,保持原始数据网络结构的低维节点的抽象压缩表示,使得较大相似度的节点具有类似的向量表示。

27.本步骤为:构建对手智能体状态模型,所述对手智能体状态模型包括神经网络,输入带时序信息的对手状态数据,利用所述神经网络提取出时序特征组,再在隐空间将所述时序特征组进一步提取处理,生成标准正态分布n(z),以及该标准正态分布的均值和方差,再对这些标准正态分布n(z)做概率采样,生成隐状态t时刻的状态数据并输出;利用步骤s110中的状态动作转移环境状态量样本数据对所述对手智能体状态模型进行学习训练直至收敛,输出该观测状态的抽象表示。

28.具体的,所述对手智能体状态模型包括卷积神经网络模块和循环神经网络模块,利用卷积神经网络模块输入带时序信息的对手状态数据,提取特征,将连续n时刻的特征处理为时序特征组,输出至循环神经网络模块;循环神经网络模块对应均值方差计算模块,生成标准正态分布n(z),以及该标准正态分布的均值和方差,再对这些标准正态分布n(z)做概率采样,生成隐状态下t时刻的状态数据并输出。

29.对手智能体状态预测模型构建及训练步骤s130:在本步骤中,对于对手状态预测模型采用解码器结合深度强化学习网络构造,在低维潜在空间生成未来状态的预测表示。

30.本步骤为:在低维隐空间中利用ddpg深度强化学习网络构建状态预测模型,输入t时刻的状态数据和对手智能体动作数据,输出t+1时刻的隐空间状态变量预测值,利用kl散度和重构前后的损失函数之和作为目标函数,根据需要设定具体阈值,如果达到训练目标,则停止训练,反之继续训练,通过不断调参使模型对目标函数的优化达到最优。

31.该步骤具体为:在低维隐空间(潜在空间)利用ddpg深度强化学习网络构建状态预测模型,ddpg深度强化学习网络包括:actor现实策略网络、actor估计策略网络、critic现实得分网络和critic估计得分网络,输入t时刻的状态数据和对手智能体动作数据,输出t+1时刻的状态预测值自身的隐状态,隐状态是前一时刻的隐状态和当前时刻数据的函数,即预测输出下一时刻状态值的概率密度函数,此时以概率密度函数的形式输出,概率密度函数不是一个确定值,是一个范围区间,其中,表示深度强化学习网络模型在t+1时刻的隐状态,即智能体对于自身行动所引发的环境变化的预测。

32.利用kl散度和重构前后的损失函数之和作为目标函数,根据需要设定具体阈值,如果达到训练目标,则停止训练,反之继续训练,通过不断调参使模型对目标函数的优化达到最优。

33.进一步的,所述目标函数使用的是kl散度与均方误差之和作为指标,并根据需要设定具体阈值,如果达到训练目标,则停止训练,反之继续训练,通过不断调参使模型对目标函数的优化达到最佳。

34.状态转移模型构建及输出步骤s140:本步骤在于:将已经训练好的预测值,通过变分自编码器的解码器以反变换的方式恢复到高维度空间。

35.该步骤为:利用解码器在隐变量空间中构建状态转移模型,通过重参数,恢复对手智能体特征信息里的采样数据,将隐变量映射为可观测变量的

估计值,升维重构生成新的重构样本值。

36.解码器的作用是根据标准正态分布的均值和方差,重新生成状态预测值。

37.进一步的,在该步骤中,解码器为反卷积模块,将循环神经网络提取的潜在变量从预设分布中采样重构,在隐空间对下一时刻状态预测值实施反卷积,生成和原始训练样本分布相似的新样本数据,得到重构样本值并输出。

38.因此,参见图2,示出了根据本发明的对抗场景下对手模型的网络结构图。

39.步骤s140中构建的状态转移模型也可以认为属于对手智能体状态预测模型的一部分,从而整体呈现出解码器结合深度强化学习的网络构造。

40.本发明进一步公开了一种存储介质,用于存储计算机可执行指令,所述计算机可执行指令在被处理器执行时执行上述的对抗场景下的对手模型构建方法。

41.本发明具有如下优点:1.神经网络结构和状态特征属性相结合方法,模仿人脑对高维数据的抽象思维和分布式的表达,较好地表现了模拟人类决策过程。面对场景任务迁移时,可灵活调整结构和特征属性的结合方式进行环境特征提取。

42.2.引入变分自编码器模型可对高维数据降维提取特征,不仅能够捕获对手策略网络数据中的高度非线性特征,还能节省开销加快数据处理速度,学习到其数据的分布,有一定的泛化能力,生成的数据具有灵活性和多样性。

43.3.将变分自编码器模型与深度强化学习相结合,在用深度强化学习训练对手模型的过程中,不断采集数据去扩充训练变分自编码器的数据集。同时,利用变分自编码器的目标函数构造附加奖励,加速智能体对陌生状态空间的探索,缩短探索用时,增加奖励次数,提高了深度强化学习的探索率和学习率。在训练模型的同时,实时填充经验池,支撑后期的网络训练。

44.显然,本领域技术人员应该明白,上述的本发明的各单元或各步骤可以用通用的计算装置来实现,它们可以集中在单个计算装置上,可选地,他们可以用计算机装置可执行的程序代码来实现,从而可以将它们存储在存储装置中由计算装置来执行,或者将它们分别制作成各个集成电路模块,或者将它们中的多个模块或步骤制作成单个集成电路模块来实现。这样,本发明不限制于任何特定的硬件和软件的结合。

45.以上内容是结合具体的优选实施方式对本发明所作的进一步详细说明,不能认定本发明的具体实施方式仅限于此,对于本发明所属技术领域的普通技术人员来说,在不脱离本发明构思的前提下,还可以做出若干简单的推演或替换,都应当视为属于本发明由所提交的权利要求书确定保护范围。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1