一种机械臂最优路径优化定位方法与流程

1.本发明涉及变压器清洗用机器人技术领域,具体为一种机械臂最优路径优化定位方法。

背景技术:

2.油浸式变压器一侧为高压进线,一侧为低压出线,采用机械臂械臂自动清洗时,需要对机器臂及喷头进行控制,以避开进出线等障碍,确保安全安全清洗,表面除污是这类油浸式变压器日常维护的一个重要部分。

3.目前,对变压器表面污垢的清理一般只能人工进行脉冲水清洗或绝缘清洗剂清洗,这种清洗方式要求变压器必须断电以保证工人安全,对变压器用户的正常生产有较大影响,进而需要一套针对变压器表面除垢的机器人系统。

4.目前,大部分除垢机器人系统的机械臂实现定位的方法主要有两种方式,一种是采用示教编程的方法,根据操作人员事先设定好的轨迹进行定位,这种方法的实际效果取决于操作人员的工作经验,并且存在前期编程工作量大、轨迹优化不明显和运动耗能高等缺点。另外一种方式是采用工业摄像机进行物体的识别定位,包括特定频谱的摄像机如红外成像摄像机等,通过摄像机对外界场景信息的感知,经过决策规划,实现定位。这种方法使用范围受限,无法适应更复杂的定位环境,现有的视觉技术难以处理实时性的视觉信息,同时也需要人工编程设置一些中间检查点。

5.大多数自动化机器人的动作生成问题可以概括为序列决策问题,而强化学习擅长解决决策问题,强化学习可以帮助人们找到难以发现到的并且有价值的动作,使任务变得更加高效,本专利提供了一种基于强化学习的机械臂定位方法。

技术实现要素:

6.(一)解决的技术问题

7.针对现有技术的不足,本发明提供了一种机械臂最优路径优化定位方法,无需昂贵的工业级别的传感器和摄像机、无需操作人员前期的进行复杂的示教编程,降低人员使用操作使用门槛、除了可用于抓取的路径模型的获取外,其设计思想还可扩展到清洗路径和喷涂路径等机械臂常见任务的应用中,解决了现有除垢机器人系统机械臂实现定位方法中出现的问题。

8.(二)技术方案

9.为实现上述无需昂贵的工业级别的传感器和摄像机、无需操作人员前期的进行复杂的示教编程,降低人员使用操作使用门槛、除了可用于抓取的路径模型的获取外,其设计思想还可扩展到清洗路径和喷涂路径等机械臂常见任务的应用中的目的,本发明提供如下技术方案:一种机械臂最优路径优化定位方法,包括如下步骤:

10.步骤一:v

‑

rep场景的配置:使用虚拟机器人实验平台v

‑

rep(virtual robot experimentation platform,简称v

‑

rep)进行仿真实验,进而完成v

‑

rep场景的配置;

11.步骤二:v

‑

rep场景的初始化:在v

‑

rep场景里建立场景模型,可以自由选择不同机械臂真实模型,调取变压器型号,通过扫描确定污染物目标位置等,进而完成v

‑

rep场景的初始化;

12.步骤三:机械臂启动:机械臂开始环境的探索,以此获得特定场景的抓取路径模型,而且路径模型具有最少以及多的动作数,减少机器臂不必要的动作切换;

13.步骤四:数据的记录:记录所述步骤三中每一回合的状态于q表中;

14.步骤五:机械臂碰撞测试:机械臂基于q

‑

learning算法进行运作,根据机械臂运作过程中是否碰撞进行运动,若运作过程中发生碰撞,重复至所述步骤三中重新开始机械臂的启动,若运作过程中没有发生碰撞,进入下一个步骤并更新调整q表中的数据;

15.步骤六:回合数是否最大值:当所述步骤五运作过程中没有发生碰撞,根据机械臂是否到达最大回合数限值操作机械臂进行运动,当机械臂到达最大回合数限值,进入下一个步骤,当机械臂没有到达最大回合数限值,重复所述步骤三,重新开始机械臂的启动并更新调整q表中的数据;

16.步骤七:数据的导出:导出所述步骤六中q表中的数据,进而导出q表的模型,转化为实际的路径,并将模型应用于实际生产使用过程中的场景。

17.优选的,所述步骤五中机械臂碰撞测试步骤使用python脚本负责与v

‑

rep进行交互控制,编写强化学习q

‑

learning算法脚本,包括智能体的脚本和奖励惩罚脚本。

18.优选的,所述步骤五机械臂碰撞测试步骤q

‑

learning算法中的智能体是通过玻尔兹曼分布概率策略来探索环境。

19.优选的,所述步骤四数据的记录步骤中每一回合中的状态具体指定是机械臂对应位置的三维空间坐标,包括x轴、y轴以及z轴上对应的坐标。

20.优选的,所述步骤一至步骤七中进行模拟仿真时,可根据需要使用更高性能的计算机进行仿真和训练实验,以缩短仿真时长提高仿真效率。

21.优选的,所述步骤五以及步骤六中对于后续出现更为复杂的动作,会产生更大的状态空间,根据需要可以采用函数逼近以及dqn网络进行运算操作。

22.优选的,所述步骤一至步骤七中进行模拟仿真时,还可以采用分布式计算机系统进行异步仿真和训练模型,以减少训练时间。

23.(三)有益效果

24.与现有技术相比,本发明提供了一种机械臂最优路径优化定位方法,具备以下有益效果:

25.该机械臂最优路径优化定位方法,本方案采用强化学习q

‑

learning来训练机械臂抓取,无需昂贵的工业级别的传感器和摄像机,只需针对特定的场景建立场景模型,再利用v

‑

rep进行仿真和训练以获得特定场景的抓取路径模型;而且无需操作人员前期的进行复杂的示教编程,降低人员使用操作使用门槛,本方案除了可用于抓取的路径模型的获取外,其设计思想还可扩展到清洗路径和喷涂路径等机械臂常见任务的应用中;无需昂贵的工业级别的传感器和摄像机、无需操作人员前期的进行复杂的示教编程,降低人员使用操作使用门槛、除了可用于抓取的路径模型的获取外,其设计思想还可扩展到清洗路径和喷涂路径等机械臂常见任务的应用中。

附图说明

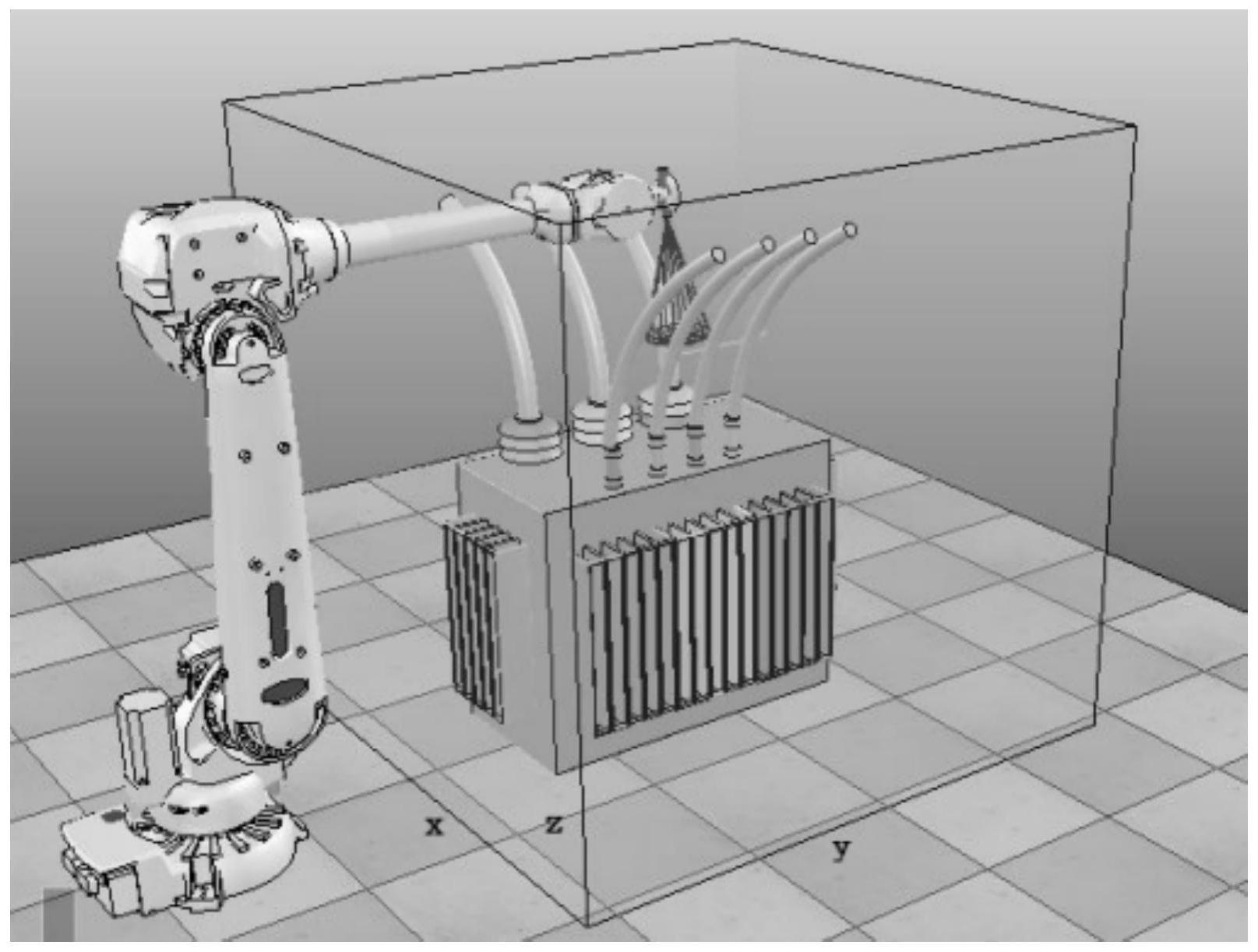

26.图1为本发明提出的一种机械臂最优路径优化定位方法机械臂定位训练场景图;

27.图2为本发明提出的一种机械臂最优路径优化定位方法状态奖励行动周期图;

28.图3为本发明提出的一种机械臂最优路径优化定位方法强化学习训练机械臂抓取的流程图。

具体实施方式

29.下面将结合本发明实施例中的附图,对本发明实施例中的技术方案进行清楚、完整地描述,显然,所描述的实施例仅仅是本发明一部分实施例,而不是全部的实施例。基于本发明中的实施例,本领域普通技术人员在没有做出创造性劳动前提下所获得的所有其他实施例,都属于本发明保护的范围。

30.请参阅图1

‑

3,一种机械臂最优路径优化定位方法,包括如下步骤:

31.步骤一:v

‑

rep场景的配置:使用虚拟机器人实验平台v

‑

rep(virtual robot experimentation platform,简称v

‑

rep)进行仿真实验,进而完成v

‑

rep场景的配置;

32.步骤二:v

‑

rep场景的初始化:在v

‑

rep场景里建立场景模型,可以自由选择不同机械臂真实模型,调取变压器型号,通过扫描确定污染物目标位置等,进而完成v

‑

rep场景的初始化;

33.步骤三:机械臂启动:机械臂开始环境的探索,以此获得特定场景的抓取路径模型,而且路径模型具有最少以及多的动作数,减少机器臂不必要的动作切换;

34.步骤四:数据的记录:记录步骤三中每一回合的状态于q表中;

35.步骤五:机械臂碰撞测试:机械臂基于q

‑

learning算法进行运作,根据机械臂运作过程中是否碰撞进行运动,若运作过程中发生碰撞,重复至步骤三中重新开始机械臂的启动,若运作过程中没有发生碰撞,进入下一个步骤并更新调整q表中的数据;

36.步骤六:回合数是否最大值:当步骤五运作过程中没有发生碰撞,根据机械臂是否到达最大回合数限值操作机械臂进行运动,当机械臂到达最大回合数限值,进入下一个步骤,当机械臂没有到达最大回合数限值,重复步骤三,重新开始机械臂的启动并更新调整q表中的数据;

37.步骤七:数据的导出:导出步骤六中q表中的数据,进而导出q表的模型,转化为实际的路径,并将模型应用于实际生产使用过程中的场景;

38.本方案采用强化学习q

‑

learning来训练机械臂抓取,无需昂贵的工业级别的传感器和摄像机,只需针对特定的场景建立场景模型,再利用v

‑

rep进行仿真和训练以获得特定场景的抓取路径模型;而且无需操作人员前期的进行复杂的示教编程,降低人员使用操作使用门槛,本方案除了可用于抓取的路径模型的获取外,其设计思想还可扩展到清洗路径和喷涂路径等机械臂常见任务的应用中;无需昂贵的工业级别的传感器和摄像机、无需操作人员前期的进行复杂的示教编程,降低人员使用操作使用门槛、除了可用于抓取的路径模型的获取外,其设计思想还可扩展到清洗路径和喷涂路径等机械臂常见任务的应用中。

39.步骤五中机械臂碰撞测试步骤使用python脚本负责与v

‑

rep进行交互控制,编写强化学习q

‑

learning算法脚本,包括智能体的脚本和奖励惩罚脚本。

40.步骤五机械臂碰撞测试步骤q

‑

learning算法中的智能体是通过玻尔兹曼分布概

率策略来探索环境。

41.步骤四数据的记录步骤中每一回合中的状态具体指定是机械臂对应位置的三维空间坐标,包括x轴、y轴以及z轴上对应的坐标。

42.步骤一至步骤七中进行模拟仿真时,可根据需要使用更高性能的计算机进行仿真和训练实验,以缩短仿真时长提高仿真效率。

43.步骤五以及步骤六中对于后续出现更为复杂的动作,会产生更大的状态空间,根据需要可以采用函数逼近以及dqn网络进行运算操作。

44.步骤一至步骤七中进行模拟仿真时,还可以采用分布式计算机系统进行异步仿真和训练模型,以减少训练时间。

45.综上,该机械臂最优路径优化定位方法,本方案采用强化学习q

‑

learning来训练机械臂抓取,无需昂贵的工业级别的传感器和摄像机,只需针对特定的场景建立场景模型,再利用v

‑

rep进行仿真和训练以获得特定场景的抓取路径模型;而且无需操作人员前期的进行复杂的示教编程,降低人员使用操作使用门槛,本方案除了可用于抓取的路径模型的获取外,其设计思想还可扩展到清洗路径和喷涂路径等机械臂常见任务的应用中;无需昂贵的工业级别的传感器和摄像机、无需操作人员前期的进行复杂的示教编程,降低人员使用操作使用门槛、除了可用于抓取的路径模型的获取外,其设计思想还可扩展到清洗路径和喷涂路径等机械臂常见任务的应用中。

46.图1是机械臂定位训练场景图,包含机械臂,被定位污染物位置。为智能体提供可操作机械臂末端运动的空间坐标,即为工作空间,如图1中的长方体透明框所示。x=[

‑

0.32,

‑

0.21],y=[

‑

0.12,

‑

0.08],z=[0,0.14],单位是米,因为在v

‑

rep中的坐标单位是米。然而,现实世界中的环境是连续的,为了方便机械臂的动作选取及执行,将工作空间以0.005单位的离散步距隔开(0.005单位的分辨率),分割为一个个小的执行到达空间,一共4928个执行小空间。机械臂在工作空间中有三种动作:1、机械臂移动到工作空间中的某个位置;2、开启喷头;3、喷洗。利用机械臂不断在工作空间中的探索试错来学习到最佳策略,以更新q表的形式记录下来。

[0047]

图2是状态奖励行动周期图,展示了在强化学习中智能体控制着机械臂与环境之间的交互行为。智能体执行每一次动作后状态空间将得到更新,即值函数更新,更新后的状态将决定着获得的奖惩,探索环境策略根据奖惩和值函数决定出下一步动作的选取。

[0048]

图3是强化学习训练机械臂定位的流程图,为了寻求到最优的路径模型,首先在v

‑

rep上配置与实际场景一致的场景信息,机械臂开始仿真训练,期间会以一个回合一个回合来不断探索环境,并记录下每一回合的动作数和奖惩值,而值函数和q表也会随之不断更新。当回合数到达最大限值,结束训练。此时的q表中包含有最优抓取路径模型。衡量最优的标准为动作数最少和奖励值最大。

[0049]

需要说明的是,术语“包括”或者其任何其他变体意在涵盖非排他性的包含,从而使得包括一系列要素的过程、方法、物品或者设备不仅包括那些要素,而且还包括没有明确列出的其他要素,或者是还包括为这种过程、方法、物品或者设备所固有的要素。在没有更多限制的情况下,由语句“包括一个

……”

限定的要素,并不排除在包括要素的过程、方法、物品或者设备中还存在另外的相同要素。

[0050]

尽管已经示出和描述了本发明的实施例,对于本领域的普通技术人员而言,可以

理解在不脱离本发明的原理和精神的情况下可以对这些实施例进行多种变化、修改、替换和变型,本发明的范围由所附权利要求及其等同物限定。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1