一种基于神经网络的婴儿哭声识别方法与流程

1.本发明涉及声音检测领域,具体地讲,涉及一种基于神经网络的婴儿哭声识别方法。

背景技术:

2.婴儿的监护人总是希望能更好地掌握儿童的精神状态,而婴儿因为语言能力较弱,主要是用哭声来表达自己的不适,比如恐惧、孤独等感情和饥饿、疼痛等身体感受,所以如果能够及时通过获悉婴儿的哭声来了解其精神状态,就可以更好地照顾安抚婴儿,使其健康成长。然而,由于监护人不是时刻都能在婴儿身边,比如需要工作、做家务,准备食物等的时候,经常将婴儿哄睡或者放在安全的区域内玩耍。然而婴儿的哭声可能会因为背景噪声等原因无法被监护人听到,有鉴于此,如果有一种方法能够准确快速地识别婴儿哭声,就可以通过婴儿监护器或类似的简易声音传输设备让监护人即刻了解到婴儿的需求。

3.传统的婴儿哭声识别,主要是基于不同声音的音质、频率等性质,在滤波之后进行声音的分类或识别,在背景噪声复杂的情况下很难做到准确快速的区分,容易受到环境的影响而漏报误报。有鉴于此,目前有些研究者采用了深度学习的方法来训练识别系统智能地分析声音的特质,通过深度学习分类或者音频特征提取的办法来进行婴儿哭声检测,例如公开号为cn112185364a的专利申请中公开了一种婴儿啼哭检测方法,婴儿啼哭的声音是基于深度学习模型进行训练得到的,但是其模型过于复杂,对处理器算力有较高的要求,难以加载到算力较弱的平价婴儿监护器设备上;还有一些检测方法存在训练选取的声音特征过于简单的缺点,虽然能够保证较快的速度,却无法保证准确性。

4.因此,有必要对现有的婴儿啼哭识别方法进行改进和优化。

技术实现要素:

5.本发明的目的在于克服现有技术中存在的上述不足,而提供一种基于神经网络的婴儿哭声识别方法,该方法基于简单的神经网络就可以训练系统对婴儿哭声进行准确的识别。

6.本发明解决上述问题所采用的技术方案是:一种基于神经网络的婴儿哭声识别方法,其特征在于:步骤如下:步骤一:获取不同类型的婴儿哭声音频和不同类型的非婴儿哭声音频;步骤二:设定婴儿哭声音频为正样本,非婴儿哭声音频为负样本,将正样本和负样本音频数据进行预处理;步骤三:对预处理后的正样本和负样本音频进行fbank特征提取;步骤四:对每一种类型的音频在fbank特征提取过程中,将特征的时域维度和频域维度随机置零,以对音频进行增强操作;步骤五:长短时特征融合:对每一种类型的音频取不同时长的音频片段进行特征数据提取,将各个时长对应的特征数据进行融合后得到训练模型;

步骤六:将所有训练模型放置到神经网络中进行训练,通过模型综合投票技术将不同训练模型加权平均得到最终的预测模型;步骤七:将预测模型由浮点模型转为定点模型,以便于嵌入式移植;步骤八:利用拾音器采集环境音频数据,并判断环境音频数据是否为静音,如果不是静音则对其进行特征提取,然后利用步骤七得到的定点模型进行判断是否有婴儿哭声,若有婴儿哭声,则利用定点模型判断出婴儿哭声种类;步骤九:根据不同种类婴儿哭声进行不同方式的安抚。

7.优选的,在所述步骤二中,预处理是指将正样本和负样本音频数据统一为:wav格式、单声道、16khz采样、16bit表达。

8.优选的,在所述步骤三中,fbank特征提取方法步骤依次为:预加重处理、分帧处理、加窗滤波和短时傅里叶变换。

9.优选的,在所述步骤五中,对每一种类型的音频取100ms、50ms和25ms三种时长的音频片段,对其分别进行fbank特征提取操作, 每一种时长的音频片段都能得到128维的特征数据,之后将三种时长的128维特征数据进行融合,得到384维特征并放入到神经网络中进行训练得到训练模型,此操作可以提升测试集的预测准确率。

10.优选的,在所述步骤六中,训练模型放置到神经网络中进行训练时,使训练模型在线学习某个婴儿哭声,如果采集到婴儿哭声的特征和之前特征相似,提高此种哭声类别的置信度,其中哭声特征是否相近通过全连接层特征向量的余弦距离来表示。

11.优选的,在所述步骤八中,静音判断方法为:频域的200帧音频求平均值,将此平均值+1.5作为阈值,如果200帧音频中没有一帧音频大于此阈值,则判定为静音状态。

12.本发明与现有技术相比,具有以下优点和效果:1、长短时融合:在特征提取过程中将音频的帧长分为100ms、50ms和25ms,对其分别进行fbank特征提取操作,每一种长度的音频都得到128维的特征数据,之后将128维特征进行融合,得到384维特征放入到神经网络中进行训练,此操作可以提升测试集的预测准确率;2、静音检测:目前成熟的静音检测是从webrtc中裁剪出来的一块和静音检测(vad)相关的一块代码,但是由于其代码复杂度比较大,需要加载很多的静态库和动态库,本发明设计了一种简单的静音检测方法,而且效果通过测试能够满足要求,方法是频域的200帧音频求平均值,将此平均值+1.5作为阈值,这200帧音频如果没有一帧的音频大于此阈值,则判定为静音状态,此方法可以在保证检测效果的前提下大大减少了cpu资源的消耗;3、模型综合投票: 在某一个时刻截取不同时长音频通过特征提取训练出不同的模型,不同模型通过加权平均得到最终的哭声类别;4、在线学习某个婴儿哭声:如果当前哭声特征和之前识别到的哭声特征非常相近,提高这个识别的置信度,这里哭声特征是否相近通过全连接层特征向量的余弦距离来表示。

附图说明

13.为了更清楚地说明本发明具体实施方式或现有技术中的方案,下面将对具体实施

方式或现有技术描述中所需要使用的附图作简单的介绍,显而易见地,下面描述中的附图是本发明的一些实施方式,对于本领域技术人员来讲,在不付出创造性劳动的前提下,还可以根据这些附图获得其他的附图。

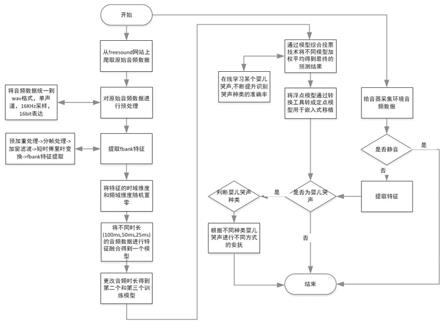

14.图1是本发明实施例婴儿哭声识别方法的流程图。

具体实施方式

15.下面结合附图并通过实施例对本发明作进一步的详细说明,以下实施例是对本发明的解释而本发明并不局限于以下实施例。

16.实施例。

17.参见图1。

18.本实施例中公开了一种基于神经网络的婴儿哭声识别方法,其步骤如下:步骤一:可以从freesound网站上获取不同类型的婴儿哭声音频和不同类型的非婴儿哭声音频;步骤二:设定婴儿哭声音频为正样本,非婴儿哭声音频为负样本,将正样本和负样本音频数据进行预处理,这里的预处理是指将正样本和负样本音频数据统一为:wav格式、单声道、16khz采样、16bit表达;步骤三:对预处理后的正样本和负样本音频进行fbank特征提取,fbank特征提取方法步骤依次为:预加重处理、分帧处理、加窗滤波和短时傅里叶变换;步骤四:对每一种类型的音频在fbank特征提取过程中,将特征的时域维度和频域维度随机置零,以对音频进行增强操作;步骤五:长短时特征融合:对每一种类型的音频取100ms、50ms和25ms三种时长的音频片段,对其分别进行fbank特征提取操作,每一种时长的音频片段都能得到128维的特征数据,之后将三种时长的128维特征数据进行融合,得到384维特征并放入到神经网络中进行训练得到训练模型,此操作可以提升测试集的预测准确率;步骤六:将所有训练模型放置到神经网络中进行训练,通过模型综合投票技术将不同训练模型加权平均得到最终的预测模型;其中训练模型放置到神经网络中进行训练时,使训练模型在线学习某个婴儿哭声,如果采集到婴儿哭声的特征和之前特征相似,提高此种哭声类别的置信度,其中哭声特征是否相近通过全连接层特征向量的余弦距离来表示;步骤七:将预测模型由浮点模型转为定点模型,以便于嵌入式移植;步骤八:利用拾音器采集环境音频数据,并判断环境音频数据是否为静音,如果不是静音则对其进行特征提取,然后利用步骤七得到的定点模型进行判断是否有婴儿哭声,若有婴儿哭声,则利用定点模型判断出婴儿哭声种类;其中,静音判断方法为:频域的200帧音频求平均值,将此平均值+1.5作为阈值,如果200帧音频中没有一帧音频大于此阈值,则判定为静音状态;步骤九:根据不同种类婴儿哭声进行不同方式的安抚。

19.虽然本发明已以实施例公开如上,但其并非用以限定本发明的保护范围,任何熟悉该项技术的技术人员,在不脱离本发明的构思和范围内所作的更动与润饰,均应属于本发明的保护范围。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1