一种在车载场景下提供情感关怀的方法及系统与流程

1.本技术涉及智能车辆技术领域,尤其涉及一种在车载场景下提供情感关怀的方法及系统。

背景技术:

2.车辆一般配置有车载语音助手辅助车主操控车辆。车载语音助手的功能在于,通过和车主进行语音交互获取车主意图,从而为车主提供多样化服务。

3.但是,传统的车载语音助手在和车主进行语音交互时,只能识别“语音”,也即:车主和车机的语音对话。例如车主发出语音指示:“降下车窗”,车载语音助手据此识别车主意图并遵照车主语音指示降下车窗。但是,在实际车载交互场景中存在的大多不是车主发出的“语音”,而是某种“声音”。例如除语音指示之外的咳嗽、喇叭等声音。目前的车载语音助手对于这种声音是无法理解并识别的,因此会在识别语音指示时,将其当做噪声去掉,从而限制了车载语音助手的功能扩展。

4.因此,如何使车载语音助手能够识别除语音指示之外的声音,实现车载语音助手的功能扩展,是目前亟需解决的问题。

技术实现要素:

5.本说明书公开了一种在车载场景下提供情感关怀的方法及系统,主要利用在常规识别时被当做噪音的咳嗽、喇叭等声音数据合并语音指示进行模型训练,并在模型训练时对此类声音数据和语音指示进行区分,从而使训练出的目标分类模型能够准确识别此类声音数据和语音指示的不同,并根据声音数据所属类别提供对应的情感关怀作为车载语音助手的扩展功能,从而解决或者部分解决目前车载语音助手的功能扩展能力低下的技术问题。

6.为解决上述技术问题,本说明书的第一方面,公开了一种在车载场景下提供情感关怀的方法,所述方法包括:

7.采集样本声音数据;其中,所述样本声音数据包括状态声音样本数据和干扰样本数据;所述状态声音样本数据包括用于表征用户体征状态的体征声音样本数据和/或用于表征车载环境状态的环境声音样本数据;所述干扰样本数据包括语音指示样本数据;

8.对所述样本声音数据清洗打标签,以使所述状态声音样本数据和所述干扰样本数据具有不同类别的标签;其中,所有干扰样本数据打标成同一类标签;

9.提取所述样本声音数据的样本声音特征值;

10.将所述样本声音特征值、所述状态声音样本数据的标签和所述干扰样本数据的标签一并输入选取的初始模型进行有监督训练,并通过混淆矩阵对分类准确度进行评估,训练出目标分类模型;

11.利用所述目标分类模型对车载场景下产生的目标声音数据进行实时分类,得到所述目标声音数据对应的目标声音分类标签,并根据所述目标声音分类标签输出对应的问候

语进行情感关怀。

12.优选的,所述对所述样本声音数据清洗打标签,具体包括:

13.将所述状态声音样本数据标注到各自对应的类别中;

14.设置其他类别,并将所述干扰样本数据标注到所述其他类别中。

15.优选的,所述提取所述样本声音数据的样本声音特征值,具体包括:

16.从提取短时特征值、提取中时特征值、提取长时特征值三者中选择一种作为所述样本声音数据的特征值提取方式;

17.基于所述样本声音数据的特征值提取方式,提取所述样本声音特征值。

18.优选的,所述基于所述样本声音数据的特征值提取方式,提取所述样本声音特征值,具体包括:

19.若所述样本声音特征值的特征值提取方式为提取短时特征值,逐帧提取所述样本声音数据的n个特征值,作为所述样本声音数据的短时特征值;

20.若所述样本声音特征值的特征值提取方式为提取中时特征值,提取所述样本声音数据的短时特征值,以及提取所述样本声音数据基于第一帧段范围的m个特征值,将所述短时特征值和所述第一帧段范围的m个特征值一并作为所述样本声音数据的中时特征值;

21.若所述样本声音特征值的特征值提取方式为提取长时特征值,提取所述样本声音数据的短时特征值,以及提取所述样本声音数据基于第二帧段范围的m个特征值,将所述短时特征值和所述第二帧段范围的m个特征值一并作为所述样本声音数据的长时特征值。

22.优选的,所述将所述样本声音特征值、所述状态声音样本数据的标签和所述干扰样本数据的标签一并输入选取的初始模型进行有监督训练,并通过混淆矩阵对分类准确度进行评估,训练出目标分类模型,包括:

23.基于所述样本声音数据的标签和样本声音特征值,构建特征值矩阵;其中,所述特征值矩阵的“列”包含标签和特征值;所述特征值矩阵的“行”为帧数;所述特征值矩阵中的标签用于区分所述样本声音数据的类别;

24.将所述特征值矩阵输入所述初始模型进行有监督训练,并通过混淆矩阵对分类准确度进行评估,训练出所述目标分类模型。

25.优选的,所述利用所述目标分类模型对车载场景下产生的目标声音数据进行实时分类,得到所述目标声音数据对应的目标声音分类标签,具体包括:

26.实时采集在车载场景下产生的目标声音数据;所述目标声音数据包括:用于表征用户当前体征状态的体征声音数据、用于表征周围环境状态的环境声音数据、干扰数据中的一种或者多种;

27.利用所述样本声音特征值的特征值提取方式提取所述目标声音数据的目标声音特征值;

28.将所述目标声音特征值输入到所述目标分类模型进行分类,得到所述目标声音数据对应的目标声音分类标签。

29.优选的,所述利用所述目标分类模型对车载场景下产生的目标声音数据进行实时分类,得到所述目标声音数据对应的目标声音分类标签之后,所述方法还包括:

30.若所述目标声音分类标签与所述干扰样本数据的标签一致,不做情感关怀处理;

31.若所述目标声音分类标签与所述干扰样本数据的标签不一致,执行根据所述目标

声音分类标签输出对应的问候语进行情感关怀的步骤。

32.本说明书的第二方面,公开了一种在车载场景下提供情感关怀的系统,所述系统包括:

33.训练数据采集模块,用于采集样本声音数据;其中,所述样本声音数据至少包括体征声音样本数据和语音指示样本数据;

34.训练数据打标模块,对所述样本声音数据清洗打标签,以使所述体征声音样本数据和所述语音指示样本数据具有不同类别的标签;其中,所有语音指示样本数据打标成同一类标签;

35.特征提取模块,用于从所述样本声音数据中提取样本声音特征值;

36.训练模块,用于将所述样本声音特征值、所述体征声音样本数据的标签和所述语音指示样本数据的标签一并输入选取的初始模型进行有监督训练,并通过混淆矩阵对分类准确度进行评估,训练出目标分类模型;

37.声音分类模块,用于利用所述目标分类模型对车载场景下产生的目标声音数据进行实时分类,得到所述目标声音数据对应的目标声音分类标签;

38.输出模块,用于根据所述目标声音分类标签输出对应的问候语进行情感关怀。

39.优选的,所述对所述训练数据打标模块,具体用于:

40.将所述状态声音样本数据标注到各自对应的类别中;

41.设置其他类别,并将所述干扰样本数据标注到所述其他类别中。

42.优选的,所述特征提取模块,具体用于:

43.从提取短时特征值、提取中时特征值、提取长时特征值三者中选择一种作为所述样本声音数据的特征值提取方式;

44.基于所述样本声音数据的特征值提取方式,提取所述样本声音特征值。

45.优选的,所述特征提取模块,具体用于:

46.若所述样本声音特征值的特征值提取方式为提取短时特征值,逐帧提取所述样本声音数据的n个特征值,作为所述样本声音数据的短时特征值;

47.若所述样本声音特征值的特征值提取方式为提取中时特征值,提取所述样本声音数据的短时特征值,以及提取所述样本声音数据基于第一帧段范围的m个特征值,将所述短时特征值和所述第一帧段范围的m个特征值一并作为所述样本声音数据的中时特征值;

48.若所述样本声音特征值的特征值提取方式为提取长时特征值,提取所述样本声音数据的短时特征值,以及提取所述样本声音数据基于第二帧段范围的m个特征值,将所述短时特征值和所述第二帧段范围的m个特征值一并作为所述样本声音数据的长时特征值。

49.优选的,所述训练模块,具体用于:

50.基于所述样本声音数据的标签和样本声音特征值,构建特征值矩阵;其中,所述特征值矩阵的“列”包含标签和特征值;所述特征值矩阵的“行”为帧数;所述特征值矩阵中的标签用于区分所述样本声音数据的类别;

51.将所述特征值矩阵输入所述初始模型进行有监督训练,并通过混淆矩阵对分类准确度进行评估,训练出所述目标分类模型。

52.优选的,所述声音分类模块,具体用于:

53.声音采集模块,用于实时采集在车载场景下产生的目标声音数据;所述目标声音

数据包括:用于表征用户当前体征状态的体征声音数据、用于表征周围环境状态的环境声音数据、干扰数据中的一种或者多种;

54.所述特征提取模块,用于利用所述样本声音特征值的特征值提取方式提取所述目标声音数据的目标声音特征值;

55.分类模块,用于将所述目标声音特征值输入到所述目标分类模型进行分类,得到所述目标声音数据对应的目标声音分类标签。

56.优选的,所述系统还用于:

57.若所述目标声音分类标签与所述干扰样本数据的标签一致,不做情感关怀处理;

58.若所述目标声音分类标签与所述干扰样本数据的标签不一致,控制所述输出模块执行根据所述目标声音分类标签输出对应的问候语进行情感关怀的步骤。

59.本说明书的第三方面,公开了一种计算机可读存储介质,其上存储有计算机程序,该程序被处理器执行时实现上述方法的步骤。

60.本说明书的第四方面,公开了一种车载设备,包括存储器、处理器及存储在存储器上并可在处理器上运行的计算机程序,所述处理器执行所述程序时实现上述方法的步骤。

61.通过本说明书的一个或者多个技术方案,本说明书具有以下有益效果或者优点:

62.本说明书公开了一种在车载场景下提供情感关怀的方法及系统,主要利用在常规识别时被当做噪音的咳嗽、喇叭等声音数据合并语音指示进行模型训练,并在模型训练时对此类声音数据和语音指示进行区分,从而使训练出的目标分类模型能够准确识别此类声音数据和语音指示的不同,并根据声音数据的类别提供对应的情感关怀,以此作为车载语音助手的扩展功能,增加了车载语音助手的情感关怀功能,从而提供更加人性化的驾驶体验。

63.上述说明仅是本说明书技术方案的概述,为了能够更清楚了解本说明书的技术手段,而可依照说明书的内容予以实施,并且为了让本说明书的上述和其它目的、特征和优点能够更明显易懂,以下特举本说明书的具体实施方式。

附图说明

64.通过阅读下文优选实施方式的详细描述,各种其他的优点和益处对于本领域普通技术人员将变得清楚明了。附图仅用于示出优选实施方式的目的,而并不认为是对本说明书的限制。而且在整个附图中,用相同的参考符号表示相同的部件。在附图中:

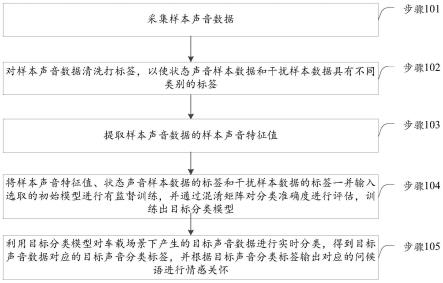

65.图1示出了根据本说明书一个实施例的在车载场景下提供情感关怀的方法流程图;

66.图2示出了根据本说明书一个实施例的在车载场景下提供情感关怀的系统示意图;

67.图3示出了根据本说明书一个实施例的在车载场景下提供情感关怀的系统另一示意图。

具体实施方式

68.下面将参照附图更详细地描述本说明书的示例性实施例。虽然附图中显示了本说明书的示例性实施例,然而应当理解,可以以各种形式实现本说明书而不应被这里阐述的

实施例所限制。相反,提供这些实施例是为了能够更透彻地理解本说明书,并且能够将本说明书的范围完整的传达给本领域的技术人员。

69.本说明书实施例公开了一种在车载场景下提供情感关怀的方法,该方法在车载场景下的声音分类识别的基础之上,针对不同类型的声音输出不同的情感关怀。而声音分类识别的任务本质上是从声音中提取特征,然后识别出声音所属类别。由于声音数据获取的难度要远高于图像以及文本数据,因此面临着样本有限的问题,基于此,本实施例放弃端到端方案,从常规的模型训练入手,结合采集的语音指示和除语音指示之外的声音数据(本实施例称为状态声音数据)训练出具有针对性的目标分类模型置入车载设备,对车载场景下产生的各种声音进行分类,从而准确识别出声音数据和语音指示的不同,并根据声音数据的类别提供对应的情感关怀,以此作为车载语音助手的扩展功能。

70.参看图1,本实施例的方法包括下述步骤:

71.步骤101,采集样本声音数据。

72.在本实施例中,若需要准确区分语音指示和除语音指示之外的声音数据(本实施例称之为状态声音数据),前提是收集各种类别的样本声音数据。因此,本实施例采集到的样本声音数据包含了各种类型的声音数据。具体来说,样本声音数据包括状态声音样本数据和干扰样本数据。状态声音样本数据表征人和/或环境所呈现的状态,主要包括用于表征用户体征状态的体征声音样本数据,例如咳嗽,打哈欠,打响指,鼓掌声,笑声,哭声等声音;当然,状态声音样本数据还可以包括用于表征车载环境状态的环境声音样本数据,例如周围车按喇叭声,救护车声,警笛声等。本实施例将除状态声音样本数据之外的所有声音数据作为干扰样本数据进行采集。因此,干扰样本数据包括:语音指示样本数据,其他数据。其他数据指干扰样本数据中除语音指示之外的数据。

73.进一步的,本实施例需要尽可能多的采集样本声音数据,并在达到一定量时建立数据库进行存储,以便后续使用。

74.步骤102,对样本声音数据清洗打标签,以使状态声音样本数据和干扰样本数据具有不同类别的标签。

75.本实施例中,清洗打标签用于对样本声音数据划分类别,以供后续训练模型使用。本实施例可对样本声音数据划分多个类别,例如:咳嗽、哈欠、响指、鼓掌、笑声、哭声、喇叭声、救护车、警笛、其他,但并不形成限制。

76.由于本说明书需要区分语音指示以及除语音指示之外的状态声音数据。因此,将状态声音样本数据标注到各自对应的类别中;然后设置其他类别(other类别),并将干扰样本数据(包含语音指示样本数据和其他样本数据)标注到其他类别中,从而使样本声音数据形成闭环声音训练据集,提升有监督学习分类的准确率,以使训练出的目标分类模型能够准确识别除语音指示之外的各种声音的所属类别。值得注意的是,所有干扰样本数据打标成同一类标签,放置于other类别,从而将所有语音指示当做干扰数据识别为同一类,以有效区分语音指示和除语音指示之外的状态声音数据。

77.步骤103,提取样本声音数据的样本声音特征值。

78.由于在实际场景中,样本声音数据的获取难度要远高于图像、文本数据的获取难度,因此样本声音数据往往面临着样本有限的问题。因此,为了弥补样本有限的缺陷,本实施例公开了三种提取方式,能够根据实际情况按需提取出有效的样本声音特征值。具体的,

本实施例包含下述三种提取方式:提取短时特征值、提取中时特征值、提取长时特征值。在提取样本声音特征值时,先从提取短时特征值、提取中时特征值、提取长时特征值三者中选择一种作为样本声音数据的特征值提取方式;再基于样本声音数据的特征值提取方式,提取样本声音特征值。

79.在本实施例中,提取短时特征值、提取中时特征值、提取长时特征值这三种提取方式的选取取决于时延需求、准确率、数据长短中的一种或者多种组合。

80.由于样本声音特征值需要先缓存再处理,而缓存时产生的时延是选取特征值提取方式的影响因素之一。因此不同的时延需求对应不同的特征值提取方式。举例来说,一帧声音数据的时延为20ms~30ms。若时延需求为20ms~30ms,则确定提取短时特征值为样本声音数据的特征值提取方式,若时延需求为400ms~1s,则确定提取中时特征值为样本声音数据的特征值提取方式。若时延需求为2s以上,则确定提取长时特征值为样本声音数据的特征值提取方式。

81.进一步的,随着短时特征值、中时特征值、长时特征值三者的分类准确率逐渐升高,相应的,计算复杂度也逐渐升高。因此,分类准确率并非是越高越好,需要结合车载设备的计算能力选择。而不同的分类准确率对应不同的特征值提取方式,因此可根据要求的分类准确率选取对应的特征值提取方式。

82.此外,数据长短也会作为特征值提取方式的影响因素之一。在数据量充足且样本声音数据的数据较长,则可以提取样本声音数据的中时特征值或长时特征值,否则提取样本声音数据的短时特征值。值得注意的是,一旦确定了特征值提取方式,则会采用此特征值提取方式对所有样本声音数据进行处理,因此,所有样本声音数据都采用同一种特征值提取方式。而在提取特征值时,由于本实施例逐帧对样本声音数据进行处理,因此样本声音数据的长短并不影响样本声音特征值的有效性。

83.在上述实施例中,介绍了短时特征值、中时特征值、长时特征值三者的一个或者多个选取条件,这些选取条件可单独使用,也可以结合使用,从而合理提高样本分类精度。

84.下面具体介绍短时特征值、中时特征值、长时特征值三者的提取过程。

85.在本实施例中,短时特征值是每帧样本数据内部呈现的特征值,中时特征值和长时特征值时是在短时特征值的基础上,引入经过时间累积在统计学上呈现出的帧间特征值。中时特征值和长时特征值时的区别在于时间上的不同。

86.短时特征值,设置有n个特征值。例如,本实施例中设置有21个特征值,包括:过零率、短时能量、能量熵、谱质心、谱延展、谱熵、频谱通量、滚降系数、13个mel频谱系数。当然,短时特征值的特征值个数还可以根据实际情况进行扩展。中时特征值在上述21个特征值的基础上,增加了各特征值在帧段范围内的均值、方差、静音比、子带能量比、低频能量比值。长时特征值和中时特征值包含的特征值种类一致。

87.若样本声音特征值的特征值提取方式为提取短时特征值,则逐帧提取样本声音数据的n个特征值,作为样本声音数据的短时特征值。也即:每帧样本声音数据都提取出n个特征值作为每帧样本声音数据的短时特征值,n≥21且为正整数。

88.若样本声音特征值的特征值提取方式为提取中时特征值,提取样本声音数据的短时特征值,以及提取样本声音数据基于第一帧段范围的m个特征值,将短时特征值和第一帧段范围的m个特征值一并作为样本声音数据的中时特征值。具体来说,若需提取中时特征

值,则从样本声音数据中截取第一帧段范围,然后据此计算出m个特征值,结合短时特征值一并作为中时特征值,m≥1且为正整数。例如,样本声音数据有70帧,第一帧段范围为20帧~50帧,则从70帧中截取50帧样本声音数据,并计算前述21个特征值在第一帧段范围内的均值、方差、静音比、子带能量比、低频能量比值,并将前述21个特征值一并作为中时特征值。当然,也可以基于样本声音数据的全部帧数统计均值、方差、静音比、子带能量比、低频能量比值,在此本说明书不做限制。如此,即得到了每帧样本声音数据各自呈现的特征值,又得到了样本声音数据在统计学上呈现出的帧间特征值,以便提高样本分类的精度。

89.若样本声音特征值的特征值提取方式为提取长时特征值,提取样本声音数据的短时特征值,以及提取样本声音数据基于第二帧段范围的m个特征值,将短时特征值和第二帧段范围的m个特征值一并作为样本声音数据的长时特征值。具体来说,若需提取长时特征值,则从样本声音数据中截取第二帧段范围,然后据此计算出m个特征值,结合短时特征值一并作为长时特征值,m≥1且为正整数。提取长时特征值的方式和提取中时特征值的方式相同,区别仅在于选取的帧段范围不同。例如,中时特征值选取的帧段范围为20帧~50帧,长时特征值选取的帧段范围为100帧以上。因此,提取长时特征值的过程可参照提取中时特征值的方式执行,在此本说明书不再赘述。而由于长时特征值的帧数更多,因此相对于中时特征值来说,其在统计学上呈现出的帧间特征值更为准确,而样本分类精度也更高。

90.值得注意的是,一旦样本声音数据的特征值提取方式确定,则后续实际分类是,会按照样本声音数据的特征值提取方式提取实际分类时的目标声音数据的特征值。

91.在本实施例中,通过提供三种不同的特征值提取方式,增加了特征值选取的灵活多样性,使特征值提取能够按需选择,并且使提取出的样本声音特征值更加贴合实际分类需求,并且使得后续分类也更加贴合实际分类需求。

92.步骤104,将样本声音特征值、状态声音样本数据的标签和干扰样本数据的标签一并输入选取的初始模型进行有监督训练,并通过混淆矩阵对分类准确度进行评估,训练出目标分类模型。

93.在有监督训练的过程中,先基于样本声音数据的标签和样本声音特征值,构建特征值矩阵。再将特征值矩阵输入初始模型进行有监督训练,并通过混淆矩阵对分类准确度进行评估,训练出目标分类模型。

94.具体来说,特征值矩阵的“列”包含标签和特征值,特征值矩阵的“行”为帧数,反之亦可。本实施例在训练时是将一类数据放入一个文件夹,文件夹名称以打标时的标签命名,因此一个文件夹中包含有一类标签下的所有训练数据。在构建特征值矩阵时可参照此设计,在特征值矩阵中引入标签列,用于区分样本声音数据的类别。以短时特征值为例,特征值矩阵的“列”具有22列,包含21列短时特征值和1列标签,标签用于区分样本声音数据的类别。而“行”以帧为单位进行排列,为所有样本声音数据分帧后的帧数,并且包含other类。然后将特征值矩阵改写成分类算法所需要输入的数据格式输入训练,并通过混淆矩阵对分类准确度进行评估,即可训练出目标分类模型。

95.在选取初始模型时,适用于多类分类的算法均适用于本实施例,此算法可处理声音、图像等数据,对于算法而言,只要输入数据格式符合算法即可,而无需在意原始数据的表现形式。并且,训练结果的优劣大多取决于特征值的选取,对于每一类声音,其特征值差别越大越优。具体来说,由于车载设备的存储空间有限,并且样本声音数据的数据量不大,

故可选取机器学习中svm(支持向量网络)、knn(k近邻算法)、random forest(随机森林算法)、extratress(extremely randomized trees,极端随机树)、gradient boosting(梯度提升)等算法来作为初始模型进行训练,再利用输出的混淆矩阵对训练出的每类结果的准确度进行综合评估,从而训练出最终的目标分类模型。由于数据量不大,因此本实施例能够在线训练目标分类模型。若样本声音数据的数据量较大且车载设备的存储空间足够,则选择深度学习多分类算法(比如同样适用于声音、图像的深度学习网络cnn)进行训练,从而训练出最终的目标分类模型。

96.以上是本实施例的训练过程,为了区分语音指示和除语音指示之外的状态声音数据,可将包含有样本语音数据的干扰数据单独放置于其他类别,并将状态声音数据按照各自的类别进行划分,再一并输入模型进行训练,从而使得训练出的目标分类模型能够很好地区分出语音指示数据和状态声音数据,并且能够识别出状态声音数据各自所属类别。

97.为了详细说明目标分类模型的识别过程,请参看下面的介绍。

98.步骤105,利用目标分类模型对车载场景下产生的目标声音数据进行实时分类,得到目标声音数据对应的目标声音分类标签,并根据目标声音分类标签输出对应的问候语进行情感关怀。

99.在具体的实施过程中,目标分类模型实时分类的过程如下:

100.实时采集在车载场景下产生的目标声音数据。

101.具体的,通过车内配置的麦克实时采集车载场景下产生的各种目标声音数据。目标声音数据包括:用于表征用户当前体征状态的体征声音数据、用于表征周围环境状态的环境声音数据、干扰数据中的一种或者多种。例如,咳嗽,打哈欠,打响指,鼓掌声,笑声,哭声,周围车按喇叭声、救护车声、警笛声等等。当然,声音类型还可以扩充。

102.在一些可选的实施方式中,目标声音数据可由一个或者多个用户发出。由于车辆所处环境不断变化,因此麦克采集到的目标声音数据可能由一个用户发出的一种或者多种声音,例如驾驶员在驾车时不时咳嗽,此时麦克会采集到咳嗽声。再例如,驾驶员在发出“降下车窗”的语音指示后咳嗽,此时麦克风会依次采集语音指示、咳嗽传入目标分类模型中处理。此外,麦克采集到的目标声音数据也可能包含多个用户同时发出的多种声音,例如在同一环境中,驾驶员发出“降下车窗”的语音指示,其中夹杂着其他乘员的咳嗽声。

103.众所周知,在常规识别用户意图时,会重点识别语音指示,并将采集到的咳嗽声当作噪声去掉。而在本实施例中,则主要针对采集到的咳嗽声进行识别处理,而为了防止语音指示的干扰,会在分类时将其分类为其他类别并且不做处理,具体请看后续描述。

104.利用样本声音特征值的特征值提取方式提取目标声音数据的目标声音特征值,从而保证目标声音特征值和样本声音特征值的种类一致,以便于目标分类模型进行处理。而具体的特征值提取过程请参看前述实施例的描述,在此不再赘述。

105.将目标声音特征值输入到目标分类模型进行分类,得到目标声音数据对应的目标声音分类标签。

106.具体的,基于目标声音特征值构建对应的特征值矩阵,并将目标声音特征值对应的特征值矩阵的输入格式改为目标分类模型所需格式进行输入,通过目标分类模型的处理即可得到目标声音数据对应的目标声音分类标签。

107.举例来说,若目标声音数据包含有咳嗽声和“降下车窗”的语音指示,则通过上述

特征值提取后输入到目标分类模型之后,会将咳嗽声分类到“咳嗽”类别,咳嗽声对应的分类标签为“咳嗽”,而“降下车窗”的语音指示会分类到“其他”类别,语音指示对应的分类标签为“其他”。

108.而在得到目标声音数据对应的目标声音分类标签之后,根据标签的不同,会有不同的处理方式。

109.若目标声音分类标签与干扰样本数据的标签一致,不做情感关怀处理。承接上述举例,由于“降下车窗”的语音指示和干扰样本数据的标签一致,都为“其他”,则针对“降下车窗”的语音指示不做情感关怀处理,直接忽略即可。

110.若目标声音分类标签与干扰样本数据的标签不一致,执行根据目标声音分类标签输出对应的问候语进行情感关怀的步骤。承接上述举例,由于咳嗽声和干扰样本数据的标签不一致,根据咳嗽声对应的分类标签“咳嗽”输出对应的问候语进行情感关怀。

111.具体来说,声音分类标签和问候语具有映射关系。不同的声音分类标签对应不同的问候语。从而可基于声音分类标签,从映射关系中确定出对应的问候语并输出,从而对用户进行情感关怀。

112.本实施例通过麦克收集车辆内外的声音信号,并通过在车载语音助手中加载目标分类模型进行识别分类,再根据不同的分类结果结合tts(text to speech,从文本到语音)语音播报,给予温馨的提示和问候。例如,若采集到咳嗽声音,那么会温馨的问候:主人您咳嗽了,请注意身体。若采集到车外鸣笛声音,会提示:汽车鸣笛,请注意安全,从而对用户进行情感关怀,让用户体验到关心和温暖,提升用户的驾驶体验。当然,本实施例可根据声音分类,设置与场景相符合的tts语音播报问候语。

113.基于与前述实施例中同样的发明构思,本说明书实施例还公开了一种在车载场景下提供情感关怀的系统,该系统在传统的车载语音链路中增加声音识别功能,从而准确识别此类声音数据和语音指示的不同,并根据声音数据的类别提供对应的情感关怀,以此作为车载语音助手的扩展功能,增加了车载语音助手的情感关怀功能,从而提供更加人性化的驾驶体验。参看图2,系统包括两部分:训练部分和实际分类部分。其中,训练部分训练的是非实时数据,训练时所用数据是事先采集的。实际分类部分处理的是实时数据。

114.训练部分包括:

115.训练数据采集模块201,用于采集样本声音数据;其中,所述样本声音数据至少包括体征声音样本数据和语音指示样本数据;

116.训练数据打标模块202,对所述样本声音数据清洗打标签,以使所述体征声音样本数据和所述语音指示样本数据具有不同类别的标签;其中,所有语音指示样本数据打标成同一类标签;

117.特征提取模块203,用于从所述样本声音数据中提取样本声音特征值;

118.训练模块204,用于将所述样本声音特征值、所述体征声音样本数据的标签和所述语音指示样本数据的标签一并输入选取的初始模型进行有监督训练,并通过混淆矩阵对分类准确度进行评估,训练出目标分类模型;

119.实际分类部分包括:

120.声音分类模块205,用于利用所述目标分类模型对车载场景下产生的目标声音数据进行实时分类,得到所述目标声音数据对应的目标声音分类标签;

121.输出模块206,用于根据所述目标声音分类标签输出对应的问候语进行情感关怀。

122.在一些可选的实施方式中,所述对所述训练数据打标模块202,具体用于:

123.将所述状态声音样本数据标注到各自对应的类别中;

124.设置其他类别,并将所述干扰样本数据标注到所述其他类别中。

125.在一些可选的实施方式中,所述特征提取模块203,具体用于:

126.从提取短时特征值、提取中时特征值、提取长时特征值三者中选择一种作为所述样本声音数据的特征值提取方式;

127.基于所述样本声音数据的特征值提取方式,提取所述样本声音特征值。

128.在一些可选的实施方式中,所述特征提取模块203,具体用于:

129.若所述样本声音特征值的特征值提取方式为提取短时特征值,逐帧提取所述样本声音数据的n个特征值,作为所述样本声音数据的短时特征值;

130.若所述样本声音特征值的特征值提取方式为提取中时特征值,提取所述样本声音数据的短时特征值,以及提取所述样本声音数据基于第一帧段范围的m个特征值,将所述短时特征值和所述第一帧段范围的m个特征值一并作为所述样本声音数据的中时特征值;

131.若所述样本声音特征值的特征值提取方式为提取长时特征值,提取所述样本声音数据的短时特征值,以及提取所述样本声音数据基于第二帧段范围的m个特征值,将所述短时特征值和所述第二帧段范围的m个特征值一并作为所述样本声音数据的长时特征值。

132.在一些可选的实施方式中,所述训练模块204,具体用于:

133.基于所述样本声音数据的标签和样本声音特征值,构建特征值矩阵;其中,所述特征值矩阵的“列”包含标签和特征值;所述特征值矩阵的“行”为帧数;所述特征值矩阵中的标签用于区分所述样本声音数据的类别;

134.将所述特征值矩阵输入所述初始模型进行有监督训练,并通过混淆矩阵对分类准确度进行评估,训练出所述目标分类模型。

135.在一些可选的实施方式中,所述声音分类模块205,具体包括:

136.声音采集模块2051,用于实时采集在车载场景下产生的目标声音数据;所述目标声音数据包括:用于表征用户当前体征状态的体征声音数据、用于表征周围环境状态的环境声音数据、干扰数据中的一种或者多种;

137.所述特征提取模块203,用于利用所述样本声音特征值的特征值提取方式提取所述目标声音数据的目标声音特征值;

138.分类模块2052,用于将所述目标声音特征值输入到所述目标分类模型进行分类,得到所述目标声音数据对应的目标声音分类标签。

139.在一些可选的实施方式中,所述系统还用于:

140.若所述目标声音分类标签与所述干扰样本数据的标签一致,不做情感关怀处理;

141.若所述目标声音分类标签与所述干扰样本数据的标签不一致,控制所述输出模块206执行根据所述目标声音分类标签输出对应的问候语进行情感关怀的步骤。

142.下面参看图3,在声音采集模块2051采集到声音数据之后,一方面输入传统的车载语音链路处理,另一方面会通过新增的链路,对声音数据进行识别并进行情感关怀。具体来说,在传统的车载语音链路中,在声音采集模块2051后,设置有:

143.声学前端模块301:用于处理语音激活检测,语音回声消除,语音降噪处理,从而得

到降噪后的语音。

144.意图识别模块302,用于理解降噪后的语音,从而识别出对应的语音意图。当然,此前也可以先采用快捷唤醒词唤醒识别功能。

145.执行模块303,用于根据语音意图执行对应操作。

146.在此之后,可通过输出模块206生成答复语回应用户。例如,驾驶员发出“降下车窗”的语音指示,在执行完对应操作后,输出模块206可输出答复语“已降下车窗”告知驾驶员。

147.而在新增的链路对声音数据进行识别时,参看图2的处理过程处理实际分类部分,并输出对应的问候语进行情感关怀。

148.值得注意的是,由于采集到的声音数据可能仅包含体征状态声音数据或环境状态数据,此时传统车载语音链路会当做噪音处理。而在新增的链路中针对性输出问候语进行情感关怀。若采集到的声音数据包含有用户语音指示,在此基础上还包含体征状态声音数据或环境状态数据中的一种。则此时传统车载语音链路会将体征状态声音数据或环境状态数据当做噪音处理,并识别用户语音命令得到语音意图进行操作。而新增的链路则处理体征状态声音数据或环境状态数据,并输出问候语进行情感关怀。

149.以上是本系统的执行逻辑,具体的细节参看前述方法实施例的描述,在此不再赘述。

150.基于与前述实施例中同样的发明构思,本说明书实施例还公开了一种计算机可读存储介质,其上存储有计算机程序,该程序被处理器执行时实现前文任一所述方法的步骤。

151.基于与前述实施例中同样的发明构思,本说明书实施例还公开了一种车载设备,包括存储器、处理器及存储在存储器上并可在处理器上运行的计算机程序,所述处理器执行所述程序时实现前文任一所述方法的步骤。

152.通过本说明书的一个或者多个实施例,本说明书具有以下有益效果或者优点:

153.本说明书公开了一种在车载场景下提供情感关怀的方法及系统,主要利用在常规识别时被当做噪音的咳嗽、喇叭等声音数据合并语音指示进行模型训练,并在模型训练时对此类声音数据和语音指示进行区分,从而使训练出的目标分类模型能够准确识别此类声音数据和语音指示的不同,并根据声音数据的类别提供对应的情感关怀,以此作为车载语音助手的扩展功能,增加了车载语音助手的情感关怀功能,从而提供更加人性化的驾驶体验。

154.在此提供的算法和显示不与任何特定计算机、虚拟系统或者其它设备固有相关。各种通用系统也可以与基于在此的示教一起使用。根据上面的描述,构造这类系统所要求的结构是显而易见的。此外,本说明书也不针对任何特定编程语言。应当明白,可以利用各种编程语言实现在此描述的本说明书的内容,并且上面对特定语言所做的描述是为了披露本说明书的最佳实施方式。

155.在此处所提供的说明书中,说明了大量具体细节。然而,能够理解,本说明书的实施例可以在没有这些具体细节的情况下实践。在一些实例中,并未详细示出公知的方法、结构和技术,以便不混淆对本说明书的理解。

156.类似地,应当理解,为了精简本说明书并帮助理解各个发明方面中的一个或多个,在上面对本说明书的示例性实施例的描述中,本说明书的各个特征有时被一起分组到单个

实施例、图、或者对其的描述中。然而,并不应将该公开的方法解释成反映如下意图:即所要求保护的本说明书要求比在每个权利要求中所明确记载的特征更多的特征。更确切地说,如下面的权利要求书所反映的那样,发明方面在于少于前面公开的单个实施例的所有特征。因此,遵循具体实施方式的权利要求书由此明确地并入该具体实施方式,其中每个权利要求本身都作为本说明书的单独实施例。

157.本领域那些技术人员可以理解,可以对实施例中的设备中的模块进行自适应性地改变并且把它们设置在与该实施例不同的一个或多个设备中。可以把实施例中的模块或单元或组件组合成一个模块或单元或组件,以及此外可以把它们分成多个子模块或子单元或子组件。除了这样的特征和/或过程或者单元中的至少一些是相互排斥之外,可以采用任何组合对本说明书(包括伴随的权利要求、摘要和附图)中公开的所有特征以及如此公开的任何方法或者设备的所有过程或单元进行组合。除非另外明确陈述,本说明书(包括伴随的权利要求、摘要和附图)中公开的每个特征可以由提供相同、等同或相似目的的替代特征来代替。

158.此外,本领域的技术人员能够理解,尽管在此的一些实施例包括其它实施例中所包括的某些特征而不是其它特征,但是不同实施例的特征的组合意味着处于本说明书的范围之内并且形成不同的实施例。例如,在下面的权利要求书中,所要求保护的实施例的任意之一都可以以任意的组合方式来使用。

159.本说明书的各个部件实施例可以以硬件实现,或者以在一个或者多个处理器上运行的软件模块实现,或者以它们的组合实现。本领域的技术人员应当理解,可以在实践中使用微处理器或者数字信号处理器(dsp)来实现根据本说明书实施例的网关、代理服务器、系统中的一些或者全部部件的一些或者全部功能。本说明书还可以实现为用于执行这里所描述的方法的一部分或者全部的设备或者装置程序(例如,计算机程序和计算机程序产品)。这样的实现本说明书的程序可以存储在计算机可读介质上,或者可以具有一个或者多个信号的形式。这样的信号可以从因特网网站上下载得到,或者在载体信号上提供,或者以任何其他形式提供。

160.应该注意的是上述实施例对本说明书进行说明而不是对本说明书进行限制,并且本领域技术人员在不脱离所附权利要求的范围的情况下可设计出替换实施例。在权利要求中,不应将位于括号之间的任何参考符号构造成对权利要求的限制。单词“包含”不排除存在未列在权利要求中的元件或步骤。位于元件之前的单词“一”或“一个”不排除存在多个这样的元件。本说明书可以借助于包括有若干不同元件的硬件以及借助于适当编程的计算机来实现。在列举了若干装置的单元权利要求中,这些装置中的若干个可以是通过同一个硬件项来具体体现。单词第一、第二、以及第三等的使用不表示任何顺序。可将这些单词解释为名称。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1