一种由舌部超声图像直接合成语音的方法与流程

1.本公开涉及电子信息技术,尤其涉及一种由舌部超声图像直接合成语音的方法。

背景技术:

2.无声语音接口技术的基本原理:通过传感器获取人体发音器官例如舌头,唇部的运动信号,并对信号进行处理和编码,然后选择恰当的模型与算法进行解码,最后合成、重建语音。这实现了非声学信号到声学信号的转换,用来达到无声交流的目的。

3.最相近似的实现方案:申请公开号为cn108538282a的专利,一种由唇部视频直接生成语音的方法。该方法通过采集唇部视频并将视频切分成图像序列,提取唇部特征序列并将其转换为语音帧编码参数向量序列,进而采用语音合成技术得到语音帧序列,并由语音帧特征数据合成语音。然而,通过唇部视频合成语音的方法在与智能设备交互时易受环境影响,有一定局限性;如光照条件较差或是使用者戴口罩时将不能达到很好的效果。此外,对于有唇语经验者,直接使用唇部视频也有个人信息被泄露的风险,保密性较弱。

技术实现要素:

4.针对上述现有技术,本发明旨在通过深度学习技术,直接通过超声成像方法找出人说话时舌头运动的特征,建立超声舌部图像与语音之间的映射关系,从而实现端到端的语音合成。该方法不易受环境影响,保密性较强。

5.为了实现上述目的,本发明的技术方案如下。

6.第一方面,本发明提出了一种由舌部超声图像直接合成语音的方法,所述方法包括下述步骤:

7.获取舌部的待识别信息,所述待识别信息包括有声或无声表达时舌部的动态特征;

8.基于跨模态学习模型,将所述待识别信息转换为梅尔频谱,并通过频谱重建时域信号,以获得合成语音;

9.其中,所述跨模态学习模型是采用深度学习方法训练出的用于将舌部的待识别信息换为梅尔频谱的模型。

10.在上述技术方案中,通过深度学习技术,建立舌部的待识别信息与梅尔频谱的映射关系,进而合成语音,不受环境影响,保密性较强,且不受面部光照或遮挡的影响。

11.在上述技术方案的一种实施方式中,所述频谱重建采用griffin-lim算法,以实现合成语音,该语音可以是变声、也可以还原的原声。

12.在上述技术方案的一种实施方式中,所述跨模态学习模型,采用编码器-解码器架构,编码器部分采用3d卷积提取图像特征,从而获得时间序列的舌部的待识别信息,解码器部分采用带注意力机制的lstm网络预测声学特征。

13.在上述技术方案的一种实施方式中,所述跨模态学习模型,训练过程中使用了teacher forcing和学习率衰变方法加速训练,提高模型效果。

14.在上述技术方案的一种实施方式中,所述跨模态学习模型采用下述数据进行训练,以使模型具有较好的转换性能,提高重建语音的质量:

15.使用超声仪采集带有声音的舌部超声视频记录,按每秒30帧的帧速率将视频转换为时间图像序列;

16.将每条舌部超声视频记录对应的时间图像序列作为输入,用于获取舌部的待识别信息;

17.提取视频的音频部分,将音频波形转换为梅尔频谱,并使每条舌部超声视频记录中的时间图像序列和梅尔频谱一一对应,将梅尔频谱作为训练标签。

18.作为上述技术方案的改进,所述每条舌部超声视频记录时长约3-5秒,以便获得能够合成语音的舌部静态特征和有声或无声表达时舌部动态特征。

19.第二方面,本发明提出了一种由舌部超声图像直接合成语音的装置,所述装置包括存储器和处理器,所述存储器上存储有能够被处理器加载并执行上述任一种方法的计算机程序。

20.第三方面,本发明提出了一种计算机可读存储介质,存储有能够被处理器加载并执行上述任一种方法的计算机程序。

21.第四方面,本发明提出了一种由舌部超声图像直接合成语音的系统,所述系统包括获取模块,跨模态学习模块;

22.所述获取模块,被配置用于获取舌部的待识别信息,所述待识别信息包括舌部的静态特征和有声或无声表达时舌部的动态特征;

23.所述跨模态学习模块,被配置用于基于跨模态学习模型,将所述待识别信息转换为梅尔频谱,并通过频谱重建时域信号,获得耳部可听的声音;

24.其中,所述跨模态学习模型是采用深度学习方法训练出的用于将舌部的待识别信息换为梅尔频谱的模型。

25.其中,所述跨模态学习模型,采用编码器-解码器架构,编码器部分采用3d卷积提取图像特征,解码器部分采用带注意力机制的lstm网络预测声学特征。

附图说明

26.为了更清楚地说明本技术实施例中的技术方案,下面将对实施例描述中所需要使用的附图作简单地介绍,显而易见地,下面描述中的附图仅仅是本技术的一些实施例,对于本领域普通技术人员来讲,在不付出创造性劳动性的前提下,还可以根据这些附图获得其他的附图。

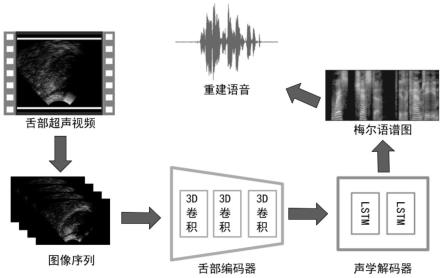

27.图1、一种实施方式中由舌部超声图像直接合成语音方法的流程示意图;

28.图2、一种实施方式中得到的编码器与解码器的注意力矩阵示意图;

29.图3、一种实施方式中原始语音与重建语音频谱对比示意图。

具体实施方式

30.下面将结合本技术实施例中的附图,对本技术实施例中的技术方案进行清楚、完整地描述,显然,所描述的实施例仅仅是本技术一部分实施例,而不是全部的实施例。

31.在第一类实施方式中,参加图1,所示意的一种由舌部超声图像直接合成语音的方

法包括下述步骤。

32.s100、获取舌部的待识别信息,所述待识别信息包括有声或无声表达时舌部的动态特征。

33.舌部的待识别信息通过下述方式获取:使用超声仪采集带有声音的或无声的舌部超声视频记录,每条视频记录约3-5秒,以便获得能够合成语音的舌部静态特征和有声或无声表达时舌部动态特征。按每秒30帧的帧速率将视频转换为图像序列,归一化尺寸后并标号排序。

34.s200、基于跨模态学习模型,将所述待识别信息转换为梅尔频谱,并通过频谱重建时域信号,以获得合成语音;其中,所述跨模态学习模型是采用深度学习方法训练出的用于将舌部的待识别信息换为梅尔频谱的模型。

35.上述步骤通过深度学习技术,建立舌部的待识别信息与梅尔频谱的映射关系,进而合成语音,不受环境影响,保密性较强,且不受面部光照或遮挡的影响。在一些实施例中,舌部的待识别信息还可以包括舌部的静态特征,即特定舌头位置空间特征。舌部的静态特征可用于非语言表达的识别确认,也可以用于特定字母、字词等单个语音的识别。当同时采用舌部的静态特征配合舌部的动态特征作为舌部的待识别信息,可提高语音表达识别的准确性。

36.跨模态深度学习模型,将舌部的待识别信息作为输入,提取舌部静态特征和有声或无声表达时舌部动态特征,输出声学特征,该声学特征能够用于建立梅尔频谱图,进而通过griffin-lim算法,实现合成语音,该语音可以是变声、也可以还原的原声。

37.在一种具体实施方式中,跨模态深度学习模型采用编码器-解码器架构,如图1所示,编码器采用3个3d卷积,解码器部分采用带有注意力机制的双lstm网络。其中,编码器部分用于提取图像特征,从而获得时间序列的舌部的待识别信息,解码器部分用于预测声学特征。

38.跨模态深度学习模型采用深度学习方法训练,使用高质量的训练数据,能够使模型具有高性能,提高重建语音的质量。

39.在一个具体训练方式中,采用下述步骤获得高质量的训练数据:

40.步骤1:使用超声仪采集带有声音的舌部超声视频,按每秒30帧的帧速率将视频转换为图像序列并标明序号。每条视频记录约3-5秒,总计1400多条,时常共计一小时左右。

41.步骤2:提取视频的音频部分,将音频波形转换为声学特征更加丰富的梅尔频谱并保存。每条视频记录中图像序列与梅尔频谱一一对应,作为模型训练时的标签使用。

42.使用上述预处理好的数据进行训练,图2为超声图像的舌部编码器与声学解码器之间的注意力矩阵,展示了模型目前的学习情况。在训练跨模态深度学习模型时,还可使用teacher forcing和学习率衰变方法加速训练,提高模型效果。

43.模型训练完成后,使用不带语音的舌部超声视频进行预测测试,图3将原始语音频谱与重建的语音频谱进行对比,展示了模型预测的准确程度。使用griffin lim算法,通过测试得到的频谱重建时域信号,得到人耳可听的声音波形。将得到的语音,采用下述标准进行语音质量评估,得到表1的结果:

44.pesq(语音质量感知评估):常用于模拟信号的主观测试(itu-tp.800),以评估人类感知的语音质量。它采用真实语音样本作为原始信号,表征用户感知的收听质量。

45.stoi/estoi(扩展/短时客观可懂度):stoi是语音清晰度的标准客观指标,被广泛应用于音素分离和韵律方面的研究。

46.表1

47.methodspesqstoiestoidnn-based1.2920.4060.210lstm-based1.3470.4570.268跨模态深度学习模型1.4310.5390.387

48.从表1可以看出,跨模态深度学习模型在客观评估标准中都优于基于lstm、dnn的模型。

49.在第二类实施方式中,根据上述实施方案转换成一种由舌部超声图像直接合成语音的装置,所述装置包括存储器和处理器,所述存储器上存储有能够被处理器加载并执行上述任一种方法的计算机程序。

50.第三类实施方式为一种由舌部超声图像直接合成语音的系统,所述系统包括获取模块,跨模态学习模块;

51.所述获取模块,被配置用于获取舌部的待识别信息,所述待识别信息包括舌部的静态特征和有声或无声表达时舌部的动态特征;

52.所述跨模态学习模块,被配置用于基于跨模态学习模型,将所述待识别信息转换为梅尔频谱,并通过频谱重建时域信号,获得耳部可听的声音;其中,所述跨模态学习模型是采用深度学习方法训练出的用于将舌部的待识别信息换为梅尔频谱的模型。具体地,所述跨模态学习模型,采用编码器-解码器架构,编码器部分采用3d卷积提取图像特征,解码器部分采用带注意力机制的lstm网络预测声学特征。

53.通过以上的实施方式的描述,所属领域的技术人员可以清楚地了解到本公开方法可借助软件加必需的通用硬件的方式来实现,当然也可以通过专用硬件包括专用集成电路、专用cpu、专用存储器、专用元器件等来实现。一般情况下,凡由计算机程序完成的功能都可以很容易地用相应的硬件来实现,而且,用来实现同一功能的具体硬件结构也可以是多种多样的,例如模拟电路、数字电路或专用电路等。但是,对本公开而言更多情况下,软件程序实现是更佳的实施方式。

54.综上,本发明通过收集包含声音的舌部超声视频数据,先将视频处理成图像序列,归一化尺寸后并标号排序,再将音频转化成梅尔频谱并与图像序列对齐。然后通过基于“编码器-解码器”框架建立跨模态学习模型,通过模型抽取图像与梅尔频谱的特征并寻找两者之间的映射关系。对于建立好映射关系的跨模态学习模型,在应用时,将采集的舌部超声视频数据输入模型,输出相应的声学特征。将声学特征转换成梅尔频谱,进而可通过频谱重建时域信号,得到耳朵可听的声音波形。

55.尽管以上结合附图对本发明的实施方案进行了描述,但本发明并不局限于上述的具体实施方案和应用领域,上述的具体实施方案仅仅是示意性的、指导性的,而不是限制性的。本领域的普通技术人员在本说明书的启示下和在不脱离本发明权利要求所保护的范围的情况下,还可以做出很多种的形式,这些均属于本发明保护之列。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1