一种基于半监督语音情感识别框架的深度情感聚类方法

本发明涉及一种基于半监督语音情感识别框架的深度情感聚类方法,属于语音情感识别。

背景技术:

1、语音情感识别(ser)是根据说话者的语音信号判断其情绪状态的传统的分类任务。图像和文本的分类方法特别关注数据特征上的空间相关信息和时间上下文信息。由于语音数据的空间和时间特性,这些方法不适合提取情感特征。半监督方法试图通过揭示大量未标记数据的潜在模式来学习特定类型数据的背景知识,从而为标记模型训练提供有用的先验知识。在工作中研究了半监督学习框架上空间和时间语音数据提取的挑战,该框架有效地应用于语音情感的分类。ser任务有两个基本处理步骤:语音特征提取和情感属性分类。语音特征提取受计算机视觉(cv)和自然语言处理(nlp)领域以及语音数据特征的影响,涉及在各自空间中学习语音帧的全局特征和语音上下文特征和时间。例如,chen,m.等人使用对数梅尔谱作为三维卷积的输入来捕获空间信息。在中,双向长短期记忆网络(bilstm)用于获取时间特征。在此之后的技术建立了一个同时包含卷积神经网络(cnn)和bilstm网络的模型,以在时间和空间上捕获信息。一种端到端的模式。对于时间信息,采用轻量级且长期可靠的网络双向门控循环单元(bigru)以双向方式学习语音上下文特征。情感属性分类进一步将提取的语音特征与任务目标相匹配。ser旨在分别在空间和时间维度上学习语音数据的情感特征。前者主要是从cv中的图像分类方法迁移而来,后者主要是借鉴了nlp中的自动编码器方法。对于提取语音空间特征的任务,现有技术使用预训练的alexnet模型来学习ser的深度频谱特征。aapb论文中直接设计了一个注意力池,为语音嵌入一个深度cnn,以增强学习空间特征的泛化能力。为了减少卷积计算和减轻内存需求,现有技术提出了一种新的扩张卷积并针对标准1d和2d过滤和卷积操作进行了调整。然而,这些卷积操作需要满足特定网络深度或池化层的要求才能访问全局信息。

2、半监督学习由学习特定领域背景知识的无监督学习过程和基于获得的背景知识初始化主干参数的监督学习过程组成。在cssl相关论文中,提出了一种新的对比半监督学习方法,该方法通过对比损失来提高学习语音表示的稳定性。mtssa的作者以无监督的方式重建语音数据,以增强模型的泛化能力,提高语音情感特征的表达能力。与这种丢失一些声学特征的重建方法相比,deepemocluster由deepcluster贡献,以使用k-means算法改进无监督学习特征。

3、语音情感识别(ser)根据说话者的语音信号确定说话者的情绪状态,是一项基本的分类任务。图像和文本的分类方法特别关注空间相关信息和时间相关信息,数据特征的上下文信息。考虑到语音数据的时空特征,这些方法不能用于完全提取情感特征。这是因为语音数据比图像具有更高的信息饱和度,比文本具有更高的时间连贯性。更具体地说,图像有两层(前景和背景)信息,其中背景信息通常是模型的噪声源,而语音数据(例如,频谱图)具有全景信息。随着语音的声学特性(例如强度和速度),在任何两个相邻元素之间的强相关性,而文本缺少此属性。

技术实现思路

1、本发明的目的在于提出一种基于半监督语音情感识别框架的深度情感聚类方法,从而克服现有技术中的不足。

2、本发明的特征提取器将注意力机制结合到卷积处理中,以引入语音帧的全局空间特征,可以将其扩展到具有卷积操作的任意神经网络,并可以选择调整attn-convolution块的数量以应用数据规模。本发明提出了一个新的attn-convolution块,它在卷积操作中引入全局特征,而不施加网络深度限制。对于学习语音时间特征,大多数语音情感工作都受到nlp贡献的启发。例如,利用bilstm来学习语音帧的前向和后向上下文相关性。或者引入了一个门控循环单元(gru)网络,该网络将语音嵌入总结为语音表示并减少学习参数。为了防止模型过度拟合并减少无监督学习所需的样本数量,使用bigru从前向和后向两个方向提取语音帧的上下文相关性。

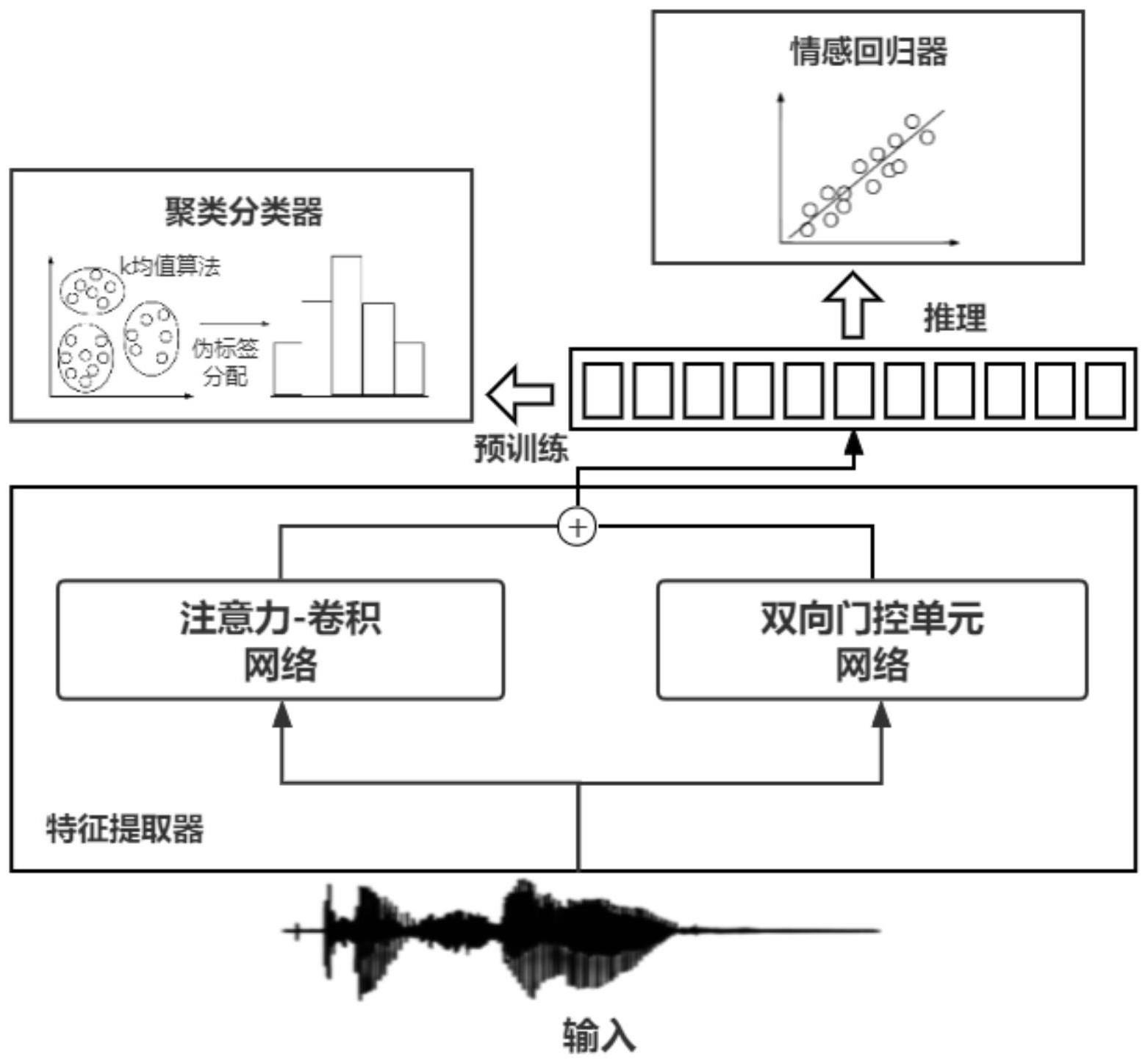

3、本发明的技术内容在于,基于深度情感聚类方法的时空共同捕获的半监督语音情感识别框架,简称acg-emocluster,包括以下方法:

4、步骤1,对输入的语料库中的音频进行预处理;

5、步骤2,使用由注意力机制与卷积操作搭建而成的深度学习网络,

6、简称attn-convolution网络,对预处理后的语音数据在空间上进行特征提取;

7、步骤3,使用由双向门控单元构建的深度学习网络,简称bigru网络,对预处理后的语音数据在时间上进行特征提取;

8、步骤4,将提取出的语音特征使用集成于pytorch框架的矩阵加和函数,简称add函数,进行特征融合;

9、步骤5,在聚类分类器模块中对未标记的数据集进行伪标签分配;

10、步骤6,在情感回归器中对每个句子i的语音片段sij进行回归预测,并将n个语音片段{si1,……,sin}进行归一化后的结果作为句子i的预测结果;

11、步骤7,使用新的ccc-ce联合损失作为回归器与分类器模型的损失函数;ccc为相关一致性系数损失,用于情感回归器中;ce为交叉熵损失,用于聚类分类器中。

12、所述的步骤1还包括以下方法:

13、步骤1.1,使用第三方库librosa工具包从原始语音数据中提取128维的梅尔谱图的声学嵌入作为acg-emocluster的输入,librosa是一个非常强大,可在pytorch环境中直接被调用于语音信号处理的第三方库;

14、步骤1.2,使用32毫秒窗口计算波形信号的幅度谱图,将融合32毫秒声学信息的频谱图作为128维的梅尔尺度滤波器的输入;

15、步骤1.3,计算滤波器组所有输出的均值和标准差;

16、步骤1.4,使用输出的均值和标准差对嵌入进行归一化;

17、步骤1.5,降低模型的输入维度,使用提出的块分割方法将归一化的频谱图均匀地划分为更小的子图,通过自适应地调整频谱块之间的重叠,将任意时长的语音序列分割成一组相同数量和维度的语音块;

18、步骤1.5.1,将dmax作为语音样本在数据集上的最大持续时间,tc作为每个语音样本的可配置块长度,其c是每个样本的嵌入块数通过作用于dmax和tc的上限函数:

19、

20、步骤1.5.2,计算持续时间为di的语音i的分段块之间的步长δci

21、

22、所述的步骤2还包括以下方法:

23、步骤2.1,以句子i中切割好的n个语音片段{si1,……,sin}作为acg-emocluster模型框架的输入;

24、步骤2.2,将原始数据{si1,……,sin}输入由注意力机制与卷积操作搭建而成的深度学习网络,简称attn-convolution网络中,其中网络使用的由注意力机制与卷积操作搭建而成的深度学习网络块,简称attn-convolution block,的数量为4,组成attn-convolution网络,block中的具体网络结构与处理步骤如下:

25、步骤2.2.1,以{si1,……,sin}作为原始输入,同时输入一个卷积核大小为3*3的convolution层与一个单头的自注意力机制;

26、步骤2.2.2,注意力机制中

27、其中querys为语音块s的查询矩阵,keys为语音块s的键矩阵,values为语音块s的值矩阵;在自注意力机制中,querys,keys,values均被赋值为同一矩阵;中,s表示截取的语音块,i表示句子的索引,即该处为第i个句子的语音块,ls表示该句子被切割后的语音片段数量,取值范围为[1,11];

28、步骤2.2.3,计算querys,keys间的cosine相似性:

29、

30、其中querys为语音块s的查询矩阵,keys为语音块s的键矩阵,values为语音块s的值矩阵;在自注意力机制中,querys,keys,values均被赋值为同一矩阵;similarity(querys,keys)表示使用querys,keys通过公式计算相关性,该公式名设定为similarity;

31、步骤2.2.4,通过得到的相似性similarityqk,计算softmax相关性得分

32、其中querys为语音块s的查询矩阵,keys为语音块s的键矩阵,values为语音块s的值矩阵;在自注意力机制中,querys,keys,values均被赋值为同一矩阵;softmax(querys·keys)使用querys,keys通过公式计算一种不同于similarity的相关性,该公式名设定为softmax;simqk为similarityqk的简称,ls表示该句子被切割后的语音片段数量,取值范围为[1,11];

33、步骤2.2.5,计算该片段sij的注意力值attention:

34、

35、步骤2.2.6,将从convolution层中得到的空间局部特征mapfconv与从attention得到的空间全局特征mapfattn,进行映射加和:

36、mapfa-c=linear(512,mapfattn)+linear(512,mapfconv);

37、步骤2.2.7,将融合的空间特征mapfa-c输入到一个convolution层中进行特征提取强化,得到mapfacc;

38、其中querys为语音块s的查询矩阵,keys为语音块s的键矩阵,values为语音块s的值矩阵;在本发明使用的自注意力机制中,querys,keys,values均被赋值为同一矩阵;convolution层为卷积操作层,mapfconv为经过卷积操作后获得的卷积特征映射图,mapfattn为经过注意力机制后获得的自注意力特征映射图,mapfa-c表示将mapfattn与mapfconv进行加和操作之后获得的卷积-注意力特征映射图;linear(512,mapfattn)表示使用线性层将mapfattn映射为512维度大小,linear(512,mapfconv)表示使用线性层将mapfconv映射为512维度大小;mapfacc表示经过一个自注意力机制与两个卷积操作层所获得的特征映射图。

39、所述的步骤4还包括以下方法:

40、步骤4.1,将从attn-convolution网络中得到的mapfacclast与从bigru中得到的mapftemp,使用线性加和方法进行特征融合操作,得到提取器的最终特征向量输出:

41、mapfacg=linear(512,mapfacclast)+linear(512,mapftemp);

42、mapfacclast表示经过使用了若干个使用如图二所示的搭建方法构建的attn-convolution网络块而构成的网络,所获得的特征映射图;mapftemp表示经过了双向门控单元网络而获得的特征映射图;linear(512,mapfacclast)表示使用线性层将mapfacclast映射为512维度大小,linear(512,mapftemp)表示使用线性层将mapftemp映射为512维度大小。

43、所述的步骤7还包括以下方法:

44、步骤7.1,情感聚类分类器中将交叉熵损失ce用于分类任务,情感回归器将一致性相关系数ccc作为损失应用于回归任务;

45、步骤7.2,完成一种在语音情感识别上的多任务深度学习,因此将联合loss=(1-ccc)+λ×ce作为整体模型框架中的损失函数;

46、其中λ为控制情感聚类分类器在多任务学习时的重要程度,是一个可控的参数,本发明中设置为1;ccc为相关一致性系数损失,用于情感回归器中,ce为交叉熵损失,用于聚类分类器中,loss指本发明中使用的损失函数。

47、本发明的有益效果在于,受deepcluster框架的启发,该框架使用k-means迭代地对提取的语音特征进行聚类,然后使用学习的先验知识初始化模型的权重以用于下游任务。本发明提出了一种新的半监督框架,简称acg-emocluster,用于学习语音数据的空间和时间特征。特别是,采用了一个语音特征提取器,它结合了attn-convolution神经网络和bigru,其中前者通过卷积运算与注意力机制获得语音帧的空间特征,而后者获得语音上下文特征。此外,为了学习语音数据的先验知识,聚类分类器使用k-means算法通过对提取的语音特征进行分组来分配伪标签。对于推断,通过学习的先验知识初始化的方法在语音情感识别的唤醒、支配和效价方面优于msp-podcast语料库上的全监督和半监督基线测试。在半监督学习的背景下,对获得的语音特征进行伪标记,为下游任务提供一些背景信息。使用较少未标记数据的模型框架比现有的半监督框架实现了更好的语音表示,并且在下游任务中优于最先进的方法。此外,所提出的attn-convolution块可以扩展到任何cnn架构。

- 还没有人留言评论。精彩留言会获得点赞!