交通工具数据关联设备及其方法与流程

1.本公开的各个方面涉及来自图像数据的语音识别和基于语音的对象识别。

背景技术:

2.自主交通工具和部分自主交通工具通常依赖于多个传感器来检测与交通工具周围环境有关的信息,并基于该信息来做出驾驶决策。此类传感器可能包括例如多个相机、一个或多个光检测与测距(lidar)系统、一个或多个无线电检测与测距(radar)系统、麦克风、加速计和/或位置传感器。由于这些传感器生成大量的数据,因此可能需要自主交通工具对这些大量的数据进行解析以用于其驾驶操作。

3.处理这些数据的一个特定挑战是在相关传感器数据与不相关传感器数据之间进行辨别的能力。人工神经网络(ann)被越来越多地用于处理传感器数据和达成驾驶决策。人工神经网络可能特别适于该项任务,因为人工神经网络可以被配置成用于接收和快速解析大量的数据。

4.然而,成功实现用于此类传感器数据的解析的ann需要大量的训练。一个特别具有挑战性的任务是教导ann在相关的传感器数据与不相关的传感器数据之间进行区分。换言之,虽然人类驾驶员可能能够相对容易地区分相关的视觉或听觉信息,但ann在没有附加训练的情况下可能无法做到这一点。

附图说明

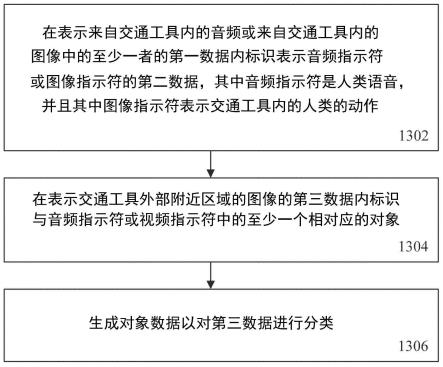

5.在附图中,贯穿不同的视图,相同的附图标记一般指代相同部分。这些附图不一定是按比例的,而是一般着重于说明本公开的示例性原理。在下列描述中,参照下列附图描述本公开的各个示例性方面,在附图中:图1示出根据本公开的各个方面的示例性自主交通工具;图2示出根据本公开的各个方面的交通工具的安全性系统的各种示例性电子组件;图3描绘了配置有多个传感器的示例性交通工具;图4描绘了根据本公开的一方面的交通工具内部400;图5描绘了基于人类语音的对象标注算法;图6描绘了注视被用来标识对象的示例;图7描绘了根据本公开的一方面的眼睛注视检测器;图8示出了根据本公开的一方面的镜向注视的计算;图9描绘了手部姿势检测器,该手部姿势检测器可以被配置成用于检测一个或多个手部姿势或手部位置;图10描绘了根据本公开的一方面的数据合成器和标注器;图11描绘了根据本公开的一方面的数据存储设备;图12描绘了根据本公开的一方面的交通工具数据关系设备;以及

图13描绘了交通工具数据关联的方法。

具体实施方式

6.下列具体实施方式引用附图,这些附图通过说明的方式示出示例性细节以及本公开可在其中实施的各方面。

7.在本技术中使用词“示例性”来意指“充当示例、实例或说明”。在本技术中被描述为“示例性”的任何方面或设计不一定被解释为相对于其它方面或设计为优选的或有优势的。

8.贯穿附图,应注意,除非另有说明,否则相同的附图标记用于描绘相同或相似的要素、特征和结构。

9.短语“至少一个”和“一个或多个”可被理解为包括大于或等于一的数量(例如,一个、两个、三个、四个、[...]等)。关于一组要素的短语“至少一个”在本文中可用于意指来自由要素组成的组的至少一个要素。例如,关于一组要素的短语

“……

中的至少一个”在本文中可用于意指以下各项中的选择:所列要素中的一个、多个的所列要素中的一个要素、多个个体所列要素、或多个的数个个体所列要素。

[0010]

说明书和权利要求书中的词语“复数个(plural)”和“多个(multiple)”明确地指代大于一的量。因此,任何明确地援引上述词语来指代某个数量的要素的短语(例如,“复数个[要素]”、“多个[要素]”)明确地指代多于一个的所述要素。例如,短语“多个(a plurality)”可被理解为包括大于或等于二的数量(例如,两个、三个、四个、五个、[...]等)。

[0011]

说明书中和权利要求书中的短语“(

……

的)组”、“(

……

的)集”、“(

……

的)集合”、“(

……

的)系列”、“(

……

的)序列”、“(

……

的)分组”等(如果存在)指代等于或大于一的量,即一个或多个。术语“适当的子集”、“减小的子集”、和“较小的子集”指代集合的不等于该集合的子集,说明性地,指代集合的包含比该集合少的元素的子集。

[0012]

如本文中所使用的术语“数据”可被理解为包括采用任何合适的模拟或数字形式的信息,例如,作为文件、文件的部分、文件集合、信号或流、信号或流的部分、信号或流的集合等等来提供的信息。进一步地,术语“数据”还可用于意指对信息的例如以指针的形式的引用。然而,术语“数据”不限于上述示例,并且可采取各种形式并表示如本领域中理解的任何信息。

[0013]

例如,如本文中所使用的术语“处理器”或“控制器”可被理解为允许处置数据的任何种类的技术实体。可根据由处理器或控制器执行的一个或多个特定功能来处置数据。进一步地,如本文中所使用的处理器或控制器可被理解为任何种类的电路,例如任何种类的模拟或数字电路。处理器或控制器因此可以是或可包括模拟电路、数字电路、混合信号电路、逻辑电路、处理器、微处理器、中央处理单元(cpu)、图形处理单元(gpu)、数字信号处理器(dsp)、现场可编程门阵列(fpga)、集成电路、专用集成电路(asic)等、或其任何组合。下文将进一步详细描述的相应功能的任何其他种类的实现方式也可被理解为处理器、控制器或逻辑电路。应理解,本文中详述的处理器、控制器或逻辑电路中的任何两个(或更多个)可被实现为具有等效功能的单个实体等等,并且相反地,本文中详述的任何单个处理器、控制器或逻辑电路可被实现为具有等效功能的两个(或更多个)分开的实体等等。

[0014]

如本文中所使用,“存储器”被理解为数据或信息可以被存储在其中以供检取的计算机可读介质(例如,非暂态计算机可读介质)。对本文中所包括的“存储器”的引用可因此被理解为是指易失性或非易失性存储器,包括随机存取存储器(ram)、只读存储器(rom)、闪存、固态存储、磁带、硬盘驱动器、光驱、3d xpoint

tm

等等、或其任何组合。在本文中,寄存器、移位寄存器、处理器寄存器、数据缓冲器等等也可由术语存储器包含。术语“软件”是指任何类型的可执行指令,包括固件。

[0015]

除非明确地指定,否则术语“发射”涵盖直接(点对点)和间接(经由一个或多个中间点)的发射两者。相似地,术语“接收”涵盖直接和间接的接收两者。此外,术语“发射”、“接收”、“传递”和其他相似术语涵盖物理传输(例如,对无线电信号的传输)和逻辑传输(例如,通过逻辑软件级连接对数字数据的传输)两者。例如,处理器或控制器可通过与另一处理器或控制器的软件级连接以无线电信号的形式对数据进行发射或接收,其中,物理发射和接收由诸如rf收发机和天线之类的无线电层组件处置,并且通过软件级连接的逻辑发射和接收由处理器或控制器执行。术语“传递”涵盖发射和接收中的一者或两者,即,在传入方向和传出方向中的一个方向或这两个方向上的单向或双向传输。术语“计算”涵盖经由数学表达式/等式/关系进行的

‘

直接’计算和经由查找表或散列表以及其他数组索引或搜索操作进行的

‘

间接’计算两者。

[0016]

可以将“交通工具”理解为包括任何类型的被驱动对象。作为示例,交通工具可以是具有内燃机、反作用式引擎、电驱动对象、混合驱动对象或其组合的被驾驶对象。交通工具可以是或者可以包括汽车、公共汽车、小型公共汽车、货车、卡车、房车、车辆拖车、摩托车、自行车、三轮车、火车机车、火车车厢、移动机器人、个人运输机、船只、船、潜水器、潜艇、无人机、飞机或火箭等。

[0017]

术语“自主交通工具”可描述能够在不具有驾驶员输入的情况下实现至少一种导航改变的交通工具。导航改变可描述或包括交通工具的转向、制动、或加速/减速中的一者或多者的改变。即使在交通工具不是完全自动(例如,在有驾驶员输入或无驾驶员输入的情况下完全操作)的情况下,也可以将交通工具描述为自主的。自主交通工具可以包括可以在某些时间段内在驾驶员控制下操作并且在其他时间段内无需驾驶员控制而操作的那些交通工具。自主交通工具还可包括仅控制交通工具导航的一些方面的交通工具,交通工具导航的一些方面诸如转向(例如,在交通工具车道约束之间维持交通工具路线)或在某些情形下(但并非在所有情形下)进行一些转向操作,但可能将交通工具导航的其他方面留给驾驶员(例如,在某些情形下进行制动或刹车)。自主交通工具还可以包括在某些情形下共同控制交通工具导航的一个或多个方面的交通工具(例如,动手操作(诸如响应于驾驶员的输入))和在某些情形下控制交通工具导航的一个或多个方面的交通工具(例如,放手操作(诸如独立于驾驶员的输入))。自主交通工具还可以包括在某些情形下(诸如在某些环境状况下(例如,空间区域、道路状况))控制交通工具导航的一个或多个方面的交通工具。在一些方面,自主交通工具可以处置交通工具的制动、速率控制、速度控制和/或转向的一些或所有方面。自主交通工具可以包括可以在没有驾驶员的情况下操作的那些交通工具。交通工具的自主性级别可以由交通工具的汽车工程师协会(sae)级别(例如,由sae例如在sae j3016 2018:道路机动交通工具的驾驶自动化系统相关术语的分类和定义中定义)或由其他相关专业组织进行描述或确定。sae级别可以具有范围从最小级别(例如,0级(说明性地,

基本上没有驾驶自动化))到最大级别(例如,5级(说明性地,完全驾驶自动化))的值。

[0018]

在本公开的上下文中,“交通工具操作数据”可被理解为描述与交通工具的操作有关的任何类型的特征。作为示例,“交通工具操作数据”可描述交通工具的状态,诸如,交通工具的轮胎的类型、交通工具的类型、和/或交通工具的制造的时限。更一般地,“交通工具操作数据”可描述或包括静态特征或静态交通工具操作数据(说明性地,不随时间改变的特征或数据)。作为另一示例,附加地或替代地,“交通工具操作数据”可描述或包括在交通工具的操作期间改变的特征,例如,交通工具的操作期间的环境状况(诸如天气状况或道路状况)、燃料水平、液位、交通工具的驱动源的操作参数等。更一般地,“交通工具操作数据”可描述或包括变化的特征或变化的交通工具操作数据(说明性地,时变特征或数据)。

[0019]

本文中本公开的各个方面可利用一个或多个机器学习模型来执行或控制交通工具的功能(或本文中所描述的其他功能)。例如,本文使用的术语“模型”可以被理解为根据输入数据提供输出数据的任何种类的算法(例如,从输入数据生成或计算输出数据的任何种类的算法)。机器学习模型可由计算系统执行以渐进地改进特定任务的性能。在一些方面中,可在训练阶段期间基于训练数据来调整机器学习模型的参数。可在推断阶段期间使用经训练的机器学习模型基于输入数据来作出预测或决策。在一些方面中,可使用经训练的机器学习模型来生成附加训练数据。可在第二训练阶段期间基于所生成的附加训练数据来调整附加机器学习模型。可在推断阶段期间使用经训练的附加机器学习模型来基于输入数据作出预测或决策。

[0020]

本文中所描述的机器学习模型可采取任何合适的形式或利用任何合适的技术(例如,以用于训练目的)。例如,这些机器学习模型中的任何机器学习模型均可利用监督式学习、半监督式学习、无监督式学习、或强化学习技术。

[0021]

在监督式学习中,可使用训练数据集来建立模型,该训练数据集既包括输入又包括对应的期望输出(说明性地,每个输入可与针对该输入的期望或预期输出相关联)。每个训练实例可包括一个或多个输入并且包括期望输出。训练可包括通过训练实例迭代以及使用目标函数来教导模型预测针对新的输入的输出(说明性地,对于训练集中不包括的输入)。在半监督式学习中,训练集中的输入中的部分可能缺少相应的期望输出(例如,一个或多个输入可能不与任何期望或预期的输出相关联)。

[0022]

在无监督式学习中,可从仅包括输入而不包括期望输出的训练数据集来建立模型。无监督式模型可用于说明性地通过发现数据中的模式而找到该数据中的结构(例如,对数据点的分组或聚类)。可在无监督式学习模型中实现的技术可包括例如自组织图、最近邻映射、k均值聚类、以及奇异值分解。

[0023]

强化学习模型可包括正反馈或负反馈以改善准确性。强化学习模型可尝试使一个或多个目标/回报最大化。可在强化学习模型中实现的技术可包括例如q学习、时间差(td)和深度对抗网络。

[0024]

本文中所描述的各个方面可利用一个或多个分类模型。在分类模型中,输出可限于值的有限集合(例如,一个或多个类)。分类模型可输出针对具有一个或多个输入值的输入集合的类。输入集合可包括传感器数据,诸如图像数据、无线电检测与测距传感器(radar)数据、光检测与测距传感器(lidar)数据等等。如本文中所描述的分类模型可例如对某些驾驶状况和/或环境状况(诸如,天气状况、道路状况)等等进行分类。本文中对分类

模型的引用可构想实现例如下列技术中的任何一种或多种技术的模型:线性分类器(例如,逻辑回归或朴素贝叶斯分类器)、支持向量机、决策树、提升树、随机森林、神经网络或最近邻。

[0025]

本文中所描述的各个方面可利用一个或多个回归模型。回归模型可基于具有一个或多个值的输入集合(说明性地,从具有一个或多个值的输入集合开始或使用具有一个或多个值的输入集合)输出连续范围中的数字值。本文中对回归模型的引用可设想实现例如下列技术(或其他合适技术)中的任何一种或多种技术的模型:线性回归、决策树、随机森林、或神经网络。

[0026]

本文中所描述的机器学习模型可以是或可包括ann。ann可以是任何种类的神经网络,诸如卷积神经网络、自编码器网络、变分自编码器网络、稀疏自编码器网络、循环神经网络、去卷积网络、生成性对抗网络,前瞻性神经网络、和积神经网络等等。ann可包括任何数量的层。对ann的训练(例如,调整神经网络的层)可使用或可基于任何种类的训练原理,诸如反向传播(例如,使用反向传播算法)。

[0027]

贯穿本公开,下列术语将作为同义词来使用:驾驶参数集,驾驶模型参数集,安全层参数集,驾驶员辅助、自动化驾驶模型参数集,和/或类似术语(例如,驾驶安全参数集)。

[0028]

此外,贯穿本公开,下列术语将作为同义词来使用:驾驶参数、驾驶模型参数、安全层参数、驾驶员辅助和/或自动化驾驶模型参数、和/或类似术语(例如,驾驶安全性参数)。

[0029]

图1示出根据本公开的各个方面的示例性交通工具,即交通工具100。在一些方面,交通工具100可以包括一个或多个处理器102、一个或多个图像采集设备104、一个或多个位置传感器106、一个或多个速度传感器108、一个或多个无线电检测与测距传感器110、和/或一个或多个光检测与测距传感器112。

[0030]

在一些方面,交通工具100可包括(如下文参考图2所描述的)安全性系统200。应领会,交通工具100和安全性系统200本质上是示例性的,并且因此可出于解释的目的而被简化。要素的位置和关系距离(如上文所讨论的,这些图并未按比例绘制)是作为示例而提供,并不限于此。取决于特定实现方式的要求,安全性系统200可以包括各种组件。

[0031]

图2示出根据本公开的各个方面的交通工具的各种示例性电子组件,即安全性系统200。在一些方面,安全性系统200可包括一个或多个处理器102、一个或多个图像采集设备104(例如,一个或多个相机)、一个或多个位置传感器106(例如,全球导航卫星系统(gnss)、全球定位系统(gps)等)、一个或多个速度传感器108、一个或多个无线电检测与测距(radar)传感器110、和/或一个或多个光检测与测距(lidar)传感器112。根据至少一个方面,安全性系统200可进一步包括一个或多个存储器202、一个或多个地图数据库204、一个或多个用户接口206(例如,显示器、触摸屏、话筒、扬声器、一个或多个按钮和/或开关等)、和/或一个或多个无线收发器208、210、212。在一些方面,无线收发器208、210、212可根据相同的、不同的无线电通信协议或标准或其任何组合来配置。作为示例,无线收发器(例如,第一无线收发器208)可以根据短程移动无线电通信标准(例如,蓝牙、zigbee等)来进行配置。作为另一示例,无线收发器(例如,第二无线收发器210)可以根据中程或宽程移动无线电通信标准(例如,根据对应的3gpp(第三代合作伙伴计划)标准的3g(例如,通用移动通信系统

–

umts)、4g(例如,长期演进

–

lte)和/或5g移动无线电通信标准等)来进行配置。作为进一步地示例,无线收发器(例如,第三无线收发器212)可以根据无线局域网通信协议或标准(例

如,ieee802.11、802.11a、802.11b、802.11g、802.11n、802.11p、802.11-12、802.11ac、802.11ad、802.11ah等)进行配置。一个或多个无线收发器208、210、212可以被配置成通过空中接口经由天线系统传送信号。

[0032]

在一些方面,一个或多个处理器102可以包括应用处理器214、图像处理器216、通信处理器218和/或任何其他合适的处理设备。取决于特定应用的要求,(多个)图像采集设备104可包括任何数量的图像采集设备和组件。图像采集设备104可包括一个或多个图像捕捉设备(例如,相机、ccd(电荷耦合器件)、或任何其他类型的图像传感器)。

[0033]

在至少一个方面,安全性系统200还可包括将一个或多个处理器102通信地连接至一个或多个图像采集设备104的数据接口。例如,第一数据接口可包括任何有线和/或无线的一个或多个第一链路220,该一个或多个第一链路220被配置成用于将由一个或多个图像采集设备104获取的图像数据传送至一个或多个处理器102(例如,传送到图像处理器216)。

[0034]

在一些方面,无线收发器208、210、212可经由例如第二数据接口耦合至一个或多个处理器102(例如,耦合至通信处理器218)。第二数据接口可包括任何有线和/或无线的一个或多个第二链路222,该一个或多个第二链路222被配置成用于将由无线收发器208、210、212获取的无线电传送的数据传送至一个或多个处理器102(例如,传送至通信处理器218)。

[0035]

在一些方面,存储器202以及一个或多个用户接口206可例如经由第三数据接口耦合至一个或多个处理器102中的每个处理器。第三数据接口可以包括任何有线和/或无线的一个或多个第三链路224。此外,位置传感器106可例如经由第三数据接口耦合至一个或多个处理器102中的每个处理器。

[0036]

此类传输还可包括交通工具100与交通工具100的环境中的一个或多个其他(目标)交通工具之间的通信(例如,单向或双向)(例如,以促进交通工具100鉴于在交通工具100的环境中的其他(目标)交通工具或与其他(目标)交通工具一起进行的导航的协调),或甚至向正在发射的交通工具100附近的未指定接收者进行广播传输。

[0037]

收发器208、210、212中的一个或多个收发器可被配置成实现一个或多个交通工具对外界(v2x)通信协议,该交通工具对外界(v2x)通信协议可以包括交通工具对交通工具(v2v)、交通工具对基础设施(v2i)、交通工具对网络(v2n)、交通工具对行人(v2p)、交通工具对设备(v2d)、交通工具对网格(v2g)、以及其他协议。

[0038]

一个或多个处理器102中的每个处理器214、216、218可包括各种类型的基于硬件的处理设备。作为示例,每个处理器214、216、218可包括微处理器、预处理器(诸如图像预处理器)、图形处理器、中央处理单元(cpu)、支持电路、数字信号处理器、集成电路、存储器,或适合用于运行应用以及用于图像处理和分析的任何其他类型的设备。在一些方面,每个处理器214、216、218可包括任何类型的单核或多核处理器、移动设备微控制器、中央处理单元等。这些处理器类型可各自包括具有本地存储器和指令集的多个处理单元。此类处理器可包括用于从多个图像传感器接收图像数据的视频输入,并且还可包括视频输出能力。

[0039]

本文中所公开的处理器214、216、218中的任一者可被配置成用于根据可被存储在一个或多个存储器202中的存储器中的程序指令来执行某些功能。换言之,一个或多个存储器202中的一个存储器可存储在由处理器(例如,由一个或多个处理器102)执行时控制系统(例如,安全性系统)的操作的软件。例如,一个或多个存储器202中的存储器可存储一个或多个数据库和图像处理软件、以及经训练的系统(诸如神经网络、或深度神经网络)。一个或

多个存储器202可以包括任何数量的随机存取存储器、只读存储器、闪存、盘驱动器、光盘存储设备、磁带存储设备、可移动存储设备和其它类型的存储设备。

[0040]

在一些方面,安全性系统200可进一步包括诸如用于测量交通工具100的速度的速度传感器108(例如,速度计)之类的组件。安全性系统还可包括用于测量交通工具100沿一个或多个轴线的加速度的一个或多个(单轴或多轴)加速度计(未示出)。安全性系统200可进一步包括附加传感器或不同的传感器类型,诸如超声波传感器、热传感器、一个或多个无线电检测与测距传感器110、一个或多个光检测与测距传感器112(其可集成在交通工具100的前照灯中)等等。无线电检测与测距传感器110和/或光检测与测距传感器112可以被配置成用于提供经预处理的传感器数据,诸如无线电检测与测距目标列表或光检测与测距目标列表。第三数据接口可以将速度传感器108、一个或多个无线电检测与测距传感器110、以及一个或多个光检测与测距传感器112耦合至一个或多个处理器102中的至少一个处理器。

[0041]

一个或多个存储器202可将数据存储在例如数据库中或以任何不同格式存储数据,这些数据例如指示已知地标的位置。一个或多个处理器102可以处理交通工具100的环境的传感信息(诸如图像、无线电检测与测距信号、来自对两个或更多个图像的光检测与测距或立体处理的深度信息)以及位置信息(诸如gps坐标、交通工具的自我运动等),以确定交通工具100相对于已知地标的当前位置,并细化对交通工具的位置的确定。该技术的某些方面可以被包括在定位技术(诸如映射和路由模型)中。

[0042]

地图数据库204可包括存储用于交通工具100(例如,用于安全性系统200)的(数字)地图数据的任何类型的数据库。地图数据库204可以包括与各种项目(包括道路、水景、地理特征、商业、感兴趣的点、餐馆、加油站等)在参考坐标系中的位置相关的数据。地图数据库204不仅可以存储此类项目的位置,还可以存储与这些项目相关的描述符,包括例如与存储的特征中的任何特征相关联的名称。在此类方面中,一个或多个处理器102中的处理器可通过到通信网络的有线或无线数据连接(例如,通过蜂窝网络和/或互联网等)从地图数据库204下载信息。在一些情形下,地图数据库204可存储稀疏数据模型,包括针对交通工具100的某些道路特征(例如,车道标记)或目标轨迹的多项式表示。地图数据库204还可以包括各种识别出的地标的所存储的表示,这些所存储的表示可被提供以确定或更新交通工具100相对于目标轨迹的已知位置。地标表示可以包括诸如地标类型、地标位置、以及其他潜在标识符之类的数据字段。

[0043]

此外,安全性系统200可包括例如在高级驾驶辅助系统(adas)和/或驾驶辅助系统及自动化驾驶系统中实现的驾驶模型。作为示例,安全性系统200可以包括(例如,作为驾驶模型的一部分的)形式模型(诸如,安全性驾驶模型)的计算机实现方式。安全性驾驶模型可以是或可包括对适用于自驾驶(地面)交通工具的可适用法律、标准、政策等的解释进行形式化的数学模型。安全性驾驶模型可被设计为实现例如三个目标:第一,法律的解释在它符合人类如何解释法律的意义上应该听起来是合理的;第二,解释应该带来有用的驾驶策略,这意味着它将带来灵活的驾驶策略而不是过度防御性的驾驶,该过度防御性的驾驶不可避免地会使其他人类驾驶员感到迷惑并将阻塞交通,并且进而限制系统部署的可缩放性;以及第三,在可以严格地证明自驾驶(自主)交通工具正确地实现该法律的解释的意义上,解释应当是高效地可验证的。说明性地,安全性驾驶模型可以是或可包括用于安全保障的数学模型,该数学模型实现对危险情况的恰当响应的标识和执行,使得可以避免自身导致的

事故。

[0044]

如上文所述,交通工具100可包括安全性系统200,还参考图2来描述该安全性系统200。

[0045]

交通工具100可包括例如与交通工具100的引擎控制单元(ecu)集成或分离的一个或多个处理器102。

[0046]

一般而言,安全性系统200可生成数据来控制或辅助控制ecu和/或交通工具100的其他组件,以直接地或间接地控制对交通工具100的驾驶。

[0047]

实现用于自主驾驶的ann的一个挑战是训练ann以在相关和不太相关(例如,不相关、不太直接相关)的传感器数据之间进行区分。这可以类比为新手驾驶员。尽管新手驾驶员可能已经发展了出色的视觉和听觉敏锐性,并且可能能够准确地感知交通工具的周围环境,但新手驾驶员可能难以将更重要的信息与不太重要的信息进行区分。说明性地,新手驾驶员可能会将划定的公路的相对侧上的救护车赋予过度的重要性,或者没有意识到离公路几米处的骑自行车的小孩的重要性。随着新手驾驶员驾驶能力的发展,新手驾驶员学会了发现感官信息中的危险,并将适当的权重(例如重要的或不重要的、相关的或不相关的)赋予传感器信息的各个方面。

[0048]

ann必须经历类似的训练,以允许其能够在相关的信息与不相关的信息之间进行辨别。也就是说,ann必须被训练以接收传感器信息(例如各个传感器数据流或多个传感器数据流),并标识传感器数据中的对驾驶决策具有特别相关性的方面或部分。反之,ann可以被配置成用于标识不太相关或不相关的传感器数据。

[0049]

如上文所述,ann的训练可能导致对与其节点或层相关联的一个或多个权重的修改和/或对一个或多个函数(例如,一个或多个激活函数)的修改。由于存在可能影响ann训练细节的各种ann类型和实现方式,并且鉴于期望技术人员理解节点和/或函数级别下的ann训练的细节,本公开将主要描述更高级别的训练函数,其中传感器数据的一个或多个流被分析以得到相关性并且被交叉参考。使用这些技术,并根据本公开的一个方面,ann可以标识和标注相关的传感器数据,以用于处理驾驶决策。根据本公开的另一方面,ann可以利用这些技术来将相关信息与不相关信息辨别开来。

[0050]

在用于训练ann的已知工作量中,诸如为了评估自主驾驶情境中的传感器数据,供应商可能收集数百小时或甚至数千小时的传感器数据,这些传感器数据结合与交通工具的附近区域相对应的所记录的数据(诸如与道路边界和可驾驶表面、交通标志、静态对象、移动对象和位置数据有关的数据)示出人类驾驶员的动作。使用该数据,ann可以学习将某些外部传感器输入与某些驾驶员的动作进行匹配。在此类常规方法中,难以向ann教导某些情况下的具体危险,因为通常存在来自驾驶员的明显反应,或者因为实际上没有发生事故。换言之,因为有经验的人类驾驶员(例如训练项目的模范驾驶员)可以在没有对正在避免的危险或为避免危险而采取的步骤的任何明显提示的情况下,在整个正常操作中避免或防止危险,所以ann从这些情况中学习的能力可能是有限的。相比之下,人类教员可以利用教员的经验来识别和指导有关潜在的危险。在一些情况下,甚至在碰撞即将发生或可能发生之前,教员可能能够对潜在危险进行评论或指导。感知驾驶指令的能力表示一种用于增强或替代现有的方法来训练ann以进行驾驶操作的有效策略。

[0051]

本公开尤其描述了用于捕获人类驾驶教员的输入或指令,并通过将该信息与一个

或多个附加信息源(诸如与交通工具中的新手驾驶员的动作和/或附加传感器信息)进行交叉参考来学习,使得ann学习标注危险的驾驶情况和/或将这些危险情况映射到人类驾驶员的正确和不正确行为的示例的策略。以此方式,人类驾驶行为可以与基于传感器的环境模型一起被记录;此外,潜在的危险驾驶情况可以被指出,并且对感知到的危险的正确反应被记录。由于潜在的危险可能在交通工具操作期间不会作为实际的危险实现,所以传统的方法在没有对这些潜在危险进行明确评论的情况下,可能无法领会此类潜在危险的重要性。

[0052]

驾驶教员在识别危险情况并向新手驾驶员(例如他们的学生)描述危险情况的方面是经验丰富的。新手驾驶员在其整个驾驶指导中会表现出正确的行为和不正确的行为两者,并且驾驶教员的原则任务是对这些行为进行评论或“标注(label)”。老师和学生之间的这种交流可以被用来改善自动化交通工具对危险情况的评估(例如,用来训练ann以更好地评估传感器数据)。

[0053]

如上文关于与新手驾驶员的类比或与其中乘客向驾驶员提供指令的另一交通工具类比所述,驾驶员的教育项目(例如课程、指导课、实践课等)通常在教员和学生一起在交通工具或交通工具模拟器中的情境下执行。贯穿本公开,术语“交通工具”用于驾驶员教育的情境中;然而,明确说明术语“交通工具”也可以指交通工具模拟器。通常,学生将操作交通工具(例如,坐在驾驶员座椅上),而教员提供驾驶输入,诸如口头指令、身体提示(例如,姿势、指向、其他身体语言),或者在一些情况下,甚至对方向盘或制动器进行实体操作。该驾驶输入可以用来训练ann。换言之,该驾驶输入可以被分析,并与传感器数据交叉参考,以在更加相关的传感器数据与不太相关的传感器数据之间进行区分。

[0054]

自主交通工具、半自主交通工具(例如,执行一个或多个自主驾驶操作但不能持续地完全独立于人类控制的交通工具)以及甚至占主导的非自主交通工具经常配备有多个传感器,这些传感器可以检测与交通工具内部或外部区域有关的信息(例如,交通工具的内部、交通工具外部附近区域等)并生成对应的传感器数据。一个或多个传感器可以被连接(例如,被导电地连接)至一个或多个处理器,或者可以被配置成用于(例如,经由一个或多个发射器和接收器)将传感器数据无线地发送到一个或多个处理器。图3描绘了配置有多个传感器的示例性交通工具。在该图中,交通工具包括多个外部传感器(例如,面向外的传感器),该多个外部传感器被配置成用于检测交通工具附近区域内的环境,包括但不限于,可驾驶的路径、车道标记、静态和移动对象(例如,其他交通工具)和交通标志。传感器可以被布置成用于围绕交通工具360

°

覆盖,使得既可以领会前向操作又可以领会反向操作。此类传感器可包括一个或多个图像传感器(例如相机、相机、深度相机等)302a和一个或多个测距传感器(例如光检测与测距(lidar)、无线电检测与测距(radar))302b。外部传感器可任选地包括可被配置成用于检测外部和/或环境噪声的一个或多个麦克风(未示出)。

[0055]

交通工具可配备有可被配置成用于检测交通工具内部的信息的一个或多个面向内的视觉传感器304a。这些传感器可以包括一个或多个图像传感器(例如单声道或立体声相机)和/或一个或多个新型传感器,诸如可以能够检测(诸如来自驾驶教员和/或驾驶员的)眼睛注视和/或姿势的事件相机。交通工具还可以配备有可以被配置成用于记录交通工具内的(诸如驾驶教员和/或驾驶员的)语音的一个或多个面向内的麦克风304b。交通工具可配备有可被配置成用于检测速度、加速度、转向和/或制动的交通工具致动传感器306。交通工具可以包括可被配置成用于检测定位、位置和/或航向数据的一个或多个位置传感器

308(例如,一个或多个全球导航卫星系统(gnss)传感器)。交通工具可包括数据存储系统308(例如,存储器、硬盘、固态驱动器、光驱等),上述传感器数据的一些或全部可(例如,在驾驶课程的持续时间内、在预定的持续时间内、无限期地,等等)存储在该数据存储系统308上。交通工具可以包括一个或多个守时器(例如时钟、处理器时钟、gnss守时设备等)(未示出),该一个或多个守时器可以允许设备在所有传感器数据流之间创建同步的时间戳。此类同步对于后续的数据流的比较可能是有用的或甚至是必要的。交通工具可以包括高带宽数据连接,交通工具可以经由该高带宽数据连接将所收集的传感器数据上传到外部设备(例如,服务器、数据储存库等)。替代地或附加地,交通工具可以包括一个或多个数据传输器(未示出),该一个或多个数据传输器可以包括一个或多个总线、一个或多个端口、一个或多个数据传输电缆等。此类传感器数据的上传可以连续地发生或者在训练轮次之后发生。

[0056]

交通工具可包括一个或多个处理器和包括指令的一个或多个非暂态计算机可读介质,这些指令如果被执行则使一个或多个处理器解释驾驶员和/或驾驶教员的注视、姿势和语音中的任何一项,并创建可以根据其将危险情况与外部传感器数据相关联的标签。这些指令可以包括用于外部和内部场景解释的一种或多种机器学习算法。

[0057]

在一些情形中,尽管与学生(新手驾驶员)相关的此类数据可能是有用的,但与驾驶教员的注视、姿势、语音或上述各项中的任何一项相关的数据可能比与学生相关的此类数据更有用,或更持续有用。在一些情形中,学生的反应和相关的转向、加速和/或制动数据在如本文所述的数据参考和/或标签生成中可能是有用的。当交通工具包括一个或多个处理器和如本文所述的非暂态计算机可读介质时,如本文所述的传感器数据参考和标签生成功能可在交通工具内执行。替代地或附加地,这些功能可以在交通工具外部执行(例如,在相关数据被上传到的设备中,无论是与驾驶指令同时地/并发地执行还是在驾驶指令之后执行)。例如,可能存在(诸如针对所有参与的驾驶教学学校的交通工具的)中央存储和处理设施。在该情形中,所有相关/合格的交通工具可以将其数据上传到中央存储和处理设施。

[0058]

传感器数据参考和标签生成可随着交通工具操作实时地执行(例如在线)或在交通工具操作之后执行(例如离线)。无论是在线还是离线,都可以基于所期望的实现方式来选择配置。由于传感器数据参考和标签生成根据传感器数据来执行(该传感器数据可以以其整体被记录),因此预计不会从离线配置中发生分析质量的任何损失。

[0059]

该设备可以基于来自交通工具内部的输入来标注外部传感器数据。图4描绘了根据本公开的一个方面的内部(例如,通过挡风玻璃的内部的程式化视图)400。在该图中,挡风玻璃被描绘为包括教员部分402(例如,通常与乘客的座椅相对应)和驾驶员部分410(通常与驾驶员的座椅相对应)。如上文所述,内部可包括可被配置成用于检测和记录交通工具的内部内的语音或人类声音(例如,非语音发声)的一个或多个麦克风404。交通工具还可以包括可以被配置成用于检测信息并生成交通工具的内部的对应的图像数据的一个或多个相机(未示出)。尽管交通工具内部的任何方面均可用于本文所公开的原理和方法,但一个或多个处理器可被配置成用于检测图像数据内的、可提供相关信息的某些标记。这些标记可以包括教员406的注视、教员407的面部表情、教员408的姿势(例如,手部姿势)、新手驾驶员412的注视,或上述各项中的任一项。

[0060]

根据本公开的一个方面,一个或多个处理器可以基于驾驶教员的一个或多个评论来标注外部传感器数据。人类语音可以传递不同程度的信息内容。因此,为了处理和理解与

传感器数据相关的人类语音,首先针对人类语音的(多个)内容类型来分析人类语音可能是有用的。此类内容类型可以包括,例如:危险的位置(例如,“右前方”);对危险中涉及的(多个)对象(例如:“一群年长的女士”)的标识;对可能的后果的说明(例如,“他们可能在没有观看的情况下就迈上道路”);正确的动作的说明(例如,“观察”、“准备制动”、“减速”、“向右转”、“按喇叭”等);或上述各项中的任一项。

[0061]

根据本公开的一方面,一个或多个处理器可以被配置成用于至少基于人类语音来标注对象的不相关性。为了利用人类语音(例如,基于人类语音来标识危险或相关性),一个或多个处理器可以被配置成用于识别人类语音内的模式或关键字。在下文中,描述了用于标注相关对象的关键字分析的描述。

[0062]

一个或多个处理器可被配置成用于利用语音数据作为主模式来触发增加的相关性对传感器数据的归因。一个或多个处理器可以利用对象分布关键字来对与人类语音相关的特定对象或对象组进行分类。该一个或多个处理器可被配置成用于(例如,使用对象检测网络分析)将对象检测算法并行地应用于外部传感器输入。例如,如果语音识别类别是自行车,则图像传感器数据中的所有自行车都被标记(例如标注)为是危险的或是潜在危险的。如果检测到若干个相同类型的对象(例如,如果图像传感器数据内存在多于一个的自行车),则一个或多个处理器可以被配置成用于按相关性对多个对象进行排名。可以基于任何期望的因素来确定相关性。根据本公开的一个方面,一个或多个处理器可被配置成用于基于与相同关键字相对应的多个对象距自我交通工具的距离在相关性方面来对该多个对象进行排名。

[0063]

所接收的人类语音可被视为包括多个关键字,每个关键字潜在地提供与危险或对象的位置或相关性有关的信息。尽管关键字结构可以以各种方式实现,但下文描述了示例性关键字实现方式。在该实现方式中,关键字可以由以下类别来定义:a)提醒关键字。提醒关键字可以包括表明对即将发生的危险的警觉性的增加的需求或即将发生的危险的可能性的任何关键字。此类关键字可以包括,但不限于,“注意”、“小心”、“留心”、“看”、或“当心”。附加地或替代地,此类提醒关键字可以不完全与某个词本身相对应,而是同与对即将发生的危险的警觉性需求或即将发生的危险的可能性相关联的发声,诸如“啊(ack)”、“哇(woah)”、“呃(uhh)”等。b)方向关键字。方向关键字可包括表明方向(诸如相对于说话者的方向、相对于驾驶员的方向、相对于交通工具的方向或其他方向)的任何关键字。此类方向关键字可以包括但不限于“在前方”、“向左”、“向右”、“在左方”、“在右方”、“向上”、“向下”、“后面”或其他方向关键字。c)定性位置关键字。定性位置关键字可以包括表明相对于参考点的位置的任何关键字。参考点可以是任何事物,但不作为限制,并且可以包括但不限于人、道路、建筑、交通工具、动物和其他对象。定性位置关键字的示例可以包括但不限于“在下一个交叉口处”、“在公共车站后面”、“在人行道上”、“在白色汽车旁边”、“在道路上方”、“在桥下面”、“在垃圾箱前面”、“在标志旁边”,或者其他示例。d)对象描述关键字。对象描述关键字可以包括描述一个或多个对象的任何关键

字。在该情形中,对象可以包括有生命的对象、无生命的对象、动物、人,或其任何组合。对象描述关键字可相对于对驾驶员或交通工具构成风险的对象使用。对象描述关键字可包括但不限于“一群儿童”、“两辆自行车”、“拖车”、“年长的女士”、“骑自行车者”、“慢跑者”等。e)动作关键字。动作关键字可包括表明要由驾驶员或交通工具执行的动作的指令的关键字。在驾驶指导的情境中,驾驶教员可能被要求以命令的形式提供与感知到的危险相关的指示。动作关键字可以与指令密切相关联,使得一个或多个动作关键字的存在可以允许底层系统标识指令并将该指令与驾驶命令关联。动作关键字的示例包括但不限于“慢一点”、“快一点”、“停车”、“靠边停车”、“快速经过”、“快速超车”、“转向”、“急转弯”、“制动”、“信号灯”等等。

[0064]

人类语音中的关键字识别至少需要语音识别的功能级别。也就是说,一个或多个处理器必须分析表示人类语音的麦克风数据,并且一个或多个处理器必须从该人类语音中标识单词、短语、句子或上述各项中的任一项。由于计算机化语音识别是众所周知的,将不在本文中详细描述。相反,假设技术人员将理解如何实现一个或多个语音识别程序,以检测音频数据内的人类语音。此类语音识别程序通常被配置成用于接收音频文件并用于输出与所识别的人类语音相对应的文本。对于上述与关键字相关的描述,假设此类识别在用于关键字识别的文本中或用于关键字识别的任何其他合适形式中是可用的。

[0065]

根据本公开的一方面,设备可被编程成用于执行推断阶段,在该推断阶段期间检测到人类交互。对于推断阶段,声音识别可以是机器学习工具链中的主模式。当识别提醒关键字时,新的提醒标签可以被启动(例如,被生成、被实现、被执行)。该关键字随后可与外部传感器数据相关联。与提醒关键字同时存在的外部传感器数据可能被认为是最相关的。替代地或附加地,稍微在提醒关键字之前的外部传感器数据可能是特别相关的。这由驾驶教员的认知过程需要时间来领会交通工具外部的情况(例如,对象和危险等),并且随后制定和表达与所领会的情况相关的口头说明或反应的事实进行了最佳解释。因此,任何口语都可以归因于紧接在该字之前发生的传感器数据。替代地,由于对象和某些危险情况的相对持久性,在说出与危险有关的关键字之前顷刻间地领悟到的危险很可能在说出该关键字时继续存在。因此,一个或多个处理器可被配置成用于将相关性归因于与所讲的关键字同时存在的传感器数据的部分。

[0066]

取决于教员的指令中所包含的信息的丰富性,将由传感器记录的整个场景映射到指令或者仅将某个区域或某些对象映射到指令以进行标注可以是可能的。

[0067]

也就是说,在与关键字相关的对象被标识的情况下,一个或多个处理器可被配置成用于通过应用定性关键字位置来进一步限制外部传感器数据(例如图像传感器数据、无线电检测与测距、光检测与测距等)内的聚焦区域。更具体地,说话者可以说出与对象组内的特定对象相对应的定性关键字位置。更具体地,并且继续假设的自行车示例,教员可以说出:“小心!标志旁的自行车”。以此方式,“小心”是将导致一个或多个处理器将传入的传感器数据标注为在预定的持续时间内具有增加的相关性的注意力关键字。关键字“自行车”描述了传感器数据内的对象,并且一个或多个处理器可以被配置成用于定位传感器数据内的一个或多个自行车。例如,前向相机可以递送表示其中存在三辆自行车的交通工具附近区域的传感器数据。一个或多个处理器可被配置成用于将这三辆自行车中的每一辆自行车均标注为是特别相关的。接下来,关键字“在标志旁”描述最相关的自行车的位置。以此方式,

一个或多个处理器可以被配置成用于定位标志并用于确定该标志与各个自行车之间的接近度。最接近标志的自行车可以被标识为驾驶员要小心提防的标志旁的自行车。一个或多个处理器可被配置成用于将该自行车标注为比其他所识别的自行车更重要。

[0068]

图5描绘了基于人类语音的对象标注算法。在该图中,一条道路和三个儿童的四个场景被描绘为502、504、506和508。这些场景是按时间顺序描绘的,并基于人类语音来指示对象标识的时序。在第一场景502中,教员利用提醒关键字“注意”。如上所述,该提醒关键字可以指示视场中的一个或多个对象产生了对附加谨慎的需要。因为未提供与危险的源有关的标识信息,因此一个或多个处理器可以将整个视场标注为是特别相关的。这由502的全阴影的视图来描绘。也就是说,一个或多个处理器可以将与提醒关键字同时存在或基本同时存在的所有图像数据标注为具有增加的相关性。一个或多个处理器可以被配置成用于从后续人类语音中得出附加的关键字,以进一步标识危险。

[0069]

在下一个场景504中,教员利用对象描述关键字“小孩”来跟进。一个或多个处理器可被配置成用于识别该关键字,并用于搜索已经被标记为具有增加的相关性的图像数据中是否有与关键字“小孩”相关联的对象。一个或多个处理器可以为此目的利用任何已知的对象检测算法。在检测到图像传感器数据中的一个或多个“小孩”后,一个或多个处理器可被配置成用于将具有增加的相关性的区域限制为与“小孩”大体上相对应的区域。以此方式,一个或多个处理器能够将较小的区域标注为具有增加的相关性,从而允许在相关材料与不相关材料之间进行进一步区分。

[0070]

在下一个场景506中,教员利用定性位置关键字“在道路上(on the road)”。假设该定性位置关键字以与提醒关键字在时间上紧密的关系说出,则一个或多个处理器可以被配置成用于将具有增加的相关性的区域进一步缩小为在道路上有儿童的区域。当然,这需要“道路(road)”的附加情境,并确定道路位于何处,以及“在

……

上(on)”的情境。通过利用情境短语“在

……

上(on)”和“在道路上(on the road)”,一个或多个处理器可以对已标识的儿童中的目前正在道路上的一个儿童进行搜索。在该情形中,当前仅一个孩子在道路上,并且因此一个或多个处理器可以将具有增加的相关性的区域限制为围绕道路上的单个儿童的区域。

[0071]

在下一个场景508中,可以为所确定的具有增加的相关性的区域提供附加置信度。在场景502、504和506内做出的确定可以相对于置信度水平来确定。也就是说,可以利用一个或多个附加的口头关键字或姿势来增加或减少506中描绘的位置的置信度水平。

[0072]

尽管图5中的场景被描绘为按照提醒关键字、对象描述关键字和定性位置关键字的顺序实现,但应具体说明,可以在与图5中描绘的过程类似的过程中利用任一类别或顺序的提醒关键字、方向关键字、定性位置关键字、对象描述关键字、动作关键字或上述各项中的任一项。也就是说,图5是对标识相关对象的关键字使用的示例性描绘;然而,关键字和/或关键字的顺序可以相对于图5中的关键字和/或关键字的顺序而变化。关键字的顺序可能在很大程度上取决于教员的语音中的单词的顺序,并且因此底层系统在理想情况下应该能够以不同的顺序处理关键字。

[0073]

替代地或附加地,一个或多个处理器可以被配置成用于使用教员或乘客的眼睛注视和/或一个或多个所检测的人类姿势来标识对象。因为教员很可能提供口头或听觉指令,眼睛注视和人类姿势可能主要用作对口头指令的补充,使得一个或多个处理器可以基于眼

睛注视或人类姿势进一步细化对象标识,或者可以基于眼睛注视或人类姿势来改善对象标识置信度水平。尽管如此,还可以设想教员可以提供人类姿势来标识危险,而无需同时提供口头或听觉指令。因此,应明确指出,本文所公开的关于使用眼睛注视和人类姿势进行对象标识和/或置信度确定的原理和方法可以结合语音指令来使用或者独立于语音指令来使用。

[0074]

根据本公开的一方面,一个或多个处理器可以被配置成用于识别注视方向。也就是说,一个或多个处理器可被配置成用于根据图像传感器数据确定人类注视的方向(例如,注意力的焦点、眼睛的方向)。允许注视检测的基本假设是,人们经常看着他们正在讨论的对象。根据该假设,一个或多个处理器可以确定人类注视的方向,并将该方向与交通工具附近区域中的对象相关联。一旦所述对象被确定,就可能进一步将同时说出的文本或关键字与该对象相关联。例如,教员在看到骑自行车者正朝向交通工具的行进路径行进时可能会注视骑自行车者的方向,同时大声说出一个或多个关键字,诸如“小心!”。通过检测教员的注视,注视的方向可能与骑自行车者相关联,并且随后提醒关键字“小心”可以使一个或多个处理器将更高级别的重要性或相关性与骑自行车者关联。

[0075]

在对注视方向的识别期间,一个或多个处理器可被配置成用于根据图像传感器数据确定人类注视的方向(例如,注意力的焦点、眼睛的方向)。允许注视检测的基本假设是,人们经常看着他们正在讨论的对象。根据该假设,一个或多个处理器可以确定人类注视的方向,并将该方向与交通工具附近区域中的对象相关联。一旦所述对象被确定,就可能进一步将同时说出的文本或关键字与该对象相关联。例如,看到骑自行车者正朝向交通工具的行进路径行进时的教员可能会注视骑自行车着的方向,同时大声说出一个或多个关键字,诸如“小心!”。通过检测教员的注视,注视的方向可能与骑自行车者相关联,并且随后提醒关键字“小心”可以使一个或多个处理器将更高级别的重要性或相关性与骑车者关联。

[0076]

根据本公开的另一方面,基于人类语音对数据的标注可由注视(例如,教员观看的方向;与注视相对应的何种外部对象)和/或姿势(例如,教员指向某个方向)支持。新手驾驶员的反应可以被任选地记录,并被映射到教员的评论,所述映射在评论之后的有限(例如预定的)时间内发生,因为此类反应的相关性在大多数情况下与刺激紧密相关(例如,反应在时间上紧跟刺激(指令)时可能更相关,但其相关性随着与刺激在时间上的远离而减少)。

[0077]

眼睛注视方向估计对于许多人机交互应用是重要的。注视方向的知识给出与用户注意力焦点有关的信息。对于用于眼睛注视方向的分类的实时框架,最初,一个或多个处理器可以被配置成用于实现面部检测器。该面部检测器可以是任何已知的面部检测系统。根据本公开的一个方面,面部检测器可以包括viola-jones算法,该viola-jones算法是已经被成功地实现用于面部检测的已知的对象检测框架。

[0078]

图6描绘了注视被用来标识对象的示例。在该图像中,自我交通工具的附近区域包括自行车602和两个行人604。在没有进一步的信息的情况下,可能不会立即清楚自行车602或两个行人604中的哪一者对自我交通工具构成危险,或以其他方式与自我交通工具具有增加的相关性。在该示例中,教员提供口头说明“小心!”,并盯着自行车。一个或多个处理器可被配置成用于解释教员的语音,以检测单词“小心!”。在仅有关键字“小心!”的情况下,显而易见的是交通工具附近区域中的某事物需要提高的警觉性;但是,并不能立即显而易见的是该对象是什么(例如,是自行车还是行人)。然而,如果教员注视着自行车的同时说出“小心!”,则一个或多个处理器可能会把教员的注视与自行车进行关联,并且因此将相关性区域606缩小到自行车周围的区域,而不是将整个附近区域视为特别不相关。类似地,如果教员喊道:“小心!”,同时指向自行车或以其他方式向自行车做出手势,则一个或多个处理器可将指向自行车或向自行车做出手势与自行车进行关联,并且因此将相关性区域606缩小到自行车周围的区域。

[0079]

替代地或附加地,一个或多个处理器可以被配置成用于利用一个或多个方向关键字与注视和/或手部姿势一起,以进一步增加对位置中的所标识的对象的信任。在此,注视方向可能是特别重要的。一个或多个处理器可以利用注视方向来标识传感器数据内具有特定重要性的对象和/或在具有特定重要性的对象是多个对象中的某个对象时,标识该对象。继续该自行车示例,在假设一个或多个处理器在传感器数据内检测到三辆自行车时,教员可能会注视被认为是特别相关性或有风险的自行车。一个或多个处理器可被配置成用于确定注视方向,并将该注视方向与外部传感器数据相关联,使得可以确定教员正在注视特定的自行车。以此方式,被注视的自行车可以被标注为比其他所标识的自行车更重要。

[0080]

在应用面部检测之后(例如,在检测到面部之后),一个或多个处理器可以被配置成用于对所检测到的面部执行粗略的眼睛区域检测。眼睛区域检测可以利用任何已知的眼睛区域检测算法或过程。已知的眼睛区检测过程可以依赖于几何关系和面部特征来定位和标识眼睛。一旦检测到眼睛区域,一个或多个处理器可被配置成用于对眼睛注视方向进行分类。一个或多个处理器可被配置成用于实现用于眼睛注视检测的卷积神经网络(cnn)。以此方式,该一个或多个处理器可以确定眼睛注视的方向

[0081]

眼睛注视的方向可以取决于教员的两只眼睛的方向。根据本公开的一方面,cnn可以被配置成用于独立地确定每只眼睛的注视方向(例如,诸如确定左眼的方向,接着确定右眼的方向)。使用这些所确定的方向,一个或多个处理器可以计算融合得分以对眼睛注视进行分类。也就是说,一个或多个处理器可以被配置成用于确定两个所确定的眼睛注视方向的平均数或中点,使得左眼的所确定的方向和右眼的所确定的方向可以被协调。该经协调的或经融合的方向性得分可被分类为眼睛注视。

[0082]

存在若干个可用于眼睛注视分类的数据集。例如,eye chimera是允许眼睛注视检测的已知的数据库。根据本公开的一方面,一个或多个处理器和/或cnn可以利用eye chimera来检测教员或交通工具内的其他人员的眼睛注视。

[0083]

图7描绘了根据本公开的一方面的眼睛注视检测器702。眼睛注视检测器可以包括面部检测器702,和眼睛区域定位器704,以及眼睛注视方向分类器706。这些组件可以被实现为(例如,处理器中的、处理器组中的、集成电路上的、片上系统上的,等等)单个组件,或者可以被实现在多个组件中。这些组件可以被实现为要由一个或多个处理器执行的软件。这些组件可以被实现为ann。面部检测器702可以接收交通工具内部的图像传感器数据,并可以对图像传感器数据执行一个或多个面部检测算法。可以针对给定的实现方式选择所采用的具体面部检测算法。根据本公开的一方面,可以使用viola jones算法,尽管实现方式不限于使用viola jones算法。面部检测器702可以输出与其中面部已被检测到的图像传感器数据相对应的图像的部分的标签或其他标识符。眼睛区域定位器704可以接收图像传感器数据、与所检测的面部相对应的图像传感器数据、和与所检测的面部的区域相对应的标识符或上述各项中的任一项,并且可以对与所检测的面部的区域相对应的数据执行眼睛区

域定位。在眼睛区域定位期间,眼睛区域定位器704可以实现用于确定与所检测的面部相对应的区域内存在眼睛的一种或多种算法。眼睛区域定位器704可以实现用于定位眼睛的任何已知的眼睛区域定位算法。这些可以包括但不限于,基于形状的模型(例如,诸如基于半椭圆头部模型来检测眼睛的算法或基于广义头部变换来定位眼睛区域的算法);基于特征的形状方法;基于外观的方法;或其任何组合。在对眼睛区域进行定位后,眼睛区域定位器704可以输出由与眼睛区域相对应的传感器数据表示的图像内的位置的标识符。注视方向分类器706可以接收该标识符并确定注视方向。用于根据图像数据确定注视方向的各种策略是已知的,并且可以针对给定的实现方式选择合适的注视方向过程。在一些情况下,注视可以仅根据眼睛位置来确定。在其他情况下,注视可以根据相对于头部位置的眼睛位置来确定。在其他情况下,注视可以根据相对于固定参考点的眼睛位置来确定,诸如交通工具内部的部分。眼睛注视方向分类器706可以输出可以表示注视的方向的注视方向标识符。该标识符是面部特征、身体部位、头部的部分或轴线、交通工具内的参考点、交通工具外部的参考点或其他。

[0084]

根据本公开的一方面,注视检测器可以在ann(包括但不限于cnn)内实现。ann可能特别适于快速评估图像传感器数据以确定注视方向。ann可以被训练成使用经注释的数据708来检测注视方向。作为一般原则,可以假设教员正在注视作为教员的关键字的受试者的对象。因此,当检测到关键字以及当一个或多个关键字被用来标识本文所述的具有增加的相关性的对象时,标识具有增加的相关性的对象的经注释的数据(例如其位置、其类型或身份或其他)可被发送到注视方向分类器706。使用该经注释的数据,注视方向分类器706可以将交通工具附近区域中的对象的位置与所检测的注视方向进行比较。通过将注视方向映射到外部图像传感器数据,注视检测器可以确定注视方向分类的准确性。也就是说,假设由关键字描述的对象是教员的注视的受试者,注视方向应该与所检测的对象的位置相对应。注视方向与对象的位置之间的任何差异都可以在训练阶段中用于改善注视检测器的结果。

[0085]

值得注意的是,注视方向可以包括直接视线注视方向和/或反射镜注视方向。在视线注视方向中,交通工具可以根据交通工具内部的传感器数据(例如相机数据或其他数据)确定教员的注视方向。一个或多个处理器也具有与交通工具外部附近区域相对应的传感器数据(图像传感器数据、光检测与测距、无线电检测与测距等)。一个或多个处理器可以确定说话者的注视方向,诸如相对于说话者的注视方向、相对于交通工具的注视方向、相对于交通工具内固定点的注视方向或其他。内部传感器数据(例如内部麦克风、内部相机)和外部传感器数据(例如图像传感器数据、光检测与测距、无线电检测与测距)可以各自被加盖时间戳,这随后允许将内部传感器数据与同时存在的外部传感器数据进行比较。当检测到注视方向时,一个或多个处理器可以被配置成用于分析同时存在的外部传感器数据(例如,具有与所检测的注视方向相同的、相似的、同时存在的或重叠的时间戳的外部数据),并用于在与注视相对应的传感器数据中标记或标注为具有更高的相关性的对象。

[0086]

一个或多个处理器可以被配置成用于在对对象的视线注视与对反射镜的注视(在本文被称为“反射镜注视”)之间进行区分。图8示出了根据本公开的一方面的反射镜注视的计算。在该图中,描绘了具有前挡风玻璃802和后挡风玻璃804的交通工具的表示。驾驶员或乘客806处于交通工具内并且被描述为正朝向后视镜808注视。如果注视检测器和/或一个或多个处理器简单地检测注视的方向(例如角度)并将该方向与交通工具外部的对象相关

联,注视检测器和/或一个或多个处理器可能会忽略后视镜808并且替代地将注视视为在超出前挡风玻璃802的直线路径上继续,如810所描绘的那样。如果对象沿着该路径定位(如812所示),则注视检测器和/或一个或多个处理器可能错误地将驾驶员或乘客806的注视与该对象812相关联。相反,注视检测器和/或一个或多个处理器有必要考虑后视镜808的存在以及它对驾驶员或乘客806的注视的影响。具体地,驾驶员或乘客806正在沿反射路径816观看障碍物814的反射。

[0087]

为了实现这一点,一个或多个处理器可以被配置成用于确定驾驶员或乘客是否正在朝向反射镜(例如,后视镜或其他反射镜)注视,并确定反射角。反射定律表明反射角与入射角相等,即:θi=θrꢀꢀꢀꢀꢀꢀ

(1)其中θi是相对于垂直于反射镜表面的轴线的入射角818a,并且θr是相对于垂直于反射镜表面的轴线的反射角818b。也就是说,一个或多个处理器可被配置成用于确定反射镜的角度或位置以及相对于反射镜的法线的入射角,并根据该计算确定反射角。一旦确定了反射角,反射角就可以与外部传感器数据相匹配,以确定教员或乘客正在注视的对象。例如,如果教员或乘客正在观看后视镜,则一个或多个处理器可以确定与朝向交通工具后方的视线相对应的反射角,并且一个或多个处理器可以使用该反射角将乘客或教员的注视与交通工具后面的对象相匹配。尽管这关于后视镜进行了示例性描述,但这些原理可适用于任何其他反射镜,包括但不限于一个或多个侧视镜。

[0088]

如上所述,并且根据本公开的另一方面,一个或多个处理器可被配置成用于识别(诸如图像传感器数据(例如,来自向内转向驾驶员和/或乘客的相机的数据)中的)一个或多个人类姿势。此类人类姿势可至少包括以下各项:a)指向某个方向。教员可以在指向某一特定方向的同时递送指令。通常,此类指向结合口头参考执行。也就是说,教员可以(例如,诸如利用对象描述关键字)对对象进行命名并指向对象。可以结合与对象的位置有关的说明(诸如利用方向关键字或定性位置关键字)来执行指向对象,在这种情况下,指向用于通过口头命令加强对对象的标识,或以其他方式简化对对象的标识。替代地,可以执行指向以代替与对象的位置有关的陈述,诸如仅仅指向对象并对其进行命名(例如“骑自行车者”)。b)注意标志(例如,举起的食指)。某些姿势可能与对注意力的增加的需要相关联。这些姿势可能在文化上是特定的,并且因此没有特定的姿势可能是通用的。相反,与注意力相关联的一个或多个特定姿势可以被选择用于满足特定实现方式的需要。例如,在一些国家,在没有任何附加言语或非言语交流的情况下,举起的食指可能指示对注意力的增加的需要。c)否定性标志。某些姿势可能与否定相关联,这可能表明当前的动作方式是不正确的并且应该被放弃,或者表明先前的指令应被忽略。此类否定性姿势也可能是特定于文化的,并且因此可以针对给定的实现方式来进行选择。此类否定性姿势的示例可以包括但不限于,左右摇头、左右挥动一只或多只手或其他否定性姿势。d)停车姿势。某些手势可能与需要停车相关联。此类停车姿势也可能是特定于文化的,并且因此可以针对给定的实现方式来进行选择。与需要停车相关联的已知姿势包括但不限于:单臂向前伸展,手腕弯曲;或双臂向前伸展,大致相互平行,手腕弯曲。

[0089]

根据本公开的一方面,一个或多个处理器和/或ann可以被配置成用于检测一个或

多个手部姿势和/或检测一个或多个手部姿势的方向。出于不同目的,姿势识别已被用于许多系统。基于图像数据的姿势识别是已知的,并且可以使用用于确定图像数据中的姿势的任何合适的方法。

[0090]

图9描绘了手部姿势检测器,该手部姿势检测器可以被配置成用于检测一个或多个手部姿势或手部位置,如上所述。手部姿势检测器可包括手部检测器902,该手部检测器902可接收图像传感器数据(例如,来自面向交通工具内部的相机的图像传感器数据/交通工具内部的图像传感器数据)并可采用一种或多种手部检测算法来检测图像传感器数据内的手部。各种已知的手部检测算法和过程是可用的。例如,已知的手部检测算法利用皮肤颜色、手部形状、手部外壳凸度、手指形状或上述各项中任一项来检测手部。无论选择何种实现方式,手部检测器都能在图像数据中检测出手部。然后,处置定位器904可以对所检测的手部的位置进行定位,并输出相对于由图像传感器数据表示的图像的手部位置。一旦手部被检测到并被定位,手部姿势识别器908就可以标识手部姿势。

[0091]

根据本公开的一方面,手部姿势识别器可以被配置为ann(例如,包括但不限于cnn)。例如,作为手部姿势识别器的cnn的已知实现方式已经示出根据图像传感器数据标识微手部姿势(诸如左/右滑动、下/上轻弹、轻拍、无以及其他动作)的能力。此类cnn可以被进一步训练以标识其他手部姿势,诸如指向、注意标志、停车姿势、或任何其他期望的手部姿势。

[0092]

手部姿势检测器的接下来的步骤取决于手部姿势识别器908的确定。如果908中所识别的手部姿势不是指向性姿势(例如,它是注意标志、停车姿势等),则手部姿势识别器908可以输出对所确定的手部姿势的标识。所确定的手部姿势可以与一个或多个关键字或动作相关联。例如,注意标志可与提醒关键字类似地被处理,诸如最初将交通工具的整个附近区域标注为具有增加的相关性。基于注意标志,一个或多个处理器可以利用眼睛注视、其他关键字、随后的指向或上述各项中的任一项来进一步细化或更紧密地标识图像传感器数据内具有增加的相关性的一个或多个对象。

[0093]

如果手部姿势识别器908是指向性姿势,则手部姿势识别器908可以向手部方向分类器912输出与指向性姿势相对应的标识符。手部方向分类器912可以被实现为ann(例如,包括但不限于cnn)。手部方向分类器可以被配置成用于确定手部指向的方向。

[0094]

非常类似于眼睛注视分类,手部方向分类可以在经注释的数据上进行训练。作为一般原则,可以假设如果教员正在指向,则教员正指向朝向作为教员的关键字的受试者的对象。因此,当检测到关键字以及当一个或多个关键字被用来标识本文所述的具有增加的相关性的对象时,标识具有增加的相关性的对象的经注释的数据(例如其位置、其类型或身份或其他)可被发送到手部方向分类器912。使用该经注释的数据,手部方向分类器912可以将交通工具附近区域中的对象的位置与所检测的手部方向进行比较。通过将手部方向映射到外部图像传感器数据,手部检测器可以确定手部方向分类的准确性。也就是说,假设由关键字描述的对象是教员的指向的受试者,手部方向应该与所检测的对象的位置相对应。手部方向与对象的位置之间的任何差异都可以在训练阶段中用于改善手部检测器的结果。

[0095]

根据本公开的另一方面,一个或多个处理器可以基于指向姿势来增加或减少所检测的对象是教员的注意力的受试者的置信度。人类经常指向其注意力的受试者。一个或多个处理器可被配置成用于根据图像传感器数据(例如,交通工具附近区域内的一个或多个

相机、指向交通工具乘员的一个或多个相机)确定指向性姿势。一个或多个处理器可以将该指向性姿势与方向相关联,就像将注视与方向相关联一样。指向性姿势的方向随后可以相对于外部传感器数据(例如相机、光检测与测距、无线电检测与测距)进行评定,该外部传感器数据被配置成用于检测与交通工具外部或附近区域有关的信息,并且指向性姿势的方向随后可以与外部图像传感器数据内的一个或多个对象相关联。如果外部传感器数据中的对象已经(例如,诸如根据口头关键字)被标识,则指向性姿势可用于增加或减少所检测的对象的置信度。也就是说,在根据口头关键字标识的对象与指向性姿势的方向上的对象相对应的情况下,教员的注意力被引导至该对象的置信度可能增加。相反,在根据口头关键字标识的对象与出现在指向性姿势的方向上的对象不同的对象相对应的情况下,教员的注意力被引导至该对象的置信度可能降低。

[0096]

根据本公开的一方面,一个或多个处理器可被配置成用于在相对于提醒关键字的预定持续时间内将增加的风险级别归因于所有外部传感器数据。如上所述,预定持续时间可以在说出关键字之前不久、说出关键字期间或说出关键字之后不久开始。预定的持续时间可以是可配置的。以此方式,可以基于任何所期望的因素来针对实现方式配置传感器数据相对于关键字的增加的重要性的持续时间。这些因素可包括但不限于,教员的个人属性、特定类型的关键字、特定类型的危险、区域或文化差异等。

[0097]

在对于传感器数据具有增加的相关性的预定持续时间期间,一个或多个处理器可被配置成用于利用来自语音、注视、姿势或上述各项中的任一项的附加情境来进一步指定危险的区域。现在将更详细地描述这一点。

[0098]

图10描绘了根据本公开的一方面的数据合成器和标注器。在该图中,来自交通工具内部的麦克风数据被描绘为1002,并且与交通工具的附近区域相对应的图像传感器数据被描绘为1004。在1003处,与时间戳10:42:22:06(样本时间戳是出于说明性目的而严格提供的,并不意味着是限制性的)相对应,一个或多个处理器检测声音数据关键字。在该情形中,声音数据关键字包括“小心!小孩!在道路上!”。在标识了声音关键字的情况下,一个或多个处理器可以利用图像传感器数据1004的时间戳来标识图像传感器数据的对应部分。一个或多个处理器可以被配置成用于对图像传感器数据的、与1003处的时间戳相对应的特定部分进行定位。替代地或附加地,一个或多个处理器可以被配置成用于对图像传感器数据的、与1003处的时间戳稍前和/或稍后的时间相对应的部分进行定位。例如,并认识到描述危险的人类语音通常会在第一次领会到危险稍后发生,一个或多个处理器可被配置成用于考虑与10:42:21:06至10:42:24:06(例如,在关键字前一秒和关键字后两秒)相对应的图像传感器数据。当然,一个或多个处理器审查的关键字之前或之后的持续时间是偏好和实现方式的问题,并且不应被理解为是限制性的。

[0099]

在标识了图像传感器数据1005的对应部分的情况下,一个或多个处理器可以审查图像传感器数据以标识与麦克风数据关键字1003相对应的一个或多个对象。继续上面的示例,一个或多个处理器可以标识1005中与道路上的儿童相对应的图像传感器数据。如果与麦克风数据关键字中的一个或多个麦克风数据关键字相对应的对象位于图像传感器数据的对应部分内,则一个或多个处理器可以生成与所检测的对象相对应的标签。标签生成的具体细节可能取决于给定的实现方式。根据本公开的一方面,标签可以包括:图像数据标识符,其表示与所检测的关键字相对应的图像数据的部分;对象标识符,其表示与所检测的关

键字相对应的对象的身份;对象标签,其表示所标识的对象的名称或类型;优先级标签,其表示所检测的对象的相关性,或上述各项中的任一项。该标签可以是外部图像传感器数据(例如,所标注的数据)的一部分,或者可以独立于外部图像传感器数据(例如,与外部图像传感器数据分开存储)。

[0100]

在一些实现方式中,可能期望交通工具内的一个或多个处理器来执行本文所述的关键字和图像传感器匹配过程。在此类配置中,每个交通工具可以包括一个或多个处理器,该一个或多个处理器可以被配置成用于标识关键字和麦克风数据,并将所标识的关键字与本文所述的图像传感器数据内的对象关联。这可以实时地或以任何给定的等待时间来执行。

[0101]

根据本公开的另一方面,可能期望一个或多个中央数据库来执行本文所述的关键字和图像传感器匹配过程。图11描绘了根据本公开的一方面的数据存储设备,其中数据存储设备被配置成用于接收麦克风数据和外部图像传感器数据以用于标签生成。在该实现方式中,一个或多个交通工具可配备有一个或多个数据存储模块,该一个或多个数据存储模块可被配置成用于接收和存储至少麦克风数据和图像传感器数据。此类麦克风数据和图像传感器数据可被加盖时间戳,以允许数据流的时间比较。数据存储模块的实际类型在很大程度上无关紧要,但可以包括但不限于一个或多个硬驱动器、一个或多个固态驱动器、一个或多个光驱,或其他数据存储模块。储存在数据存储模块内的数据可以不时地被传输到一个或多个中央数据库。此种传输可以使用任何数据传输方法来执行,但不作为限制。该传输可以作为有线传输或无线传输来执行。替代地或附加地,数据存储模块的一个或多个元件可以从交通工具物理地移除,并直接与一个或多个服务器连接以用于上传。该配置可以在任何给定的实现方式中使用。此类实现方式的一个示例可以在驾驶学校的情境中,其中学校利用多个交通工具进行驾驶指导。多个交通工具可以各自记录和存储其相应的麦克风数据和外部图像传感器数据,并且这些数据随后可以偶尔地或周期性地上传到中央数据库进行处理。

[0102]

图12描绘了根据本公开的一方面的交通工具数据关联设备1200。该交通工具数据关联设备可以包括:内部音频/图像数据分析器1202,被配置成用于在表示来自交通工具内的音频或来自交通工具内的图像中的至少一者的第一数据内标识表示音频指示符或图像指示符的第二数据,其中音频指示符是人类语音,并且其中图像指示符表示交通工具内的人类动作;外部图像分析器1204,被配置成用于在表示交通工具外部附近区域的图像的第三数据内标识与音频指示符或视频指示符中的至少一者相对应的对象;以及对象数据生成器1206,被配置成用于生成对象数据以对第三数据进行分类。

[0103]

图13描绘了一种交通工具数据关联的方法,包括:在表示来自交通工具内的音频或来自交通工具内的图像中的至少一者的第一数据内标识表示音频指示符或图像指示符的第二数据,其中音频指示符是人类语音,并且其中图像指示符表示交通工具内的人类动作;在表示交通工具外部附近区域的图像的第三数据内标识与音频指示符或视频指示符中至少一者相对应的对象;以及生成对象数据以对第三数据进行分类。

[0104]

根据本公开的一方面,可以任选地采用一种或多种技术来交叉验证危险的概念。例如,可以利用一个或多个责任敏感安全性算法或其他风险评估过程,诸如例如,以确定数据与估计模型之间的差异的度量。

[0105]

根据本公开的一方面,可将置信度水平与由于注视方向而标识的对象相关联。也就是说,注视的检测和外部传感器数据中的对象与所检测的注视的关系可能依赖于多个变量,每个变量均具有一定的误差裕度。因此,可以向被认为与所检测的注视相关的对象分配置信度水平,其中置信度水平指示所标注的对象与注视(例如,表示正被教员关注的对象)相对应的可能性或置信度。可以利用各种附加的关系(例如,关键字和/或姿势)来增加置信度。

[0106]

根据本公开的一方面,可以利用方向关键字来增加对注视方向和/或被认为与注视方向相对应的对象的置信度。教员可能并不总是包括方向关键字;然而,如果教员利用方向关键字,一个或多个处理器可以利用方向关键字来标识外部传感器数据内被认为与教员的注意力相对应的对象。在一个或多个处理器已经将对象与教员的注视关联的情况下,对与相同对象相对应的方向关键字的添加可以增加与对象标识相关联的置信度水平。反之,如果对象关键字建议除了先前被标识为可能与教员的注视相关的对象之外的对象,那么与先前标识的对象相关联的置信度水平可能会降低。

[0107]

使用本文描述的原理和方法,一个或多个处理器可以使用多个细节水平中的任何水平来标注危险状况。也就是说,一个或多个处理器可以确定危险的一般概念(例如,诸如一般标识危险类型或对象类型),或者可以确定与危险相关联的具体对象,或者甚至与具体对象相关联的危险类型。

[0108]

根据本公开的一方面,一个或多个处理器可以被配置成用于在关键字和/或姿势之后的预定持续时间之后结束标注会话。如上所述,并且所标识的危险在时间上紧密接近于说出的关键字或姿势时是最相关的,并且因此标识对应的对象或标注对应的危险的相关性随着与关键字和/或姿势中在时间上远离越久而降低。解决该问题的一个方法是定义距关键字或姿势的预定持续时间,在到达该预定持续时间时标注过程结束。说明性地,标注过程可以在关键字或姿势之后的0.5秒、1秒、2秒、5秒或10秒结束。根据本发明的一方面,该预定的持续时间(诸如对于特定的指令、特定的情境、特定的文化或国家,或者其他)可以是可配置的。替代地或附加地,被标识的对象或危险的相关性可以与自关键字或姿势以来的时间持续期成反比。以此方式,一个或多个处理器可被配置成用于(例如,诸如在与该对象相关联的标签中)将相关性分配给对象或危险,并且该相关性当在时间上更紧密接近于关键字或姿势时可能更大,并且该相关性在在时间上更远离于关键字或姿势时可能降低。

[0109]

根据本公开的一方面,本公开的主题可以允许对人类交互的观察,诸如在驾驶指导期间,而不仅仅是观察人类驾驶,如在常规的自主交通工具训练中所执行的那样。这允许底层系统获得与原本在常规的训练中可能会错过的危险情况(诸如,当仅观察到其他交通参与者时)有关的附加信息。如本文所公开,交通工具不是根据复制人类驾驶行为学习,而是学习如何关注潜在的危险情况,该危险情况不一定导致人类驾驶员的直接反应,而是可以利用这些情况来关注图像传感器数据中最相关的部分。此类训练数据的标注可以半自动地执行。也就是说,即使人类动作被用于标注,训练数据可以在不需要来自人类参与者的附加工作量的情况下被标注。

[0110]

根据本公开的一方面,所标注的数据可以包括对特定情景的正确响应。也就是说,使用本文所述的指令,一个或多个处理器可以在图像传感器数据内定位相关的或危险的情况。除了仅仅标识该相关的或危险的情况之外,一个或多个处理器可以以驾驶员的反应的

形式记录或获得对该情景的期望响应。

[0111]

将以示例的方式描述本公开的附加方面:

[0112]

在示例1中,一种交通工具数据关联设备,包括:内部音频/图像数据分析器,被配置成用于在表示来自交通工具内的音频或来自交通工具内的图像中的至少一者的第一数据内标识表示音频指示符或图像指示符的第二数据,其中音频指示符是人类语音,并且其中图像指示符表示交通工具内的人类的动作;外部图像分析器,被配置成用于:接收表示交通工具外部附近区域的图像的第三数据;在表示交通工具外部附近区域的图像的第三数据内标识与音频指示符或视频指示符中的至少一者相对应的对象;以及对象数据发生器,被配置成用于生成对象数据以对第三数据进行分类。

[0113]

在示例2中,示例1的交通工具数据关联设备,其中,对象的身份包括定义对象的边界的一个或多个坐标。

[0114]

在示例3中,示例1或2的交通工具数据关联设备,其中标识第二数据包括:内部音频/图像数据分析器标识音频内的一个或多个关键字。

[0115]

在示例4中,示例3的交通工具数据关联设备,其中,一个或多个关键字包括以下各项中的至少一项:提醒关键字、方向关键字、定性位置关键字、对象描述关键字、动作关键字或其任何组合。

[0116]

在示例5中,示例3或4的交通工具数据关联设备,其中内部音频/图像数据分析器被配置成用于将表示一个或多个关键字的数据发送到外部图像分析器,并且外部图像分析器被配置成用于基于对象与一个或多个关键字之间的关系来标识对象。

[0117]

在示例6中,示例3至5中任一项的交通工具数据关联设备,其中外部图像分析器被配置成用于使用至少两个关键字迭代地标识对象。

[0118]

在示例7中,示例1至6中任一项的交通工具数据关联设备,其中标识第二数据包括:内部音频/图像数据分析器标识视频内的人类姿势。

[0119]

在示例8中,示例7的交通工具数据关联设备,其中人类姿势是以下各项中的至少一项:指向某个方向、做出注意姿势、做出否定性姿势、做出停车姿势或其任何组合。

[0120]

在示例9中,示例7或8的交通工具数据关联设备,其中内部音频/图像数据分析器被配置成用于将表示姿势的数据发送到外部图像分析器,并且外部图像分析器被配置成用于基于对象与姿势之间的关系来标识对象。

[0121]

在示例10中,示例7至9中任一项的交通工具数据关联设备,其中内部音频/图像数据分析器被配置成用于将表示姿势的数据发送到外部图像分析器,并且外部图像分析器被配置成用于将指向性动作映射到第三数据并用于基于指向性动作与对象之间的映射关系来标识对象。

[0122]

在示例11中,示例1至10中任一项的交通工具数据关联设备,其中标识第二数据包括:内部音频/图像数据分析器标识视频内的人类注视方向。

[0123]

在示例12中,示例11的交通工具数据关联设备,其中内部音频/图像数据分析器被配置成用于通过使用viola-jones算法来标识人类注视方向。

[0124]

在示例13中,示例11的交通工具数据关联设备,其中内部音频/图像数据分析器被配置成用于通过使用viola-jones算法或类似的算法来标识人类注视方向。

[0125]

在示例14中,示例11至13中任一项的交通工具数据关联设备,其中内部音频/图像

数据分析器被配置成用于通过使用来自通过对眼睛和表情分析的相互使用进行认知过程推断(eye-chimera)的eye(眼睛)部分来标识人类注视方向。

[0126]

在示例15中,示例12至14中任一项的交通工具数据关联设备,其中内部音频/图像数据分析器被配置成用于通过使用来自通过对眼睛和表情分析的相互使用进行认知过程推断(eye-chimera)的eye(眼睛)部分或类似的算法来标识人类注视方向。

[0127]

在示例16中,示例13至15中任一项的交通工具数据关联设备,其中内部音频/图像数据分析器被配置成用于将表示注视方向的数据发送到外部图像分析器,并且外部图像分析器被配置成用于基于对象与注视方向之间的关系来标识对象。

[0128]

在示例16中,示例13至16中任一项的交通工具数据关联设备,其中内部音频/图像数据分析器被配置成用于将表示注视方向的数据发送到外部图像分析器,并且外部图像分析器被配置成用于将注视方向映射到第三数据并用于基于注视方向与对象之间的映射关系来标识对象。

[0129]

在示例18中,示例1至17中任一项的交通工具数据关联设备,其中,来自交通工具内的图像包括交通工具的驾驶员或乘客的图像。

[0130]

在示例19中,示例1至18中任一项的交通工具数据关联设备,其中外部图像分析器被配置成用于基于以下各项中的至少两项来标识对象:一个或多个关键字、一个或多个姿势、或注视方向。

[0131]

在示例20中,示例1至19中任一项的交通工具数据关联设备,其中,第一数据包括图像传感器数据和/或麦克风数据。

[0132]

在示例21中,示例1至20中任一项的交通工具数据关联设备,其中第三数据包括图像传感器数据、光检测和测距(lidar)传感器数据、无线电检测和测距(radar)传感器数据或其任何组合。

[0133]

在示例22中,示例1至21中任一项的交通工具数据关联设备,进一步包括交通工具传感器数据分析器,被配置成用于从交通工具传感器接收交通工具传感器数据,并且其中外部图像分析器进一步被配置成用于基于交通工具传感器数据来生成对象数据。

[0134]

在示例23中,示例22的交通工具数据关联设备,其中,交通工具传感器包括转向传感器、加速度计、制动传感器、速度计或其任何组合。

[0135]

在示例24中,示例1至23中任一项的交通工具数据关联设备,进一步包括交通工具致动器数据分析器,被配置成用于接收致动器数据,并且其中外部图像分析器进一步被配置成用于基于交通工具致动器数据来生成对象数据。

[0136]

在示例25中,示例24的交通工具数据关联设备,其中,交通工具致动器数据包括表示方向盘位置、制动位置、制动压下、制动力、速率、速度、加速度或其任何组合的数据。

[0137]

在示例26中,示例22至25中任一项的交通工具数据关联设备,其中,传感器数据分析器和/或交通工具致动器数据分析器被配置成用于根据传感器数据和/或交通工具致动器数据来确定交通工具相对于由对象数据表示的对象的动作。

[0138]

在示例27中,示例1至26中任一项的交通工具数据关联设备,进一步包括人工神经网络,其中内部音频/图像数据分析器、外部图像分析器或对象数据生成器被实现为人工神经网络。

[0139]

在示例28中,示例1至27中任一项的交通工具数据关联设备,进一步包括存储器,

被配置成用于存储第一数据、第二数据、第三数据、对象数据或其任何组合。

[0140]

在示例29中,示例1至28中任一项的交通工具数据关联设备,其中以下各项中的至少两项各自包括时间戳:第一数据、第二数据、第三数据、对象数据或其任何组合,并且其中多个数据源经由时间戳被同步。

[0141]

在示例30中,示例1至29中任一项的交通工具数据关联设备,其中,对象数据生成器被配置成用于在音频指示符或图像指示符之后的预定时间内将对象与第二数据关联,并且其中,对象数据生成器被配置成用于在音频指示符或图像指示符之后的预定时间到期后不将对象与第二数据关联。

[0142]

在示例31中,示例1至30中任一项的交通工具数据关联设备,其中,对象数据生成器被配置成用于基于音频指示符或图像指示符来确定对象的优先级。

[0143]

在示例32中,示例31的交通工具数据关联设备,其中,优先级基于避免与对象碰撞的重要性、与对象碰撞的风险、与对象碰撞相关联的估计损害或其任何组合。

[0144]

在示例33中,示例1至32中任一项的交通工具数据关联设备,其中,对象数据包括一个或多个所检测的对象的标签。

[0145]

在示例34中,示例1至33中任一项的交通工具数据关联设备,其中,对象数据生成器进一步被配置成用于生成传感器数据标签,其中,传感器数据标签是表示以下各项中的至少一项的标签:对象的身份、对象的动作或对象的优先级。

[0146]

在示例35中,示例34的交通工具数据关联设备,其中,对象数据生成器进一步被配置成用于输出包括传感器数据标签的传感器数据。

[0147]

在示例36中,示例35或34的交通工具数据关联设备,其中,所输出的传感器数据包括第三数据和传感器数据标签。

[0148]

在示例37中,一种非暂态计算机可读介质,包括指令,该指令如果被执行,则使得一个或多个处理器用于:在表示来自交通工具内的音频或来自交通工具内的图像中的至少一者的第一数据内标识表示音频指示符或图像指示符的第二数据,其中音频指示符是人类语音,并且其中图像指示符表示交通工具内的人类动作;在表示交通工具外部附近区域的图像的第三数据内标识与音频指示符或视频指示符中至少一者相对应的对象;以及对象数据生成器,被配置成用于生成对象数据以对第三数据进行分类。

[0149]

在示例38中,示例37的非暂态计算机可读介质,其中,对象的身份包括定义对象的边界的一个或多个坐标。

[0150]

在示例39中,示例37或38的非暂态计算机可读介质,其中标识第二数据包括标识音频内的一个或多个关键字。

[0151]

在示例40中,示例39的非暂态计算机可读介质,其中,一个或多个关键字包括以下各项中的至少一项:提醒关键字、方向关键字、定性位置关键字、对象描述关键字、动作关键字或其任何组合。

[0152]

在示例41中,示例39或40的非暂态计算机可读介质,其中指令进一步被配置成用于使得一个或多个处理器用于将表示一个或多个关键字的数据发送到外部图像分析器,并且外部图像分析器被配置成用于基于对象与一个或多个关键字之间的关系来标识对象。

[0153]

在示例42中,示例39至41中任一项的非暂态计算机可读介质,其中外部图像分析器被配置成用于使用至少两个关键字迭代地标识对象。

[0154]

在示例43中,示例37至42中任一项的非暂态计算机可读介质,其中,标识第二数据包括标识视频内的人类姿势。

[0155]

在示例44中,示例43的非暂态计算机可读介质,其中人类姿势是以下各项中的至少一项:指向某个方向、做出注意姿势、做出否定性姿势、做出停车姿势或其任何组合。

[0156]

在示例45中,示例37至44中任一项的非暂态计算机可读介质,其中,标识第二数据包括标识视频内的人类注视方向。

[0157]

在示例46中,示例45的非暂态计算机可读介质,其中指令被进一步被配置成用于使得一个或多个处理器用于通过使用viola-jones算法来标识人类注视方向。

[0158]

在示例47中,示例45至46中任一项的非暂态计算机可读介质,其中指令被进一步被配置成用于使得一个或多个处理器用于通过使用来自通过对眼睛和表情分析的相互使用进行认知过程推断(eye-chimera)的eye(眼睛)部分来标识人类注视方向。

[0159]

在示例48中,示例45至47中任一项的非暂态计算机可读介质,其中指令被进一步被配置成用于使得一个或多个处理器用于通过使用来自通过对眼睛和表情分析的相互使用进行认知过程推断(eye-chimera)的eye(眼睛)部分或类似的算法来标识人类注视方向。

[0160]

在示例49中,示例37至48中任一项的非暂态计算机可读介质,其中,来自交通工具内的图像包括交通工具的驾驶员或乘客的图像。

[0161]

在示例50中,示例37至49中任一项的非暂态计算机可读介质,其中,指令进一步被配置成用于使得一个或多个处理器用于基于以下各项中的至少两项来标识对象:一个或多个关键字、一个或多个姿势、或注视方向。

[0162]

在示例51中,示例37至50中任一项的非暂态计算机可读介质,其中,第一数据包括图像传感器数据和/或麦克风数据。

[0163]

在示例52中,示例37至51中任一项的非暂态计算机可读介质,其中第三数据包括图像传感器数据、光检测和测距(lidar)传感器数据、无线电检测和测距(radar)传感器数据或其任何组合。

[0164]

在示例53中,示例37至52中任一项的非暂态计算机可读介质,其中指令进一步被配置成用于使得一个或多个处理器用于从交通工具传感器接收交通工具传感器数据并基于交通工具传感器数据来生成对象数据。

[0165]

在示例54中,示例53的非暂态计算机可读介质,其中,交通工具传感器包括转向传感器、加速度计、制动传感器、速度计或其任何组合。

[0166]

在示例55中,示例37至54中任一项的非暂态计算机可读介质,其中指令进一步被配置成用于使得一个或多个处理器用于接收致动器数据,并且其中外部图像分析器进一步被配置成用于基于交通工具致动器数据来生成对象数据。

[0167]

在示例56中,示例55的非暂态计算机可读介质,其中,交通工具致动器数据包括表示方向盘位置、制动位置、制动压下、制动力、速率、速度、加速度或其任何组合的数据。

[0168]

在示例57中,示例53至56中任一项的非暂态计算机可读介质,其中指令进一步被配置成用于使得一个或多个处理器用于根据传感器数据和/或交通工具致动器数据确定交通工具相对于由对象数据表示的对象的动作。

[0169]

在示例58中,示例37至57中任一项的非暂态计算机可读介质,其中指令在人工神经网络内被实现。

[0170]

在示例59中,示例37至58中任一项的非暂态计算机可读介质,其中以下各项中的至少两项各自包括时间戳:第一数据、第二数据、第三数据、对象数据或其任何组合,并且其中多个数据源经由时间戳被同步。

[0171]

在示例60中,示例37至59中任一项的非暂态计算机可读介质,其中指令进一步被配置成用于使得一个或多个处理器用于在音频指示符或图像指示符之后的预定时间内将对象与第二数据关联,并且其中,对象在音频指示符或图像指示符之后的预定时间到期后不与第二数据关联。

[0172]

在示例61中,公开了示例37至60中任一项的非暂态计算机可读介质,其中指令进一步被配置成用于使一个或多个处理器用于基于音频指示符或图像指示符来确定对象的优先级。

[0173]

在示例62中,示例61的非暂态计算机可读介质,其中,优先级基于避免与对象碰撞的重要性、与对象碰撞的风险、与对象碰撞相关联的估计损害或其任何组合。

[0174]

在示例63中,示例37至62中任一项的非暂态计算机可读介质,其中,对象数据包括一个或多个所检测的对象的标签。

[0175]

在示例64中,示例37至63中任一项的非暂态计算机可读介质,其中,指令进一步被配置成用于使一个或多个处理器用于生成传感器数据标签,其中,传感器数据标签是表示以下各项中的至少一项的标签:对象的身份、对象的动作或对象的优先级。

[0176]

在示例65中,示例64的非暂态计算机可读介质,其中指令进一步被配置成用于使得一个或多个处理器用于输出包括传感器数据标签的传感器数据。

[0177]

在示例66中,示例65或64的非暂态计算机可读介质,其中,所输出的传感器数据包括第三数据和传感器数据标签。

[0178]

在示例67中,一种用于交通工具数据关联的装置,包括:内部音频/图像数据分析器,被配置成用于在表示来自交通工具内的音频或来自交通工具内的图像中的至少一者的第一数据内标识表示音频指示符或图像指示符的第二数据,其中音频指示符是人类语音,并且其中图像指示符表示交通工具内的人类的动作;外部图像分析器,被配置成用于:在表示交通工具外部附近区域的图像的第三数据内标识与音频指示符或视频指示符中的至少一者相对应的对象;以及对象数据发生器,被配置成用于生成对象数据以对第三数据进行分类。

[0179]

在示例68中,示例67的用于交通工具数据关联的装置,其中,对象的身份包括定义对象的边界的一个或多个坐标。

[0180]

在示例69中,示例67或68的用于交通工具数据关联的装置,其中标识第二数据包括:内部音频/图像数据分析器标识音频内的一个或多个关键字。

[0181]

在示例70中,示例69的用于交通工具数据关联的装置,其中,一个或多个关键字包括以下各项中的至少一项:提醒关键字、方向关键字、定性位置关键字、对象描述关键字、动作关键字或其任何组合。

[0182]

在示例71中,示例69或70的用于交通工具数据关联的装置,其中内部音频/图像数据分析器被配置成用于将表示一个或多个关键字的数据发送到外部图像分析器,并且外部图像分析器被配置成用于基于对象与一个或多个关键字之间的关系来标识对象。

[0183]

在示例72中,示例69至71中任一项的用于交通工具数据关联的装置,其中外部图

像分析器被配置成用于使用至少两个关键字迭代地标识对象。

[0184]

在示例73中,示例67或72中任一项的用于交通工具数据关联的装置,其中标识第二数据包括:内部音频/图像数据分析器标识视频内的人类姿势。

[0185]

在示例74中,示例73的用于交通工具数据关联的装置,其中人类姿势是以下各项中的至少一项:指向某个方向、做出注意姿势、做出否定性姿势、做出停车姿势或其任何组合。

[0186]

在示例75中,示例73或74的用于交通工具数据关联的装置,其中内部音频/图像数据分析器被配置成用于将表示姿势的数据发送到外部图像分析器,并且外部图像分析器被配置成用于基于对象与姿势之间的关系来标识对象。

[0187]

在示例76中,示例73至75中任一项的用于交通工具数据关联的装置,其中内部音频/图像数据分析器被配置成用于将表示姿势的数据发送到外部图像分析器,并且外部图像分析器被配置成用于将指向性动作映射到第三数据并用于基于指向性动作与对象之间的映射关系来标识对象。

[0188]

在示例77中,示例67或76中任一项的用于交通工具数据关联的装置,其中标识第二数据包括:内部音频/图像数据分析器标识视频内的人类注视方向。

[0189]

在示例78中,示例77的用于交通工具数据关联的装置,其中内部音频/图像数据分析器被配置成用于通过使用viola-jones算法来标识人类注视方向。

[0190]

在示例79中,示例77的用于交通工具数据关联的装置,其中内部音频/图像数据分析器被配置成用于通过使用viola-jones算法或类似的算法来标识人类注视方向。

[0191]

在示例80中,示例77至79中任一项的用于交通工具数据关联的装置,其中内部音频/图像数据分析器被配置成用于通过使用来自通过对眼睛和表情分析的相互使用进行认知过程推断(eye-chimera)的eye(眼睛)部分来标识人类注视方向。

[0192]

在示例81中,示例78至80中任一项的用于交通工具数据关联的装置,其中内部音频/图像数据分析器被配置成用于通过使用来自通过对眼睛和表情分析的相互使用进行认知过程推断(eye-chimera)的eye(眼睛)部分或类似的算法来标识人类注视方向。

[0193]

在示例82中,示例79至81中任一项的用于交通工具数据关联的装置,其中内部音频/图像数据分析器被配置成用于将表示注视方向的数据发送到外部图像分析器,并且外部图像分析器被配置成用于基于对象与注视方向之间的关系来标识对象。

[0194]

在示例83中,示例79至82中任一项的用于交通工具数据关联的装置,其中内部音频/图像数据分析器被配置成用于将表示注视方向的数据发送到外部图像分析器,并且外部图像分析器被配置成用于将注视方向映射到第三数据并用于基于注视方向与对象之间的映射关系来标识对象。

[0195]

在示例84中,示例67至83中任一项的数据分析设备,其中,来自交通工具内的图像包括交通工具的驾驶员或乘客的图像。

[0196]

在示例85中,示例67至84中任一项的用于交通工具数据关联的装置,其中外部图像分析器被配置成用于基于以下各项中的至少两项来标识对象:一个或多个关键字、一个或多个姿势、或注视方向。

[0197]

在示例86中,示例67至85中任一项的用于交通工具数据关联的装置,其中,第一数据包括图像传感器数据和/或麦克风数据。

[0198]

在示例87中,示例67至86中任一项的用于交通工具数据关联的装置,其中第三数据包括图像传感器数据、光检测和测距(lidar)传感器数据、无线电检测和测距(radar)传感器数据或其任何组合。

[0199]

在示例88中,示例67至87中任一项的用于交通工具数据关联的装置,进一步包括交通工具传感器数据分析器,被配置成用于从交通工具传感器接收交通工具传感器数据,并且其中外部图像分析器进一步被配置成用于基于交通工具传感器数据来生成对象数据。

[0200]

在示例89中,示例88的用于交通工具数据关联的装置,其中,交通工具传感器包括转向传感器、加速度计、制动传感器、速度计或其任何组合。

[0201]

在示例90中,示例67至89中任一项的用于交通工具数据关联的装置,进一步包括交通工具致动器数据分析器,被配置成用于接收致动器数据,并且其中外部图像分析器进一步被配置成用于基于交通工具致动器数据来生成对象数据。

[0202]

在示例91中,示例90的用于交通工具数据关联的装置,其中,交通工具致动器数据包括表示方向盘位置、制动位置、制动压下、制动力、速率、速度、加速度或其任何组合的数据。

[0203]

在示例92中,示例88至91中任一项的用于交通工具数据关联的装置,其中,传感器数据分析器和/或交通工具致动器数据分析器被配置成用于根据传感器数据和/或交通工具致动器数据来确定交通工具相对于由对象数据表示的对象的动作。

[0204]

在示例93中,示例67至92中任一项的用于交通工具数据关联的装置,进一步包括人工神经网络,其中内部音频/图像数据分析器、外部图像分析器或对象数据生成器被实现为人工神经网络。

[0205]

在示例94中,示例67至93中任一项的用于交通工具数据关联的装置,进一步包括存储器,被配置成用于存储第一数据、第二数据、第三数据、对象数据或其任何组合。

[0206]

在示例95中,示例67至94中任一项的用于交通工具数据关联的装置,其中以下各项中的至少两项各自包括时间戳:第一数据、第二数据、第三数据、对象数据或其任何组合,并且其中多个数据源经由时间戳被同步。

[0207]

在示例96中,示例67至95中任一项的用于交通工具数据关联的装置,其中,对象数据生成器被配置成用于在音频指示符或图像指示符之后的预定时间内将对象与第二数据关联,并且其中,对象数据生成器被配置成用于在音频指示符或图像指示符之后的预定时间到期后不将对象与第二数据关联。

[0208]

在示例97中,示例67至96中任一项的用于交通工具数据关联的装置,其中,对象数据生成器被配置成用于基于音频指示符或图像指示符来确定对象的优先级。

[0209]

在示例98中,示例97的用于交通工具数据关联的装置,其中,优先级基于避免与对象碰撞的重要性、与对象碰撞的风险、与对象碰撞相关联的估计损害或其任何组合。

[0210]

在示例99中,示例67至98中任一项的用于交通工具数据关联的装置,其中,对象数据包括一个或多个所检测的对象的标签。

[0211]

在示例100中,示例67至99中任一项的用于交通工具数据关联的装置,其中,对象数据生成器进一步被配置成用于生成传感器数据标签,其中,传感器数据标签是表示以下各项中的至少一项的标签:对象的身份、对象的动作或对象的优先级。

[0212]

在示例101中,示例100的用于交通工具数据关联的装置,其中,对象数据生成器进

一步被配置成用于输出包括传感器数据标签的传感器数据。

[0213]

在示例102中,示例101或100的用于交通工具数据关联的装置,其中,所输出的传感器数据包括第三数据和传感器数据标签。

[0214]

在示例103中,一种交通工具数据关联的方法,包括:在表示来自交通工具内的音频或来自交通工具内的图像中的至少一者的第一数据内标识表示音频指示符或图像指示符的第二数据,其中音频指示符是人类语音,并且其中图像指示符表示交通工具内的人类动作;在表示交通工具外部附近区域的图像的第三数据内标识与音频指示符或视频指示符中至少一者相对应的对象;以及生成对象数据以对第三数据进行分类。

[0215]

在示例104中,示例103的交通工具数据关联的方法,其中,对象的身份包括定义对象的边界的一个或多个坐标。

[0216]

在示例105中,示例103或104的交通工具数据关联的方法,其中标识第二数据包括标识音频内的一个或多个关键字。

[0217]

在示例106中,示例105的交通工具数据关联的方法,其中,一个或多个关键字包括以下各项中的至少一项:提醒关键字、方向关键字、定性位置关键字、对象描述关键字、动作关键字或其任何组合。

[0218]

在示例107中,示例105或106的交通工具数据关联的方法,进一步包括:将表示一个或多个关键字的数据发送到外部图像分析器,并且该外部图像分析器被配置成用于基于该对象与一个或多个关键字之间的关系来标识该对象。

[0219]

在示例108中,示例105至107中任一项的交通工具数据关联的方法,其中外部图像分析器被配置成用于使用至少两个关键字迭代地标识对象。

[0220]

在示例109中,示例103至108中任一项的交通工具数据关联的方法,其中,标识第二数据包括标识视频内的人类姿势。

[0221]

在示例110中,示例109的交通工具数据关联的方法,其中人类姿势是以下各项中的至少一项:指向某个方向、做出注意姿势、做出否定性姿势、做出停车姿势或其任何组合。

[0222]

在示例111中,示例109或110的交通工具数据关联的方法,进一步包括基于对象与姿势之间的关系来标识对象。

[0223]

在示例112中,示例109至111中任一项的交通工具数据关联的方法,进一步包括将指向性动作映射到第三数据,并且基于指向性动作与对象之间的映射关系来标识对象。

[0224]

在示例113中,示例103至112中任一项的交通工具数据关联的方法,其中标识第二数据包括:内部音频/图像数据分析器标识视频内的人类注视方向。

[0225]

在示例114中,示例113的交通工具数据关联的方法,进一步包括通过使用viola-jones算法来标识人类注视方向。

[0226]

在示例115中,示例112至114中任一项的交通工具数据关联的方法,其中进一步包括:通过使用来自通过对眼睛和表情分析的相互使用进行认知过程推断(eye-chimera)的eye(眼睛)部分来标识人类注视方向。

[0227]

在示例116中,示例113至115中任一项的交通工具数据关联的方法,其中进一步包括:通过使用来自通过对眼睛和表情分析的相互使用进行认知过程推断(eye-chimera)的eye(眼睛)部分或类似算法来标识人类注视方向。

[0228]

在示例117中,示例114至116中任一项的交通工具数据关联的方法,进一步包括基

于对象与注视方向之间的关系来标识对象。

[0229]

在示例118中,示例114至117中任一项的交通工具数据关联的方法,进一步包括将注视方向映射到第三数据,以及基于注视方向与对象之间的映射关系来标识对象。

[0230]

在示例119中,示例103至118中任一项的交通工具数据关联的方法,其中,来自交通工具内的图像包括交通工具的驾驶员或乘客的图像。

[0231]

在示例120中,示例103至119中任一项的交通工具数据关联的方法,进一步包括基于以下各项中的至少两项来标识对象:一个或多个关键字、一个或多个姿势、或注视方向。

[0232]

在示例121中,示例103至120中任一项的交通工具数据关联的方法,其中,第一数据包括图像传感器数据和/或麦克风数据。

[0233]

在示例122中,示例103至121中任一项的交通工具数据关联的方法,其中第三数据包括图像传感器数据、光检测和测距(lidar)传感器数据、无线电检测和测距(radar)传感器数据或其任何组合。

[0234]

在示例123中,示例103至122中任一项的交通工具数据关联的方法,进一步包括从交通工具传感器接收交通工具传感器数据并基于交通工具传感器数据来生成对象数据。

[0235]

在示例124中,示例123的交通工具数据关联的方法,其中,交通工具传感器包括转向传感器、加速度计、制动传感器、速度计或其任何组合。

[0236]

在示例125中,示例103至124中任一项的交通工具数据关联的方法,进一步包括接收致动器数据并基于交通工具致动器数据来生成对象数据。

[0237]

在示例126中,示例125的交通工具数据关联的方法,其中,交通工具致动器数据包括表示方向盘位置、制动位置、制动压下、制动力、速率、速度、加速度或其任何组合的数据。

[0238]

在示例127中,示例123至126中任一项的交通工具数据关联的方法,进一步包括根据传感器数据和/或交通工具致动器数据确定交通工具相对于由对象数据表示的对象的动作。

[0239]

在示例128中,示例103至127中任一项的交通工具数据关联的方法,进一步包括在人工神经网络中实现示例103至127中任一项或多项要素。

[0240]

在示例129中,示例103至128中任一项的交通工具数据关联的方法,进一步包括将第一数据、第二数据、第三数据、对象数据或其任何组合存储在存储器中。

[0241]

在示例130中,示例103至129中任一项的交通工具数据关联的方法,其中以下各项中的至少两项各自包括时间戳:第一数据、第二数据、第三数据、对象数据或其任何组合,并且其中多个数据源经由时间戳被同步。

[0242]

在示例131中,示例103至130中任一项的交通工具数据关联的方法,进一步包括在音频指示符或图像指示符之后的预定时间内将对象与第二数据关联,并且在音频指示符或图像指示符之后的预定时间到期后不将对象与第二数据关联。

[0243]

在示例132中,示例103至131中任一项的交通工具数据关联的方法,进一步包括基于音频指示符或图像指示符来确定对象的优先级。

[0244]

在示例133中,示例132的交通工具数据关联的方法,其中,优先级基于避免与对象碰撞的重要性、与对象碰撞的风险、与对象碰撞相关联的估计损害或其任何组合。

[0245]

在示例134中,示例103至133中任一项的交通工具数据关联的方法,其中,对象数据包括一个或多个所检测的对象的标签。

[0246]

在示例135中,示例103至134中任一项的交通工具数据关联的方法,进一步包括生成传感器数据标签,其中,传感器数据标签是表示以下各项中的至少一项的标签:对象的身份、对象的动作或对象的优先级。

[0247]

在示例136中,示例135的交通工具数据关联的方法,进一步包括输出包括传感器数据标签的传感器数据。

[0248]

在示例137中,示例136或135的交通工具数据关联的方法,其中,所输出的传感器数据包括第三数据和传感器数据标签。

[0249]

虽然已经参照具体方面具体地示出和描述了本公开,但本领域技术人员应当理解,可对本发明作出形式上和细节上的各种变化而不背离如所附权利要求所限定的本公开的精神和范围。因此,本公开的范围由所附权利要求表示并且因此旨在涵盖落在权利要求的等效含义和范围内的所有变化。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1