基于灰狼算法的智能体路径搜索方法、设备和存储介质

本技术实施例涉及智能体路径搜索,特别涉及一种基于灰狼算法的智能体路径搜索方法、设备和存储介质。

背景技术:

1、近年来,面对优化问题,技术人员通常选择使用优化算法来寻找问题的最优解。仿生算法的研究近年来也在飞速发展,与优化算法不同,仿生算法是基于直观数据和经验规则,为具有可接受成本(如计算时间成本、内存消耗成本)的问题提供可行的解决方案,不过其不能保证解决方案是最优的。如果将放生算法与优化算法相融合,则可以带来很大的收益。

2、通过对各种优化算法和仿生算法的研究和分析,技术人员发现灰狼算法具有良好的优化能力,灰狼算法作为一种仿生算法,已成功应用于许多工程优化问题中。

3、然而,灰狼算法受算法结构和仿生算法特性的限制,其最终只能生成接近最优的解,在迭代过程中很容易陷入局部最优状态,同时还存在开发能力差、更新策略不灵活的缺点,这导致其在智能体路径搜索技术中表现不佳,难以满足智能体路径搜索的需求。

技术实现思路

1、本技术实施例的目的在于提供一种基于灰狼算法的智能体路径搜索方法、设备和存储介质,提高了灰狼算法更新的灵活性、解的多样性和收敛速度,避免智能体路径搜索陷入局部最优,准确地为智能体路径搜索寻找全局最优解。

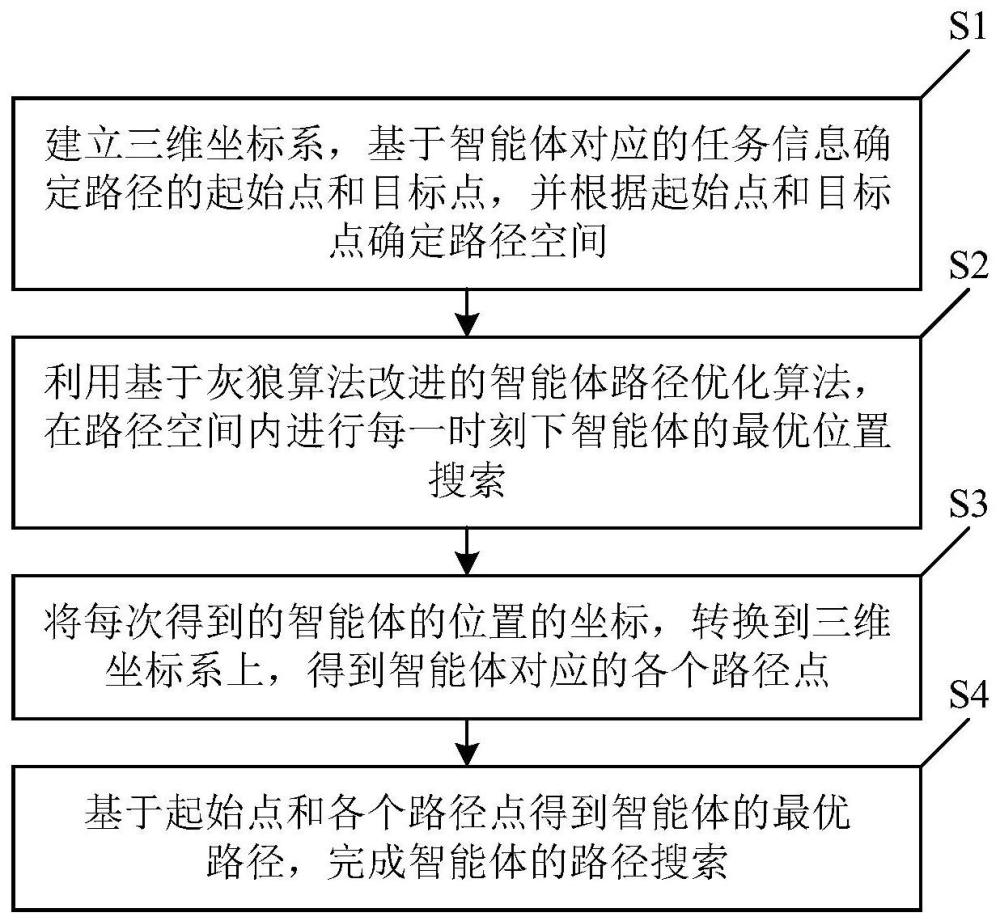

2、为解决上述的技术问题,本技术的实施例提供了一种基于灰狼算法的智能体路径搜索方法,包括以下步骤:

3、s1:建立三维坐标系,基于智能体对应的任务信息确定路径的起始点和目标点,并根据所述起始点和所述目标点确定路径空间;

4、s2:利用基于灰狼算法改进的智能体路径优化算法,在所述路径空间内进行每一时刻下所述智能体的最优位置搜索,具体为:

5、s21:根据灰狼算法的观察机制和捕猎机制,对初始参数选择困难的问题,使用线性微分递减策略,实时更新所述智能体的位置;

6、一只灰狼代表一个搜索因子,在初始的观察机制阶段,基于不少于四只灰狼的一组灰狼随机生成搜索空间,基于预设的适应度计算函数计算每一只灰狼的适应度值,依次将适应度值前三的灰狼作为α等级灰狼、β等级灰狼和δ等级灰狼,基于所述α等级灰狼、所述β等级灰狼和所述δ等级灰狼确定最佳候选解,其余的灰狼通过在后续迭代周期中根据所述最佳候选解来修改其位置,实现对所述智能体的包围,定义各灰狼位置的更新满足以下公式:

7、di()=|•x*()-xi()|

8、xi(+1)=x*()-a·di()

9、a=2·a·r-a

10、c=2·r

11、其中,x*()为所述智能体在第t个迭代周期时的位置向量,xi()为灰狼i在第t个迭代周期时的位置向量,di()为灰狼i在第t个迭代周期时与所述智能体之间的距离,xi(+1)为灰狼i在第t+1个迭代周期时的位置向量,a和c为预设的系数向量,r是在(0,1)中生成的一个随机数;

12、在所述捕猎机制中,根据所述α等级灰狼、所述β等级灰狼和所述δ等级灰狼的位置和适应度值,更新各灰狼的位置,其通过以下公式实现:

13、

14、

15、σ=ε·a

16、

17、

18、其中,xα()为所述α等级灰狼第t个迭代周期时的位置向量,xβ()为所述β等级灰狼第t个迭代周期时的位置向量,xδ()为所述δ等级灰狼第t个迭代周期时的位置向量,a1、a2、a3、c1、c2、c3为预设的系数向量,ε为预设的动态加权干扰因子,分别为所述α等级灰狼、所述β等级灰狼和所述δ等级灰狼的适应度值,a满足所述线性微分递减策略,所述线性微分递减策略具体如下:

19、

20、其中,tmax为预设的最大迭代次数;

21、s22:基于所述适应度计算函数重新计算每一只灰狼的适应度值,按照适应度值的大小更新所述α等级灰狼、所述β等级灰狼和所述δ等级灰狼,将更新后的所述α等级灰狼的位置,作为下一个迭代周期中所述智能体的位置,并转向s21,周而复始地,重复执行s2,直至所述智能体的位置更新到所述目标点,或迭代次数达到所述最大迭代次数;

22、s3:将每次得到的所述智能体的位置的坐标,转换到所述三维坐标系上,得到所述智能体对应的各个路径点;

23、s4:基于所述起始点和所述各个路径点得到所述智能体的最优路径,完成所述智能体的路径搜索。

24、本技术的实施例还提供了一种电子设备,包括:至少一个处理器;以及,与所述至少一个处理器通信连接的存储器;其中,所述存储器存储有可被所述至少一个处理器执行的指令,所述指令被所述至少一个处理器执行,以使所述至少一个处理器能够执行上述的基于灰狼算法的智能体路径搜索方法。

25、本技术的实施例还提供了一种计算机可读存储介质,存储有计算机程序,所述计算机程序被处理器执行时实现上述的基于灰狼算法的智能体路径搜索方法。

26、本技术的实施例提供的基于灰狼算法的智能体路径搜索方法、设备和存储介质,根据灰狼算法的捕食策略和层次结构,对初始参数选择困难的问题,使用线性微分递减策略,实时更新位置;在捕猎机制中引入动态加权干扰因子,提高了原始灰狼算法更新的灵活性,增加了解的多样性,同时提高了收敛速度。在应用于智能体的路径搜索技术时,能够有效避免智能体路径搜索陷入局部最优,准确地为智能体路径搜索寻找全局最优解。

27、在一些可选的实施例中,在所述根据所述起始点和所述目标点确定路径空间时,根据预设的人工势场法设置智能体之间的碰撞约束条件、静态障碍物和动态障碍物,所生成的路径需避免所述智能体与所述静态障碍物和所述动态障碍物发生碰撞。进一步提升智能体路径搜索的科学性和合理性。

28、在一些可选的实施例中,所述将更新后的所述α等级灰狼的位置,作为下一个迭代周期中所述智能体的位置,包括:

29、对每次迭代后的更新后的所述α等级灰狼的位置进行加权平均,将所述加权平均后得到的位置作为下一个迭代周期中所述智能体的位置;

30、所述加权平均通过以下公式进行:

31、yi(t+1)=μyi(t)+(1-μ)x’i(t+1)

32、其中,μ为预设的自适应权重值,所述μ的取值范围为(0,1),x’i(t+1)为第t次迭代后对应的更新后的所述α等级灰狼的位置向量,yi(t)为第t-1次迭代后对应的所述加权平均后得到的位置向量,yi(t+1)为第t次迭代后对应的所述加权平均后得到的位置向量,yi(0)=0。加权平均操作可以进一步提升解的多样性。

33、在一些可选的实施例中,所述将所述加权平均后得到的位置作为下一个迭代周期中所述智能体的位置,包括:

34、根据所述自适应权重值和当前迭代次数对所述加权平均后得到的位置进行修正,将所述修正后得到的位置作为下一个迭代周期中所述智能体的位置;

35、所述修正通过以下公式进行:

36、

37、其中,yi(t+1)为第t次迭代后对应的所述加权平均后得到的位置向量,μ为所述自适应权重值,zi(t+1)为第t次迭代后对应的所述修正后得到的位置向量。修正操作可以有效提升加权平均的精度。

38、在一些可选的实施例中,所述自适应权重值μ设置为0.648。

39、在一些可选的实施例中,所述动态加权干扰因子ε设置为0.8。

40、在一些可选的实施例中,所述最大迭代次数tmax设置为100。

- 还没有人留言评论。精彩留言会获得点赞!