一种路径自动采集系统及方法与流程

本发明涉及一种路径自动采集系统及方法,属于无人驾驶。

背景技术:

1、随着无人驾驶技术的不断发展,其应用场景也日趋丰富。高速公路养护作业场景相对简单,车辆的行驶路径固定、行驶速度低且外部干扰较少,因此无人驾驶技术在养护作业领域的应用和传统领域相比有着明显的优势。

2、路径的采集作为高速公路养护作业的前置工作,当前采用的方式为现场技术人员手持rtk设备,步行打点采集路径。该采集方式作业效率低下,每小时仅能采集2-3公里路线。针对非连续作业工地,采集的时间会更长,这种低效率的采集极大地限制了无人化作业的推广。

技术实现思路

1、本发明的目的在于提供一种路径自动采集系统及方法,该系统及方法能够提高路径采集的效率,有利于无人化作业的推广。

2、为了实现上述目的,本发明提供一种路径自动采集系统,包括定位固定基站、实时差分固定基站、高精度相机、惯导系统、轮速计、运输车辆、车载rtk和控制单元;

3、所述的定位固定基站为设定的固定的位置参考点,其用于校准和修正以其作为参照点的数据;

4、所述的实时差分固定基站利用gps信号提供位置信息并传递至控制单元,通过将其获取的数据与定位固定基站的数据对比消除常见的gps误差;

5、所述的高精度相机用于捕获车道线的图像信息,并将采集到的图像信息传递至控制单元,控制单元利用图像处理技术来检测和识别车道线;

6、所述的惯导系统用于测量运输车辆的加速度和角速度,并将加速度和角速度信息传递至控制单元,控制单元进行车辆的方向和位置变化的计算;

7、所述的轮速计用于测量车轮的转速,并将车轮的转速信息传递至控制单元,控制单元进行车辆的行驶距离和速度的计算;

8、所述的车载rtk用于实时记录运输车辆的行驶轨迹,并将行驶轨迹信息传送至控制单元;控制单元将行驶轨迹数据转化为车道线的坐标位置;

9、所述的运输车辆用于搭载实时差分固定基站、高精度相机、惯导系统、轮速计和车载rtk于所行驶的路面上进行数据的收集;

10、所述的控制单元用于接收定位固定基站、高精度相机、惯导系统、轮速计、车载rtk传送的位置信息、车道线的图像信息、车辆的加速度和角速度信息、车轮的转速信息和车辆的行驶轨迹信息,并对接收到的信息处理后进行gps误差的消除、检测和识别车道线、车辆的方向和位置变化的计算、车辆的行驶距离和速度的计算。

11、进一步地,所述的实时差分固定基站利用gps信号提供厘米级精度的位置信息。

12、进一步地,所述的高精度相机具备视频拍摄、图像抓取以及连续拍摄功能;其拍照取样的样本涵盖实线、虚线、斑马线在不同光照条件下的车道线类型以及城市道路和高速公路场景,构成原始图像数据库。

13、进一步地,所述的定位固定基站安装于路边无遮挡处,其覆盖半径为5至8公里。

14、一种路径自动采集方法,包括如下步骤:

15、step 1、自动采集系统启动后,利用定位固定基站和rtk对运输车辆进行初始定位;利用高精度相机捕获初始图像,并依据所述初始图像设置视觉识别的参考帧;惯导系统和轮速计开始记录车辆当前的速度、车轮转角及车辆实时位置、姿态信息,用于和rtk信息互相验证;

16、step 2、高精度相机连续捕获车道线图像;实时差分固定基站持续提供位置信息;惯导系统测量运输车辆的加速度和角速度;轮速计测量车轮的转速;所述车道线图像信息、位置信息、加速度和角速度信息和车轮的转速信息实时传送至控制单元,所述控制单元利用图像处理技术来检测和识别车道线,将运输车辆的加速度和角速度与车轮的转速数据结合,通过航位推算方法计算车辆的位置变化,将实时差分固定基站提供的位置信息与航位推算结果融合,用于校正累积误差;同时,控制单元将车道线及车辆位置实时记录用于异常状况报警及后续分析。

17、进一步地,所述步骤step 2中,检测和识别车道线基于深度学习的车道线检测模型进行,具体步骤如下:

18、step 2-1.1、利用ufld实现高帧速率的车道线检测,车道线定位损失函数和总检测损失的计算公式分别如下:

19、

20、ldetection=lcls+α*lsim+γ*lshp;

21、式中,m为车道线的数量,h为图像识别框的数量,lce为交叉损失函数,pi,j为模型输出单元的概率,ti,j为输出目标;α和γ为损失系数,其取值均为(0,1);lsim为相似损失,表示相邻图像识别框内车道线彼此接近情况;lshp为形状损失,取决于车道线的非标准状态;直线状态的车道线是标准状态,曲线状态的车道线是非标状态,弯曲越厉害,图像损失越严重;

22、step 2-1.2、通过构建图像无监督自适应uda算法,生成车道线检测识别模型,具体步骤如下:

23、a.使用高精度相机对不同形式的车道线进行拍照取样,构成原始图像数据库;

24、b.通过卷积神经网络从原始图像数据库中学习并提取有用特征,具体为卷积层提取图像的局部特征,各个卷积层均包含一组卷积核,所述卷积核用于在输入特征图上进行滑动并进行卷积计算,生成新的特征图,卷积计算公式如下:

25、

26、式中,表示第l层卷积后得到的特征图的第k个通道在位置(i,j)的值;

27、是第l层卷积核的第k个通道在位置(p,q)的权重;是第(l-1)层输出特征图的第k个通道在位置(i+p,j+q)的激活值;是第l层卷积核的第k个通道的偏置项;p和q是卷积核的高度和宽度;

28、c.将经过步骤b处理后的特征图通过池化层进行维度降低的同时保留重要信息,池化公式如下:

29、yij=max0<x<w,0<y<h{xi×s+x,j×s+y};

30、式中,yi,j表示池化后特征图在位置(i,j)的值;xi×s+x,j×s+y表示输入特征图在池化窗口内的值,其中,s是池化步长,w和h是池化窗口的宽度和高度;

31、d.将池化后的特征图进行正则化,公式如下:

32、

33、式中,j是正则化后的损失函数;j0是原始损失函数;λ是正则化系数;∑w∈ww2是模型中所有权重的集合;m是训练样本的数量;w是模型中的权值,即要优化的参数;所述训练和优化是指利用bp算法计算损失函数对梯度化进行优化,以加快模型的收敛速度,计算过程如下:

34、

35、式中,yi是第i个样本的标签;zi是对应的预测值;wj代表权重;xij是第i个样本第j个特征值;b是偏置项;是更新后的权重;b+是更新后的偏置;α是学习率;

36、step 2-1.3、进行车道线边缘相对距离计算,记录绝对坐标全局坐标系下的关键帧位姿,步骤如下:

37、a.通过从高精度相机拍摄的图像或视频帧中选取图像清晰的特定帧为关键帧,用于计算相邻帧之间的变化;

38、b.将步骤a中选取的关键帧,将其位姿从局部帧转换为全局坐标,具体的转换过程为:通过因子图对关键帧图像进行优化划分为初始化、外部标定和定位三个阶段,其中,初始化进行初始外部参数估计,即在上一帧的基础上经过设定的时间间隔,产生清晰的图片,且与前一个节点有足够的运动,即与之前的图片存在明显色差或特征变量后,选择一个新的关键帧,并通过球面线性姿态插值将该一对关键帧姿态插入因子图中进行时间对齐;在每帧收集了n个节点后,确定初始化成功;所述n的取值为取车辆每秒的行驶距离,单位取米/s,向上取整;其中,明显色差通过比较颜色直方图的方式进行区分,过程如下:

39、import cv2

40、import numpy as np

41、#读取图像

42、image1=cv2.imread('sunset1.jpg')

43、image2=cv2.imread('sunset2.jpg')

44、#计算每个通道的直方图

45、histsize=256#bin的数量

46、histrange=(0,256)#范围

47、hist_full=cv2.calchist([image1],[0,1,2],none,[histsize,histsize,histsize],[histrange,histrange,histrange])

48、hist_flat=hist_full.flatten()

49、#对第二张图像做同样的处理

50、cv2.normalize(hist_flat,hist_flat,alpha=0,beta=1,norm_type=cv2.norm_minmax)

51、similarity=cv2.comparehist(hist_flat1,hist_flat2,cv2.histcmp_correl)

52、#返回值在-1到1之间,其中1表示完全相似;

53、外部标定为构建三元边缘,分别从两帧图像和外部参数中约束关键帧姿态,以精确求解坐标转换关系,所述约束关键帧姿态的步骤如下:

54、①提取图像中的特征点,使用视觉里程计方法,根据连续帧之间的特征点匹配来估计高精度相机的相对运动;

55、②确定出相对于前一个节点有足够运动的图片,建立新的关键帧;

56、③通过姿态插值将新关键帧的姿态与上一个关键帧的姿态进行时间对齐;

57、④重复步骤①至③,收集到设定数量的关键帧后,使用因子图优化所有关键帧的姿态和外部参数;

58、定位即坐标转化过程如下:

59、①构建因子图中的三元边缘约束,所述约束用于编码关键帧之间以及关键帧与外吧参数之间的几何关系,其来源于两帧图像之间的相对姿态以及gps和imu数据信息;

60、②使用levenberg-marquardt算法最小化因子图中所有边的误差,精确求解坐标转换关系后,将全局坐标系下得到的相对位姿转换为全局坐标;所述全局坐标的计算方法为:

61、利用高精度相机获得表示特征点相对高精度相机坐标系的距离信息,为相对坐标(x1,y1),由天线和高精度相机标定参数知,特征点到天线的相对坐标为(x1+x2,y1);特征点到天线的距离为l2,则:

62、

63、根据定位天线与高精度相机的位置关系得到特征点与定位天线连线相对于正北方向的夹角σ,由三角函数可知,特征点相对定位天线的距离分别为:

64、xi=l2sinσ

65、yi=l2cosσ;

66、step 2-1.4、进行车辆行驶坐标计算,过程为:

67、在进行路径采集之前,在路边合适位置固定好定位固定基站,用于给定相对坐标原点,所述基站的目的是为了消除卫星定位信号的时钟误差和多径效应。固定基站看作是坐标系的原点;在运输车辆上指定位置固定安装差分固定基站,运输车辆在行驶过程中,rtk、固定基站与卫星之间通讯,实时获取rtk随车辆行驶的轨迹坐标,并通过惯导系统和轮速计对该坐标进行实时纠偏;当定向天线出现短时间信号丢失时,依靠惯导提供持续导航,由于惯导自身存在累计误差,因此,惯导和定位天线在导航过程中相互校正,当惯导信息和导航信息偏差大于5%时发出报警;

68、step 2-1.5、进行车道线坐标计算,过程为:

69、根据实时获取的rtk坐标轨迹,结合相机识别车道线距离车辆的相对距离信息,利用step 2-1.3中的空间三角函数关系,通过对多传感器在统一时间的联合标定,将摄像头与rtk、惯导系统、轮速计进行融合分析,结合数据关联算法、通过对相同时刻帧的数据关系输出车道线的位置信息,将rtk实时轨迹转化为车道线的坐标轨迹,并将此轨迹指定为任务路径;具体公式如下:

70、

71、式中,是运输车辆在时刻(i+1)的状态估计;

72、是运输车辆在时刻i的状态估计;

73、是运输车辆在时间段[i,i+1]之间的平均速度,δt是时间间隔。

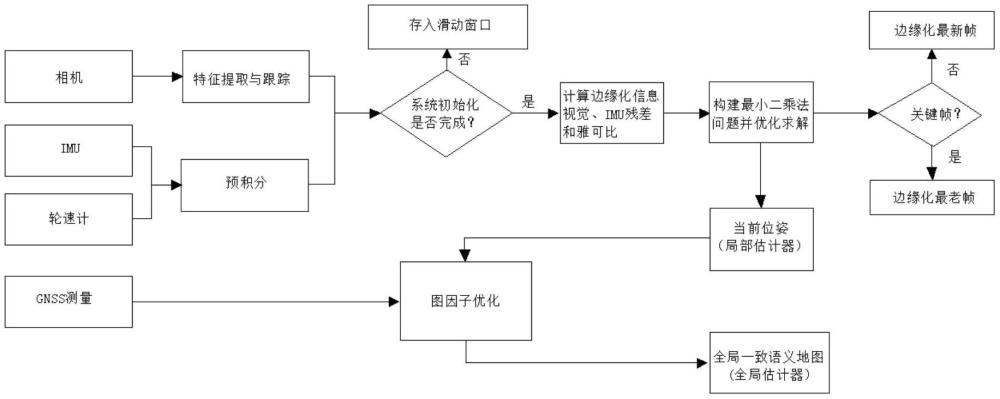

74、进一步地,所述步骤step 2中,校正累积误差的方法为:惯导系统、轮速计及rtk设备通过多传感器融合滤波算法对车辆行驶轨迹进行点位检测及矫正,当惯导系统、轮速计与rtk采集路径出现偏差时,通过积分计算排除错误参数,修正最终的路径轨迹参数,具体为:

75、step 2-2.1、利用系统的时间戳确保传感器数据的时间同步性;

76、step 2-2.2、比较不同传感器的轨迹数据,超出设定的阈值则标记为偏差;系统误差通常设定为1%以内;

77、step 2-2.3、基于车辆的运动学模型,计算车辆下一时刻的加速度和转向角是否符合预期;其中,车辆的运动学模型以点f为控制参考点,l为车辆的轴间距,r为前轮的转弯半径,α和β分别为前轮和后轮的转角,vf为前轮的行驶速度,γ为车身于x周之间的夹角,又称为航向角,公式如下:

78、

79、车辆下一时刻的加速度和转向角是否符合预期的计算过程为:

80、车辆行驶过程中,在获取惯导系统和车轮预计分后,通过调整各预测位置方差的一致性并进行动态调整,并将噪声再估计应用于图像特征的提取及识别,公式如下:

81、

82、式中,||γp-hpx||2是先验信息与状态变量之间的误差;是惯性测量单元与状态变量之间的误差;是车轮与状态变量之间的误差;是相邻帧间重投影误差与状态变量之间的误差;x为状态变量,4个残差分别对应边缘化、惯导系统测量、车轮测量和相邻帧间重投影误差的先验信息。

83、进一步地,所述步骤step2中,高精度相机连续捕获的车道线图像经控制单元利用图像识别算法和深度学习结合的方式建立数学模型后,增加车道线的识别率及距离测算精度;所述图像识别算法和深度学习结合的数学模型构建过程如下:

84、step 2-3.1、对高精度相机连续捕获的图像进行预处理,包括图像清洗、裁剪、增强,以提高图像质量并减少噪声干扰;

85、step 2-3.2、利用图像识别算法提取图像中的车道线特征,包括颜色、形状、纹理;这些特征将作为后续深度学习模型的输入;

86、step 2-3.3、利用yolo算法模型对图像进行学习和训练,并对训练好的模型进行评估,包括计算准确率、召回率;根据评估结果对模型进行优化,包括调整网络结构、增加训练数据;

87、step 2-3.4、利用加权交叉熵函数计算车道线识别损失函数,公式如下:

88、

89、式中,c表示分类个数,i,j分别表示第i个样本和第j个分类;y是样本的真值,yij表示样本属于第j个分类的真值,经过onehot编码后,yij=0或者yij=1;pij代表第j个分类中第i个样本预测值的输出概率;wj表示第j个分类的权值,该值表达式如下:

90、

91、其中,med_pixel_j表示图片中j分类像素点的中值;sum_pixel_j表示图片中j分类像素点的总和;sum_pixel_all表示所有图片样本像素点总和。

92、进一步地,为了提高对采集路径出现偏差的计算效率,根据获得的姿态角,计算相对于平移变分解的雅可比矩阵如下:

93、

94、式中,θ表示旋转角,a是单位向量旋转轴,(*)^是斜对称矩阵,将车轮的线速度和加速度转换为imu帧,表示为:

95、

96、woi是刚性连接产生的角速度,通过将雅可比矩阵、速度和最近的时间间隔相乘,即得到系统需求的平移量;系统需求的平移量是指系统在对坐标进行采集时会获得两个坐标,一个是定位天线自身移动过程产生的坐标点,一个是相机拍照处理后得到的车道线特征点相对相机的坐标点,最后要把相机得到的坐标点换算为定位定向天线的坐标信息,这里不仅要考虑相机和定位定向天线的相对位置,同时要考虑两者采集信息时的时间差以及在该时间差内两者之间的相对坐标变化。

97、本发明通过设置定位固定基站、实时差分固定基站、高精度相机、惯导系统(imu)、轮速计、运输车辆、车载rtk和控制单元,自动采集系统启动后,利用定位固定基站和rtk对运输车辆进行初始定位;利用高精度相机捕获初始图像,依据所述初始图像设置视觉识别的参考帧;惯导系统和轮速计开始记录车辆当前的速度、车轮转角及车辆实时位置、姿态信息,用于和rtk信息互相验证;高精度相机连续捕获车道线图像;实时差分固定基站持续提供位置信息;惯导系统测量运输车辆的加速度和角速度;轮速计测量车轮的转速;所述车道线图像信息、位置信息、加速度和角速度信息和车轮的转速信息实时传送至控制单元,所述控制单元利用图像处理技术来检测和识别车道线,将运输车辆的加速度和角速度与车轮的转速数据结合,通过航位推算方法计算车辆的位置变化,将实时差分固定基站提供的位置信息与航位推算结果融合,用于校正累积误差;同时,控制单元将车道线及车辆位置实时记录用于异常状况报警及后续分析。本发明提高了路径采集的效率,利于无人化作业的推广。

- 还没有人留言评论。精彩留言会获得点赞!