基于RTK高精度定位与机器视觉融合的无人机自主巡检方法与流程

基于rtk高精度定位与机器视觉融合的无人机自主巡检方法

技术领域

1.本发明涉及无人机自动控制技术领域,具体的说是基于rtk高精度定位与机器视觉融合的无人机自主巡检方法。

背景技术:

2.无人机按照已知航线点集合遍历飞行,完成巡检任务。航线点集合包括冗余点,因此无人机自主巡检的效率及安全性将会受到影响。无人机到达巡检拍照点后,会执行云台对焦,对目标进行拍照但是路点精度不够导致拍摄精度不够。同时电力设备尺寸各异,拍摄要求不一,在规范化作业的过程中,不同设备的特性决定了它在画面中的大小。部分巡检目标在照片中占用画幅大,无人机垂直高度精度稍差就可能导致拍不全。进一步的,由于无人机在巡检过程中到达每处悬停位置时,均有一定的位置偏差,反应在照片中会导致目标设备偏出镜头获取范围,造成数据采集失败。需要一种无人机自主巡检方法,解决现有无人机巡检智能化程度低、完全依靠人工手动操作、对无人机飞手的专业水平要求高等问题。

技术实现要素:

3.本发明要解决的技术问题是提供一种基于rtk高精度定位与机器视觉融合的无人机自主巡检方法,该方法基于垂距法的全轨迹关键拐点选取能很好地去除航线点集合中的冗余点,提高无人机自主巡检的效率及安全性。基于rtk的高精度定位方法,将会在无人机将要到达路点后基于rtk定位精度优化,减少路点精度误差。并且利用基于巡检对象差异特性的动态优化定位方法,针对设备在基准图像中的画面占幅特性设置不同的定位容忍阈值,提高巡检速度。

4.为解决上述技术问题,本发明采用的技术方案为:

5.基于rtk高精度定位与机器视觉融合的无人机自主巡检方法,其特征在于:在无人机自动巡检过程中能够进行航线选取,对冗余的路点进行去除;无人机在飞行至接近拍照点时,自动减小自身位置与期望位置的距离,精确到达拍照点;无人机在拍照前控制云台转动,在目标设备图片位于照片中心位置后进行拍照;具体巡检步骤如下:

6.步骤1,获取原始航线点集,并对原始航线点集通过基于关键点和轨迹夹角的轨迹筛选方法进行冗余点过滤,输出优化后的巡检航线;

7.步骤2,将巡检航线数据上传至无人机,无人机由起巡检航线内的起始位置点开始巡检工作;

8.步骤3,无人机飞至巡检航线上的拍照点附近,调整无人机上云台带动相机朝向待巡检物体,无人机通过基于rtk的高精度定位方法调整无人机空间位置,缩小与目标拍照点坐标的距离偏差;

9.步骤4,通过基于巡检对象差异特性的动态优化定位方法,调整无人机云台,使目标巡检物体在相机图片中占幅符合要求后,控制相机拍照;

10.步骤5,判断巡检航线是否巡检完成,若未巡检航线内还存在拍照点,则无人机飞

行至下一拍照点附近,重复步骤3~至步骤5;

11.步骤6,若未巡检航线内不存在拍照点,则无人机按照巡检航线数据飞行至巡检航线结束点处,完成巡检作业。

12.所述的步骤1中原始航线点集为无人机巡检路线采集过程中采集记录的所有位置点构成,采集记录的所有位置点包括轨迹起始位置点,拍照位置点,轨迹拐点,轨迹结束位置点,所述的轨迹起始位置点、拍照位置点和轨迹结束位置点均为不可删除的关键位置点,所述的基于关键点和轨迹夹角的轨迹筛选方法具体步骤如下:

13.步骤1.1,以原始航线中的关键位置点为界,将原始航线分为若干段轨迹区间,其中每个轨迹区间的起始点和结束点都为关键位置点;

14.步骤1.2,取一段轨迹区间,如果轨迹区间中只有两个点,则不用筛选,进入步骤1.6;

15.步骤1.3,设轨迹区间起始点a点和结束点b点之间的每个中间点为o

i

点,其中,i[1,n],n为中间点的个数;为每个中间点做连线o

i

a和o

i

b,确定所有满足o

i

a>长度阈值、o

i

b>长度阈值的点,并确定所有满足上述条件的中间点中夹角∠ao

i

b最小的点o

j

;

[0016]

步骤1.4,如果点o

j

的夹角∠ao

j

b>角度阈值,则将轨迹区间中除了起始点和结束点之外的其余点都删去,进入步骤1.6;若点o

j

的夹角∠ao

j

b<角度阈值,则将点o

j

保留并标记为关键位置点,

[0017]

步骤1.5,以o

j

为关键位置点将轨迹区间分为两段新的轨迹区间,对这两段新的轨迹区间执行步骤1.2至步骤1.5;

[0018]

步骤1.6,顺次取下一段轨迹区间重复步骤1.2至步骤1.5,直至遍历完全部轨迹区间;

[0019]

步骤1.7,输出新的轨迹位置点集合即为删选优化后的新轨迹。

[0020]

所述的步骤1.3中长度阈值为3米,所述的步骤1.4中角度阈值为100度。

[0021]

所述的步骤3中基于rtk的高精度定位方法通过在到达拍照位置点后,无人机根据自身的rtk与姿态反馈,执行速度控制减少位置误差实现;具体步骤如下:

[0022]

步骤3.1,获取拍照位置点的期望rtk坐标(lat1,lon1,alt1)以及无人机当前的rtk坐标(lat2,lon2,alt2),计算得到拍照位置点的期望点与无人机当前位置的垂直距离dh,北向距离dn,东向距离de,具体公式如下:

[0023]

radlat1=lat1*pi/180.0

[0024]

radlat2=lat2*pi/180.0

[0025]

a=radlat1-radlat2

[0026]

b=lon1*pi/180.0-lon2*pi/180.0

[0027]

d

h

=alt1-alt2

[0028][0029][0030]

其中,(lat1,lon1,alt1)分别为拍照位置期望点的rtk纬度、经度、高度;(lat2,lon2,alt2)分别为无人机当前位置点的rtk纬度、经度、高度;pi为圆周率;earth_radius为地球赤道半径,约为6378.137km;α为无人机朝向角;

[0031]

步骤3.2,计算无人机飞往拍照位置点的控制速度,所述的无人机控制速度分为无人机切向方向的速度vx,径向方向的速度vy,高度方向的速度vz,采用pid控制算法,vx、vy、vz三个控制速度的计算方法如公式2.2-2、公式2.2-3所示:

[0032]

v

z

=d

h

×

k

pz

ꢀꢀ

(2.2-2)

[0033][0034]

其中,k

pz

为高度方向比例系数,k

p

为水平方向比例系数;

[0035]

步骤3.3,根据步骤3.2中计算得到的无人机切向方向的速度vx,径向方向的速度vy,高度方向的速度vz对无人机进行控制,直至拍照位置点的期望点与无人机当前位置的垂直距离dh≤30cm,北向距离dn≤30cm,东向距离de≤30cm,此时无人机基于rtk的高精度定位过程完成。

[0036]

所述的步骤4中通过基于巡检对象差异特性的动态优化定位方法调整无人机云台转动,使目标巡检物体在相机图片中占幅符合要求,具体步骤如下:

[0037]

步骤4.1,计算出目标巡检物体识别框中心点(x1,y1)和画面中心点(x0,y0)在水平和垂直方向上的像素距离(dw,dh),其中,dw=x1-x0,dh=y1-y0;

[0038]

步骤4.2,根据拍照位置点的期望rtk坐标(lat1,lon1,alt1)以及无人机当前的rtk坐标(lat2,lon2,alt2),计算得到拍照位置点的期望点与无人机当前位置的垂直距离dh,北向距离dn,东向距离de;计算出当前无人机位置点与期望点位置的水平径向距离dr如下:

[0039]

d

r

=d

e

×

sin(α)+d

n

×

cos(α)

ꢀꢀ

(2.2-9)

[0040]

式中,α为无人机朝向角;

[0041]

步骤4.3,获取期望点与目标设备的水平径向距离为d

t

,计算出当前无人机与目标设备的水平径向距离d=d

t-d

r

;

[0042]

步骤4.4,获取相机镜头的视场角度f,则可以算得视野对角线距离l

f

,

[0043][0044]

获取基准图像宽为w,高为h,计算画幅比r=w

÷

h;则水平切向与垂直方向的视野v

f

与v

f

计算公式如下:

[0045][0046][0047]

进一步计算目标巡检物体识别框中心点(x1,y1)和画面中心点(x0,y0)在水平和垂直方向上的物理距离(d

w

,d

h

),所述的d

w

和d

h

的计算公式如下:

[0048][0049][0050]

步骤4.5,根据目标巡检物体识别框中心点和画面中心点在水平和垂直方向上的

物理距离(d

w

,d

h

)以及当前无人机与目标设备的水平径向距离d,计算得到云台需要调整的水平角度

△

α

yaw

和垂直角度

△

α

pitch

,所述的水平角度

△

α

yaw

和垂直角度

△

α

pitch

具体计算公式如下:

[0051]

△

α

yaw

=arctan(d

w

/d)

[0052]

△

α

pitch

=arctan(d

h

/d)

[0053]

步骤4.6,根据水平角度

△

α

yaw

和垂直角度

△

α

pitch

的计算结果控制云台左右转动,具体控制方式如下:

[0054]

若水平角度

△

α

yaw

>0,云台向右转动|

△

α

yaw

|角度;若水平角度

△

α

yaw

<0,云台向左转动|

△

α

yaw

|角度;若垂直角度

△

α

pitch

>0,云台向下转动|

△

α

pitch

|角度;若垂直角度

△

α

pitch

<0,云台向上转动|

△

α

pitch

|角度;

[0055]

步骤4.7,重新计算水平角度

△

α

yaw

和垂直角度

△

α

pitch

,若云台需要再次调整的水平角度

△

α

yaw

和垂直角度

△

α

pitch

均小于预设阈值,则云台调整结束;否则,返回步骤4.6。

[0056]

所述的步骤4.7中,重新计算水平角度

△

α

yaw

和垂直角度

△

α

pitch

的循环次数不大于5次,若超过循环次数云台调整后的水平角度

△

α

yaw

或垂直角度

△

α

pitch

大于预设阈值,则强制云台相机拍摄。

[0057]

所述的不可删除位置点还包括可以人工标定的巡航路线必经位置点,所述的巡航路线必经位置点为无人机飞行过程中为了避障而必须穿过的位置点。

[0058]

该种基于rtk高精度定位与机器视觉融合的无人机自主巡检方法能够产生的有益效果为:第一,在巡检轨迹的优化过程中应用了基于关键点和轨迹夹角的轨迹筛选方法,能够在保留轨迹起始位置点、拍照位置点、轨迹结束位置点和人工标定的巡航路线必经位置点的基础上,过滤掉冗余的位置点,优化巡检轨迹,提高飞行效率。

[0059]

第二,在无人机飞行至拍照位置点处时,由于不可避免的误差,采用基于rtk的高精度定位方法,对无人机的拍照悬停位置进行优化调整,极大的减少了路点精度误差,为无人机的巡检拍照质量提供了基础。

[0060]

第三,无人机在对目标物体巡检拍照的过程中,利用基于巡检对象差异特性的动态优化定位方法,针对设备在基准图像中的画面占幅特性设置不同的定位容忍阈值,通过云台控制无人机的照相机发生偏转,对待巡检物体进行精准捕捉和拍摄,提高巡检速度。

[0061]

第四,该种巡检方法解决了航线采集以及定位优化问题,贯穿航线学习到自主巡检的流程之中,兼顾了巡检效率以及巡检精确度,提供了精细化巡检的高效率解决方案,能够实现无人机巡检过程的自动化,降低对无人机专业飞手的需求。

附图说明

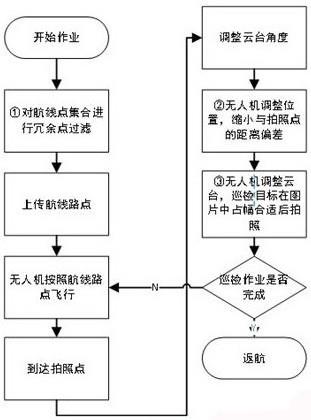

[0062]

图1为本发明基于rtk高精度定位与机器视觉融合的无人机自主巡检方法的流程示意图。

[0063]

图2为本发明基于rtk高精度定位与机器视觉融合的无人机自主巡检方法中关键技术框架图。

[0064]

图3为本发明基于rtk高精度定位与机器视觉融合的无人机自主巡检方法中基于关键点和轨迹夹角的轨迹筛选方法示意图。

[0065]

图4为本发明基于rtk高精度定位与机器视觉融合的无人机自主巡检方法中基于

关键点和轨迹夹角的轨迹筛选方法示意图。

[0066]

图5为本发明基于rtk高精度定位与机器视觉融合的无人机自主巡检方法中基于rtk的高精度定位方法的路点拍摄流程示意图。

[0067]

图6为本发明基于rtk高精度定位与机器视觉融合的无人机自主巡检方法中基于rtk的高精度定位方法的工作流程示意图。

[0068]

图7为本发明基于rtk高精度定位与机器视觉融合的无人机自主巡检方法中基于巡检对象差异特性的动态优化定位方法的流程示意图。

[0069]

图8为本发明基于rtk高精度定位与机器视觉融合的无人机自主巡检方法中目标待巡检设备示例图。

[0070]

图9为本发明基于rtk高精度定位与机器视觉融合的无人机自主巡检方法中镜头视野平面内中心点、识别框中心点的位置关系示意图。

[0071]

图10为本发明基于rtk高精度定位与机器视觉融合的无人机自主巡检方法中水平观察角度时镜头与镜头视野平面中心点、识别框中心点的位置关系示意图。

[0072]

图11为本发明基于rtk高精度定位与机器视觉融合的无人机自主巡检方法中垂直观察角度时镜头与镜头视野平面中心点、识别框中心点的位置关系示意图。

具体实施方式

[0073]

为解决现有无人机巡检智能化程度低、完全依靠人工手动操作、对无人机飞手的专业水平要求高等问题,提出了基于rtk高精度导航的无人机自主巡检技术,减少巡检过程中人工干预,最大程度地提高无人机自主巡检能力。在无人机巡检过程中需要解决如下问题:第一,航迹选取;如何对输电线路的航线信息进行采集,获取关键的轨迹航点,减少冗余的路点,将决定无人机自主巡检的效率及安全性。第二,定位控制;如何确保无人机沿着航线精准飞行,控制无人机在设备拍照点精准拍摄照片,决定着无人机自主巡检任务的完成质量,甚至决定后续状态感知与缺陷识别的完成质量。第三,定位优化;输电线路中包含大量尺寸不一、形状各异、位置随机分布的设备,如何根据设备差异特性进行定位优化,决定着无人机自主巡检的设备辨识与信息采集效率。

[0074]

如图1所示,基于rtk高精度定位与机器视觉融合的无人机自主巡检方法,其特征在于:在无人机自动巡检过程中能够进行航线选取,对冗余的路点进行去除;无人机在飞行至接近拍照点时,自动减小自身位置与期望位置的距离,精确到达拍照点;无人机在拍照前控制云台转动,在目标设备图片位于照片中心位置后进行拍照;具体巡检步骤如下:

[0075]

步骤1,获取原始航线点集,并对原始航线点集通过基于关键点和轨迹夹角的轨迹筛选方法进行冗余点过滤,输出优化后的巡检航线;

[0076]

步骤2,将巡检航线数据上传至无人机,无人机由起巡检航线内的起始位置点开始巡检工作;

[0077]

步骤3,无人机飞至巡检航线上的拍照点附近,调整无人机上云台带动相机朝向待巡检物体,无人机通过基于rtk的高精度定位方法调整无人机空间位置,缩小与目标拍照点坐标的距离偏差;

[0078]

步骤4,通过基于巡检对象差异特性的动态优化定位方法,调整无人机云台,使目标巡检物体在相机图片中占幅符合要求后,控制相机拍照;

[0079]

步骤5,判断巡检航线是否巡检完成,若未巡检航线内还存在拍照点,则无人机飞行至下一拍照点附近,重复步骤3~至步骤5;

[0080]

步骤6,若未巡检航线内不存在拍照点,则无人机按照巡检航线数据飞行至巡检航线结束点处,完成巡检作业。

[0081]

进一步的,步骤1中原始航线点集为已知的飞行航线点集合,原始航线是无人机在进行路线采集过程中实时记录的所有位置点构成的,每一个位置点都可以视为观测值,其中不免存在由于信号跳变等原因引起的不准确位置噪点,噪点的存在不仅会加重计算负担,而且严重影响航线学习精度,因此利用卡尔曼滤波对原始轨迹进行滤波处理。利用卡尔曼滤波得到较为准确的原始位置点轨迹线路后,得到的位置点数量仍然较多,这会导致无人机需要飞行的位置点过多,严重降低飞行效率。为此,需要对位置点集合进行筛选。

[0082]

利用卡尔曼滤波得到较为准确的原始位置点轨迹线路中的所有位置点包括轨迹起始位置点,拍照位置点,轨迹拐点,轨迹结束位置点,所述的轨迹起始位置点、拍照位置点、人工标定的巡航路线必经位置点和轨迹结束位置点均为不可删除位置点,巡航路线必经位置点包括但不限于无人机飞行过程中为了避障而必须穿过的位置点,如图4所示,所述的步骤1中原始航线点集为无人机巡检路线采集过程中采集记录的所有位置点构成,采集记录的所有位置点包括轨迹起始位置点,拍照位置点,轨迹拐点,轨迹结束位置点,所述的轨迹起始位置点、拍照位置点和轨迹结束位置点均为不可删除的关键位置点,如图4所示,所述的基于关键点和轨迹夹角的轨迹筛选方法具体步骤如下:

[0083]

步骤1.1,以原始航线中的关键位置点为界,将原始航线分为若干段轨迹区间,其中每个轨迹区间的起始点和结束点都为关键位置点;

[0084]

步骤1.2,取一段轨迹区间,如果轨迹区间中只有两个点,则不用筛选,进入步骤1.6;

[0085]

步骤1.3,设轨迹区间起始点a点和结束点b点之间的每个中间点为o

i

点,其中,i[1,n],n为中间点的个数;为每个中间点做连线o

i

a和o

i

b,确定所有满足o

i

a>长度阈值、o

i

b>长度阈值的点,并确定所有满足上述条件的中间点中夹角∠ao

i

b最小的点o

j

;

[0086]

步骤1.4,如果点o

j

的夹角∠ao

j

b>角度阈值,则将轨迹区间中除了起始点和结束点之外的其余点都删去,进入步骤1.6;若点o

j

的夹角∠ao

j

b<角度阈值,则将点o

j

保留并标记为关键位置点,

[0087]

步骤1.5,以o

j

为关键位置点将轨迹区间分为两段新的轨迹区间,对这两段新的轨迹区间执行步骤1.2至步骤1.5;

[0088]

步骤1.6,顺次取下一段轨迹区间重复步骤1.2至步骤1.5,直至遍历完全部轨迹区间;

[0089]

步骤1.7,输出新的轨迹位置点集合即为删选优化后的新轨迹。

[0090]

本实施例中,步骤1.3中长度阈值为3米,所述的步骤1.4中角度阈值为100度。

[0091]

进一步的,轨迹中的关键位置点不局限于轨迹起始位置点、拍照位置点、轨迹结束位置点,还包括可以人工标定的巡航路线必经位置点,所述的巡航路线必经位置点为无人机飞行过程中为了避障而必须穿过的位置点。

[0092]

进一步的,步骤3中基于rtk的高精度定位方法通过在到达拍照位置点后,无人机根据自身的rtk与姿态反馈,执行速度控制减少位置误差实现;所述的rtk是实时处理两个

测量站载波相位观测量的差分方法,将基准站采集的载波相位发给用户接收机,求差解算坐标,通过引入基于rtk的高精度定位方法,提高巡检设备拍摄的精度;如图6所示,具体步骤如下:

[0093]

步骤3.1,获取拍照位置点的期望rtk坐标(lat1,lon1,alt1)以及无人机当前的rtk坐标(lat2,lon2,alt2),计算得到拍照位置点的期望点与无人机当前位置的垂直距离dh,北向距离dn,东向距离de,具体公式如下:

[0094]

radlat1=lat1*pi/180.0

[0095]

radlat2=lat2*pi/180.0

[0096]

a=radlat1-radlat2

[0097]

b=lon1*pi/180.0-lon2*pi/180.0

[0098]

d

h

=alt1-alt2

[0099][0100][0101]

其中,(lat1,lon1,alt1)分别为拍照位置期望点的rtk纬度、经度、高度;(lat2,lon2,alt2)分别为无人机当前位置点的rtk纬度、经度、高度;pi为圆周率;earth_radius为地球赤道半径,约为6378.137km;α为无人机朝向角;

[0102]

步骤3.2,计算无人机飞往拍照位置点的控制速度,所述的无人机控制速度分为无人机切向方向的速度vx,径向方向的速度vy,高度方向的速度vz,采用pid控制算法,vx、vy、vz三个控制速度的计算方法如公式2.2-2、公式2.2-3所示:

[0103]

v

z

=d

h

×

k

pz

ꢀꢀ

(2.2-2)

[0104][0105]

其中,k

pz

为高度方向比例系数,k

p

为水平方向比例系数;

[0106]

步骤3.3,根据步骤3.2中计算得到的无人机切向方向的速度vx,径向方向的速度vy,高度方向的速度vz对无人机进行控制,直至拍照位置点的期望点与无人机当前位置的垂直距离dh≤30cm,北向距离dn≤30cm,东向距离de≤30cm,此时无人机基于rtk的高精度定位过程完成。

[0107]

进一步的,步骤4中通过基于巡检对象差异特性的动态优化定位方法调整无人机云台转动,使目标巡检物体在相机图片中占幅符合要求,如图7所示,具体步骤如下:

[0108]

步骤4.1,如图9所示,计算出目标巡检物体识别框中心点(x1,y1)和画面中心点(x0,y0)在水平和垂直方向上的像素距离(dw,dh),其中,dw=x1-x0,dh=y1-y0,此时实际画面中目标设备的位置如图8所示;

[0109]

步骤4.2,根据拍照位置点的期望rtk坐标(lat1,lon1,alt1)以及无人机当前的rtk坐标(lat2,lon2,alt2),计算得到拍照位置点的期望点与无人机当前位置的垂直距离dh,北向距离dn,东向距离de;计算出当前无人机位置点与期望点位置的水平径向距离dr如下:

[0110]

d

r

=d

e

×

sin(α)+d

n

×

cos(α)

ꢀꢀ

(2.2-9)

[0111]

式中,α为无人机朝向角;

[0112]

步骤4.3,获取期望点与目标设备的水平径向距离为d

t

,计算出当前无人机与目标设备的水平径向距离d=d

t-d

r

;

[0113]

步骤4.4,获取相机镜头的视场角度f,则可以算得视野对角线距离l

f

,

[0114][0115]

获取基准图像宽为w,高为h,计算画幅比r=w

÷

h;则水平切向与垂直方向的视野v

f

与v

f

计算公式如下:

[0116][0117][0118]

进一步计算目标巡检物体识别框中心点(x1,y1)和画面中心点(x0,y0)在水平和垂直方向上的物理距离(d

w

,d

h

),所述的d

w

和d

h

的计算公式如下:

[0119][0120][0121]

步骤4.5,如图10、图11所示,根据目标巡检物体识别框中心点和画面中心点在水平和垂直方向上的物理距离(d

w

,d

h

)以及当前无人机与目标设备的水平径向距离d,计算得到云台需要调整的水平角度

△

α

yaw

和垂直角度

△

α

pitch

,所述的水平角度

△

α

yaw

和垂直角度

△

α

pitch

具体计算公式如下:

[0122]

△

α

yaw

=arctan(d

w

/d)

[0123]

△

α

pitch

=arctan(d

h

/d)

[0124]

步骤4.6,根据水平角度

△

α

yaw

和垂直角度

△

α

pitch

的计算结果控制云台左右转动,具体控制方式如下:

[0125]

若水平角度

△

α

yaw

>0,云台向右转动|

△

α

yaw

|角度;若水平角度

△

α

yaw

<0,云台向左转动|

△

α

yaw

|角度;若垂直角度

△

α

pitch

>0,云台向下转动|

△

α

pitch

|角度;若垂直角度

△

α

pitch

<0,云台向上转动|

△

α

pitch

|角度;

[0126]

步骤4.7,重新计算水平角度

△

α

yaw

和垂直角度

△

α

pitch

,若云台需要再次调整的水平角度

△

α

yaw

和垂直角度

△

α

pitch

均小于预设阈值,则云台调整结束;否则,返回步骤4.6。

[0127]

步骤4.7中,重新计算水平角度

△

α

yaw

和垂直角度

△

α

pitch

的循环次数不大于5次,若超过循环次数云台调整后的水平角度

△

α

yaw

或垂直角度

△

α

pitch

大于预设阈值,则强制云台相机拍摄。

[0128]

进一步的,步骤4.1中对目标巡检物体识别框中心点(x1,y1)的方法为:通过对每一种目标电力设备采集一定量的现场巡检照片,标注后生成样本集,导入深度神经网络模型进行迭代训练,将训练完成后的深度神经网络模型部署到控制终端,对无人机摄像头采集到的实时图像进行识别,最终完成目标巡检物体识别框中心点的判断。

[0129]

通过对于云台在水平方向和垂直方向的两次角度调整,能够将目标物体画框对中在无人机云台画幅中间位置,多次的调整能够进一步的提高精度,保证调整后对中的有效性,同时,也不能无限次的调整,如果出现多次调整依然达不到预设效果的情况下,应在有

限次的循环次数中结束,保证巡检效率,减少云台调整时间,为后续的巡检的完成留足电能。

[0130]

进一步的,当无人机按照优化后的巡检航迹完成巡检时,最终飞至航迹的结束位置,完成回收。

[0131]

综上,该种无人机自主巡检方法中,基于关键点和轨迹夹角的轨迹筛选方法能很好地去除航线点集合中的冗余点,提高无人机自主巡检的效率及安全性。基于rtk的高精度定位方法,将会在无人机将要到达路点后基于rtk定位精度优化,减少路点精度误差。解决了航线采集以及定位优化问题,贯穿航线学习到自主巡检的流程之中,兼顾了巡检效率以及巡检精确度,提供了精细化巡检的高效率解决方案。

[0132]

以上仅是本发明的优选实施方式,本发明的保护范围并不仅局限于上述实施例,凡属于本发明思路下的技术方案均属于本发明的保护范围。应当指出,对于本技术领域的普通技术人员来说,在不脱离本发明原理前提下的若干改进和润饰,应视为本发明的保护范围。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1