自走车跟随系统及自走车跟随方法与流程

1.本发明涉及一种自走车跟随系统及自走车跟随方法,且特别是涉及一种让自走车能在干扰较多或路线较复杂的场所跟随目标的自走车跟随系统及自走车跟随方法。

背景技术:

2.近年来智能零售与物流电商蓬勃发展,但劳动人口高龄化,搬运与捡货等人力作业成本显著上升。为解决物流业人力资源供不应求的问题,使用人机协作跟随式自走车,可提升人员作业效率并扩大就业年龄层。

3.仓储用服务型自走车可大致分为导航式自走车及跟随式自走车。现存的跟随型自走车主要应用于环境较单纯的场所,如货架位置固定的物流仓。若在干扰较多或路线较复杂的场所,如人车繁杂的物流仓或零售卖场,当多人同时作业时,难免发生人员交错的情况,目标一旦被遮蔽,便无法继续跟随。因此,如何让自走车能正确地跟随人员是本领域技术人员应致力的目标。

技术实现要素:

4.(一)要解决的技术问题

5.有鉴于此,本发明提供一种自走车跟随系统及自走车跟随方法,让自走车能在干扰较多或路线较复杂的场所跟随目标。

6.(二)技术方案

7.本发明提出一种自走车跟随系统,包括:数据收集单元,包括:彩色影像深度摄影机,获得彩色影像;以及光学雷达,获得二维信息;以及数据运算单元,包括:影像目标追踪模块,获得所述彩色影像中的目标的三维坐标;光学雷达目标追踪模块,并获得所述二维信息中所述目标的二维坐标;坐标融合模块,将所述三维坐标转换为球坐标系的第一球坐标,并将所述二维坐标转换为所述球坐标系的第二球坐标;以及控制指令输出模块,根据基于所述彩色影像深度摄影机获得的所述第一球坐标与基于所述光学雷达获得的所述第二球坐标,来产生所述目标的第三球坐标;以及车体控制单元,包括车体控制器,根据所述第三球坐标控制车体来跟随所述目标。

8.本发明提出一种自走车跟随方法,包括:通过彩色影像深度摄影机获得彩色影像,并通过光学雷达,获得二维信息;获得所述彩色影像中的目标的三维坐标,并获得所述二维信息中所述目标的二维坐标;将所述三维坐标转换为球坐标系的第一球坐标,并将所述二维坐标转换为所述球坐标系的第二球坐标;根据基于所述彩色影像深度摄影机获得的所述第一球坐标与基于所述光学雷达获得的所述第二球坐标,来产生所述目标的第三球坐标;以及通过车体控制器根据所述第三球坐标控制车体来跟随所述目标。

9.(三)有益效果

10.基于上述,本发明的自走车跟随系统及自走车跟随方法利用设置于车体上的彩色影像深度摄影机获得彩色影像并利用设置于车体上的光学雷达获得二维信息,获得彩色影

像中的目标的三维坐标及二维信息中目标的二维坐标,并分别将三维坐标及二维坐标转换为第一球坐标及第二球坐标,再根据第一球坐标及第二球坐标产生目标的第三球坐标。最后,车体的车体控制器可根据第三球坐标控制车体来跟随目标。本发明的自走车跟随系统及自走车跟随方法以彩色影像深度摄影机增加目标可被辨识的特征来弥补光学雷达的点云图特征不足的问题,以在复杂的环境中可更准确地侦测目标。

附图说明

11.包含附图以便进一步理解本公开,且附图并入本说明书中并构成本说明书的一部分。附图说明本公开的实施例,并与描述一起用于解释本公开的原理。

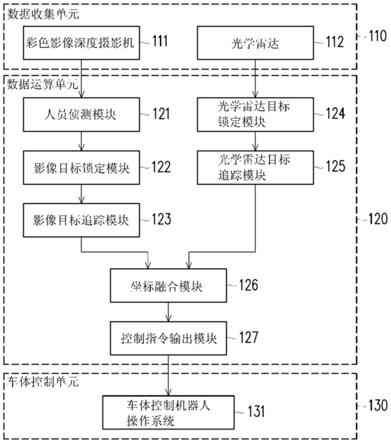

12.图1为根据本发明一实施例的自走车跟随系统的方块图;

13.图2为根据本发明一实施例的人员侦测模块的方块图;

14.图3为根据本发明一实施例的影像目标锁定模块的方块图;

15.图4为根据本发明一实施例的影像目标追踪模块的方块图;

16.图5为根据本发明一实施例的光学雷达目标锁定模块的方块图;

17.图6为根据本发明一实施例的光学雷达目标追踪模块的方块图;

18.图7为根据本发明一实施例的摄影机坐标系、光学雷达坐标系及车体坐标系的坐标关系的示意图;

19.图8为根据本发明一实施例的控制指令输出模块输出目标的第三球坐标的流程图。

20.附图标号说明

21.110:数据收集单元;

22.111:彩色影像深度摄影机;

23.112:光学雷达;

24.120:数据运算单元;

25.121:人员侦测模块;

26.122:影像目标锁定模块;

27.123:影像目标追踪模块;

28.124:光学雷达目标锁定模块;

29.125:光学雷达目标追踪模块;

30.126:坐标融合模块;

31.127:控制指令输出模块;

32.130:车体控制单元;

33.131:车体控制机器人操作系统;

34.210:彩色影像;

35.220:人员全身定界框坐标和框中影像;

36.230:深度学习对象侦测模型;

37.231:分类器;

38.232:卷积层;

39.233:人员侦测功能;

40.310:目标影像特征;

41.320:目标定界框;

42.s301~s303:步骤;

43.410:像素深度信息;

44.420:三维坐标;

45.s401~s403:步骤;

46.510:二维信息;

47.520:特征追踪器;

48.s501~s502:步骤;

49.610:二维坐标;

50.s601~s602:步骤;

51.710:车体坐标系;

52.720:摄影机坐标系;

53.730:光学雷达坐标系;

54.801:「a:基于彩色影像判断的第一球坐标(r1,θ1)」;

55.802:「b:基于光学雷达判断的第二球坐标(r2,θ2)」;

56.s810~s820:步骤。

具体实施方式

57.为使本发明的目的、技术方案和优点更加清楚明白,以下结合具体实施例,并参照附图,对本发明作进一步的详细说明。

58.本发明同时使用光学雷达(lidar)及视觉影像两种跟随方法,以互相弥补不足。具体来说,当目标被遮挡时,光学雷达无法判断目标物与障碍物的不同,易跟错目标。视觉影像储存了目标的颜色、形状、纹理等特征,供系统匹配,使跟随车不会误判目标,当障碍物移除后,仍可继续跟随正确的目标物。光学雷达所生成的点云图可获得目标与车体的距离和目标大致的形状大小,在追踪的过程中易与形状相近的障碍物混淆。视觉影像可储存目标物的色彩分布、形状、纹理等特征,使追踪目标的过程有更多信息可供判读。然而,视觉影像的视域范围较窄,当目标超出彩色影像深度(rgb-d)摄影机之视线范围时,易跟丢目标。光学雷达视域广,可继续追踪超出摄影机视域之目标物,使跟随自走车能继续追踪跟随。

59.图1为根据本发明一实施例的自走车跟随系统的方块图。

60.请参照图1,本发明一实施例的自走车跟随系统包括数据收集单元110、数据运算单元120及车体控制单元130。数据收集单元110包括设置于自走车车体上的彩色影像深度摄影机111及光学雷达112。彩色影像深度摄影机111可获得彩色影像。光学雷达112可获得例如点云图的二维信息。数据运算单元120可对彩色影像及二维信息进行运算以输出目标坐标让车体控制单元130的车体控制机器人操作系统(robot operating system,ros)131根据目标坐标控制车体来跟随目标。数据运算单元120包括人员侦测模块121、影像目标锁定模块122、影像目标追踪模块123、光学雷达目标锁定模块124、光学雷达目标追踪模块125、坐标融合模块126及控制指令输出模块127。在一实施例中,数据运算单元120可包括处理器并执行分别对应各模块(即,人员侦测模块121、影像目标锁定模块122、影像目标追踪

模块123、光学雷达目标锁定模块124、光学雷达目标追踪模块125、坐标融合模块126及控制指令输出模块127)的软件/固件程序代码。在另一实施例中,数据运算单元120的各模块可透过硬件电路来实作。在另一实施例中,数据运算单元120的各模块也可透过硬件电路及/或软件/固件程序代码的组合来实作。本发明不限制数据运算单元120的各模块的实作方式。数据运算单元120的各模块将在下文中详细说明。

61.在一实施例中,数据运算单元120可执行锁定目标人员程序或人员辨识追踪程序来进行彩色深度影像的目标锁定及追踪。锁定目标人员程序或人员辨识追踪程序都可利用深度学习方法取得目标人员影像或是取得影像中所有人的影像,再通过机器学习方法(例如,mobilenet-ssd v2 lite对象识别模型)执行分割影像并取得特征,例如将取得的人员影像分割成多个等份,并取得多等份的第一主成分当作此影像的特征。在执行锁定目标人员程序时,数据运算单元120储存这些特征。在执行人员辨识追踪的程序时,数据运算单元120可将锁定目标人员时所得到的特征做为目标特征输入,用以进行特征比对并取得目标位置,并依据辨识结果锁定目标与进行跟随。特征提取方法为例如是rgb直方图(histogram)。

62.另一方面,数据运算单元120还可执行光学雷达算法来进行光学雷达二维信息的目标锁定及追踪。光学雷达算法可透过二维光学雷达(lidar)经由光学传感器取得环境信息(例如,点云图)。这些信息为以光学雷达为中心,与周遭环境物体距离和角度信息的集合。为了避免因画面中对象大小的改变而跟丢,本发明可使用csrt追踪算法进行对象追踪。csrt追踪算法可使用具有通道及空间可靠度的判别相关滤波器(discriminative correlation filter with channel and spatial reliability,dcf-csr)算法来调整滤波器,确保对象被缩放时依旧能被追踪。csrt追踪算法可计算被选取区域的方向梯度直方图(histogram of oriented gradient,hog)特征及色彩名称(colornames)特征,与前一帧进行比对,以此判断对象当前的位置。

63.图2为根据本发明一实施例的人员侦测模块的方块图。

64.请参照图2,人员侦测模块121可接收彩色影像210的输入,将彩色影像210经过深度学习对象侦测模型230的分析,以输出人员全身定界框坐标和框中影像220。深度学习对象侦测模型230例如是单次多框侦测器(single shot multibox detector,ssd)。深度学习对象侦测模型230可经由分类器231接收彩色影像210再透过多个卷积层232进行特征提取后执行人员侦测功能233,最后输出人员全身定界框坐标和框中影像220。

65.图3为根据本发明一实施例的影像目标锁定模块的方块图。

66.请参照图3,影像目标锁定模块122会接收来自人员辨识模块121的人员定界框坐标和框中影像220,在彩色影像深度摄影机111的视域范围内,锁定面积最大的定界框为目标(s301)并忽略人员侦测模块121侦测到的其他非目标人员。接着,影像目标锁定模块122会针对面积最大的定界框提取影像特征并储存为目标影像特征(s302)以输出目标影像特征310,储存面积最大的定界框为目标影像定界框(s303)以输出目标定界框320(或称为第一目标定界框)。

67.图4为根据本发明一实施例的影像目标追踪模块的方块图。

68.请参照图4,影像目标追踪模块123可执行目标追踪模块执行影像目标追踪程序来接收目标影像特征310、目标定界框320及人员定界框坐标和框中影像220来计算人员定界

框与目标定界框的覆盖率(s401)。影像目标追踪模块123还将框中影像与目标影像特征310进行人员全身影像特征匹配(s402)。影像目标追踪模块123再接收彩色影像210的像素深度信息410来定位目标的三维中心位置(s403)以输出三维坐标420。举例来说,当目标定界框以(x1,y1,w1,h1)表示且人员定界框以(x2,y2,w2,h2)表示时,

[0069][0070]

其中x及y为定界框的基准坐标(例如,中心坐标或角落坐标),w及h分别为定界框的宽度及高度。

[0071]

图5为根据本发明一实施例的光学雷达目标锁定模块的方块图。

[0072]

请参照图5,光学雷达目标锁定模块124可接收光学雷达112的二维信息510(例如,二维点云图)以锁定预定坐标的定界框为目标定界框(或称为第二目标定界框)(s501),初始化特征追踪器(s502)并输出特征追踪器520。特征追踪器520例如是腿部特征追踪器。

[0073]

图6为根据本发明一实施例的光学雷达目标追踪模块的方块图。

[0074]

请参照图6,光学雷达目标追踪模块125可执行点云目标追踪程序来接收二维信息510及特征追踪器520并依据二维信息510与特征追踪器520来追踪目标(s601),并定位目标的二维中心位置(s602)以输出目标的二维坐标610。

[0075]

请再参考图1,坐标融合模块126舍弃摄影机坐标系的三维坐标420中对应高度的坐标值以将三维坐标420转换为对应车体的车体坐标系的第一坐标再将第一坐标转换为第一球坐标,并将光学雷达坐标系的二维坐标610转换为车体坐标系的第二坐标再将第二坐标转换为第二球坐标。以下将参考图7来说明摄影机坐标系及光学雷达坐标系分别转换为车体坐标系的转换流程。

[0076]

图7为根据本发明一实施例的摄影机坐标系、光学雷达坐标系及车体坐标系的坐标关系的示意图。

[0077]

请参照图7,车体是从车体坐标系710的角度来判断人员的位置,因此坐标融合模块126会将摄影机坐标系720及光学雷达坐标系730的资料转换到车体坐标系710来显示。

[0078]

举例来说,假设摄影机坐标系720的数据点坐标为pc=[x

c yc]r。若车体坐标系710与摄影机坐标系720之间存在旋转关系及平移关系则摄影机坐标系720的数据点在车体坐标系710的第一坐标为

[0079]

其中

[0080]

类似地,假设光学雷达坐标系730的数据点坐标为p

l

=[x

l y

l

]

t

。若车体坐标系710与光学雷达坐标系730之间存在旋转关系平移关系则光学雷达坐标系730的数据点在车体坐标系710的第二坐标为

[0081]

其中

[0082]

接着,坐标融合模块126可利用以下公式将第一坐标及第二坐标分别转换为第一球坐标及第二球坐标:

[0083][0084]

也就是将第一坐标及第二坐标的笛卡儿坐标(x,y)转换为第一球坐标及第二球坐标的极坐标(r,θ)。

[0085]

图8为根据本发明一实施例的控制指令输出模块输出目标的第三球坐标的流程图。

[0086]

请参照图8,「a:基于彩色影像判断的第一球坐标(r1,θ1)」801及「b:基于光学雷达判断的第二球坐标(r2,θ2)」802会被输入控制指令输出模块127来进行目标位置判断(s810)。若a及b皆有值(s811),且θ1及θ2相差大于门限值(s812),取a为第三球坐标(s813),因为彩色影像深度摄影机111在没跟丢目标时准确率比光学雷达112高。

[0087]

若a及b皆有值,且θ1及θ2相差小于等于门限值(s814),根据θ1及θ2的算术平均值及r1及r2较小者获得第三球坐标(s815),因为具有较小半径值的输出坐标离车体较近,有较大的可能性为要追踪的目标。

[0088]

若a及b其中之一为空值(s816),也就是从彩色影像深度摄影机111及光学雷达112的其中之一没有追踪到目标时,取a与b的有值者为第三球坐标(s817)。

[0089]

若a及b皆为空值(s818),则不输出第三球坐标(s819),并重新执行目标追踪程序(s820)。

[0090]

综上所述,本发明的自走车跟随系统及自走车跟随方法利用设置于车体上的彩色影像深度摄影机获得彩色影像并利用设置于车体上的光学雷达获得二维信息,获得彩色影像中的目标的三维坐标及二维信息中目标的二维坐标,并分别将三维坐标及二维坐标转换为第一球坐标及第二球坐标,再根据第一球坐标及第二球坐标产生目标的第三球坐标。最后,车体的车体控制器可根据第三球坐标控制车体来跟随目标。本发明的自走车跟随系统及自走车跟随方法以彩色影像深度摄影机增加目标可被辨识的特征来弥补光学雷达的点云图特征不足的问题,以在复杂的环境中可更准确地侦测目标。此外,系统也能记忆目标特征,即使目标被遮蔽也能继续跟随。

[0091]

最后应说明的是:以上各实施例仅用以说明本公开的技术方案,而非对其限制;尽管参照前述各实施例对本公开进行了详细的说明,本领域的普通技术人员应当理解:其依然可以对前述各实施例所记载的技术方案进行修改,或者对其中部分或者全部技术特征进行等同替换;而这些修改或者替换,并不使相应技术方案的本质脱离本公开各实施例技术方案的范围。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1