用于确定工业任务的AI模型的压缩率的方法和系统与流程

本发明涉及根据权利要求1的确定工业任务的ai模型的压缩率的方法、根据权利要求10的系统和根据权利要求11的计算机程序产品。

背景技术:

1、工业物联网的概念与基于ai的革命性解析技术一起可由以下语句来描述:给定生产地点、客户或自动化制造商安装工业装备,其中可能利用不同传感器收集不同类型的数据。收集的数据通过有线或无线连接传输以用于进一步分析。数据的分析是利用传统方法或ai方法来执行的。数据分析可以在云上进行,或者利用所谓的边缘设备或其他计算设备上的部署模型(ai模型)现场进行。基于数据分析的结果,客户或自动化制造商本身可以执行商业/生产过程的优化,以降低生产成本、电力消耗、资源使用,并且因此降低对全球气候变化的总体贡献。

2、ai模型在工业边缘设备、工业控制器(例如,plc-可编程逻辑控制器)上执行,或者甚至在基于云的计算实体(所谓的“web服务”或“云托管”)上执行。

3、挑战在于,ai模型工作得越精确,它需要越多的资源(存储器空间、计算时间等)。另一方面,在现有环境中,计算能力(“cpu时间”)是有限的。此外,在大多数情况下,ai模型的响应是在有限的时间范围内,因此最大响应时间或“推断时间”是有限的。ai模型可以被压缩,例如在减少其参数方面,以便加速和减少存储器分配或其他资源消耗。然而,这种压缩降低了ai模型预测的准确度。

4、文献cn110163341a“神经网络模型优化处理的方法和设备”公开了一种深度神经网络的压缩方法。

5、如上所表述,如何执行优化的一种方法是,与适当的ai模型一起,找到如何优化该ai模型的方式,以便将其部署在边缘设备或诸如工业控制器的另一个执行环境上,使得其将尽可能精确和高效地运行,目的在于减少计算工作量并降低总功耗。

技术实现思路

1、因此,本发明的任务是提出一种用于选择应在工业环境中部署的ai模型的最优压缩率的方法和推荐系统。

2、该任务的解决方案考虑工业环境要求、边缘设备(或其他执行环境)本身的硬件资源和解析项目(“工业任务”)描述中的ai模型所指定的要求。

3、当为ai模型选择压缩率时,我们面临折衷使得更高的压缩率将节省更多的存储器空间并提高预测速度,但ai模型准确度却有更大的降低。类似地,较低的压缩率将具有相反的效果。本发明的核心是应用来自运筹学(英语:operation research)领域的数学方法来处理这种折衷。它提供了使ai模型预测准确度最大化的压缩率,同时满足了空间存储的限制和预测速度(推断时间)的要求。当然,诸如部署时间等的其他标准或“特征”也可以是优化问题的一部分。

4、在独立权利要求中限定了该优化问题的解决方案。

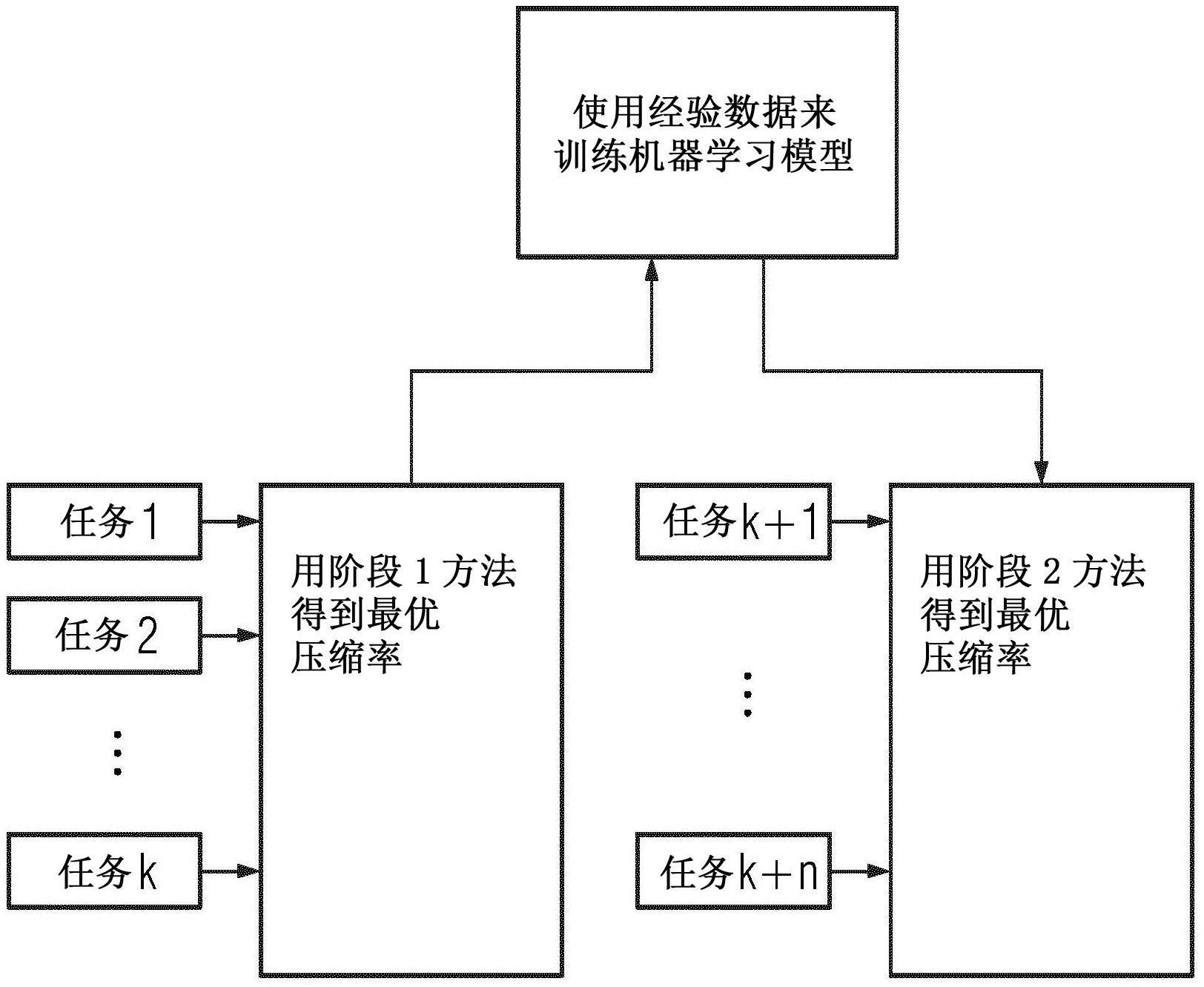

5、该问题通过一种根据工业任务的ai模型的运行时属性的要求集合来确定该ai模型的压缩率的方法来解决,其中对于该ai模型,将原始的参数数量缩减到减少的参数数量。在该方法的第一阶段中,对于多个工业任务的多个不同ai模型,为每个工业任务确定被分配的ai模型的多个不同压缩率。此后,在第一步骤中,用该多个不同压缩率对每个ai模型压缩多次。在第二步骤中,在执行环境中执行每个被压缩的ai模型,其中作为在每个ai模型的执行期间的第一结果,记录运行时属性,并且其中在第三步骤中,通过对第一结果的解析分析来计算每个ai模型的最优压缩率,其中将每个工业任务的最优压缩率与工业任务的描述一起存储在数据库或类似的存储技术中。在该方法的第二阶段中,来自数据库的数据被用于训练附加机器学习模型,该附加机器学习模型具有关于工业任务中的每一者的特征信息作为输入以及所计算的最优压缩率作为输出,该特征信息至少包括关于存储器分配限制、被压缩的模型的推断时限、未压缩的ai模型的原始ai模型大小以及所使用的压缩算法的信息,并且在第三阶段中,对于新工业任务的新ai模型,定义期望运行时属性的新集合,并且执行附加机器学习模型并将其用于确定该新ai模型关于期望运行时属性的最优压缩率。然后,根据该最优压缩率来压缩新ai模型,并执行该新ai模型以完成新的工业任务。使用该方法,ai模型以最好的可能准确度运行,同时满足推断时间的要求并且不超过允许的或给定的计算资源和要求。

6、该问题还通过一种根据工业任务的ai模型的运行时属性的要求集合来确定该ai模型的压缩率的系统来解决,其中对于ai模型,将原始的参数数量缩减到减少的参数数量。该系统包括第一计算机系统,其被设置用于执行前述方法的第一阶段的步骤,并且用于在执行被压缩的ai模型时控制执行环境。该系统还包括第二计算机系统,其被设置用于执行如前所述的方法的第二阶段和第三阶段的方法步骤,以及连接第一计算机系统和第二计算机系统的通信信道。该系统可以实现如结合本发明的方法所描述的优点。

7、本发明的有利实施例在从属方法权利要求中公开。这些实施例的特征和它们的优点也以类似的方式适用于本发明的系统。可以组合各种实施例的特征。

8、在一个实施例中,在第一步骤中,对于每个压缩率,创建并执行压缩的ai模型。多种压缩率可覆盖宽范围的压缩,但在子步骤中是不同的,因为其具有第三步骤中解析分析的精确基础。

9、在大多数情况下,至少使用所执行的ai模型的存储器消耗和推断时间作为运行时属性可能是适当的。在大多数情况下,最大推断时间的要求由工业任务的使用情况给出,并且在大多数情况下,存储器消耗仅取决于给定的执行环境(计算设备)。因此,对于系统工程师来说,容易提供这些属性参数。

10、在一个重要的实施例中,在第三步骤中,最优压缩率是具有最优推断准确度的压缩率,其仍然符合运行时属性的要求。这产生其中给定计算能力被最大限度地使用的系统。

11、在第三步骤中,对于每个ai任务,通过所记录的运行时属性来拟合线性或非线性函数。这可以通过已知的软件来完成,并且不需要用户输入。线性或非线性函数可以包括插值法,例如线性插值法或样条插值法,但不限于这些。

12、在第二阶段和第三阶段中,每个工业任务的特征信息至少包括:关于存储器分配限制、压缩模型的推断时限、未压缩的ai模型的原始ai模型大小以及用于该特定任务的压缩算法的类型的信息。

13、使用工业边缘设备来执行ai模型是有利的,因为边缘设备向工业车间提供计算能力,从而使控制器(plc-可编程逻辑控制器)免于耗时的计算,即运行ai模型。在其他情况下,它可以是眼前不同的设备,尤其是可以是工业控制器的一部分的神经处理单元(所谓的用于神经处理的技术模块)。

14、在一个实施例中,可以在不同的平台(执行环境)上执行第一阶段中的ai任务,从而返回这些环境中的每一者的最优压缩率。在其它情况下,为了减少第一阶段中的“测试”-执行的次数,可以使用经验资源使用因素。这意味着,一旦确定了第一类型平台上的运行时属性,就可以通过使用经验因素来估计具有相同压缩率但在不同平台(执行环境)上的相同ai任务的运行时属性。

15、另一有利的实施例使用仿真设备来进行第一阶段测试系列。这意味着,例如,plc或神经处理单元或另一类型的执行环境可以用标准硬件、例如个人计算机或虚拟机器来模拟(“仿真”)。

16、在一些实施例中,第一阶段中的“目标”是云计算服务(ccs)。云计算服务可以递送虚拟的无限计算资源,尤其是在其中需要在本地实体(如plc)与云计算服务之间交换有限数量的参数的情况下,云计算服务执行ai模型。

- 还没有人留言评论。精彩留言会获得点赞!