基于离线增量学习的自动驾驶汽车路径规划方法及系统

文档序号:29964122发布日期:2022-05-11 09:51阅读:259来源:国知局

导航: X技术> 最新专利>控制;调节装置的制造及其应用技术

1.本发明属于自动驾驶汽车路径规划领域,更具体地,涉及一种基于离线增量学习的自动驾驶汽车路径规划方法及系统。

背景技术:

2.尽管交通系统已经发展了几十年,但交通事故仍然是全世界的首要死因。自动驾驶技术有望减少事故,自动驾驶系统可以代替人类驾驶员,根据路况和车辆状态自主控制运动。自动驾驶的一项基本任务是在存在众多静态和移动障碍物的情况下规划无碰撞运动。避障的主要技术包括路径规划、决策和路径跟踪。路径规划模型旨在生成参考路径,避开障碍物,满足道路安全规则和车辆运动学约束的要求。

3.车辆行驶路径规划旨在设计一种轨迹规划算法,它基于车辆动力学并受车辆运动学极限的约束,同时可以避免行驶环境中的障碍物。在此基础上,通过某个优化准则(如规划路径最短、所需的时间最短、耗能最少等),为车辆选择一条最优的行驶路径。基于节点采样的快速扩展随机树(rapidly-exploring random tree,rrt)的路径规划框架结合了采样效率、转向功能和路径平滑度,能够找到满足运动动力学约束的平滑且无碰撞的路径,适合解决复杂约束下的路径规划问题。其主要思想是使用控制理论以增量的方式搜索生成类似于树状的轨迹曲线,使得车辆能够顺利到达目标点。但是,rrt算法只关注于快速的轨迹规划,无法根据指定的标准有效且快速的获得最佳的轨迹规划方案。因此需要研究高效的车辆避障行驶轨迹规划方法。

技术实现要素:

4.针对现有技术的缺陷,本发明的目的在于提供一种基于离线增量学习的自动驾驶汽车路径规划方法及系统,旨在解决现有技术无法根据指定的标准有效且快速的获得最佳的汽车轨迹规划方案的问题。

5.为实现上述目的,本发明提供了一种基于离线增量学习的自动驾驶汽车路径规划方法,包括如下步骤:

6.确定汽车的当前状态变量和目标信息;所述当前状态变量包括:汽车的位置、速度、加速度以及偏航速度;所述目标信息为汽车行驶目的地的区域范围信息;

7.利用基于车辆运动学的概率路径预测模型实时预测汽车下一时刻的状态变量,以规划汽车的短期路径;

8.基于二维地图信息构建人工势场,以为二维地图上不同类型的障碍物和道路结构分配不同的势函数,使得障碍物周围与道路边缘形成排斥势场,中间目标处周围形成引力势场;所述中间目标指的是汽车行驶路径中的位置点;

9.通过线性二次调节(linear quadratic regulation,lqr)策略获取汽车行驶路径的离线数据,并利用径向基函数(radial basis function,rbf)神经网络对所述离线数据进行训练,以对汽车行驶路径的行驶距离进行预测;

10.基于离线学习的快速扩展随机路径规划算法对汽车行驶的长期路径进行规划,并结合所述行驶距离的预测结果确定汽车自动驾驶的最优避障路径;其中,将所述汽车短期路径作为长期路径规划的采样指导,将所述人工势场作为长期路径规划的方向约束。

11.在一个可选的实施例中,所述利用基于车辆运动学的概率路径预测模型实时预测汽车下一时刻的状态变量具体为:

12.x(k+1)=ax(k)+bu(k)+q(k)

13.y(k)=cx(k)+r(k)

14.其中k∈[ki,kf],k表示采样时刻,ki表示开始采样时刻,kf表示结束采样时刻;是车辆当前状态变量,其包含n个状态向量,是下个采样时刻的车辆的状态变量,表示车辆的控制输入变量,是p个车辆传感器的测量输出,是高斯噪声,是观测噪声,a,b,c分别表示状态转移矩阵、输入矩阵和测量矩阵;

[0015]

x(k+δk)=δρ(k)+x(k)

[0016][0017]

其中,x(k)=(xv,yv,θ,ω,v,a),xv与yv表示车辆的横向位置与纵向位置,v与a表示车辆的速度与加速度,θ表示转向角,ω表示角速度,δk表示采样时间间隔,δρ(k)表示车辆的状态转移矩阵;x(k+δk)是预测的车辆下一个采样间隔的状态变量。

[0018]

在一个可选的实施例中,所述基于二维地图信息构建人工势场,以为二维地图上不同类型的障碍物和道路结构分配不同的势函数,具体为:

[0019]

障碍物的斥力势场p

ov

(xv,yv)为:

[0020][0021]

其中,po是障碍物产生的势场的最大振幅,δ1与δ2的取值范围为(0,1),共同决定势场电位上升与下降的速率,(xv,yv)与(xo,yo)分别表示车辆与障碍物的坐标;

[0022]

车辆行驶路径势场p

lane

(xv,yv)为:

[0023]

其中,a

lane

是道路中心线的最大振幅,d

safe

是确保安全的最短制动距离,lw是道路

总宽度,a

x

和ay表示中间变量;

[0024]

道路势场p

road

(xv,yv)为:p

road

(xv,yv)=ln(1-|sin((xvπ)/l

w-π/2|);

[0025]

总势场力为:

[0026]

其中,pu(xv,yv)表示总的势函数,所述总势场力用于引导车辆到朝向目的地的最陡下降方向行径。

[0027]

在一个可选的实施例中,所述通过线性二次调节策略获取汽车行驶路径的离线数据,并利用径向基函数神经网络对所述离线数据进行训练,以对汽车行驶路径的行驶距离进行预测,具体为:

[0028]

建立基于二次调节策略的二次代价函数度量距离,通过最小化车辆的状态误差来计算采样点之间的距离;

[0029][0030]

其中,j表示二次代价函数,x

init

与xf是初始地的汽车状态变量与目标地的汽车状态变量,q与qf是半正定权重矩阵,r是正定权重矩阵,xi,ui(i∈{0,

…

,f-1})分别表示采样点的汽车状态变量与控制输入变量,f表示采样点总个数;

[0031]

构建标准的线性优化控制模型,从而计算代价函数cost;在基于线性二次调节策略的最优距离计算过程中,需要改变权重矩阵q、qf与r,并进行多次迭代,生成合适的距离度量:

[0032][0033][0034]

方程系数和权值的更新如下:

[0035][0036][0037][0038]

式中,以及均为中间变量;

[0039]

通过线性二次调节策略得到代价函数cost(x

init

,xf)和增益矩阵k的局部最优解:

[0040][0041]

其中s=cost(x

init

,xf);

[0042]

设计径向基函数神经网络来提高计算效率,利用线性二次调节策略获得的离线训练数据学习成本函数的最优估计;

[0043]

[0044]

yk=cost(x

ni

,x

nf

)

[0045]

其中dis_e(x

ki

,x

kf

)是样本点x

ki

到样本点x

kf

的欧几里得距离;yk表示估计的样本点x

ki

到样本点x

kf

的行驶距离;

[0046]

由于车辆运动轨迹的非完整性约束,采用dubins距离dis_d来衡量状态点的相似度;dubins距离度量受最大曲率曲线的约束,以曲线路径的形式测量指定初始位置到目标位置的距离;此时,径向基函数神经网络的期望输出表示为:

[0047]

φ

jk

=exp(-dis_d(xk,x

cj

)/(2η2))1≤k≤n

[0048][0049]

其中m是隐藏节点的数目,φ

jk

是第j个隐藏神经元的基函数,x

cj

是中心向量,dis_d(xk,x

cj

)表示样本节点和中心节点之间的dubins距离,η决定隐藏神经元的宽度,是径向基函数神经网络的实际输出,ek是建模误差,ωj是隐藏层和输出层之间的权重;

[0050]

由此,径向基函数神经网络的输出表示为:

[0051]

y=φw+e

[0052]

其中y=[y1,

…

,yn]

t

是期望输出向量,φ=[φ1,

…

,φm]

t

是回归矩阵,φi=[φ

i1

,

…

,φ

in

]

t

,w=[ω1,

…

,ωm]

t

是权重向量,e=[e1,

…

,em]

t

是误差矩阵。

[0053]

在一个可选的实施例中,所述并利用径向基函数神经网络对所述离线数据进行训练,以对汽车行驶路径的行驶距离进行预测,具体包括如下步骤:

[0054]

(1)网络参数的初始化:隐藏节点的数目m,迭代终止阈值ε,距离度量阈值gj(j∈{1,2,

…

,m});

[0055]

(2)中心向量xc=[x

c1

,

…

,x

cm

]

t

,x

cji

=minxi+(maxx

i-minxi)/(2m)+(j-1)(maxx

i-minxi)/m;其中i∈{1,2},j∈{1,2,

…

,m},x

cj1

,x

cj2

是中心x

cj

的特征,min xi,max xi分别是输入向量的第i个特征的最小值和最大值;

[0056]

(3)从隐藏层到输出层的权重向量wj=[ω

j1

,

…

,ω

jm

]

t

(j∈{1,2,

…

,m}),其中ω

jk

=exp(-0.5(x

k-x

cj

)

tgj

(x

k-x

cj

));

[0057]

(4)令若rms≤0,则训练结束,得到了行驶距离否则跳转步骤(5);

[0058]

(5)执行基于正则化正交最小二乘法的中心向量选择方法,逐个选择m个中心xc的子集,选择一个满足终止准则的候选中心:[err]j(j∈{1,2,

…

,m})为迭代误差减小率;

[0059]

(6)用梯度下降法逼近权矩阵w=[ω

jk

]

mn

的最优值,然后转到步骤(4)。

[0060]

在一个可选的实施例中,所述基于离线学习的快速扩展随机路径规划算法对汽车行驶的长期路径进行规划,具体包括如下步骤:

[0061]

1)对随机树t进行扩展,随机树t将作为起始点,将x

goal

作为目标点;并将作为本次扩展的父节点;

[0062]

2)依据采样约束函数sample_apf生成随机状态点然后利用函数nearest找到与最近的节点作为父节点

[0063]

3)以为中心rn为半径,在树t上搜索满足apf约束的节点作为子节点的潜在父亲节点比较作为父亲节点的轨迹p1的成本cost1与作为父亲节点的轨迹p2的成本cost2,当p2无碰撞(满足obstaclefree函数)并且cost2《cost1时,将的父亲节点改为添加新的边,然后删掉树t上之前的父亲节点与子节点之间的边;

[0064]

4)遍历所有潜在的父节点,得到更新后的树t。

[0065]

第二方面,本发明提供了一种基于离线增量学习的自动驾驶汽车路径规划系统,包括:

[0066]

汽车信息获取单元,用于确定汽车的当前状态变量和目标信息;所述当前状态变量包括:汽车的位置、速度、加速度以及偏航速度;所述目标信息为汽车行驶目的地的区域范围信息;

[0067]

短期路径规划单元,用于利用基于车辆运动学的概率路径预测模型实时预测汽车下一时刻的状态变量,以规划汽车的短期路径;

[0068]

人工势场构建单元,用于基于二维地图信息构建人工势场,以为二维地图上不同类型的障碍物和道路结构分配不同的势函数,使得障碍物周围与道路边缘形成排斥势场,中间目标处周围形成引力势场;所述中间目标指的是汽车行驶路径中的位置点;

[0069]

行驶距离预测单元,用于通过线性二次调节策略获取汽车行驶路径的离线数据,并利用径向基函数神经网络对所述离线数据进行训练,以对汽车行驶路径的行驶距离进行预测;

[0070]

长期路径规划单元,用于基于离线学习的快速扩展随机路径规划算法对汽车行驶的长期路径进行规划,并结合所述行驶距离的预测结果确定汽车自动驾驶的最优避障路径;其中,将所述汽车短期路径作为长期路径规划的采样指导,将所述人工势场作为长期路径规划的方向约束。

[0071]

在一个可选的实施例中,所述短期路径规划单元利用基于车辆运动学的概率路径预测模型实时预测汽车下一时刻的状态变量具体为:

[0072]

x(k+1)=ax(k)+bu(k)+q(k)

[0073]

y(k)=cx(k)+r(k)

[0074]

其中k∈[ki,kf],k表示采样时刻,ki表示开始采样时刻,kf表示结束采样时刻;是车辆当前状态变量,其包含n个状态向量,是下个采样时刻的车辆的状态变量,表示车辆的控制输入变量,是p个车辆传感器的测量输出,是高斯噪声,是观测噪声,a,b,c分别表示状态转移矩阵、输入矩阵和测量矩阵;

[0075]

x(k+δk)=δρ(k)+x(k)

[0076][0077]

其中,x(k)=(xv,yv,θ,ω,v,a),xv与yv表示车辆的横向位置与纵向位置,v与a表示车辆的速度与加速度,θ表示转向角,ω表示角速度,δk表示采样时间间隔,δρ(k)表示车辆的状态转移矩阵;x(k+δk)是预测的车辆下一个采样间隔的状态变量。

[0078]

在一个可选的实施例中,所述人工势场构建单元构建的势场具体包括:

[0079]

障碍物的斥力势场p

ov

(xv,yv)为:

[0080][0081]

其中,po是障碍物产生的势场的最大振幅,δ1与δ2的取值范围为(0,1),共同决定势场电位上升与下降的速率,(xv,yv)与(xo,yo)分别表示车辆与障碍物的坐标;

[0082]

车辆行驶路径势场p

lane

(xv,yv)为:

[0083]

其中,a

lane

是道路中心线的最大振幅,d

safe

是确保安全的最短制动距离,lw是道路总宽度,a

x

和ay表示中间变量;

[0084]

道路势场p

road

(xv,yv)为:p

road

(xv,yv)=ln(1-|sin((xvπ)/l

w-π/2|);

[0085]

总势场力为:

[0086]

其中,pu(xv,yv)表示总的势函数,所述总势场力用于引导车辆到朝向目的地的最陡下降方向行径。

[0087]

在一个可选的实施例中,所述行驶距离预测单元通过线性二次调节策略获取汽车行驶路径的离线数据,并利用径向基函数神经网络对所述离线数据进行训练,以对汽车行驶路径的行驶距离进行预测,具体为:

[0088]

建立基于二次调节策略的二次代价函数度量距离,通过最小化车辆的状态误差来计算采样点之间的距离;

[0089][0090]

其中,j表示二次代价函数,x

init

与xf是初始地的汽车状态变量与目标地的汽车状

态变量,q与qf是半正定权重矩阵,r是正定权重矩阵,xi,ui(i∈{0,

…

,f-1})分别表示采样点的汽车状态变量与控制输入变量,f表示采样点总个数;

[0091]

构建标准的线性优化控制模型,从而计算代价函数cost;在基于线性二次调节策略的最优距离计算过程中,需要改变权重矩阵q、qf与r,并进行多次迭代,生成合适的距离度量:

[0092][0093][0094]

方程系数和权值的更新如下:

[0095][0096][0097][0098]

式中,以及均为中间变量;

[0099]

通过线性二次调节策略得到代价函数cost(x

init

,xf)和增益矩阵k的局部最优解:

[0100][0101]

其中s=cost(x

init

,xf);

[0102]

设计径向基函数神经网络来提高计算效率,利用线性二次调节策略获得的离线训练数据学习成本函数的最优估计;

[0103][0104]

yk=cost(x

ni

,x

nf

)

[0105]

其中dis_e(x

ki

,x

kf

)是样本点x

ki

到样本点x

kf

的欧几里得距离;yk表示估计的样本点x

ki

到样本点x

kf

的行驶距离;

[0106]

由于车辆运动轨迹的非完整性约束,采用dubins距离dis_d来衡量状态点的相似度;dubins距离度量受最大曲率曲线的约束,以曲线路径的形式测量指定初始位置到目标位置的距离;此时,径向基函数神经网络的期望输出表示为:

[0107]

φ

jk

=exp(-dis_d(xk,x

cj

)/(2η2))1≤k≤n

[0108][0109]

其中m是隐藏节点的数目,φ

jk

是第j个隐藏神经元的基函数,x

cj

是中心向量,dis_d(xk,x

cj

)表示样本节点和中心节点之间的dubins距离,η决定隐藏神经元的宽度,是径向基函数神经网络的实际输出,ek是建模误差,ωj是隐藏层和输出层之间的权重;

[0110]

由此,径向基函数神经网络的输出表示为:

[0111]

y=φw+e

[0112]

其中y=[y1,

…

,yn]

t

是期望输出向量,φ=[φ1,

…

,φm]

t

是回归矩阵,φi=

[φ

i1

,

…

,φ

in

]

t

,w=[ω1,

…

,ωm]

t

是权重向量,e=[e1,

…

,em]

t

是误差矩阵。

[0113]

总体而言,通过本发明所构思的以上技术方案与现有技术相比,具有以下有益效果:

[0114]

本发明结合基于车辆运动学的短期规划方法和基于行为认知的长期路径规划方法,能够在交通规则、道路边界和车辆运动学的约束下高效准确地实现车辆轨迹预测。

[0115]

本发明利用短期轨迹预测和人工势场策略限制采样过程,加快了路径生成速率。

[0116]

为了克服车辆运动学系统的复杂性和非线性约束问题,本发明使用lqr策略度量车辆距离,使得运用于智能车辆路径规划的rrt算法距离度量更加合理。同时,本发明利用深度学习技术对使用lqr策略得到的距离度量数据进行线下训练,然后将其运用于距离预测,规避了精确求解带来的计算开销。

附图说明

[0117]

图1是本发明实施例提供的基于离线增量学习的自动驾驶汽车路径规划方法流程图;

[0118]

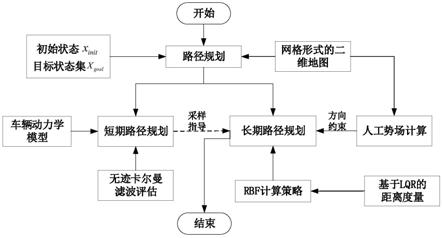

图2是本发明实施例提供的自动驾驶汽车路径规划方法的工作流程框图;

[0119]

图3是本发明实施例提供的基于离线增量学习的快速扩展随机树轨迹规划流程框图;

[0120]

图4是本发明实施例提供的基于离线增量学习的自动驾驶汽车路径规划系统架构图。

具体实施方式

[0121]

为了使本发明的目的、技术方案及优点更加清楚明白,以下结合附图及实施例,对本发明进行进一步详细说明。应当理解,此处所描述的具体实施例仅用以解释本发明,并不用于限定本发明。

[0122]

针对车辆初始状态、传感器测量、定位和机动性等方面的不确定性,提出了基于安全的短期规划和基于效率的长期规划相结合的轨迹预测方法。短期规划主要考虑了初始状态引起的轨迹预测的不确定性,如定位的感知误差,以及运动学的不确定性,使轨迹规划方法在短期内避免了极端情况。以有效性为导向的长期预测考虑了长期的行驶目标,避免了过于保守的计划。鉴于此,本发明的目的是建立一种结合基于车辆运动学的短期规划和基于行为认知的长期路径规划的综合方法,能够在交通规则、道路边界和车辆运动学的约束下高效准确地实现车辆轨迹预测。基于车辆运动学的轨迹预测方法在考虑车辆运行动态参数的同时,能够保证短期精度,而基于行为认知的轨迹预测方法对未来的行为轨迹具有长期的洞察力。本发明利用基于车辆运动学的运动模型来预测车辆短期内的理想路径,并指导长期路径规划的采样过程。在长期路径规划中,本发明采用基于离线增量学习的快速扩展随机树方法生成渐进最优路径。

[0123]

本发明要解决的技术问题就在于:针对现有基于快速扩展随机树的路径规划技术存在的技术问题,本发明提供一种具有较高效率和准确度的自动驾驶汽车路径预测方法来避免碰撞。

[0124]

为达到上述目的,本发明的技术方案如下:基于离线增量学习的自动驾驶汽车路

径规划方法,该方法包括如下步骤:

[0125]

步骤一:短期路径预测,利用基于车辆运动学的概率路径预测模型,实时预测车辆的状态变量,如位置、速度、加速度、偏航速度等。

[0126]

步骤二:构建人工势场,为不同类型的障碍物和道路结构分配不同的势函数,并为障碍物生成排斥势场,为目标生成引力势场。

[0127]

步骤三:利用径向基函数神经网络方法线下训练通过线性二次调节策略获得的离线数据,然后应用于智能车辆路径规划算法的距离预测。

[0128]

步骤四:依据基于离线增量学习的快速扩展随机树轨迹规划算法,得到渐进最优的避障路径。

[0129]

所述的自动驾驶汽车路径规划方法综合基于车辆运动学的短期规划和基于行为认知的长期路径规划,利用短期轨迹预测模型和人工势场技术来指导长期路径规划的采样过程。

[0130]

所述步骤一中基于车辆运动学的轨迹预测主要包括两个阶段:车辆运动模型评估阶段和车辆行驶轨迹预测阶段。

[0131]

所述步骤一中车辆动力学控制模型如下:

[0132]

σ:x(k+1)=ax(k)+bu(k)+q(k)

[0133]

y(k)=cx(k)+r(k)

[0134]

其中k∈[ki,kf],是车辆当前状态包含n个状态向量,是下个采样时刻的系统状态,表示控制输入,是p个传感器的测量输出,是高斯噪声,是观测噪声,a,b,c分别表示状态转移矩阵、输入矩阵和测量矩阵。

[0135]

所述步骤一中基于车辆运动学轨迹预测的车辆运动模型如下:x(k+δk)=δρ(k)+x(k)

[0136][0137]

其中x(k)=(xv,yv,θ,ω,v,a)是车辆的状态,xv与yv表示横向位置与纵向位置,v与a表示速度与加速度,δk表示采样时间间隔,δρ(k)表示状态转移矩阵。

[0138]

所述步骤一中的短期路径规划采用无迹卡尔曼滤波器来处理车辆运动模型中的不确定性,从而进行短期轨迹预测,具体过程如下:

[0139]

1)无迹变换,先生成2n+1个sigma点来表示当前的分布(n表示状态数),并通过非线性转化将这些点转化为新的点函数。

[0140]

2)使用新的sigma点计算高斯分布,依据每个sigma点的权重,得到预测的新分布的均值和协方差。

[0141]

3)利用非线性函数h(

·

)将预测状态转换为测量状态,并利用预测状态与测量状态来获得卡尔曼增益k

k+1|k

和状态空间与测量空间的互相关函数t

k+1|k

,最终预测状态x

k+1|k+1

和协方差p

k+1|k+1

计算如下:

[0142][0143][0144]

x

k+1|k+1

=x

k+1|k

+k

k+1|k

(z

k+1-z

k+1|k

)

[0145][0146]

所述步骤二中势场构建的过程为:

[0147]

1)障碍物的斥力势场p

ov

(xv,yv)

[0148]

障碍物势场旨在通过建立一个靠近车辆的排斥力为无限的势场,使车辆与每个障碍物保持安全距离。

[0149][0150]

其中po是障碍物产生的势场的最大振幅,δ1与δ2决定电位上升与下降的速率。

[0151]

2)车道势场p

lane

(xv,yv)

[0152]

车道势场引导车辆进入中心车道,同时车道势场很小,使得在换道避撞场景下可以轻易克服。

[0153]

p

lane

(xv,yv)=a

xay

[0154]ax

=a

lane

cos(xv/lw)

[0155][0156]

其中a

lane

是道路中心线的最大振幅,d

safe

是确保安全的最短制动距离,lw是道路总宽度。

[0157]

3)道路势场p

road

(xv,yv)

[0158]

道路势场通过在道路边缘变得无限大来阻止车辆离开高速公路。

[0159]

p

road

(xv,yv)=ln(1-|sin((xvπ)/l

w-π/2|)

[0160]

4)总势场力

[0161]

总势函数的负梯度称为势感力,是引导车辆到达目的地的最陡下降方向,总势场力定义为:

[0162][0163]

基于人工势场约束的搜索策略有助于加快路径生成算法收敛至一阶解和渐进最

优解的速度。

[0164]

所述步骤三中距离的最优估计,步骤如下:

[0165]

1)建立基于lqr的二次代价函数度量距离,通过最小化车辆的状态误差来计算采样点之间的距离。作为“距离”的度量,代价函数对采样点搜索的性能起着至关重要的作用,即高代价的采样点与低代价的采样点离目标的距离更远。

[0166][0167]

其中x

init

与xf是初始系统状态与目标系统状态,q与qf是半正定权重矩阵,r是正定权重矩阵,xi(i∈{0,

…

,f-1})是采样点的状态。

[0168]

2)构建标准的线性优化控制模型,从而计算代价函数cost。在基于lqr的最优距离计算过程中,需要改变权值矩阵q、qf与r,并进行多次迭代,生成合适的距离度量。

[0169][0170][0171]

方程系数和权值的更新如下:

[0172][0173][0174][0175]

最终,通过lqr策略得到代价函数cost(x

init

,xf)和增益矩阵k的局部最优解。

[0176][0177]

其中s=cost(x

init

,xf),lqr函数的计算结果由matlab提供。

[0178]

3)设计径向基神经网络算法来提高计算效率,利用lqr策略获得的离线训练数据学习成本函数的最优估计。

[0179][0180]

yk=cost(x

ni

,x

nf

)

[0181]

其中dis_e(x

ki

,x

kf

)是样本点x

ki

到样本点x

kf

的欧几里得距离。

[0182]

神经网络的输出表示为:

[0183]

y=φw+e

[0184]

其中y=[y1,

…

,yn]

t

是期望输出向量,φ=[φ1,

…

,φm]

t

是回归矩阵,φi=[φ

i1

,

…

,φ

in

]

t

,w=[ω1,

…

,ωm]

t

是权重向量,e=[e1,

…

,em]

t

是误差矩阵。

[0185]

基于径向基神经网络的成本计算方法的详细步骤为:

[0186]

(1)网络参数的初始化:隐藏节点的数目m,迭代终止阈值ε,距离度量阈值gj(j∈{1,2,

…

,m});

[0187]

(2)中心向量xc=[x

c1

,

…

,x

cm

]

t

,x

cji

=minxi+(maxx

i-minxi)/(2m)+(j-1)(maxx

i-minxi)/m;其中i∈{1,2},j∈{1,2,

…

,m},x

cj1

,x

cj2

是中心x

cj

的特征,min xi,max xi分别是

输入向量的第i个特征的最小值和最大值;

[0188]

(3)从隐藏层到输出层的权重向量wj=[ω

j1

,

…

,ω

jm

]

t

(j∈{1,2,

…

,m}),其中ω

jk

=exp(-0.5(x

k-x

cj

)

tgj

(x

k-x

cj

));

[0189]

(4)令若rms≤0,则训练结束,得到了行驶距离否则跳转步骤(5);

[0190]

(5)执行基于正则化正交最小二乘法的中心向量选择方法,逐个选择m个中心xc的子集,选择一个满足终止准则的候选中心:[err]j(j∈{1,2,

…

,m})为迭代误差减小率;

[0191]

(6)用梯度下降法逼近权矩阵w=[ω

jk

]

mn

的最优值,然后转到步骤(4)。

[0192]

所述步骤四中基于离线增量学习的快速扩展随机树轨迹规划算法,步骤如下:

[0193]

1)对随机树t进行扩展,随机树t将作为起始点,将x

goal

作为目标点;并将作为本次扩展的父节点;

[0194]

2)依据采样约束函数sample_apf生成随机状态点然后利用函数nearest找到与最近的节点作为父节点

[0195]

3)以为中心rn为半径,在树t上搜索满足apf约束的节点作为子节点的潜在父亲节点比较作为父亲节点的轨迹(p1)成本cost1与作为父亲节点的轨迹(p2)成本cost2,当p2无碰撞(满足obstaclefree函数)并且cost2《cost1时,将的父亲节点改为添加新的边,然后删掉树t上之前的父亲节点与子节点之间的边;

[0196]

4)遍历所有潜在的父节点,得到更新后的树t。

[0197]

本发明提出了一种基于离线增量学学习的自动驾驶汽车路径规划方法,在rrt算法的基础上规划出更优的避障路径。采用的技术方案为:在rrt算法的基础上加入短期轨迹预测技术与人工势场策略限制采样过程,达到提高算法收敛至一阶解和渐进最优解的速度的目的;再利用lqr策略度量车辆距离,使得运用于智能车辆路径规划的rrt算法的距离度量更加合理;接着,使用径向基函数神经网络方法线下训练通过lqr策略获得的离线数据,然后应用于智能车辆路径规划算法的距离预测,规避了精确求解带来的计算开销。

[0198]

图1是本发明实施例提供的基于离线增量学习的自动驾驶汽车路径规划方法流程图;如图1所示,包括如下步骤:

[0199]

s101,确定汽车的当前状态变量和目标信息;所述当前状态变量包括:汽车的位置、速度、加速度以及偏航速度;所述目标信息为汽车行驶目的地的区域范围信息;

[0200]

s102,利用基于车辆运动学的概率路径预测模型实时预测汽车下一时刻的状态变量,以规划汽车的短期路径;

[0201]

s103,基于二维地图信息构建人工势场,以为二维地图上不同类型的障碍物和道路结构分配不同的势函数,使得障碍物周围与道路边缘形成排斥势场,中间目标处周围形成引力势场;所述中间目标指的是汽车行驶路径中的位置点;

[0202]

s104,通过线性二次调节策略获取汽车行驶路径的离线数据,并利用径向基函数神经网络对所述离线数据进行训练,以对汽车行驶路径的行驶距离进行预测;

[0203]

s105,基于离线学习的快速扩展随机路径规划算法对汽车行驶的长期路径进行规划,并结合所述行驶距离的预测结果确定汽车自动驾驶的最优避障路径;其中,将所述汽车短期路径作为长期路径规划的采样指导,将所述人工势场作为长期路径规划的方向约束。

[0204]

在一个更具体的实施例中:利用carsim-matlab/simulink联合仿真分析,验证提出的无碰撞轨迹规划算法的性能。仿真中,carsim提供车辆运动学,matlab/simulink实现渐近最优轨迹规划、轨迹跟踪控制器等算法。

[0205]

接下来结合附图对本发明的具体实施步骤进行详细的阐述:

[0206]

如图2所示,一种基于离线增量学习的自动驾驶汽车路径规划方法,主要采用基于车辆运动学的短期规划方法和基于行为认知的长期路径规划方法,步骤如下:

[0207]

步骤一:短期路径预测,利用基于车辆运动学的概率路径预测模型,实时预测车辆的状态变量,如位置、速度、加速度、偏航速度等。

[0208]

步骤二:构建人工势场,为不同类型的障碍物和道路结构分配不同的势函数,并为障碍物生成排斥势场,为目标生成引力势场。

[0209]

步骤三:利用径向基函数神经网络方法线下训练通过线性二次调节策略获得的离线数据,然后应用于智能车辆路径规划算法的距离预测。

[0210]

步骤四:依据基于离线增量学习的快速扩展随机树轨迹规划算法,得到渐进最优的避障路径。

[0211]

需要说明的是,图2中无迹卡尔曼滤波评估是卡尔曼滤波评估的变体,是从系统已知的控制输入和状态测量值中估计系统的状态值。

[0212]

如图3所示,步骤四所述的基于离线增量学习的快速扩展随机树轨迹规划算法的实施步骤如下:

[0213]

1)对随机树t进行扩展,随机树t将作为起始点,将x

goal

作为目标点;并将作为本次扩展的父节点;

[0214]

2)依据采样约束函数sample_apf生成随机状态点然后利用函数nearest找到与最近的节点作为父节点

[0215]

3)以为中心rn为半径,在树t上搜索满足apf约束的节点作为子节点的潜在父亲节点比较作为父亲节点的轨迹(p1)成本cost1与作为父亲节点的轨迹(p2)成本cost2,当p2无碰撞(满足obstaclefree函数)并且cost2《cost1时,将的父亲节点改为添加新的边,然后删掉树t上之前的父亲节点与子节点之间的边;

[0216]

4)遍历所有潜在的父节点,得到更新后的树t。

[0217]

图4是本发明实施例提供的基于离线增量学习的自动驾驶汽车路径规划系统架构图;如图4所示,包括:

[0218]

汽车信息获取单元,用于确定汽车的当前状态变量和目标信息;所述当前状态变

量包括:汽车的位置、速度、加速度以及偏航速度;所述目标信息为汽车行驶目的地的区域范围信息;

[0219]

短期路径规划单元,用于利用基于车辆运动学的概率路径预测模型实时预测汽车下一时刻的状态变量,以规划汽车的短期路径;

[0220]

人工势场构建单元,用于基于二维地图信息构建人工势场,以为二维地图上不同类型的障碍物和道路结构分配不同的势函数,使得障碍物周围与道路边缘形成排斥势场,中间目标处周围形成引力势场;所述中间目标指的是汽车行驶路径中的位置点;

[0221]

行驶距离预测单元,用于通过线性二次调节策略获取汽车行驶路径的离线数据,并利用径向基函数神经网络对所述离线数据进行训练,以对汽车行驶路径的行驶距离进行预测;

[0222]

长期路径规划单元,用于基于离线学习的快速扩展随机路径规划算法对汽车行驶的长期路径进行规划,并结合所述行驶距离的预测结果确定汽车自动驾驶的最优避障路径;其中,将所述汽车短期路径作为长期路径规划的采样指导,将所述人工势场作为长期路径规划的方向约束。

[0223]

需要说明的是,图4中各个单元的详细功能实现可参见前述方法实施例中的介绍,在此不做赘述。

[0224]

本发明公开了一种基于离线增量学习的自动驾驶汽车路径规划方法,属于路径规划领域。为了提高快速扩展随机树算法的收敛速度,本发明利用车辆运动学模型预测短期最优路径,指导长期路径规划的采样过程。对于长期路径规划,本发明首先利用人工势场技术来约束搜索方向,加快路径搜索速度。其次,为了克服车辆运动学系统的复杂性和非线性约束问题,本发明采用将线性二次调节算法与径向基函数神经网络相结合的距离度量方法,先通过线性二次调节算法获得训练数据,然后使用径向基函数神经网络算法进行线下训练,在合理近似最短路径距离度量的同时规避了精确求解带来的计算开销。基于车辆运动学的路径预测方法可以在兼顾车辆运行动态参数的同时保证短期精度。此外,基于离线增量学习的快速扩展随机树预测方法提供了对未来轨迹的长期洞察。

[0225]

本领域的技术人员容易理解,以上所述仅为本发明的较佳实施例而已,并不用以限制本发明,凡在本发明的精神和原则之内所作的任何修改、等同替换和改进等,均应包含在本发明的保护范围之内。

- 该技术已申请专利。仅供学习研究,如用于商业用途,请联系技术所有人。

- 技术研发人员:周漫 韩福济 付才 张云鹤 袁斌 慕冬亮 韩兰胜

- 技术所有人:华中科技大学

- 我是此专利的发明人

- 该领域下的技术专家

- 如您需求助技术专家,请点此查看客服电话进行咨询。

- 1、唐老师:1.高效节能装备 2.流动稳定性 3.汽车流场分析和淀粉糖工艺技术。

- 2、孙老师:1.振动信号时频分析理论与测试系统设计 2.汽车检测系统设计 3.汽车电子控制系统设计

- 3、王老师:电子信息处理、先进检测方法和智能化仪表

- 4、周老师:1.智能电网 2.新能源利用 3.泛在电力物联网

- 5、赵老师:检测与控制技术、机器人技术、机电一体化技术

- 如您是高校老师,可以点此联系我们加入专家库。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1

精彩留言,会给你点赞!

专利分类正在加载中....