基于双层Q学习的储能系统多变流器自适应功率控制方法

本发明涉及储能,具体涉及一种基于双层q学习的储能系统多变流器自适应功率控制方法。

背景技术:

1、近年来,储能电站在电力系统发电侧、输配电侧、用电侧都起到关键性作用。储能电站为电网提供多种服务,有效实现削峰填谷,缓解电网运行压力,平抑新能源波动,提高用户供电可靠性。随着储能技术的日益成熟,电力系统对于储能容量的需求持续增长,在大规模储能电站中往往采用多装置并联运行的方式提高储能装置的容量和可靠性。储能变流器作为电池系统的一部分,是连接电网和电池组的重要枢纽,其运行效率与负载功率有关。多个电池系统并联系统中储能变流器的整体运行效率由负载功率分配方式决定。对于许多大规模储能电站来说提高利润的关键就在于降低损耗,提高电能的利用率。

2、现有技术申请号为:cn201210091331.1公开了一种基于贪婪策略的电池储能电站功率控制方法及其系统,通过贪婪算法计算各储能机组的决策变量,并通过决策变量确定出参与本次功率分配的储能机组。申请号为:cn201210091332.6公开了一种基于遗传算法的电池储能电站功率控制方法及其系统,通过通过遗传算法计算各储能机组的决策变量,并根据决策变量确定参与本次功率分配的储能机组;申请号为:cn202110710383.1公开了一种平抑快速电压波动的储能电站功率分配方法,通过分析电网中储能电站状态、构造泛函并求解极值点、选择无功功率容量最大的功率分配方案。上述方案中均对新能源功率波动抑制、电网调频等场景的储能系统的运行效率有一定的提升,但是贪婪、遗传等智能算法容易陷入局部最优解,储能系统的整体运行效率仍有进一步优化空间。

技术实现思路

1、1.所要解决的技术问题:

2、针对上述技术问题,本发明提供一种基于双层q学习的储能系统多变流器自适应功率控制方法,

3、2.技术方案:

4、基于双层q学习的储能系统多变流器自适应功率控制方法,其特征在于:包括以下步骤:

5、基于双层q学习算法的自适应功率控制方法获取各并联储能模块的荷电状态soci,以并联的多储能变流器总效率最优为目标,在各并联储能模块的出力限制约束下,将当前调度周期的上级调度任务功率ptotal在各并联储能模块之间进行分配,以确定各并联储能模块的功率分配值;

6、所述双层q学习算法的智能体包含两层学习单元,通过外层学习得到各并联储能模块的功率分配模式的工作区间,内层利用actor神经网络得到自适应功率分配模式下的最优功率分配策略,同时内层得到的行动奖励对外层求得的工作区间进行动态修正。

7、进一步地,所述并联的多储能变流器总效率的模型为:

8、

9、(1)式中,ptotal是分配给所有并联储能变流器的功率总和,其范围为(0,1)p.u.;ηt(ptotal)是整个储能系统的功率值为ptotal时并联储能变流器的总运行效率,pib是电网侧第i个储能变流器的功率输出;n为并联储能模块的数目,n≥i。

10、进一步地,所述外层学习得到各并联储能模块的功率分配模式的工作区间,内层利用actor神经网络得到自适应分配模式下的动作策略,同时内层得到的动作奖励对外层求得的工作区间进行动态修正,具体包括:

11、双层q学习的外层动作空间a包括n+1种工作模式;所述n+1种工作模式包括n种多储能变流器均分模式和1种自适应分配模式,即:

12、a={ms1 ms2 … msn ma} (2);

13、(2)式中,动作msi表示多储能变流器并联系统工作在i台变流器功率均分模式下,分配给每台储能变流器的输出任务功率等于ptotal/n,动作ma表示多储能变流器并联系统工作在自适应模式下;

14、所述双层q学习算法的外层将储能系统的调度任务功率进行离散化,并将离散化后的结果定义为状态集s,状态s∈s,每个状态s对应一个ptotal;为保证计算精度,预设△p为一档,ptotal为正代表放电,为负代表充电;因此外层q表维度为(2ptotal/△p+1,n+1);

15、由于在求解系统最优效率问题中,各个状态之间没有必然的关联,每个状态下对应的q值只与该状态有关,并且在强化学习过程中,奖励函数的值越大越好,所以将系统总效率ηt设定为奖励函数r;但是直接把总效率设定为奖励函数的话,奖励值之间差距较小,无法较好地体现出动作之间的优劣性,所以根据(3)式将效率转化为范围在0-100之间的奖励值:

16、

17、(3)式中和是整体的运行效率ηt的最大值和最小值;

18、在动作ma中,通过actor神经网络得到奖励值r,再以δ(k)作为新的奖惩信息来确定动作概率的更新方向:

19、δ(k)=rk(s,ma)-max{r(s,ms1),…,r(s,msn)} (4);

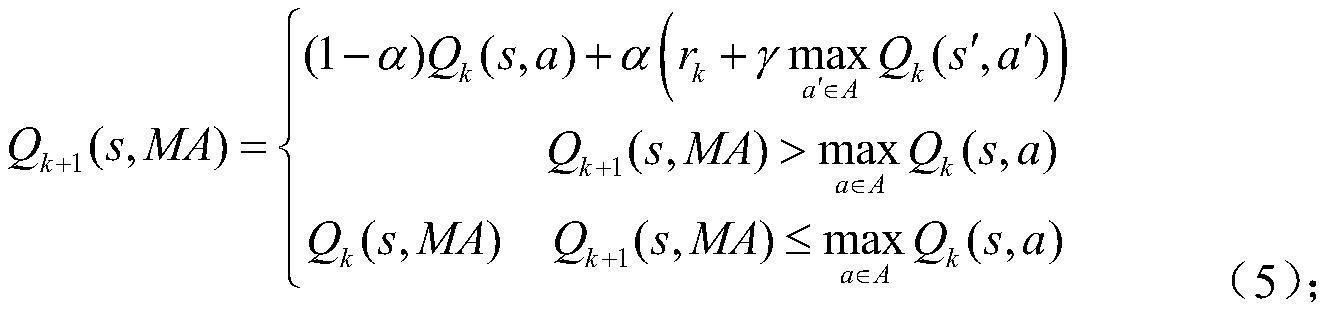

20、(4)式中rk(s,ma)为状态为s时的动作ma在第k次学习迭代中获得的奖励;在智能体最初阶段优先得到每个状态s下动作msi的奖励值r(s,msi);利用内层动作的奖励值,对外层q表进行更新,如(5)式所示,得到外层的qk+1(s,ma);只有当qk+1(s,ma)大于对于任一均分模式下的q值,a=ma下的q值才会更新;

21、

22、(5)式中,qk(s,a)表示q表中状态为s时的动作a在第k次学习迭代中得到的q值;s′表示在状态s执行动作a后进入的下一状态,表示在该状态下q表中的最大q值。

23、进一步地,所述将当前调度周期的上级调度任务功率在各并联储能模块之间进行分配,还包括对充放电过程中功率分配系数μ的计算,其计算过程如(6)式:

24、

25、(6)式中μ1为各并联储能模块中最大分配系数,且μ1≥μ2≥…≥μn;由于各并联储能模块中的每个电池系统的参数相同,避免了重复选择,简化了功率分配系数的选择。

26、进一步地,还包括:当使用双层q学习算法实现并联储能变流器的最优功率分配问题时,智能体学习在各个系统状态下执行动作得到的环境反馈,在线更新pr和q表,不断增强对多储能变流器并联系统效率模型的认知。

27、进一步地,在动作ma对应的模式下,使用actor神经网络得到最优策略π,actor神经网络超参数θ的更新方法为:

28、

29、(7)式中δ(k)是优势函数;θ是actor网络的超参数,πθ(sk,ak)是第k次学习迭代中的行动策略,参数απ是actor神经网络的学习率;actor神经网络输入是状态s,输出是动作策略π;(7)式表示根据学习率aπ更新actor神经网络的参数。

30、进一步地,其特征在于:求解动作ma对应的模式时的最优功率分配策略时,actor神经网络目标网络参数的更新方法,如式(8)所示:

31、θπ',k+1=τθπ,k+(1-τ)θπ',k (8);

32、(8)式中,τ是目标网络参数的学习率并且τ<<1,π是最优策略,在第k次学习过程中,actor神经网络的超参数为θπ,k时能够得到策略π;π'表示网络超参数更新为θπ',k后的最优策略。

33、进一步地,还包括:为了实现并联储能模块间的soc平衡,采用soc优先原则,即soc较低的储能模块的电池优先充电,soc较高的储能模块的电池优先放电;通过将预学习得到的双层q学习算法输出的分配系数μ1,μ2,…,μn与ptotal相乘得到n组分配功率;根据储能模块电池的实时soc值,在调度任务为放电时,将最大任务功率分配给当前时刻soc最大的储能模块,在调度任务为充电时,将最大任务功率分配给当前时刻soc最小的储能模块,实现不同电池系统间的soc平衡;

34、根据(9)式计算每个调度任务周期内各个储能模块消耗的电量,改变其soc大小;

35、△soc=π·ptotal·△t/c0 (9);

36、(9)式中△t表示调度任务周期,c0是电池系统的额定容量。

37、3.有益效果:

38、在储能系统多变流器自适应最优功率分配问题中,随着并联储能变流器台数的增加,求解难度大大提高,本发明采用双层q学习算法实现该复杂非线性问题的求解。但是传统的q学习方法采用离散的动作量和状态量,对于n台变流器并联系统会产生维数灾的问题,因此针对该问题做出了如下改进:首先,根据储能系统效率模型简化了功率分配系数的选取,避免了重复动作的选取;对于n台储能变流器并联系统,根据系统效率最优功率分配特征,将外层动作空间设置为n+1种功率分配模式;内层利用actor神经网络求解自适应分配模式下的最优动作策略,有效增强了优化效果,加快了学习速度。q学习算法在调度功率范围内预学习得到q学习控制器后投入真实工况中,在考虑荷电状态约束的同时,实现在线自适应功率分配,与传统的功率分配方法以及基于智能算法的自适应功率分配方法相比,基于双层q学习的自适应功率分配方法实现了储能变流器并联系统整体运行效率最优,降低了储能系统的电能损耗。

- 还没有人留言评论。精彩留言会获得点赞!