一种全电无人拖轮智能协同辅助大型货轮自动靠泊的方法

1.本发明涉及无人船技术领域,尤其是一种全电无人拖轮智能协同辅助大型货轮自动靠泊的方法。

背景技术:

[0002][0003]

自主靠泊主要分为两种形式:

[0004]

1)全驱动货轮依靠自身的推力实现自主靠泊,但这种方式需要将现有的欠驱动大型货轮全部升级改造为全驱动货轮,货轮改造成本高,难度大。

[0005]

2)多拖轮协同辅助货轮自主靠泊,这就亟需对多拖轮辅助自主靠泊系统路径规划与控制技术进行研究。各大科研院所、高校和企业在船舶协同路径规划、协同控制和协同拖拽方面进行了大量的研究,取得了一系列的研究成果。但是在多无人拖轮协同辅助货轮自主靠泊方面研究较少。

[0006]

现有技术在进行无人拖轮路径规划领域基本都是针对单无人拖轮,多无人拖轮协同控制技术上还有很大提升,对于多无人拖轮控制,现有技术有采用目标分配方法将目标点分配给多无人拖轮,生成单个无人拖轮的初级航行路线,依据运动限制范围在可航行区域规划单无人拖轮沿初级航行路线驶向下一个目标点的实际路径。这种方式避免了无人拖轮之间发生碰撞,但是在运动限制范围内遇到其他船只或者海上浮漂可能造成无法行进或者发生碰撞,因此只适用于无其他船只,海上浮漂等障碍物的已知海洋环境。另外,现有无人拖轮大多采用燃油提供动力,对能源消耗和环境造成一定的影响。并且燃油无人拖轮实现自动加油非常困难,岸基现阶段无法提供燃油自动补给站,需要工人实现燃油补充。

[0007]

为此需要研究一种协同辅助自主靠泊路径规划与控制方法,实现欠驱动货轮的全自主靠泊。所以本发明提出一种以基于深度强化学习协同路径规划和动力分配算法为基础,实现对多拖轮辅助靠泊系统高精度的协同路径规划与控制的方法。

技术实现要素:

[0008]

本发明提出一种全电无人拖轮智能协同辅助大型货轮自动靠泊的方法,能大大改善传统方法的随机性太高、求解不稳定、容易陷入局部最优解的缺点。

[0009]

本发明采用以下技术方案。

[0010]

一种全电无人拖轮智能协同辅助大型货轮自动靠泊的方法,用于多艘全电无人拖轮协同进行水面工作的路径跟踪与动力分配,所述方法以深度确定性策略梯度算法ddpg为基础,辅以人工设定势场函数拓展和目标引力函数扩展相结合的扩展策略,并采用节点拓展概率准则及多步贪婪准则,自动求解出全电无人拖轮的航行路径,包括以下步骤;

[0011]

步骤s1,构建决策神经网络模型;

[0012]

步骤s2,以多艘无人拖轮同时探索提取航行水域环境信息,把提取的信息储存为经验数据;

[0013]

步骤s3,从储存的经验数据中选取训练数据,训练第一决策神经网络模型、第二决策神经网络模型;

[0014]

步骤s4,对于已知的地图环境,将环境地图进行锐化处理后输入无人拖轮核心处理器;

[0015]

步骤s5,核心处理器接收图像信息,并对其进行再次处理,转化为能够识别的电子数据信息;

[0016]

步骤s6,无人拖轮利用第一决策神经网络模型和电子地图数据,以所需辅助的大型货轮为终点进行路径规划;

[0017]

步骤s7,无人拖轮按步骤s6的路径规则航行到目标终点后,与大型货轮通过绳索或者船体拼接装置连接;

[0018]

步骤s8,无人拖轮与大型货轮连接组合后,作为拖曳船组,针对地图电子数据信息,综合考虑多船整体起点,终点泊位;

[0019]

步骤s9,无人拖轮利用第二决策神经网络模型和电子地图数据再次进行路径规划,再由无人拖轮的船体控制系统进行控制以实现各艘无人拖轮之间的动力分配,使组合后的拖曳船组航行移动至泊位。

[0020]

步骤s1中,以强化学习rl结合神经网络形成深度强化学习drl,采用以下方法;

[0021]

a、用经验重放和目标网络,采用深度神经网络cnn使行动价值的函数逼近训练稳定;

[0022]

b、设计仅以像素和游戏分数作为输入的端到端rl方法;

[0023]

c、使用相同的算法、网络架构和超参数来训练更为灵活的网络,要求标准是能在不同的任务上表现良好且优于先前的算法,最终达到能与人类专业测试者相当的水平。

[0024]

步骤s2中,通过所述决策神经网络模型输出动作,并将相关状态、动作、奖励保存经验池中,然后从所述经验池中选择经验数据形成训练数据集,在采用所述训练数据集训练所述决策神经网络模型时,每个无人拖轮从不同的初始状态开始探测,并将探测的运动状态存入所述经验池中。

[0025]

步骤s3中,基于ddpg算法对所述决策神经网络模型进行训练,在训练过程中将ou过程和人工设定势场函数拓展和目标引力函数扩展相结合的扩展策略引入到ddpg算法中来探索环境,当所述决策神经网络模型做出决策和输出动作a

t

=u(s

t

)时,由随机过程产生的动作噪声的平均值为0,a

t

表示神经网络输出的动作,u(s

t

)表示神经网络决策策略,s

t

表示t时刻输入神经网络的状态输入,ao表示神经网络输出的动作加入随机噪声后生成的动作。ddpg算法的critic 当前网络负责对当前状态s使用actor当前网络进行策略网络参数θ的迭代更新,根据当前状态s选择当前动作a,用于和环境交互生成s

′

,r,存放到经验池中;对经验回放池中采样的下一状态s

′

选择动作a

′

,在actor目标网络中进行,actor 目标网络负责根据经验回放池中采样的下一状态s

′

选择最优下一动作a

′

。网络参数θ

′

定期从θ复制。基于经验回放池和目标actor网络提供的s

′

,a

′

计算目标q值部分,放到critic目标网络完成。而critic目标网络计算出目标q值后,critic当前网络会计算目标q值,并进行网络参数更新,并定期将网络参数复制到critic 目标网络;此外,actor当前网络也会基于critic当前网络计算出目标q值,进行网络参数更新,并定期将网络参数复制到actor目标网络;

[0026]

上述网络参数更新方式采用软更新,即每次仅少量更新,公式表述为:

[0027]

ω

′←

τω+(1-τ)ω

′ꢀꢀꢀꢀ

公式一;

[0028]

θ

′←

τθ+(1-τ)θ

′

[0029]

公式二;

[0030]

其中τ是更新系数,采用小数值;

[0031]

对于损失函数,使用均方误差损失函数

[0032][0033]

通过神经网络的梯度反向传播来更新critic当前网络的所有参数ω;公式为

[0034][0035]

通过神经网络的梯度反向传播来更新actor当前网络的所有参数θ;其中yj表示目标q值,表示j时刻状态的特征向量。

[0036]

所述全电无人拖轮在执行ddpg算法时,引进目标引力函数对其进行大方向上的引导,使搜索朝着目标的位置方向生长,以提高工作效率,同时加入设定人工势场和与目标引力函数扩展相结合的扩展策略,加入势场的过程如下:

[0037]

引力势场的形式以公式表述为

[0038][0039]

式中,x是全电无人拖轮当前所在位置,xg是目标点所在位置,k是引力势场的

[0040]

增益系数;

[0041]

设全电无人拖轮在该点受到来自目标点的引力为f1,即其所受引力势场的梯度,方向由其当前位置指向目标点,公式如下所示

[0042][0043]

模型中,全电无人拖轮所受引力随其距目标点距离的增加而减小,反之则增加,当全电无人拖轮到达或无限接近目标点时,其所受引力为0;

[0044]

假设全电无人拖轮在此点受到斥力势场为u2,来自于障碍物,其公式如下

[0045]

其中,xb是障碍物的位置坐标,m是斥力势场的增益系数,ρ为障碍物的影响半径,由上可得全电无人拖轮受到的斥力f2(x)为其所受斥力势场的负梯度,公式如下:

x

goal

||数值为0保持不变;若数值不为0,则重新执行步骤 a2;

[0061]

步骤a7、若已到达目标点位置状态,则进行全电无人拖轮与大型货轮的连接,通过载入的第二决策神经网络模型进行路线拓展与规划;第二决策神经网络模型中,动作空间变为三个维度,将全电无人拖轮视为大型货轮三个方向的推进器,执行的动作为各方向全电无人拖轮提供的合力大小,直至拖拽大型货轮到达泊位;

[0062]

步骤a8,在靠近泊位3-5米时,全电无人拖轮与大型货轮分离,全电无人拖轮返回岸基,实现自动充电,准备下一次航行任务。大型货轮自动或手动完成后续系泊工作,此时整个任务过程结束。

[0063]

训练第一决策神经网络模型的运算过程包括以下步骤;

[0064]

步骤s311、确定无人拖轮的起始点状态和目标点状态;

[0065]

步骤s312、通过算法进行无人拖轮的位置状态、动作状态更新;

[0066]

步骤s313、若无人拖轮遇到障碍物,则提升人工势场函数权重,使无人拖轮避开障碍物;

[0067]

步骤s314、若无人拖轮航行时距离目标点越来越远,则提升目标引力函数,使全电无人拖轮向着靠近目标点的方向前进。若全电无人拖轮距离目标点越来越近,则执行下一步骤;

[0068]

步骤s315、若算法陷入局部最优,则说明目标引力函数所占权重过高,此时则需要提升ou算法权重以便能够跳出局部最优,继续寻找目标点。若算法没有陷入局部最优,则执行下一步骤;

[0069]

步骤s316、判断是否已经到达目标点位置状态,若没有到达目标点位置状态,则降低ou算法权重,回到步骤s312,继续进行迭代更新;

[0070]

步骤s317、若已到达目标点位置状态,则无人拖轮得出整体基本规划路线;

[0071]

步骤s318、船载核心处理器对路线进行b样条曲线圆滑处理,进一步优化路线;

[0072]

步骤s319、得到最优路线,算法训练完成,得到第一决策神经网络模型。

[0073]

训练第二决策神经网络模型的运算过程包括以下步骤;

[0074]

步骤s321、确定组合后的拖曳船组的起始点状态和泊位状态;

[0075]

步骤s322、通过算法进行拖曳船组位置状态、动作状态更新;

[0076]

步骤s323、若拖曳船组遇到障碍物,则提升人工势场函数权重,使全电无人拖轮避开障碍物,实现方式即远离障碍物的拖轮启动推进器,将拖曳船组整体脱离障碍物范围,若距离障碍物达到设置阈值,则推进器关闭;

[0077]

步骤s324、若距离目标点越来越远,则提升目标引力函数,使全电无人拖轮向着靠近目标点的方向前进,实现方式即靠近目标点的全电无人拖轮和侧方全电无人拖轮启动推进器,使拖曳船组整体向靠近泊位方向航行;若拖曳船组整体距离目标点越来越近,则执行下一步骤;

[0078]

步骤s325、若算法陷入局部最优,则说明目标引力函数所占权重过高,此时则需要提升ou算法权重以便能够跳出局部最优,继续寻找目标点。若算法没有陷入局部最优,则执行下一步骤;

[0079]

步骤s326、判断拖曳船组是否已经到达泊位位置状态,若没有到达泊位位置状态,则降低ou算法权重,回到步骤s322,继续进行迭代更新;

[0080]

步骤s327、若已到达泊位位置状态,全电无人拖轮得出整体基本规划路线;

[0081]

步骤s328、船载核心处理器对路线进行b样条曲线圆滑处理,进一步优化路线;

[0082]

步骤s329、得到最优路线,算法训练完成,得到第二决策神经网络模型。

[0083]

步骤s4中,首先确定一个包含地图信息和船体运动状态模型的坐标系,然后将卫星地图进行锐化,空白部分为可行驶区域,阴影部分为障碍物,地图信息以横纵坐标系表示,使处理器能够读取和识别地图信息;

[0084]

步骤s5中,通过全电无人拖轮上传感器来感知附近环境信息,结合处理器读取的已知的卫星云图建立环境模型地图进行处理,将整个环境空间划分为障碍物空间x

obs

和无障碍物空间x

free

,障碍物以阴影部分来表示。

[0085]

步骤s6中,将第一决策神经网络模型和电子地图数据载入核心处理器,实现自主路径规划。

[0086]

全电无人拖轮的传感器包括毫米雷达、摄像头、光电传感器、惯性传感器;步骤s7中,全电无人拖轮到达目标点的大型货轮处后,与大型货轮连接,形成一个整体。

[0087]

步骤s8中,综合考虑拖曳船组的多船整体,调整全电无人拖轮的串口通信,协调各全电无人拖轮推进器;

[0088]

步骤s9中,将第二决策神经网络模型和电子地图数据载入核心处理器,实现整体自主路径规划。

[0089]

本发明采用电力推进系统,并且实现岸基自动充电,从航行到动力补给真正意义上全面实现无人化,代替燃油无人拖轮,从而减少化石能源消耗,有利于生态文明建设。

[0090]

本发明为解决现有技术对于多无人拖轮需要设定运动限制范围,且需要目标分配方法将目标点分配给多无人拖轮的缺陷;本发明提出基于深度确定性策略梯度与人工势场相结合的方法,本方法可以实现对多全电无人拖轮协同控制,多全电无人拖轮可以实现自动避障,相互之间实现避碰,且航行路线更加优化,不需要设定运动限制范围,克服了现有技术速度慢、效果差、效率低等缺点。

[0091]

众所周知,全电无人拖轮在执行任务时,一旦触碰到海上浮漂,岸基以及其他船只,势必会影响全电无人拖轮的正常工作,甚至会损伤全电无人拖轮船体,重则报废,造成更加严重的后果,在本发明中,引入人工势场法来避免全电无人拖轮触碰障碍物,同时引进目标引力函数对其进行大方向上的引导,用以提高工作效率。在ddpg算法中引入目标引力函数,目标引力函数使搜索朝着目标的位置方向生长,这样不仅避免了随机对全局空间进行搜索,大大减少了运算量,提高了实时性,而且使规划出的路径尽可能的接近最优路径,并改进了路径的光滑性。

[0092]

本发明中的该路径规划方法以深度确定性策略梯度算法(ddpg)为基础,再辅以人工设定势场函数拓展和目标引力函数扩展相结合的扩展策略,并采用节点拓展概率准则及多步贪婪准则,自动求解出全电无人拖轮的航行路径。大大改善了随机性太高,求解不稳定,容易陷入局部最优解的缺点。

[0093]

本发明中的路径规划算法以ddpg算法为基础,形成基于设定人工势场和与目标引力函数扩展相结合的扩展策略。该算法在路径规划部分,根据状态调整动作,不需要考虑全电无人拖轮的速度、加速度,以最优路径到达目的地即完成任务;此外,本发明所述算法在深度确定性策略梯度(ddpg)算法的基础上引入了人工势场函数和目标引力函数两个函数,

一定程度上克服了随机性高,避免了随机探索向目标点相反的方向拓展生长的情况,加入目标引力函数改进了缺乏确定性的问题,加入人工势场函数则有效提升了全电无人拖轮在具体水面环境中的避碰能力,总体提高了全电无人拖轮在水面路径规划方面的安全性和效率。

[0094]

本发明综合了深度决定性策略梯度(ddpg)和人工势场函数与目标引力函数,在降低随机性的同时,增大跳出局部最优的能力,使全电无人拖轮路径跟踪算法更加完善。

[0095]

本发明中,两次运用决策神经网络模型,区别一在于模型1是针对全电无人拖轮个体执行路径规划,模型2是针对船体连接的整体做协同动力分配,执行路径规划。区别二是执行不同的状态空间和动作。全电无人拖轮之间既可独立执行动作,又可协同配合执行,最终使靠泊任务可以准确高效完成。

附图说明

[0096]

下面结合附图和具体实施方式对本发明进一步详细的说明:

[0097]

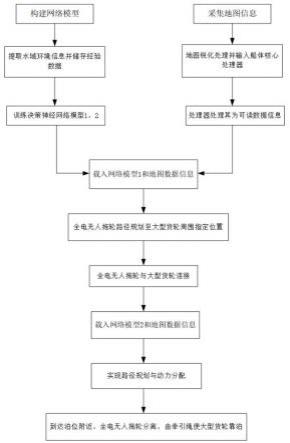

附图1是全电无人拖轮路径规划与协同控制流程示意图;

[0098]

附图2是ddpg实现路径规划和辅助靠泊任务的框架示意图;

[0099]

附图3是基于ddpg的加入人工势场函数和目标引力函数的改进后算法的算法结构简要示意图;

[0100]

附图4是船体运动协同控制与路径规划基本架构示意图。

具体实施方式

[0101]

如图所示,一种全电无人拖轮智能协同辅助大型货轮自动靠泊的方法,用于多艘全电无人拖轮协同进行水面工作的路径跟踪与动力分配,所述方法以深度确定性策略梯度算法ddpg为基础,辅以人工设定势场函数拓展和目标引力函数扩展相结合的扩展策略,并采用节点拓展概率准则及多步贪婪准则,自动求解出全电无人拖轮的航行路径,包括以下步骤;

[0102]

步骤s1,构建决策神经网络模型;

[0103]

步骤s2,以多艘无人拖轮同时探索提取航行水域环境信息,把提取的信息储存为经验数据;

[0104]

步骤s3,从储存的经验数据中选取训练数据,训练第一决策神经网络模型、第二决策神经网络模型;

[0105]

步骤s4,对于已知的地图环境,将环境地图进行锐化处理后输入无人拖轮核心处理器;

[0106]

步骤s5,核心处理器接收图像信息,并对其进行再次处理,转化为能够识别的电子数据信息;

[0107]

步骤s6,无人拖轮利用第一决策神经网络模型和电子地图数据,以所需辅助的大型货轮为终点进行路径规划;

[0108]

步骤s7,无人拖轮按步骤s6的路径规则航行到目标终点后,与大型货轮通过绳索或者船体拼接装置连接;

[0109]

步骤s8,无人拖轮与大型货轮连接组合后,作为拖曳船组,针对地图电子数据信

息,综合考虑多船整体起点,终点泊位;

[0110]

步骤s9,无人拖轮利用第二决策神经网络模型和电子地图数据再次进行路径规划,再由无人拖轮的船体控制系统进行控制以实现各艘无人拖轮之间的动力分配,使组合后的拖曳船组航行移动至泊位。

[0111]

步骤s1中,以强化学习rl结合神经网络形成深度强化学习drl,采用以下方法;

[0112]

a、用经验重放和目标网络,采用深度神经网络cnn使行动价值的函数逼近训练稳定;

[0113]

b、设计仅以像素和游戏分数作为输入的端到端rl方法;

[0114]

c、使用相同的算法、网络架构和超参数来训练更为灵活的网络,要求标准是能在不同的任务上表现良好且优于先前的算法,最终达到能与人类专业测试者相当的水平。

[0115]

步骤s2中,通过所述决策神经网络模型输出动作,并将相关状态、动作、奖励保存经验池中,然后从所述经验池中选择经验数据形成训练数据集,在采用所述训练数据集训练所述决策神经网络模型时,每个无人拖轮从不同的初始状态开始探测,并将探测的运动状态存入所述经验池中。

[0116]

步骤s3中,基于ddpg算法对所述决策神经网络模型进行训练,在训练过程中将ou过程和人工设定势场函数拓展和目标引力函数扩展相结合的扩展策略引入到ddpg算法中来探索环境,当所述决策神经网络模型做出决策和输出动作a

t

=u(s

t

)时,由随机过程产生的动作噪声的平均值为0,a

t

表示神经网络输出的动作,u(s

t

)表示神经网络决策策略,s

t

表示t时刻输入神经网络的状态输入,ao表示神经网络输出的动作加入随机噪声后生成的动作。ddpg算法的critic 当前网络负责对当前状态s使用actor当前网络进行策略网络参数θ的迭代更新,根据当前状态s选择当前动作a,用于和环境交互生成s

′

,r,存放到经验池中;对经验回放池中采样的下一状态s

′

选择动作a

′

,在actor目标网络中进行,actor 目标网络负责根据经验回放池中采样的下一状态s

′

选择最优下一动作a

′

。网络参数θ

′

定期从θ复制。基于经验回放池和目标actor网络提供的s

′

,a

′

计算目标q值部分,放到critic目标网络完成。而critic目标网络计算出目标q值后,critic当前网络会计算目标q值,并进行网络参数更新,并定期将网络参数复制到critic 目标网络;此外,actor当前网络也会基于critic当前网络计算出目标q值,进行网络参数更新,并定期将网络参数复制到actor目标网络;

[0117]

上述网络参数更新方式采用软更新,即每次仅少量更新,公式表述为:

[0118]

ω

′←

τω+(1-τ)ω

′

公式一;

[0119]

θ

′←

τθ+(1-τ)θ

′

[0120]

公式二;

[0121]

其中τ是更新系数,采用小数值;

[0122]

对于损失函数,使用均方误差损失函数

[0123][0124]

通过神经网络的梯度反向传播来更新critic当前网络的所有参数ω;公式为

[0125][0126]

通过神经网络的梯度反向传播来更新actor当前网络的所有参数θ;其中yj表示目标q值,表示j时刻状态的特征向量。

[0127]

所述全电无人拖轮在执行ddpg算法时,引进目标引力函数对其进行大方向上的引导,使搜索朝着目标的位置方向生长,以提高工作效率,同时加入设定人工势场和与目标引力函数扩展相结合的扩展策略,加入势场的过程如下:

[0128]

引力势场的形式以公式表述为

[0129][0130]

式中,x是全电无人拖轮当前所在位置,xg是目标点所在位置,k是引力势场的增益系数;

[0131]

设全电无人拖轮在该点受到来自目标点的引力为f1,即其所受引力势场的梯度,方向由其当前位置指向目标点,公式如下所示

[0132][0133]

模型中,全电无人拖轮所受引力随其距目标点距离的增加而减小,反之则增加,当全电无人拖轮到达或无限接近目标点时,其所受引力为0;

[0134]

假设全电无人拖轮在此点受到斥力势场为u2,来自于障碍物,其公式如下

[0135]

其中,xb是障碍物的位置坐标,m是斥力势场的增益系数,ρ为障碍物的影响半径,由上可得全电无人拖轮受到的斥力f2(x)为其所受斥力势场的负梯度,公式如下:

[0136][0137]

公式八;

[0138]

模型中,全电无人拖轮所受斥力随其距障碍物距离的减小而增大,反之则减小;全电无人拖轮受到的合力作用为f,公式如下

[0139]

f=f1+f2公式九;

[0140]

全电无人拖轮在合力f的作用下,躲避障碍,朝着目标点移动;

[0141]

当全电无人拖轮、目标点和障碍物三者处于同一条直线上,且障碍物位于全电无人拖轮与目标点之间时,目标点对全电无人拖轮的引力和障碍物对全电无人拖轮的斥力的合力为零,全电无人拖轮则陷入局部最小值,在该局部小范围内反复移动而无法到达目的

点,如果遇到这种情形,系统将自动提高算法权重,跳出此局部最优。

[0142]

所述全电无人拖轮在执行ddpg算法时,其运算包括以下步骤;

[0143]

步骤a1、全电无人拖轮船载处理器接收地图信息,确定起始点状态和目标点状态;通过本发明所介绍的方法建立环境坐标系,并将船体位置状态参数化,由船载传感器自动感知,并将船体状态输入船载核心处理器;

[0144]

步骤a2、通过载入的第一决策神经网络模型进行路线拓展与规划,具体为:令a

∞

为全电无人拖轮的连续动作维度,可做任意方向的动作;a

∞

∈x

free

,其中 x

free

为无人拖轮的动作空间,探索前先确定全电无人拖轮的初始位置x

init

;全电无人拖轮每执行一个step,记录一次运动的位置x

next

,判断x

next

与x

goal

的向量,其中x

goal

为目标位置;根据向量判断当前step全电无人拖轮执行动作action 的好坏,并奖励相应的reward,动作好reward为正,动作坏reward为负。并将 x

init

,action,x

next

,reward存入经验池,此时一个step结束。执行下一个step, x

next

作为当前的x

init

,开始执行动作,以下同上一个step,通过reward的值不断调整action的方向,不断靠近x

goal

直至结束。

[0145]

步骤a3、若遇到障碍物,若||x

next-x

obs

||<ρ,其中,x

obs

表示障碍物的位置, ||x

next-x

obs

||表示欧拉范数定义的x

next

和x

obs

之间距离,ρ为设定的阈值,表示障碍物的斥力半径。此时action改变方向,同时提高障碍物斥力系数和目标引力系数,躲避障碍物,从而保证全电无人拖轮安全平稳行驶;

[0146]

步骤a4、若距离目标点越来越远,则提升目标引力系数,使全电无人拖轮向目标点位置行驶,若开始向目标点靠近,则可以确保全电无人拖轮航行轨迹正常。

[0147]

步骤a5,若全电无人拖轮无法到达目标点,陷入局部最优,则需要提高ou算法权重,给全电无人拖轮动作加一个随机噪声,使其跳出局部最优,继续寻找目标点。若算法没有陷入局部最优,则执行下一步骤;

[0148]

判断全电无人拖轮是否行驶至局部最优时,只需判断||x

next-x

goal

||的数值是否变化,若保持不变,且不为0,则可以判定其已行驶至局部最优;此时若跳出局部最优,可增加ou算法的权重比例,利用随机动作噪声跳出局部最优,继续向目标点行驶。

[0149]

步骤a6、判断是否已经到达目标点位置状态,若没有到达目标点位置状态,则降低ou算法权重,回到步骤a2,继续进行拓展;即若全电无人拖轮已行驶至目标点,则||x

next-x

goal

||数值为0保持不变;若数值不为0,则重新执行步骤 a2:

[0150]

步骤a7、若已到达目标点位置状态,则进行全电无人拖轮与大型货轮的连接,通过载入的第二决策神经网络模型进行路线拓展与规划;第二决策神经网络模型中,动作空间变为三个维度,将全电无人拖轮视为大型货轮三个方向的推进器,执行的动作为各方向全电无人拖轮提供的合力大小,直至拖拽大型货轮到达泊位;

[0151]

步骤a8,在靠近泊位3-5米时,全电无人拖轮与大型货轮分离,全电无人拖轮返回岸基,实现自动充电,准备下一次航行任务。大型货轮自动或手动完成后续系泊工作,此时整个任务过程结束。

[0152]

训练第一决策神经网络模型的运算过程包括以下步骤;

[0153]

步骤s311、确定无人拖轮的起始点状态和目标点状态;

[0154]

步骤s312、通过算法进行无人拖轮的位置状态、动作状态更新;

[0155]

步骤s313、若无人拖轮遇到障碍物,则提升人工势场函数权重,使无人拖轮避开障

碍物;

[0156]

步骤s314、若无人拖轮航行时距离目标点越来越远,则提升目标引力函数,使全电无人拖轮向着靠近目标点的方向前进。若全电无人拖轮距离目标点越来越近,则执行下一步骤;

[0157]

步骤s315、若算法陷入局部最优,则说明目标引力函数所占权重过高,此时则需要提升ou算法权重以便能够跳出局部最优,继续寻找目标点。若算法没有陷入局部最优,则执行下一步骤;

[0158]

步骤s316、判断是否已经到达目标点位置状态,若没有到达目标点位置状态,则降低ou算法权重,回到步骤s312,继续进行迭代更新;

[0159]

步骤s317、若已到达目标点位置状态,则无人拖轮得出整体基本规划路线;

[0160]

步骤s318、船载核心处理器对路线进行b样条曲线圆滑处理,进一步优化路线;

[0161]

步骤s319、得到最优路线,算法训练完成,得到第一决策神经网络模型。

[0162]

训练第二决策神经网络模型的运算过程包括以下步骤;

[0163]

步骤s321、确定组合后的拖曳船组的起始点状态和泊位状态;

[0164]

步骤s322、通过算法进行拖曳船组位置状态、动作状态更新;

[0165]

步骤s323、若拖曳船组遇到障碍物,则提升人工势场函数权重,使全电无人拖轮避开障碍物,实现方式即远离障碍物的拖轮启动推进器,将拖曳船组整体脱离障碍物范围,若距离障碍物达到设置阈值,则推进器关闭;

[0166]

步骤s324、若距离目标点越来越远,则提升目标引力函数,使全电无人拖轮向着靠近目标点的方向前进,实现方式即靠近目标点的全电无人拖轮和侧方全电无人拖轮启动推进器,使拖曳船组整体向靠近泊位方向航行;若拖曳船组整体距离目标点越来越近,则执行下一步骤;

[0167]

步骤s325、若算法陷入局部最优,则说明目标引力函数所占权重过高,此时则需要提升ou算法权重以便能够跳出局部最优,继续寻找目标点。若算法没有陷入局部最优,则执行下一步骤;

[0168]

步骤s326、判断拖曳船组是否已经到达泊位位置状态,若没有到达泊位位置状态,则降低ou算法权重,回到步骤s322,继续进行迭代更新;

[0169]

步骤s327、若已到达泊位位置状态,全电无人拖轮得出整体基本规划路线;

[0170]

步骤s328、船载核心处理器对路线进行b样条曲线圆滑处理,进一步优化路线;

[0171]

步骤s329、得到最优路线,算法训练完成,得到第二决策神经网络模型。

[0172]

步骤s4中,首先确定一个包含地图信息和船体运动状态模型的坐标系,然后将卫星地图进行锐化,空白部分为可行驶区域,阴影部分为障碍物,地图信息以横纵坐标系表示,使处理器能够读取和识别地图信息;

[0173]

步骤s5中,通过全电无人拖轮上传感器来感知附近环境信息,结合处理器读取的已知的卫星云图建立环境模型地图进行处理,将整个环境空间划分为障碍物空间x

obs

和无障碍物空间x

free

,障碍物以阴影部分来表示。

[0174]

步骤s6中,将第一决策神经网络模型和电子地图数据载入核心处理器,实现自主路径规划。

[0175]

全电无人拖轮的传感器包括毫米雷达、摄像头、光电传感器、惯性传感器;步骤s7

中,全电无人拖轮到达目标点的大型货轮处后,与大型货轮连接,形成一个整体。

[0176]

步骤s8中,综合考虑拖曳船组的多船整体,调整全电无人拖轮的串口通信,协调各全电无人拖轮推进器;

[0177]

步骤s9中,将第二决策神经网络模型和电子地图数据载入核心处理器,实现整体自主路径规划。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1