一种基于双深度Q网络的在线车载雷达抗干扰波形设计方法

一种基于双深度q网络的在线车载雷达抗干扰波形设计方法

技术领域

1.本发明涉及车载雷达抗干扰波形设计方法,该方法可用于车辆跟踪定位、自主导航以及高级驾驶员辅助系统(advanced driver assistance system,adas)等领域中,属于雷达抗干扰领域。

背景技术:

2.随着信息技术的发展和人们生活水平的提高,汽车已逐渐成为日常生活的必需品,与此同时汽车的安全性能成为人们首要关注的因素。然而,城市交通系统中汽车和装载毫米波雷达的汽车数量激增,导致了非常严重的雷达干扰问题,使得参数感知性能下降甚至失效。车载雷达作为自动驾驶的关键感知器件,对位置、速度以及方位角的准确感知不仅能有效地提高自动驾驶的安全性能,还能对后续自动驾驶融合感知和规划决策过程提供有效支撑。因此研究相同调制方式、相似波形样式、重叠波形带宽等复杂干扰情况下的抗干扰技术具有重要的意义。

3.近年来涌现许多干扰处理技术,根据干扰处理技术发生在接收端还是发射端可以分为两个大类:干扰消除技术和干扰避免技术。干扰消除技术一般用在接收端,它在时域、频域或时频域进行相关信号处理以实现干扰的降低或消除。例如,利用参数估计技术在接收端重现干扰信号,然后用接收信号减抗干扰信号以实现抗干扰。干扰避免技术一般在发射端进行处理,它通过时域、频域、时频域以及空域协同设计避免干扰。例如,根据参数感知分辨率要求将频段等分,不同汽车采用不同频段雷达信号从而从根本上避免干扰。上述这些方法大部分都依赖具体的干扰环境参数,只能在限定的场合下实现抗干扰,对环境和硬件依赖偏高,当环境突变时相关方法会失效,缺乏在线更新性能,导致现有技术不稳定,鲁棒性差。

技术实现要素:

4.本发明的目的是为了解决现有干扰处理技术大部分都依赖具体的干扰环境参数,只能在限定的场合下实现车载雷达抗干扰,对环境和硬件依赖偏高,当环境突变时相关方法会失效,缺乏在线更新性能,导致现有干扰处理技术不稳定,鲁棒性差的问题,而提出一种基于双深度q网络的在线车载雷达抗干扰波形设计方法。

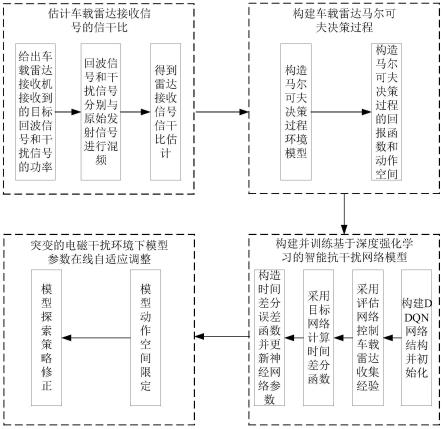

5.基于双深度q网络的在线车载雷达抗干扰波形设计方法具体过程为:

6.步骤一、估计车载雷达接收信号的信干比;

7.步骤二、基于步骤一的信干比,构建车载雷达马尔可夫决策过程;

8.步骤三、基于步骤二的车载雷达马尔可夫决策过程,构建并训练双深度q网络模型;

9.步骤四、突变的电磁干扰环境下基于双深度q网络模型参数在线自适应调整,得到突变条件下的电磁干扰环境下双深度q网络模型;

10.步骤五、获取车载雷达所处的状态空间,输入步骤四得到的突变条件下的电磁干

扰环境下双深度q网络模型,输出最优动作价值函数值对应的最优动作,即为车载雷达抗干扰波形。

11.本发明的有益效果为:

12.本发明针对存在相同调制方式、相似波形样式、重叠波形带宽等复杂电磁环境下的车载雷达干扰问题,提出了一种基于双深度q网络(double deep q network,ddqn)的在线车载雷达抗干扰波形设计方法,解决了因为复杂的电磁环境干扰导致的车载雷达位置、速度等参数严重失准或失效问题,同时借助模型的动作空间限定和探索策略调整方法实现了模型的在线更新,提高了模型的环境适应能力。

13.(1)本发明所述的基于双深度q网络的在线车载雷达抗干扰波形设计方法利用深度强化学习算法进行雷达参数波形的设计,克服了传统方法对环境的依赖性,解决了城市道路中由于复杂的电磁干扰环境导致车载雷达感知性能严重下降甚至失效的问题,实现了突变电磁环境下的在线更新能力,有效提升了存在复杂干扰情况下的环境感知性能;

14.(2)本发明所述的基于双深度q网络的在线车载雷达抗干扰波形设计方法无需外界环境通信提供额外信息即可实施有效的抗干扰波形设计,有效降低了对通信硬件设备的需求。

附图说明

15.图1是本发明所述的一种基于双深度q网络的在线车载雷达抗干扰波形设计方法的原理框图;

16.图2是在无干扰环境下本发明所述的一种基于双深度q网络的在线车载雷达抗干扰波形设计方法的目标检测仿真结果图;

17.图3是在复杂电磁干扰环境下本发明所述的一种基于双深度q网络的在线车载雷达抗干扰波形设计方法的目标检测仿真结果图;

18.图4是在信号带宽重叠50%,环境平稳情况下本发明所述的一种基于双深度q网络的在线车载雷达抗干扰波形设计方法与传统方法抗干扰成功率对比仿真图;

19.图5是在信号带宽重叠50%,环境突变情况下本发明所述的一种基于双深度q网络的在线车载雷达抗干扰波形设计方法与传统方法抗干扰成功率对比仿真图;

20.图6是在信号带宽重叠100%,环境平稳情况下本发明所述的一种基于双深度q网络的在线车载雷达抗干扰波形设计方法与传统方法抗干扰成功率对比仿真图;

21.图7是在信号带宽重叠100%,环境突变情况下本发明所述的一种基于双深度q网络的在线车载雷达抗干扰波形设计方法与传统方法抗干扰成功率对比仿真图。

具体实施方式

22.具体实施方式一:本实施方式一种基于双深度q网络的在线车载雷达抗干扰波形设计方法具体过程为:

23.步骤一、估计车载雷达接收信号的信干比;

24.步骤二、基于步骤一的信干比,构建车载雷达马尔可夫决策过程;

25.步骤三、基于步骤二的车载雷达马尔可夫决策过程,构建并训练双深度q网络模型;

26.步骤四、突变的电磁干扰环境下基于双深度q网络模型(基于深度强化学习的智能抗干扰网络)参数在线自适应调整,得到突变条件下的电磁干扰环境下双深度q网络模型;

27.步骤五、获取车载雷达所处的状态空间,输入步骤四得到的突变条件下的电磁干扰环境下双深度q网络模型,输出最优动作价值函数值对应的最优动作,即为车载雷达抗干扰波形。

28.具体实施方式二:本实施方式与具体实施方式一不同的是,所述步骤一中估计车载雷达接收信号的信干比;具体过程为:

29.步骤一一、给出车载雷达接收机接收到的目标回波信号和干扰信号的功率;具体过程为:

30.设车载雷达接收机接收到的目标回波信号的功率为pr,有

[0031][0032]

设车载雷达接收机接收到的干扰信号的功率为pi,有

[0033][0034]

其中p

t

表示车载雷达发射功率,g表示天线增益,σ表示目标的雷达截面积、r表示目标或干扰源到车载雷达接收机的距离,ae表示车载雷达天线的有效孔径,λ为车载雷达发射信号载波波长;

[0035]

步骤一二、将车载雷达接收机接收到的目标回波信号和干扰信号分别与车载雷达发射信号(原始发射信号)进行混频;具体过程为:

[0036]

车载雷达接收机接收到的目标回波信号与车载雷达发射信号(原始发射信号)进行混频,得到频域表达式为

[0037][0038]

其中δ(

·

)为冲激函数,f

0,v

是车载雷达发射信号的载波频率,τ是回波信号的时延,kv为车载雷达发射的chirp信号的斜率;j为虚数单位,j2=-1;f为雷达频率;

[0039]

车载雷达接收机接收到的干扰信号与车载雷达发射信号(原始发射信号)进行混频,得到频域表达式为

[0040][0041]

其中t

arr

为干扰信号进入雷达接收机带宽的时间,t

end

为干扰信号离开雷达接收机带宽的时间,k

if

是雷达发射机发射chirp信号和干扰源发射的chirp信号的斜率之差的绝对值,为初始相位,rect(

·

)为幅值为1的矩形窗函数;

[0042]

步骤一三、估计车载雷达接收信号的信干比;具体过程为:

[0043]

结合步骤一二中得到的回波信号与车载雷达发射信号(原始发射信号)的混频频域表达式以及干扰信号与车载雷达发射信号(原始发射信号)的混频频域表达式

估计目标检测点处车载雷达接收信号的信干比;表达式为:

[0044][0045]

其中,p

v-v

为检测点处目标回波信号的接收功率,p

i-v

为检测点处干扰信号引入的干扰功率;δf为频域采样间隔;为单位幅值的矩形函数;

[0046]

考虑到|exp[j(2πf

0,v

τ-πkvτ2)|和的值为1,所以信干比估计表达式可以近似为

[0047][0048]

由于结合步骤一一得到的回波信号功率pr和干扰信号功率pi以及δ2(f)表达式,信干比估计表达式进一步化简为

[0049][0050]

其它步骤及参数与具体实施方式一相同。

[0051]

具体实施方式三:本实施方式与具体实施方式一或二不同的是,所述步骤二中基于步骤一的信干比,构建车载雷达马尔可夫决策过程;具体过程为:

[0052]

步骤二一、构建马尔可夫决策过程环境模型;具体过程为:

[0053]

针对复杂的车载雷达电磁干扰环境,采用深度强化学习技术进行车载雷达波形参数选择,可以避免对复杂电磁环境的先验要求,深度强化学习可以用马尔可夫决策过程建模,在t时刻车载雷达所处的状态空间s

t

定义为[o

t

,o

t-1

,...,o

t-l

],其中l为组成状态空间的观测向量个数,o

t

=[r

t

,sir

t

,p

t

,a

t

]为t时刻的观测向量,r

t

为t时刻的回报函数,sir

t

为t时刻车载雷达接收信号的信干比,p

t

为t时刻环境中待探测干扰源相对于车载雷达的位置行向量(假设有w个干扰源,每个干扰源都有位置(x,y)坐标,我把w个坐标组合成一个大的行

向量,这样子我就能让ot是一个一维的方便后面神经网络输入),其中w为环境中待探测干扰源数量,为t时刻环境中第w个待探测干扰源相对于车载雷达的位置行向量,为t时刻环境中以车载雷达为参考系的第i个待探测干扰源(其他车上上安装的雷达)的笛卡尔坐标,i=1,2,

…

,w,a

t

为动作空间,代表s

t

状态下车载雷达所采用的雷达波形参数;

[0054]

步骤二二、基于步骤一的信干比,构造马尔可夫决策过程的回报函数和动作空间;具体过程为:

[0055]

马尔可夫决策过程的回报函数为

[0056]

其中sir0为设定的信干比阈值,sir

t

为t时刻车载雷达接收信号的信干比;

[0057]

马尔可夫决策过程的动作空间集合可以表示为a={a

t0

,a

t1

,...,a

tm

};

[0058]

其中m为动作空间个数,为动作空间集合中的第个动作(s

t

状态下车载雷达所采用的雷达波形参数,也是第个动作空间车载雷达发射的chirp信号的斜率),

[0059]

其它步骤及参数与具体实施方式一或二相同。

[0060]

具体实施方式四:本实施方式与具体实施方式一至三之一不同的是,所述步骤三中基于步骤二的车载雷达马尔可夫决策过程,构建并训练双深度q网络模型(基于深度强化学习的智能抗干扰网络模型);具体过程为:

[0061]

步骤三一、构建双深度q网络(ddqn网络)结构并初始化;

[0062]

步骤三二、采用评估网络控制车载雷达收集经验[r

t

,sir

t

,p

t

,a

t

];

[0063]

步骤三三、采用目标网络计算时间差分函数;

[0064]

步骤三四、构造时间差分误差函数并更新神经网络参数;

[0065]

步骤三五、重复执行步骤三二至步骤三四,直至收敛,得到训练号的双深度q网络模型。

[0066]

步骤三二、步骤三三和步骤三四是训练过程,步骤三二会不断收集模拟到的场景数据,放在经验池子里,然后步骤三三和步骤三四会不断构造损失函数loss进行更新。

[0067]

其它步骤及参数与具体实施方式一至三之一相同。

[0068]

具体实施方式五:本实施方式与具体实施方式一至四之一不同的是,所述步骤三一中构建双深度q网络(ddqn网络)结构并初始化;具体过程为:

[0069]

步骤三一一、构建双深度q网络模型(基于深度强化学习的智能抗干扰网络模型)(ddqn网络);具体过程为:

[0070]

ddqn网络采用q(s

t

,a

t

;w)和q-(s

t

,a

t

;w-)两个神经网络分别对评估网络和目标网络进行近似,能够有效解决传统深度q网络(deep q network,dqn)的高估问题;

[0071]

基于深度强化学习的智能抗干扰网络(ddqn网络)包括评估网络q(s

t

,a

t

;w)和目标网络q-(s

t

,a

t

;w-);

[0072]

评估网络q(s

t

,a

t

;w)依次包括一层卷积层和五层全连接层;

[0073]

t时刻车载雷达所处的状态空间s

t

输入评估网络q(s

t

,a

t

;w),经一层卷积层提取特

征,再经五层全连接层输出最优动作价值函数值;

[0074]

t时刻车载雷达所处的状态空间s

t

输入评估网络q(s

t

,a

t

;w),确定输入的状态空间s

t

,就确定了对应的a

t

,a

t

可能对应3个,a

t1

、a

t2

、a

t3

,评估网络输出q(s

t

,a

t

),找出3个q(s

t

,a

t

)中最大值,取q(s

t

,a

t

)最大值即为最优动作价值函数值,对应的a

t

为最优动作;

[0075]

目标网络q-(s

t

,a

t

;w-)采用和评估网络q(s

t

,a

t

;w)一样的网络结构,不过目标网络的参数更新滞后于评估函数;

[0076]

评估网络和目标网络中的输入s

t

为t时刻车载雷达所处的状态空间;

[0077]

评估网络和目标网络中的输出a

t

为s

t

状态下车载雷达所采用的雷达波形参数;

[0078]

w为评估网络待学习参数,w-为目标网络参数,目标网络参数不需要学习,周期性的将评估网络待学习参数w赋值给目标网络参数w-即可;

[0079]

所述ddqn(double deep q network)网络为双深度q网络;

[0080]

步骤三一二、初始化双深度q网络模型(基于深度强化学习的智能抗干扰网络);具体过程为:

[0081]

初始化的双深度q网络模型(刚开始评估网络和目标网络一起初始化为同一值)的网络参数包括经验回放库大小d,学习率lr,衰减ε-greedy策略中的ε0,回报衰减因子γ,一次更新学习大小batch_size,目标网络q-(s

t

,a

t

;w-)的参数滞后的更新步伐的次数阈值c(评估网络每次输入数据都会进行更新,而目标网络不是,目标网络是每经过c次训练才对目标网络进行一次更新,c为更新步伐的次数);

[0082]

ε0为初始探索率;c为更新步伐的次数阈值。

[0083]

其它步骤及参数与具体实施方式一至四之一相同。

[0084]

具体实施方式六:本实施方式与具体实施方式一至五之一不同的是,所述步骤三二中采用评估网络控制车载雷达收集经验[r

t

,sir

t

,p

t

,a

t

];具体过程为:

[0085]

在初始状态空间s

t

下根据衰减ε-greedy策略选择波形参数a

t

,然后环境给出回报函数r

t

(t时刻车载雷达所处的状态空间s

t

输入评估网络q(s

t

,a

t

;w),确定输入的状态空间s

t

,就确定了对应的a

t

,a

t

可能对应3个,a

t1

、a

t2

、a

t3

,评估网络输出q(s

t

,a

t

),找出3个q(s

t

,a

t

)中最大值,取q(s

t

,a

t

)最大值即为最优动作价值函数值,对应的a

t

为最优动作;选择动作a

t

后,仿真环境会收集会把对应的波形发射出去,然后模拟收到的回波信干比,然后算出回报给神经网络用),环境跳转到下一状态空间s

t+1

,结合t时刻的信干比估计sir

t

和t时刻环境中待探测干扰源相对于车载雷达的位置行向量p

t

,整合成经验[r

t

,sir

t

,p

t

,a

t

]存入经验池,直到存满经验池后进行batch_size大小的随机抽取学习;

[0086]

衰减ε-greedy策略可表示为p(s

t

,a

t

),其中ε0为初始探索率,n

exp

表示探索的总步数,k表示当前的探索步数,εk表示第k次探索对应的探索率。

[0087]

采用衰减ε-greedy策略能够有效权衡网络前期训练的探索性要求和后期网络的高效性要求;

[0088]

其它步骤及参数与具体实施方式一至五之一相同。

[0089]

具体实施方式七:本实施方式与具体实施方式一至六之一不同的是,所述步骤三三中采用目标网络计算时间差分函数;具体过程为:

[0090]

采用目标网络q-(s

t

,a

t

;w-)计算时间差分函数y

t

,

[0091]

其中γ表示折扣衰减因子,

·

表示乘法。

[0092]

时间差分函数y

t

和评估网络q(s

t

,a

t

;w)本质上都是对最优动作价值函数的近似,不过y

t

由于含有真实回报函数值r

t

而较q(s

t

,a

t

;w)更加准确,而q(s

t

,a

t

;w)需要学习更新参数w去不断接近y

t

。

[0093]

其它步骤及参数与具体实施方式一至六之一相同。

[0094]

具体实施方式八:本实施方式与具体实施方式一至七之一不同的是,所述步骤三四中构造时间差分误差函数并更新神经网络参数;具体过程为:

[0095]

构建时间差分误差函数e

t

=q(s

t

,a

t

;w)-y

t

,使用随机梯度下降方法对进行参数更新,同时当更新步伐达到c的整数倍时(第一次达到c时更新,第二次2c时更新等等),将评估网络q(s

t

,a

t

;w)中的参数w赋值给目标网络q-(s

t

,a

t

;w-);

[0096]

其中loss(w)表示双深度q网络模型的损失函数;c为更新步伐的次数阈值。

[0097]

其它步骤及参数与具体实施方式一至八之一相同。

[0098]

具体实施方式九:本实施方式与具体实施方式一至七之一不同的是,所述步骤四中突变的电磁干扰环境下基于双深度q网络模型(基于深度强化学习的智能抗干扰网络)参数在线自适应调整,得到突变条件下的电磁干扰环境下双深度q网络模型;具体过程为:

[0099]

步骤四一、双深度q网络模型动作空间限定;具体过程为:

[0100]

当模型训练完毕时,如果面临突变的电磁环境,模型的泛化性能大幅下降,可以对网络模型进行适当调整,限定动作空间实现模型的快速再收敛,具体方法如下:a表示电磁环境突变前的动作空间集合,表示突变前的最优的n个动作空间集合,是突变前t时间段内的模型波形参数应用最多的n组波形参数;电磁环境突变后,意味着动作集中的动作可以忽略,只需考虑中的动作集合,从而加速模型收敛;

[0101]

用电磁环境突变前的动作空间集合a减去突变前的最优的n个动作空间集合作为新的动作空间集合;

[0102]

步骤四二、双深度q网络模型探索策略修正;具体过程为:

[0103]

为了提高模型的前期探索度并保证模型训练后期的动作选择最优性,基于双深度q网络模型使用衰减ε-greedy策略在新的动作空间集合中进行动作选择,将εk中的当前探索步数置零,让k从零开始重新计数,确保衰减ε-greedy策略的探索性带入中,p

(s

t

,a

t

)取2个情况的值,中a

t

是新的动作空间集合中的动作);即选择最优的波形参数,当模型训练平稳后,ε-greedy策略趋向于贪心策略,策略探索概率将不断降低,如果电磁干扰环境突变,模型的泛化能力将大幅下降,此时需要重置衰减ε-greedy策略,让模型在环境突变时,在限定空间内进行大概率探索,实现模型快速再收敛;

[0104]

重复执行步骤三二、三三、三四,得到突变条件下的电磁干扰环境下双深度q网络模型。

[0105]

其它步骤及参数与具体实施方式一至八之一相同。

[0106]

实施例一:

[0107]

本发明针对存在相同调制方式、相似波形样式、重叠波形带宽等复杂电磁环境下的车载雷达干扰问题,构造车载雷达作用范围内存在4辆干扰车,即4个干扰源,干扰车相对于车载雷达进行匀速、减速、加速等多种动态运动场景的城市公路路段,通过深度强化学习实现对雷达波形参数的进行智能选择,进行在线可控的抗干扰设计。

[0108]

参阅图1,利用matlab和python仿真软件,本发明所述的一种基于双深度q网络的车载雷达抗干扰波形设计方法的仿真实验步骤如下:

[0109]

1.估计车载雷达接收信号的信干比

[0110]

1)给出车载雷达接收机接收到的目标回波信号和干扰信号的功率

[0111]

设车载雷达接收机接收到的目标回波信号的功率为pr,有

[0112][0113]

设车载雷达接收机接收到的干扰信号的功率为pi,有

[0114][0115]

其中p

t

表示车载雷达发射功率、g表示天线增益、σ表示目标的雷达截面积、r表示目标或干扰源到车载雷达接收机的距离,表示车载雷达天线的有效孔径,λ为车载雷达发射信号载波波长;

[0116]

仿真实验中,仿真实验中p

t

取值为10dbm,天线增益g为12dbi,σ取值为汽车雷达截面积典型值100m2,载波波长λ取值为3.947mm,目标与车载雷达之间的距离r波动范围为50m~100m;

[0117]

2)回波信号和干扰信号分别与原始发射信号进行混频

[0118]

车载雷达接收机接收到的目标回波信号与原始发射信号进行混频,得到频域表达式为

[0119][0120]

其中δ(

·

)为冲激函数,f

0,v

是车载雷达发射信号的载波频率,τ是回波信号的时延,kv为车载雷达发射的chirp信号的斜率;

[0121]

车载雷达接收机接收到的干扰信号与原始发射信号进行混频,得到频域表达式为

[0122][0123]

其中t

arr

为干扰信号进入雷达接收机带宽的有效时间,t

end

为干扰信号离开雷达接收机带宽的有效时间,k

if

是雷达发射机和干扰源发射的chirp信号的斜率之差的绝对值,为初始相位,rect(

·

)为幅值为1的矩形窗函数;

[0124]

仿真实验中,车载雷达发射信号的载波频率f

0,v

设置为76ghz,chirp斜率kv设置为{5.3

×

10

12

hz/s,6.3

×

10

12

hz/s,...,21.3

×

10

12

hz/s}集合中任意一个,间隔为1.0

×

10

12

hz/s,初始相位设置为0-2π的随机分布,以接收到雷达回波信号为时间起点,t

arr

设置为0-20us,且t

arr

<t

end

,假设雷达发射机和干扰源采用不一样的chirp斜率,所以k

if

取值为{5.3

×

10

12

hz/s,6.3

×

10

12

hz/s,...,21.3

×

10

12

hz/s}中任意两不相同斜率之差;

[0125]

3)得到雷达接收信号的信干比估计

[0126]

结合步骤2)中得到的回波信号与原始发射信号的混频频域表达式以及干扰信号与原始发射信号的混频频域表达式得到目标检测点处雷达接收信号的信干比估计为

[0127][0128]

其中,p

v-v

为检测点处目标回波信号的接收功率,p

i-v

为检测点处干扰信号引入的干扰功率,考虑到|exp[j(2πf

0,v

τ-πkvτ2)|和的值为1,其中δf为频域采样间隔,为单位幅值的矩形函数,所以信干比估计表达式可以近似为

[0129][0130]

由于结合步骤1)得到的回波信号功率pr和干扰信号功率pi以及δ2(f)表达式,信干比估计表达式进一步化简为

[0131][0132]

仿真实验中,δf的取值为135khz,车载雷达发射的chirp信号斜率波动范围为5.3

×

10

12

hz/s~21.3

×

10

13

hz/s,间隔为1.0

×

10

12

hz/s,k

if

是雷达发射机和干扰源发射的chirp信号的斜率之差的绝对值,其取值随着仿真环境的变化而变化;

[0133]

2.构建车载雷达马尔可夫决策过程

[0134]

1)构建马尔可夫决策过程环境模型

[0135]

针对复杂的车载雷达电磁干扰环境,采用深度强化学习技术进行车载雷达波形参数选择,可以避免对复杂电磁环境的先验要求,深度强化学习可以用马尔可夫决策过程建模,在t时刻的状态空间s

t

定义为[o

t

,o

t-1

,...,o

t-l

],其中l为组成状态空间的观测向量个数,o

t

=[r

t

,sir

t

,p

t

,a

t

]为t时刻的观测向量,r

t

为t时刻的回报函数,sir

t

为t时刻的信干比估计,p

t

为t时刻环境中待探测目标相对于车载雷达的位置行向量,其中w为环境中待探测干扰源数量,为t时刻环境中以车载雷达为参考系的第i个目标的笛卡尔坐标,a

t

为t时刻车载雷达采用的波形参数;

[0136]

仿真实验中w=4,l=7,为t时刻环境中第i个目标的笛卡尔坐标,初始化为[1m,50m,-2m,70m,0m,80m,-0.5m,90m];

[0137]

2)构造马尔可夫决策过程的回报函数和动作空间

[0138]

马尔可夫决策过程的回报函数为sir0为设定的信干比阈值,动作空间集合可以表示为a={k

v0

,k

v1

,...,k

vm

},其中m为动作空间个数,k

vi

,i=1,...,m为第i个动作空间车载雷达发射的chirp信号的斜率;

[0139]

仿真实验中sir0为15db,m=17,动作空间集合a={5.3

×

10

12

hz/s,6.3

×

10

12

hz/s,...,21.3

×

10

12

hz/s},间隔为1.0

×

10

12

hz/s;

[0140]

3.构建并训练基于深度强化学习的智能抗干扰网络模型

[0141]

1)构建ddqn网络结构并初始化

[0142]

(1)ddqn网络采用q(s

t

,a

t

;w)和q-(s

t

,a

t

;w-)两个神经网络分别对评估网络和目标网络进行近似,能够有效解决传统深度q网络(deep q network,dqn)的高估问题,目标网络q-(s

t

,a

t

;w-)采用和评估网络q(s

t

,a

t

;w)一样的网络结构,不过目标网络的参数更新滞后于评估函数;评估网络q(s

t

,a

t

;w)采用卷积网络和全连接网络形式,对状态s

t

进行卷积,进一步提取特征,再进行若干层全连接网络进行输出得到最优动作价值函数值;评估网络和目标网络中的输入参数s

t

为t时刻车载雷达所处的状态,a

t

为s

t

状态下车载雷达所采用的雷达波形参数,w为评估网络待学习参数,w-为目标网络参数,该参数不需要学习,周期性的将参数w赋值给w-即可;

[0143]

仿真实验中double-dqn网络结构采用一层卷积网络卷积网络和五层全连接网络形式,其中卷积核大小为2

×

2,卷积步长为1,采用全零填充,卷积通道数为32,拉平后经过5

层全连接层输出每个状态下的动作价值函数;

[0144]

(2)初始化的网络参数包括经验回放库大小d,学习率lr,衰减ε-greedy策略中的ε0,回报衰减因子γ,一次更新学习大小batch_size,目标网络q-(s

t

,a

t

;w-)的参数滞后更新步伐c;

[0145]

仿真实验中经验回放库大小d为5000,学习率lr设定为0.0001,衰减ε-greedy策略中的ε0设定为0.2,回报衰减因子γ设定为0.9,一次更新学习大小为batch_size设定为32,目标网络q-(s

t

,a

t

;w-)的参数滞后更新步伐为c设定为5;神经网络参数w用均值为0,方差为0.01的高斯随机函数初始化;

[0146]

2)采用评估网络控制车载雷达收集经验

[0147]

首先对评估网络q(s

t

,a

t

;w)随机初始化,在初始状态s

t

下根据衰减ε-greedy策略选择波形参数a

t

,然后环境给出回报函数r

t

,环境跳转到下一状态s

t+1

,结合t时刻的信干比估计sir

t

和位置向量p

t

,整合成经验[r

t

,sir

t

,p

t

,a

t

]存入经验池,直到存满经验库后进行batch_size大小的随机抽取学习,衰减ε-greedy策略可表示为其中ε0为初始探索率,n

exp

表示探索的总步数,k表示当前的探索步数,采用衰减ε-greedy策略能够有效权衡网络前期训练的探索性要求和后期网络的高效性要求;

[0148]

仿真实验中ε0取值为0.2,n

exp

取值为500000;

[0149]

3)采用目标网络计算时间差分函数

[0150]

采用目标网络q-(s

t

,a

t

;w-)计算时间差分函数y

t

,时间差分函数y

t

和评估网络q(s

t

,a

t

;w)本质上都是对最优动作价值函数的近似,不过y

t

由于含有真实回报函数值r

t

而较q(s

t

,a

t

;w)更加准确,而q(s

t

,a

t

;w)需要学习更新参数w去不断接近y

t

;

[0151]

4)构造时间差分误差函数并更新神经网络参数

[0152]

构建时间差分误差函数e

t

=q(s

t

,a

t

;w)-y

t

,使用随机梯度下降方法对进行参数更新,同时当更新步伐达到c的整数倍时,将评估网络q(s

t

,a

t

;w)中的参数w赋值给目标网络q-(s

t

,a

t

;w-);

[0153]

4.突变的电磁干扰环境下模型参数在线自适应调整

[0154]

1)模型动作空间限定

[0155]

当模型训练完毕时,如果面临突变的电磁环境,模型的泛化性能大幅下降,可以对网络模型进行适当调整,限定动作空间实现模型的快速再收敛,具体方法如下:a表示电磁环境突变前的动作空间集合,表示突变前的最优的n个动作空间集合,是突变前t时间段内的模型波形参数应用最多的n组波形参数,电磁环境突变后,意味着动作集中的动作可以忽略,只需考虑中的动作集合,从而加速模型收敛;

[0156]

仿真实验中n设置为5;

[0157]

2)模型探索策略修正

[0158]

为了提高模型的前期探索度并保证模型训练后期的动作选择最优性,模型使用的是持续衰减的ε-greedy策略进行动作选择,即选择最优的波形参数,当模型训练平稳后,ε-greedy策略趋向于贪心策略,策略探索概率将不断降低,如果电磁干扰环境突变,模型的泛化能力将大幅下降,此时需要重置衰减ε-greedy策略,让模型在环境突变时,在限定空间内进行大概率探索,实现模型快速再收敛。

[0159]

在无干扰环境下本发明方法目标检测的仿真结果如图2示,仿真实验中信噪比为30db,考虑四辆待测干扰车目标,在无干扰环境下,假设待测干扰源发射的雷达波无法干扰车载雷达,只充当待测目标作用,以车载雷达为参考点,它们相对于参考点的初始径向距离和径向速度组成的向量表示为[50m,-30m/s,80m,30m/s,110m,-20m/s,140m,-40m/s],四辆干扰车分别采取匀速、匀加速、匀减速、匀速运动,加速度向量表示为[0m/s2,5m/s2,-5m/s2,0m/s2],0.5s后真实的瞬时距离和瞬时速度可表示为[35m,-30m/s,64.375m,32.5m/s,100.625m,-17.5m/s,120m,-40m/s]。采用常规的2-dfft变换方法对干扰车进行目标检测,本发明方法0.5秒后的瞬时距离和瞬时速度估计值为[34.75m,-32.4m/s,64.25m,32.3m/s,100.5m,-17.4m/s,120.25m,-40.2m/s]。在复杂电磁干扰环境下本发明方法目标检测的仿真结果如图3所示,仿真实验中信噪比为30db,信干比为15db,估计值为[34.5m,-32.3m/s,64.0m,32.6m/s,101.0m,-17.6m/s,120.5m,-40.4m/s]。目标检测仿真实验结果表明,本发明方法具有较好的抗干扰性能。

[0160]

在信号带宽重叠50%,环境平稳情况下本发明方法与传统方法抗干扰成功率对比仿真结果如图4所示,其中方法1为本发明方法,方法2为传统的基于ddqn的波形参数选择方法,方法3为传统的随机发射波形方法。成功率定义为一次训练历程中波形选择正确的次数与总选择次数之比。从仿真图我们可以看出在平稳状态下,本发明方法和方法2具有类似的性能指标,都优于方法3。环境突变时的仿真结果如图5所示,在训练片段数等于280时候干扰环境突变,实验中将干扰源发射波形参数进行随机改变,将四个干扰源发射chirp斜率由原来的{5.3

×

10

12

hz/s,8.3

×

10

12

hz/s,14.3

×

10

12

hz/s,16.3

×

10

12

hz/s}随机变化为{5.3

×

10

12

hz/s,6.3

×

10

12

hz/s,7.3

×

10

12

hz/s,8.3

×

10

12

hz/s},此时由于模型泛化能力有限,导致方法1和方法2波形参数选择成功率下降,但是本发明方法由于采用了动作空间限定和探索策略重置方法使得模型的性能能够速度反弹,达到接近于环境平稳时的性能,而方法2没有采取任何措施,模型性能下降较大,同时需要较长时间收敛,且模型收敛时的性能不及平稳时的性能,方法3采用随机策略,与环境突变与否无关,性能无明显变化。

[0161]

在信号带宽重叠100%条件下,环境平稳情况下本发明方法与传统方法抗干扰成功率对比仿真结果如图6所示。环境突变时的仿真结果如图7所示。由于带宽完全重叠,干扰效果增加,导致在带宽重叠50%条件下可用的部分波形参数无法使用,从而导致方法1、方法2和方法3的性能均明显下降,但是它们的趋势和带宽重叠50%条件下一致。

[0162]

采用动作域限定和探索策略重置的本发明方法虽然在环境平稳条件下性能和方法2不相上下,但是本发明方法在面对突变的电磁环境时能够借助有效的动作域限定和高探索率重置算法进行快速再收敛,实现实时更新,体现了本发明方法较方法2和方法3的优势。综上所述,本实施例证明了所述的一种双深度q网络的车载雷达抗干扰波形设计方法的有效性和可靠性。

[0163]

本发明还可有其它多种实施例,在不背离本发明精神及其实质的情况下,本领域技术人员当可根据本发明作出各种相应的改变和变形,但这些相应的改变和变形都应属于本发明所附的权利要求的保护范围。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1