一种追踪机动目标的DDPG协同制导律设计方法与流程

本发明涉及协同制导领域,特别是涉及一种追踪机动目标的强化学习协同制导律。

背景技术:

1、对于机动目标的打击问题,在现有的研究成果中,主要有四类追踪机动目标的策略:

2、第一类是基于博弈论的协同制导方法,主要是两个或多个飞行器和目标的控制作用同时施加于一个由微分方程描述的运动系统时实现各自最优目标的对策过程,根据微分对策理论对多飞行器及多目标分别设计飞行器的最优协同追踪策略、目标的最优规避策略,搭建适用性较强的非线性飞行器-目标运动制导模型,并根据优化目标建立代价函数,代价函数的目标是使追踪飞行器的过载最小;

3、第二类是基于预测命中点的协同制导方法,根据对目标机动信息的提取,预测目标机动形式,解算预测命中点,将预测命中点作为虚拟目标点,转化为一个对低速甚至静止目标的制导问题,建立追踪目标与防御飞行器的三维相对运动学模型,采用传统的制导律与实时迭代的方式,在线求取预测命中点,并将其设定为虚拟目标,再设计制导律对虚拟目标实施追踪。预测制导策略建立在将高速来袭目标转化为低速虚拟目标的思想上,从而提高了追踪性能。在前置角较大的场景下,仍可以实现蓝方飞行器的迅速机动,及时完成追踪任务,增加了蓝方防御系统的有效防御范围;

4、第三类是基于鲁棒控制(自抗扰/滑模)的协同制导方法,考虑到目标机动,将其直接当做系统的干扰,采用扩张状态观测器观测系统扰动,设计误差的补偿控制器,实现协同,基于多智能体理论、自适应控制、鲁棒控制、自抗扰控制等理论,设计协同制导律,并根据“领从”式的制导架构,研究“领从”式的多飞行器协同制导律。首先根据对机动目标的追踪性能要求设计领飞行器的制导律,保证领飞行器实现有效打击任务;其次针对领从协同,在视线方向和视线法向分别设计从飞行器的协同制导律,实现时间的协同和最终同时打击;

5、第四类是基于覆盖的协同制导方法,主要是协调各枚飞行器的可行攻击区,使其覆盖目标的逃逸区,使得只要有一枚飞行器能够成功击中目标即可考虑了追踪飞行器自身的机动过载限制,在假设目标的机动策略未知而机动过载上限已知的情况下,提出基于最优覆盖的追踪大机动目标的协同制导律,通过虚拟目标点的设计,采用偏置比例导引法来导引多枚飞行器的可达区覆盖目标的机动逃逸区,来实现小机动目标对大机动目标的协同追踪。

6、然而,第一类基于博弈论的协同制导方法需要在制导过程中时刻知道目标的运动状态,甚至需要知道对方的角加速度信息,这在实际应用中难以做到;第二类基于预测命中点的协同制导方法需要基于提取的目标机动信息解算出预测命中点,这种方法适用于机动频率较低的目标,当目标多次机动时,需要频繁更换预测命中点,导致飞行器的需用过载偏大;第三类基于鲁棒控制的协同制导方法直接将目标的机动当做系统的干扰,虽然可以对干扰进行补偿,但这是一种滞后补偿的方法,也会导致飞行器的需用过载偏大;第四类基于覆盖的协同制导方法适用于追踪飞行器机动能力小于机动目标的问题,但只能确保一个飞行器可以命中机动目标。

技术实现思路

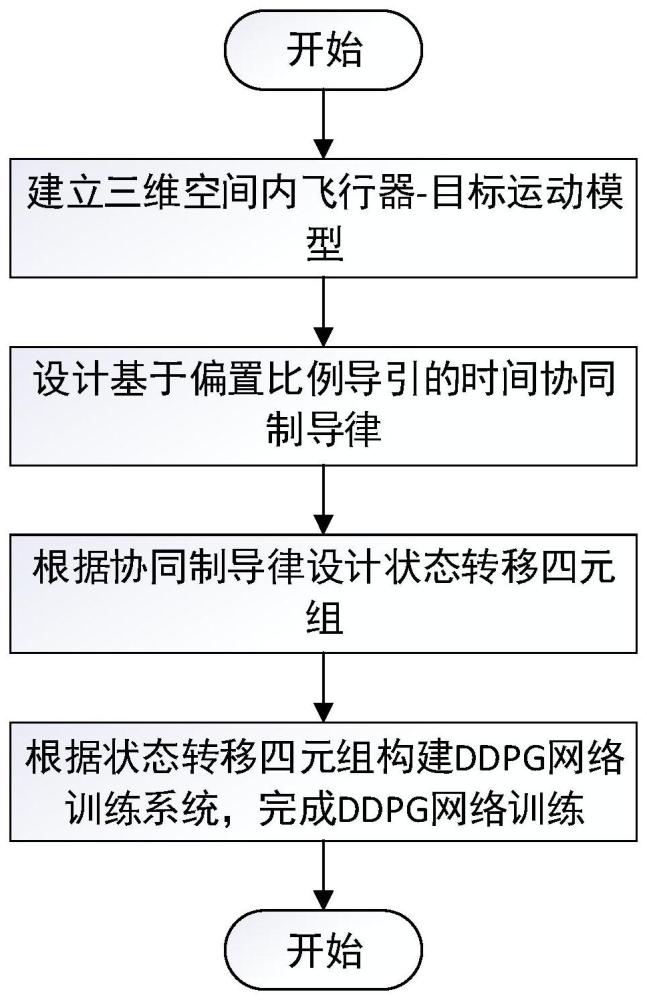

1、本发明的技术解决问题是:克服现有技术的不足,提出一种追踪机动目标的ddpg(deep deterministic policy gradient,深度确定性策略梯度算法)协同制导律确定方法,解决了追踪机动目标时协同制导律解析解难求解,无法协同追踪的问题。

2、本发明采用的技术解决方案是:

3、一种追踪机动目标的ddpg协同制导律确定方法,包括:

4、建立三维空间内飞行器-目标运动模型:将飞行器目标的运动关系投影到两个平面内,一个是包含第i个飞行器速度矢量的纵向平面omi,一个是侧向平面oxy,形成纵向平面omi的飞行器-目标相对运动方程组以及在侧向平面oxy的飞行器-目标相对运动方程组;

5、设计基于偏置比例导引的时间协同制导律;

6、根据时间协同制导律设计状态转移四元组;

7、构建时间协同制导律ddpg网络;

8、根据状态转移四元组,结合三维空间内飞行器-目标运动模型,完成时间协同制导律ddpg网络训练。

9、进一步的,

10、所述纵向平面omi的飞行器-目标相对运动方程组为:

11、

12、其中,为第i个飞行器与目标的距离变化率,ηm,i为飞行器i在纵向平面omi的前置角,φq,i为飞行器i视线角在纵向平面omi的分量,φm,i为第i个飞行器的速度倾角,为第i个飞行器的速度倾角变化率,φt,i为目标的速度倾角在纵向平面omi的投影分量,为目标的速度倾角在纵向平面omi的投影分量的变化率,am,lon,i为飞行器i的纵向加速度,ηt,i为目标在纵向平面omi的前置角,at,lon,i为目标相对于飞行器i的纵向加速度,ri为第i个飞行器与目标的距离,vm,lon,i和vt,lon,i分别为飞行器i和目标速度在纵向平面omi的分量,即:

13、

14、其中,vm为飞行器速度矢量,vt为目标速度矢量,σm,i为飞行器i在侧向平面oxy的前置角,σt,i为目标在侧向平面oxy的前置角。

15、进一步的,

16、在侧向平面oxy的飞行器-目标相对运动方程组为:

17、

18、其中,θq,i为飞行器i视线角在侧向平面的投影分量,θm,i为第i个飞行器的速度偏角,是第i个飞行器的速度偏角的变化率,θt为目标投影在侧向平面的速度偏角,是目标投影在侧向平面的速度偏角的变化率,am,lat,i为飞行器i的侧向加速度,at,lat为目标加速度在侧向平面的分量,vm,lat,i为飞行器i速度在侧向平面的分量,vt,lat为目标速度在侧向平面的分量,rlat,i为第i个飞行器和目标距离在侧向平面的投影分量,为第i个飞行器和目标距离在侧向平面的投影分量的变化率,即:

19、

20、其中,φt为目标的速度倾角。

21、进一步的,

22、所述时间协同制导律形式如下:

23、an,i=ap,i+aξ,i

24、式中,an,i为第i个飞行器的过载指令,ap,i为第i个飞行器过载指令的比例导引项,aξ,i为第i个飞行器过载指令的时间协同偏置项;

25、时间协同偏置项为:

26、aξ,i=kiriξi

27、其中,ki为调节系数,与飞行器-目标初始距离ri(0)以及初始剩余飞行时间估计值有关;ξi表示第i个飞行器的剩余飞行时间误差,两者的具体表达式为:

28、

29、

30、其中,ki为时间协同项调节因子,tgo.i=maxtgo,i,tgo,i为第i枚飞行器在通信拓扑中获取到的其邻居飞行器剩余飞行时间估计值的最大值,为第i枚飞行器的剩余飞行时间估计值,vi为弹目相对接近速度,θi为第i枚飞行器的前置角,n为过载指令中比例导引项的导航比,n∈[3,6]。

31、根据上面的分析,ki的具体取值与弹目相对位置相关,严重依赖专家设计,限制了时间协同制导律的泛化性,故采用强化学习的方法训练学习ki值的具体选择。

32、进一步的,

33、根据时间协同制导律,设计状态转移四元组mdp(s,a,r,γ),具体包括,

34、(1)状态s=[r1…ri…rn,ξ1…ξi…ξn,los1…losi…losn]

35、其中,ri表示第i个飞行器的飞行器-目标相对距离,n为飞行器数量,ξi表示第i个飞行器的剩余飞行时间误差、losi表示第i个飞行器的视场角,且

36、losi=arccos(cos(ηm,i)cos(σm,i))

37、(2)动作a=[k1…ki…kn]

38、式中,ki∈[0,3000],n为飞行器数量;

39、(3)奖励函数r=r1+r2+r3+r4+r5

40、其中,

41、tf为命中时刻的时间,rf为最小脱靶量,ξf为命中时刻的时间一致性误差,ξi(t)为t时刻的时间一致性误差,losmax是飞行器的最大视场角;

42、(4)γ为折扣因子。

43、进一步的,所述构建时间协同制导律ddpg网络,具体为:

44、时间协同制导律ddpg网络,包括预测策略网络目标策略网络预测价值网络目标价值网络其中s为当前时刻的状态,a为动作,s′为下一时刻的状态,θ、θ′、ω、ω′为网络参数;

45、其中预测策略网络将当前状态s作为输入、输出为当前状态s条件下的最优动作a,目标策略网络将下一状态s′作为输入、输出为下一状态s′条件下的最优动作a′,预测价值网络将当前的状态动作对(s,a)作为输入、输出为状态值函数q,目标价值网络将下一状态s′和目标策略网络的输出组成的状态动作对作为输入、输出为下一状态动作对的状态值函数q。

46、进一步的,完成对时间协同制导律ddpg网络训练,具体为:

47、s1、设计学习率α,软更新参数τ,最大训练局数num_episodes,经验回放池容量pool_size,批量大小batch_size;

48、s2、初始化赋值预测价值网络参数ω,预测策略网络参数θ,目标价值网络参数ω′=ω,目标策略网络参数θ′=θ,经验回放池:

49、s3、预测策略网络根据当前状态s选择最优动作a,执行动作a得到奖励r,转移到下一个状态s′,形成经验元组{s,a,r,s′,end},并存储到经验回放池d←d∪{(s,a,r,s′,end)},其中end是表示终止的逻辑变量,当经验回放池中的元组数量超过pool_size时,随机丢弃一个batch_size批量大小的元组;

50、s4、当经验回放池数量大于batch_size时,任取一个批量的训练数据

51、利用目标策略网络计算

52、si为当前时刻的状态,ai为当前时刻的动作,ri为状态为si动作为ai时的奖励值,s′i为下一时刻的状态,endi为表示终止的逻辑变量;

53、s5、计算目标价值

54、用作为训练数据训练预测价值网络和预测策略网络,对于批量的训练数据,预测价值网络的损失函数为:预测策略网络的损失函数为:其中,表示状态为si、动作为ai、预测价值网络参数为ω时的预测价值,表示策略πθ下的预测价值网络,表示预测策略网络的策略梯度;

55、s6、利用随机梯度下降方法,按照初始化设计的学习率α,以最小化损失函数l(ω)和j(θ)为目标,优化更新网络参数ω′和θ′,并进行软更新

56、s7、重复s3~s6,直到达到预设的训练次数或者达到收敛条件完成训练。

57、第二方面,本发明还提出一种存储介质,所述存储介质包括存储的程序,其中,在所述程序运行时控制所述存储介质所在设备执行所述的追踪机动目标的ddpg协同制导律确定方法。

58、第三方面,本发明还提出一种处理器,所述处理器用于运行程序,其中,所述程序运行时执行所述的追踪机动目标的ddpg协同制导律确定方法。

59、第四方面,本发明还提出一种计算机程序产品,该计算机程序产品被处理器执行时实现所述追踪机动目标的ddpg协同制导律确定方法的步骤。

60、本发明与现有技术相比带来的有益效果为:

61、(1)本发明引入强化学习的方法,通过离线训练的方式,能够在线自动求解过载指令中合适的时间协同项;

62、(2)本发明有效解决了现有技术面临的解析解难求解,时间协同项依赖专家经验的问题;

63、(3)本发明选择的ddpg强化学习方法,能够求解连续动作空间、连续状态空间的问题,能够有效提高求解精度。

- 还没有人留言评论。精彩留言会获得点赞!