一种基于深度信息的人形机器人分层AI导航避障方法与流程

本发明涉及人形机器人,具体涉及一种基于深度信息的人形机器人分层ai导航避障方法。

背景技术:

1、在人形机器人技术领域,对于腿部运动能力的关注点,当下重点在于行走、奔跑、跑酷等领域,但是未来将机器人应用于室内或室外执行任务时,上述运动能力与导航避障能力结合,是必须要实现的,当下相关研究还较少,因此该发明是具有前瞻性的。但是从算法角度和软硬件配合等角度来看,该能力的实现还具有诸多难点和限制,主要体现在以下几个方面:

2、算法框架设计:运动能力和避障能力的侧重点是不同的,将两种能力在人形机器人上进行有机结合,需要一套合理的算法框架来统筹,这是难点之一。

3、智能性:相比四足机器人、扫地机器人等其他形态的机器人,人形机器人的控制难度更高,同时对算法智能性要求也更高,如何提升机器人的智能性,是开发的关键点之一。

4、算法稳定性:机器人的导航能力和运动能力无法完全解耦,因此如何在多种导航避障场景下保持稳定的运动能力,以及在不同的运动形式下(如行走或奔跑)保持良好的避障性能,是开发的另一个难点。

5、成本控制:导航避障算法需要结合外部传感器来实现,可使用多种传感器,而不同传感器的价位和原理是完全不同的,常见的有激光雷达、rgb-d相机、超声波雷达等,量产产品在选取传感器时,需要考虑到成本限制、传感器数据的稳定性,以及算法的实现难度。

6、现有技术中的人形机器人在运行时普遍存在以下技术问题:

7、运动流畅性:目前企业和机构针对人形机器人运动能力的开发,深度强化学习是被普遍认可和采用的算法,但是在模拟人类运动的流畅性和鲁棒性方面还存在不足,尤其是在赋予机器人导航避障能力之后,对运动性能和流畅性的要求更高,现有的基于深度强化学习的步态控制算法表现还不够稳定。

8、指令跟随精度:现有技术中人形机器人速度的指令跟随精度还有待提升,无法满足上层导航指令的跟随性要求,因此还需对其进行优化。

9、避障实时性:机器人的导航避障能力,要求有较高的实时性,这对于传感器和算法都有较高的要求。在人形机器人领域,当前几乎没有相关参考算法,因此需要我们对避障实时性进行针对性地开发和设计。

10、泛化性:现有的基于深度强化学习的人形机器人运动控制方法,在不同场景下的泛化性还较为有限,导致在实际应用中可能出现性能下降或误差累积。

11、节能性:现有的人形机器人运动算法,能量消耗是比较高的,特别是在需要长时间运行的导航避障任务中,该问题会限制机器人的实用性。

12、虚拟到现实的转换:从虚拟环境到现实世界的转换过程中,机器人的运动控制策略可能无法直接应用,需要额外的调整和优化。

技术实现思路

1、为解决上述技术问题,本发明提出了一种基于深度信息的人形机器人分层ai导航避障方法,使得人形机器人在仅通过深度相机作为传感器的情况下,实现较好的导航和避障效果。

2、为实现上述目的,本发明采取的技术方案是:

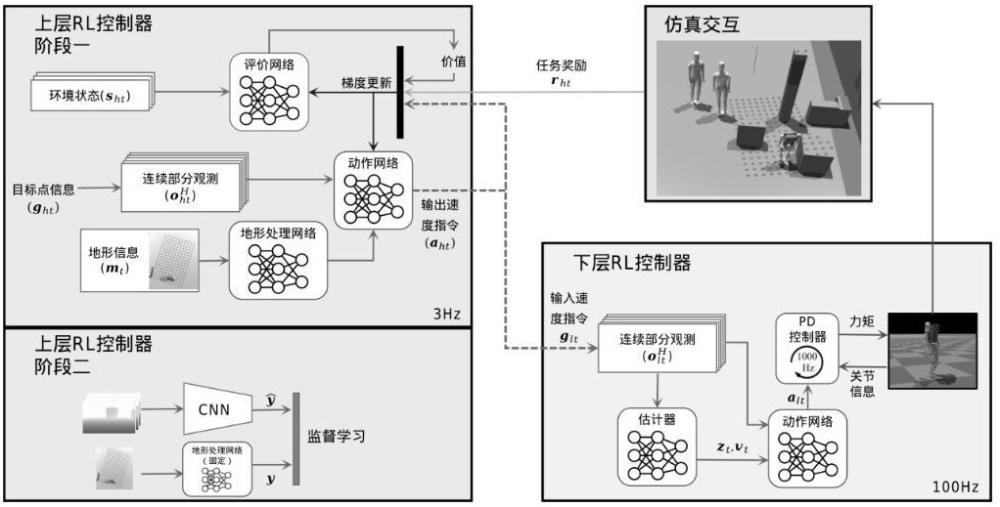

3、一种基于深度信息的人形机器人分层ai导航避障方法,其特征在于:设计上层强化学习模型和下层强化学习模型,其中,上层强化学习模型,用于将人形机器人的多种信息作为输入,并输出速度指令,输出的速度指令作为下层强化学习模型的指令输入,下层强化学习模型输出各个关节的力矩用于控制机器人运动,并包含了估计器、估计网络和下层策略网络,会对人形机器人当前的速度和角速度进行估计,与人形机器人本体信息进行融合后,可以在部署时估计出人形机器人的实时位置,

4、具体包括如下步骤:

5、s1、下层强化学习模型的训练

6、对下层策略网络和估计器进行训练,得到策略模型和估计器模型,下层策略模型基于amp框架来训练,且引入了状态估计器;估计器模型通过采用对比学习的方法来估计人形机器人自身的内部状态和环境状态,估计器包含了人形机器人的速度估计和隐式响应,它们通过对比学习被优化以接近人形机器人的后继状态,

7、基于对比学习的估计器训练模型训练如下:

8、正负样本对的定义:

9、在每次迭代中,收集每个环境的轨迹作为一批数据,如果ot+1和ot-h:t属于同一轨迹,则它们是正样本对;否则,它们是负样本对,

10、特征提取:

11、使用源编码器和目标编码器将历史观测ot-h:t和后继观测ot+1映射到高维空间的特征向量zs和zt,zt为隐向量,

12、归一化:

13、对特征向量进行l2归一化处理,以确保它们位于高维空间的单位球面上,

14、原型学习:

15、使用原型来预测特征向量所属的簇分配概率,原型是预先定义的、固定在特征空间中的点,用于帮助分类和对比学习,

16、优化目标:

17、优化目标是最大化预测精度,即最大化正样本对的匹配概率的对数似然和,公式如下:

18、

19、其中,和是源和目标向量的实际簇分配,和是预测的簇分配概率;

20、s2、上层强化学习模型的训练

21、s21、阶段一:基于仿真环境的核心训练阶段:

22、选用ppo算法对多个网络进行训练,

23、该ppo算法基于actor-critic框架,其中,actor为上层策略网络,输入为多帧观测信息其中,h为叠帧的数量,h=5,多帧观测信息中包含了目标点信息ght,目标点信息ght以人形机器人与目标点夹角的cos和sin值,以及当前与目标点之间的距离和初始任务距离的比例来表示,输出为动作aht,在进行训练后得到上层策略模型critic为评价网络,用于对当前的actor产生的动作进行好坏评价,

24、在上述两个网络的基础上,再训练一个用于对地形信息进行特征提取的地形处理网络,该网络的输入信息是人形机器人前方2m×3.2m范围内的地形高度图,为一系列的二维离散点,将其拉伸为一维向量mt后,形成地形高度图,

25、上述三个网络均为mlp网络,

26、通过假设期望的智能体行为,并结合环境信息,设计出适用上述三个网络的奖励函数,来对智能体的每一步进行好坏评价,得到具体的奖励值rht,

27、评价网络的输出值是对未来累积奖励期望值的估计值,而通过当前最新的策略网络与仿真环境进行交互,可以得到当前奖励的真实值vt,两者进行通过均方误差来计算损失,即可实现对评价网络的梯度更新,

28、动作网络的损失函数,是通过最小化旧策略和新策略之间的差异来实现的,具体公式是:

29、

30、其中,

31、·θ表示策略网络的参数。

32、·rt(θ)是策略比率(probability ratio),计算为新策略下动作的概率与旧策略下动作的概率的比值,即

33、·at是优势函数(advantage function)的估计值,表示在状态st下采取动作at的预期回报与当前策略下预期回报的差异

34、·clip(x,1-∈,1+∈)是一个裁剪函数,将值x限制在[1-∈,1+∈]范围内,用于减少策略更新的方差并提高算法的稳定性

35、·∈是一个超参数,用于控制裁剪的范围,通常设置为一个很小的值,如0.1或0.2

36、因此,最终的损失函数表达为:

37、

38、s22、阶段二:替换训练阶段:

39、把以地形高度图mt为输入的mlp地形处理网络替换为以深度图dt为输入的cnn地形处理网络,通过仿真采集与人形机器人机身周围地形一一对应的高度图mt、深度图dt和输出yt,构建数据集,并进行监督学习训练,

40、使用深度图dt作为输入的cnn网络来拟合一阶段中的地形高度图处理网络,用于实机部署;

41、s3、下层训练模型会对人形机器人当前的速度和角速度分别进行估计,与人形机器人本体信息进行融合后,在部署时估计出人形机器人的实时位置;

42、s4、在s2中得到的上层策略模型,在训练时可以直接从仿真环境拿到人形机器人自身的各种信息,在部署时,结合下层网络中估计器对位置和角度的估计和自身imu信息,来推算出状态信息,输入到上层策略网络中,进而输出速度指令,最终实现避障。

43、作为本发明的优选技术方案:在步骤s21中,所述核心训练阶段完全在仿真环境中进行。

44、作为本发明的优选技术方案:上层强化学习模型的决策频率为3hz,下层强化学习模型的动作频率为100hz,pd控制器的执行频率为1000hz。

45、上述结构中:本发明通过构建全新的算法架构,和一系列创新技术,实现了人形机器人在仅通过深度相机作为传感器的情况下,实现较好的导航和避障效果。

46、本发明通过采用分层训练架构,分别为上层强化学习模型和下层强化学习模型,上层强化学习模型为基于视觉的强化学习算法,将深度信息和任务信息等作为输入,输出速度指令,作为下层强化学习模型的指令输入,上层强化学习模型为导航避障层,同时,下层强化学习模型会对人形机器人当前的速度和角速度进行估计,与人形机器人本体信息进行融合后,可以在部署时估计出机器人的实时位置。

47、因此,上下两层是密切联系、相辅相成的,本发明在实施之前,需提前训练下层强化学习模型,在训练完成之后,下层强化学习模型中网络的参数是固定的。

48、下层强化学习模型:通过优化估计器的形式和算法,并且取消了相位信息的输入,使得人形机器人可以以更加拟人的步态进行运动,并且有非常高的稳定性,可以承受来自一个成年人的使劲推踹,承受力约为600n,通过上述优化,实现了人形机器人更加拟人的步态和更好的指令跟随性。

49、上层强化学习模型:分两阶段训练,一阶段基于仿真环境完成,将地形高度图和人形机器自身信息作为输入,速度作为输出,二阶段使用深度图作为输入的cnn网络来拟合一阶段中的地形高度图处理网络,用于实机部署。

50、本发明通过设置分层架构,使得人形机器人的导航避障能力可以与运动能力几乎解耦,网络也能分开训练,方便问题分析和优化,同时,上下层又有联系,下层强化学习模型对速度进行了估计,且估计精度很高,使得在没有外部定位的情况下,也可以估计出机身的速度和位置,上层强化学习模型则是通过对视觉图像的分析,来做出速度的调整,最终实现避障和导航。

51、深度图拟合:通过简单高效的监督学习的方式,便可以实现将地形高度图输入变为相机深度图输入,且无需修改框架内的其他网络,实现从仿真到现实的迁移。

52、与现有技术相比,本发明的有益效果为:

53、本发明通过构建全新的算法架构和一系列创新技术,实现了人形机器人在仅通过深度相机作为传感器的情况下,实现较好的导航和避障效果,具体如下:

54、开创性分层算法:

55、本发明采用的分层训练架构,可以在不同时间分别独立训练上下层,同时,下层的指令跟随性越好,速度估计的准确度越高,会使得上层模型的效果越佳,可以充分发挥下层步态的能力。

56、较高的运动稳定性:

57、本发明经过优化改动,使得下层模型实现原地站立,从站立无缝切换到行走,且有非常强的抗干扰能力。

58、步态拟人性:

59、通过模仿学习组件以及相应优化,显著提升了机器人模仿人类运动的准确性,使得机器人的运动更加贴近人类自然行为,如静止时保持站立

60、准确的避障效果:

61、本发明中的上层网络,可以精确输出指令,使得机器人可以根据当下深度图感知到的障碍物信息,进行避障,且反应灵敏。

62、准确的导航效果:

63、本发明中,通过在下层进行速度估计,并且与机器人本体实际信息进行融合,可以准确估计出机器人的当前位置,实现定点到达的效果。

64、泛化能力:

65、仿真环境中只使用了不同长宽高的块状物体作为障碍物,但是在实际测试中发现,机器人完全可以避开人和其他在仿真环境中没有出现过的障碍物

66、通过以上技术效果,本发明推动了人形机器人技术的发展,提升了人形机器人在未来的应用场景中的移动避障能力,为更多应用场景的实现提供了可能性,特别是在需要人形机器人与人类密切交互的场景中。

- 还没有人留言评论。精彩留言会获得点赞!