一种基于QMIX算法的自动化仓库多AGV多周期路径规划方法

本发明涉及agv路径规划,尤其是涉及一种基于qmix算法的自动化仓库多agv多周期路径规划方法。

背景技术:

1、近年来,随着电子商务平台的迅猛发展和消费习惯的改变,网络购物的用户数量持续攀升,带动了物流行业的快速增长。这些在线购买的商品通常需要从仓库发出,仓库因此成为了关键的商品中转站。然而,传统的仓库管理方式,如工人手动搬运或操作机械设备进行大型货物搬运,已经无法满足当前日益增长的物流需求。这些传统方法不仅管理复杂,效率低下,而且人力成本高昂。因此,寻找更高效、更经济的仓库管理方式已经成为行业内的紧迫需求。

2、为了应对仓储管理中的诸多挑战,智能物料搬运装备技术应运而生,尤其是自动导引车(automated guided vehicle,agv)在其中发挥了重要作用。agv利用先进的自动化设备、物联网、人工智能和大数据分析,实现了物料搬运的自动化和智能化操作。这些智能车辆能够在无需人工干预的情况下,自动完成货物的搬运、装卸和堆垛操作。

3、agv不仅显著提升了仓库的运营效率和订单准确性,降低了人力成本,还促进了仓库的科学管理和优化配置。通过精准的路径规划和灵活的调度系统,agv能够高效地在仓库内进行物料搬运,大幅减少了人工操作带来的误差和延迟。agv技术的应用不仅符合现代物流发展的趋势,更能适应未来智能物流的需求,为企业提供更强的竞争力和可持续发展能力。agv的广泛应用,也使得物流系统更具灵活性和响应能力,能够显著提升物流行业的整体效能。

4、为确保agv的可靠运行,有必要对agv进行准确的路径规划,路径规划是一种用于连接起始点和目标点的轨迹设计策略。现有技术中,常见路径规划算法包括传统路径规划算法、启发式路径规划算法、基于采样的路径规划算法和智能仿生学算法。但这些agv小车路径规划算法无法很好地应对多agv冲突的问题,对未知复杂环境的适用性较低,导致需要较高的人工参与度,因而其工作和运行效率较低,存在耗时长且无法求解大规模算例的问题。

技术实现思路

1、本发明的目的就是为了克服上述现有技术存在的缺陷而提供一种基于qmix算法的自动化仓库多agv多周期路径规划方法,能够针对多agv进行多周期的路径规划,提高多agv在复杂环境中的工作效率和准确性。

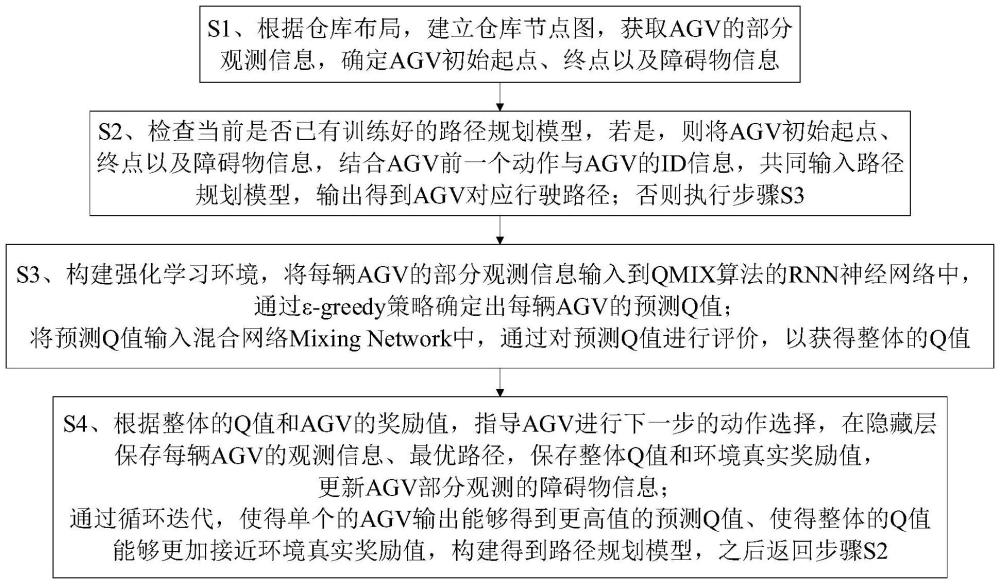

2、本发明的目的可以通过以下技术方案来实现:一种基于qmix算法的自动化仓库多agv多周期路径规划方法,包括以下步骤:

3、s1、根据仓库布局,建立仓库节点图,获取agv的部分观测信息,确定agv初始起点、终点以及障碍物信息;

4、s2、检查当前是否已有训练好的路径规划模型,若是,则将agv初始起点、终点以及障碍物信息,结合agv前一个动作与agv的id信息,共同输入路径规划模型,输出得到agv对应行驶路径;否则执行步骤s3;

5、s3、构建强化学习环境,将每辆agv的部分观测信息输入到qmix算法的rnn(recurrent neural network,循环神经网络)神经网络中,通过ε-greedy策略确定出每辆agv的预测q值;

6、将预测q值输入混合网络mixing network中,通过对预测q值进行评价,以获得整体的q值;

7、s4、根据整体的q值和agv的奖励值,指导agv进行下一步的动作选择,在隐藏层保存每辆agv的观测信息、最优路径,保存整体q值和环境真实奖励值,更新agv部分观测的障碍物信息;

8、通过循环迭代,使得单个的agv输出能够得到更高值的预测q值、使得整体的q值能够更加接近环境真实奖励值,构建得到路径规划模型,之后返回步骤s2。

9、进一步地,所述步骤s1中agv的部分观测信息具体为:

10、<i,s,a,t,r,o,ω,γ>

11、a={a1,a2,a3,...,an}

12、t(s,a,s′)=p(s′∣s,a)

13、

14、其中,i表示智能体的数量;s表示状态空间,其中包含了智能体与环境信息;a表示联合动作空间,其中ai表示智能体i所能采取的局部动作ai的集合;t为状态转移函数,t表示在状态s下,表示智能体采取联合动作a之后,转移到状态s′的概率函数;r为奖励函数,用以表示发生状态转移时智能体获得的奖励;o为观测空间,表示联合观测的集合,ot为时间t的观测集合,ω为观测函数;γ∈[0,1]为折扣因子。

15、进一步地,所述状态空间具体为:s=(s小车,s目的地,s障碍物),其中,agv的状态即位置坐标由表示,它由n个位置坐标元组构成,n为agv的数量;

16、agv目标的状态即目标位置坐标由表示,包括n个位置坐标元组,s小车和s目的地通过顺序一一对应,从而保证agv与目标点一一对应;

17、障碍物的状态即障碍物位置坐标由表示,包含了所有障碍物的位置坐标,由m个位置坐标元组构成,m为障碍物的数量;

18、所有的agv在0时刻处在初始位置,当某个坐标位置被agv或者障碍物占据时,其他agv将不可以到达该节点,即agv坐标位置以及障碍物坐标位置无法重合,当agv到达其目标位置后,会对应为其生成下一个目标位置并存入目标状态s障碍物中。

19、进一步地,所述观测空间具体为:o=(o障碍物,o小车,o目的地),将其分解为三个矩阵,即障碍矩阵、其他agv矩阵以及目标投影矩阵,障碍矩阵o障碍物包含了agv可观测距离内的障碍物信息,当观测范围内有障碍物时,矩阵中该部分会被置1,否则为0;

20、agv矩阵o小车包含了agv可观测范围内的其他agv信息,当观测范围内有其他agv时,矩阵中该部分会被置1,否则为0;

21、目标矩阵o目的地包含了agv目标点的位置信息,当目标点不在当前agv的观测范围内时,其为从agv指向目标点的一个向量在矩阵中的投影,且会显示在矩阵的边缘位置,即将该边缘位置1,其他位置为0;当目标点进入agv的观测空间内时,该目标点被置1,其他为0。

22、进一步地,所述步骤s2中路径规划模型包括多个rnn神经网络,多个rnn神经网络分别连接至混合网络,多个rnn神经网络分别对应于不同的agv,各rnn神经网络均包括输入层mlp(multilayer perceptron,多层感知器)、中间层gru(gated recurrent unit,门控循环单元)和输出层mlp,所述rnn神经网络的输入为每辆agv的观测空间、agv的动作编码以及agv的id,输出为该agv的q值;

23、所述混合网络包括推理网络和参数网络,推理网络的输入为所有agv的q值,输出为全局q值qtot,推理网络中权重和偏置参数由参数网络生成;

24、所述参数网络的输入为全局状态·st,输出为推理网络的权重w和偏置b;

25、所述混合网络最后一层的偏移量通过两层网络以及relu激活函数得到非线性映射网络,推理网络接收参数网络的参数后直接计算出全局q值qtot。

26、进一步地,所述步骤s3中rnn神经网络的工作过程包括:将每个agv的当前观测值、上一步的动作、以向量形式表示的每个agv的id的one-hot编码输入给输入层mlp、通过中间层gru接受第一层的输入和隐藏的历史信息,通过输出层mlp输出预测的q值。

27、进一步地,所述步骤s3中ε-greedy策略的计算公式为:

28、

29、其中,c+1表示agv动作空间的动作总数,a*表示使q值最大的动作,π(a|s)表示在π策略中agv在某个状态下的动作,即表示有ε的概率从c+1个动作中随机选择一个动作、包括使q值最大的动作,还有1-ε的概率直接选取使q值最大的动作,ε随着训练的进行不断减小,从而保证前期训练时,agv的动作选择更具备探索性,后期agv的动作选择更加稳定。

30、进一步地,所述步骤s4中agv的奖励值通过奖励函数计算得到:

31、r(s,a)=wtrt(s,a)-wprp(s,a)-wcrc(s,a)

32、

33、其中,rt为agv到达目标点所获得的奖励值,rp(s,a)表示移动惩罚,当agv移动时,会获取一定的惩罚值,从而鼓励agv采用尽可能少的移动次数到达目标点,rc(s,a)为冲突惩罚,当发生冲突时,会给予一个负的奖励值,从而使agv尽可能避免冲突,当agv到达目标后会获得奖励值1,即此时rt(s,a)=1,其余情况都会获得奖励值0,当发生冲突时,agv将无法通过目标点且获得冲突惩罚rc(s,a)。

34、进一步地,所述冲突包括节点冲突、跟随冲突、换位冲突和循环冲突。

35、进一步地,所述节点冲突具体是指:agv计划在同一时间步长占据同一节点;

36、所述跟随冲突具体是指:一辆agv计划占用在上一个时间步长中被另一辆agv占用的节点;

37、所述换位冲突具体是指:两辆agv计划在单个时间步长中交换位置;

38、所述循环冲突具体是指:每辆agv移动到一个以前被另一辆agv占据的顶点,形成一个“旋转循环”模式,也被称为死锁。

39、与现有技术相比,本发明具有以下优点:

40、本发明结合强化学习技术,将agv所观测到的观测空间(障碍、其它agv、终点)和前一个动作,agv的id作为对应rnn神经网络的输入,通过ε-greedy策略来预测下一步动作,并通过混合网络mixing network对预测的动作进行评估,从而得到当下最优的下一步动作。即引入agv的局部观测信息作为输入将其转化为观测矩阵,将观测矩阵输入rnn神经网络,输出每个agv的值函数q值,再通过参数网络接受全局信息生成参数,最后推理网络读取每辆agv的q值与参数网络的参数输出整体q值,从而实现集中式训练,分布式执行的目标,该方法解决了多agv在路径上冲突、死锁等问题,与此同时,通过合理的奖励函数设置可以减少agv的随机性和盲目性,使得agv能够选择高效的动作,能够有效解决现有路径规划算法耗时长且无法求解大规模算例的问题。

41、本发明使用局部观测的方式限制每辆agv的观测空间,将观测空间定义为o=(o障碍物,o小车,o目的地),即每辆agv只能观测到自己周围一个矩阵范围内的状态信息,将其分解为三个矩阵,即障碍矩阵、其他agv矩阵以及目标投影矩阵,三个矩阵共同构成了每辆agv在时间t的观测空间将每辆agv的观测空间由矩阵转化为向量,作为对应rnn神经网络的一个输入,能够使得后续训练得到的rnn网络具有更好的鲁棒性和可迁移性,从而适应于不同复杂环境。

42、本发明为了鼓励移动,设计不对移动设定惩罚值,当agv到达目标后会获得奖励值1,其余情况都会获得奖励值0,当发生冲突时,agv将无法通过目标点,从而鼓励其在规定时间内完成更多的任务、提升吞吐量,由于对应于每辆agv是否成功到达目标点,因此有利于快速准确计算整体成功率等评价指标、且更利于多周期完成任务数量的统计。

43、本发明将多个agv放入同一个元组的列表中,当一个agv完成一个周期后,它会进入下一个循环完成下一个任务,从而避免了当agv在仓库完成一个周期后被设定为停止或者消失。相比之下,传统的启发式算法主要是针对单周期的,与实际的环境不符。此外,本发明在qmix算法引入了防冲突的机制,从而减少或避免两个或者多个agv发生冲突,有效的提高了多agv在复杂环境中的工作效率。

- 还没有人留言评论。精彩留言会获得点赞!