学习程序、学习方法以及学习装置与流程

1.本发明涉及学习程序、学习方法以及学习装置。

背景技术:

2.在顺序学习等深度学习中,直接保存学习数据会带来信息泄漏等风险,因此以作为转换原始学习数据的形式的学习模型的特征量来保持。另外,在作为分别学习多个学习模型的学习数据,利用获取源不同的数据的情况下,也进行以特征量的形式来保持在之前的学习中利用的学习数据的处理。

3.像这样,在以特征量来保持的情况下,评价特征量中剩余多少原始学习数据的信息。例如,已知有在学习完毕的神经网络中求出特征量相同的输入数据,基于输入数据来推断通过特征量保持的信息,判断是否能够保持特征量的技术。

4.专利文献1:国际公开第二016/132468号

5.专利文献2:日本特开2017-174298号公报

6.专利文献3:日本特开2016-126597号公报

7.专利文献4:日本特开2017-126112号公报

8.然而,通过上述技术获得的输入数据未必是适合判断是否可以保持用于学习的学习数据的数据。例如,为了将输入数据x应用于学习完毕的学习模型而获得的特征量z转换为原始的输入数据x的形式,利用梯度法求出最佳地获得特征量z的输入数据x

′

。然而,由于存在多个获得某个特征量z的输入数据,所以利用梯度法获得的输入数据x

′

未必是对风险评价等的判断有用的数据。

技术实现要素:

9.在一个侧面,目的在于提供一种能够适当地进行数据保持的判断的学习程序、学习方法以及学习装置。

10.在第一方案中,学习程序使计算机执行如下处理:按照输入至学习模型的每个输入数据,根据多个特征量,使用与上述多个特征量中每个特征量对应的多个恢复器生成恢复数据,其中,与各输入数据对应地由上述学习模型生成多个特征量。学习程序使计算机执行如下处理:使上述多个恢复器学习,以使由上述多个恢复器分别生成的多个恢复数据中每个数据与上述输入数据接近。

11.根据一个实施方式,能够适当地进行数据保持的判断。

附图说明

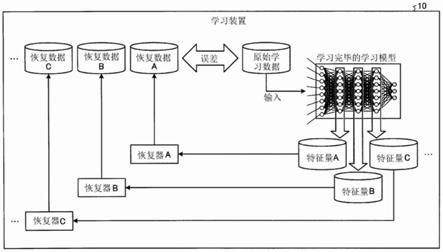

12.图1是对实施例1的学习装置的整体例进行说明的图。

13.图2是对参考技术进行说明的图。

14.图3是表示实施例1的学习装置的功能结构的功能框图。

15.图4是对学习模型的学习例进行说明的图。

16.图5是对特征量进行说明的图。

17.图6是对解码器的学习进行说明的图。

18.图7是对评价方法的一个例子进行说明的图。

19.图8是对评价方法的其它例子进行说明的图。

20.图9是表示处理的流程的流程图。

21.图10是对实施例2的学习例进行说明的图。

22.图11是对实施例3的学习例进行说明的图。

23.图12是对实施例4的学习例进行说明的图。

24.图13是对硬件构成例进行说明的图。

具体实施方式

25.以下,基于附图对本发明的学习程序、学习方法以及学习装置的实施例进行详细说明。此外,本发明并不被本实施例所限定。另外,各实施例能够在不矛盾的范围内适当地组合。

26.实施例1

27.[整体例]

[0028]

图1是对实施例1的学习装置的整体例进行说明的图。图1所示的学习装置10学习车、人等进行图像分类等的学习模型。具体而言,学习装置10为了执行使用机械学习、深度学习(深度学习(dl)

·

deep learning)等的学习处理,而能够对每个现象正确地辨别(分类)学习数据,学习神经网络(nn:neural network)等。

[0029]

一般地,在深度学习等中,由于学习数据的量越多学习模型越提高,所以学习数据的量越多越好,但另一方面,收集学习数据很难。因此,也考虑使用获取目的地不同的学习数据,来进行多个学习模型的学习。但是,在使用顾客数据的业务环境中,在学习某位顾客数据结束后还继续保持、或用于其它顾客任务(学习)等会带来合同上的问题、信息泄漏的风险。由于这样的原因,存在以作为转换原始学习数据的形式的特征量来保持的情况。通过以特征量来保持能够减少风险,但正确地评价特征量中剩有多少原始学习数据的信息很重要。

[0030]

因此,实施例1的学习装置10学习恢复器,该恢复器根据由学习模型生成的多个特征量来生成多个恢复数据,基于解码器的解码结果,来评价保持对象的特征量。具体而言,学习装置10对输入至学习模型的每个学习数据,根据与各学习数据对应地由学习模型生成的各特征量,使用与各特征量对应的恢复器来生成恢复数据。而且,学习装置10使多个恢复器学习,以使由多个恢复器分别生成的多个恢复数据中每个数据与学习数据接近。

[0031]

若以图1为例进行说明,则学习装置10使用多个学习数据中的每个数据,学习使用nn的学习模型。之后,学习装置10将用于学习模型的原始学习数据输入至学习完毕的学习模型,从nn的各中间层获取特征量a、特征量b、特征量c。然后,学习装置10将特征量a输入至恢复器a生成恢复数据a,以恢复数据a与原始学习数据的误差变小的方式,学习恢复器a。同样地,学习装置10将特征量b输入至恢复器b生成恢复数据b,以恢复数据b与原始学习数据的误差变小的方式,学习恢复器b。同样地,学习装置10将特征量c输入至恢复器c生成恢复数据c,以恢复数据c与原始学习数据的误差变小的方式,学习恢复器c。

[0032]

像这样,学习装置10使用将原始学习数据输入至学习完毕的学习模型而获得的各特征量,来学习各恢复器。然后,在各恢复器的学习完成后,学习装置10将各学习数据输入至学习完毕的学习模型来获取各特征量,将各特征量输入至学习完毕的各恢复器生成各恢复数据。之后,学习装置10基于各恢复数据的恢复程度,来决定可保持的特征量。

[0033]

即,学习装置10在深度学习中选择作为原始学习数据的代替而保存的特征量时,能够根据从各特征量解码的解码数据的解码程度,来选择所保持的特征量,所以能够适当地进行特征量保持的判断。

[0034]

[参考技术]

[0035]

在这里,作为评价保持对象的特征量的技术,对通常所利用的参考技术进行说明。首先,对参考技术和实施例1中均共用的针对神经网络的深度学习进行说明。

[0036]

深度学习是针对学习模型利用梯度法学习参数,以对训练数据x获得所希望的y的方法,其中,上述学习模型以具有能够对输入x进行微分的参数的函数转换而获得输出y。所谓的深度学习的学习模型并不限于由线性转换f(x)=ax+b和非线性激活函数g构成的模型y=g

n

(f

n

(

…

g1(f1(x))),也包含由任意的能够微分的运算h构成的模型h=h

n

(

…

h2(h1(x)))。

[0037]

接下来,对参考技术进行具体说明。图2是对参考技术进行说明的图。如图2所示,在参考技术中,在学习模型中将用于学习的原始学习数据输入至学习完毕的学习模型来生成特征量。接着,利用梯度法推断作为特征量的输入数据。例如,在将特征量设为z、将输入的学习数据设为x的情况下,利用梯度法计算推断数据x

※

=argmin

x d(f(x),z)。在这里,f是能够进行表示从x到z的转换的微分的学习模型的式子,d是能够进行微分的距离函数或者误差函数(平方误差)。

[0038]

之后,将推断数据输入至学习完毕的学习模型,获取与推断数据对应的推断特征量,以该推断特征量和根据原始学习数据获得的特征量的误差变小的方式来推断推断数据。这样的参考技术是根据特征量来推断原始学习数据的技术,由于能够根据一个特征量推断多个学习数据,所以无法判断特征量本身是否是可以保持的水平的特征量。因此,在实施例1中,通过生成用于判断特征量本身是否是可以保持的水平的特征量的指标,来改善参考技术的问题。

[0039]

[功能结构]

[0040]

图3是表示实施例1的学习装置10的功能结构的功能框图。如图3所示,学习装置10具有通信部11、存储部12、控制部20。

[0041]

通信部11是控制其它装置的通信的处理部,例如是通信接口等。例如,通信部11从管理者的终端接收处理开始指示。另外,通信部11从管理者的终端等接收作为学习对象的学习数据(输入数据)并储存至学习数据db13。

[0042]

存储部12是存储程序、数据的存储装置的一个例子,例如是存储器、硬盘等。该存储部12存储学习数据db13、学习结果db14。

[0043]

学习数据db13是存储用于学习模型的学习的学习数据的数据库。这里存储的学习数据可以是由管理者等赋予了正确答案标签的有标签数据,也可以是未赋予正确答案标签的无标签数据。此外,学习数据能够采用图像、视频、文档、图表等各种数据。

[0044]

学习结果db14是存储学习结果的数据库。例如,学习结果db14存储由控制部20进

行的学习数据的判别结果(分类结果)、通过机械学习、深度学习学习的各种参数。

[0045]

控制部20管理学习装置10整体的处理的处理部,例如处理器等。该控制部20具有模型学习部21、解码器学习部22、评价部23。此外,模型学习部21、解码器学习部22、评价部23是由处理器等所具有的电子电路、处理器等执行的工序的一个例子。

[0046]

模型学习部21是执行使用nn等的学习模型的学习的处理部。具体而言,模型学习部21使用存储于学习数据db13的学习数据来执行nn的学习,并将学习结果储存至学习结果db14。

[0047]

图4是对学习模型的学习例进行说明的图。如图4所示,模型学习部21读出存储于学习数据db13的带有正确答案标签的学习数据。然后,模型学习部21将学习数据输入至nn得到输出结果。之后,模型学习部21以输出结果与正确答案标签的误差变小的方式,学习nn。此外,学习方法能够采用梯度法、误差反向传播法等公知的方法。另外,模型学习部21也能够继续进行学习处理直到nn的判定精度为阈值以上,并能够在预先决定的次数、完成所有学习数据的学习等任意的时机结束。

[0048]

解码器学习部22是按每个解码器具有学习部,使用原始学习数据来学习各解码器的处理部,上述解码器是作为使用nn的学习模型的解码器,根据特征量来恢复数据。具体而言,解码器学习部22从学习结果db14读出各种参数,并构建包含设定有各种参数的神经网络等的学习模型。然后,解码器学习部22对作为学习模型的nn所具有的中间层的每一个设定解码器。然后,解码器学习部22利用各解码器根据各特征量生成恢复数据,并学习各解码器,以使各恢复数据与原始学习数据接近。

[0049]

在这里,使用图5和图6具体地进行说明。图5是对特征量进行说明的图,图6是对解码器的学习进行说明的图。在这里,如图5所示,对nn具有输入输入x的输入层、3个中间层以及输出y的输出层的情况进行说明。在该情况下,在第一个中间层获得的信息是特征量a,在第二个中间层获得的信息为特征量b,在第三个中间层获得的信息为特征量c。因此,解码器学习部22准备与特征量a对应的解码器a、与特征量b对应的解码器b、与特征量c对应的解码器c,并执行各解码器的学习。

[0050]

具体而言,如图6所示,解码器学习部22的解码器a学习部22a将原始学习数据输入至学习完毕的学习模型(nn),并获取特征量a。然后,解码器a学习部22a将特征量a输入至解码器a,生成恢复数据a。之后,解码器a学习部22a计算恢复数据a与原始学习数据的误差(以下有记载为恢复误差的情况),并以该误差变小的方式,学习解码器a。

[0051]

同样地,解码器学习部22的解码器b学习部22b将原始学习数据输入至学习完毕的学习模型(nn),获取特征量b。然后,解码器b学习部22b将特征量b输入至解码器b,生成恢复数据b。之后,解码器b学习部22b计算恢复数据b与原始学习数据的误差,以该误差变小的方式,来学习解码器b。

[0052]

同样地,解码器学习部22的解码器c学习部22c将原始学习数据输入至学习完毕的学习模型(nn),获取特征量c。然后,解码器c学习部22c将特征量c输入至解码器c,生成恢复数据c。之后,解码器c学习部22c计算恢复数据c与原始学习数据的误差,以该误差变小的方式,学习解码器c。

[0053]

此外,各学习部将解码器的学习结果储存至学习结果db14。另外,误差例如能够采用平方误差等,解码器的学习能够采用梯度法、误差反向传播法等。另外,解码器的学习也

能够继续学习处理直到nn的判定精度为阈值以上,并能够在预先决定的次数等任意的时机结束。另外,学习器的数量是一个例子,能够任意地设定变更。

[0054]

评价部23是对每个学习数据,使用学习完毕的各解码器评价各特征量的恢复的程度的处理部。具体而言,评价部23从学习结果db14读出与学习模型对应的各种参数,并构建包含设定有各种参数的神经网络等的学习模型,并且从学习结果db14读出与各解码器对应的各种参数,构建包含设定有各种参数的神经网络等的各解码器。然后,评价部23将保持对象的学习数据输入至学习完毕的学习模型,获取各特征量。接着,评价部23将各特征量输入至对应的学习完毕的解码器,生成各解码数据。然后,评价部23判定各解码数据的恢复状况,决定要保持的特征量。

[0055]

图7是对评价方法的一个例子进行说明的图。如图7所示,评价部23将原始学习数据输入至学习完毕的学习模型。而且,评价部23将从学习完毕的学习模型获得的特征量a、特征量b、特征量c分别输入至学习完毕的解码器a、学习完毕的解码器b、学习完毕的解码器c,生成恢复数据a、解码数据b、解码数据c。

[0056]

之后,评价部23计算恢复数据a与原始学习数据的平方误差a、恢复数据b与原始学习数据的平方误差b、恢复数据b与原始学习数据的平方误差c。然后,评价部23从平方误差a、平方误差b、平方误差c中确定小于允许保持的预先设定的阈值并且最接近阈值的平方误差b。其结果是,评价部23决定保持成为平方误差b的恢复源的特征量b。

[0057]

另外,评价部23也能够将恢复数据本身提示给作为原始学习数据的提供源的用户使其进行评价。图8是对评价方法的其它例子进行说明的图。如图8所示,评价部23利用与图7相同的方法,使用原始学习数据以及各恢复器,生成恢复数据a、解码数据b、解码数据c。而且,评价部23将恢复数据a、解码数据b、解码数据c提示给用户。在这里,用户判断为恢复数据a以及恢复数据c过度恢复,并判断为恢复数据b恢复到不知道原始学习数据的程度。在该情况下,评价部23决定为保持与恢复数据b对应的特征量b。此外,图8的方法在学习数据是图像数据等的情况下特别有效。

[0058]

[处理的流程]

[0059]

图9是表示处理的流程的流程图。如图9所示,模型学习部21若被指示处理开始(s101:是),则对学习模型进行初始化(s102)。

[0060]

接着,模型学习部21读入存储于学习数据db13的学习数据(s103),使用学习数据来学习学习模型(s104)。然后,在精度不是阈值以上的情况下(s105:否),模型学习部21返回到s103反复学习。另一方面,若精度为阈值以上(s105:是),则模型学习部21将学习结果输出至学习结果db14(s106)。

[0061]

之后,解码器学习部22若初始化各解码器(s107),则读入存储至学习数据db13的学习数据(s108),使用学习数据以及学习完毕的学习模型来学习各解码器(s109)。

[0062]

接着,在精度不是阈值以上的情况下(s110:否),解码器学习部22返回到s108反复学习。另一方面,若精度为阈值以上(s110:是),则解码器学习部22将学习结果输出至学习结果db14(s111)。

[0063]

之后,评价部23对保持对象的学习数据分别根据学习完毕的学习模型生成各特征量,并将各特征量输入至学习完毕的各解码器生成各解码数据,评价各特征量(s112)。

[0064]

[效果]

[0065]

如上所述,学习装置10能够使逆转换器学习而获得从特征量向原始数据的恢复器,并能够以使恢复数据与原始学习数据的误差直接最小化的方式学习。另外,学习装置10为了使保持对象的特征量和原始学习数据成为能够比较的形式,能够将特征量尽可能地转换为恢复到原始数据的形式。其结果是,学习装置10能够基于根据各特征量生成的恢复数据,适当地进行多个特征量中每个特征量的评价。

[0066]

实施例2

[0067]

然而,学习装置10的各解码器也能够学习向比自身所使用的特征量靠前的其它特征量的恢复,而不是原始学习数据。由此,能够减少各个恢复器的学习的难度的偏差。因此,在实施例2中,对不是学习向原始学习数据的恢复,而是向前面的特征量的恢复的例子进行说明。此外,这里对恢复到从前一个中间层输出的特征量的例子进行说明,但恢复对象并不限定于此,也可以是比与自身对应的中间层靠前的中间层。

[0068]

图10是对实施例2的学习例进行说明的图。如图10所示,解码器学习部22将原始学习数据输入至学习完毕的学习模型。于是,解码器a学习部22a将从学习完毕的学习模型输出的特征量a输入至解码器a生成恢复数据a,并以恢复数据a与原始学习数据的误差亦即恢复误差变小的方式,学习解码器a。

[0069]

另一方面,解码器b学习部22b将从学习完毕的学习模型获得的特征量b输入至解码器b,生成恢复到从前一个中间层获得的特征量a的恢复数据b。而且,解码器b学习部22b以从前一个中间层获得的特征量a与恢复数据b的误差亦即恢复误差变小的方式,来学习解码器b。另外,对于解码器c也同样地、解码器c学习部22c将从学习完毕的学习模型获得的特征量c输入至解码器c,生成恢复到从前一个中间层获得的特征量b的恢复数据c。而且,解码器c学习部22c以从前一个中间层获得的特征量b与恢复数据c的误差亦即恢复误差变小的方式,学习解码器c。

[0070]

此外,在各解码器的学习后执行的特征量的评价能够采用与实施例1相同的方法。例如,评价部23计算恢复数据a与原始学习数据的平方误差a、恢复数据b与特征量a的平方误差b、恢复数据c与特征量b的平方误差c,并基于阈值,来决定所保持的特征量。

[0071]

实施例3

[0072]

然而,学习装置10在恢复器的学习时,也可以不是使用恢复数据与原始学习数据的误差,而是使用再次转换为特征量时的误差来学习。由此,能够考虑特征量转换的方法,来学习恢复器,恢复数据的恢复精度提高的结果是也能够提高特征量的评价精度。

[0073]

图11是对实施例3的学习例进行说明的图。如图11所示,解码器学习部22将原始学习数据输入至学习完毕的学习模型。于是,解码器a学习部22a将所输出的特征量(原始特征量a)输入至解码器a生成恢复数据a,计算恢复数据a与原始学习数据的误差亦即恢复误差a1。

[0074]

接着,解码器学习部22将恢复数据a输入至学习完毕的学习模型。然后,解码器a学习部22a获取从学习完毕的学习模型输出的特征量(恢复特征量a),并计算原始特征量a与恢复特征量a的误差亦即恢复误差a2。之后,解码器a学习部22a以恢复误差a1以及恢复误差a2变小的方式,学习解码器a。此外,也能够仅使用恢复误差a2来执行学习。另外,对于其它解码器也同样地使用2个恢复误差来执行学习。

[0075]

实施例4

[0076]

然而,在实施例1-3中,对在结束学习模型的学习后,执行各解码器的学习的例子进行了说明,但并不限定于此。例如,也能够并行地学习学习模型和各解码器。

[0077]

图12是对实施例4的学习例进行说明的图。如图12所示,若向学习模型输入赋予了正确答案标签的学习数据,则学习装置10并行地执行学习模型和各解码器的学习。

[0078]

具体而言,模型学习部21若输入学习数据,则以正确答案标签与输出标签的误差变小的方式,学习学习模型。与该动作并行地、解码器a学习部22a将从学习模型获取的特征量a输入至解码器a生成恢复数据a,以恢复数据a与原始学习数据的恢复误差变小的方式,学习解码器a。同样地,解码器b学习部22b将从学习模型获取的特征量b输入至解码器b生成恢复数据b,以恢复数据b与原始学习数据的恢复误差变小的方式,学习解码器b。

[0079]

像这样,学习装置10由于能够使用各学习数据,同时平行地学习学习模型和各解码器,所以能够缩短总学习时间。

[0080]

实施例5

[0081]

那么,以上对本发明的实施例进行了说明,但本发明除上述的实施例以外,也可以以各种不同的方式来实施。

[0082]

[解码器的学习数据]

[0083]

在上述实施例中,对将用于学习模型的学习的学习数据也用于解码器的学习的例子进行了说明,但并不限定于此,也能够使用不同的学习数据来学习学习模型的学习和解码器的学习。

[0084]

例如,学习装置10使用数据x来学习学习模型,并生成学习完毕的学习模型m。接着,学习装置10向学习模型m输入数据x,获取数据x的特征量x。之后,学习装置10将作为其它数据的数据y输入至学习模型m,获取数据y的特征量y。然后,学习装置10利用与实施例1相同的方法,使用数据y和特征量y来学习恢复器r。

[0085]

之后,学习装置10向学习完毕的恢复器r输入特征量x生成恢复数据x

′

。然后,学习装置10利用与实施例1相同的方法对原始的数据x和恢复数据x

′

进行比较,评价特征量x。

[0086]

通过这样,在利用数据x学习的学习完毕模型以及数据x的特征量泄漏时,学习装置10能够评价得到它们的第三方能够将数据x本身恢复到何种程度。例如,若考虑到由第三方进行的数据恢复,则由于第三方保持学习数据x的特征量,但不具有学习数据x本身,所以尝试根据所拥有的其它数据y和将数据y通过学习模型而获得的数据y的特征量来学习恢复器。之后,考虑第三方向进行了学习的恢复器输入数据x的特征量,尝试原始数据x的恢复。

[0087]

针对于此,学习装置10能够评价由使用与学习模型m的学习数据不同的数据恢复的恢复器根据特征量恢复的学习数据的恢复程度。因此,学习装置10能够执行也考虑了信息泄漏时的危险性的评价。

[0088]

[学习模型、解码器]

[0089]

在上述实施例中,以将nn应用于学习模型以及解码器的情况为例进行了说明,但并不限定于此,也能够采用其它的一般的深度学习、机械学习。另外,nn的学习方法能够采用反向误差传播方法等公知的各种方法。另外,对于在学习nn时计算的误差,能够采用如平方误差等那样,在深度学习的学习时所利用的公知的各种误差计算方法。另外,各nn的中间层的数量、特征量的数量、恢复器的数量等只是一个例子,能够任意地设定变更。另外,不仅可以对nn的每个中间层设置恢复器,还可以仅对nn的多个中间层中的指定的中间层设置恢

复器。另外,作为上述的特征量的一个例子,在学习对象为图像的情况下,可举出图像内的边缘、对比度、图像内的眼睛、鼻的位置等。

[0090]

[评价对象]

[0091]

在上述实施例中,对于各学习数据,对进行特征量的评价的例子进行了说明,但并不限定于此,也可以仅对由管理者等指定的学习数据进行上述特征量的评价,判定能否保持。

[0092]

[系统]

[0093]

除非另有说明,否则对于在上述文档中、附图中所示的处理步骤、控制步骤、具体的名称、包含各种数据、参数的信息能够任意地变更。另外,在实施例中说明的具体例、分布、数值等只是一个例子,能够任意地变更。

[0094]

另外,图示出的各装置的各构成要素是功能概念性的要素,未必一定在物理上如图示那样构成。即,各装置的分散、统一的具体方式并不限于图示的方式。换句话说,能够根据各种负荷、使用状况等,将其全部或者一部分以任意的单位功能性或者物理地分散/统一而构成。进一步,在各装置中进行的各处理功能的全部或者任意的一部分由cpu以及由该cpu解析执行的程序来实现、或者可以作为由有线逻辑构成的硬件来实现。

[0095]

[硬件]

[0096]

图13是对硬件构成例进行说明的图。如图13所示,学习装置10具有通信装置10a、hdd(hard disk drive:硬盘驱动器)10b、存储器10c、处理器10d。另外,图13所示的各部通过总线等相互连接。

[0097]

通信装置10a是网络接口卡等,进行与其它装置的通信。hdd10b存储使图3所示的功能动作的程序、db。

[0098]

处理器10d通过从hdd10b等读出与图3所示的各处理部相同的处理的程序并在存储器10c中展开,使执行在图3等中说明的各功能的工序动作。即,该工序执行与学习装置10所具有的各处理部相同的功能。具体而言,处理器10d从hdd10b等读出具有与模型学习部21、解码器学习部22、评价部23等相同的功能的程序。而且,处理器10d执行进行与模型学习部21、解码器学习部22、评价部23等相同的处理的工序。

[0099]

像这样,学习装置10作为通过读出程序并执行来执行学习方法的信息处理装置来动作。另外,学习装置10通过利用介质读取装置从记录介质读出上述程序,并执行所读出的上述程序也能够实现与上述的实施例相同的功能。此外,在该其它实施例中所说的程序并不限定于由学习装置10执行的程序。例如,在其它计算机或者服务器执行程序的情况下、这些结构配合执行程序的情况下,也能够同样地应用本发明。

[0100]

该程序能够经由因特网等网络分发。另外,该程序记录于硬盘、软盘(fd)、cd-rom、mo(magneto-optical disk:磁光盘)、dvd(digital versatile disc:数字多功能光盘)等计算机可读取的记录介质,能够通过计算机从记录介质读出而执行。

[0101]

附图标记说明:10

…

学习装置;11

…

通信部;12

…

存储部;13

…

学习数据db;14

…

学习结果db;20

…

控制部;21

…

模型学习部;22

…

解码器学习部;22a

…

解码器a学习部;22b

…

解码器b学习部;22c

…

解码器c学习部;23

…

评价部。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1