一种数据容灾方法、装置、设备及介质与流程

1.本技术涉及计算机技术领域,尤其涉及一种数据容灾方法、装置、设备以及计算机可读存储介质。

背景技术:

2.随着用户对数据安全性的要求越来越高,越来越多的应用采用集群方式进行数据存储。例如,采用etcd集群进行数据存储。etcd集群是一个分布式系统,一般包括多个节点。多个节点之间相互通信构成整体对外服务。其中,每个节点存储有完整的数据,而且节点之间采用一致性协议如raft协议保证每个节点维护的数据是一致的。

3.上述分布式系统如果部署在单个数据中心,则可能存在数据中心的基础设施如水、电、网络等发生故障,导致无法对外提供服务的问题。为此,业界常常将分布式系统部署在两个独立的数据中心,以提高可用性。

4.一种典型的部署方式是将两个节点部署于一个数据中心,一个节点部署于另一个数据中心,从而形成三节点集群。当部署有两个节点的数据中心故障时,集群可能无法对外提供服务,难以满足高可用性需求。

技术实现要素:

5.本技术提供了一种数据容灾方法,该方法解决了双数据中心架构的集群在部署有较多节点的数据中心故障时,无法对外提供服务的问题,满足了高可用性需求。本技术还提供了该数据容灾方法对应的装置、设备、计算机可读存储介质以及计算机程序产品。

6.第一方面,本技术提供了一种数据容灾方法。该方法应用于第一数据中心和第二数据中心。其中,第一数据中心部署有m个节点,第二数据中心部署有n个节点。m为偶数,n为奇数,m大于n。所述第一数据中心的m个节点和所述第二数据中心的n个节点形成第一集群,该第一集群基于第一集群中的领导节点提供服务。

7.第二数据中心可以获取第一数据中心的工作状态,当第一数据中心的工作状态指示第一数据中心故障时,第二数据中心启动第二集群(第一集群的子集群)以通过第二集群的领导节点提供服务。该第二集群的领导节点为n个节点中的一个节点,第二集群的领导节点用于维护数据在所述第二集群中n个节点之间的一致性。

8.如此,第一数据中心故障时,应用仍能通过第二集群对外提供服务,解决了相关技术中由于只剩一个节点无法选出领导节点导致集群无法对外提供服务的问题。此外,第二数据中心故障时,第一集群中仍有过半的节点工作,能够正常对外提供服务。也即第一数据中心和第二数据中心中的任一个故障时,均可以对外提供服务,满足了高可用性的要求。

9.其中,第二集群可以预先创建,然后在第一数据中心故障时激活该第二集群。在一些可能的实现方式中,第二数据中心可以在第一数据中心故障时创建第二集群,然后激活该第二集群。第二集群的创建时间不影响本技术的具体实现。

10.在一些可能的实现方式中,当所述第一数据中心恢复时,所述第二数据中心可以

将所述第一数据中心的节点添加至所述第二集群。如此,可以实现第一数据中心的m个节点和第二数据中心的n个节点之间的数据一致性,进一步提高应用可用性。

11.在一些可能的实现方式中,第二数据中心可以向仲裁节点发送查询请求,该查询请求用于查询所述第一数据中心的工作状态,然后接收所述仲裁节点发送的查询响应,从而实现从查询响应中获得第一数据中心的工作状态。

12.在一些可能的实现方式中,第二数据中心从故障中恢复时,第二数据中心还可以从第二数据中心部署的n个节点中确定所述第一集群的领导节点。具体地,第二数据中心可以响应于所述第一数据中心的节点触发的领导节点转移操作,从所述第二数据中心中确定领导节点。也即,第二数据中心正常时,始终以第二数据中心中的节点为领导节点,从而保障第二数据中心故障或者正常时,写入到第二数据中心的节点的数据是完整的。第一数据中心和第二数据中心均可以保存完整的数据,保障了数据一致性。

13.在一些可能的实现方式中,第一数据中心包括2k个节点,第二数据中心包括2k-1个节点。所述k为正整数。作为一个示例,k可以取值为1或2,对应地,第一集群可以是3节点集群或者7节点集群。第一集群为3节点集群时,所述第一数据中心包括2个节点,所述第二数据中心包括1个节点。第一集群为7节点集群时,所述第一数据中心包括3个节点,所述第二数据中心包括4个节点。如此,可以实现容错能力和性能的均衡。

14.第二方面,本技术提供了一种数据容灾装置。该装置应用于第一数据中心和第二数据中心。第一数据中心部署有m个节点,第二数据中心部署有n个节点。m为偶数,n为奇数,m大于n。第一数据中心的m个节点和第二数据中心的n个节点形成第一集群,第一集群基于第一集群中的领导节点提供服务。

15.所述装置包括通信模块和启动模块。其中,通信模块用于获取所述第一数据中心的工作状态,启动模块用于当所述第一数据中心故障时,启动第二集群以通过所述第二集群的领导节点提供服务。所述第二集群的领导节点为所述n个节点中的一个节点,所述第二集群的领导节点用于维护数据在所述第二集群中n个节点之间的一致性。

16.在一些可能的实现方式中,所述装置还包括:

17.添加模块,用于当所述第一数据中心恢复时,将所述第一数据中心的节点添加至所述第二集群。

18.在一些可能的实现方式中,所述通信模块具体用于:

19.向仲裁节点发送查询请求,所述查询请求用于查询所述第一数据中心的工作状态;

20.接收所述仲裁节点发送的查询响应,所述查询响应包括所述第一数据中心的工作状态。

21.在一些可能的实现方式中,所述装置还包括:

22.确定模块,用于所述第二数据中心从故障中恢复时,从所述第二数据中心中确定所述第一集群的领导节点。

23.在一些可能的实现方式中,所述第一数据中心包括2k个节点,所述第二数据中心包括2k-1个节点,所述k为正整数。作为一个示例,k可以取值为1或2。k取值为1时,所述第一数据中心包括2个节点,所述第二数据中心包括1个节点,k取值为2时,所述第一数据中心包括4个节点,所述第二数据中心包括3个节点。

24.第三方面,本技术提供一种设备,所述设备可以是服务器、云服务器等计算机设备。所述设备包括处理器和存储器。所述处理器、所述存储器进行相互的通信。所述处理器用于执行所述存储器中存储的指令,以使得所述设备执行如第一方面或第一方面的任一种实现方式中的数据容灾方法。

25.第四方面,本技术提供一种计算机可读存储介质。所述计算机可读存储介质中包括指令,所述指令指示执行上述第一方面或第一方面的任一种实现方式所述的数据容灾方法。

26.第五方面,本技术提供了一种包含指令的计算机程序产品。所述计算机程序产品在设备如计算机设备上运行时,使得设备执行上述第一方面或第一方面的任一种实现方式所述的数据容灾方法。

27.本技术在上述各方面提供的实现方式的基础上,还可以进行进一步组合以提供更多实现方式。

附图说明

28.为了更清楚地说明本技术实施例的技术方法,下面将对实施例中所需使用的附图作以简单地介绍。

29.图1为本技术实施例提供的一种数据容灾方法的系统架构图;

30.图2为本技术实施例提供的一种数据容灾方法的流程图;

31.图3为本技术实施例提供的一种数据容灾方法的系统架构图;

32.图4为本技术实施例提供的一种数据容灾方法的系统架构图;

33.图5为本技术实施例提供的一种数据容灾装置的结构示意图;

34.图6为本技术实施例提供的一种设备的结构示意图。

具体实施方式

35.下面将结合本技术中的附图,对本技术提供的实施例中的方案进行描述。

36.本技术的说明书和权利要求书及上述附图中的术语“第一”、“第二”等是用于区别类似的对象,而不必用于描述特定的顺序或先后次序。应该理解这样使用的术语在适当情况下可以互换,这仅仅是描述本技术的实施例中对相同属性的对象在描述时所采用的区分方式。

37.为了便于理解本技术的技术方案,下面对本技术涉及的一些技术术语进行介绍。

38.数据容灾是一种保护数据安全以及提高数据持续可用性的技术。数据容灾通常是通过对数据进行备份,实现保障数据安全以及提高数据持续可用性。根据数据备份方式不同,数据容灾一般可以分为不同的等级。例如将数据备份在本地的磁带机以及将数据备份在异地的数据中心的容灾等级显然是不同的,后者容灾能力明显高于前者。

39.数据中心(data center)是一种用于传递、加速、展示、计算以及存储数据的基础设施。该基础设施可以理解为提供电源、网络、散热系统及其他服务的机房。数据中心中部署有节点,节点是实现数据计算和/或存储的设备,数据中心通过部署在其中的节点实现数据传递、加速、展示、计算以及存储等功能。其中,节点可以是物理设备,例如服务器。当然,节点也可以是逻辑设备,如服务器上的虚拟机(virtual machine,vm)等等。数据中心为节

点提供电源以及网络服务,以保障节点能够正常对外提供服务。

40.考虑到数据安全性和持续可用性,许多应用采用双数据中心架构,防止单个数据中心故障导致无法提供服务。在双数据中心架构下,两个数据中心可以同时接受交易,处理相同数据。当一个数据中心发生故障时,交易可以在另一个数据中心继续进行,无需进行系统切换。

41.其中,数据中心故障时切换到另一个数据中心的关键即在于两个数据中心之间保持数据一致性。两个数据中心一般可以通过建立集群的方式保持数据一致性。为了便于理解,本技术实施例以etcd集群进行示例说明。

42.etcd集群是用于共享配置和服务发现的分布式存储系统。etcd集群使用raft协议来维护集群内各个节点状态的一致性。raft协议也称作raft算法,该算法属于一种共识算法(consensus algorithm)。所谓共识是指即使在部分节点故障、网络延时或者网络分割等情况下,多个节点对某个事情达成一致的看法。一般情况下,etcd集群中超过一半的节点对某个事情达成一致的看法,则认为该看法是可信的。例如,etcd集群中包括4k-1个节点,k为正整数时,如果有2k个节点对写入数据达成一致的看法,则etcd集群中的各节点可以写入数据。即使部分节点由于网络或者其他原因未更新数据,但最终会保持数据一致。

43.业界提供了一种双数据中心架构的etcd集群。该etcd集群包括dc1和dc2两个数据中心。其中,dc1包括两个节点,分别记作vm1和vm3。dc2包括一个节点,记作vm2。当dc2故障时,vm1、vm3可以组成集群继续对外提供服务。但是当dc1故障时,因为只剩vm2一个节点,etcd集群无法选出领导(leader)节点而导致集群无法对外提供服务。此时,应用对外服务异常,不满足高可用性的要求。

44.有鉴于此,本技术实施例提供了一种数据容灾方法。该方法应用于双数据中心,具体为第一数据中心和第二数据中心,其中,第一数据中心部署有m个节点,第二数据中心部署有n个节点。m为偶数,n为奇数,m大于n。第一数据中心的m个节点和第二数据中心的n个节点形成大小为m+n的第一集群。第一集群基于该第一集群的领导节点对外提供服务。第二数据中心可以获取第一数据中心的工作状态,当第一数据中心的工作状态指示第一数据中心故障时,则第二数据中心可以启动第二集群(第一集群的子集群),第二数据中心的一个节点作为该第二集群的领导节点,维护数据在第二集群中的n个节点之间的一致性,从而使得第一数据中心故障时应用仍能对外提供服务。如此,解决了相关技术中由于只剩一个节点无法选出领导节点导致集群无法对外提供服务的问题,满足了高可用性的要求。

45.在具体实现时,第一数据中心可以包括2k个节点,第二数据中心可以包括2k-1个节点。其中,k为正整数。通过上述设置可以使得节点在第一数据中心和第二数据中心的分布较为均匀,可以实现容错能力和性能的均衡。

46.为了使得本技术的技术方案更加清楚、易于理解,接下来将结合附图对本技术实施例提供的数据容灾方法的应用环境进行介绍。

47.本技术实施例提供的数据容灾方法包括但不限于如图1所示的应用环境中。如图1所示,该场景中包括数据中心102和数据中心104。其中,数据中心102中部署有2k个节点,记作节点1至节点2k。数据中心104中部署有2k-1个节点,记作节点2k+1至节点4k-1。k为正整数,例如可以为1或者2。对应地,数据中心102可以包括2个节点,数据中心104包括1个节点。当然,数据中心102也可以包括4个节点,对应地,数据中心104包括3个节点。

48.数据中心104可以获取数据中心102的工作状态。当数据中心102故障时,数据中心104可以启动第二集群。该第二集群包括数据中心104中的2k-1个节点,即节点2k+1至4k-1。

49.其中,第二集群的领导(leader)节点为上述节点2k+1至4k-1中的一个。具体地,集群中的一个节点在任一时刻处于以下三种状态之一:领导节点、候选(candidate)节点和跟随(follower)节点。所有节点在启动时都是follower节点,当一段时间内没有收到来自leader节点的心跳消息时,从follower节点切换为candidate节点。candidate节点可以为自己投票,并向其他节点发送选举请求,当一个candidate节点获得大部分选票(例如超过一半的节点的选票)时,在该candidate节点赢得选举,成为leader节点。leader节点负责接收来自于客户端的更新请求(如数据写入请求),然后复制更新请求到follower节点,并在“安全”时(例如超过一半以上的节点同意时)执行这些更新请求,从而维护数据在第二集群中的2k-1个节点之间的一致性。

50.接下来,从数据中心104的角度对本技术实施例提供的数据容灾方法进行介绍。

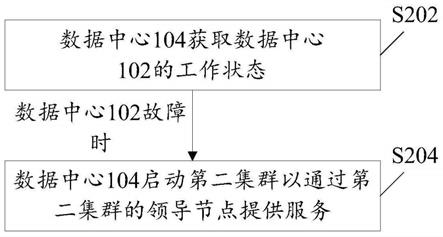

51.参见图2所示的数据容灾方法的流程图,该方法包括:

52.s202:所述数据中心104获取所述数据中心102的工作状态。当所述数据中心102的工作状态指示所述数据中心102故障时,执行s204。

53.数据中心102的工作状态具体包括两种状态。一种状态为正常工作状态,此时,数据中心102能够为节点提供电源、网络以及散热系统等等,使得节点能够正常对外提供服务。另一种状态为故障工作状态,此时,数据中心102不能为节点提供电源、网络或者散热系统,导致节点不能正常对外提供服务。

54.需要说明的是,数据中心102处于故障工作状态与数据中心102中的节点处于故障工作状态是完全不同的。数据中心102处于故障工作状态如断电时,该数据中心102中的所有节点均不能对外提供服务。数据中心102中的某个节点处于故障工作状态时,该数据中心102中的其他节点仍然能够对外提供服务。

55.数据中心104可以通过该数据中心104中部署的任一节点获取数据中心102的工作状态,以便根据数据中心102的工作状态进行数据处理,从而实现数据容灾。数据中心104的节点在获取数据中心102的工作状态时,可以通过仲裁节点实现。

56.参见图3所示的数据容灾系统的结构示意图,该数据容灾系统包括数据中心102和数据中心104,此外还包括仲裁节点106。仲裁节点106用于与数据中心102和数据中心104交互。如此,数据中心104可以通过仲裁节点106获取数据中心102的工作状态。

57.在一些可能的实现方式中,数据中心104可以向所述仲裁节点106发送查询请求,该查询请求用于查询所述数据中心102的工作状态。仲裁节点106可以基于与数据中心102中节点的心跳消息确定数据中心102的工作状态。例如,仲裁节点106在预设时间段内接收到来自于数据中心102中至少一个节点的心跳消息,则确定数据中心102处于正常工作状态。仲裁节点106在预设时间段内未接收到来自于数据中心102中任一个节点发送的心跳消息,则确定数据中心102处于故障工作状态。仲裁节点106根据数据中心102的工作状态生成查询响应,然后向数据中心104发送上述查询响应,以使数据中心104根据查询响应获知数据中心102的工作状态。

58.当数据中心104获知数据中心102故障时,则数据中心104可以执行s204,以使得数据中心102故障时仍能维持各节点之间数据一致性,并正常对外提供服务。

59.s204:所述数据中心104的节点启动第二集群以通过所述第二集群的领导节点提供服务。

60.所述第二集群的领导节点为所述第二数据中心的节点中的一个节点。第二数据中心部署有n个节点时,第二集群的领导节点即为n个节点中的一个节点,n等于2k-1时,第二集群的领导节点即为2k-1个节点中的一个。所述第二集群的领导节点具体用于维护数据在所述第二集群中的n(n可以取值为2k-1)个节点之间的一致性。

61.当数据中心102故障时,数据中心104中的任意一个节点或者数据中心104中的第一预设节点可以创建第二集群,例如通过force-new-cluster等命令创建上述第二集群。该第二集群包括数据中心104中部署的2k-1个节点。该第二集群以上述2k-1个节点中的一个节点为领导节点,该领导节点可以维护数据在第二集群中2k-1个节点之间的一致性。

62.其中,第二集群的领导节点可以是2k-1个节点中的第二预设节点。该第二预设节点与第一预设节点可以是同一节点,也可以是不同节点。当数据中心104的节点创建第二集群时,第二预设节点可以向第二集群中其他节点发送通知消息,以向该第二集群中其他节点通知领导节点为上述第二预设节点。如此,可以减少选举等操作导致的额外开销。

63.在一些实现方式中,第二集群的领导节点也可以通过选举方式确定。在创建第二集群时,数据中心104中部署的2k-1个节点由follower节点变为candidate节点,candidate节点为自己投票,并向第二集群中其他节点发送选举请求,当一个candidate节点获得大部分(majority)选票时,该candidate节点切换为leader节点。

64.在一些实现方式中,数据中心104还可以预先创建第二集群,确定该第二集群的领导节点,然后在第一数据中心故障时,启动该第二集群,以通过第二集群的领导节点提供服务。

65.当数据中心104故障时,数据中心102中包括2k个节点,其数量超过第一集群包括节点的数量,因此,这2k个节点对于更新请求(如数据写入请求)达成一致时,仍可维持第一集群中这2k个节点之间的数据一致性。当数据中心104恢复时,第一集群中的领导节点可以再执行更新请求(如数据写入请求),将数据写入到数据中心104中部署的2k-1个节点,从而维持第一集群中4k-1个节点之间的数据一致性。

66.在本技术实施例中,数据中心102和数据中心104部署的节点的数量可以根据业务需求而设置。考虑到容错能力,可以在数据中心102和数据中心104中部署较多的节点。考虑到性能,可以在数据中心102和数据中心104中部署较少的节点。综合考虑容错能力和性能,k可以取值为1或2。

67.基于此,在一些可能的实现方式中,数据中心102可以部署2个节点,数据中心104可以部署1个节点。在该实现方式中,数据中心102故障时,数据中心104中的节点可以创建单节点集群,该单节点集群即为上文所述的第二集群。该单节点集群可以以数据中心104包括的一个节点作为领导节点,用于维护第二集群中不同节点之间的数据一致性。

68.在另一些可能的实现方式中,数据中心102可以部署4个节点,数据中心104可以部署3个节点。在该实现方式中,数据中心102故障时,数据中心104中的节点可以创建一个三节点集群,该三节点集群即为上文所述的第二集群。三节点集群中的领导节点可以是第二预设节点,也可以通过选举方式确定的一个节点,本实施例对此不作限定。

69.基于上述内容描述,本技术实施例提供的数据容灾方法支持双中心的数据容灾系

统中包括节点数量较多的数据中心(即第一数据中心)故障时,另一个数据中心(即第二数据中心)能够单独创建第二集群,第二数据中心的一个节点作为该第二集群的领导节点,维护数据在第二集群中不同节点之间的一致性,从而使得第一数据中心故障时应用仍能对外提供服务。如此,解决了相关技术中由于只剩一个节点无法选出领导节点导致集群无法对外提供服务的问题,满足了高可用性的要求。

70.在图2所示实施例中,当数据中心102恢复,也即由故障工作状态切换为正常工作状态时,数据中心104将所述数据中心102的节点添加至所述第二集群。具体地,数据中心104的节点中包括第二集群的领导节点,该领导节点可以通过成员添加命令如member add命令将数据中心102中部署的节点添加至第二集群。

71.在一些可能的实现方式中,数据中心104从故障中恢复,即数据中心104由故障工作状态切换为正常工作状态时,所述数据中心104可以从数据中心104部署的节点中确定第一集群的领导节点。具体地,数据中心104可以响应于所述数据中心102的节点触发的领导节点转移操作,从所述数据中心104中确定领导节点。其中,数据中心102中作为领导节点的节点可以通过领导转移命令,如move leader命令将leader权限转移至数据中心104的节点中。第一集群的领导节点由数据中心102中部署的节点切换为数据中心104中部署的节点。

72.为了便于理解本技术的技术方案,下面以数据中心102部署2个节点即vm1和vm3,数据中心104部署1个节点即vm2,对数据容灾方法进行示例说明。

73.参见图4所示的数据容灾系统的结构示意图,数据中心102和数据中心104部署的节点vm1、vm2和vm3形成一个三节点的etcd集群。etcd集群中的每个节点具有监控程序,当监控程序运行时,节点可以调用仲裁节点106提供的仲裁服务对应的仲裁代理接口进行仲裁。

74.具体地,数据中心104部署的节点vm2的监控程序调用仲裁节点106的仲裁代理接口,确定数据中心102的工作状态。当数据中心102故障时,vm2使用force-new-cluster命令自动将etcd集群改造为单节点集群。其中,vm2为单节点集群的leader节点。

75.当vm2的监控程序通过调用仲裁节点106的仲裁代理接口确定数据中心102恢复时,作为leader节点的vm2使用member add命令将vm1和vm3加入新的集群中。

76.当数据中心104故障时,数据中心102中的节点vm1、vm3仍然可用,etcd集群可以依靠自身选举能力确定vm1或vm3为领导节点,基于该领导节点仍然可以实现集群服务的高可用。当数据中心104恢复时,即由故障工作状态切换为正常工作状态时,etcd集群可以将vm2纳入到集群管理中。vm1或vm3通过move leader命令将leader权限进行转移,使得vm2成为领导节点。如此可以使得数据在数据中心102故障或者正常时,写入到vm2的数据均是完整的,数据中心102和数据中心104中均保存有完整的数据,从而保障了数据一致性。

77.通过本技术实施例提供的上述方法,可以解决双数据中心的数据容灾系统中包括较多节点的数据中心整体故障时,因为无法选出leader导致服务不可用的问题,满足了高可用性要求。此外,该方法无需建设3个数据中心来保证etcd集群的奇数节点要求,减少了数据容灾成本。

78.以上结合图1至图4对本技术实施例提供的数据容灾方法进行详细说明,接下来,结合附图对本技术实施例提供的数据容灾装置、设备进行介绍。

79.参见图5所示的数据容灾装置500的结构示意图,该装置500应用于第一数据中心

和第二数据中心。第一数据中心部署有m个节点,第二数据中心部署有n个节点。m为偶数,n为奇数,m大于n。所述第一数据中心的m个节点和所述第二数据中心的n个节点形成第一集群。

80.所述装置500包括:

81.通信模块502,用于获取所述第一数据中心的工作状态;

82.启动模块504,用于当所述第一数据中心的工作状态指示所述第一数据中心故障时,启动所述第二集群以通过所述第二集群的领导节点提供服务,所述第二集群的领导节点为所述n个节点中的一个节点,所述领导节点用于维护数据在所述第二集群中的n个节点之间的一致性。

83.其中,通信模块502的具体实现可以参见图2所示实施例中s202相关内容描述,启动模块504的具体实现可以参见图2所示实施例中s204相关内容描述,在此不再赘述。

84.在一些可能的实现方式中,所述装置500还包括:

85.添加模块506,用于当所述第一数据中心恢复时,将所述第一数据中心的节点添加至所述第二集群。

86.其中,添加模块506的具体实现可以参见图2所示实施例中相关内容描述,在此不再赘述。

87.在一些可能的实现方式中,

88.所述通信模块502具体用于:

89.向仲裁节点发送查询请求,所述查询请求用于查询所述第一数据中心的工作状态;

90.接收所述仲裁节点发送的查询响应,所述查询响应包括所述第一数据中心的工作状态。

91.在一些可能的实现方式中,所述装置500还包括:

92.确定模块508,用于所述第二数据中心从故障中恢复时,从所述第二数据中心中确定领导节点。

93.其中,确定模块508的具体实现可以参见图2所示实施例中相关内容描述,在此不再赘述。

94.在一些可能的实现方式中,所述第一数据中心包括2k个节点,所述第二数据中心包括2k-1个节点,所述k为正整数。

95.根据本技术实施例的数据容灾装置500可对应于执行本技术实施例中描述的方法,并且数据容灾装置500的各个模块/单元的上述和其它操作和/或功能分别为了实现图2所示实施例中的各个方法的相应流程,为了简洁,在此不再赘述。

96.本技术实施例还提供了一种设备。该设备可以是服务器等物理设备,或者云服务器等虚拟化设备。该设备具体用于实现如图5所示实施例中数据容灾装置500的功能。

97.图6提供了一种设备600的结构示意图,如图6所示,设备600包括总线601、处理器602、通信接口603和存储器604。处理器602、存储器604和通信接口603之间通过总线601通信。总线601可以是外设部件互连标准(peripheral component interconnect,pci)总线或扩展工业标准结构(extended industry standard architecture,eisa)总线等。总线可以分为地址总线、数据总线、控制总线等。为便于表示,图6中仅用一条粗线表示,但并不表示

仅有一根总线或一种类型的总线。通信接口603用于与外部通信。例如,接收更新请求(如数据写入请求),向仲裁节点106发送查询请求,接收仲裁节点106发送的查询响应等等。

98.其中,处理器602可以为中央处理器(central processing unit,cpu)。存储器604可以包括易失性存储器(volatile memory),例如随机存取存储器(random access memory,ram)。存储器604还可以包括非易失性存储器(non-volatile memory),例如只读存储器(read-only memory,rom),快闪存储器,hdd或ssd。

99.存储器604中存储有可执行代码,处理器602执行该可执行代码以执行前述数据容灾方法。

100.具体地,在实现图5所示实施例的情况下,且图5实施例中所描述的数据容灾装置500的各模块为通过软件实现的情况下,执行图5中的启动模块504、添加模块506、确定模块508功能所需的软件或程序代码存储在存储器604中。通信模块102获取第一数据中心如数据中心102的工作状态,通过总线601传输至处理器602,处理器602执行存储器604中存储的各模块对应的程序代码,如启动模块504对应的程序代码,以在第一数据中心的工作状态指示第一数据中心故障时,启动第二集群以通过所述第二集群的领导节点提供服务。如此,应用仍可以基于第二集群对外提供服务,从而实现数据容灾。

101.当然,处理器602还可以执行添加模块506对应的程序代码,以在第一数据中心恢复时,将第一数据中心的节点添加至第二集群。处理器602还可以执行确定模块508对应的程序代码,以在第二数据中心从故障中恢复时,响应于第一数据中心的节点触发的领导节点转移操作,从所述第二数据中心中重新确定领导节点。

102.本技术实施例还提供了一种计算机可读存储介质,该计算机可读存储介质包括指令,所述指令指示设备600执行上述应用于数据容灾装置500的数据容灾方法。

103.本技术实施例还提供了一种计算机可读存储介质,该计算机可读存储介质包括指令,所述指令指示设备600执行上述应用于数据容灾装置500的数据容灾方法。

104.本技术实施例还提供了一种计算机程序产品,所述计算机程序产品被计算机执行时,所述计算机执行前述数据容灾方法的任一方法。该计算机程序产品可以为一个软件安装包,在需要使用前述数据容灾方法的任一方法的情况下,可以下载该计算机程序产品并在计算机上执行该计算机程序产品。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1