一种基于因果逻辑和图卷积特征提取的网络耦合时序信息流预测方法与流程

[0001]

本发明涉及一种基于因果逻辑和图卷积特征提取的网络耦合时序信息流预测方法,属于信息流预测技术领域。

背景技术:

[0002]

现代化管理服务已经进入了以数据资源和信息技术为双轮驱动的新时期,大数据为信息管理和服务提供了更广阔的视野和更有效的途经。依托多源大数据资源形成的“数据智慧”,亟须构建以大数据体系为统领、科技创新为驱动的发展模式,满足现代化信息管理服务需求。首先,需完善网络化、标准化的数据状态感知采集体系,进一步整合数据资源;其次,需创新大数据分析应用,支撑应用场景高效运营管理、智能化服务;最后,需强化顶层设计、融合发展,构建智能信息大数据生态体系。

[0003]

流量预测是大数据领域的一个十分重要的研究课题,在交通、金融、气候等领域有着重要的实际应用价值。随着近几年机器学习热潮的到来,机器学习方法中深度利用学习方法进行流量预测得到了广泛关注。2014年,lv yisheng et al.将深度学习框架引入流量预测领域,提出了基于stack autoencoder的深度学习方法,并取得较为不错的预测结果。后续深度学习方法逐渐引起了人们的关注。2017年,j.tang et al.提出了一种改进的模糊神经网络方法,成功实现了对时序信息流的多步预测。然而此时的信息流量预测仍然存在着很多问题,其中最重要的是预测准确率不够高,并且预测步数不够长,还不能够实现较为准确的中长期的预测。

[0004]

2018年,lstm(long short-term memory)的兴起,同时也带动了时序信息流预测技术的发展,lstm是循环神经网络(recurrent neural network,rnn)的一种。2017年,li y.et al.引入了rnn,其团队提出了一种混合卷积rnn的方法,解决了原先的深度学习框架不能实现较为准确的多步预测的难题,并一定程度上克服了多区域数据关联性耦合的问题,提高了预测准确率。但同时也带来了新的问题,其中就是中长期预测中,由于rnn层数逐渐加深,模型更加复杂,在优化过程中出现了梯度消失问题,而lstm则很好的解决了这个问题。mackenzie j.et al.于2018年在lstm的基础上,增加了层级临时记忆机制(hierarchical temporal memory,htm),很好的延长了rnn模型在神经网络层数加深时带来的优化难题,更好的延长了时序信息流的预测步数。至此,主流的信息流流量预测模型已经基本建立在各种rnn模型及其变种的基础上。

[0005]

近两年,又由于图卷积网络(graph convolutional network,gcn)的兴起,图结构信息流预测在效果上有了质的飞跃。图卷积网络是图神经网络的一个重要的分类,图卷积网络借鉴了卷积神经网络中卷积的思想,利用卷积来处理图结构数据的信息,得到了很好的信息特征。由于图结构的数据与图像等数据结构不同,是一种非欧几里得的数据结构,每个节点的邻居数量不同,不能直接利用卷积网络进行特征提取。2014年joan bruna等人利用图的拉普拉斯矩阵提出了基于图拉普拉斯矩阵的第一代图卷积网络。其结构为:h

t+1

=σ

(ug

θ

u

t

h

t

),其中u是拉普拉斯矩阵的特征向量,h为隐藏层,g是需要训练的参数,此后defferrard等人对训练参数利用切比雪夫多项式进行改良得到了第二代图卷积,2017年kipf.等人将切比雪夫多项式参数化简得到了第三代的图卷积,极大简化了计算量其形式为:其中a是改进的邻接矩阵,d是改进的度矩阵。在第二代图卷积网络中通过对切比雪夫多项式的k值选取,在图数据中反应的是选取某个节点的k阶邻居来进行信息融合。空间域图卷积网络利用某个节点周围的邻居的信息来更新节点的信息。通过对邻居节点的筛选的补0,将节点的邻居个数统一之后采取卷积来提取图数据的信息。

技术实现要素:

[0006]

本发明的目的是针对现有的技术存在的上述问题,提供一种基于因果逻辑和图卷积特征提取的网络耦合时序信息流预测方法,本发明所要解决的技术问题是通过计算成对节点之间的转移熵建立一种描述其依赖性的因果逻辑网络,替代单一实体交通网络作为耦合时序信息流预测的输入,从而在因果逻辑网络基础上利用图卷积网络(gcn)来提取图数据的特征,再将提取的特征利用门控循环单元(gru)进行预测。

[0007]

为达到上述目的,本发明采用如下的技术方案:一种基于因果逻辑和图卷积特征提取的网络耦合时序信息流预测方法,所述方法包括以下步骤:

[0008]

s1,基于n个采样节点的时间序列数据利用转移熵(transferentropy)建立因果逻辑网络g=(v,e);

[0009]

转移熵为信息论中两个随机事件x与y间依赖性的一种度量,表达式为:

[0010][0011]

其中熵h

x

=-∑

x

p(x)log2p(x)度量了离散随机变量x在概率分布p(x)下的不确定性,为已知过程x的k阶时滞子序列时的条件熵,时的条件熵,为已知过程x的k阶时滞子序列和过程y的l阶时滞子序列时的条件熵。若te

y

→

x

>0,则y到x之间存在信息流。

[0012]

因果逻辑网络定义为g=(v,e),其中v={1,2,

…

,n}为节点集,e=(e_ij)为连边集,i与j连边的权重e

ij

代表i到j的信息流量,本方法中用转移熵值作为连边权重。

[0013]

s1.1,为了计算转移熵,需要首先确定参数k和l,再估计随机变量的概率分布函数。本方法使用符号编码方法,将节点的时间序列划分为完备事件组。确定状态数q后,将时间序列数值利用分位数划分为q个状态,状态集合为s={s1,s2,

…

,s

q

}。因此,节点i的状态可以按下式进行区分,并且将每种状态的频率近似作为概率分布用以计算转移熵

[0014][0015]

s1.2,遍历成对节点i,j之间的转移熵te

i

→

j

,得到初始的有向加权网络。

[0016]

s1.3,由于转移熵计算存在冗余信息,所以本发明设置阈值θ从而过滤冗余信息。交通节点i流向节点j的信息流连边权重w

ij

为

[0017][0018]

s2,基于因果逻辑网络g对逻辑网络节点数据利用图卷积网络(gcn)进行特征提取。逻辑因果网络为g=(v,e),因果网络节点个数为n,初始因果逻辑网络节点特征为x∈r

n*c

,c为单个节点特征维数,特征提取结果为h∈r

n*f

,f为特征提取后的节点特征维度。

[0019]

s2.1,为提取节点特征,图卷积神经网络将集合图结构信息对每个节点进行信息提取,在不考虑边权情况下,传统图神经网络节点特征将按如下形式更新:

[0020][0021]

此处,h

(l)

表示网络中的第l层,σ是非线性函数,其形式为:θ

(l)

是该层的权重矩阵。如通常所定义,d和a分别代表度矩阵和邻接矩阵。是一种重新规范化的技巧,我们对图的每个节点添加了自连接,并构建了相应的度数和邻接矩阵,其形式分别为:i

n

是单位矩阵。输入h

(l)

即为因果逻辑网络的原始节点特征x,其维数为r

n*c

,其中n是节点数,c是输入要素数。我们将多层图卷积神经网络链接起来,以生成r

n*f

维的输出,其中f是输出节点特征向量的维数。

[0022]

s2.2,对每个节点单独考虑,通过度矩阵与邻接矩阵的实际含义不难得出在图卷积神经网络中每个节点的信息是按照如下规则进行传递的:

[0023][0024]

其中代表节点i在第l+1层的输出,n(i)是节点i的邻居节点的集合,c

ij

是第i个节点与第j个节点度的平方根之积。从上式可以看出每个节点的更新都依赖其邻居节点的信息,特征按照会和邻居特征的形式更新。由于步骤s1中构建的因果逻辑矩阵中存在边权,故对上式结合边权进行改进得到最终的信息提取公式:

[0025][0026]

s3,基于提取的图信息特征h

i

进行流量预测,在步骤s2中通过结合边权的改进图卷积神经网络对因果逻辑网络的图结构特征进行了提取,从而提取后的节点特征h

i

中既包

含了第i个节点自身特征又包含了i节点的图结构特征,因此本过程将对每个节点独立考虑,利用图信息特征h进行流量预测。

[0027]

s3.1,对于n个采样节点的时间序列数据针对其每个采样点t,利用s2中提取公式:

[0028][0029]

可以得到t时刻时间截面数据特征h

t

,在当前时间截面下第i个节点的特征为对第i个节点的所有时间采样节点处理后可得到第i个节点的特征数据

[0030]

s3.2,针对第i个节点的特征数据利用门控循环单元gru对数据流进行预测。gru模块的结构为:

[0031]

z

t

=σ(w

z

[m

t-1

,h

t

])

[0032]

r

t

=σ(w

r

[m

t-1

,h

t

])

[0033][0034][0035]

其中输入为h

t

输出为m

t

。需要训练的参数为:w

z

,w

r

,w。r

t

是重置门,控制在t步重置的信息的比例,z

t

是更新门,确定接受新的信息的比例,最后由m

t

完成信息的综合。可以见得gru模块的传递过程可以如下表示:

[0036]

m

t

=gru(m

t-1

,h

t

)

[0037]

从而将n个gru模块按顺序排列即可接收第i个节点数据特征流上述步骤完成了数据流的编码过程,得到信息流的编码结果

[0038]

s3.3,记编码结果利用编码结果r构造解码器,进行解码预测输出。解码器结构依旧为gru模块,其传递过程为:

[0039]

v

t+k

=gru(v

t+k-1

,h

t+k-1

)

[0040][0041][0042]

其中v

t+k

为解码器在t+k时刻预测输出,为根据v

t+k

求得的t+k时刻的流量预测数据。

[0043]

解码器初始输入v

t

=r,

[0044]

s4,利用反向传播算法进行训练优化参数。对于n个采样节点的时间序列数据设立时间窗t,将0-t时刻的数据用于编码,t-t时刻的数据用于解码,从而有真实训练标签x

t+1

,x

t+2

,

…

,x

2t

,定义损失函数:

[0045][0046]

利用反向传播算法来逐步减小损失函数,实现参数的训练更新,最终得到信息流

数据预测模型。

[0047]

与现有技术相比,本发明具有以下优点:

[0048]

1、基于转移熵的耦合信息流测度具有方向性,且能够捕获时间序列的非线性特征,以此建立的因果逻辑网络能够对耦合时序信息流在预测方面表现出的不同时空特征进行很好的测度。

[0049]

2、图卷积神经网络是一种新型的处理图数据的方法,可以通过邻接矩阵,拉普拉斯矩阵有效的提取图网络信息。

[0050]

3、门控循环单元gru是lstm结构的变体,在处理时序数据中有着广泛的应用,本技术将因果逻辑网络、图卷积网络gcn与门控循环单元gru相结合,在gcn处理逻辑网络信息额基础上在利用gru进行时序数据处理,模型具有更好的精度。

[0051]

4、本方案通过因果逻辑网络进行根源推理提取节点间的因果关系,通过带权改进的图卷积神经网络来提取空间信息,之后通过gru提取时间信息。全面多层次的运用了空间时间的数据特征,将复杂的流量数据的各个方面进行分析提取,比传统的只考虑空间状态或时间序列信息的预测方法有了明显的进步,也取得了更好的预测结果。

附图说明

[0052]

图1是本方法中各个部分的结构示意图。

[0053]

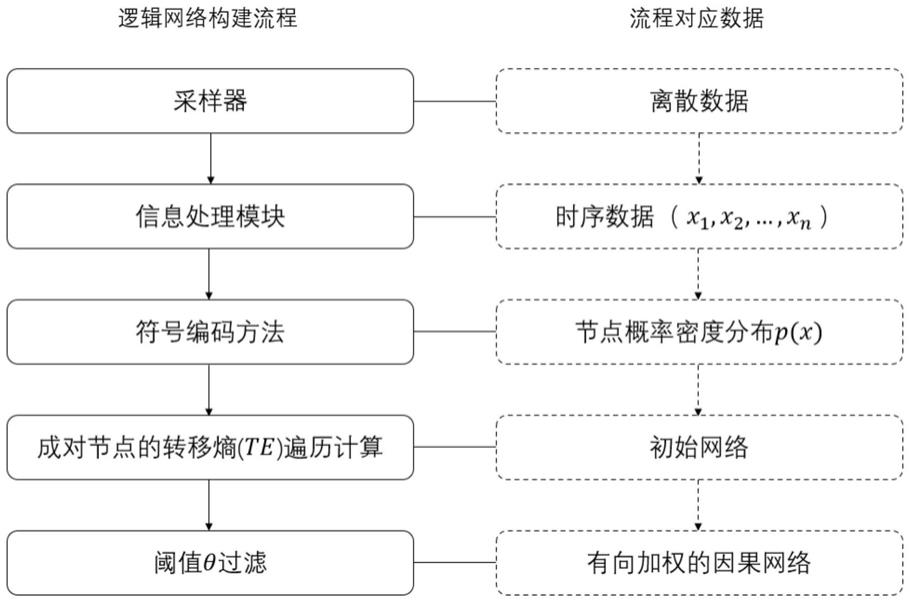

图2是本方法中基于转移熵的因果逻辑网络建立流程图。

[0054]

图3是本方法的图卷积网络(gcn)示意图。

[0055]

图4是本方法门控循环单元(gru)单元结构图。

[0056]

图5是本方法中门控循环单元(gru)模型图(h为gru单元)。

具体实施方式

[0057]

下面结合实施例及附图对本发明作进一步详细的描述,但本发明的实施方式不限于此。

[0058]

实施例1:参见图1—图5,一种基于因果逻辑和图卷积特征提取的网络耦合时序信息流预测方法,所述方法包括以下步骤:

[0059]

s1,基于n个采样节点的时间序列数据利用转移熵(transferentropy)建立因果逻辑网络g=(v,e);

[0060]

转移熵为信息论中两个随机事件x与y间依赖性的一种度量,表达式为:

[0061][0062]

其中熵h

x

=-∑

x

p(x)log2p(x)度量了离散随机变量x在概率分布p(x)下的不确定性,为已知过程x的k阶时滞子序列时的条件熵,时的条件熵,为已知过程x的k阶时滞

子序列和过程y的l阶时滞子序列时的条件熵。若te

y

→

x

>0,则y到x之间存在信息流。

[0063]

因果逻辑网络定义为g=(v,e),其中v={1,2,

…

,n}为节点集,e=(e

ij

)为连边集,i与j连边的权重e

ij

代表i到j的信息流量,本方法中用转移熵值作为连边权重。

[0064]

s1.1,为了计算转移熵,需要首先确定参数k和l,再估计随机变量的概率分布函数。本方法使用符号编码方法,将节点的时间序列划分为完备事件组。确定状态数q后,将时间序列数值利用分位数划分为q个状态,状态集合为s={s1,s2,

…

,s

q

}。因此,节点i的状态可以按下式进行区分,并且将每种状态的频率近似作为概率分布用以计算转移熵

[0065][0066]

s1.2,遍历成对节点i,j之间的转移熵te

i

→

j

,得到初始的有向加权网络。

[0067]

s1.3,由于转移熵计算存在冗余信息,所以本发明设置阈值θ从而过滤冗余信息。交通节点i流向节点j的信息流连边权重w

ij

为

[0068][0069]

s2,基于因果逻辑网络g对逻辑网络节点数据利用图卷积网络(gcn)进行特征提取。逻辑因果网络为g=(v,e),因果网络节点个数为n,初始因果逻辑网络节点特征为x∈r

n*c

,c为单个节点特征维数,特征提取结果为h∈r

n*f

,f为特征提取后的节点特征维度。

[0070]

s2.1,为提取节点特征,图卷积神经网络将集合图结构信息对每个节点进行信息提取,在不考虑边权情况下,传统图神经网络节点特征将按如下形式更新:

[0071][0072]

此处,h

(l)

表示网络中的第l层,σ是非线性函数,其形式为:θ

(l)

是该层的权重矩阵。如通常所定义,d和a分别代表度矩阵和邻接矩阵。是一种重新规范化的技巧,我们对图的每个节点添加了自连接,并构建了相应的度数和邻接矩阵,其形式分别为:i

n

是单位矩阵。输入h

(l)

即为因果逻辑网络的原始节点特征x,其维数为r

n*c

,其中n是节点数,c是输入要素数。我们将多层图卷积神经网络链接起来,以生成r

n*f

维的输出,其中f是输出节点特征向量的维数。

[0073]

s2.2,对每个节点单独考虑,通过度矩阵与邻接矩阵的实际含义不难得出在图卷积神经网络中每个节点的信息是按照如下规则进行传递的:

[0074][0075]

其中代表节点i在第l+1层的输出,n(i)是节点i的邻居节点的集合,c

ij

是第i个节点与第j个节点度的平方根之积。从上式可以看出每个节点的更新都依赖其邻居节点的信息,特征按照会和邻居特征的形式更新。由于步骤s1中构建的因果逻辑矩阵中存在边权,故对上式结合边权进行改进得到最终的信息提取公式:

[0076][0077]

s3,基于提取的图信息特征h

i

进行流量预测,在步骤s2中通过结合边权的改进图卷积神经网络对因果逻辑网络的图结构特征进行了提取,从而提取后的节点特征h

i

中既包含了第i个节点自身特征又包含了i节点的图结构特征,因此本过程将对每个节点独立考虑,利用图信息特征h进行流量预测。

[0078]

s3.1,对于n个采样节点的时间序列数据针对其每个采样点t,利用s2中提取公式:

[0079][0080]

可以得到t时刻时间截面数据特征h

t

,在当前时间截面下第i个节点的特征为对第i个节点的所有时间采样节点处理后可得到第i个节点的特征数据

[0081]

s3.2,针对第i个节点的特征数据利用门控循环单元gru对数据流进行预测。gru模块的结构为:

[0082]

z

t

=σ(w

z

[m

t-1

,h

t

])

[0083]

r

t

=σ(w

r

[m

t-1

,h

t

])

[0084][0085][0086]

其中输入为h

t

输出为m

t

。需要训练的参数为:w

z

,w

r

,w。r

t

是重置门,控制在t步重置的信息的比例,z

t

是更新门,确定接受新的信息的比例,最后由m

t

完成信息的综合。可以见得gru模块的传递过程可以如下表示:

[0087]

m

t

=gru(m

t-1

,h

t

)

[0088]

从而将n个gru模块按顺序排列即可接收第i个节点数据特征流上述步骤完成了数据流的编码过程,得到信息流的编码结果

[0089]

s3.3,记编码结果利用编码结果r构造解码器,进行解码预测输出。解码器结构依旧为gru模块,其传递过程为:

[0090]

v

t+k

=gru(v

t+k-1

,h

t+k-1

)

[0091]

[0092][0093]

其中v

t+k

为解码器在t+k时刻预测输出,为根据v

t+k

求得的t+k时刻的流量预测数据。解码器初始输入v

t

=r,

[0094]

s4,利用反向传播算法进行训练优化参数。对于n个采样节点的时间序列数据设立时间窗t,将0-t时刻的数据用于编码,t-t时刻的数据用于解码,从而有真实训练标签x

t+1

,x

t+2

,

…

,x

2t

,定义损失函数:

[0095][0096]

利用反向传播算法来逐步减小损失函数,实现参数的训练更新,最终得到信息流数据预测模型。

[0097]

具体来说,基于转移熵(te)因果网络—图卷积网络(gcn)—门控循环单元(gru)的预测模型,包括下述步骤:

[0098]

1.数据处理:

[0099]

采用深圳某地区2019年6月1日至2019年12月31日的交通流量数据,采样的道路点为154,即节点数为154。统计每个节点的过车量,时间分辨率为5min,即对每五分钟每个采样点统计流量。将流量数据集按照8:2的比例划分训练集和测试集,流量预测的时间窗为1小时,即以用1小时的流量数据预测1小时的流量情况。

[0100]

2.建模过程:

[0101]

如图2所示,采样数据处理后得到时间序列数据,在符号编码方法中将交通流区间利用20%、40%、60%、80%分位数划分为5个状态,将每种状态的频率近似作为概率分布,设置参数k=l=1遍历计算两两节点的转移熵后对初始网络进行阈值筛选,只有边权大于阈值的连边被保留下来,形成最终的有向加权因果逻辑网络。

[0102]

如图3所示,将得到的加权因果逻辑网络放入图卷积神经网络中,对于每个时间点使用共享参数的图神经网络进行训练得到各个节点的时序提取信息数据。

[0103]

如图5所示,将经过信息提取的时序数据作为输入,输入至gru模块中,通过gru模块的编码解码过程实现流量的预测,将流量预测的结果作为下步流量预测的输入多次迭代实现多步预测,gru单元涉及的算法如图4所示,主要包括更新门与重置门,通过更新门确定接收信息的比例,通过重置门确定重置信息的比例,模块结构如下:

[0104]

z

t

=σ(w

z

[m

t-1

,h

t

])

[0105]

r

t

=σ(w

r

[m

t-1

,h

t

])

[0106][0107][0108]

最后将真实数据和输出结果模型置入损失函数l计算,与阈值0.05进行对比,获得模型参数的最优解。

[0109]

上述为本发明较佳的实施方式,但本发明的实施方式并不受上述内容的限制,其他的任何未背离本发明的精神实质与原理下所作的改变、修饰、替代、组合、简化,均应为等效的置换方式,都包含在本发明的保护范围之内。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1