多任务分类模型的训练方法、数据分类方法及相关设备与流程

1.本技术涉及人工智能领域,具体而言,本技术涉及一种多任务分类模型的训练方法、数据分类方法及相关设备。

背景技术:

2.标签比例学习(learning from label proportions,llp)是机器学习领域中一种新的弱监督学习方式,标签比例学习中的训练数据以数据包的形式组成,且数据包中已知包含样本数据所对应类别标签的比例信息且未知样本数据所确切对应的标签;可见,在标签比例学习中所包含的监督信息非常少,当将通过少量监督信息训练的分类模型的性能与通过经典监督学习的监督信息训练的分类模型的性能相比较时,明显可见,前者所得模型的性能较差。

3.现有技术中,在基于标签比例学习的模型中,通过kl散度约束后验分布与先验分布的差异来构建目标函数,其中,先验分布由训练数据提供,后验分布是通过网络基于每个样本的概率输出获得。但是,kl散度存在无法度量两个分布在不相交情况下的距离的问题,且在数据包的尺寸较大时,基于kl散度的度量容易得到平凡解,限制了模型的性能。

4.基于此,如何优化基于标签比例学习模型的性能是一大难题。

技术实现要素:

5.本技术的目的旨在提供一种多任务分类模型的训练方法和数据分类方法,以优化基于标签比例学习训练所得模型的性能。本技术实施例所提供的方案具体如下:

6.第一方面,本技术提供了一种多任务分类模型的训练方法,包括:

7.获取包括多个数据包的训练数据集,所述数据包中包括多个样本数据及样本数据所对应类别标签的比例信息;

8.交替执行以下步骤:基于最新的类别标签信息与所述训练数据集训练所述多任务分类模型;采用求解最佳运输问题的方式更新所述类别标签信息

9.第二方面,本技术提供了一种数据分类方法,包括:

10.获取待分类的数据;

11.通过多任务分类模型对所述待分类的数据进行处理,确定所述待分类的数据对应的类别标签;

12.其中,所述多任务分类模型采用第一方面所述的方法训练而得。

13.第三方面,本技术提供了一种多任务分类模型的训练装置,包括:

14.获取模块,用于获取包括多个数据包的训练数据集,所述数据包中包括多个样本数据及样本数据所对应类别标签的比例信息;

15.训练模块,用于交替执行以下步骤:基于最新的类别标签信息与所述训练数据集训练所述多任务分类模型;采用求解最佳运输问题的方式更新所述类别标签信息。

16.第四方面,本技术提供了一种数据分类装置,包括:

17.数据获取模块,用于获取待分类的数据;

18.数据处理模块,用于通过多任务分类模型对所述待分类的数据进行处理,确定所述待分类的数据对应的类别标签;

19.其中,所述多任务分类模型采用第一方面所述的方法训练而得。

20.第五方面,本技术提供了一种电子设备,该电子设备包括存储器和处理器;

21.存储器中存储有计算机程序;

22.处理器,用于在运行计算机程序时,执行本技术实施例第一方面所述的多任务分类模型的训练方法,或者执行本技术实施例第二方面所述的数据分类方法。

23.第六方面,本技术提供了一种计算机可读存储介质,该存储介质中存储有计算机程序,计算机程序在被处理器运行时,执行本技术实施例第一方面所述的多任务分类模型的训练方法,或者执行本技术实施例第二方面所述的数据分类方法。

24.本技术实施例提供的技术方案带来的有益效果将在下文具体实施方式部分的描述中结合各可选实施例进行详细描述,在此不再展开说明。

附图说明

25.为了更清楚地说明本技术实施例中的技术方案,下面将对本技术实施例描述中所需要使用的附图作简单地介绍。

26.图1为标签比例学习方法的示例图。

27.图2为本技术提供的一种多任务分类模型的训练方法的流程示意图;

28.图3为本技术一示例中提供的一种多任务分类模型的训练方法的原理示意图;

29.图4为本技术提供的一种多任务分类模型的训练装置的结构示意图;

30.图5为本技术提供的一种数据分类装置的结构示意图;

31.图6为本技术提供的一种电子设备的结构示意图。

具体实施方式

32.下面详细描述本技术的实施例,所述实施例的示例在附图中示出,其中自始至终相同或类似的标号表示相同或类似的元件或具有相同或类似功能的元件。下面通过参考附图描述的实施例是示例性的,仅用于解释本技术,而不能解释为对本发明的限制。

33.本技术领域技术人员可以理解,除非特意声明,这里使用的单数形式“一”、“一个”、“所述”和“该”也可包括复数形式。应该进一步理解的是,本技术的说明书中使用的措辞“包括”是指存在所述特征、整数、步骤、操作、元件和/或组件,但是并不排除存在或添加一个或多个其他特征、整数、步骤、操作、元件、组件和/或它们的组。应该理解,当我们称元件被“连接”或“耦接”到另一元件时,它可以直接连接或耦接到其他元件,或者也可以存在中间元件。此外,这里使用的“连接”或“耦接”可以包括无线连接或无线耦接。这里使用的措辞“和/或”包括一个或更多个相关联的列出项的全部或任一单元和全部组合。

34.为了更好的理解及说明本技术实施例所提供的方案,下面首先对本技术所涉及的相关技术进行说明。

35.关于标签比例学习(learning from label proportions,llp),现在技术中提出了llp的端到端算法,该算法采用了kl散度以度量先验分布与后验分布之间的约束。通过端

到端训练,该算法只能通过最小化基于比例的损失函数来学习实例级分类器。但是,基于kl散度的度量无法总是与每个数据包的原始比例一致,尤其是在数据包尺寸较大时(如size》64),这种缺陷限制了模型的性能。

36.在上述算法的基础上,现有技术中还提出一种通过引入对抗学习机制(llp-gan)改进上述算法的方法。具体地,对抗生成网络中的分类器被设计为应用于对(k+1)项类别进行分类的分类器,其中前k个类别指示多类别的真实样本,而第(k+1)个类别指示生成器所生成的伪样本。这项引入对抗学习的机制是通过对抗过程更好地了解数据分布,从而提高模型的性能。

37.尽管与基础的llp算法相比,llp-gan算法的性能有了很大的提高,但该方法继承了对抗生成网络的特征,网络训练的稳定性较差。此外,为了获得满意的结果,在llp-gan中需要微妙的网络结构设计和超参数选择,这将增加了计算的复杂度。

38.为了解决现有技术中存在的至少一个问题,本技术提供了一种多任务分类模型的训练方法,该方法采用了本技术提出来的一种应用求解最佳运输问题的方式的标签比例学习算法(optimal transport-learning from label proportions,ot-llp),在采用基于本技术提供的训练方法训练得到的多任务分类模型在相关任务上进行测试分类时,能够有效提高分类的准确性。

39.为使本技术的目的、技术方案和优点更加清楚,下面将结合具体地实施例和附图对本技术的各可选的实施方式及本技术实施例的技术方案如何解决上述技术问题进行详细说明。下面这几个具体的实施例可以相互结合,对于相同或相似的概念或过程可能在某些实施例中不再赘述。下面将结合附图,对本技术的实施例进行描述。

40.在说明本技术实施例如何将求解最佳运输问题的方式应用于标签比例学习之前,分别对求解最佳运输问题的方式以及标签比例学习的相关情况进行说明。

41.最佳运输问题在本技术实施例中主要涉及经典的monge-kantorovich transportation problem。以下通过举例简单描述本技术所涉及求解最佳运输问题的情况:从概率的角度进行分析,可以将n个仓库看作随机变量x,那么不同地区仓库的出货量为关于随机变量x的概率分布p;将货物分配的地点看作随机变量y,那么不同分配地点的货物需求量为关于随机变量y的概率分布q;基于此,求解最佳运输问题在本技术实施例中可以看作:求解将一个概率分布p转换(运输)为另一个概率分布q所需的最小代价。

42.以下针对通过kantorovich relaxation(kantorovich relaxation实际对应为凸最小化问题)实现最佳运输的情况进行说明。

43.设定∑s为一个简单概率,其形式可以参见下述公式(1):

[0044][0045]

在两个任意的集合x和y上定义两个离散度量α和β,分别如下公式(2)所示:

[0046][0047]

其中,以及

[0048]

基于此,继续定义映射t:x

→

y将每一个xi映射至yj,以使所有j∈[m],由质量运输引起的离散概率度量的运输可以用紧凑的前推(push forward)形式t

#

α=β表示。此外,蒙格(monge)问题是要针对在x

×

y上定义的非负成本函数c(x,y)(满足合法距离度量的三个属性)寻求最优的映射t,以最大程度地降低运输成本,例如以下公式(3)所示:

[0049][0050]

特别地,当n=m时,映射t是从源域x到目标域y的双射,并且可以引起σ∈perm(n)的排列,使得txi=y

σ(i)

。

[0051]

在以上设定的基础上,可能存在下述三种情况:

[0052]

第一种:当度量α和β不兼容时,monge问题可能没有解决方案,这通常在目标度量比源度量具有更多点(如,n《m)的情况下发生。此外,当n=m并且目标度量中至少有一个点的质量与源度量的任何点都不匹配时,即时也存在monge问题没有解决方案的情况,反之亦然。

[0053]

为了解决第一种情况中提到的问题,可以将耦合的kantorovich公式描述为质量运输的扩展。不同的是,质量运输是具有确定性的,而kantorovich relaxation则需要考虑概率运输,这种概率运输允许质量从源头分裂到几个目标。通过这种方式,可以解决第一种情况中提到的问题,因为源度量在monge问题中被视为原子,而在kantorovich relaxation方面源度量却是可分离的。

[0054]

为了实现质谱分裂(the mass splitting),定义一个耦合矩阵来代替排列σ或映射t,其中元素p

ij

代表从xi移动到yj的质量。

[0055]

可允许的耦合(admissible coupling)比monge问题中的映射接受更简单的表征,如下公式(4)所示:

[0056][0057]

上述公式(4)针对行和为a向量,列和为b向量的矩阵,由此可见,矩阵集合u(a,b)被n+m个等式约束。

[0058]

第二种:与蒙格映射不同,kantorovich公式在的情况(即耦合矩阵p在u(a.b)中当且仅当p

t

在u(b,a)时)下总是对称的。

[0059]

类似于上述第一种情况公式(3)提及的蒙格问题,令《.,.》为frobenius点积,

kantorovich的最佳运输(ot)问题可以理解为:

[0060][0061]

由公式(5)所示的情况可见,kantorovich的最佳运输(ot)问题属于一个线性规划问题,其中,给定a,b和c。

[0062]

ot问题的一个重要特征是,只要成本矩阵(cost matrix)满足合法距离的属性,它就可以在∑n中诱导两个离散的概率度量(分布)之间的距离。

[0063]

假设是[n]上的距离,且p≥1;则可以将∑n上的p-wasserstein distance定义为:

[0064][0065]

第三种:例如,w1(a,b)=min

p∈u(a,b)e(x.y)~p

[||x-y||]是两个分布之间的合法距离,在wasserstein gan中使用时属于较弱的距离而不是原始gan中的默认jensen-shannon(js)散度和最大化似然估计(mle)中的kullback-leibler(kl)散度。

[0066]

以下针对本技术实施例所涉及的采用熵项调节最佳运输问题在求解过程中实现收敛的情况进行说明。

[0067]

求解原始运输问题(如公式5所示)的解决方案并非是唯一的,并且往往是稀疏的,即到达多面体u(a,b)的某个顶点。在某些情况下,为了避免稀疏的最优耦合,可以考虑使用熵项来形成更“模糊”的预测。如下公式(7)所示的耦合矩阵p的离散熵:

[0068][0069]

结合上述公式(7)所示的情况,给出下述两种情况的说明。

[0070]

第一种:结合定义为负的hessian矩阵且p

ij

≤1可见,熵函数h(

·

)是强凸函数。

[0071]

在本技术中,最佳运输的熵正则化是使用-h(

·

)作为正则化函数来获得原始输运问题(如公式5所示)的近似解。

[0072][0073]

其中,公式(8)所示的情况是ε凸函数的约束最小化问题,因此具有唯一的最优解。

[0074]

此外,以下ε收敛所对应的结果,证实了原始ot和熵正则ot之间的密切关系。

[0075]

ε收敛:在ot问题(公式(5)所示)的所有最优解的集合内,唯一解p

ε

收敛具有最大熵的最优解。

[0076][0077]

基于公式(9)所示的情况,具体地:

[0078][0079]

另外,还可以设定如下:

[0080][0081]

第二种:随着ε的增加,公式(8)所示的最优耦合变得越来越稀疏,这反过来又起到了加速计算算法的作用,并导致更快的收敛。另,还可以通过减小ε的大小以将当前基于熵项求解的情况还原到求解原始的ot问题的基础上。实际上,熵正则化项提供了计算效率与解的稀疏性之间的折衷。

[0082]

以下针对本技术实施例所涉及的标签比例学习进行说明。

[0083]

由于标签比例学习算法是基于深度卷积神经网络进行的,可以考虑将该算法应用于多任务分类领域中,以解决大规模数据的分类问题。在本技术实施例中所涉及的标签比例学习算法是一种特殊的弱监督分类学习算法,其特殊在于训练数据集中给定样本数据所对应的标签不是以“属性-标签”的形式(即类别标签表征样本数据的属性的形式)给出,而是以组(group)或者包(bag)的形式组合在一起,而每个数据包中只给出不同类别样本数据的比例信息。本技术实施例基于标签比例学习进行模型训练的最终目的是获得一个分类器,来预测一个待分类数据所对应的类别标签。

[0084]

请参阅图1,以下结合图1对本技术提出的基础(标签比例学习)进行说明。如图1所示,当前训练数据中包括4个数据包,已知每个数据包中正样本与负样本的比例信息与数据包中所包括样本的数量(数据包的尺寸),但并不明确每个样本所对应的类别(属于正样本还是属于负样本);采用训练数据基于标签比例学习进行模型训练,训练后的模型可以分辨出每个样本所对应的类别。

[0085]

在llp问题中,因为标签的比例信息是已知的,所以可以在使用ot框架时使用这些比例信息来限制自标签过程。在本技术中考虑k(k》2)类的多类llp问题。在没有先验(未知确切的标签分布)的情况下,假设训练数据由n个随机生成的不相交的数据包组成。因此,训练数据d可以用以下形式表示:

[0086][0087]

其中,所有的训练数据d中包含有m个数据包,而其中表示为训练数据集中的第i个包,而每个数据包的具体形式可以表示为如下的

形式其中,pi表示训练数据d中第i个数据包中不同类别样本数据的概率,ni代表训练数据d中第i个数据包的大小或尺寸。

[0088]

基于上述对求解最佳运输问题的方式与标签比例学习的说明,下面针对基于本技术提出的ot-llp算法进行的模型训练方法进行说明。

[0089]

图2中示出了本技术实施例提供的一种多任务分类模型的训练方法,该训练方法具体可以由本技术实施例提供的电子设备执行,具体地电子设备可以是终端,也可以是服务器,终端可以是智能手机、平板电脑、笔记本电脑、台式计算机、智能音箱、智能手表等,服务器可以是独立的物理服务器,也可以是多个物理服务器构成的服务器集群或者分布式系统,还可以是提供云服务、云数据库、云计算、云函数、云存储、网络服务、云通信、中间件服务、域名服务、安全服务、内容分发网络(content delivery network,cdn)、以及大数据和人工智能平台等基础云计算服务的云服务器,但并不局限于此。如图2中所示,该训练方法可以包括步骤s101-s103:

[0090]

步骤s101:获取包括多个数据包的训练数据集,数据包中包括多个样本数据及样本数据所对应类别标签的比例信息。

[0091]

可选地,本技术实施例的多任务分类模型主要基于k(k》2)类的多类问题进行处理,但也可应用于二分类任务中。其中,训练数据集可以参考上述公式(12)的形式,训练数据集d中包括多个随机生成的数据包,数据包互不相交,且已知每个数据包中样本数据所对应类别标签的比例信息。

[0092]

举例说明,假设k=3,训练数据集d中包括4个随机生成的数据包,数据包a中包括类别1共2两个、类别2共4个、类别3共7个,则已知数据包a中类别1的比例信息为2/13,类别2的比例信息为4/13,类别3的比例信息为7/13,以及包的大小n=13;其他3个数据包的已知信息同理。其中,数据包的尺寸遵循网络训练参数的要求,在此仅作为例子进行说明。

[0093]

以交替的形式执行下述步骤s102-s103:

[0094]

步骤s102:基于最新的类别标签信息与训练数据集训练多任务分类模型。

[0095]

步骤s103:采用求解最佳运输问题的方式更新类别标签信息。

[0096]

可选地,以交替的形式执行步骤s102-步骤s103可以理解为每训练一次模型则更新一次类别标签信息,即循环执行步骤s102-s103,直至满足停止训练的条件。

[0097]

在一可行的实施例中,以交替的形式执行步骤s102-s103还可以理解为执行预设次数(或任意次数)的步骤s102后,执行一次步骤s103,进而继续执行预设次数(或任意次数)的步骤s102;即对模型进行多次训练后,更新一次类别标签信息,继而再进行模型的训练。本技术对实际执行的交替形式不作限定。

[0098]

具体地,在初次训练多任务分类模型时,最新的类别标签信息包括根据比例信息预设的类别标签信息。即,在初始化模型的网络参数后,对模型进行首次训练时,尚不存在采用求解最佳运输问题的方式更新的类别标签信息,此时类别标签信息可以是根据比例信息预设的类别标签信息。预设的类别标签信息可以是人工标注,也可以是基于所采集的训练数据集确定的。

[0099]

其中,多任务分类模型可以应用于各种神经网络,本技术实施例对此不作限定。多任务分类模型具体指示多标签分类模型,训练后的多任务分类模型可以处理各种任务数据的分类,如图像分类、各种采集样本分类等。

[0100]

具体地,类别标签信息labels可以理解为类别标签,表征为类别概率,如[0.2,0.3,0.5],labels的每一行是一个概率分布(即概率之和为1)。

[0101]

以下针对本技术实施例所涉及方法从监督学习到无监督学习的推导过程进行说明。

[0102]

在标准的监督学习中,通过深度神经网络(dnn)φ

θ

(

·

)映射后,在高层表示φ

θ

(x)之后紧接完全连接的多层感知器(mlp)以生成特定类的logits。基于这些logits,dnn通过softmax操作获得相应的后验类概率(第一分类概率)。定义多类分类为rd→rk

,相应地,换言之,基于样本数据x的概率输出可以总结如下公式(13)所示:

[0103][0104]

其中是模型的参数。

[0105]

此外,基于训练数据集d={(x1,y1),(x2,y2),

…

,(xn,yn)|(xi,yi)∈x

×

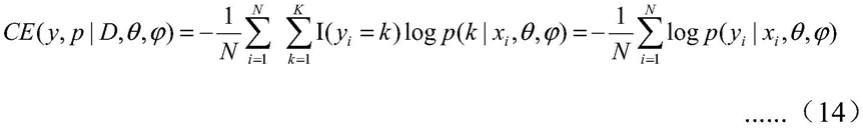

[k]},通过最小化平均交叉熵损失来学习模型dnn的表达部分和头参数交叉熵损失可以参考下述公式(14):

[0106][0107]

另一方面,标准的半监督学习通常利用一种转换方案,通过自标记(self-labeling)或自监督框架(self-supervised)来合并无标签数据的信息。此过程中的关键思想是,当标签不可用时,需要一种自标签机制来自动分配标签。

[0108]

具体地,假设{(x1,y1),(x2,y2),

…

,(x

l

,y

l

)}为带标签数据,并且{x

l+1

,x

l+2

,

…

,x

l+u

}是无标签数据,例如基于该训练数据集通过最小化平均交叉熵损失l来学习模型的表达部分和头参数交叉熵损失可以参考下述公式(15):

[0109][0110]

尽管公式在(14)和(15)中保持不变,但与监督学习中的公式(14)不同,在半监督学习中的转换方案是结合公式(15)与模型的参数和无标签数据的标签同时根据带标签数据中的完全监督信息进行优化,即通过固定其他参数对以下两个公式(16)和(17)所示的情况进行优化:

[0111][0112]

[0113][0114]

其中,y=(y

l+1

,y

l+2

,

…

,y

l+u

)是无标签数据的未知标签。

[0115]

通过同时执行聚类和表示学习,可以将上述公式扩展到训练数据d={x1,x2,

…

,xn}的完全无监督学习场景。但是,这种机制的完整运输不受标签的约束,将导致最终结果的退化:将所有数据点分配给单个(任意)标签。为避免此问题,本技术实施例引入了以下受约束的自标记框架来解决聚类问题。

[0116]

首先,标签的软编码是基于以下公式(18)所示的交叉熵损失,利用概率(非互斥)分类器来推断后验分布(伪标签):

[0117][0118]

其中,q(y|xi)是相应标签的后验分布,p(y|xi)是相应标签的前验分布。

[0119]

具体地,针对固定的p,在ce(p,q)中q的约束最小化问题如下公式(19)所示:

[0120][0121][0122]

基于此,得到了组合编程,因此很难进行优化。但是结合前述的sinkhorn算法,可以将公式(19)转换为标准的最佳运输问题(原始ot问题)进行解决。

[0123]

一般而言,设定q

ij

=qi(xj)/n,同理可得,p

ij

=pi(xj)/n。此外,定义:

[0124][0125]

其中,1n代表所有维度为n的向量。因此,可以定义以下形式的集合:

[0126][0127]

然后,可以采用以下ot问题给出公式(19)的等价问题:

[0128][0129]

结合上述说明,以下针对本技术提出的ot-llp算法以及本技术提供的各可选实施例进行详细说明。

[0130]

在一实施例中,交替执行的步骤s102-s103基于最新的类别标签信息与训练数据集训练多任务分类模型;采用求解最佳运输问题的方式更新类别标签信息,包括以下步骤s201-s202:

[0131]

步骤s201:将最新的类别标签信息与训练数据集输入多任务分类模型,得到第一分类概率。

[0132]

结合公式(13)所示,第一分类概率可以是如[0.95,0.05,0]的概率表达,各个值累计之和为1。

[0133]

可选地,步骤s201将最新的类别标签信息与训练数据集输入多任务分类模型,得到第一分类概率,包括以下步骤s301-302:

[0134]

步骤s301:将最新的类别标签信息与训练数据集输入多任务分类模型,得到模型基于输入数据所表征的特征向量转换的类别分数。

[0135]

步骤s302通过激活函数softmax对类别分数进行处理确定第一分类概率。

[0136]

具体地,类别分数也可以理解为模型输出的logits,模型输出的logit的值域范围[-inf,+inf]属于正负无穷区间;经步骤s302通过softmax函数将一个系列的概率替代物(logits)进行映射(对模型输出的数据进行加工),获得softmax输出的第一分类概率。

[0137]

步骤s202:采用求解最佳运输问题的方式基于第一分类概率与比例约束条件更新类别标签信息。其中,比例约束条件为类别标签信息符合训练数据集每个数据包中的比例信息。

[0138]

在本技术实施例中,模型输出经激活函数softmax加工,可确定为“归一化”的概率:第一分类概率p;采用求解最佳运输问题的方式确定的labels可表征为第二分类概率q。

[0139]

在llp问题中,每个数据包中的类别分布不是均匀的,在本技术实施例中可以修改公式(19)中的比例约束条件或ot问题(公式(22))中的可允许耦合,以适应llp中的比例信息。

[0140]

因此,公式(19)的目标可以成为以下公式(23)所示的目标:

[0141][0142][0143]

其中,表示数据包i中第y个类别的比例。前者可以理解为最小化平均交叉熵损失,后者s.t.所示条件则可被用作约束(比例约束条件),标签应符合每个数据包的比例信

息。公式(23)中的目标包含变量q的组合,因此可能很难优化,但是本技术实施例可以结合求解最佳运输问题的方式相对有效地解决。

[0144]

为了更好地说明上述公式(23),将其重写为矩阵形式。一般而言,设定以及同理可得,以及另外,设:

[0145][0146][0147]

其中,p=(p1,p2,

…

,pm);

[0148]

其中1n代表所有维度为n的向量。因此,可以定义以下形式的集合:

[0149][0150]

在一实施例中,步骤s202采用求解最佳运输问题的方式基于第一分类概率与比例约束条件更新类别标签信息,包括:基于比例约束条件采用求解最佳运输问题的方式计算将第一分类概率所表征的第一概率分布转换为类别标签信息所表征的第二概率分布的最小代价,以确定更新的类别标签信息。

[0151]

具体地,在本技术实施例中可以用以下ot问题给出优化问题的等价问题:

[0152][0153]

其中,等价问题的核心在于将当前的优化问题替代为最佳运输问题中求解最小代价的问题(即将第一概率分布与第二概率分布之间的距离定义为从第一概率分布运输到第二概率分布所需要付出的最小代价)。

[0154]

在一可行的实施例中,步骤s202采用求解最佳运输问题的方式基于第一分类概率与比例约束条件更新类别标签信息,还包括:采用第二概率分布的耦合矩阵的离散熵作为正则函数,基于最小代价和正则函数确定更新的类别标签信息。

[0155]

具体地,在λ

→

+∞的情况下,可以采用下述公式(27)所示代之以解决熵正则化ot问题,以加快该过程,并避免非唯一性稀疏解决方案。

[0156][0157]

其中q所对应的耦合矩阵的离散熵形式如下公式(28)所示:

[0158][0159]

其中,结合公式(7)、(8)和(9)可见,可以通过调整λ约束求解ot问题的最优解。

[0160]

在一实施例中,步骤s102基于最新的类别标签信息与训练数据集训练多任务分类模型,包括以下步骤s401-s402:

[0161]

步骤s401:基于第一分类概率与最新的类别标签信息确定目标函数。

[0162]

具体地,基于第一分类概率表征的第一概率分布与最新的类别标签信息表征的第二概率分布构建目标函数;目标函数为表征第一概率分布与第二概率分布之间的距离的交叉熵损失函数。

[0163]

步骤s402:基于目标函数更新多任务分类模型的网络参数。

[0164]

其中,交叉熵损失函数(cross entropy)用于度量两个概率分布间的差异信息,基于该差异信息作为网络调参的依据。若存在差异时,则基于该差异信息调整模型的网络参数,让差异在模型不断迭代训练的过程中变得更小。通过不断地迭代训练,第一概率分布与第二概率分布将趋近。在一可行的实施例中,将交叉熵损失所度量的差异信息与预设信息进行比较,若比较结果表征当前第一概率分布与第二概率分布的差异仍大于可接受范围时,调整网络参数。

[0165]

基于上述实施例的描述,结合图3所示的原理图,以进一步描述本技术实施例基于ot-llp进行模型训练的过程。

[0166]

在本技术实施例提出的基于ot-llp进行模型训练的框架中,主要包括交替执行以下两个步骤(网络参数以及自标签q的更新):

[0167]

训练网络:由于交叉熵相对于网络参数都是可微的。因此,在训练网络时可以通过固定q,针对公式(23)所示的情况实现网络参数的优化。

[0168]

更新标签:当模型固定时(以当前的网络参数为准),通过ot或者熵正则化ot可确定类别标签q。当采用原始的求解ot问题的方式确定q时,求解所得的q为0或1的二进制元素。当采用求解熵正则化ot问题的方式确定q时,求解所得的q为[0,1]的元素。

[0169]

在一可行的实施例中,在更新标签时,可以采用以下两种方法:硬标签方法和软标签方法。

[0170]

其中,当采用硬标签方法更新标签时,可以如下公式(29)所示情况进行类别标签q的更新:

[0171][0172]

当采用软标签方法更新标签时,通过求解最佳运输问题的方式来获得更新的类别标签q。

[0173]

结合上述实施例的说明,下面给出一种可行的实施例对基于ot-llp算法进行模型训练时执行的步骤进行说明。

mnist(草书日语的数据集),fashion-mnist(机器学习算法的新型图像数据集)和cifar-10(用于普适物体识别的数据集)。

[0192]

在实验中,首先需要生成用于训练模型的训练数据集,具体为比例信息;其次,需要设定训练的网络。在生成训练数据集时,构造了四种数据包,数据包的大小分别为16、32、64和128,其中每个数据包的比例都是通过标签信息进行计算的。且为了避免不同标签分布的影响,根据不同算法固定数据包的设置。以下结合表1所示的针对不同数据包尺寸进行实验时在不同数据集上所对应的测试错误率(精度=1-测试错误率)和标准偏差(%),可有效证明本技术提出的ot-llp算法训练所得模型在各个数据集中的性能较算法dllp(深度标签比例学习)训练所得模型的性能要好。

[0193]

表1

[0194][0195][0196]

基于同一发明构思,本技术实施例还提供了一种数据分类方法,该方法包括步骤a1-a2:

[0197]

步骤a1:获取待分类的数据。

[0198]

步骤a2:通过多任务分类模型对待分类的数据进行处理,确定待分类的数据对应的类别标签。

[0199]

其中,该多任务分类模型是采用本技术任一可选实施例所提供的训练方法训练而得,各个训练步骤可参考上述实施例,在此不再赘述。

[0200]

本技术提出的算法ot-llp经典的应用场景是针对现实生活中以比例的形式给出的数据进行预测,以下提供两个应用例,对本技术提出的ot-llp算法的应用场景进行说明,但并不限定仅可应用于以下场景。

[0201]

在一应用例中,应用场景为投票选举,通过公告的投票结果仅知悉每位候选人在不同地区所获选票的比例,而无法知悉具体每个人的选举情况;在此基础上,可采用当前知悉的每位候选人在不同地区所获选票的比例作为训练数据集(如可以根据不同地区的选票情况(每位候选人所获选片的比例以及该地区投票数)生成不同的数据包,基于此,每个数据包互不相交,且已知每个数据包的比例信息与尺寸),采用本技术提出的ot-llp算法训练多任务分类模型,训练后的模型可以基于样本(进行投票的人员)所表征的特征预测进行投

票人员的投票结果(具体选择哪一位候选人)。

[0202]

在另一应用例中,应用场景为医疗疾病预测,由于病人的信息一般具有很强的隐私性,医院不可在未经病人同意的情况下披露病人患病信息,但是结合医疗疾病的预测方案,可有效且及时地发现病人的患病情况,对病人进行及时的救治。在保护病人隐私以及进行有效及时的患病信息预测两者的权衡下,医院可以通过对病人患病信息进行分析处理,将分析后的结果采用比例的方式提供给进行医疗疾病预测的第三方机构,由第三方机构基于当前患病的比例信息对病人的所患病的风险进行预测,可有效解决在保护病人隐私的同时,采用了科学的手段及时有效地发现病人的患病风险。基于此,可以采用当前知悉的由医院提供的不同科室或不同地区患病的比例信息作为训练数据集,采用本技术提出的ot-llp训练多任务分类模型,训练后的模型可以基于样本(病人)所表征的特征预测病人所患某种疾病的风险。

[0203]

对应于本技术所提供的训练方法,本技术实施例还提供了一种多任务分类模型的训练装置,如图4中所示,该装置400可以包括:获取模块401和训练模块402。

[0204]

其中,获取模块401,用于获取包括多个数据包的训练数据集,数据包中包括多个样本数据及样本数据所对应类别标签的比例信息。

[0205]

训练模块402,用于交替执行以下步骤:基于最新的类别标签信息与训练数据集训练多任务分类模型;采用求解最佳运输问题的方式更新类别标签信息。

[0206]

可选地,训练模块402还用于交替执行下述步骤:将最新的类别标签信息与训练数据集输入多任务分类模型,得到第一分类概率;采用求解最佳运输问题的方式基于第一分类概率与比例约束条件更新类别标签信息;其中,比例约束条件为类别标签信息符合训练数据集每个数据包中的比例信息。

[0207]

可选地,训练模块402还用于基于比例约束条件采用求解最佳运输问题的方式计算将第一分类概率所表征的第一概率分布转换为类别标签信息所表征的第二概率分布的最小代价,以确定更新的类别标签信息。

[0208]

可选地,训练模块402还用于采用第二概率分布的耦合矩阵的离散熵作为正则函数,基于最小代价和正则函数确定更新的类别标签信息。

[0209]

可选地,训练模块402还用于将最新的类别标签信息与训练数据集输入多任务分类模型,得到模型基于输入数据所表征的特征向量转换的类别分数;通过激活函数softmax对类别分数进行处理确定第一分类概率。

[0210]

可选地,训练模块402还用于基于第一分类概率与最新的类别标签信息确定目标函数;基于目标函数更新多任务分类模型的网络参数。

[0211]

可选地,训练模块402还用于基于第一分类概率表征的第一概率分布与最新的类别标签信息表征的第二概率分布构建目标函数;目标函数为表征第一概率分布与第二概率分布之间的距离的交叉熵损失函数。

[0212]

可选地,在初次训练多任务分类模型时,最新的类别标签信息包括根据比例信息预设的类别标签信息。

[0213]

对应于本技术所提供的数据分类方法,本技术还提供了一种数据分类装置500,如图5所示,该装置500可以包括:数据获取模块501和数据处理模块502。

[0214]

其中,数据获取模块501,用于获取待分类的数据。

[0215]

数据处理模块502,用于通过多任务分类模型对待分类的数据进行处理,确定待分类的数据对应的类别标签。

[0216]

其中,多任务分类模型本技术实施例提供的多任务分类模型的训练方法训练而得。

[0217]

本技术实施例的装置可执行本技术的实施例所提供的方法,其实现原理相类似,本技术各实施例中的装置中的各模块所执行的动作是与本技术各实施例中的方法中的步骤相对应的,对于装置的各模块的详细功能描述具体可以参见前文中所示的对应的方法中的描述,此处不再赘述。

[0218]

本技术还提供了一种电子设备,该电子设备包括存储器和处理器;其中,存储器中存储有计算机程序;处理器用于在运行计算机程序时,执行本技术任一可选实施例中所提供的方法。

[0219]

本技术还提供了一种计算机可读存储介质,该存储介质中存储有计算机程序,计算机程序在被处理器运行时,执行本技术任一可选实施例中所提供的方法。

[0220]

作为一可选方案,图6示出了本技术实施例适用的一种电子设备的结构示意图,如图6所示,该电子设备600可以包括处理器601和存储器603。其中,处理器601和存储器603相连,如通过总线602相连。可选地,电子设备600还可以包括收发器604。需要说明的是,实际应用中收发器604不限于一个,该电子设备600的结构并不构成对本技术实施例的限定。

[0221]

处理器601可以是cpu(central processing unit,中央处理器),通用处理器,dsp(digital signal processor,数据信号处理器),asic(application specific integrated circuit,专用集成电路),fpga(field programmable gate array,现场可编程门阵列)或者其他可编程逻辑器件、晶体管逻辑器件、硬件部件或者其任意组合。其可以实现或执行结合本技术公开内容所描述的各种示例性的逻辑方框,模块和电路。处理器601也可以是实现计算功能的组合,例如包含一个或多个微处理器组合,dsp和微处理器的组合等。

[0222]

总线602可包括一通路,在上述组件之间传送信息。总线602可以是pci(peripheral component interconnect,外设部件互连标准)总线或eisa(extended industry standard architecture,扩展工业标准结构)总线等。总线602可以分为地址总线、数据总线、控制总线等。为便于表示,图6中仅用一条粗线表示,但并不表示仅有一根总线或一种类型的总线。

[0223]

存储器603可以是rom(read only memory,只读存储器)或可存储静态信息和指令的其他类型的静态存储设备,ram(random access memory,随机存取存储器)或者可存储信息和指令的其他类型的动态存储设备,也可以是eeprom(electrically erasable programmable read only memory,电可擦可编程只读存储器)、cd-rom(compact disc readonly memory,只读光盘)或其他光盘存储、光碟存储(包括压缩光碟、激光碟、光碟、数字通用光碟、蓝光光碟等)、磁盘存储介质或者其他磁存储设备、或者能够用于携带或存储具有指令或数据结构形式的期望的程序代码并能够由计算机存取的任何其他介质,但不限于此。

[0224]

存储器603用于存储执行本技术方案的应用程序代码,并由处理器601来控制执行。处理器601用于执行存储器603中存储的应用程序代码(计算机程序),以实现前述任一

方法实施例所示的内容。

[0225]

本技术所提供的实施例中,由电子设备执行的上述数据分类方法可以使用人工智能模型来执行。

[0226]

根据本技术的实施例,在电子设备中执行的该方法可以通过使用图像数据或视频数据作为人工智能模型的输入数据来获得识别图像或图像中的图像内容特征的输出数据。人工智能模型可以通过训练获得。这里,“通过训练获得”意味着通过训练算法用多条训练数据训练基本人工智能模型来获得被配置成执行期望特征(或目的)的预定义操作规则或人工智能模型。人工智能模型可以包括多个神经网络层。多个神经网络层中的每一层包括多个权重值,并且通过在前一层的计算结果与多个权重值之间的计算来执行神经网络计算。

[0227]

本技术所提供的实施例中,可以通过ai模型来实现多个模块中的至少一个模块。可以通过非易失性存储器、易失性存储器和处理器来执行与ai相关联的功能。

[0228]

该处理器可以包括一个或多个处理器。此时,该一个或多个处理器可以是通用处理器,(例如中央处理单元(cpu)、应用处理器(ap)等)、或者是纯图形处理单元(,例如,图形处理单元(gpu)、视觉处理单元(vpu)、和/或ai专用处理器(,例如,神经处理单元(npu))。

[0229]

该一个或多个处理器根据存储在非易失性存储器和易失性存储器中的预定义的操作规则或人工智能(ai)模型来控制对输入数据的处理。通过训练或学习来提供预定义的操作规则或人工智能模型。

[0230]

这里,通过学习来提供指的是通过将学习算法应用于多个学习数据来得到预定义的操作规则或具有期望特性的ai模型。该学习可以在其中执行根据实施例的ai的装置本身中执行,和/或可以通过单独的服务器/系统来实现。

[0231]

该ai模型可以由包含多个神经网络层组成。每一层具有多个权重值,一个层的计算是通过前一层的计算结果和当前层的多个权重来执行的。神经网络的示例包括但不限于卷积神经网络(cnn)、深度神经网络(dnn)、循环神经网络(rnn)、受限玻尔兹曼机(rbm)、深度信念网络(dbn)、双向循环深度神经网络(brdnn)、生成对抗网络(gan)、以及深度q网络。

[0232]

学习算法是一种使用多个学习数据训练预定目标装置(例如,机器人)以使得、允许或控制目标装置进行确定或预测的方法。该学习算法的示例包括但不限于监督学习、无监督学习、半监督学习、或强化学习。

[0233]

应该理解的是,虽然附图的流程图中的各个步骤按照箭头的指示依次显示,但是这些步骤并不是必然按照箭头指示的顺序依次执行。除非本文中有明确的说明,这些步骤的执行并没有严格的顺序限制,其可以以其他的顺序执行。而且,附图的流程图中的至少一部分步骤可以包括多个子步骤或者多个阶段,这些子步骤或者阶段并不必然是在同一时刻执行完成,而是可以在不同的时刻执行,其执行顺序也不必然是依次进行,而是可以与其他步骤或者其他步骤的子步骤或者阶段的至少一部分轮流或者交替地执行。

[0234]

以上所述仅是本发明的部分实施方式,应当指出,对于本技术领域的普通技术人员来说,在不脱离本发明原理的前提下,还可以做出若干改进和润饰,这些改进和润饰也应视为本发明的保护范围。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1