基于VI-SLAM和深度估计网络的无人机场景稠密重建方法与流程

基于vi-slam和深度估计网络的无人机场景稠密重建方法

技术领域

[0001]

本发明涉及一种基于vi-slam(视觉惯导融合同时定位与建图)和深度估计网络的无人机场景稠密重建方法,属于虚拟现实领域。

背景技术:

[0002]

三维重建是指对三维物体建立适合计算机表示和处理的数学模型,是在计算机环境下对其进行处理、操作和分析其性质的基础,也是在计算机中建立表达客观世界的虚拟现实关键技术。随着三维重建需求日益增加以及无人机航拍的不断普及,基于无人机航拍图像的点云重建工作成为了研究热点。

[0003]

传统的利用深度相机或基于sfm的稠密重建方式,需要较为复杂的硬件设备以及较为庞大的运算资源,不能很好的满足无人机大规模场景重建中设备轻量化及快速重建的需求。kinectfusion给出了令人印象深刻的结果,它将kinect测量的深度图作为输入,同时使用迭代最近点(icp)对相机本身进行定位,并使用tsdf融合将所有测量融合到全局图中。虽然rgb-d摄像机提供几乎没有异常的深度测量,但由于它是基于tof相机实现的,它只能在四到五米距离内保持准确地测量。因此它们无法在室外这种大场景中工作。针对场景快速重建的需求,深度学习在深估计方面的应用为研究者提供了新的思路。由tateno等人在2017年提出的cnn-slam,作者提出了一种利用cnn结合slam的应用,主要流程为:利用直接法slam进行相机跟踪并提取关键帧,在所提取的关键帧上预测单帧图深度值得到深度图。但是基于深度学习的单张图像深度估计方法主要关注单视图的场景信息与深度信息的直接对应关系,直接在单张图像的基础上对深度信息进行估计。在模型设计过程中没有充分利用环境信息中包含的几何约束,模型精度依赖训练数据集质量,导致网络缺乏泛化能力。

[0004]

基于sfm技术的场景稠密重建方式,主要利用图像之间的特征匹配关系构建图像间的几何信息约束,并通过全局优化的方式获取满足几何约束的点云重建结果。这种方式在对地图点云优化时需要使用大量的计算资源,忽略重建过程的效率,需要较长时间获取点云模型。

[0005]

对以上当前工作的一些局限性,本发明提出一种基于vi-slam和深度估计网络的无人机场景重建的方法,通过综合利用图像的场景信息提升场景重建的运行效率,能够解决大场景无法快速重建的问题。

技术实现要素:

[0006]

本发明的技术解决问题:克服现有技术的针对大规模场景无法快速稠密重建的问题,提供一种基于vi-slam和深度估计网络的无人机场景稠密重建方法,通过实时跟踪相机姿态,并通过单张图片的深度估计实现对场景深度信息的估计,可以在重稠密建时达到较快的运行效率。实验表明本发明的算法能够显著提高场景重建的效率,对视频流处理速度可以达到每秒1.3帧;同时能够保证大场景重建结果的全局一致性。

[0007]

本发明所采取的技术方案是:一种基于vi-slam和深度估计网络的无人机场景稠

密重建方法,利用中低空采集到航拍图像与imu信息进行融合,估计出相机空间位姿,并初步获取场景三维结构;然后利用深度估计网络估计单目图像中场景的深度信息,为场景稠密重建提供基础。最终利用获取到的深度信息以及相机姿态,将所得局部点云进行全局一致性融合达到三维场景快速重建的目的。

[0008]

具体包含步骤如下:

[0009]

步骤1:将惯性导航器件imu固定到无人机上,并对无人机自带的单目相机内参、外参和惯性导航器件imu的外参进行标定;

[0010]

步骤2:利用无人机自带的单目相机及绑定的imu器件采集无人机场景的图像序列并按固定频率获取无人机飞行时各时间点处imu信息;

[0011]

步骤3:使用融合视觉与惯性导航的同时定位与建图方法,即vi-slam算法对步骤2中的图像序列和imu信息进行处理,分为跟踪、局部地图优化、回环检测三个线程,最终得到带有尺度信息即绝对位移信息的相机位姿;

[0012]

步骤4:将单目图像信息作为左视图输入视点生成网络,得到右视图,再将左视图和右视图输入深度估计网络,得到图像深度信息;

[0013]

步骤5:将步骤3中得到的相机位姿和步骤4中的图像深度信息进行结合,得到局部点云;

[0014]

步骤6:经过点云优化及配准,将局部点云融合,得到无人机场景的稠密点云模型。

[0015]

所述步骤3中,vi-slam算法的实现过程如下:

[0016]

vi-slam算法分为三个线程,为属于前端的跟踪线程和属于后端的局部地图优化线程与回环检测线程:

[0017]

跟踪线程,主要为优化线程提供关键帧的初始值,并维护一个固定大小窗口控制优化的规模,先对vi-slam系统进行初始化,获得相机的初始位姿估计和尺度因子、重力方向、imu偏置及速度;然后计算跟踪过程中旋转、速度、位置的噪声协方差传递;最后基于滑动窗口跟踪相机位姿,对新帧位姿进行定位并标记出新的关键帧,还要通过边缘化掉旧帧以维护一个固定大小的滑动窗口;

[0018]

局部地图优化线程,对跟踪线程中滑动窗口里的关键帧信息作进一步的位姿优化,利用关键帧之间的共视关系创建局部地图,针对局部地图内由观测差异产生的残差进行非线性优化,获取更为精确的相机位姿估计;

[0019]

回环检测线程,是检测跟踪过程中是否产生回环,当产生回环时,利用构成回环的帧之间的相对位姿,作为约束关系对局部地图优化中估计的位姿进一步矫正,保证位姿估计的一致性,由于跟踪过程中融合了imu信息,相机位姿的尺度信息是可观的,通过回环帧之间的矫正,相机位姿更加精确,最终得到带有尺度信息即绝对位移信息的相机位姿。

[0020]

所述跟踪线程的实现为:

[0021]

(1)vi-slam系统初始化,采用松耦合的方式,先进行视觉初始化,获取帧与帧之间的相对位姿,再根据获取到的位姿与imu的对应关系求解出imu初始化数值,视觉初始化以首帧的位姿作为全局基准坐标,采用对极几何方式对相机位姿进行初始估计,得到相机间的相对位姿;利用imu测量值与相机跟踪相对位姿的关系计算出重力方向,尺度因子,imu偏置,最后求出速度;

[0022]

(2)协方差传递,imu测量数据受到噪声的影响,噪声服从高斯分布,通过建立旋

转、速度、位置的噪声模型,获取优化变量的协方差信息,作为优化时的权重因子;

[0023]

(3)基于滑动窗口的位姿跟踪,维护一个固定大小的窗口,所述窗口由最近相邻帧及最近关键帧组成,新帧到来时,先标记其是否为关键帧,并对旧帧进行边缘化,以便新帧进入窗口,如果次新帧是关键帧时使用关键帧边缘化,即边缘化掉滑动窗口中最老的关键帧;否则将次新帧进行边缘化,边缘化方法采用shur分解,保证保留先验信息在优化问题中。

[0024]

所述局部地图优化的实现为:

[0025]

(1)对于跟踪线程中维护的滑动窗口,将新到窗口的帧首先与上一相邻帧进行优化,最小化两帧之间的重投影误差、imu测量与视觉测量之间的差异,此时由于只涉及两帧之间的位置优化,计算速度很快;

[0026]

(2)如果新到窗口的帧是关键帧,将与当前关键帧具有共视关系的所有关键帧视为当前关键帧的局部地图,在进行优化时将利用局部地图中的所有共视关系产生的约束对此局部地图中的所有相机位姿进行优化,此非线性优化通过最小化共视帧之间的重投影误差、imu测量与视觉测量之间的差异、先验误差进行计算,参与优化的所有关键帧获得更加精确的相机位姿估计。

[0027]

所述回环检测的具体实现如下:

[0028]

(1)对于新来的关键帧,利用词袋模型加速特征匹配。找出新帧与其局部地图中关键帧的最小相似度分数,以该值作为阈值;然后从之前的所有关键帧(不包括当局部地图的关键帧)中找出与新帧相似度分数大于阈值的关键帧,将这些关键帧进行分组,每个关键帧和与其相邻最紧密的前10个关键帧分为一组,计算每组总得分以及每组得分最高的关键帧,然后以组得分最高值的75%作为新阈值,找出高于这个新阈值的所有组里面得分最高的帧作为回环候选帧;对新帧的相邻帧与候选帧的相邻帧进行匹配,检查其是或否有相同的相邻关键帧均检查通过,认为回环检测成功;

[0029]

(2)只要回环检测成功,代表相机回到了原来经过的某一地点,利用回环帧与新帧的位姿关系消除跟踪过程中的累积误差,固定住新帧与回环帧的位置作为全局约束,在此基础上通过最小化共视帧之间的重投影误差、imu测量与视觉测量之间的误差,进行全局非线性优化,调整中间的关键帧位姿,使得局部地图优化得到的相机位姿进一步精确。由于跟踪过程中融合了imu信息,相机位姿的尺度信息是可观的,最终得到带有尺度信息即绝对位移信息的相机位姿;将回环检测成功的帧与回环帧之间新的约束关系添加到全局位姿优化中,重新构建优化问题,通过最小化共视关键帧之间的重投影误差以及imu测量与视觉测量之间的差异,最终得到精度更高的带尺度的位姿估计。

[0030]

所述步骤4中,得到图像深度信息的过程如下:

[0031]

(1)网络整体结构,将深度估计任务分为两个子问题,一是由单目视图作为左视图,经由视点估计网络生成右视图;二是由左视图和右视图联合输入深度估计网络得到深度估计结果;第一子问题采用deep3d网络结构,分为主预测网络和选择层两部分,主预测网络基于vgg16,在每一个池化层之后有一个分支,用反卷积层上采样输入的特征图,将分支得到特征图进行叠加,得到一个和输入图像尺寸一致的特征表示;之后选择层通过这个特征再次卷积,并在每个空间位置通道上进行一次softmax变换,得到不同视差下的概率分布图,对图像每个像素按视差概率加权计算该点的偏移,输出的加权结果即为最终生成的右

视图;第二子问题网络采用flownetcorr网络结构,该网络也分为两个部分,一为收缩部分,由卷积层组成,用于提取两个图片的特征并进行融合,二为扩大层,将深度预测恢复到高像素,收缩部分先将左右两个视图各进行三次卷积操作,提取两个视图的特征,然后将特征信息进行匹配融合;扩大层由反卷积层和一个卷积层组成,反卷积过程中对每层获取到的特征上采样,并与收缩部分对应的特征进行连接,反卷积4次后结束,得到深度估计图;

[0032]

(2)模型训练,模型训练过程分为两个阶段,第一阶段单独训练视点生成网络和深度估计网络;第二阶段将两部分合为一个整体,采用端到端方式进行训练;对于视点生成网络利用vgg16作为基准网络并利用在imagenet上的训练的参数作为网络参数的初始化,对于网络中其他参数,利用deep3d的训练结果作为对应初始化数值;在此基础上,利用从kitti数据集中选取的22600组双目图像作为训练集对视点生成网络做进一步训练,模型以0.0002学习率迭代20万次及以上,对于双目深度估计网络,利用虚拟数据集flyingtings3d对网络进行训练;第二阶段,将上述训练好的两个网络结合起来进行端到端的训练,选取kitti数据集中200对存在视差的帧对,在微调试过程中使用,同时保证微调数据集中不包含测试数据集中已选的帧,另外由于kitti数据分辨率高于视点生成图像的分辨率,需要对视点生成获取到的右图进行上采样使得双目分辨率保持一致;

[0033]

(3)深度估计结果,利用训练后得到的网络模型,即实现对单目图像的深度估计,单目图像作为左视图输入到深度估计网络后,先通过视点生成得到右视图,之后将左右视图联合进行深度估计,得到图像的深度信息,视点生成结果及深度估计结果示意图如附图4所示。

[0034]

所述步骤5,局部点云的生成过程如下:

[0035]

局部点云由一组离散的点组成,每个点对应二维图像中的某个像素,其具有x,y,z三维坐标和r,g,b彩色信息,二维图像和三维空间点的对应关系通过针孔相机模型进行计算,该模型公式如公式(a)所示:

[0036][0037]

其中,针孔相机模型中包含x轴方向焦距f

x

、y轴方向焦距f

y

、x轴方向光心位置c

x

、y轴方向光心位置c

y

模型参数,(u,v)代表图像的像素坐标,d为图像深度信息提供的像素点的深度值,公式右侧即为空间点三维坐标的齐次表达式,通过将求解单张图像上每个像素点的三维坐标即得到局部点云;

[0038]

以上局部点云的坐标对应的是相机坐标系下的位置,利用估计的相机位姿,将局部点云中各点的空间坐标变换到统一的全局坐标之下,以便后续的点云融合。

[0039]

所述步骤6,点云优化及配准、融合的过程如下:

[0040]

(1)点云优化中的外点剔除,用深度信息恢复的点云存在大量估计不精确的深度点,其中表现最突出的就是离群点,即部分像素点距离相邻其他空间点的距离明显偏离点群,使用lof算子、视差阈值以及视点共视关系多种约束方式对点云中外点进行剔除,为描述空间点周围的点云分布情况,设局部可达密度lrd

k

(p)表示点p的邻域内点到目标点的平均可达距离的倒数,n

k

(p)是点p的第k距离领域,reach-distance(p,o)是点o到点p的第k可达距离,点p的局部可达密度计算公式如公式(b)所示:

[0041][0042]

根据计算获取到的可达密度,进一步计算空间点对应的lof因子,计算公式如公式(c)所示,当lof

k

(p)大于1时说明当前点分布相比其他点更为稀疏,视为候选外点;此外点剔除过程中,一方面按照视差阈值提取0-30m的空间点,另外只考虑根据共视区域划分出深度估计精确区域进行场景,在此基础上剔除掉候选外点,为点云融合提供精确信息;

[0043][0044]

(2)点云优化中进行三边滤波,同时计算位姿、像素、深度差异作为滤波权重值,滤波因子计算公式如下:

[0045][0046]

s表示滤波核的范围,i表示对应点的像素值,d表示对应点的深度值,为点p和点q位姿差异的高斯权重函数,为像素差异的高斯权重函数,为深度差异的高斯权重函数,w

p

为各高斯分布权重的连续乘积,计算公式为(e),

[0047][0048]

其中,物体边缘色差越大的区域,i

p-i

q

和d

p-d

q

取值越大,权重结果越接近于0,有效保留物体边缘信息;对于同一物体深度色差不明显的区域,对应的i

p-i

q

和d

p-d

q

接近于0,其权重结果接近于1,三边滤波接近高斯滤波,滤波后达到很好的平滑效果;通过三边滤波,在保留物体边缘信息的基础上进行降噪,进一步提升点云的精确度;

[0049]

(3)点云配准及融合,首先通过icp算法针对具有共视关系的两组点云,利用特征点对应关系估计点云之间的相对位姿;然后进行尺度配准,将点云位姿与slam跟踪的位姿进行比较即可将点云与相机位姿融合,融合时以相机跟踪位姿为准,将局部点云按照路径轨迹完成融合,获得全局一致的无人机场景稠密点云模型。

[0050]

本发明是在跟踪过程中将视觉信息和imu信息进行融合,获得更加精确的相机姿态,利用深度学习方法估计出图像深度信息,实现对三维场景的重建,得到无人机场景的点云模型。

[0051]

本发明与现有技术相比的优点在于:

[0052]

(1)本发明提出一种新的单目深度估计的方式,先利用视点生成网络,估计各像素点在对应视图下的视差信息,为保证视图生成的精确性,我们利用概率分布的形式描述视差信息,再此基础上构建新视点下的图像;然后通过两张图像构建的双目系统生成对应的深度信息。早期基于深度学习方式进行单目深度估计的方法在精度方面表现不佳,主要原因是直接利用单目图像和对应深度图对网络进行训练,在预测过程中缺乏场景几何信息的约束。相反基于深度学习方式的双目视觉深度估计方法综合表现优于单目深度估计。该方

法在深度估计时充分考虑了场景内的几何约束,在精度方面远高于传统单张图像深度估计方法。同时由于划分为两个相对独立的任务,在训练时,对数据集的要求相对较低,并不需要大量的真实场景稠密深度图信息。此网络有较好的泛化能力,利用虚拟场景对网络进行训练,依然能够保证较高的精确性。试验证明,在kitti数据集上深度估计精度高于传统方法,在0-50m的范围内ard残差可以达到0.09。本发明针对大规模场景无法快速稠密重建的问题,使用vi-slam技术实时跟踪相机姿态,并通过单张图片的深度估计实现对场景深度信息的估计。可以在稠密重建时达到较快的运行效率。实验表明本发明的算法能够显著提高场景重建的效率,对视频流处理速度可以达到每秒1.3帧;同时能够保证大场景重建结果的全局一致性。

[0053]

(2)本发明中利用输入相机位姿与图像深度信息恢复局部点云,并针对局部点云中存在的外点过多、物体边缘不清晰等问题,提出基于lof算子的点云异常值处理、点云三边滤波等算法。传统基于特定阈值的外点剔除方式,缺乏对空间点周围点云分布的整体观测,在外点计算时完全依靠先验信息,不能很好的适应大部分场景。lof算法同时考虑点间距与周围点云分布情况,在计算外点时可以自适应的计算点周围的点云分布,进而能够自适应的根据周边点云分布情况判断该点是否为离群点,进行外点剔除工作。在密度不均匀的点云中有相对传统的特定阈值策略具有更好的剔除效果。但是对于物体边缘,深度估计依然存在深度信息过于连续,无法区分不同物体的情况,采用三边滤波后,可以有效区分色差较大和深度差异较大的区域,而对深度和色差区别不大的区域进行很好的平滑效果,同一物体点云更加紧凑,粘连现象得到解决。实验表明,本发明方法的点云重建比例可以达到百分之二十,远高于同场景下的slam方式。同时能够保证单帧图像场景30m之内的场景信息,在进行全局重建时可以保证点云没有断层现象出现,可以达到较好的可视化效果。

附图说明

[0054]

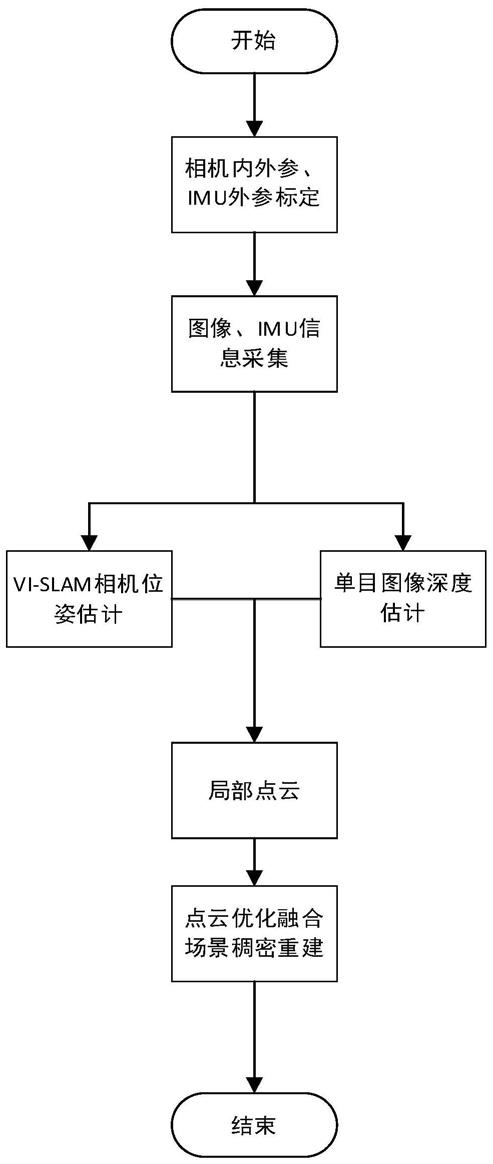

图1是本发明方法实现流程示意图;

[0055]

图2是本发明中单目图像深度估计流程示意图;

[0056]

图3是本发明中单目图像深度估计结果示意图;

[0057]

图4是本发明中点云优化结果示意图;

[0058]

图5是本发明中尺度配准示意图;其中(a)为尺度配准前情况;(b)为尺度配准后情况;

[0059]

图6是本发明中三维场景重建结果示意图,(a)为vi-slam定位结果,(b)为稠密场景重建结果俯视图;(c)为稠密场景重建结果全视图。

具体实施方式

[0060]

下面结合附图和实施示例对本发明作进一步详细地描述:

[0061]

本发明中无人机场景重建方法的基本操作是使用配置imu元件的无人机对三维环境进行摄影,将获取到的信息传输给后端进行处理,输出无人机场景稠密重建点云效果图。

[0062]

如图1所示,本发明的基于vi-slam和深度估计网络的无人机三维重建方法步骤如下:

[0063]

(1)将惯性导航器件imu固定到无人机上,并对无人机自带单目相机内参、外参和

imu外参进行标定;

[0064]

(2)使用无人机单目相机和imu采集无人机场景的图像序列及imu信息;

[0065]

(3)使用vi-slam对步骤(2)中采集的图像和imu信息进行处理,得到带尺度信息的相机位姿;

[0066]

(4)将单目图像信息作为原视图输入视点生成网络,得到右视图,再将原视图和右视图输入深度估计网络,得到图像的深度信息;

[0067]

(5)将步骤(3)中得到的相机姿态和步骤(4)中的深度图进行结合,得到局部点云;

[0068]

(6)经过点云优化及配准,将slam跟踪轨迹与局部点云融合,从而得到无人机场景稠密点云模型。

[0069]

结合相关附图阐述各步骤中做出的创新,具体内容如下:

[0070]

(1)单目图像深度估计

[0071]

如图2所示,本发明将单张图像深度估计划分为视点生成与双目深度估计两个子任务。通过两个相对独立的任务解决单目深度估计问题,其中视点生成与双目深度估计都充分考虑了场景几何信息;此外在模型训练时可以使用虚拟数据集进行训练,有效解决真实场景训练数据不足的问题。同时整体模型训练完成后,利用端到端的训练方式对网络估计结果进行微调。先将原单目图像作为左视图输入deep3d视点生成网络,生成不同视差下的概率分布图,利用图像与视差概率的加权结果作为右视图。deep3d相比于传统视差对应像素计算,对于待优化量是可导的,具体计算如公式(1)所示,其中为视差为d时对应的像素值,d

d

为视差对应的权重。在新像素计算过程中采用加权的方式求解。

[0072][0073]

将原视图及其生成的右视图输入flownetcorr深度估计网络,对图像深度信息进行预测。在进行单独的三次卷积操作之后,将获取的特征信息输入到关联层corr进行信息融合。对融合后新的特征利用卷积对其进一步处理。在反卷积过程中,本发明利用卷积过程中各层级获取的特征信息进行融合最终获取目标深度图像。

[0074]

(2)点云处理及尺度对准

[0075]

网络估计结果在物体边缘部分并不理想,主要表现为物体边缘估计结果过于平滑,无法区分边缘信息;同时深度信息中存在大量异常值,对于生成的局部点云,利用lof(local outlier factor)算子剔除深度信息的离群点,并且利用融合多种场景信息滤波方式增强点云边缘区分度。lof算法利用空间点之间的距离关系判断该点是否为外点,对稠密点云中的离群点有很明显的剔除作用。

[0076]

定义局部可达密度lrd

k

(p)表示点p的邻域内点到目标点的平均可达距离的倒数。根据可达密度,计算空间点对应的lof因子,其计算公式如公式(2)所示。当lof

k

(p)大于1时说明当前点分布相比其他点更为稀疏,可以视为候选外点。

[0077][0078]

在外点剔除过程中,利用视差阈值约束剔除深度值过大的空间点。场景深度估计

过程依赖图像中的视差信息,在相机焦距一定的情况下,深度值越大在图像中的视差越不明显,深度误差越为严重,因此在局部点云重建时为点云深度设置提取区间,根据实验结果,重建过程中主要利用0-30m范围内的空间点。实验证明这种方法在保证点云精度提到的同时能够场景重建的完整性。

[0079]

为保证不同物体边界的可区分性,在传统滤波的基础上同时融入色差信息与深度差异信息形成多边形式的滤波方案,计算公式如下:

[0080][0081]

如图4所示,为点云优化方法在kitti数据集上的单张图像测试结果,其中点云优化前框住的区域表示重建过程中点云存在问题的区域,点云优化后框住的区域为点云优化对点云结果的改进。在点云优化前,点云深信息来源于深度估计结果,对于物体边缘区域存在点云粘连现象,导致不同物体间点云区分不明显,径优化过后可以看出同一物体点云更加紧凑,粘连现象得到解决。根据实验结果表明,本发明方法的点云重建比例可以达到百分之二十,远高于同场景下的slam方式。同时我们能够保证单帧图像场景30m之内的场景信息,在进行全局重建时可以保证点云没有断层现象出现,达到较好的可视化效果。

[0082]

点云配准过程中使用迭代最近点算法(icp),对sift特征点对应的三维空间点进行配准。通过点云配准获取到的点云位姿与slam过程跟踪的位姿进行比较即可将点云与相机位姿融合。由于点云是利用深度学习获取的深度信息恢复出的空间点,场景信息精度方面相比跟踪轨迹略显不足。因此,在计算对应关系时主要以相机跟踪位姿为准。考虑到尺度信息对旋转不会产生影响,因此在位姿比较过程中忽略旋转矩阵,主要考虑位移向量之间的差异。同时重建算法目标场景为城市街道,运动过程中存在运动主方向,因此在计算对应关系时主要参考运动主方向上的对应关系。由于深度估计过程中在视点生成与双目深度估计的网络构建中都利用了场景的几何信息,所以深度估计结果隐含特定双目基线距离信息,算法可以保证深度估计结果是全局尺度一致的。同时slam过程利用回环检测与全局位姿优化也保证了良好的尺度一致性。在点云与姿态配准时本发明主要考虑运动主方向上的尺度比例即可。如图5所示,为尺度配准对比图。图中(a)为尺度配准前情况,直接利用深度信息与位姿信息融合生成点云。对于图像中的相同物体,点云重建结果没有对准,效果较差;(b)为尺度配准后情况,相比前者配准后的点云对同一物体点云融合效果更好。实验结果表明本发明使用的场景信息配准策略是有效的,在场景信息对齐方面具有很好表现。

[0083]

街道场景重建效果如图6所示。为kitti 06重建结果,数据集共包含1236帧图像,在实际跟踪过程中共提取402帧关键帧,路径全长3.5km。图中运动轨迹形成环路。图中第一部分为vi-slam建图结果,第二部分为场景稠密重建结果,第三部分为常见结果直观展示效果。稠密点云包含4852万空间点。此场景重建过程约需要18分钟。从重建结果中可以看出,场景快速重建能够重建出完整的街道场景信息,对于街道两侧的树木、汽车等物体可以保证点云拼接结果的一致性。

[0084]

本发明中未详细阐述的部分属于本领域技术人员的公知技术。

[0085]

最后所应说明的是,以上所述仅是本发明的优选实施方式,应当指出,对于本技术领域的普通技术人员来说,在不脱离本发明原理的前提下,还可以做出若干改进和润饰,这

些改进和润饰也应视为本发明的保护范围。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1