一种基于问答系统的伪相关反馈的扩展查询方法与流程

[0001]

本发明涉及信息检索方法领域,特别是搜索引擎中基于伪相关反馈算法的扩展查询方法研究。

背景技术:

[0002]

在信息技术日益发达的今天,越来越多的人开始用搜索引擎检索浏览和查询相关知识,搜索引擎则根据用户的需求和一些相关算法,运用特定的策略从互联网中检索出定制信息返回给用户。但是由于互联网生态的多元化以及信息量的快速增长,用户很难准确并高效的给出所需的查询,所以用户为搜索引擎提供的可能只是一些简短的查询或者少数的查询词项,这就有可能导致搜索引擎无法完全获取用户的查询意图,进而使得无法返回最佳的满足用户需求的检索结果。查询扩展技术也就应运而生了,一般情况下,搜索引擎可以通过对于用户提出的原始查询进行合理的扩展在一定程度上解决上述问题,也就是检索系统通过多种策略选择合适的词汇扩展原始查询,这样扩展后的查询语句就会包含更丰富的信息,之后根据扩展后产生的新的查询语句进行检索并向用户返回最终的结果。

[0003]

在许多常用搜索场景下,系统会提前准备好近义词表或专有词表等,当用户提交查询后,根据提前定义好的规则,用近义词等词汇扩展原始查询,这种最简单的查询扩展方法只利用了用户原始查询中的信息,但由于大量原始查询本来就有信息缺失,所以这种简单的方法常常无法真正扩展出用户的搜索意图,系统需要结合更多的信息来完成查询扩展任务。伪相关反馈算法正是解决这类问题的一种有效算法,在伪相关反馈算法中,根据用户提出的原始查询,搜索引擎会进行第一次检索,第一次检索中的前k篇文档会作为伪相关文档,算法根据原始查询和伪相关文档选择词项对原始查询进行扩展,最后搜索引擎根据扩展后的查询进行第二次检索,并将检索结果返回给用户。在整个过程中,用户只需要提交原始查询即可,之后所有的操作都由系统内部完成,所以伪相关反馈算法可以在不影响用户体验的前提下,提高搜索的质量和效果。

[0004]

分析近期关于伪相关反馈算法的专利技术:

[0005]

申请号为201710370190.x的中国发明专利申请《一种基于伪相关反馈模型的信息检索方法及系统》建立了一种基于统计学特征的伪相关反馈模型,利用tfidf、bm25等计算词项重要性,通过词语共现频率计算词与查询的相关性。但该方法仅仅依靠统计学特征判断扩展词项,无法理解查询与文档中的语义和意图,大量有效的长尾扩展词无法被选出。

[0006]

申请号为201910031478.3的中国发明专利申请《基于语义相似度的伪相关反馈模型信息检索方法及系统》基于传统的rocchio算法和语义相似度预测查询扩展词。但该方法仅使用上下文相关词嵌入向量,无法做到查询与文档间的语义交互,有信息丢失,同时,由于使用rocchio算法结合语义相似度计算,忽略了词频等大量统计学特征,会使得扩展后的查询有语义飘移问题。

[0007]

分析近期关于伪相关反馈算法的研究:

[0008]

当前信息检索领域中对于伪相关反馈算法的研究根据算法模型利用的特征可以

大致分为以下三类,基于统计学特征的伪相关反馈算法,基于语义特征的伪相关反馈算法和基于混合特征的伪相关反馈算法。

[0009]

在基于统计学特征的伪相关反馈算法中,montazeralghaem等在信息检索国际会议special interest group on information retrieval(sigir 2018年第41届)上发表的theoretical analysis of interdependent constraints in pseudo-relevance feedback《伪相关反馈中相互依赖约束的理论分析》中通过理论分析给出了一些统计学特征及约束之间的相互关联性,结合这些关联性及统计学约束特征建立了计算扩展词项相关性的具体算法,该算法可以较好地利用统计学特征,但却完全忽略了查询与文档中的语义信息及用户的搜索意图。

[0010]

在基于语义特征的伪相关反馈算法中,roy等在信息检索国际会议special interest group on information retrieval(sigir 2016年第39届)上发表的using word embeddings for automatic query expansion《利用词嵌入的自动查询扩展》中建立了knn算法结合语义相似度的完整算法,通过knn一步步地筛选出语义相似度高地扩展词项。其不足在于:只利用上下文相关的词嵌入向量,完全忽略查询与文档间的语义交互信息,同时,忽略词频等特征可能会造成扩展后的查询语义飘移。

[0011]

在基于混合特征的伪相关反馈算法中,kuzi等在信息与知识管理国际会议the conference on information and knowledge management(cikm 2016年第25届)上发表的query expansion using word embeddings《利用词嵌入的查询扩展方法》通过多种基于余弦相似度的方法叠加挖掘语义特征,结合rm3算法有效利用统计学特征,最后用线性加权的方法将两种算法的结果通过一个可调参数结合起来选择扩展词项。该方法的问题在于,基于规则方式计算统计学特征的影响,模型泛化性差,只是利用词项的嵌入向量,没有有效的手段去挖掘查询与伪相关文档间的语义联系。

[0012]

对国内外相关专利以及相关研究分析后可得出一下结论:目前信息检索领域的伪相关反馈算法无法对用户查询与伪相关文档间的语义交互信息进行有效的利用,造成相关算法无法识别用户的搜索意图,在查询扩展中有偏差。对词频等统计学信息的利用无法摆脱固定的规则模型,泛化性较差,无法充分利用特征交叉的信息。因此,本发明探究如何有效挖掘和利用查询与伪相关文档间的语义联系,并对统计学特征利用及特征交叉方法进行有效改进,从而完善查询扩展任务的伪相关反馈算法。

技术实现要素:

[0013]

有鉴于现有技术的上述缺陷,本发明的目的是提出一种基于问答系统的伪相关反馈的扩展查询方法,能够有效利用相关语义挖掘模型学习查询与伪相关文档间的语义联系,并通过成对损失函数训练的方法有效引入神经网络充分使得统计学特征交叉作用,从而共同提升查询扩展的效果,即扩展后的查询在排序时,ndcg等指标显著提高。

[0014]

为此,我们提出可以借鉴问答系统中相对成熟的语义挖掘模型,并结合伪相关反馈算法自身的特点,设计一种具有创新性的基于问答系统的伪相关反馈算法。问答系统(qa)作为自然语言领域中成熟的语义挖掘任务,需要模型根据问题从相应的文章片段中选出一段句子作为答案来回答问题。由此可以看出,问答系统的任务和模型与伪相关反馈中极其相似,问答系统中的问题、文章片段和答案分别对应伪相关反馈中的查询、伪相关文档

和扩展词项。

[0015]

从传统模型的限制出发,基于问答系统与伪相关反馈算法的共同点,本发明算法的具体设计内容如下,

[0016]

首先,是基于问答系统的语义挖掘模块,这个模块主要有输入层、注意力层和输出层。在输入层中,输入部分是原始查询以及某一篇伪相关文档的词项集,通过提前训练好的词向量模型可以得到这些词项的语义向量,借鉴transformer模型中的输入层,我们也使用相同的位置编码方式,并加到语义向量上,作为该层的输出,输入层的目的就是提取伪相关反馈模型中需要的词项语义信息,这些语义信息中已经加入了相对位置信息。

[0017]

在注意力层中,又可以进一步分为多头注意力层以及注意力流层。多头注意力层采用了自注意力机制,自注意力机制最近被广泛运用于问答系统等多种自然语言任务,可以有效挖掘词项序列内部的语义联系,在多头注意力层中,分别对伪相关反馈文档以及原始查询中的词项序列使用自注意力机制,得到包含词项序列内部相关语义信息的向量,多头注意力层又会使用多个自注意力模块,使得模型可以注意来自不同位置的不同表示子空间的语义信息。因此,多头注意力层的输入是词项的上下文无关语义向量,输出是词项考虑了其序列内部相关语义信息的语义向量,目的是是分别挖掘了伪相关文档以及原始查询中的内部语义信息。在这之后,注意力流层采用问答系统模型中常用的双向注意力机制,这种注意力机制可以分别考虑查询-文档以及文档-查询两个方向的交互语义信息,通过建立相似性矩阵与加权求和的方式识别查询与伪相关文档间的语义交互信息。

[0018]

在输出层中,由于伪相关反馈的输出扩展词项一定是来自于伪相关文档的,也就是模型的输出一定来自模型的输入,所以该模块的输出层通过指针网络来实现,最终的输出就是某一篇伪相关反馈文档的词项集中的每一个词作为扩展词项的概率。整个算法模块通过交叉熵损失函数可以得到有效的训练。在模型推理阶段,将多篇伪相关反馈文档分别输入模型,将输出进行简单的求和即可得出推断结果。

[0019]

其次,是基于统计学特征的模块,该模块的目的是为了解决语义模型存在的语义漂移问题,这些特征包括,词频、逆文档频率、文档长度等等。具体来说,就是将伪相关文档中出现过的词项作为候选扩展词项,对于每一个候选扩展词项,都会有一个基于统计学特征的向量来表征这个词项对于某一个特定查询的信息,这个特征向量的具体组成是:查询归一化词频、使用拉普拉斯平滑后的逆文档频率以及这些词项在每一篇伪相关文档中的归一化词频。之后,为了使得统计学特征得到有效的利用,使用神经网络代替了传统的统计学方法以达到特征充分交叉的目的,在神经网络的训练方法上,没有采用平方差等传统的损失函数,而是采用成对损失函数,即对于每一个扩展词项,可以定义如果原始查询在扩展这个词项后,排序得到的ndcg有所提升,就认为这个词是正例,反之这个词项则为负例。通过正负例的成对训练,使得神经网络模型可以针对ndcg或map等指标有特定的优化训练。采用这样的损失函数的原因是查询扩展中关注的是词项的相对排序,最后只需要选择排序靠前的作为最终扩展词项即可。

[0020]

最终将之前两部分介绍的模块通过加权求和的方式结合在一起,即可生成最终的基于问答系统的伪相关反馈算法。在模型训练阶段,两部分模块会进行并行训练,在测试阶段,两部分训练好的模块结合预测一个候选词项应该被扩展的概率。以上就是本发明所设计的基于问答系统的伪相关反馈模型的大致结构。

[0021]

检索查询的流程,包括:

[0022]

步骤1、根据查询q的关键字对文档集d进行初次检索。

[0023]

步骤2、取出初次检索结果中的前k篇为伪相关文档集合d’,其中的词作为候选扩展词。

[0024]

步骤3、通过基于问答系统的模块,计算查询与文档的语义交互信息得出每个候选词被扩展的概率。

[0025]

步骤4、通过基于统计学特征的模块,提取候选词的归一化词频、逆文档频率等,并通过神经网络预测扩展概率。

[0026]

步骤5、将步骤3、步骤4得出的候选词及其权重进行线性融合,最终提取出前n个查询扩展词。

[0027]

步骤6、将原查询与扩展词线性加权融合生成新的查询q’。

[0028]

步骤7、根据新查询q’进行第二次检索,生成最终查询结果。

[0029]

优选地,步骤1中,首先会对查询关键字和文档集做预处理,具体过程包括分词和去除标点及停用词,在英文中要将词项筛选为词根形式。

[0030]

进一步地,步骤2中,初次检索结果作为候选的伪相关文档集,计算候选的伪相关文档集中每一个文档的bm25分数,根据bm25分数对文档进行降序排列,提取出前k篇文档作为伪相关文档集,候选扩展词项就是这个文档集中文档所包含的所有词。

[0031]

进一步地,步骤3中,基于问答系统的模块包括输入层,输入为原始查询q和一篇伪相关文档d

u

,通过fasttext预训练模型可以得到其中每一个词项的对应词嵌入向量,借鉴transformer模型中的输入层,我们也使用相同的位置编码方式,加上对应的位置编码,即可得到注意力层的输入向量q={q1,q2,...,q

n

}与d

u

={d

u,1

,d

u,2

,...,d

u,m

},其中n为原始查询长度,m为文档集中的文档长度。

[0032]

进一步地,步骤3中,基于问答系统的模块包括注意力层,注意力层中通过多头注意力层得到上下文相关语义向量来挖掘文本内部语义信息,多头注意力层通过自注意力机制的堆叠实现,这里给出针对自注意力机制实现,即:

[0033][0034]

其中dim

k

为词嵌入向量维度,此处需要注意的是,词嵌入向量{d

u,1

,d

u,2

,...,d

u,m

}在输入注意力层前需要经过参数矩阵做一次乘法运算;将多个这样的自注意力模块堆叠即可得到多头注意力层的输出。

[0035]

进一步地,步骤3中,基于问答系统的模块包括注意力流层,注意力流层采用双向注意力机制,这种注意力机制可以分别考虑查询-文档以及文档-查询两个方向的交互语义信息;

[0036]

首先,对于一篇伪相关反馈文档以及查询中的词项集,可以建立一个相似性矩阵矩阵中的每一列分别表示文档中的词项,每一行分别表示查询中的词项,每一项的值表示一个查询词项和一个文档词项的相关度。

[0037]

文档-查询注意力表示哪一个查询词项与伪相关文档中的每一个词项是最相关的,对查询矩阵每一行通过softmax进行归一化a

i:

=softmax(s

i:

),再将查询词项的语义向

量通过该归一化权重带权相加就可以得到文档查询注意力矩阵:

[0038]

a

i:

=∑

j

a

ij

r

j

[0039]

其中r

j

表示查询经过多头注意力层的输出,

[0040]

查询-文档注意力则表示文档中的哪一个词与查询中的每一个词是最相关的,采用与文档-查询注意力矩阵相似的求法可以得到这个方向的注意力矩阵,其中权重矩阵为:

[0041][0042]

得到的注意力向量矩阵为:

[0043][0044]

其中,o

i

表示伪相关文档经过多头注意力层的输出,这里的复制m次即可得最终的矩阵

[0045]

最后将两个方向的注意力矩阵与原始文档词项集语义向量组成的矩阵求平均值即可得到注意力流层的输出:

[0046][0047]

进一步地,步骤3中,基于问答系统的模块包括输出层指针网络,输出层指针网络用来限制语义模块的输出一定来自伪相关文档,具体形式为

[0048][0049][0050]

其中w1,w2,w3为可训练参数矩阵,表示查询语义向量,e

i:

为注意力层的输出,这里的p

pointer

(d

u,i

|q,d

u

)表示第u篇伪相关文档d

u

中第i个词项d

u,i

被扩展的概率。

[0051]

之后,将k篇伪相关文档的结果加和即为基于问答系统模块结果

[0052][0053]

进一步地,步骤3中,基于问答系统的模块训练通过交叉熵损失函数来实现,对于每一个候选词项,该词为正例当且仅当原始查询扩展该词后,排序相关指标ndcg等有提升,否则为负例,具体交叉熵损失函数为:

[0054][0055]

进一步地,步骤4中,基于统计学特征的模块主要是为了纠正语义模块的语义漂移问题,在算法中,会先为每一个候选扩展词项建立统计学特征向量

[0056][0057]

其中,表示词项w在查询q的归一化词频,表示逆文档频率,表示在w伪相关文档d

u

中的归一化词频,表示词项w在文本中的词频,c表示文档总数,c

w

表示出现过词项w的文档总数,avg

l

表示平均文档长度,α为可设置的超参数。

[0058]

通过神经网络对特征向量进行预测

[0059]

w

prf

(w|q)p

lambda

(w|q)=sigmoid(w4·

relu(w5·

fv(w,q)+b5)+b6)

[0060]

进一步地,步骤4中,基于统计学特征的模块,在训练前对每一个候选词项的标签进行判断,如果该词项被扩展后可以使得排序指标ndcg提高,则这个词为正例样本,否则为负例样本,使用的成对损失函数计算方法为

[0061][0062]

其中,s

i

和s

j

分别表示神经网络对于词项i和词项j被扩展概率的预测分数,和分别表示对于原始查询q扩展词项i和j后ndcg的提升值。

[0063]

进一步地,步骤5中,基于问答系统的伪相关反馈算法的最终结果

[0064]

w(w|q)=γw

qa

(w|q)+(1-γ)w

prf

(w|q)

[0065]

其中γ为超参数。

[0066]

进一步地,步骤6中,根据每个候选词项的分数w(w|q)选出排在前m为的词项为扩展词项,使用这些查询对原始查询q进行扩展后得到新的查询q

′

为

[0067]

p(w|q

′

)=(1-β)p(w|q)+β

[0068]

其中β为超参数。

[0069]

与现有技术相比,本发明的有益效果如下:

[0070]

相比于业界常用的基于伪相关反馈算法的扩展查询方法在排序效果、准确率和鲁棒性上都有提升。

附图说明

[0071]

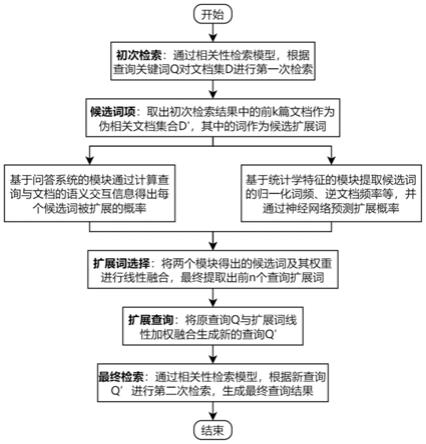

图1是本发明实施例的方法的说明图;

[0072]

图2是本发明实施例的基于问答系统的模块结构及处理过程;

[0073]

图3是本发明实施例的整体结构图及处理过程。

具体实施方式

[0074]

以下参考说明书附图介绍本申请的优选实施例,使其技术内容更加清楚和便于理解。本申请可以通过许多不同形式的实施例来得以体现,本申请的保护范围并非仅限于文中提到的实施例。

[0075]

以下将对本发明的构思、具体结构及产生的技术效果作进一步的说明,以充分地了解本发明的目的、特征和效果,但本发明的保护不仅限于此。

[0076]

本发明的一个实施例:

[0077]

如附图1,检索查询的流程,包括:

[0078]

步骤1、初次检索

[0079]

通过相关性检索模型,根据查询q的关键字对文档集d进行第一次检索。

[0080]

首先会对原始查询和文档集做预处理,具体过程包括分词和去除标点及停用词,在英文中要将词项筛选为词根形式。

[0081]

步骤2、候选词项

[0082]

取出初次检索结果中的前k篇为伪相关文档集合d’,其中的词作为候选扩展词。

[0083]

具体为,初次检索结果作为候选的伪相关文档集,计算候选的伪相关文档集中每一个文档的bm25分数,根据bm25分数对文档进行降序排列,提取出前k篇文档作为伪相关文档集,候选扩展词项就是这个文档集中文档所包含的所有词。

[0084]

步骤3、基于问答系统的模块,通过计算查询与文档的语义交互信息得出每个候选词被扩展的概率。

[0085]

步骤4、基于统计学特征的模块,提取候选词的归一化词频、逆文档频率等,并通过神经网络预测扩展概率。

[0086]

步骤5、将两个模块得出的候选词及其权重进行线性融合,最终提取出前n个查询扩展词。

[0087]

步骤6、扩展查询

[0088]

将原查询与扩展词线性加权融合生成新的查询q’。

[0089]

步骤7、最终检索

[0090]

通相关性检索模型,根据新查询q’进行第二次检索,生成最终查询结果。

[0091]

所述步骤3中,基于问答系统的模块结构及处理过程,如图2所示:

[0092]

结合图2按自下而上的顺序说明,

[0093]

最底层为输入层,该模块的输入为原始查询q和一篇伪相关文档d

u

,通过fasttext预训练模型可以得到其中每一个词项的对应词嵌入向量,借鉴transformer模型中的输入层,我们也使用相同的位置编码方式,加上对应的位置编码,即可得到注意力层的输入向量q={q1,q2,...,q

n

}与d

u

={d

u,1

,d

u,2

,...,d

u,m

},其中n为原始查询长度,m为文档集中的文档长度。

[0094]

接下来是注意力层,注意力层中通过多头注意力层得到上下文相关语义向量来挖掘文本内部语义信息,多头注意力层通过自注意力机制的堆叠实现,这里给出针对自注意力机制实现,即:

[0095][0096]

这里只给出了基于一篇伪相关文档的自注意力机制实现,对于查询的自注意力机制算法与该式相同,其中dim

k

为词嵌入向量维度,此处需要注意的是,词嵌入向量{d

u,1

,d

u,2

,...,d

u,m

}在输入注意力层前需要经过参数矩阵做一次乘法运算。将多个这样的自注意力模块堆叠即可得到多头注意力层的输出。

[0097]

接下来是注意力流层,注意力流层采用双向注意力机制,这种注意力机制可以分别考虑查询-文档以及文档-查询两个方向的交互语义信息。

[0098]

首先,对于一篇伪相关反馈文档以及查询中的词项集,可以建立一个相似性矩阵矩阵中的每一列分别表示文档中的词项,每一行分别表示查询中的词项,每一项的值表示一个查询词项和一个文档词项的相关度。

[0099]

文档-查询注意力表示哪一个查询词项与伪相关文档中的每一个词项是最相关的,对查询矩阵每一行通过softmax进行归一化a

i:

=softmax(s

i:

),再将查询词项的语义向量通过该归一化权重带权相加就可以得到文档查询注意力矩阵:

[0100]

a

i:

=∑

j

a

ij

r

j

[0101]

其中rj表示查询经过多头注意力层的输出,

[0102]

查询-文档注意力则表示文档中的哪一个词与查询中的每一个词是最相关的,采用与文档-查询注意力矩阵相似的求法可以得到这个方向的注意力矩阵,其中权重矩阵为:

[0103][0104]

得到的注意力向量矩阵为:

[0105][0106]

其中,o

i

表示伪相关文档经过多头注意力层的输出,这里的复制m次即可得最终的矩阵

[0107]

最后将两个方向的注意力矩阵与原始文档词项集语义向量组成的矩阵求平均值即可得到注意力流层的输出:

[0108][0109]

最后是输出层指针网络,用来限制语义模块的输出一定来自伪相关文档,具体形式为

[0110][0111][0112]

其中w1,w2,w3为可训练参数矩阵,表示查询语义向量,e

i:

为注意力层的输出,这里的p

pointer

(d

u,i

|q,d

u

)表示第u篇伪相关文档d

u

中第i个词项d

u,i

被扩展的概率。

[0113]

之后,将k篇伪相关文档的结果加和即为基于问答系统模块结果

[0114][0115]

这部分模型的训练通过交叉熵损失函数来实现,对于每一个候选词项,该词为正例当且仅当原始查询扩展该词后,排序相关指标ndcg等有提升,否则为负例,具体交叉熵损失函数为

[0116][0117]

步骤4中,基于统计学特征的模块主要是为了纠正语义模块的语义漂移问题,在算法中,会先为每一个候选扩展词项建立统计学特征向量

[0118][0119]

其中,表示词项w在查询q的归一化词频,表示逆文档频率,表示在w伪相关文档d

u

中的归一化词频,表示词项w在文本中的词频,c表示文档总数,c

w

表示出现过词项w的文档总数,avg

l

表示平均文档长度,α为可设置的超参数。

[0120]

通过神经网络对特征向量进行预测

[0121]

w

prf

(w|q)p

lambda

(w|q)=sigmoid(w4·

relu(w5·

fv(w,q)+b5)+b6)

[0122]

在训练前对每一个候选词项的标签进行判断,如果该词项被扩展后可以使得排序指标ndcg提高,则这个词为正例样本,否则为负例样本,使用的成对损失函数计算方法为

[0123][0124]

其中,s

i

和s

j

分别表示神经网络对于词项i和词项j被扩展概率的预测分数,和分别表示对于原始查询q扩展词项i和j后ndcg的提升值。

[0125]

步骤5中,合并步骤3与步骤4中的两个模块的结果得到基于问答系统的伪相关反馈算法的最终结果

[0126]

w(w|q)=γw

qa

(w|q)+(1-γ)w

prf

(w|q)

[0127]

其中γ为超参数。

[0128]

如图3所示,为包含了两个模块的整体结构及处理流程图。

[0129]

步骤6中,根据每个候选词项的分数w(w|q)选出排在前m为的词项为扩展词项,使用这些查询对原始查询q进行扩展后得到新的查询q

′

为

[0130]

p(w|q

′

)=(1-β)p(w|q)+β

[0131]

其中β为超参数。

[0132]

步骤7中,使用新得到的查询q

′

进行第二次检索,方法与步骤1相同,即可得到最终检索结果,可用于测评或模型预测。

[0133]

为了验证本发明方法的实际效果,在多个标准集上做了对比实验,在对比实验中,基线算法为不采用伪相关反馈的检索模型以及包括背景技术中三篇研究论文在内的伪相关反馈算法,这些算法被认为是现在信息检索中效果较好的伪相关反馈算法。本实验使用了一个标准的国际数据集trec disks 4&5和一个公开的中文数据集ogeek,这些数据集的信息如下表所示:

[0134]

数据集名称查询数文档数平均文档长度标注样本数trec250174k284311kogeek68253662k3.18750k

[0135]

表1实验数据集基本信息

[0136]

在对比实验中,主要的评测指标有ndcg和map用来反映模型扩展后排序的整体效果,准确率prec用来反映扩展查询后排序准确率,ri表示查询扩展后,ndcg提升的查询数量占总查询比例,用来反映模型的鲁棒性,其中ndcg和map在两个数据集上分别测排序前1000和前5篇文档效果,prec在两个数据集上分别测排序前20和前5篇文档效果。整体对比实验效果如下表所示,

[0137][0138]

表2伪相关反馈算法对比实验

[0139]

在表2中,无查询扩展即表示根据原查询搜索的结果,rm3+,ll(all),medmm和svm分别代表论文selecting discriminative terms for relevance model,theoretical analysis of interdependent constraints in pseudo-relevance feedback,revisiting the divergence minimization feedback model和selecting good expansion terms for pseudo-relevance feedback中的伪相关反馈算法。从表中可以观察得出,本发明算法相比于业界常用的有效伪相关反馈算法在排序效果、准确率和鲁棒性上都有一定的提升,表面本发明技术方案有效。

[0140]

以上详细描述了本申请的较佳具体实施例。应当理解,本领域的普通技术无需创造性劳动就可以根据本申请的构思作出诸多修改和变化。因此,凡本技术领域中技术人员依本申请的构思在现有技术的基础上通过逻辑分析、推理或者有限的实验可以得到的技术方案,皆应在由权利要求书所确定的保护范围内。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1